أخلاقيات الذكاء الاصطناعي: كيف يجب على المسوقين تبني الابتكار بمسؤولية

نشرت: 2023-08-21الذكاء الاصطناعي (AI) ليس مجرد ظاهرة خيال علمي تحولت إلى حقيقة، بل هو دعامة تكنولوجية أساسية، تم تطويرها على مدى عقود تحت أنوفنا. لقد حقق الذكاء الاصطناعي أحلام زيادة الكفاءة، حيث استفادت العديد من العلامات التجارية بالفعل من تسويق الذكاء الاصطناعي على مدى السنوات القليلة الماضية.

وعلى الرغم من أنه أثار الإثارة والحماس، إلا أن هناك مخاوف تحيط بأخلاقيات الذكاء الاصطناعي. مثل العديد من الابتكارات، كانت رؤية صناعة التكنولوجيا للميتافيرس لها أوجه تشابه غريبة مع وسائل الإعلام مثل Black Mirror وSnow Crash . ومع وجود أعمال مثل Parable of the Sower, the Machine and I, Robot ضمن روح العصر الثقافي، فمن المفهوم لماذا يحذر عشاق الخيال العلمي والباحثون والتقنيون على حد سواء من مخاطر تجاهل أخلاقيات الذكاء الاصطناعي.

سنحدد في هذه المقالة ما هي أخلاقيات الذكاء الاصطناعي، ولماذا يجب أن تشعر العلامات التجارية بالقلق، وأهم القضايا الأخلاقية التي تواجه المسوقين، بما في ذلك الأمن الوظيفي، والمعلومات الخاطئة، والتحيز الخوارزمي. سنشارك أيضًا خمس خطوات لمساعدتك في الحفاظ على ممارسات الذكاء الاصطناعي الأخلاقية داخل الفرق وعبر المؤسسة.

ما هي أخلاقيات الذكاء الاصطناعي؟

أخلاقيات الذكاء الاصطناعي هي نظام من المبادئ الأخلاقية والممارسات المهنية المستخدمة للإبلاغ بشكل مسؤول عن تطوير ونتائج تكنولوجيا الذكاء الاصطناعي. ويشير أيضًا إلى دراسة كيفية تحسين التأثير وتقليل مخاطر و/أو عواقب الذكاء الاصطناعي.

وقد عملت شركات التكنولوجيا الرائدة والهيئات الحكومية مثل الأمم المتحدة ومجتمعات البحث وعلوم البيانات على صياغة ونشر مبادئ توجيهية لمعالجة القضايا الأخلاقية. على سبيل المثال، نشرت منظمة الأمم المتحدة للتربية والعلم والثقافة (اليونسكو) أول معيار عالمي بشأن أخلاقيات الذكاء الاصطناعي في نوفمبر 2021: التوصية بشأن أخلاقيات الذكاء الاصطناعي.

هناك بعض لوائح الذكاء الاصطناعي المعمول بها على المستوى الوطني والمحلي، ولكن مع نمو الذكاء الاصطناعي والتقنيات الناشئة الأخرى، يجب على الشركات أن تتوقع المزيد من التنظيم الحكومي. مع اندماج الذكاء الاصطناعي بشكل أكبر في حياتنا، تصبح أخلاقيات الذكاء الاصطناعي جزءًا مهمًا من محو الأمية الرقمية.

لماذا تعتبر أخلاقيات الذكاء الاصطناعي مهمة؟

تستثمر الشركات بالفعل في الذكاء الاصطناعي، لكن الصعوبة تكمن في ضمان الاستخدام المسؤول.

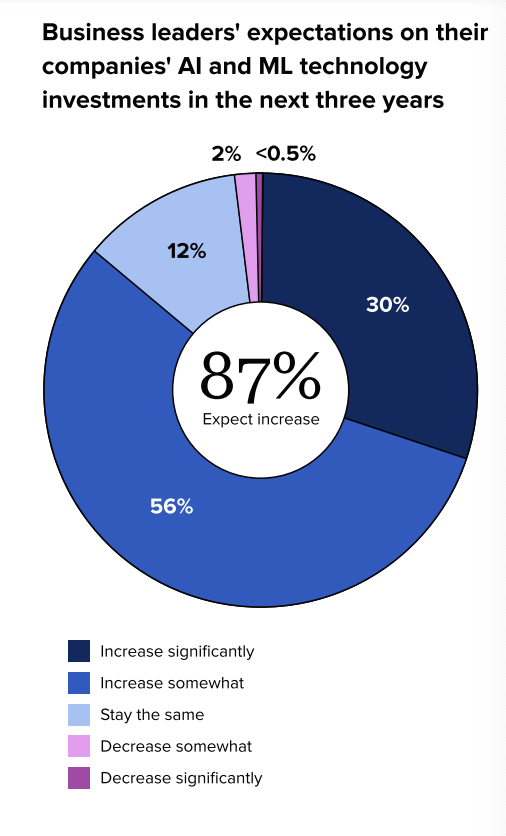

وفقًا لتقرير حالة وسائل التواصل الاجتماعي لعام 2023: الذكاء الاصطناعي والبيانات، يتوقع قادة الأعمال زيادة الاستثمارات في الذكاء الاصطناعي خلال السنوات القليلة المقبلة. ووجد تقريرنا أيضًا أن 98% من قادة الأعمال يتفقون على أن الشركات بحاجة إلى فهم أفضل لإمكانات تكنولوجيا الذكاء الاصطناعي والتعلم الآلي (ML) لتحقيق النجاح على المدى الطويل.

في حين أن الذكاء الاصطناعي يمكنه تحسين الأداء وتعزيز الكفاءة وتحقيق نتائج أعمال إيجابية، فإن العلامات التجارية تعاني أيضًا من عواقب غير متوقعة لتطبيقه. ويمكن أن ينجم ذلك عن نقص الأبحاث أو مجموعات البيانات المتحيزة، من بين أسباب أخرى. يمكن أن يؤدي سوء استخدام الذكاء الاصطناعي أو إهمال المخاوف الأخلاقية إلى الإضرار بسمعة العلامة التجارية، وفشل المنتج، والتقاضي والمشكلات التنظيمية.

تبدأ الخطوة الأولى لدعم المعايير الأخلاقية عبر الفرق داخل مؤسستك بفهم المشكلات التي يواجهها المسوقون، حتى تتمكن من تشكيل خطة للتخفيف من مخاطر الأعمال هذه وحماية علامتك التجارية.

ما هي القضايا الأخلاقية المتعلقة بالذكاء الاصطناعي التي تتصدر اهتمامات المسوقين

هناك مجموعة متنوعة من المخاوف الأخلاقية المتعلقة بالذكاء الاصطناعي في صناعة التكنولوجيا بما في ذلك، على سبيل المثال لا الحصر، ما يلي:

- توليد محتوى كاذب

- قابلية الشرح

- التأثير المجتمعي

- إساءة استخدام التكنولوجيا

- تحيز

- مسؤولية البيانات والخصوصية

- الإنصاف

- المتانة

- الشفافية

- الاستدامة البيئية

- التنوع والتضمين

- الوكالة الأخلاقية ومواءمة القيمة

- الثقة والمساءلة

يعتقد البعض أن الذكاء الاصطناعي يمكن أن يساعد في بناء تقنيات وأنظمة وخدمات أكثر شمولاً يمكنها تلبية احتياجات مجموعات سكانية متنوعة. والمفتاح هنا هو إنشاء أطر وأنظمة وآليات أخلاقية لضمان الاستخدام المسؤول.

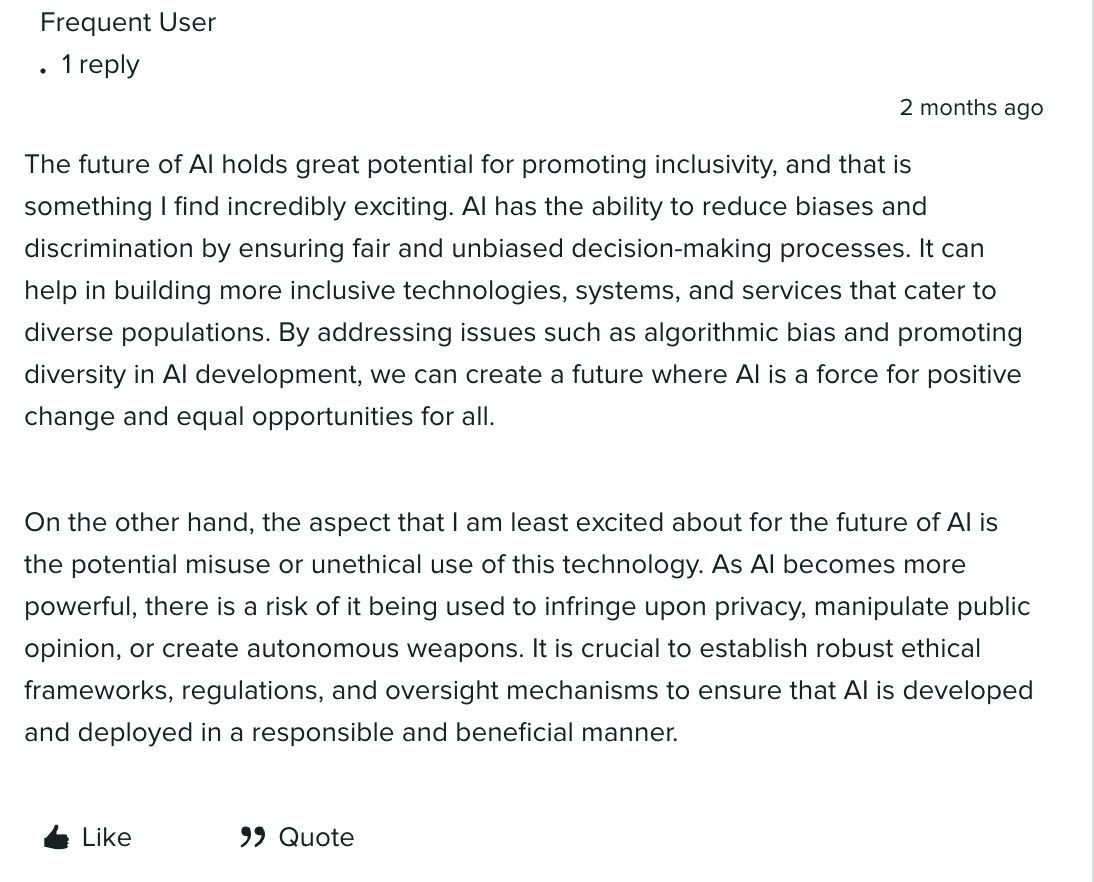

أشار أحد أعضاء المشتل، منتدى مجتمع Sprout، إلى أن الذكاء الاصطناعي لديه القدرة على تعزيز الشمولية والحد من التحيز/التمييز من خلال ضمان عمليات صنع القرار العادلة وغير المتحيزة. ومن خلال معالجة قضايا مثل التحيز الخوارزمي في تطوير الذكاء الاصطناعي، قد يكون من الممكن تشكيل مستقبل يكون فيه الذكاء الاصطناعي قوة إيجابية للتغيير.

إلى جانب إمكانية التغيير الإيجابي، هناك أيضًا فرص لإساءة استخدام الذكاء الاصطناعي أو استخدامه بشكل غير أخلاقي عندما يصبح أكثر قوة. ناقش مجتمعنا العديد من المخاطر بما في ذلك انتهاك الخصوصية والتلاعب بالرأي العام والأسلحة المستقلة.

مثل هذه التعليقات لا تخدش سوى سطح المخاوف الأخلاقية عبر الصناعات، ولكن أهم القضايا التي تهم المسوقين تشمل: الأمن الوظيفي، والخصوصية، والتحيز والتمييز، والمعلومات المضللة والمعلومات المضللة، وقضايا الملكية الفكرية/حقوق الطبع والنشر، والتي سنتعمق فيها بالتفصيل في هذا المقال. القسم التالي.

التأثير على الوظائف والنزوح الوظيفي

إن تأمين الروبوتات للهيمنة على العالم هو أقل ما يقلقنا - على الأقل في الوقت الحالي.

وذلك لأن الباحثين والخبراء ليسوا مهددين بالتفرد التكنولوجي، أو فكرة أن الذكاء الاصطناعي سيتفوق على الذكاء البشري ويكرر سمات مثل المهارات الاجتماعية. إنهم يدركون حدود الذكاء الاصطناعي والتداعيات المحتملة لاستبدال الوظيفة.

الهدف من البحث والاستثمار في الذكاء الاصطناعي ليس استبدال البشر، بل مساعدتنا على توفير الوقت والجهد للقيام بأشياء أكثر تأثيرًا. شارك بوب وولفلي، مدير وسائل التواصل الاجتماعي والشراكات في Flock Freight، تشبيهًا رائعًا للذكاء الاصطناعي: "يشبه الذكاء الاصطناعي غسالة الأطباق أو الغسالة في منازلنا. فكر طوال الوقت في توفير عدم غسل الأطباق أو الملابس يدويًا.

في سلسلتنا غير مقروءة، ناقش أعضاء فريق التسويق والإبداع في Sprout كيفية استخدامهم حاليًا للذكاء الاصطناعي، بدءًا من الانغماس في التسوق المخصص إلى استخدام ميزات مثل ViralPost للمساعدة في جدولة المنشورات الاجتماعية. شاهد الفيديو أدناه لتستمع إلى آراءهم المثيرة حول فوائد ومخاوف الذكاء الاصطناعي، بما في ذلك استبدال الوظائف:

مخاوف الخصوصية

تعتبر المخاوف المحيطة بخصوصية البيانات وحمايتها وأمنها من أهم أولويات العلامات التجارية. تمثل الاستثمارات الأمنية أولوية متزايدة للشركات لأنها تسعى إلى تجنب أي فرص للمراقبة والقرصنة والهجمات الإلكترونية. مع تزايد شعبية التخصيص، تطبق العلامات التجارية أفضل الممارسات لجمع البيانات وتخزينها وتحليلها لحماية العملاء والمؤسسات.

التحيز الخوارزمي والتمييز

ونظرًا لأنه يتعلم من البيانات، فإن الذكاء الاصطناعي الذي تم إنشاؤه أو تدريبه بشكل سيء يمكن أن يظهر تحيزًا ضد مجموعات فرعية من البيانات الممثلة تمثيلاً ناقصًا. كانت هناك العديد من حالات التحيز الكبيرة في الأعمال الفنية التي أنشأها الذكاء الاصطناعي، وروبوتات الدردشة، وبرامج التعرف على الوجه، والخوارزميات، وأدوات الذكاء الاصطناعي لممارسات التوظيف.

على سبيل المثال، أطلق العديد من مستخدمي TikTok وTwitter [تم تغيير علامتهم التجارية إلى X اعتبارًا من يوليو 2023] موضوعًا يظهر "#SouthSudan Barbie" مزينة بالبنادق، وهي صورة نمطية سلبية مرتبطة بمنطقة تتصارع مع القضايا الاجتماعية والسياسية مثل الإبادة الجماعية وأزمات اللاجئين. .

![رد مستخدم على صورة تم إنشاؤها بواسطة الذكاء الاصطناعي لـ "#SouthSudan Barbie" في أحد تغريدات تويتر [أعيدت تسميتها إلى X اعتبارًا من يوليو 2023]. يقول المنشور: "نستمر في إخباركم جميعًا أن التحيز موجود في هذه القمامة التي يولدها الذكاء الاصطناعي."](/uploads/article/221435/S1hZxuJ0KyrnC8ur.png)

ومع دخول التحيز إلى مستوى أقل من المخاطر، يستخدم الذكاء الاصطناعي حالات مثل هذه، ويصبح السؤال هو كيف يمكننا العمل ضد التحيز والتمييز عندما تكون مجموعات بيانات التدريب عرضة للتحيز؟

معلومات مضللة ومضللة

مثل البشر، الذكاء الاصطناعي ليس مثاليًا. يمكن أن تكون استجابات الذكاء الاصطناعي للمطالبات غير دقيقة، وهناك مخاوف من قيام الأشخاص بنشر معلومات مضللة بنوايا خبيثة. إلى جانب التهديدات بالتضليل، هناك احتمال حدوث أزمة للعلامة التجارية والإضرار بالسمعة، خاصة بدون وجود الضمانات والبروتوكولات المناسبة.

قضايا الملكية الفكرية وحقوق النشر

من المحتمل أنك شاهدت طاقم هاري بوتر كشخصيات في فيلم ويس أندرسون أو مواطنو بيكيني بوتوم وهم يغنون الأغاني الشعبية. هذه أمثلة على عدد الأشخاص الذين يستخدمون الذكاء الاصطناعي لاستخدام صورة الأشخاص ومثالهم أو الملكية الفكرية.

يعد الذكاء الاصطناعي شريكًا ممتازًا في السجال للمهام الإبداعية مثل العصف الذهني وإنشاء الخطوط العريضة، ولكن اعتمادًا على كيفية استخدام المخرجات، قد يؤدي ذلك إلى انتهاك حقوق الطبع والنشر والسرقة الأدبية وانتهاكات الملكية الفكرية. على سبيل المثال، رفعت مجموعة من الفنانين دعوى قضائية ضد Midjourney and Stability AI في يناير 2023 بدعوى أن الأدوات تنتهك حقوق ملايين الفنانين. يفتح الذكاء الاصطناعي التوليدي الباب أمام مجموعة من الديدان القانونية، ولا يزال هناك الكثير من الأمور التي يجب تغطيتها، ولكن إنشاء قواعد وأطر عمل استباقية سيساعد في تخفيف المخاطر الأخلاقية.

5 خطوات للحفاظ على أخلاقيات الذكاء الاصطناعي داخل الفرق

فيما يلي خمس خطوات للمساعدة في توجيه خطتك للتخفيف من المخاطر الأخلاقية المتعلقة بالذكاء الاصطناعي:

1. وضع القواعد والمسؤوليات الأساسية الداخلية لاستخدام الذكاء الاصطناعي

فكر في إنشاء فريق أخلاقيات الذكاء الاصطناعي من علماء الأخلاق والخبراء القانونيين والتقنيين والقادة للمساعدة في وضع القواعد الأساسية لمؤسستك. على سبيل المثال، يعد استخدام الذكاء الاصطناعي التوليدي فقط للمسودات والعصف الذهني، وليس للمحتوى المنشور خارجيًا، قاعدة أساسية ممتازة.

إلى جانب هذه القواعد الأساسية، حدد دور ومسؤوليات كل عضو في الفريق مشارك في الذكاء الاصطناعي، بما في ذلك فريق الأخلاقيات. حدد أهدافك وقيمك للذكاء الاصطناعي أيضًا. سيساعد ذلك في وضع الأساس لسياسة أخلاقيات الذكاء الاصطناعي وأفضل الممارسات.

2. تحديد وتدقيق دور الذكاء الاصطناعي

لا يمكن للذكاء الاصطناعي أن يحل محل منشئي المحتوى أو استراتيجيي وسائل التواصل الاجتماعي أو أي دور في التسويق. حدد مهام الذكاء الاصطناعي التي تتطلب إشرافًا بشريًا أو تدخلًا وحدد أهداف سياسة أخلاقيات الذكاء الاصطناعي الخاصة بك للمساعدة في صياغة العمليات لتطوير الذكاء الاصطناعي وإدارته والتواصل بشأنه.

بمجرد تحديد أهداف سياسة الأخلاقيات الخاصة بك، حدد الفجوات والفرص المتاحة للذكاء الاصطناعي في مؤسستك. فكر في الأسئلة التالية:

- كيف تستخدم المنظمة حاليًا الذكاء الاصطناعي وكيف نريد استخدامه في المستقبل؟

- ما هي البرامج والتحليلات التي يمكن أن تساعدنا في تخفيف مخاطر الأعمال؟

- ما هي الفجوات التي تخلقها التكنولوجيا والتحليل؟ كيف نملأها؟

- ما هي الاختبارات أو التجارب التي يتعين علينا إجراؤها؟

- ما هي الحلول الحالية التي يمكننا استخدامها مع أفضل الممارسات الحالية لفرق منتجاتنا؟

- كيف ستستخدم البيانات والرؤى؟

- كيف سنحدد موقع علامتنا التجارية ونرسل رسائل لتقنيات الذكاء الاصطناعي وأخلاقياته؟

3. تطوير عملية تقييم البائعين محكمة الإغلاق

شارك مع فرق تكنولوجيا المعلومات والفرق القانونية لديك لفحص أي أدوات تتمتع بقدرات الذكاء الاصطناعي بشكل صحيح وإنشاء عملية مخاطر أخلاقية. ستساعدك خبرتهم على تقييم الاعتبارات الجديدة مثل مجموعة البيانات التي يتم تدريب الأداة عليها وضوابط البائعين المعمول بها للتخفيف من تحيز الذكاء الاصطناعي. ستساعدك عملية العناية الواجبة لكل أداة قبل إطلاقها خارجيًا أو داخليًا على تخفيف المخاطر المستقبلية.

4. الحفاظ على الشفافية مع الإفصاحات

تعاون مع فرق الشؤون القانونية و/أو فرق الخصوصية لديك لتطوير رسائل خارجية و/أو إخلاء المسؤولية للإشارة إلى أين ومتى تعتمد علامتك التجارية على الذكاء الاصطناعي. يمكن استخدام هذه الرسائل للمحتوى وخدمة العملاء وما إلى ذلك. على سبيل المثال، قامت TikTok بتحديث إرشادات المجتمع الخاصة بها لمطالبة المبدعين بتسمية المحتوى الذي تم إنشاؤه بواسطة الذكاء الاصطناعي. سيساعد توصيل معاييرك وأطرك الأخلاقية لدعم أخلاقيات الذكاء الاصطناعي على اكتساب ثقة الأقران والعملاء المحتملين.

5. مواصلة التعليم عبر القيادة والفرق

الذكاء الاصطناعي ليس شيئًا يمكن لقيادة الأعمال الاندفاع إليه. ومثل أي موجة جديدة من الابتكار الناشئ، سيكون هناك منحنى تعليمي، بالإضافة إلى المعالم التكنولوجية الجديدة. ساعد في تحقيق تكافؤ الفرص من خلال استضافة دورات تدريبية وورش عمل داخلية لتثقيف جميع أعضاء الفريق والقادة وأصحاب المصلحة حول أخلاقيات الذكاء الاصطناعي وكيفية بنائها بشكل مسؤول.

افعل الشيء الصحيح باستخدام أخلاقيات الذكاء الاصطناعي

إن النظر في الأخلاقيات ليس مجرد الشيء الصحيح الذي ينبغي القيام به، بل إنه عنصر حاسم في الاستفادة من تكنولوجيا الذكاء الاصطناعي في الأعمال التجارية.

تعرف على المزيد من وجهات نظر القادة والمسوقين حول كيفية تأثير الذكاء الاصطناعي على مستقبل الشبكات الاجتماعية في ندوتنا عبر الإنترنت، إلى جانب النتائج الأخرى من تقرير حالة وسائل التواصل الاجتماعي لعام 2023 ونصائح لإنشاء محتوى اجتماعي مؤثر.