أفضل 7 تقنيات كشط الويب 2023: دليل عملي

نشرت: 2023-03-08من المحتمل أن يكون أكبر مصدر للمعلومات في العالم موجودًا على الإنترنت. إن جمع وتحليل البيانات من المواقع الإلكترونية له تطبيقات محتملة واسعة في مجموعة واسعة من المجالات ، بما في ذلك علم البيانات ، وذكاء الشركات ، والتقارير الاستقصائية.

يبحث علماء البيانات باستمرار عن معلومات وبيانات جديدة لتعديلها وتحليلها. يعد تجريف الإنترنت للحصول على معلومات محددة حاليًا أحد أكثر الطرق شيوعًا للقيام بذلك.

هل أنت مستعد لتجربة تجريف الويب الأولى؟ لكن أولاً ، يجب أن تفهم ماهية تجريف الويب بالفعل وبعض أساسياته ، وبعد ذلك سنتحدث عن أفضل تقنيات تجريف الويب.

جدول المحتويات

ما هو تجريف الويب؟

تُعرف تقنية جمع ومعالجة البيانات الأولية من الويب باسم تجريف الويب ، وقد طور مجتمع Python بعض أدوات تجريف الويب الفعالة إلى حد ما. يتم استخدام خط أنابيب البيانات لمعالجة هذه البيانات وتخزينها بطريقة منظمة.

يعد تجريف الويب ممارسة شائعة اليوم مع العديد من التطبيقات:

- يمكن لشركات التسويق والمبيعات جمع البيانات المتعلقة بالعميل المتوقع باستخدام تجريف الويب.

- يمكن لشركات العقارات الحصول على معلومات حول التطورات الجديدة والعقارات المعروضة للبيع وما إلى ذلك باستخدام كشط الويب.

- غالبًا ما تستخدم مواقع مقارنة الأسعار مثل Trivago تجريف الويب للحصول على بيانات المنتج والتسعير من مواقع التجارة الإلكترونية المختلفة.

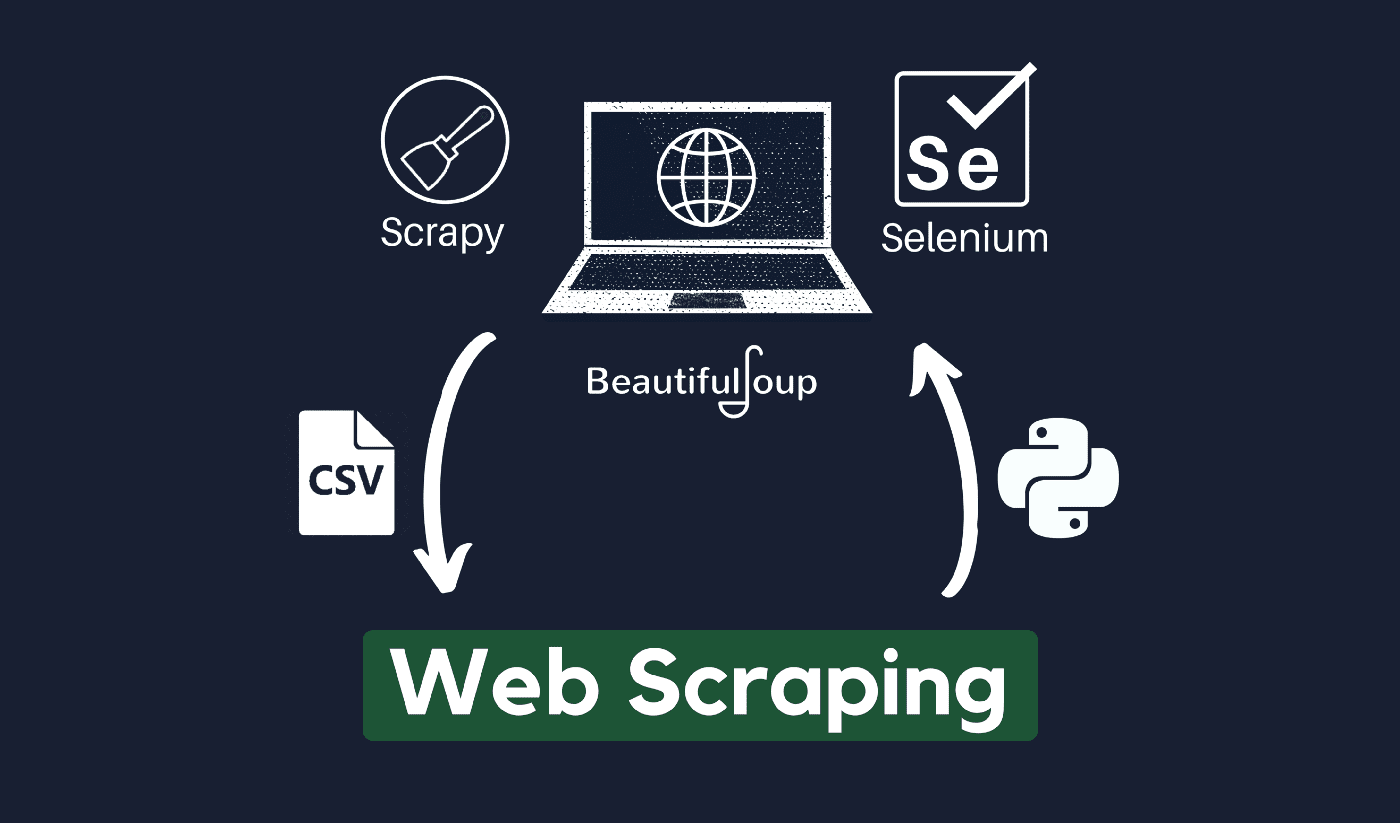

يمكنك كشط الويب باستخدام مجموعة متنوعة من لغات البرمجة ، ولكل لغة برمجة مجموعة متنوعة من المكتبات التي يمكن أن تساعدك في إنجاز نفس الشيء. يعد Python أحد البرامج الأكثر شيوعًا والموثوقة والشرعية المستخدمة في تجريف الويب الفعال.

حول بايثون

Python هي اللغة الأكثر شيوعًا للكشط التي تم تطويرها وإطلاقها في عام 1991. تُستخدم لغة البرمجة هذه بشكل متكرر لإنشاء مواقع الويب وكتابة التعليمات البرمجية وإنشاء البرامج وإنشاء نصوص النظام وأشياء أخرى. يعد البرنامج حجر الزاوية في قطاع الإنترنت ويستخدم على نطاق واسع في التجارة حول العالم.

يمكن تطوير تطبيقات الويب على خادم باستخدام Python. يمكن استخدامه مع التطبيقات لبناء العمليات والارتباط بأنظمة قواعد البيانات. يمكن أيضًا قراءة الملفات وتغييرها.

يمكن استخدامه أيضًا لإدارة البيانات الضخمة ، أو إجراء عمليات حسابية معقدة ، أو تسريع عملية النموذج الأولي ، أو إنشاء برنامج جاهز للإنتاج.

كيف يمكنك استخدام Python في تجريف الويب؟

ستحتاج على الأرجح إلى اتباع ثلاث خطوات لتتخلص من أي معلومات من الإنترنت واستخراجها: الحصول على HTML ، والحصول على شجرة HTML ، وأخيراً استخراج المعلومات من الشجرة.

من الممكن استرداد كود HTML من موقع معين باستخدام مكتبة الطلبات. سيتم بعد ذلك تحليل شجرة HTML واستخراجها باستخدام BeautifulSoup ، ويمكن بعد ذلك تنظيم البيانات باستخدام Python فقط.

يُنصح دائمًا بالتحقق من سياسة الاستخدام المقبول لموقع الويب المستهدف لمعرفة ما إذا كان الوصول إلى موقع الويب باستخدام الأدوات الآلية يعد انتهاكًا لشروط استخدامه قبل استخدام مواهب Python الخاصة بك في تجريف الويب.

كيف يعمل تجريف الويب؟

تُستخدم العناكب عادةً في عملية التجريف عبر الإنترنت. يقومون باسترداد مستندات HTML من مواقع الويب ذات الصلة ، واستخراج المحتوى الضروري بناءً على منطق الأعمال ، ثم تخزينه بتنسيق معين.

يعمل هذا الموقع كدليل لإنشاء أدوات إزالة قابلة للتطوير بدرجة عالية.

يمكن استخدام أطر عمل ونهج Python جنبًا إلى جنب مع بعض مقتطفات التعليمات البرمجية لكشط البيانات بعدد من الطرق المباشرة. هناك العديد من الأدلة المتاحة التي قد تساعدك على وضع الشيء نفسه موضع التنفيذ.

يعد كشط صفحة واحدة أمرًا بسيطًا ، ولكن إدارة الكود العنكبوتي وجمع البيانات وصيانة مستودع البيانات أمر صعب عند كشط ملايين الصفحات. لجعل الكشط بسيطًا ودقيقًا ، سنفحص هذه المشكلات وحلها.

روابط سريعة:

- مراجعة Shiftproxy

- ما هو الخادم الوكيل

- أفضل 3 بدائل لـ SmartProxy

** نصيحة إضافية: استخدم عناوين IP الدوارة وخدمات الوكيل

نظرًا لأنك حصلت على الصورة بوضوح ، فإن تجريف الويب يسمح لك بجمع المعلومات من الويب باستخدام مجموعة من أوامر البرمجة. ولكن كما يجب أن تدرك ، يمكن تتبع أنشطة تجريف الويب الخاصة بك من خلال عنوان IP الخاص بك.

لن تكون هذه مشكلة كبيرة إذا كانت البيانات التي تقوم بكشطها من مجال عام. ولكن إذا كنت تقوم باستخراج البيانات الخاصة من موقع وسائط خاص على سبيل المثال ، فقد تتعرض لمشكلة إذا تم تعقب عنوان IP الخاص بك.

لذلك ، بشكل أساسي ، لمنع عنكبوتك من أن يكون مدرجًا في القائمة السوداء ، فمن الأفضل دائمًا استخدام خدمات الوكيل وتغيير عناوين IP.

لا نشجعك بأي حال من الأحوال على استخدام تجريف الويب لجمع أي بيانات غير قانونية أو خاصة ، أو الانغماس في بعض أنشطة برامج التجسس الضارة؟

ولكن إذا كنت تجمع بيانات قد تكون خاصة ، فمن المستحسن إخفاء عنوان IP الخاص بك أو تدويره أو استخدام خادم وكيل لتجنب التعقب.

قد ترغب أيضًا في قراءة:

- مراجعة Octoparse

- أفضل كاشطات Reddit

- أفضل 12 وكيلًا لكشط الويب

هل تجريف الويب قانوني؟

رسميًا ، لم يُذكر في أي مكان في قواعد الإنترنت والمبادئ التوجيهية أن تجريف الويب غير قانوني. بكل إنصاف ، يعد تجريف الويب أمرًا قانونيًا تمامًا ، بشرط أنك تعمل على البيانات العامة.

في أواخر يناير 2020 ، أُعلن أن تجريف البيانات المتاحة للجمهور لأغراض غير تجارية كان مسموحًا به تمامًا.

المعلومات التي يمكن الوصول إليها مجانًا لعامة الناس هي البيانات التي يمكن الوصول إليها للجميع عبر الإنترنت دون كلمة مرور أو مصادقة أخرى. لذلك ، تتضمن المعلومات المتاحة للجمهور ما يمكن العثور عليه في ويكيبيديا أو وسائل التواصل الاجتماعي أو نتائج بحث Google.

ومع ذلك ، فإن بعض مواقع الويب تمنع صراحة المستخدمين من تجريف بياناتهم باستخدام تجريف الويب. يعتبر تجريف البيانات من وسائل التواصل الاجتماعي أحيانًا غير قانوني.

والسبب في ذلك هو أن بعضًا منها لا يمكن الوصول إليه لعامة الناس ، مثل عندما يجعل المستخدم معلوماته خاصة. في هذه الحالة ، يحظر كشط هذه المعلومات. يمكن أيضًا اعتبار كشط المعلومات من مواقع الويب دون موافقة المالك أمرًا ضارًا.

احصل على أفضل ما في الويب من خلال Web Scraping!

إن جمع البيانات من مواقع الويب وتحليلها له تطبيقات محتملة واسعة في مجموعة واسعة من المجالات ، بما في ذلك علوم البيانات وذكاء الشركات والتقارير الاستقصائية.

واحدة من القدرات الأساسية التي يتطلبها عالم البيانات هي تجريف الويب.

ضع في اعتبارك أنه لن يرغب الجميع في الوصول إلى خوادم الويب الخاصة بهم للحصول على البيانات. قبل البدء في حذف موقع ويب ، تأكد من قراءة شروط الاستخدام. أيضًا ، ضع في اعتبارك عند توقيت استعلامات الويب الخاصة بك لتجنب إرباك الخادم.

روابط سريعة

- أفضل وكلاء لتجميع أجرة السفر

- أفضل وكلاء الفرنسية

- أفضل وكلاء Tripadvisor

- أفضل وكلاء Etsy

- رمز القسيمة IPRoyal

- أفضل وكلاء TikTok

- أفضل الوكلاء المشتركين

- أفضل وكلاء ألمانيا