7 ernsthafte Risiken, denen Sie beim Einsatz von KI für das Marketing ausgesetzt sind

Veröffentlicht: 2023-07-06Vor ein paar Jahren hatten die meisten von uns Vermarktern nicht die geringste Ahnung, wie man KI für das Marketing nutzen könnte. Plötzlich schreiben wir LinkedIn-Beiträge über die besten Aufforderungen, ChatGPT ins Ohr zu flüstern.

Es gibt viel zu feiern über die plötzliche Einbeziehung künstlicher Intelligenz in unsere Arbeit. McKenzie geht davon aus, dass KI für Vermarkter einen Wert von 2,6 Billionen US-Dollar freisetzen wird.

Aber unsere schnelle Einführung von KI könnte wichtige ethische, rechtliche und betriebliche Fragen vorwegnehmen – wodurch Vermarkter Risiken ausgesetzt werden, über die wir noch nie zuvor nachdenken mussten (z. B. können wir verklagt werden, wenn wir der KI sagen, sie solle „wie Stephen King schreiben?“) “).

Es gibt eine Menge KI-Staub in der Marketingatmosphäre, der sich erst nach Jahren legen wird. Ganz gleich, wie sehr Sie auch die Augen zusammenkneifen, Sie werden nicht alle potenziellen Fallstricke erkennen, die sich bei der Verwendung großer Sprachmodelle und maschinellem Lernen für die Erstellung von Inhalten und die Verwaltung von Anzeigen ergeben.

Unser Ziel in diesem Artikel ist es daher, sieben der größten Risiken des Einsatzes von KI für das Marketing aus einer sehr hohen Perspektive zu betrachten. Wir haben Ratschläge von Experten zusammengestellt, um diese Risiken zu mindern. Und wir haben zahlreiche Ressourcen hinzugefügt, damit Sie tiefer in die Fragen eintauchen können, die Sie am meisten beschäftigen.

Risiko Nr. 1: Voreingenommenheit beim maschinellen Lernen

Manchmal liefern Algorithmen für maschinelles Lernen Ergebnisse, die zu Unrecht zugunsten oder gegen jemanden oder etwas ausfallen. Es wird als „Machine Learning Bias“ oder „KI Bias“ bezeichnet und ist selbst bei den fortschrittlichsten tiefen neuronalen Netzen ein allgegenwärtiges Problem.

Es ist ein Datenproblem

Es ist nicht so, dass KI-Netzwerke von Natur aus bigott sind. Es liegt ein Problem mit den Daten vor, die in sie eingespeist werden.

Algorithmen des maschinellen Lernens funktionieren, indem sie Muster identifizieren, um die Wahrscheinlichkeit eines Ergebnisses zu berechnen, etwa ob einer bestimmten Käufergruppe Ihr Produkt gefallen wird oder nicht.

Was aber, wenn die Daten, auf denen die KI trainiert, auf eine bestimmte Rasse, ein bestimmtes Geschlecht oder eine bestimmte Altersgruppe ausgerichtet sind? Die KI kommt zu dem Schluss, dass diese Personen besser zusammenpassen, und passt das Anzeigenmotiv oder die Platzierung entsprechend an.

Ausgabe zur Voreingenommenheitswäsche pic.twitter.com/YQLRcq59lQ

— Janelle Shane (@JanelleCShane) 17. Juni 2021

Hier ist ein Beispiel. Forscher haben kürzlich die Anzeigenausrichtungssysteme von Facebook auf geschlechtsspezifische Vorurteile getestet. Die Ermittler schalteten eine Anzeige zur Rekrutierung von Lieferfahrern für Pizza Hut und eine ähnliche Anzeige mit den gleichen Qualifikationen für Instacart.

Der bestehende Pool an Pizza Hut-Fahrern ist überwiegend männlich, weshalb Facebook diese Anzeigen unverhältnismäßig häufig Männern zeigte. Instacart hat mehr weibliche Fahrer, daher wurden Anzeigen für ihre Stelle vor mehr Frauen geschaltet. Aber es gibt keinen inhärenten Grund, warum Frauen nichts über die Stellenangebote bei Pizza Hut wissen wollen würden, also ist das ein großer Fehltritt bei der Anzeigenausrichtung.

KI-Voreingenommenheit ist weit verbreitet

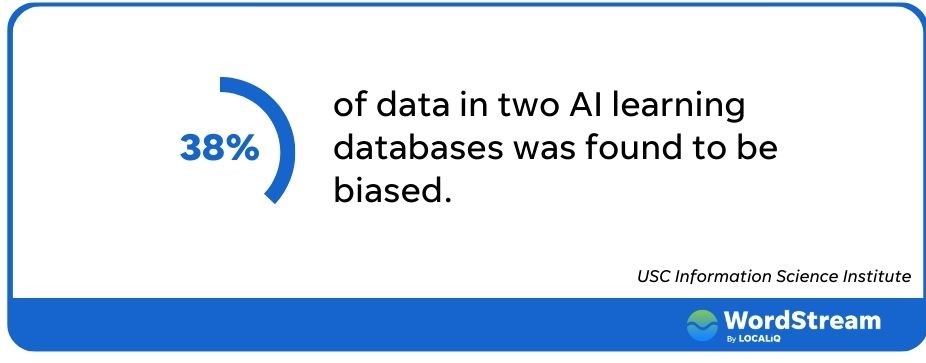

Das Problem geht weit über Facebook hinaus. Forscher des USC untersuchten zwei große KI-Datenbanken und stellten fest, dass über 38 % der darin enthaltenen Daten verzerrt waren. In der Dokumentation von ChatGPT wird sogar davor gewarnt, dass ihr Algorithmus möglicherweise „negative Stereotypen mit schwarzen Frauen“ in Verbindung bringt.

Die Verzerrung durch maschinelles Lernen hat mehrere Auswirkungen für Vermarkter. Das geringste davon ist die schlechte Anzeigenleistung. Wenn Sie möglichst viele potenzielle Kunden erreichen möchten, ist eine Ad-Targeting-Plattform, die große Teile der Bevölkerung ausschließt, alles andere als ideal.

Natürlich hat es größere Konsequenzen, wenn unsere Anzeigen bestimmte Gruppen ungerechtfertigt ansprechen oder ausschließen. Wenn Ihre Immobilienanzeige geschützte Minderheiten diskriminiert, könnten Sie auf der falschen Seite des Fair Housing Act und der Federal Trade Commission landen. Ganz zu schweigen davon, dass das inklusive Marketing-Boot völlig fehlt.

So vermeiden Sie KI-Voreingenommenheit

Was tun wir also, wenn unsere KI-Tools Amok laufen? Es gibt ein paar Schritte, die Sie unternehmen können, um sicherzustellen, dass Ihre Anzeigen alle gleich behandeln.

Stellen Sie zuallererst sicher, dass jemand Ihre Inhalte überprüft, schreibt Alaura Weaver, Senior Manager für Inhalte und Community bei Writer. „Obwohl die KI-Technologie erhebliche Fortschritte gemacht hat, mangelt es ihr an den kritischen Denk- und Entscheidungsfähigkeiten des Menschen“, erklärt sie. „Indem menschliche Redakteure KI-geschriebene Inhalte überprüfen und auf Fakten überprüfen, können sie sicherstellen, dass sie frei von Voreingenommenheit sind und ethischen Standards entsprechen.“

Durch die menschliche Aufsicht wird auch das Risiko negativer Ergebnisse bei bezahlten Werbekampagnen verringert.

„Derzeit und möglicherweise auf unbestimmte Zeit ist es nicht ratsam, Kampagnen oder jegliche Form des Marketings vollständig von KI übernehmen zu lassen“, sagt Brett McHale, der Gründer von Empiric Marketing. „KI funktioniert optimal, wenn sie genaue Eingaben von organischer Intelligenz erhält, die bereits große Mengen an Daten und Erfahrungen gesammelt hat.“

Risiko Nr. 2: Sachliche Irrtümer

Google kostete seine Muttergesellschaft kürzlich einen Wertverlust von 100 Milliarden US-Dollar, als sein neuer KI-Chatbot Bard in einem Werbe-Tweet eine falsche Antwort gab.

Bard ist ein experimenteller Konversations-KI-Dienst, der von LaMDA unterstützt wird. Es basiert auf unseren großen Sprachmodellen und stützt sich auf Informationen aus dem Internet. Es dient als Ausgangspunkt für Neugier und kann dabei helfen, komplexe Themen zu vereinfachen → https://t.co/fSp531xKy3 pic.twitter.com/JecHXVmt8l

– Google (@Google) 6. Februar 2023

Der Patzer von Google verdeutlicht eine der größten Einschränkungen von KI und eines der größten Risiken für Vermarkter, die sie einsetzen: KI sagt nicht immer die Wahrheit.

KI halluziniert

Ethan Mollic, Professor an der Wharton School of Business, beschrieb kürzlich KI-gestützte Systeme wie ChatGPT als „allwissenden, hilfsbereiten Praktikanten, der manchmal lügt“.

Natürlich ist KI nicht empfindungsfähig, auch wenn manche das behaupten. Es hat nicht die Absicht, uns zu täuschen. Es kann jedoch unter „Halluzinationen“ leiden, die dazu führen, dass es sich einfach etwas ausdenkt.

KI ist eine Vorhersagemaschine. Es versucht, das nächste Wort oder die nächste Phrase einzufügen, die Ihre Frage beantwortet. Aber es ist nicht selbstbewusst; KI verfügt nicht über eine Bauchprüfungslogik, um zu wissen, ob das, was sie aneinanderreiht, sinnvoll ist.

Im Gegensatz zur Voreingenommenheit scheint dies kein Datenproblem zu sein. Selbst wenn das Netzwerk über die richtigen Informationen verfügt, kann es uns immer noch das Falsche sagen.

Betrachten Sie dieses Beispiel, in dem ein Benutzer ChatGPT fragte: „Wie oft hat Argentinien die FIFA-Weltmeisterschaft gewonnen?“ Es hieß einmal und bezog sich auf den Sieg des Teams im Jahr 1978. Der Tweeter fragte dann, welches Team 1986 gewonnen habe.

#ChatGPT fragte, wer 2022 die FIFA-Weltmeisterschaft gewonnen habe. Keine Antwort möglich. Das wird erwartet. Es scheint jedoch falsche Informationen zu liefern (etwa bei den anderen beiden Siegen), obwohl die Informationen im System vorhanden sind. Irgendwelche #Erklärungen? pic.twitter.com/fvxe05N12p

— indranil sinharoy (@indranil_leo) 29. Dezember 2022

Der Chatbot gab zu, dass es sich um Argentinien handelte, ohne eine Erklärung für seinen früheren Fauxpas zu geben.

Das Besorgniserregende daran ist, dass die falschen Antworten der KI oft so sicher geschrieben sind, dass sie mit dem sie umgebenden Text verschmelzen und sie völlig plausibel erscheinen lassen. Sie können auch umfassend sein, wie in einer gegen Open.ai eingereichten Klage dargelegt, in der ChatGPT angeblich eine ganze Unterschlagungsgeschichte erfunden hat, die dann von einem Journalisten geteilt wurde.

Wie man KI-Halluzinationen vermeidet

Während KI Sie bereits bei Antworten auf einzelne Wörter in die Irre führen kann, ist es beim Schreiben längerer Texte wahrscheinlicher, dass sie aus dem Ruder läuft.

„Aus einer einzigen Eingabeaufforderung heraus kann KI einen Blog oder ein E-Book generieren. Ja, das ist erstaunlich – aber es gibt einen Haken“, warnt Weaver. „Je mehr es generiert, desto mehr Bearbeitung und Faktenprüfung müssen Sie durchführen.“

Um die Wahrscheinlichkeit zu verringern, dass Ihr KI-Tool anfängt, halluzinatorische Erzählungen zu spinnen, ist es laut Weaver am besten, eine Gliederung zu erstellen und den Bot diese Abschnitt für Abschnitt bearbeiten zu lassen. Und dann lassen Sie natürlich jemanden die darin enthaltenen Fakten und Statistiken überprüfen.

Risiko Nr. 3: Falsche Anwendung von KI-Tools

Jeden Morgen wachen wir mit einer neuen Generation von KI-Tools auf, die scheinbar über Nacht wie Pilze nach einem Regensturm aus dem Boden schossen.

Doch nicht jede Plattform ist für alle Marketingfunktionen ausgelegt und einige Marketingherausforderungen können (noch) nicht durch KI gelöst werden.

KI-Tools haben Einschränkungen

ChatGPT ist ein großartiges Beispiel. Es macht Spaß, mit der Schönheit des KI-Balls zu spielen (wie im Stil der King-James-Bibel zu schreiben, wie man ein Erdnussbutter-Sandwich aus einem Videorecorder entfernt). Und es kann einige überraschend gut geschriebene Kurzantworten hervorbringen, die Schreibblockaden beseitigen. Aber bitten Sie es nicht, Ihnen bei der Keyword-Recherche zu helfen.

ChatGPT scheitert an seinem relativ alten Datensatz, der nur Informationen vor 2022 enthält. Bitten Sie es, Schlüsselwörter für „KI-Marketing“ anzubieten, und die Antworten werden nicht mit denen übereinstimmen, die Sie in anderen Tools wie Thinword oder Contextminds finden.

Ebenso verfügen sowohl Google als auch Facebook über neue KI-gestützte Tools, die Vermarktern dabei helfen, Anzeigen zu erstellen, Werbeausgaben zu optimieren und das Werbeerlebnis zu personalisieren. Ein Chatbot kann diese Herausforderungen nicht lösen.

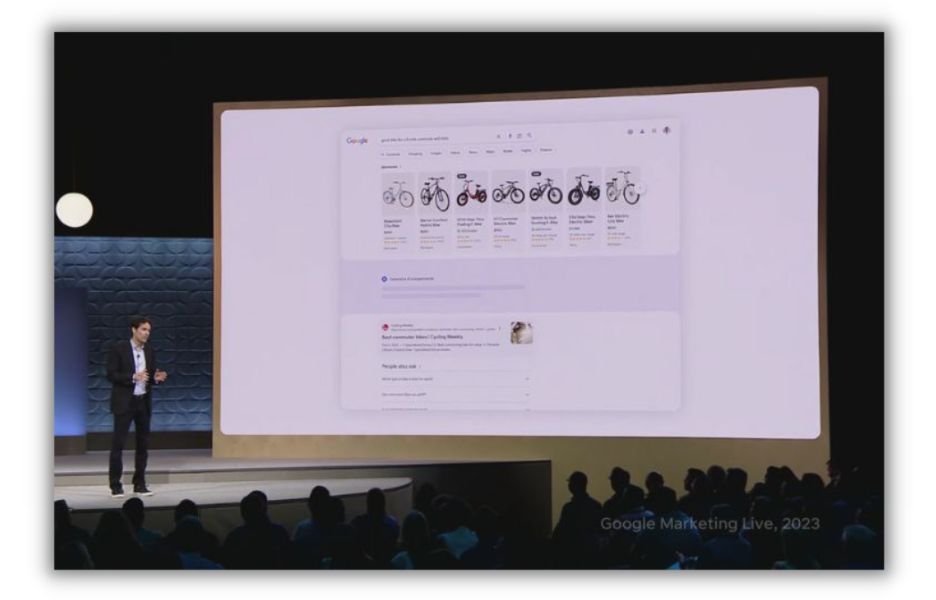

Google kündigte auf der Google Marketing Live-Veranstaltung 2023 eine Reihe von KI-Upgrades für seine Such- und Anzeigenverwaltungsprodukte an.

Sie können KI überbeanspruchen

Wenn Sie einem KI-Tool eine einzelne Aufgabe zuweisen, kann es zu einer Überindizierung nur eines Ziels kommen. Nick Abbene, ein Experte für Marketingautomatisierung, sieht dies häufig bei Unternehmen, die sich auf die Verbesserung ihrer SEO konzentrieren.

„Das größte Problem, das ich sehe, ist der blinde Einsatz von SEO-Tools, die übermäßige Optimierung für Suchmaschinen und die Missachtung der Suchabsichten der Kunden“, sagt Abbene. „SEO-Tools eignen sich hervorragend, um Suchmaschinen qualitativ hochwertige Inhalte zu signalisieren. Aber letztendlich möchte Google der Anfrage des Suchenden entsprechen.“

So vermeiden Sie eine Fehlanwendung von KI-Tools

Ein Schraubenschlüssel ist nicht die beste Option zum Einschlagen von Nägeln. Ebenso ist ein KI-Schreibassistent möglicherweise nicht für die Erstellung von Webseiten geeignet. Bevor Sie sich auf eine KI-Option einlassen, sollten Sie laut Abbene Feedback vom Entwickler des Tools und anderen Benutzern einholen.

„Um eine Fehlauswahl von KI-Tools zu vermeiden, sollten Sie herausfinden, ob andere Vermarkter das Tool für Ihren Anwendungsfall verwenden“, sagt er. „Fordern Sie gerne eine Produktdemo an oder testen Sie es zusammen mit anderen Tools, die die gleiche Funktionalität bieten.“

Auf Websites wie Capterra können Sie schnell mehrere KI-Plattformen vergleichen.

Und wenn Sie den richtigen KI-Toolstack gefunden haben, nutzen Sie ihn, um den Prozess zu unterstützen, und nicht, ihn zu übernehmen. „Haben Sie keine Angst davor, KI-Tools zur Verbesserung Ihres Arbeitsablaufs zu verwenden, aber nutzen Sie sie genau dafür“, sagt Abbene. „Beginnen Sie jeden Inhalt mit Grundprinzipien, mit einer hochwertigen Keyword-Recherche und einem Verständnis der Suchabsicht.“

Risiko Nr. 4: Homogener Inhalt

KI kann einen ganzen Aufsatz in etwa 10 Sekunden schreiben. Aber so beeindruckend die generative KI auch geworden ist, ihr fehlt die Nuance, um wirklich kreativ zu sein, sodass ihre Ergebnisse oft, nun ja, roboterhaft wirken.

„Obwohl KI gut darin ist, informative Inhalte zu produzieren, mangelt es ihr oft an der Kreativität und dem Engagement, die Menschen mitbringen“, sagt Weaver.

KI ist zum Nachahmen da

Bitten Sie einen generativen KI-Schreibroboter, Ihren Buchbericht zu verfassen, und er wird problemlos 500 Wörter hervorbringen, die das Hauptthema von Catcher in the Rye kompetent erklären (vorausgesetzt, Holden Caulfield wird nicht als Bankräuber halluziniert).

Das ist möglich, weil es Tausende von Texten über JD Salingers Meisterwerk aufgenommen hat.

Bitten Sie nun Ihren KI-Freund, einen Blogbeitrag zu schreiben, der ein Kernkonzept Ihres Unternehmens auf eine Weise erklärt, die Ihre Marke, Ihr Publikum und Ihr Wertversprechen zusammenfasst. Sie könnten enttäuscht sein. „KI-generierte Inhalte berücksichtigen nicht immer die Nuancen der Persönlichkeit und Werte einer Marke und können zu Inhalten führen, die das Ziel verfehlen“, sagt Weaver.

Mit anderen Worten: KI ist hervorragend darin, bereits Geschaffenes zu verdauen, zu kombinieren und neu zu konfigurieren. Es ist nicht besonders gut, etwas zu schaffen, das sich von bestehenden Inhalten abhebt.

Generative KI-Tools sind auch nicht gut darin, Inhalte ansprechend zu gestalten. Sie produzieren gerne riesige Wortblöcke ohne ein Bild, eine Grafik oder einen Aufzählungspunkt, um müden Augen eine Pause zu gönnen. Sie ziehen keine Kundengeschichten oder hypothetischen Beispiele heran, um einen Punkt nachvollziehbarer zu machen. Und es würde ihnen schwerfallen, eine Nachrichtenmeldung aus Ihrer Branche mit dem Nutzen zu verbinden, den Ihr Produkt bietet.

So vermeiden Sie homogene Inhalte

Einige KI-Tools wie Writer verfügen über integrierte Funktionen, die Autoren dabei helfen, eine konsistente Markenpersönlichkeit zu bewahren. Sie benötigen jedoch weiterhin einen Redakteur, der „den Inhalt überprüft und auf Markenstimme und Tonalität hin bearbeitet, um sicherzustellen, dass er beim Publikum Anklang findet und die Botschaften und Ziele der Organisation unterstreicht“, rät Weaver.

Redakteure und Autoren können einen Artikel auch wie andere Menschen sehen. Wenn es einen undurchdringlichen Wortblock gibt, werden sie es sein, der ihn auflöst und ein wenig visuelles Zhuzh hinzufügt.

Nutzen Sie KI-Inhalte als Ausgangspunkt – um Ihre Kreativität und Forschung anzukurbeln. Aber fügen Sie immer Ihre ganz persönliche Note hinzu.

Risiko Nr. 5: SEO-Verlust

Googles Haltung zu KI-Inhalten war etwas unklar. Zunächst schien es, als würde die Suchmaschine mit KI verfasste Beiträge bestrafen.

[Bild: Tweet von John Mueller über KI]

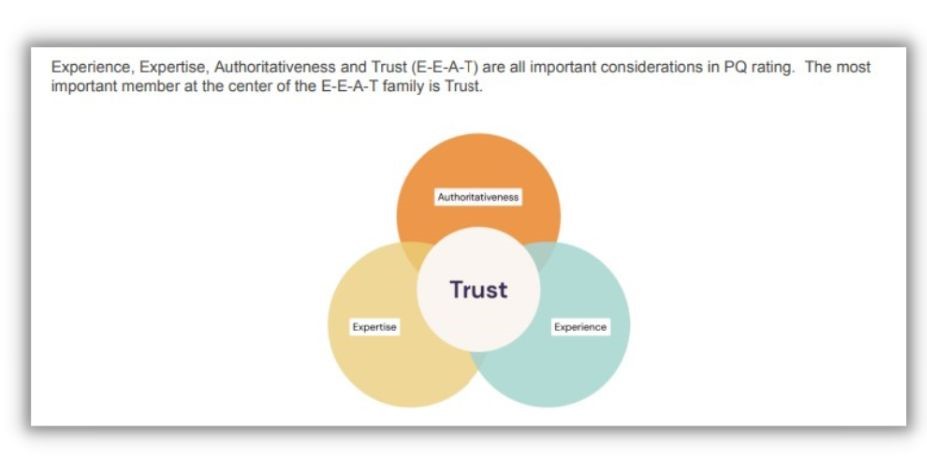

Kürzlich hieß es im Entwicklerblog von Google, dass KI in ihrem Buch in Ordnung sei. Aber in dieser Bestätigung steckt ein deutliches Augenzwinkern. Nur „Inhalte, die Qualitäten dessen aufweisen, was wir EEAT nennen: Fachwissen, Erfahrung, Autorität und Vertrauenswürdigkeit“, werden die menschlichen Suchbewerter beeindrucken, die die Ranking-Systeme von Google kontinuierlich bewerten.

Vertrauen ist für SEO das A und O

Bei Googles EEAT ist Vertrauen der einzige Faktor, der sie alle beherrscht.

[Quelle]

Wir haben bereits darüber gesprochen, dass KI-Inhalte anfällig für Trugschlüsse sind und daher ohne menschliche Aufsicht grundsätzlich nicht vertrauenswürdig sind. Außerdem erfüllt es nicht die unterstützenden Anforderungen, da es naturgemäß nicht von jemandem geschrieben wurde, der über Fachwissen, Autorität oder Erfahrung zu diesem Thema verfügt.

Nehmen Sie einen Blogbeitrag über das Backen von Bananenbrot. Ein KI-Bot gibt Ihnen in etwa zwei Sekunden ein Rezept. Aber an den kalten Wintertagen, an denen er für seine Familie backt, kann er nicht poetisch werden. Oder sprechen Sie über die Jahre, die Sie als gewerblicher Bäcker damit verbracht haben, mit verschiedenen Mehlsorten zu experimentieren. Nach diesen Perspektiven suchen die Suchmaschinenbewerter von Google.

Es scheint auch das zu sein, wonach sich die Menschen sehnen. Deshalb wenden sich so viele von ihnen in TikTok-Videos an echte Menschen, um Dinge zu erfahren, die sie früher bei Google gefunden haben.

So vermeiden Sie SEO-Verluste

Das Tolle an KI ist, dass es ihr nichts ausmacht, Verfasser zu teilen. Wenn Sie also einen Chatbot verwenden, um die Inhaltsproduktion zu beschleunigen, stellen Sie sicher, dass Sie auf einen menschlichen Autor mit Referenzen verweisen.

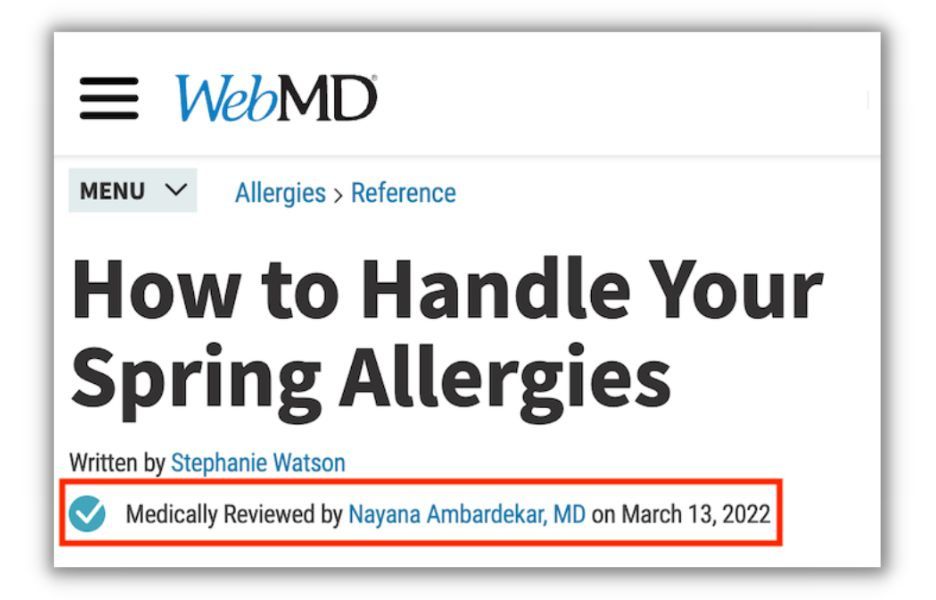

Dies gilt insbesondere für sensible Themen wie Gesundheitswesen und persönliche Finanzen, die Google als „Ihr Geld, Ihr Leben“-Themen bezeichnet. „Wenn Sie in einer YMYL-Branche tätig sind, legen Sie bei Ihren Inhalten vor allem Wert auf Autorität, Vertrauen und Genauigkeit“, rät Elisa Gabbert, Director of Content and SEO für WordStream und LocaliQ.

Wenn Sie beispielsweise über das Gesundheitswesen schreiben, lassen Sie Ihre Beiträge von einem Mediziner überprüfen und verweisen Sie im Beitrag darauf. Das ist ein starkes Signal für Google, dass Ihre Inhalte vertrauenswürdig sind, auch wenn sie in einem Chatbot gestartet wurden.

Risiko Nr. 6: Rechtliche Herausforderungen

Generative KI lernt aus der von Menschen geschaffenen Arbeit und erschafft dann etwas Neues. Die Frage des Urheberrechts ist sowohl für die Eingabe als auch für die Ausgabe des KI-Inhaltsmodells unklar.

Bestehende Arbeiten sind wahrscheinlich ein faires Spiel für KI

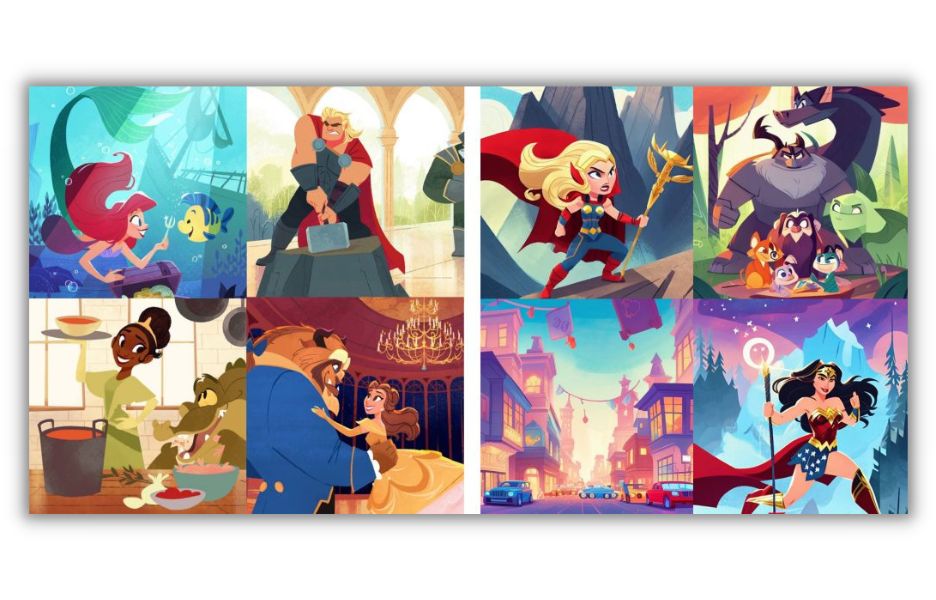

Um (Wortspiel beabsichtigt) die Urheberrechtsfrage für Werke zu veranschaulichen, die große Lernmodelle unterstützen, wenden wir uns einem Fall zu, über den der Technologe Andy Baio berichtet. Wie Baio erklärt, erfuhr eine in LA ansässige Künstlerin namens Hollie Mengert, dass 32 ihrer Illustrationen in ein KI-Modell aufgenommen und dann über eine offene Lizenz jedem angeboten wurden, der ihren Stil nachbilden wollte.

Bildunterschrift: Eine Sammlung der Illustrationen der Künstlerin Hollie Mengert (links) im Vergleich zu KI-generierten Illustrationen basierend auf ihrem Stil, kuratiert von Andy Baio .

Die Geschichte wird noch komplizierter, wenn man erfährt, dass sie viele ihrer Bilder für Kunden wie Disney erstellt hat, die tatsächlich die Rechte daran besitzen.

Können Illustratoren (oder Autoren oder Programmierer), die sich in der gleichen Lage wie Mengert befinden, erfolgreich wegen Urheberrechtsverletzung klagen?

Eine eindeutige Antwort auf die Frage gibt es noch nicht. „Ich sehe Menschen auf beiden Seiten äußerst zuversichtlich in ihren Positionen, aber die Realität ist, dass niemand es weiß“, sagte Baio gegenüber The Verge. „Und wer sagt, er wisse genau, wie es vor Gericht ausgehen wird, der irrt.“

Wenn die KI, die Sie zum Erstellen eines Bildes oder Artikels verwenden, an Tausenden von Werken vieler Urheber trainiert wurde, ist es unwahrscheinlich, dass Sie ein Gerichtsverfahren verlieren. Aber wenn Sie die Maschine mit zehn Stephen-King-Büchern füttern und dem Bot sagen, er solle ein neues in diesem Stil schreiben, könnten Sie in Schwierigkeiten geraten.

Haftungsausschluss: Wir sind keine Anwälte. Bitte holen Sie sich rechtlichen Rat ein, wenn Sie sich nicht sicher sind.

Auch Ihre KI-Inhalte sind möglicherweise nicht geschützt

Was ist mit Inhalten, die Sie mithilfe eines Chatbots erstellen? Fallen diese unter das Urheberrecht? In den meisten Fällen ist dies nicht der Fall, es sei denn, Sie haben viel Arbeit in die Bearbeitung investiert. Das bedeutet, dass Sie kaum Rückgriffsmöglichkeiten haben, wenn jemand Ihre Beiträge für seinen eigenen Blog umfunktioniert (sprich: stiehlt).

Bei geschützten Inhalten liegt möglicherweise der Programmierer der KI und nicht Sie im Besitz der Rechte. In vielen Ländern gilt der Hersteller des Werkzeugs, mit dem ein Werk erstellt wurde, als sein Schöpfer, nicht die Person, die die Eingabeaufforderung eingegeben hat.

So vermeiden Sie rechtliche Herausforderungen

Beginnen Sie mit der Verwendung eines seriösen Tools zur Erstellung von KI-Inhalten. Finden Sie eines mit vielen positiven Bewertungen eines Unternehmens, das seine Haltung zum Urheberrecht klar zum Ausdruck bringt.

Nutzen Sie außerdem Ihr gutes Urteilsvermögen, um zu entscheiden, ob Sie absichtlich die Arbeit eines Schöpfers kopieren oder einfach KI verwenden, um Ihre eigene zu erweitern.

Und wenn Sie eine Chance vor Gericht haben wollen, um Ihre Produkte zu schützen, nehmen Sie viele wesentliche Änderungen vor. Oder verwenden Sie KI, um eine Gliederung zu erstellen, aber schreiben Sie die meisten Wörter selbst.

Risiko Nr. 7: Sicherheits- und Datenschutzverletzungen

KI-Tools stellen Vermarkter vor ein breites Spektrum potenzieller Bedrohungen für die Sicherheit und den Datenschutz ihres Systems. Bei einigen handelt es sich um direkte Angriffe von böswilligen Akteuren. Bei anderen handelt es sich einfach um Benutzer, die unabsichtlich vertrauliche Informationen an ein System weitergeben, das diese weitergeben soll.

Sicherheitsrisiken durch KI-Tools

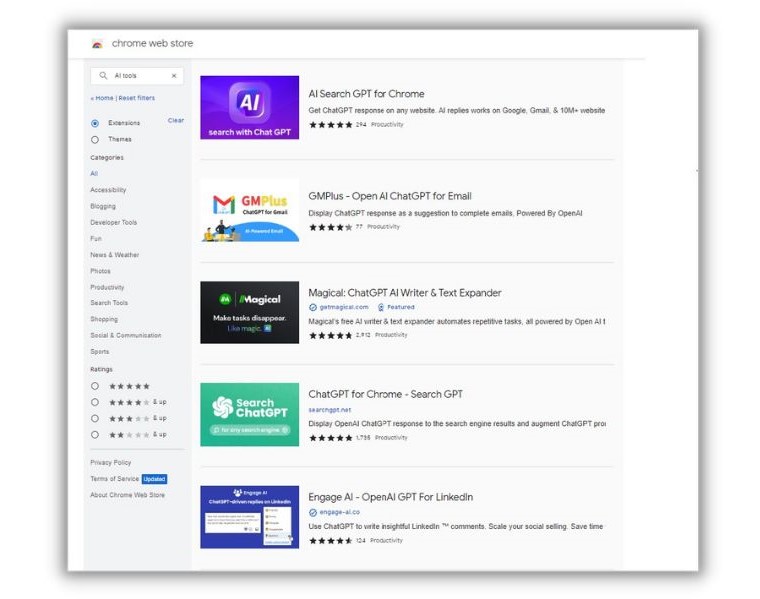

„Es gibt viele Produkte, die wie legitime Tools aussehen, sich anfühlen und sich verhalten, in Wirklichkeit aber Malware sind“, sagte uns Elaine Atwell, leitende Redakteurin für Content Marketing beim Endpoint-Sicherheitsanbieter Kolide. „Sie sind äußerst schwer von legitimen Tools zu unterscheiden und Sie können sie derzeit im Chrome Store finden.“

Geben Sie eine beliebige Version von „KI-Tools“ in den Google Chrome Store ein und Sie werden feststellen, dass es Ihnen an Optionen nicht mangelt.

Atwell hat im Kolide-Blog über diese Risiken geschrieben. In ihrem Artikel verwies sie auf einen Vorfall, bei dem eine Chrome-Erweiterung namens „Schnellzugriff auf Chat GPT“ tatsächlich eine List war. Nach dem Herunterladen kaperte die Software die Facebook-Konten der Benutzer und löschte alle Cookies des Opfers – auch die aus Sicherheitsgründen. Laut Atwell haben täglich über 2.000 Menschen die Erweiterung heruntergeladen.

Privatsphäre ungeschützt

Laut Atwell kann selbst ein legitimes KI-Tool ein Sicherheitsrisiko darstellen. „…derzeit verfügen die meisten Unternehmen nicht einmal über Richtlinien zur Bewertung der Arten und Ausmaße des Risikos, das von verschiedenen Erweiterungen ausgeht. Und da es keine klare Anleitung gibt, installieren Menschen auf der ganzen Welt diese kleinen Helfer und füttern sie mit sensiblen Daten.“

Nehmen wir an, Sie schreiben einen internen Finanzbericht, den Sie den Anlegern zur Verfügung stellen möchten. Denken Sie daran, dass KI-Netzwerke aus dem, was ihnen gegeben wird, lernen, um Ausgaben für andere Benutzer zu erstellen. Alle Daten, die Sie in den KI-Chatbot eingeben, könnten für Personen außerhalb Ihres Unternehmens ein faires Spiel sein. Und kann auftauchen, wenn ein Konkurrent Sie nach Ihrem Endergebnis fragt.

So vermeiden Sie Datenschutz- und Sicherheitsrisiken

Die erste Verteidigungslinie besteht darin, sicherzustellen, dass eine Software das ist, was sie vorgibt zu sein. Seien Sie darüber hinaus vorsichtig bei der Verwendung der von Ihnen gewählten Tools. „Wenn Sie KI-Tools verwenden (und sie haben durchaus Verwendungsmöglichkeiten!), geben Sie ihnen keine Daten, die als sensibel gelten könnten“, sagt Atwell.

Erkundigen Sie sich auch nach deren Datenschutz- und Sicherheitsrichtlinien, während Sie KI-Tools auf ihren Nutzen und ihre Voreingenommenheit überprüfen.

Reduzieren Sie die Risiken des Einsatzes von KI für Marketingzwecke

Die KI schreitet mit unglaublicher Geschwindigkeit voran. In weniger als einem Jahr hat Chat GTP seine Fähigkeiten bereits erheblich gesteigert. Es ist unmöglich zu wissen, was wir mit KI in den nächsten sechs bis zwölf Monaten erreichen können. Wir können die potenziellen Probleme auch nicht vorhersehen.

Hier sind mehrere Möglichkeiten, wie Sie Ihre KI-Marketingergebnisse verbessern und gleichzeitig einige der häufigsten Risiken vermeiden können:

- Lassen Sie die Inhalte von menschlichen Redakteuren auf Qualität, Lesbarkeit und Markenstimme prüfen

- Überprüfen Sie jedes von Ihnen verwendete Tool auf Sicherheit und Leistungsfähigkeit

- Überprüfen Sie das KI-gesteuerte Anzeigen-Targeting regelmäßig auf Verzerrungen

- Untersuchen Sie Texte und Bilder auf mögliche Urheberrechtsverletzungen

Wir möchten Elain Attwell, Brett McHale, Nick Abenne und Alaura Weaver für ihren Beitrag zu diesem Beitrag danken.

Um es noch einmal zusammenzufassen: Sehen wir uns unsere Liste der Risiken an, die mit der Verwendung von KI für Marketingzwecke einhergehen:

- Voreingenommenheit beim maschinellen Lernen

- Faktische Irrtümer

- Falsche Anwendung von KI-Tools

- Homogener Inhalt

- Verlust von SEO

- Rechtliche Herausforderungen

- Sicherheits- und Datenschutzverletzungen