Liste der 22+ besten Web Scraping Tools 2022 Was ist das beste Tool für Web Scraping?

Veröffentlicht: 2022-10-21

Schabender Roboter

Die Scraper-API verarbeitet Proxys, Browser und CAPTCHAs, sodass Sie den HTML-Code von jeder Webseite mit einem einfachen API-Aufruf abrufen können!

Helle Daten (ehemals Luminati)

Bright Data (ehemals Luminati) ist ein weltweit größter Proxy-Dienst mit einem privaten Proxy-Netzwerk von 72 Millionen IPs weltweit und einer Proxy-Verwaltungsschnittstelle ohne Codierung. Starten Sie eine kostenlose 7-Tage-Testversion.

Scraper-API

Die Scraper-API verarbeitet Proxys, Browser und CAPTCHAs, sodass Sie den HTML-Code von jeder Webseite mit einem einfachen API-Aufruf abrufen können!

In diesem Beitrag haben wir die besten Web Scraping Tools aufgelistet, die Sie jetzt ausprobieren sollten. Tauchen wir also ein.

Web-Scraping-Tools wurden speziell zum Extrahieren von Daten aus Websites entwickelt. Diese Tools, die auch als Web Harvesting Tools oder Web Data Extraction Tools bekannt sind, sind hilfreich für Personen, die Daten oder Informationen von Internetseiten sammeln möchten. Web Scraping ist die moderne Dateneingabetechnik, die das wiederholte Eintippen oder Kopieren und Einfügen von Informationen überflüssig macht.

Diese Art von Software sucht entweder manuell oder automatisch nach neuen Daten und ruft die aktualisierten Daten ab und speichert sie, damit Sie leicht darauf zugreifen können. Beispielsweise können Sie mit Hilfe eines Scraping-Tools Informationen über die Produkte und deren Kosten von Amazon sammeln.

Wenn Sie Daten von einer Website in eine Tabellenkalkulation oder eine Datenbank oder an einen anderen zentralen Ort kopieren, um sie später abzurufen, dann schaben Sie das Web. Aber wenn Sie es manuell tun, kann es viel Zeit in Anspruch nehmen.

Sie können diesen Datenerfassungsprozess automatisch mit Web-Scraping-Tools durchführen.

Sie können Web Scraping mit Hilfe der folgenden acht Techniken durchführen:

- Document Object Model (DOM)-Parsing

- HTML-Parsing

- Manuelles Kopieren und Einfügen

- Vertikale Aggregation

- Textmusterabgleich

- Semantische Annotationserkennung

- Computer Vision Webseitenanalyse

- HTTP-Programmierung

Inhaltsverzeichnis

Auf der Suche nach den besten Web-Scraping-Tools des Jahres 2021?

Verfahren wie Web Scraping, HTML Scraping oder jede andere Form der Datenextraktion können komplex sein. Vom Ermitteln der genauen Seitenquelle und der genauen Überprüfung der Quelle bis hin zum Rendern des Javascripts und dem Erhalten der Daten in einer verwendbaren Konfiguration gibt es tatsächlich viel zu tun. Während verschiedene Benutzer unterschiedliche Anforderungen haben, stehen Tools für jeden zur Verfügung – Personen, die Web Scraper ohne Codierung erstellen möchten, Entwickler, die Web Crawler erstellen möchten, um größere Websites zu durchsuchen, und vieles mehr

In diesem Beitrag listen wir die 20 besten Web-Scraping-Tools zum Sammeln von Daten ohne Codierung auf. Wir haben auch 4 ergänzende Tools nach der Top-20-Liste aufgelistet, sodass Sie aus 24 Web-Scraping-Tools auswählen können.

Top 22+ der besten Web-Scraping-Tools 2022:

Hier ist eine Liste der 20 besten Web-Scraping-Tools für Oktober 2022, die Sie verwenden sollten, um die Datenextraktionsanforderungen Ihrer Website zu erfüllen. Diese Tools wurden sowohl von Benutzern als auch von Kritikern für ihre Funktionen, Gesamtleistung, Preise und andere Schlüsselaspekte als einige der besten Tools, die Sie für Web Scraping verwenden können, gelobt.

1) Bright Data (ehemals Luminati) Nr. 1 der besten Web-Scraping-Tools

Luminati Networks hat ein Datenerfassungstool der nächsten Generation entwickelt, das einen integrierten und personalisierten Datenfluss in einem einzigen, leicht verständlichen Dashboard bietet. Die Datensätze werden auf die Bedürfnisse Ihres Unternehmens zugeschnitten und reichen von E-Commerce-Trends und Social-Media-Inhalten bis hin zu Business Intelligence und Verbraucherbefragungen.

Werkzeuge und Funktionen:

- Sie können automatisierte Datenintelligenz vom Data Collector abrufen, wann und wo immer Sie möchten.

- Eine komplizierte Datenerfassungsplattform ist nicht erforderlich.

- Sie haben die vollständige Kontrolle über den Datenerfassungsprozess.

- Datenentblocker

- Mit dem Luminati-Proxy-Manager können Sie Ihre Proxys wie ein Profi ohne Codierung handhaben.

- Innerhalb weniger Minuten haben Sie einen stabilen Datenfluss.

- Mit einer einzigen Bestellung können Sie mit ihrem Suchmaschinen-Crawler der nächsten Generation echte Benutzersuchergebnisse für jedes Schlüsselwort in allen wichtigen Suchmaschinen erhalten.

- Vielseitige und substitutsensible Datenerhebung auf der Zielseite, was zu einer hohen Erfolgsquote führt.

- Ihre benutzerfreundliche Browsererweiterung macht es einfach, auf bestimmte Geolokalisierungen abzuzielen und Ihre Proxy-Einstellungen zu ändern.

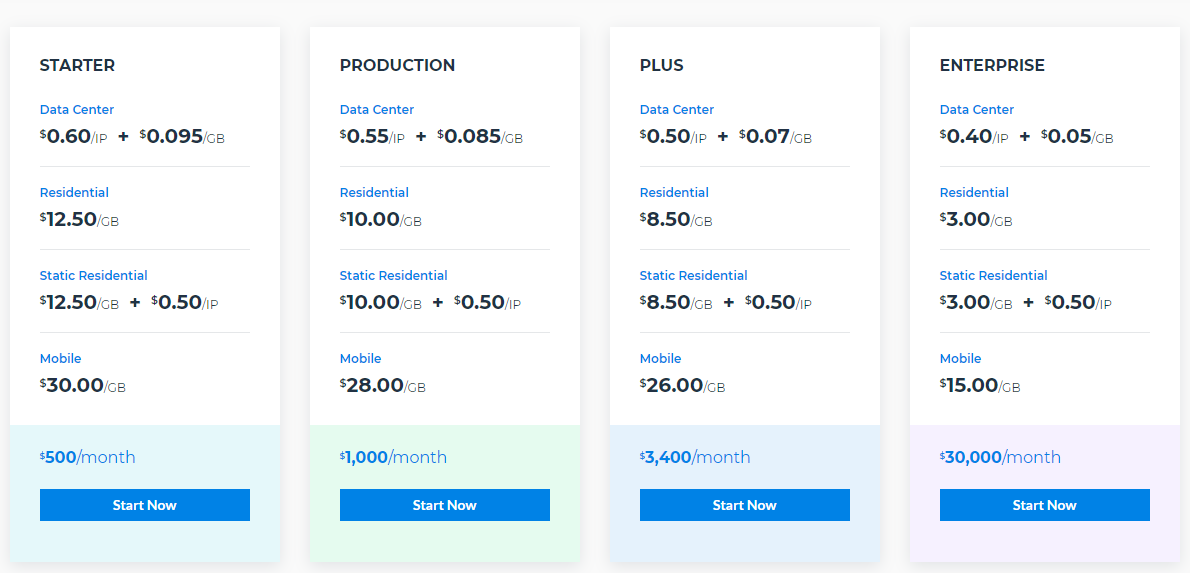

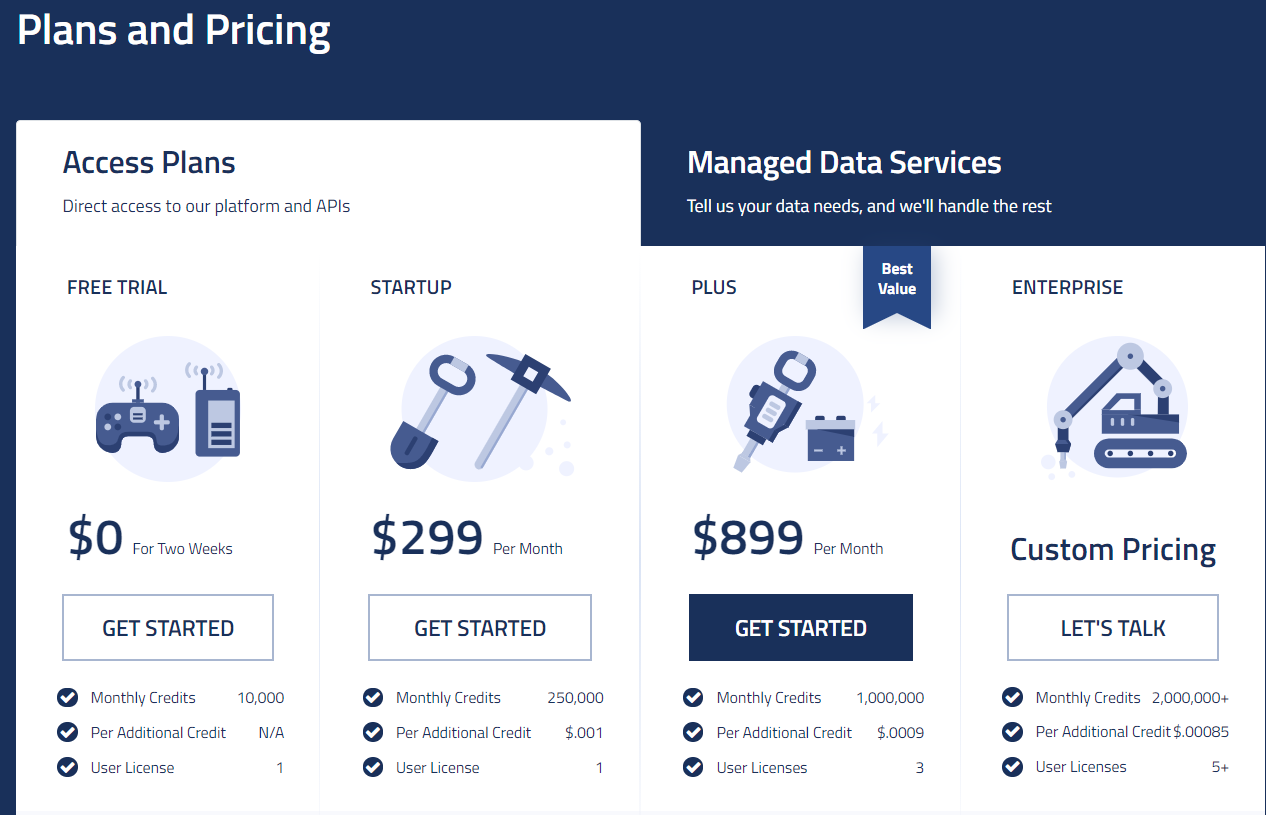

Preisgestaltung

2) Scraping Robot #2 Bestes Web-Scraping-Tool

Scraping Robot ist ein effektives, benutzerfreundliches Web-Scraping-Tool. Da es sehr einfach zu bedienen ist, ist es für Anfänger geeignet. Es verfügt über einige moderne Tools und Funktionen, die die meisten anderen verfügbaren Websites nicht bieten, und selbst wenn dies der Fall ist, werden Ihnen viel mehr berechnet.

Dies ist das beste Tool für die Datenerfassung und um Ihr Geschäft anzukurbeln. Sie haben mehrere Partnerschaften in der Industrie aufgebaut, um den Preis an mehreren Stellen zu senken, und ein gut organisiertes Verfahren aufgebaut, das die Entwicklungs- und technischen Kosten senkt. All diese Merkmale schaffen somit ein Produkt, das eine höhere Leistung zu einem niedrigeren Preis als die Konkurrenz bietet.

Werkzeuge und Funktionen

- Modulfilter:

Obwohl sich diese Funktion in der Entwicklung befindet, können sie in der kommenden Zukunft Funktionen wie Produktfilter und Profilfilter hinzufügen.

- Demo-Bibliothek:

Diese Bibliothek enthält alle Details und Informationen darüber, wie jedes Modul funktioniert.

- API:

Sie geben ihren Kunden Zugriff auf Entwicklerebene. Dies kann Ihnen helfen, Proxys, Server und Entwicklerressourcen zu organisieren und zu verwalten.

- Fahrplan:

Unter diesem Segment können Sie sehen, was sie allesamt für die Zukunft konzipiert haben. Dadurch erfahren Sie, welche Funktionen in der kommenden Zukunft für Sie verfügbar sein werden.

Es gliedert sich in drei Teile:

- Live

- Im Gange

- Geplant

Sie können auch für einige Funktionen stimmen oder diese vorschlagen. Sie versprechen auch, immer mehr Funktionen auf ihre Preisseite zu bringen.

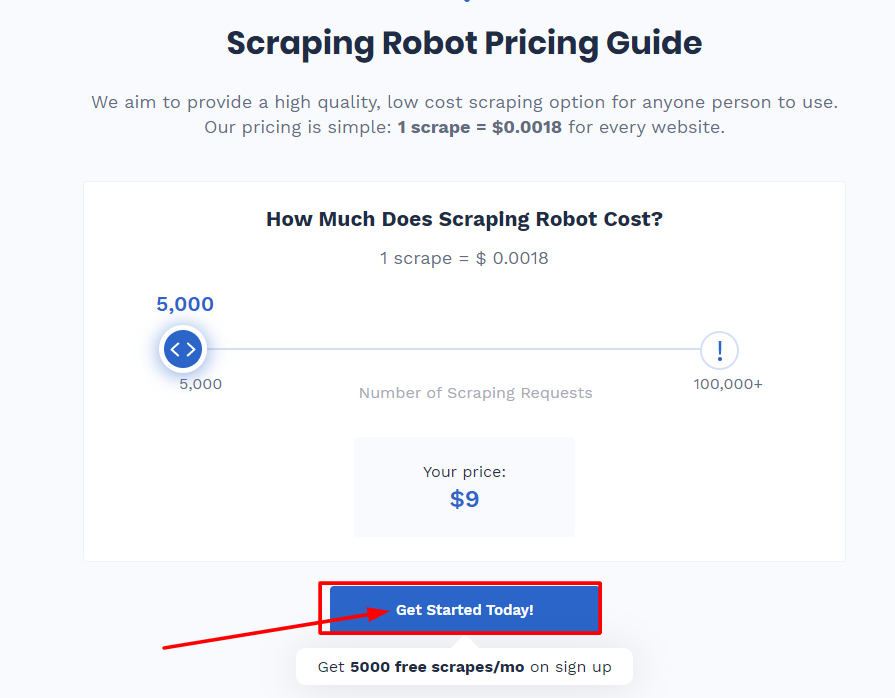

Pläne und Preise

Wenn Sie sich anmelden, erhalten Sie jeden Monat kostenlos 5.000 Scraps. Dies ist völlig ausreichend, wenn die gesuchten Daten weniger sind, aber wenn Sie mehr Daten benötigen, müssen Sie 0,0018 USD pro Scraping bezahlen. Grund dafür ist ihrer Meinung nach die Zusammenarbeit mit Blazing SEO, dem Premium-Proxy-Anbieter.

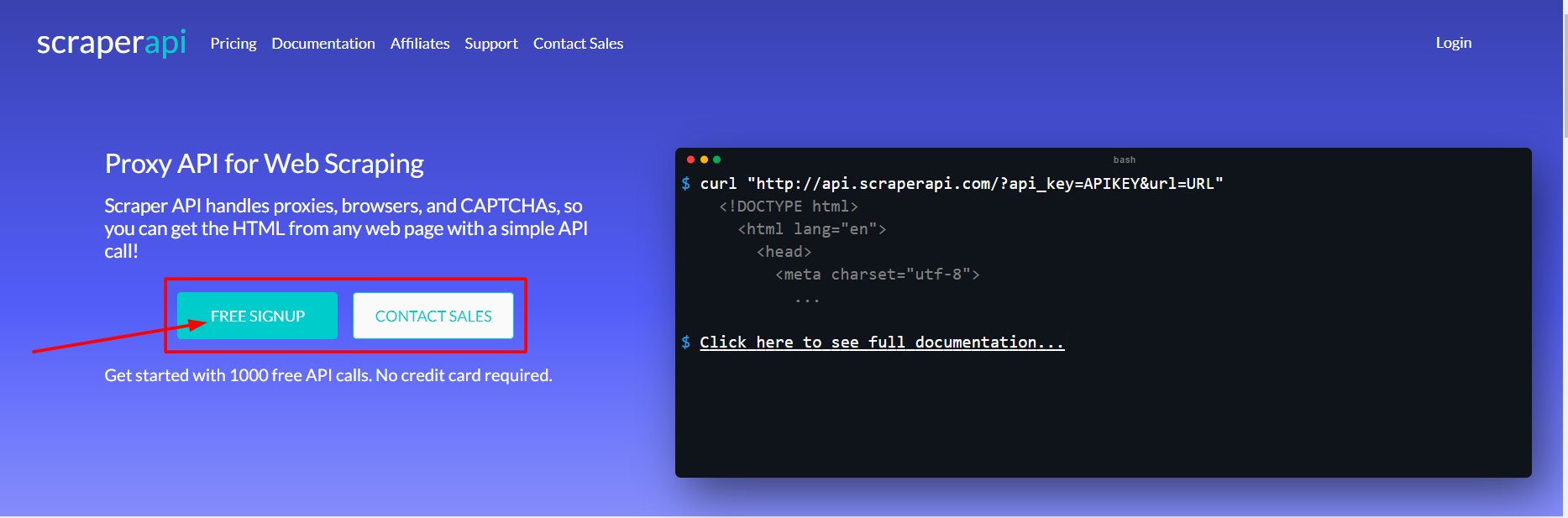

3) Scraper-API Nr. 3 der besten Web-Scraping-Tools

Scraper API ist ein Programm, mit dem Programmierer Web Scraper erstellen können. Es funktioniert für Proxys, Browser und CAPTCHAs und ermöglicht es Entwicklern, den rohen HTML-Code von jeder Website mit einem einfachen API-Aufruf abzurufen.

Es ist die ultimative Web-Scraping-Plattform für Entwickler mit dedizierten Proxy-Pools für Social Media Scraping, Ticket Scraping, Search Engine Scraping, eCommerce Price Scraping und mehr! l. Wenn Sie monatlich eine große Anzahl von Seiten benötigen, können Sie einen Mengenrabatt beantragen.

Werkzeuge und Funktionen

- Es hilft Ihnen, JavaScript zu rendern

- Sie können die Header jeder Anfrage und auch die Art der Anfrage anpassen

- Es bietet außergewöhnliche Geschwindigkeit und Zuverlässigkeit, was beim Aufbau skalierbarer Web Scraper hilft

- Geolokalisierte rotierende Proxys

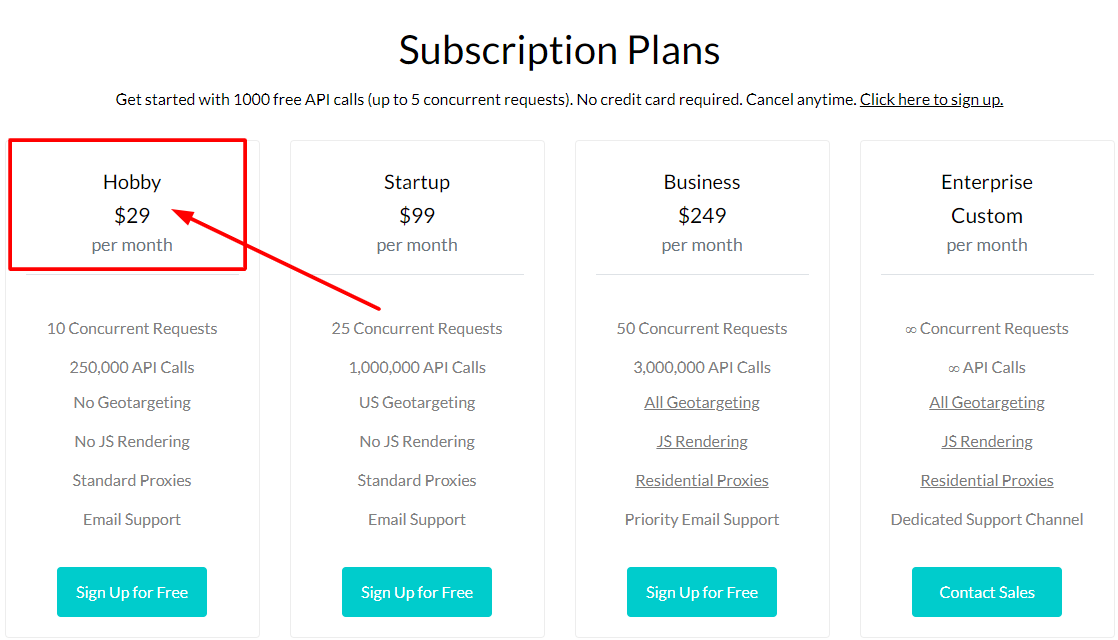

Preisgestaltung

4) ScrapeSimple

ScrapeSimple ist das beste Web-Scraping-Tool für Entwickler, die nach einem benutzerdefinierten Scraper suchen, der von Grund auf neu entwickelt wurde. Die Datenextraktion ist jetzt so einfach wie das Ausfüllen eines Formulars mit all Ihren Einstellungen und Anweisungen für den gewünschten Datentyp.

ScrapeSimple zeigt, dass es sich um einen professionell betriebenen Tool-Service handelt, der benutzerdefinierte Web Scraper für seine Benutzer erstellt und verwaltet. Teilen Sie ihnen einfach mit, welche Art von Daten Sie sammeln möchten und von welcher Website und Ihr personalisierter Web Scraper wird so eingerichtet, dass er Ihnen die Daten regelmäßig (täglich, wöchentlich, monatlich oder wann immer Sie wollen) direkt im CSV-Format zusendet in Ihren Posteingang.

Dieses Tool eignet sich für Unternehmen, die nur einen HTML-Scraper benötigen und keinen Code manuell aufschreiben müssen. Ihre Reaktionszeit ist blitzschnell und ihr Kundenservice ist äußerst hilfreich und einladend.

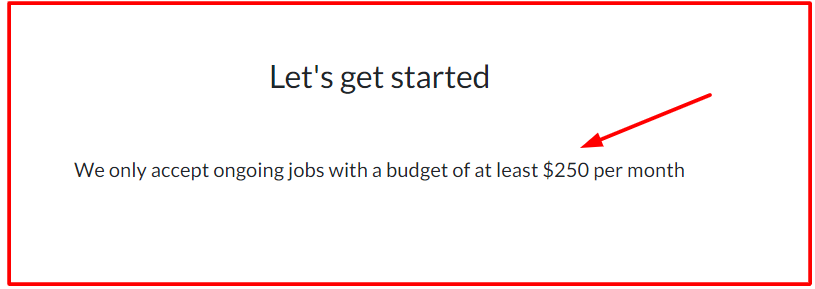

Preisgestaltung

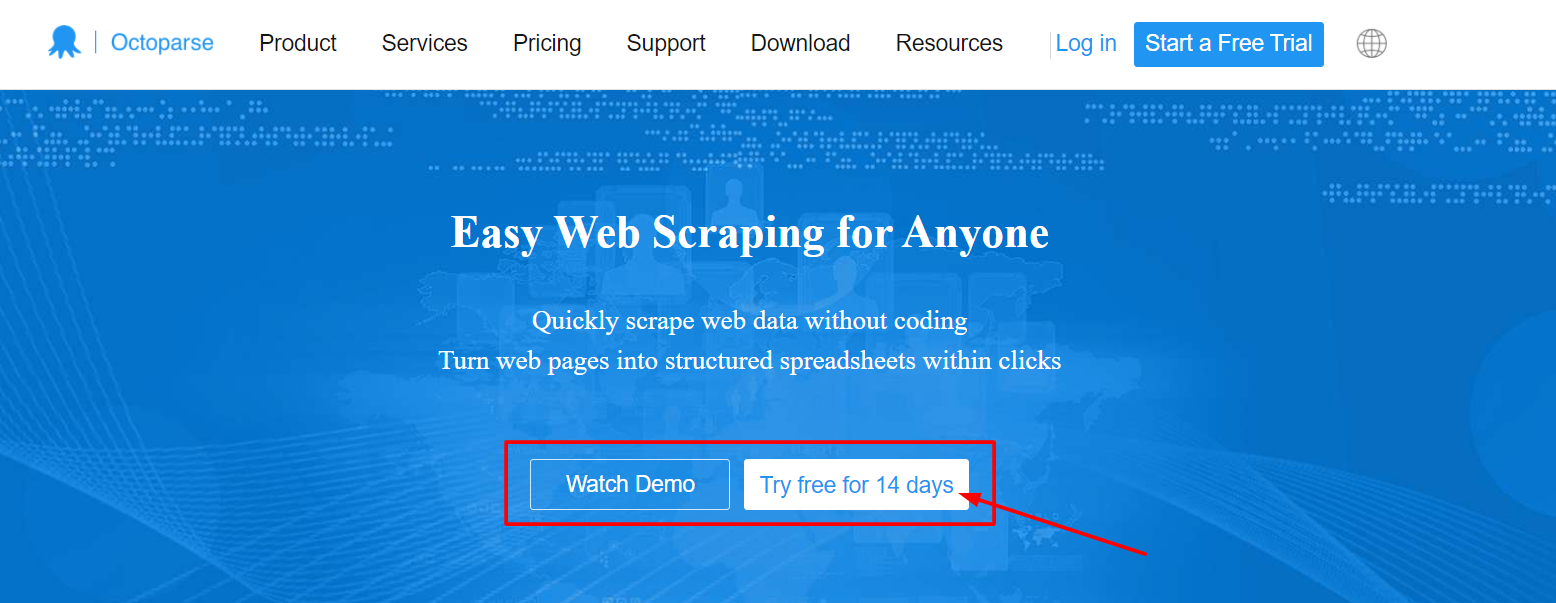

5) Oktoparse

Octoparse ist ein großartiges und schnelles Web-Scraping-Tool für Programmierer und Nicht-Programmierer, die Informationen von Websites extrahieren möchten, ohne Code schreiben zu müssen, aber dennoch die vollständige Kontrolle über den Prozess haben. Es ist sehr üblich, E-Commerce-Daten zu schaben.

Es kann verwendet werden, um Webdaten in größerem Umfang (bis zu Millionen) abzurufen, und die Daten können in organisierten und strukturierten Dateien wie Excel und CSV zum Herunterladen gespeichert werden. Kunden können auch von einem kostenlosen Plan und einem Testangebot für zahlende Abonnenten profitieren.

Zu den beliebten Funktionen dieses Tools gehören:

- Cloud-Extraktion mit IP-Rotationen zur Umgehung von Captcha und Blockierung

- Es verfügt über ein eingebettetes RegEx-Tool, um Daten automatisch zu bereinigen

- Sie können das Web Scraping planen und regelmäßig Datenaktualisierungen erhalten

- Es verwendet eine API-Verbindung, um eine Datenpipeline direkt in Ihre Datenbank einzurichten

- Es unterstützt sowohl Windows- als auch Mac-Systeme

Preisgestaltung

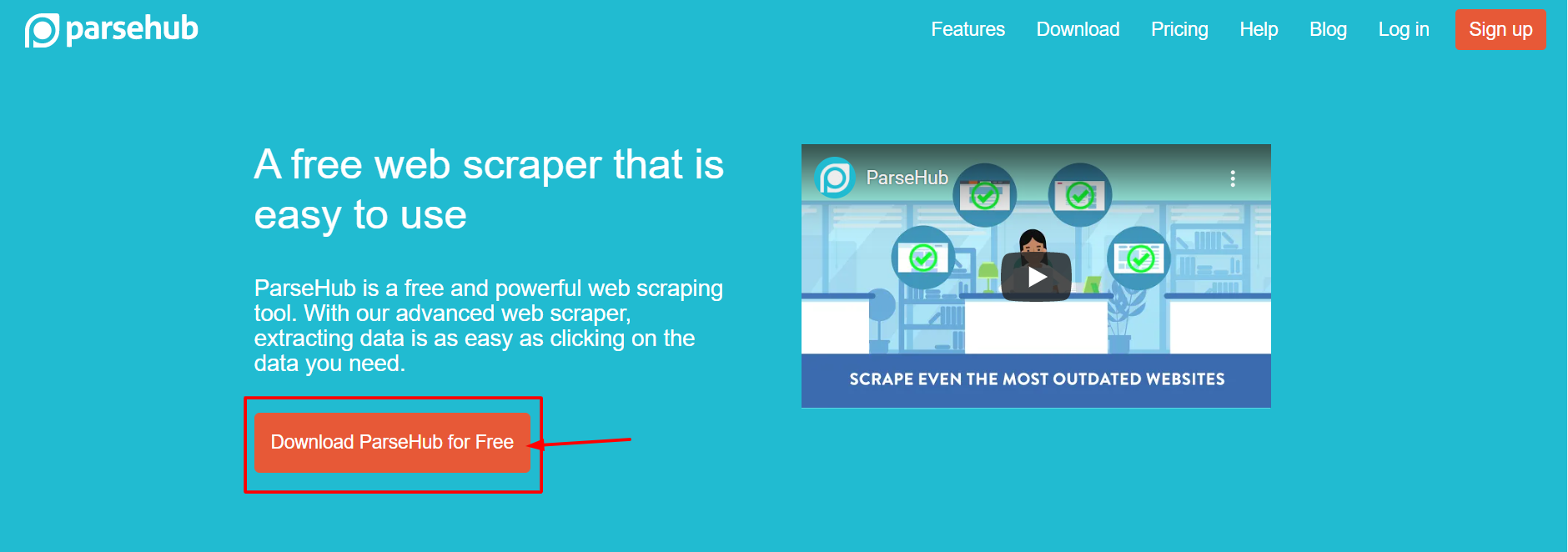

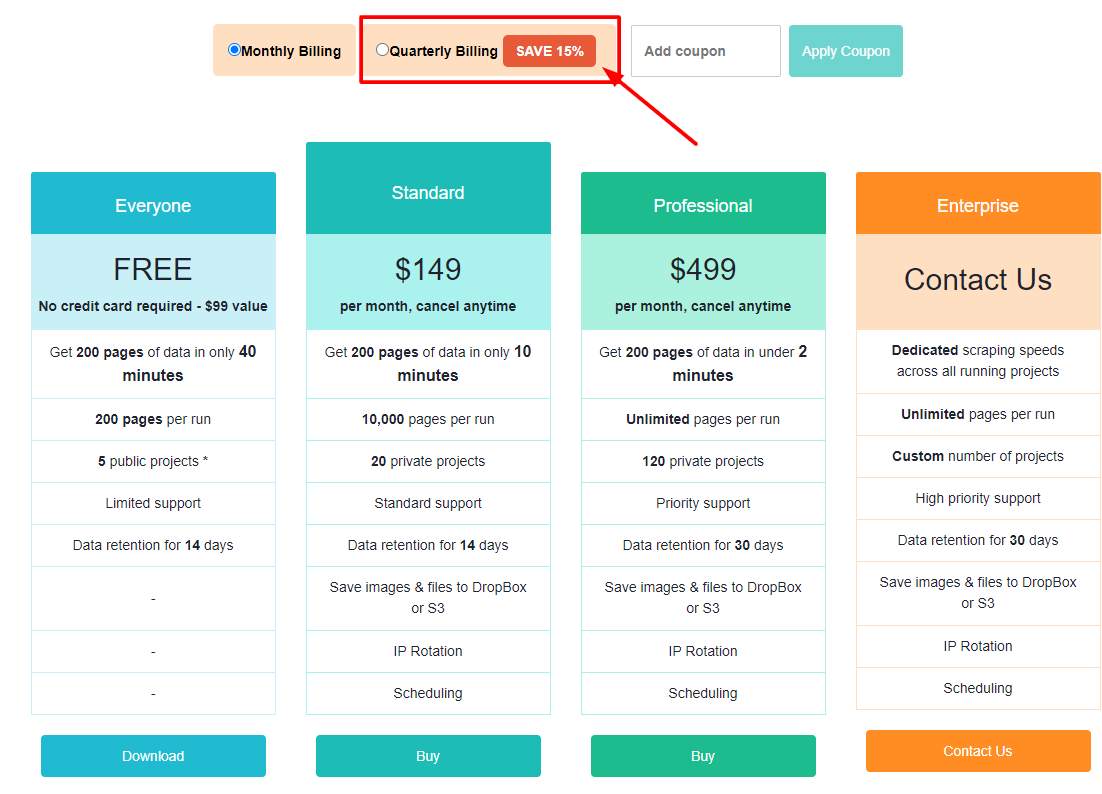

6) ParseHub

Parsehub ist ein wunderbares und effizientes kostenloses Web-Scraping-Tool, mit dem Sie Web-Scraper erstellen können, ohne programmieren zu müssen. Viele Analysten, Journalisten, Datenwissenschaftler und andere verwenden es. Es ist wirklich einfach zu bedienen. Es ist sehr einfach, Web Scraper zu rendern. Sie müssen nur auf die Daten klicken, die Sie exportieren möchten, und sie werden im JSON- oder Excel-Format exportiert.

Benutzer können Funktionen wie die automatische IP-Rotation, das Scrapen hinter Login-Türen, das Navigieren in Dropdown-Menüs und Registerkarten, das Extrahieren von Daten aus Tabellen und Karten und vieles mehr nutzen. Darüber hinaus bietet es einen großzügigen kostenlosen Plan, der es Benutzern ermöglicht, bis zu 200 Seiten Daten in weniger als 40 Minuten zu kratzen! Es bietet Desktop-Clients für Windows, Mac OS und Linux, sodass Sie unabhängig vom Betriebssystem von Ihrem Computer darauf zugreifen können.

Werkzeuge und Funktionen

- Bereinigung von Text und HTML vor dem Herunterladen von Daten

- Einfach zu bedienende grafische Oberfläche

- Sammeln und speichern Sie Informationen automatisch auf Servern

Preisgestaltung

7) Diffbot

Diffbot identifiziert nützliche Daten auf einer Webseite mithilfe von Computer Vision statt HTML-Decodierung, was es von anderen online verfügbaren Web Scrapern unterscheidet. Das bedeutet, dass selbst wenn sich das HTML-Layout einer Seite ändert, die Web Scraper weiterhin funktionieren, solange das optische Erscheinungsbild der Seite gleich bleibt.

Dies ist eine hervorragende Funktion für langjährige unternehmenskritische Web-Scraping-Mitarbeiter. Mit KI-Extraktoren können Sie mit diesem Tool strukturierte Daten aus jeder Form von URL extrahieren. Obwohl es ein wenig kostspielig ist, leistet es gute Arbeit, indem es eine Luxuslösung bietet, die einige Verbraucher für lohnenswert halten. Ihr günstigster Plan kostet 299 $ pro Monat.

Werkzeuge und Funktionen:

- Sie haben Zugriff auf eine Reihe von Datenquellen, die auf einem vollständigen und genauen Verständnis jedes Systems basieren.

- Mit Hilfe von AI Extractors ist es möglich, strukturierte Daten aus beliebigen URL-Verbindungen zu extrahieren.

- Mit Crawlbot Knowledge Graph können Sie Ihre Datenextraktion auf mehrere Domänen skalieren.

- Diese Funktion liefert Ihnen genaue, vollständige und tiefgehende Daten aus dem Internet, die BI benötigt, um nützliche Analysen und Erkenntnisse zu erstellen.

Preisgestaltung

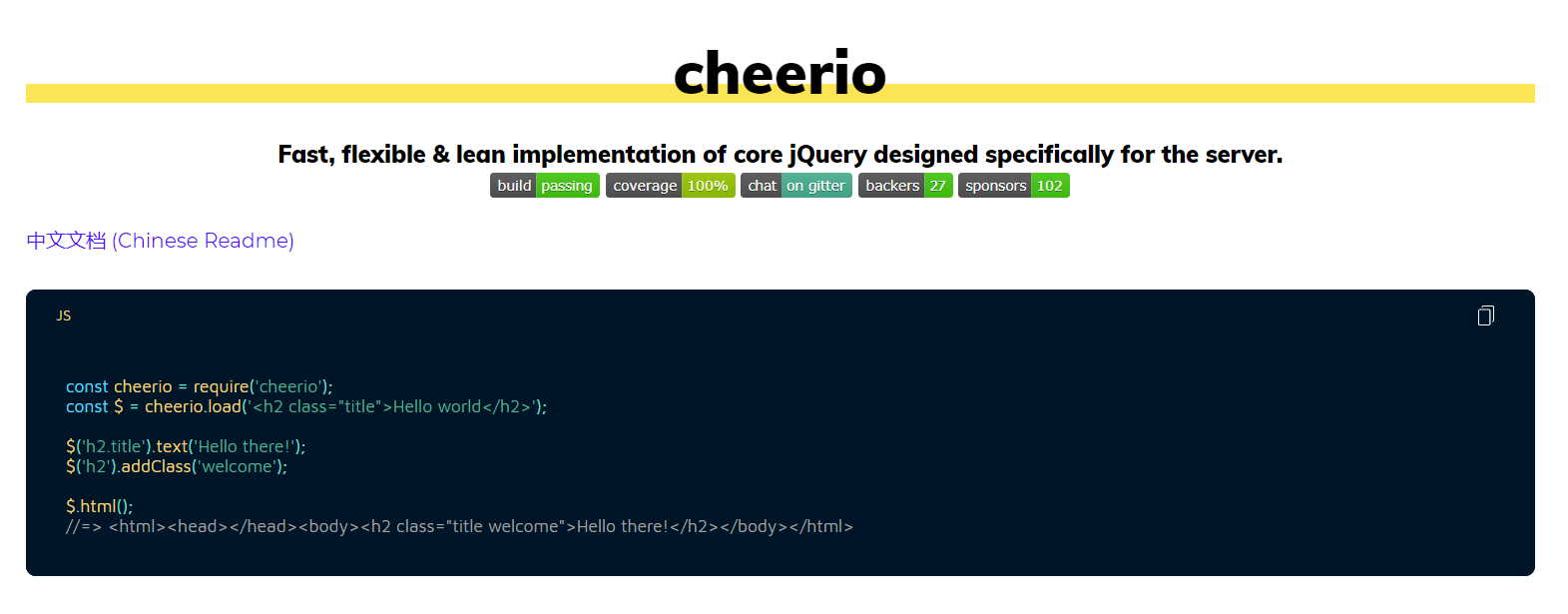

8) Tschüss

Es wurde für NodeJS-Entwickler entwickelt, die HTML auf unkomplizierte Weise analysieren möchten. Diejenigen Entwickler, die mit jQuery vertraut sind, können sofort die beste Javascript-Web-Scraping-Syntax bemerken, die verfügbar ist.

Cheerio hat eine API, die jQuery sehr ähnlich ist, was es Entwicklern, die bereits mit jQuery vertraut sind, einfacher macht, dieses Web-Scraping-Tool für das HTML-Parsing zu verwenden. Es ist blitzschnell und verfügt über eine Reihe nützlicher Funktionen zum Scrapen von HTML, Text, IDs, Klassen und mehr. Es ist seit langem die beliebteste HTML-Parsing-Bibliothek, die in NodeJS geschrieben wurde, und es ist möglicherweise eines der beliebtesten NodeJS- oder Javascript-Web-Scraping-Tools für neue Projekte.

9) Schöne Suppe

BeautifulSoup ist das ideale Tool für Python-Entwickler, die eine einfache, benutzerfreundliche Oberfläche zum Analysieren von HTML benötigen, aber nicht die Fähigkeiten oder Schwierigkeiten anderer Web Scraper benötigen.

Beautiful Soup ist der gebräuchlichste HTML-Parser für Python-Entwickler, ähnlich wie Cheerio das beste Web-Scraping-Tool für NodeJS-Entwickler ist. Es ist ein Jahrzehnt her, dass diese Methode so gut aufgenommen und aufgenommen wurde.

Viele Web-Parsing-Tutorials sind verfügbar, um Entwicklern beizubringen, wie sie diese Methode zum Scrapen verschiedener Websites in Python 2 und Python 3 verwenden können. Wenn Sie nach einer Python-HTML-Parsing-Bibliothek suchen, ist dies definitiv die beste Option.

10) Mozenda

Mozenda ist die perfekte Plattform für Unternehmen und Unternehmen, die ein Cloud-basiertes Self-Service-Tool zum Scraping von Webseiten benötigen. Mozenda hat über 7 Milliarden Seiten geschabt und verfügt über Erfahrung im Umgang mit Kunden aus der ganzen Welt.

Seine Kunden können ihre leistungsstarke Cloud-Plattform nutzen, um Web Scraper auszuführen. Ein Merkmal, das sie von anderen Web-Scraping-Tools unterscheidet, ist ihr Kundensupport, der Telefonnummern und E-Mail-Adressen für alle zahlenden Benutzer bereitstellt. Diese Plattform ist stark erweiterbar und wie Diffbot etwas kostspielig, wobei das einfachste Paket bei 250 US-Dollar pro Monat beginnt.

Mit Mozenda können Sie Text, Bilder und PDF-Material von Webseiten entfernen. Es ist als eine der besten Web-Scraping-Anwendungen zum Bearbeiten und Vorbereiten von Datendateien für die Veröffentlichung bekannt.

Werkzeuge und Funktionen:

- Sie können Ihr bevorzugtes Bl-Tool oder Ihre bevorzugte Datenbank verwenden, um Webdaten zu sammeln und zu veröffentlichen.

- In nur wenigen Minuten können Sie Web-Scraping-Agenten über eine Point-and-Click-Oberfläche erstellen.

- Job Sequencer- und Request Blocking-Funktionen sind enthalten, die bei der Echtzeit-Erfassung von Webdaten helfen.

- Es zeigt, dass es das beste Account Management und den besten Kundenservice in der Branche hat.

11) Kratzbiene

Scraping Bee ist eine Web-Scraping-Anwendung, die mit einer Reihe von Browsern und Proxy-Servern funktioniert. Es kann auch Javascript auf Webseiten ausführen und Proxys für jede Anfrage ändern, sodass Sie auf die rohe HTML-Seite zugreifen können, ohne blockiert zu werden. Sie haben auch eine dedizierte API zum Scrapen von Google-Suchergebnissen.

Werkzeuge und Funktionen:

- Es unterstützt JavaScript-Rendering

- Es bietet eine automatische Proxy-Rotation.

- Sie können diese Anwendung direkt in Google Sheet verwenden.

- Diese Anwendung wird im Google Chrome-Webbrowser unterstützt.

- Gut zum Scrapen von Amazon

- Unterstützt Google Search Scraping

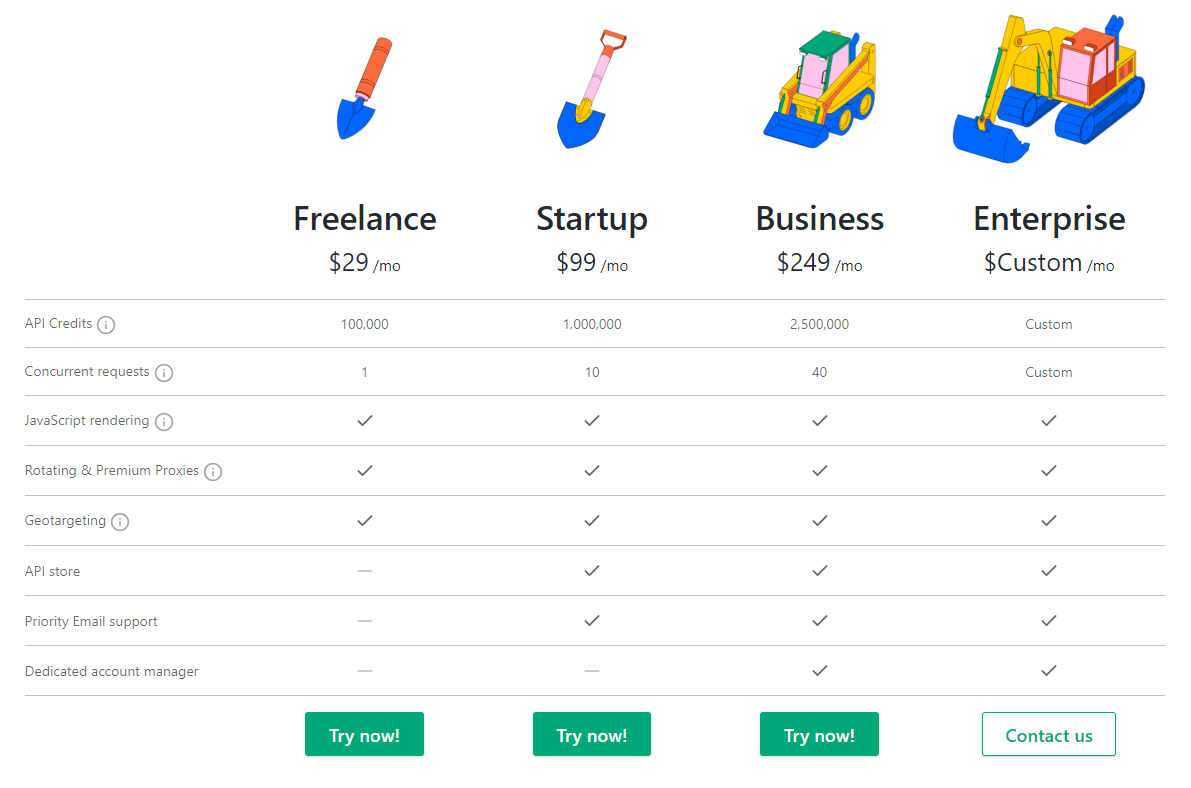

Preisgestaltung

12) xtract.io

xtract.io ist ein personalisiertes Daten-Scraping-Tool, das Webdaten, Textdokumente, PDFs, Social-Media-Nachrichten, historische Daten und sogar E-Mails in einem geschäftsfähigen Format sammelt und organisiert.

Werkzeuge und Funktionen

- Mit dem personalisierten Datenextraktionstool können Sie detaillierte Daten wie Produktkataloginformationen, Kontaktdaten, Firmendetails, Finanzinformationen, Arbeitslisten, Leasingdaten, Rezensionen, Standortdaten und Bewertungen auslesen.

- Mit einem leistungsstarken API-Framework können Sie erweiterte und bereinigte Daten problemlos direkt in Ihre Geschäftsanwendungen integrieren.

- Mit vorkonfigurierten Plänen können Sie den gesamten Datenextraktionsprozess automatisieren.

- Im Vergleich zu vorkonfigurierten Geschäftsregeln mit starrer Datenkonsistenz können Sie auf qualitativ hochwertige und geprüfte Daten zugreifen.

- Daten können in einer Reihe von Formaten exportiert werden, darunter JSON, Textdateien, HTML, CSV, TSV und andere.

- Vermeiden Sie CAPTCHA-Probleme durch rotierende Proxys, um mühelos Echtzeitdaten zu extrahieren.

13) Scraping-Bot

Scraping-Bot.io ist eine gut organisierte Methode zum Extrahieren von Informationen aus URLs. Es bietet APIs, die an Ihre Extraktionsanforderungen angepasst sind, z. B. eine allgemeine API zum Abrufen des Roh-HTML einer Webseite, ein API-Framework zum Website-Scraping und eine API zum Extrahieren von Immobilienlisten von Immobilien-Websites.

Werkzeuge und Funktionen:

- Einfach zu integrieren

- JavaScript-Rendering mit Headless-Browsern

- Erschwingliche Preispläne

- Verarbeitet Proxys und Webbrowser

- Hochwertige Proxys

- Ganzseitiges HTML

- Bis zu 20 gleichzeitige Anfragen

- Geotargeting

- Ermöglicht ein breites Spektrum an Schüttgut-Schabeanforderungen

- Monatlicher Grundnutzungsplan kostenlos

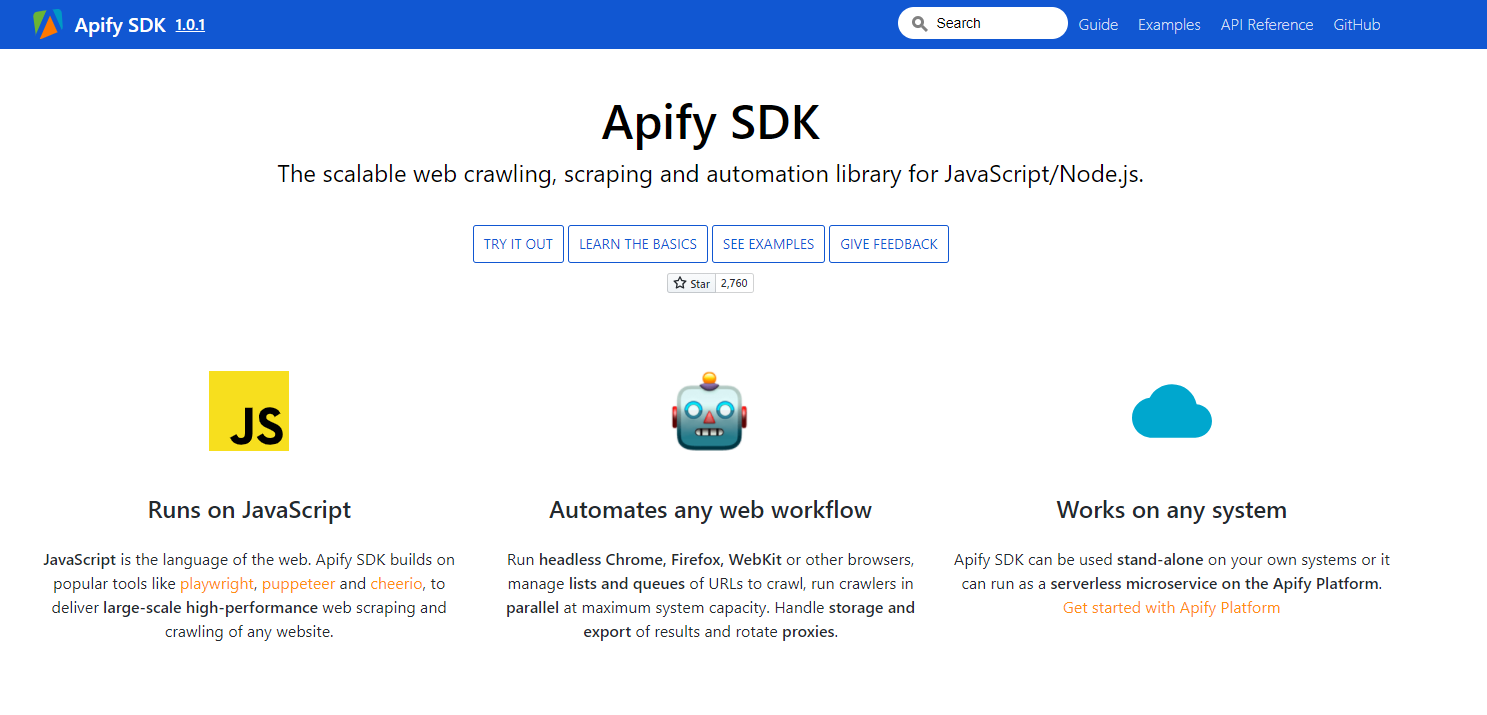

14) Apify-SDK

Apify SDK ist eine Javascript- und NodeJS-Web-Crawling-, Scraping- und Automatisierungsbibliothek. Es ermöglicht Ihnen, Headless-Browser für die Erstellung, Webautomatisierung und den Datenaustausch zu verwenden.

Werkzeuge und Funktionen:

- Automatisiert jeden Web-Workflow – Führen Sie Headless-Webbrowser wie Google Chrome, Mozilla Firefox, WebKit oder andere Browser aus.

- Verwalten und organisieren Sie Listen und URLs zum Crawlen und führen Sie Crawler gleichzeitig bei maximaler Systemkapazität aus.

- Befassen Sie sich mit der Speicherung und dem Export von Ergebnissen und rotieren Sie Proxys.

- Problemloses und schnelles Crawlen über das Web

- Kann auf jedem System arbeiten

- Läuft auf JavaScript

15) Import.io

Import.io unterstützt Sie bei der Entwicklung von Datensätzen, indem Informationen von einer einzelnen Seite importiert und in das CSV-Format exportiert werden. Es ist eines der am häufigsten verwendeten Web-Scraping-Tools zum Integrieren von Daten in Apps über ein API-Framework und eine HTTP-Push-API.

Werkzeuge und Funktionen:

- Interaktionen mit Webformularen oder Anmeldungen sind einfach und unkompliziert.

- Sie können Ihre Datenextraktion auch im Voraus vorbereiten.

- Mit der Unterstützung der Import.io-Cloud können Sie Daten speichern und darauf zugreifen.

- Erstellen Sie einen visuellen Bericht mit Diagrammen und Grafiken.

- Interaktionen und Projekte im Internet werden automatisiert.

16) Webhose.io

Webhose.io bietet Ihnen direkten Zugriff auf integrierte Echtzeitdaten zum Crawlen von Tausenden von Websites. Es gibt Ihnen Zugriff auf authentische Feeds mit über zehn Jahren nützlichem Wissen.

Werkzeuge und Funktionen:

- JSON- und XML-Datensätze, die standardisiert und maschinenlesbar sind.

- Sie erhalten Zugriff auf eine breite Datenbank mit Datenfeeds, ohne zusätzliche Gebühren zahlen zu müssen.

- Sein fortschrittlicher Filter hilft bei der Verwaltung von granularen Analysen und Datendateien, die gefüttert werden müssen.

17) Dexi intelligent

Dexi intelligent ist eine weitere beliebte Web-Scraping-Anwendung, mit der Sie jede Datenmenge sofort in Geschäftswert umwandeln können. Mit diesem Tool zum Web Scraping sparen Sie Kosten und Zeit für Ihr Unternehmen.

Werkzeuge und Funktionen:

- Erhöhte Qualität, Genauigkeit und Effizienz

- Ultimative Geschwindigkeit für Datenintelligenz

- Schnelle und effiziente Extraktion von Daten

- Erfassung von Wissen im großen Maßstab

18) Überlisten

Es ist ein Firefox-Add-On, das einfach aus dem Firefox-Add-On-Store installiert werden kann. Um dieses Produkt zu kaufen, werden Ihnen drei verschiedene alternative Pläne präsentiert, die auf Ihren Bedürfnissen basieren.

- Pro Edition (Leistungsstarkes einfaches Web Scraping)

Jahresabonnement: 69,00 $

Einmaliger Kauf: 95,00 $

- Expert Edition (Der Power User Scraper)

Jahresabonnement: 195,00 $

Einmaliger Kauf: 275,00 $

- Enterprise Edition (hohes Volumen, mehrere Benutzer)

Jahresabonnement. : $535,00

Einmaliger Kauf: 745,00 $

Werkzeuge und Funktionen:

- Sie können Email Sourcer V.9 verwenden, um Kontakte aus dem Internet zu erhalten.

- Outwit Hub erfordert keine besonderen Programmierkenntnisse, um Wissen aus Websites zu extrahieren.

- Mit nur einem Klick auf die Erkundungsschaltfläche können Sie mit dem Scrapen von Tausenden von Webseiten beginnen.

Preisgestaltung

19 ) Datenstreamer

Das Data Streamer-Tool hilft bei der Sammlung von Social-Media-Materialien und -Informationen aus dem gesamten Web. Es ist einer der besten Web Scraper, der die Verarbeitung natürlicher Sprache verwendet, um wichtige Metadaten abzurufen.

Werkzeuge und Funktionen:

- Es verfügt über eine integrierte Volltextsuche powered by Kibana und Elasticsearch

- Integrierte Boilerplate-Entfernung und Datenextraktion basierend auf Informationsabruftechniken

- Es baut auf einer fehlertoleranten Infrastruktur auf und garantiert eine hohe Datenverfügbarkeit

- Benutzerfreundliche und umfassende Verwaltungskonsole

20) FMiner

FMiner ist ein weiteres bekanntes Web-Scraping-Tool, das für Datenextraktion, Crawling, Screen Scraping, Makros und Web-Support unter Windows und Mac OS verwendet werden kann.

Werkzeuge und Funktionen:

- Verwenden eines einfachen visuellen Editors zum Erstellen eines Datenextraktionsprojekts

- Es unterstützt Sie beim Navigieren auf den Seiten der Website, indem es Linkstrukturen, Dropdown-Sammlungen und URL-Musterabgleich integriert.

- Daten können von schwer zu crawlenden dynamischen Web 2.0-Websites abgeleitet werden.

- Es ermöglicht Ihnen, automatisierte Decaptcha-Dienste von Drittanbietern oder eine manuelle Eingabe zu verwenden, um die CAPTCHA-Sicherheit einer Website anzuvisieren.

LOHNENDE ERWÄHNUNGEN!

Nachdem wir nun mit den 20 besten Web-Scraping-Tools für Februar 2021 fertig sind, finden Sie hier eine zusätzliche Liste von 4 Web-Scraping-Tools, die unserer Meinung nach in diesem Beitrag lobend erwähnt werden sollten. Diese Tools wurden auch von mehreren Benutzern und Kritikern als eines der besten Web-Scraping-Tools anerkannt, die Sie verwenden können.

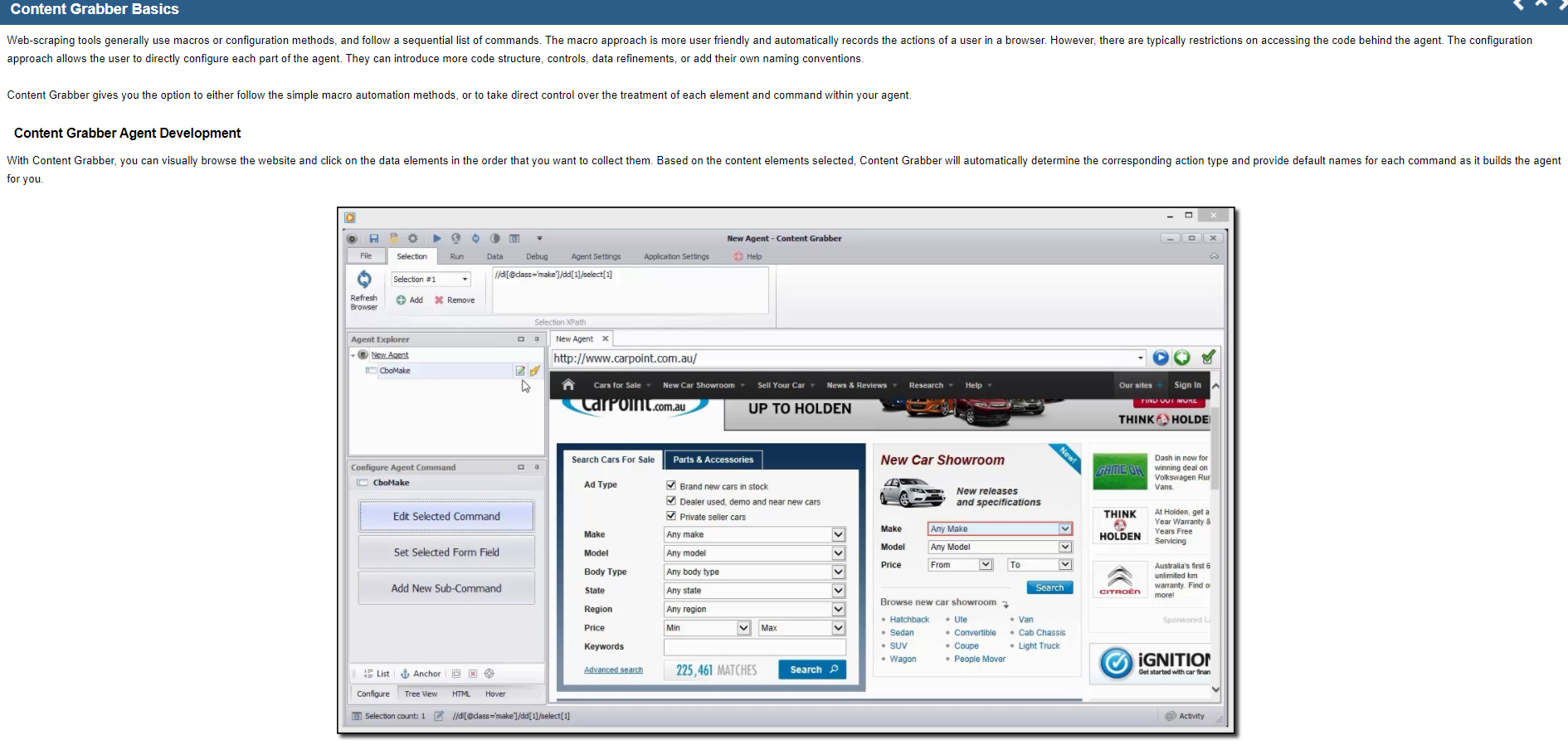

21) Content-Grabber

Content Grabber ist eine robuste Big-Data-Lösung zum Scraping von Webdaten. Es hilft Ihnen, Ihr Arrangement zu skalieren, da es einer der besten Web Scraper ist. Diese Plattform bietet grundlegende Funktionen wie einen visuellen Point-and-Click-Editor.

Werkzeuge und Funktionen:

- Die Extraktion von Webdaten ist schneller als bei anderen Tools

- Hilft Ihnen beim Erstellen von Web-Apps mit einer dedizierten Web-API, mit der Sie Webdaten direkt von Ihrer Website ausführen können

- Hilft Ihnen, zwischen verschiedenen Plattformen zu wechseln

22) Zyte (früher bekannt als ScrapingHub)

Zyte, ehemals Scraping Hub, ist ein Cloud-basiertes Web-Scraping-Tool, das Entwickler beim Abrufen wichtiger Daten unterstützt. Es verwandelt die gesamte Webseite in gut organisierte Inhalte. Wenn ihr Crawl Builder Ihre Anforderungen nicht erfüllt, steht ihr professionelles Team zur Verfügung, um Ihnen zu helfen. Mit dem kostenlosen Standardplan können Sie jeweils einen Crawl ausführen, während Sie mit dem Premium-Plan, der 25 US-Dollar pro Monat kostet, bis zu vier Crawls gleichzeitig ausführen können.

Also, welches ist Ihr bevorzugtes Web-Scraping-Tool? Und welche Art von Daten möchten Sie aus dem Internet kratzen? Lassen Sie es uns in den Kommentaren unten wissen und schlagen Sie ein anderes gutes Web-Scraping-Tool vor, das Ihrer Meinung nach auf der Liste stehen sollte.

Warum sollten Sie Web-Scraping-Tools verwenden?

Web-Scraping-Tools können sich aus zahllosen Gründen in verschiedenen Szenarien als nützlich erweisen –

Sammlung von Informationen für die Marktforschung

Diese Tools können Ihnen dabei helfen, Sie darüber auf dem Laufenden zu halten, wohin sich Ihr Unternehmen in den kommenden sechs Monaten bewegt, und dienen somit als wichtiges Instrument für die Marktforschung. Diese Tools können die Daten von mehr als einem Datenanalyseanbieter und Marktforschungsunternehmen erhalten und sie zu einfachen Referenz- und Analysezwecken an einem Ort kombinieren.

Kontaktdaten extrahieren

Diese Tools können sogar verwendet werden, um Informationen wie E-Mails und Kontaktnummern von verschiedenen Websites zu erhalten, die es ermöglichen, die Lieferanten, Hersteller und andere für Ihr Unternehmen interessante Personen mit ihren jeweiligen Kontaktnummern und Adressen aufzulisten.

Laden Sie Lösungen von StackOverflow herunter

Mit einem Web-Scraping-Tool können Sie auch einige Lösungen zum Zweck des Offline-Lesens oder -Speicherns herunterladen, indem Sie Informationen von Websites wie StackOverflow und vielen weiteren Q&A-Websites sammeln. Dies führt zu einer Reduzierung Ihrer Abhängigkeit von einer stabilen Internetverbindung, da die Ressourcen trotz Internetverfügbarkeit schnell verfügbar sind.

Suchen Sie nach Bewerbern oder Jobs

Für Mitarbeiter, die nach Bewerbern suchen, die sie mit ihrem Team vereinen können, oder für Arbeitssuchende, die ein bestimmtes Stellenangebot finden, funktionieren diese Tools hervorragend, um die Informationen und Daten basierend auf separat angewendeten Filtern einfach abzurufen und Daten ohne manuelle Suche erfolgreich abzurufen.

Verfolgen von Preisen aus mehreren Geschäften

Wenn Sie sich für Online-Shopping interessieren und die aktuellen Kosten der gesuchten Produkte in mehreren Märkten und Online-Sites und Geschäften verfolgen möchten, benötigen Sie sicherlich ein Web-Scraping-Tool.

Schnelllinks:

- Debitoor Detaillierte Überprüfung:

- Sleek Bill Review

- NetSuite-Überprüfung:

Häufig gestellte Fragen (FAQs) zu Was ist das beste Tool für Web Scraping?

Was versteht man unter Web Scraping?

Wenn Sie sich fragen, was Data Scraping ist? - Web Scraping (gleichbedeutend mit Data Scraping) ist das Verfahren zum Extrahieren und Importieren der Daten von einer bestimmten Website in eine Tabellenkalkulation. Data Scraping hilft, Daten oder Informationen aus dem Internet zu erhalten und diese Daten dann in eine Ausgabe zu übertragen, die von Menschen gelesen werden kann.

Wofür wird Web Scraping verwendet?

Web Scraping ist sehr nützlich für die Marktforschung, das Finden von Leads, den Vergleich von Produkten, die Inhaltsanalyse, den Preisvergleich, die Datenerfassung für Business Intelligence usw.

Welche Faktoren muss ich bei der Auswahl eines Web Scraping Tools berücksichtigen?

Bei der Auswahl eines guten Web-Scraping-Tools sollten Sie auf die unten aufgeführten Faktoren achten: Es sollte einfach zu bedienen sein Kosten des Web-Scraping-Tools Funktionen und Merkmale Leistung und Geschwindigkeit Flexibilität des Tools gemäß den Anforderungen Die unterstützten Datenformate Verfügbarkeit des Kundensupports

Fazit: Web-Scraping-Tools zur Datenextraktion im Jahr 2022

Web Scraping kann ein langwieriger und komplizierter Prozess sein. Bei dieser Entscheidung sind viele Faktoren zu berücksichtigen, aber am Ende sollten Sie das Werkzeug auswählen, das Ihren Anforderungen am besten entspricht! Bright Data hat mir all diesen Ärger erspart, indem es eine benutzerfreundliche Oberfläche zum Abrufen von Daten aus verschiedenen Quellen in eine Tabelle bereitgestellt hat – und so jede Woche oder jeden Monat Stunden gespart hat, ohne die Genauigkeit zu beeinträchtigen, danke wieder einmal ihrem großartigen Kundendienstteam, wenn überhaupt geht schief.