Über Schlüsselwörter hinaus: Wie Unternehmen moderne SEO-Strategien beeinflussen

Veröffentlicht: 2023-07-06Der Übergang von „Suchmaschine 2.0“ zu „Suchmaschine 3.0“ hat insbesondere mit der Einführung von Entitäten erhebliche Veränderungen mit sich gebracht.

Dieser Artikel untersucht diese Veränderungen, die Auswirkungen von Entitäten auf modernes SEO und wie Sie Ihre Strategien anpassen können, um in dieser neuen Ära erfolgreich zu sein.

Bauen Sie Ihre eigene SEO-„Fiktionsmaschine“ auf

In meinen frühen Jahren, in denen ich das Programmieren lernte, führte ein Lehrer ein wirkungsvolles Konzept namens „Notional Machine“ ein, das meine Herangehensweise an das Programmieren und später an SEO veränderte.

Einfach ausgedrückt handelt es sich um das ungefähre mentale Modell eines Entwicklers dessen, was im Computer passiert, wenn er auf „Ausführen“ klickt.

Mein Lehrer betonte, je detaillierter und genauer diese mentale Darstellung sei, desto besser sei ich für die Bewältigung neuer Probleme gerüstet.

Die erfolgreichsten Programmierer waren diejenigen, die die genauesten und zuverlässigsten fiktiven Maschinen entwickelt hatten!

Wenn wir eine Parallele zu SEO ziehen, aktualisieren wir kontinuierlich unser mentales Modell (unsere eigene fiktive Maschine) der Funktionsweise von Suchmaschinen, wenn wir neue Konzepte aufnehmen, eine Fallstudie untersuchen oder die Auswirkungen einer Änderung beobachten.

Der Unterschied zwischen erfahrenen SEOs und ungelernten SEOs besteht darin, dass sie Ergebnisse erzielen können, weil sie Lösungen aus einem genaueren Modell ziehen können.

Untersuchungen auf dem Fachgebiet von Anderson Ericsson liefern substanzielle Beweise, die diesen Punkt bestätigen.

Seine Fachwissensstudien zeigen, dass diejenigen, die in ihrem Fachgebiet hervorragende Leistungen erbringen, über überlegene und leichter zugängliche mentale Modelle verfügen.

Diese Modelle ermöglichen es ihnen, die komplizierten Ursache-Wirkungs-Beziehungen zu verstehen, zu unterscheiden, worauf es in einem komplexen Szenario wirklich ankommt, und die zugrunde liegenden Prozesse zu erkennen, die nicht sofort erkennbar sind.

Mit der Einführung von Entity SEO wurden mehrere wichtige Komponenten innerhalb der Suchmaschine von Google geändert.

Es scheint, dass viele SEO-Experten immer noch nach den Regeln der „Suchmaschine 2.0“ arbeiten, auch wenn „Suchmaschine 3.0“ mittlerweile etwas anderen Regeln folgt.

Entity SEO führt Vokabeln und Konzepte ein, die aus den Disziplinen maschinelles Lernen und Information Retrieval stammen.

Diese Begriffe mögen komplex erscheinen, da sie nicht auf ihre Kernbedeutung vereinfacht wurden. Sobald wir sie destilliert haben, werden Sie feststellen, dass die Konzepte nicht allzu kompliziert sind.

Mein Ziel ist es, eine einfache, aber effektive fiktive Maschine zu konstruieren, die zeigt, wie die neuesten Suchmaschinen Entitäten verwenden.

Genauer gesagt möchte ich veranschaulichen, wie Ihr Verständnis von SEO aktualisiert werden muss, um dieser neuen Realität Rechnung zu tragen.

Auch wenn das Verständnis des „Warum“ hinter diesen Änderungen unwichtig erscheinen mag, „hacken“ viele SEO-Experten effektiv die Matrix, indem sie ihr Verständnis darüber, wie Google das Web interpretiert, zu ihrem Vorteil nutzen.

In jüngster Zeit haben Menschen Millionenbesucher-Websites erstellt und Googles Verständnis von Themen durch die Manipulation dieser Konzepte verändert.

Auffrischung: Wie wir zur Suchmaschine 2.0 kamen

Bevor wir die Unterschiede zwischen „Suchmaschine 2.0“ und „Suchmaschine 3.0“ untersuchen, werfen wir einen Blick auf die wesentlichen Änderungen gegenüber der ersten Version 1.0.

Am Anfang operierten Suchmaschinen nach einem einfachen „Wortbeutel“-Modell.

Dieses Modell behandelte ein Dokument als bloße Ansammlung von Wörtern und vernachlässigte die kontextuelle Bedeutung oder Anordnung dieser Wörter.

Wenn ein Benutzer eine Suchanfrage stellte, verwies die Suchmaschine auf eine invertierte Indexdatenbank – eine Datenstruktur, die Wörter ihren Positionen in einer Reihe von Dokumenten zuordnet – und suchte nach Dokumenten mit der höchsten Anzahl an Übereinstimmungen.

Aufgrund des mangelnden Verständnisses des Kontexts und der Semantik sowohl von Dokumenten als auch von Benutzeranfragen gelang es diesem Modell jedoch oft nicht, relevante und präzise Suchergebnisse zu liefern.

Wenn ein Benutzer beispielsweise mithilfe eines „Bag of Words“-Modells nach „Jaguar“ suchte, würde die Suchmaschine einfach Dokumente aufrufen, die das Wort „Jaguar“ enthalten, ohne den Kontext zu berücksichtigen.

Dies könnte unabhängig von der Absicht des Benutzers zu Ergebnissen über die Automarke Jaguar, das Jaguar-Tier oder sogar die Fußballmannschaft Jacksonville Jaguars führen.

Mit dem Aufkommen der „Suchmaschine 2.0“ hat Google ausgefeiltere Strategien eingeführt. Anstatt nur Wörter abzugleichen, zielte diese Iteration darauf ab, die Absicht des Benutzers hinter seiner Anfrage zu entschlüsseln.

Wenn ein Benutzer beispielsweise nach „Jaguar“ suchte, könnte die Suchmaschine nun den Suchverlauf und den Standort des Benutzers berücksichtigen, um auf den wahrscheinlichen Kontext zu schließen.

Wenn der Benutzer nach Automodellen gesucht hat oder in einer Gegend wohnt, in der Jaguar-Autos beliebt sind, priorisiert die Suchmaschine möglicherweise Ergebnisse zur Automarke gegenüber dem Tier oder der Fußballmannschaft.

Durch die Einführung personalisierter Suchergebnisse – unter Berücksichtigung von Faktoren wie Benutzerhistorie und Standort – wurden die Relevanz und Präzision der Suchergebnisse erheblich verbessert. Dies markierte eine bedeutende Entwicklung vom Grundmodell der „Tasche voller Wörter“ hin zur „Suchmaschine 2.0“.

Suchmaschine 2.0 vs. 3.0

Als wir von „Suchmaschine 1.0“ zu „Suchmaschine 2.0“ übergingen, mussten wir unsere mentalen Modelle aktualisieren und unsere Praktiken ändern.

Die Qualität von Backlinks wurde entscheidend, was SEO-Experten dazu veranlasste, automatisierte Backlinking-Tools aufzugeben und nach Backlinks von höherwertigen Websites zu suchen – neben einer Reihe wichtiger Änderungen.

Im Zeitalter der „Suchmaschine 3.0“ ist klar, dass der mentale Wandel zur Anpassung an diese Veränderungen noch im Gange ist.

Viele Konzepte aus der 2.0-Ära bleiben bestehen, vor allem weil die Praktiker Zeit brauchen, um den Zusammenhang zwischen ihren Anpassungen und den daraus resultierenden Ergebnissen zu beobachten.

Eine beträchtliche Anzahl von SEO-Experten muss sich noch vollständig an diese erheblichen Veränderungen anpassen, oder sie haben möglicherweise entsprechende Versuche unternommen, sind aber nicht ganz ins Schwarze getroffen.

Um diese neuen Unterscheidungen zu verdeutlichen und Hinweise zur Änderung Ihres Ansatzes zu geben, präsentiere ich einen stark vereinfachten, aber nützlichen Vergleich von „Suchmaschine 2.0“ und „Suchmaschine 3.0“.

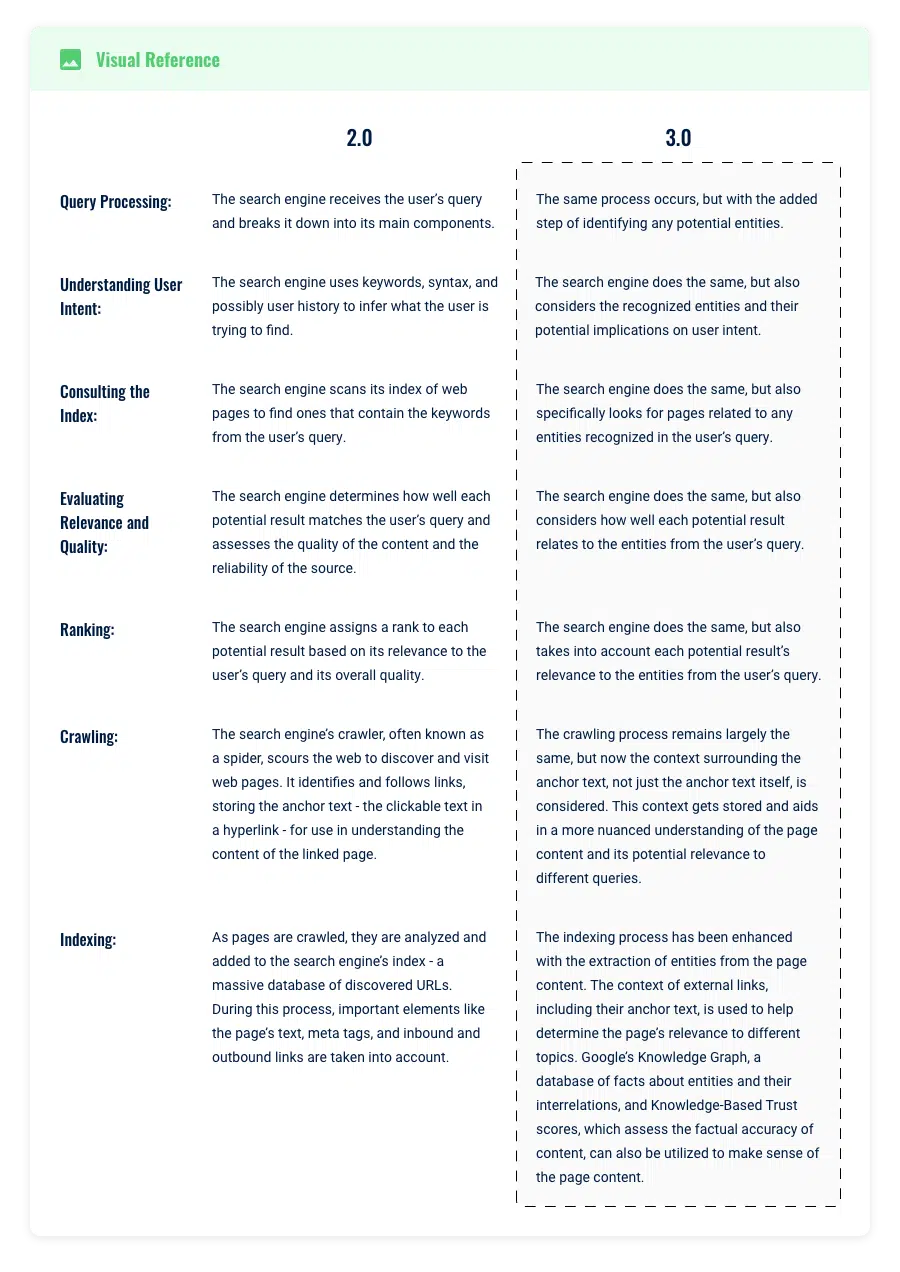

Abfrageverarbeitung und Informationsabruf

Stellen Sie sich vor, Sie geben die Suchanfrage „Elvis“ in Google ein.

Im Zeitalter der Google-Suchmaschine 2.0 ermöglichte die Ausgereiftheit der zugrunde liegenden Algorithmen ein Verständnis der Benutzerabsicht hinter einer Suchanfrage, die über die bloße Übereinstimmung mit Schlüsselwörtern hinausgeht.

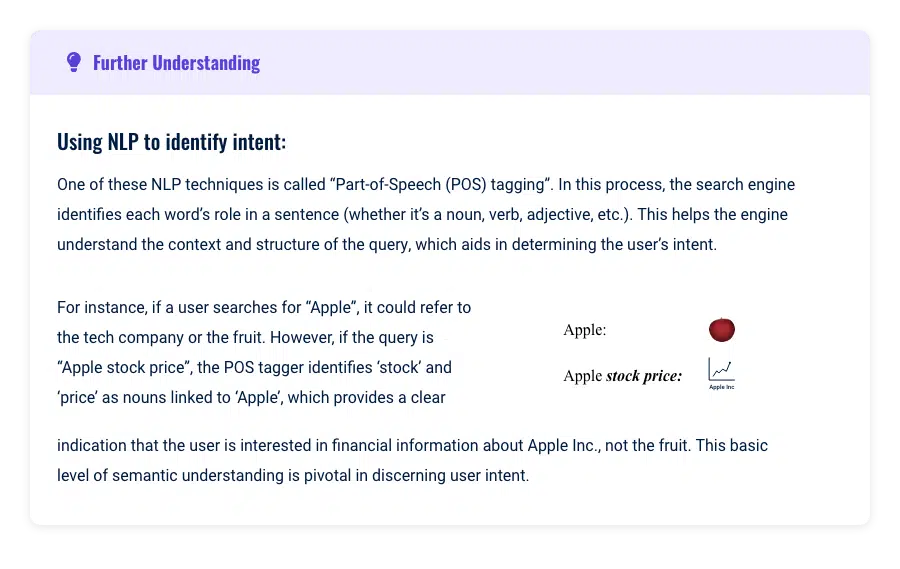

Wenn ein Benutzer beispielsweise nach „Elvis“ suchte, nutzte das System die Verarbeitung natürlicher Sprache und maschinelles Lernen, um die Absicht hinter der Suchanfrage zu verstehen und vorherzusagen.

Es suchte in seinem Index nach „Elvis“ und lieferte Ergebnisse, die das Wort „Elvis“ erwähnten oder (fast vollständig) auf der Relevanz von Texten auf Webseiten und Personalisierungsparametern wie Benutzerverlauf und Standort basierten.

Dieses Modell hatte jedoch immer noch seine Grenzen, da es weitgehend von Schlüsselwörtern, dem Suchverlauf des Benutzers, dem Standort und Phrasen im Text indizierter Webseiten abhängig war.

Der Kontext „Elvis“ könnte Elvis Presley, Elvis Costello oder sogar ein lokales Restaurant namens „Elvis“ bedeuten.

Die Herausforderung bestand darin, dass der Benutzer seine Anfrage weitgehend spezifizieren und verfeinern musste und dennoch durch die Semantik der Schlüsselwörter eingeschränkt war.

Verbesserungen bei der Abfrageverarbeitung in 3.0

Vielen Menschen ist noch nicht bewusst, wie grundlegend die Einführung von Entitäten die Funktionsweise der Suche revolutioniert hat.

Seit 2012 haben Hummingbird und RankBrain den Weg für eine zentralere Rolle von Unternehmen geebnet.

In diesem 3.0-Modell beziehen sich Entitäten auf unterschiedliche und einzigartige Konzepte oder Dinge, unabhängig davon, ob es sich um Personen, Orte oder Objekte handelt.

In unserem früheren Beispiel ist „Elvis“ nicht mehr nur ein Schlüsselwort, sondern wird als eine Einheit erkannt, die sich wahrscheinlich auf den berühmten Musiker Elvis Presley bezieht.

Wenn beispielsweise eine Entität wie „Elvis Presley“ identifiziert wird, kann die Suchmaschine nun eine Fülle von Attributen mit dieser Entität verknüpfen, darunter Aspekte wie seine Musik, seine Filmografie sowie seine Geburts- und Sterbedaten.

Dieser neue Ansatz erweitert den Umfang der Suche erheblich. Früher berücksichtigte eine Suchanfrage nach „Elvis“ in erster Linie etwa 2.000.000 Seiten, die das exakte Schlüsselwort „Elvis“ enthielten.

In diesem entitätszentrierten Modell blickt die Suchmaschine nun darüber hinaus und berücksichtigt alle Seiten, die sich auf die Attribute von Elvis beziehen.

Dies könnte das Suchfeld möglicherweise auf 10.000.000 Seiten erweitern, auch wenn einige von ihnen „Elvis“ nicht explizit erwähnen.

Darüber hinaus ermöglicht dieses Modell der Suchmaschine zu verstehen, dass andere Schlüsselwörter, die sich auf die Attribute der Elvis-Entität beziehen, wie etwa „Graceland“ oder „Blue Wildlederschuhe“, implizit mit „Elvis“ verbunden sind.

Daher könnte die Suche nach diesen Begriffen auch Informationen über Elvis liefern und so das Netz potenzieller Suchergebnisse erweitern.

Erhalten Sie den täglichen Newsletter, auf den sich Suchmaschinenmarketing verlassen.

Siehe Bedingungen.

Abfrageverarbeitung und Themengrenzen in der Suchmaschine 3.0

Eine weitere bedeutende Veränderung, die durch diese Verbesserungen an Entitäten in der Abfrageverarbeitung hervorgerufen wurde, war die Art und Weise, wie Google den Umfang der Themen wahrnimmt, die auf einer einzelnen Seite enthalten sein sollten.

Im Zeitalter der „Suchmaschine 2.0“ war es von Vorteil, für jedes identifizierte Schlüsselwort eine eigene Seite zu erstellen, um die Seite gezielt für diesen Begriff optimieren zu können.

In der „Suchmaschine 3.0“ sind die Grenzen jedoch fließender geworden und werden in Echtzeit basierend auf Vorhersagen des maschinellen Lernens und beobachtetem Benutzerverhalten aktualisiert.

In dieser neuen Ära können die Grenzen eines Themas weit oder eng sein, ein breites Themenspektrum abdecken oder sich intensiv auf einen bestimmten Aspekt konzentrieren. Diese Flexibilität ermöglicht es Websites, sowohl in breiten Bereichen als auch in Nischenbereichen zu Autoritäten zu werden.

Beispiel

Betrachten Sie das Beispiel der Buntstifte. Eine Website könnte darauf abzielen, alles abzudecken, was man über Buntstifte im Allgemeinen wissen muss – ihre Geschichte, Typen, Herstellungsverfahren, Tipps zur Verwendung usw.

Ziel dieser Website ist es, eine aktuelle Autorität zum Thema „Buntstifte“ als Ganzes zu werden.

Andererseits könnte sich eine andere Website ausschließlich auf rote Buntstifte konzentrieren – ihre einzigartigen Pigmente, Beliebtheitsstatistiken, kulturelle Bedeutung usw.

Diese Website versucht, ihre thematische Autorität in einem engeren, aber dennoch gültigen Kontext zu etablieren. Entscheidend ist jedoch, dass der Fokus auf „rote Buntstifte“ mit dem Gesamtzweck der Website übereinstimmt.

Das Hinzufügen von Mikrokontexten, die nicht zum übergeordneten Zweck Ihrer Website passen, könnte Google hinsichtlich der Relevanz und Autorität Ihrer Website verwirren und möglicherweise ihre thematische Autorität verwässern.

Theoretisch könnte eine Website sogar noch tiefer in einen Mikrokontext eintauchen und ihren Inhalt ausschließlich auf die „Etiketten auf roten Buntstiften“ konzentrieren.

Dies ist ein unglaublich spezifischer Schwerpunkt, und man könnte sich fragen, ob Google ihn als aktuelle Autorität anerkennen würde.

Social-Media-Websites nutzen maschinelles Lernen, um Benutzerinteraktionen mit Inhaltselementen zu einem bestimmten Thema vorherzusagen.

Wenn ein Benutzer häufig mit Inhalten über „auf roten Buntstiften verwendete Etiketten“ interagiert, identifiziert das System dies möglicherweise als ein Thema, das für den Benutzer von Interesse ist, und die Website, die den Inhalt bereitstellt, könnte als Autorität zu diesem Thema erkannt werden.

Es lässt sich die Theorie aufstellen, dass Google etwas Ähnliches tun oder zumindest die Erwartungen aufrechterhalten kann, wie gute Inhalte gemäß den von ihnen erfassten Nutzermetriken abschneiden sollten.

Um dies festzustellen, berücksichtigt Google mehrere Faktoren:

Gibt es eine nennenswerte Suchaktivität zu diesem Thema?

Wenn Menschen aktiv nach Informationen zu den „Etiketten für rote Buntstifte“ suchen und die Website umfassende, wertvolle Inhalte zu diesem Thema bietet, könnte sie in diesem Mikrokontext durchaus als aktuelle Autorität anerkannt werden.

Gibt es gute Benutzerkennzahlen?

Wenn Nutzer lange Zeit auf der Website verbringen, niedrige Absprungraten haben und andere Anzeichen von Engagement zeigen, interpretiert Google dies möglicherweise als Zeichen der Autorität der Website in diesem Thema.

Denken Sie daran, dass aktuelle Autorität ein Konzept ist, das auf der Relativität verschiedener Subjekte (Entitäten) basiert. Ihre Website kann als aktuelle Autorität zu Themen angesehen werden, die so umfassend sind wie „Technologie“ oder so eng gefasst sind wie „Vintage-Schreibmaschinen“.

Der entscheidende Faktor ist, dass Ihre Website ein positives Benutzerverhalten zeigt und Entitäten effektiv einsetzt, um Beziehungen innerhalb des Inhalts herzustellen. Auf diese Weise beginnt Google, sich auf Ihre Website zu verlassen, um sein eigenes Verständnis des Themas zu verbessern, unabhängig vom gesamten Suchvolumen des Themas.

SEO-Anwendungen und Imbissbuden

Umfassendere Inhalte gewinnen

In früheren Versionen wurden viele Webseiten bei Suchanfragen übersehen, weil sie nicht genau die in der Suche enthaltenen Wörter enthielten.

Beispielsweise würde eine gut verlinkte Seite, die einen bestimmten Suchbegriff nicht enthielt, nicht in den Ergebnissen angezeigt, unabhängig von anderen robusten Ranking-Faktoren wie Benutzerinteraktion und Backlinks.

Dies ermutigte SEOs, weniger fokussiertere Inhalte zu schreiben, um Rankings für ein Ziel-Keyword zu erreichen.

Mit der Einführung von 3.0 und der Fokussierung auf das Verständnis von Entitäten und ihren Beziehungen hat sich das Spiel jedoch verändert.

Dabei geht es nicht darum, ob der exakte Suchbegriff auf der Seite erscheint. Google sucht nun nach relativen Entitäten auf Ihrer Seite und versucht, diese Entitäten mit verwandten Entitäten auf Ihrer gesamten Website zu verknüpfen.

Anschließend ermittelt es die approximative Relativitätstheorie und ordnet Sie entsprechend ein. Dieser grundlegende Wandel bringt Seiten mit starken Ranking-Faktoren in den Wettbewerb, auch wenn ihnen bestimmte Begriffe fehlen

Die wichtigste Erkenntnis für Content-Ersteller und SEO-Strategen besteht darin, sich auf die Erstellung umfassenderer und umfangreicherer Inhalte zu konzentrieren.

Konzentrieren Sie Ihre Backlink-Bemühungen auf diese umfassenden, ausführlichen Artikel, anstatt die Themen auf mehrere eng fokussierte Artikel aufzuteilen.

Nutzen Sie aktuelle SERPs als Ausgangspunkt, um wichtige Themen zu identifizieren, aber lassen Sie sich nicht von ihnen einschränken.

Ziel ist es, über die bestehende thematische Berichterstattung in SERPs hinauszugehen und dem Benutzer wertvolle, umfassende Inhalte bereitzustellen.

Dadurch wird auf die bestehenden Suchanfragen des Benutzers und mögliche verwandte Suchanfragen eingegangen, was letztendlich die Relevanz und Sichtbarkeit Ihrer Inhalte in dieser neuen Ära der Suche erhöht.

Beantworten Sie die Absicht, anstatt sich auf die Verwendung von Schlüsselwörtern zu konzentrieren. Seien Sie vorsichtig mit Schlagzeilen

Im Zeitalter der „Suchmaschine 3.0“ hat sich die SEO-Strategie weiterentwickelt. Es reicht nicht mehr aus, einfach Keywords aus Ihrem Search Console-Bericht in Ihre Inhalte einzufügen und auf bessere Rankings zu hoffen.

Die fortschrittlichen Algorithmen von Google können jetzt erkennen, wenn ein Schlüsselwort außerhalb des Kontexts verwendet wird, was den Algorithmus verwirren und möglicherweise zu niedrigeren Rankings führen kann.

Die Reihenfolge der Kopfzeilen ist wichtig

Nutzen Sie Ihr Gehirn, um die Schlüsselideen zu verbinden, die für das Ziel Ihrer Seite am relevantesten sind. Stellen Sie sicher, dass der Inhalt unter der Überschrift mit dem Thema der Überschrift übereinstimmt.

Erinnern Sie sich an die Tage des Brainstormings für Ihren Schreibunterricht in der Grundschule?

Wir zeichneten Kreise, schrieben Themen in die Kreise und verknüpften sie dann, indem wir eine gerade Linie zu kleineren Kreisen mit relativen Themen zu unserer Geschichte zeichneten.

Machen Sie die Dinge nicht zu kompliziert. Nutzen Sie diese Strategie auch für die Gestaltung Ihrer Überschriften.

Kurz gesagt, „Suchmaschine 3.0“ erfordert einen durchdachteren Ansatz bei der Verwendung von Schlüsselwörtern, der auf die Absichten des Benutzers eingeht und den Kontext beibehält, um Relevanz und Ranking-Potenzial zu verbessern.

Bewerten und Einordnen der Dokumente

Sobald eine Suchmaschine wie Google potenziell relevante Dokumente abgerufen hat, besteht der nächste entscheidende Schritt darin, diese Seiten zu bewerten und sie in eine Rangfolge zu bringen, damit ein Benutzer sie auswählen kann.

Die Entwicklung der künstlichen Intelligenz (KI) und der Verarbeitung natürlicher Sprache (NLP) hat die Art und Weise, wie Dokumente eingestuft werden, erheblich verändert und eine klare Unterscheidung zwischen der 2.0- und der 3.0-Ära markiert.

2.0-Ära (Post-Bag-of-Words, vor RankBrain)

In der 2.0-Ära basierte das Bewertungssystem von Google hauptsächlich auf Algorithmen wie PageRank, Hummingbird, Panda und Penguin.

Diese Algorithmen stützten sich bei der Bewertung von Dokumenten stark auf die Keyword-Übereinstimmung und die Anzahl der Backlinks. Jedes Dokument würde eine Bewertung basierend auf den Seiten erhalten und nach der Rangfolge sortiert werden.

Bei Algorithmenentwicklungen wie Panda und Penguin ging es weniger darum, vom Keyword-Matching abzuweichen, als vielmehr darum, Websites zu bestrafen, die versuchen, das System auszutricksen.

Schlüsselwortbasierte Systeme waren immer noch effizienter und die Hardware war nicht fortschrittlich genug, um mit weiterentwickelten Sprachmethoden schnelle Suchergebnisse zu liefern.

Scoring und Ranking im Zeitalter der Suchmaschine 3.0

In der „Suchmaschinen-3.0“-Landschaft hat sich Googles Ansatz zur Bewertung und Einstufung von Dokumenten erheblich weiterentwickelt.

Dies ist das Ergebnis sowohl von Software- als auch von Hardwareverbesserungen. Google beurteilt die Eignung einer Seite für eine Suchanfrage anhand mehrerer Schlüsselfaktoren.

Der Hauptunterschied besteht in einer verbesserten Fähigkeit, die Relevanz zu quantifizieren, anstatt sich bei der Identifizierung der besten Inhalte auf externe Signale wie Backlinks zu verlassen:

Sachliche Richtigkeit

Sachlich korrekte Inhalte aus seriösen Quellen haben weiterhin einen höheren Rang. Googles Knowledge-Based Trust bestätigt dies mit den Worten:

„Wir nennen den von uns berechneten Vertrauenswürdigkeitswert wissensbasiertes Vertrauen (KBT) … Die manuelle Auswertung einer Teilmenge der Ergebnisse bestätigt die Wirksamkeit der Methode.“

Benutzerinteraktionssignale

Aus diesen Gründen können Strategien „Inhalte von geringer Qualität jetzt veröffentlichen und später bearbeiten“ problematisch sein. Google berücksichtigt jetzt sowohl historische als auch aktuelle Daten zur Nutzerinteraktion, die mit einer Webseite verknüpft sind.

Dieser Wandel wird in Googles Patent mit dem Titel „Engagement and Experience Based Ranking“ (US20140244560A1) beschrieben, das die Verwendung historischer Engagement-Bewertungen als Teil seiner Ranking-Überlegungen hervorhebt.

Hochwertige Engagements

Interaktionen wie lange Klicks, bei denen ein Benutzer längere Zeit auf Ihrer Seite verweilt, sind von Vorteil.

Allerdings können Interaktionen von schlechter Qualität, wie z. B. schnelle Rückkehr zu den Suchergebnissen (bekannt als „Pogo-Sticking“), Ihr Ranking negativ beeinflussen.

Diese Engagement-Kennzahlen können Ihre Ranking-Position und Ihre Impressionen beeinflussen und Ihre thematische Autorität steigern.

Allerdings kann ein schlechtes Nutzerengagement zu einem Rückgang des Rankings Ihrer Seite führen. Die Erholung von einem solchen Rückgang kann einige Zeit dauern, was unterstreicht, wie wichtig es ist, durchgängig hochwertige, relevante Inhalte bereitzustellen, die eine positive Benutzerinteraktion fördern.

SEO-Erkenntnisse und Anwendungen

Fakten Überprüfung

Google kann die sachliche Richtigkeit überprüfen. Investieren Sie Zeit in die Erstellung sachlich korrekter Inhalte.

Dazu gehören ordnungsgemäße Recherche, Faktenprüfung und das Zitieren seriöser Quellen. Implementieren Sie ein Faktencheck-Schema, um Glaubwürdigkeit und Relevanz für Ihre informativen Artikel aufzubauen

Benutzerengagement

Achten Sie auf die Kennzahlen zum Nutzerengagement Ihrer Seite. Wenn Ihre Inhalte die Nutzer nicht wie erwartet ansprechen, sollten Sie Ihre Content-Strategie überarbeiten.

Crawling und Indizierung

Lassen Sie uns zum Abschluss unserer Untersuchung des Suchprozesses einen Blick darauf werfen, wie sich die Web-Crawling- und Indexierungstechniken von Google mit dem Fokus auf Entitäten entwickelt haben.

Das Verständnis dieser Änderungen ist von entscheidender Bedeutung, da sie sich direkt darauf auswirken, wie Sie Ihre Website strukturieren und Ihre Inhaltsstrategie formulieren sollten, einschließlich der Erstellung Ihrer Themenkarte.

Im Zeitalter der „Suchmaschine 2.0“ durchsuchten die Webcrawler von Google, auch Spider genannt, systematisch das Internet, um neue und aktualisierte Seiten zu entdecken.

Sie würden Links von einer Webseite zur anderen folgen und Daten über jede Seite sammeln, um sie im Google-Index zu speichern. Bei diesem Prozess ging es in erster Linie darum, neue Inhalte zu entdecken und sicherzustellen, dass der Index auf dem neuesten Stand bleibt.

Sobald die Crawler eine Seite entdeckten, wurde sie dem Google-Index hinzugefügt – einer riesigen Datenbank aller von Google gefundenen Webseiten.

Der Inhalt jeder Seite (einschließlich Text, Bilder und Videos) wurde analysiert und die Seite wurde basierend auf diesem Inhalt kategorisiert.

Das Hauptaugenmerk lag auf den Schlüsselwörtern und Phrasen im Text sowie auf Faktoren wie Backlinks, die zur Bestimmung der Relevanz und Autorität einer Seite verwendet wurden.

Im Zeitalter der „Suchmaschine 3.0“ sind die Dinge komplexer geworden.

Die Crawler von Google entdecken immer noch neue und aktualisierte Seiten, indem sie Links im Internet folgen. Jetzt versuchen sie aber auch, die Entitäten zu verstehen, die die Schlüsselwörter auf einer Seite darstellen.

Beispielsweise könnte eine Seite über „Elvis“ auch unter verwandten Entitäten wie „Rock’n’Roll-Musik“, „Graceland“ und „Blaue Wildlederschuhe“ indiziert werden.

Darüber hinaus folgen sie Ihren internen Links, um zu verstehen, welche Entitäten Ihre Website miteinander in Verbindung bringt.

Das ist ein bisschen so, als würde ein Bibliothekar Bücher nicht nur anhand ihrer Titel katalogisieren, sondern sie auch lesen, um zu verstehen, wie die Kapitel zueinander und zum Gesamtthema des Buches zusammenhängen.

Dieses tiefere Verständnis hilft Google, relevantere und präzisere Suchergebnisse zu liefern.

Aber in welcher Beziehung steht Crawling zu aktuellen Autoritäten und Entitäten?

Nun, wenn Google eine Website crawlt, geht es nicht mehr nur darum, die einzelnen Seiten isoliert zu betrachten. Dabei geht es auch um das allgemeine Thema oder Thema der Website.

Hier kommt die aktuelle Autorität ins Spiel.

Wenn eine Website regelmäßig qualitativ hochwertige Inhalte zu einem bestimmten Thema veröffentlicht, kann sie als Autorität für dieses Thema angesehen werden.

Wenn Google die Website als Autorität erachtet, kann es sie in den Suchergebnissen hervorheben. (Häufig sehen Sie Websites mit kleinen Backlink-Profilen, die im Wettbewerbsumfeld ranken, wahrscheinlich aufgrund einer Steigerung der thematischen Autoritätsbewertung, die sie erhalten.)

Interessanterweise gibt es das Konzept der aktuellen Autorität schon seit mindestens einigen Jahren, Google hat es jedoch erst kürzlich anerkannt.

Am 23. Mai 2023 veröffentlichte Google „Understanding News Topic Authority“.

Obwohl viele erfahrene SEOs glaubten, dass die thematische Autorität ein Ranking-Faktor sei, konnte dies niemand anhand der von Google veröffentlichten Inhalte überprüfen (abgesehen von der Suche nach angemeldeten Patenten).

Lassen Sie sich in dieser Pressemitteilung nicht durch das Wort „Neuigkeiten“ in die Irre führen. Die Themenautorität bezieht sich auf alle Websites im Web, die von Google gecrawlt werden, nicht nur auf Nachrichtenseiten.

Dieses Konzept der aktuellen Autorität ist im Google-Patent US20180046717A1 beschrieben.

Das Patent beschreibt einen Prozess zur Bestimmung der Autorität einer Website basierend auf der Konsistenz und Tiefe eines bestimmten Themas innerhalb der Website.

Beispielsweise kann eine Website, die regelmäßig hochwertige Inhalte zum Thema „Bio-Gartenbau“ veröffentlicht, einen hohen Reinheitsfaktor aufweisen (ja, Google prüft, ob Ihre Website beim Thema bleibt), was zu einer höheren Autoritätsbewertung beiträgt.

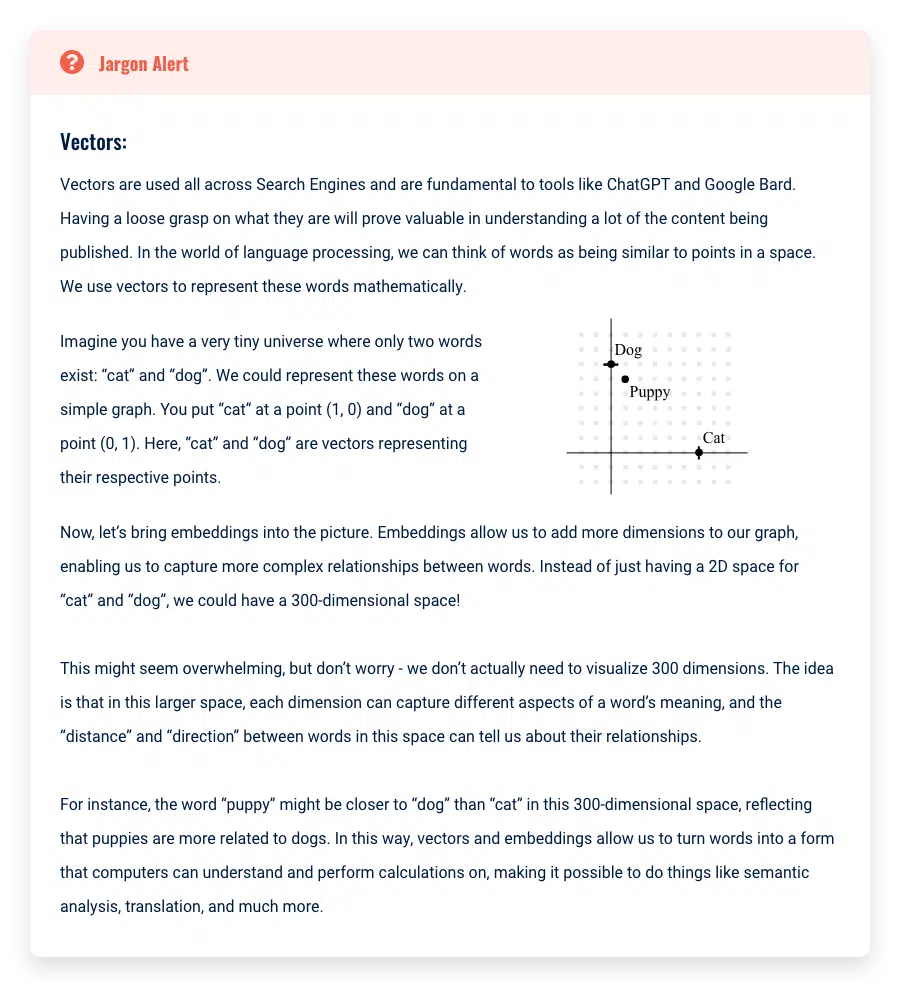

Darüber hinaus kann Google die Hauptthemen aus Ihren Inhalten extrahieren und Ihre Inhalte grafisch darstellen, ähnlich wie ChatGPT Wörter in Einbettungen grafisch darstellt (ein Feature-Vektor).

Dadurch kann Google visuell erkennen, ob Ihre Inhalte ähnlich und konsistent sind, und so das Verständnis für die thematische Autorität Ihrer Website weiter verbessern.

Im Wesentlichen geht es bei der Umstellung des Indexierungssystems von Google also nicht nur darum, den Inhalt einzelner Seiten zu verstehen, sondern auch darum, den thematischen Schwerpunkt einer Website zu erkennen.

Dies unterstreicht, wie wichtig es ist, bei Ihrer Content-Strategie einen konsistenten Fokus beizubehalten, da dies die Sichtbarkeit Ihrer Website in den Suchergebnissen erheblich beeinflussen kann.

SEO-Erkenntnisse und Anwendungen

Konsequenter Themenfokus

Google kann erkennen, wenn Ihre Website von ihrem Hauptthema abweicht. Wenn Ihr Inhalt inkonsistent ist, kann dies dazu führen, dass Zweck und Ziel Ihrer Website verwechselt werden.

Behalten Sie bei Ihrer Content-Strategie einen konsequenten Fokus bei, um von den mit der thematischen Autorität verbundenen Punktesteigerungen zu profitieren.

Inhaltliche Tiefe

Der Aufbau von Tiefe in Ihren Inhalten ist der Schlüssel, sie sollte jedoch relevant sein. Nutzen Sie Ihr Verständnis des Hauptzwecks Ihrer Website, um die Tiefe Ihres Inhalts zu bestimmen.

Wenn der Hauptzweck Ihrer Website beispielsweise darin besteht, Informationen über digitale Fototechniken bereitzustellen, sollten Sie sich nicht ausführlich mit der Geschichte der Filmkameras befassen.

Obwohl es mit der Fotografie zu tun hat, passt es nicht ganz zum Hauptschwerpunkt Ihrer Website auf digitale Techniken. Vertiefen Sie stattdessen Ihre Inhalte, indem Sie verschiedene Techniken der digitalen Fotografie erkunden, Digitalkameras überprüfen oder Tipps zum Bearbeiten digitaler Fotos geben.

Zu viel Inhalt kann Ihre Autorität schwächen

Zu viel Inhalt auf Ihrer Website kann den Sinn und Zweck Ihrer Website verwässern.

Durchsuchen Sie Ihre Sitemap und stellen Sie sicher, dass sie nur Inhalte enthält, die Ihre Kernideen unterstützen, und dass der Inhalt von ausreichender Qualität ist, um Google dabei zu helfen, Entitäten zu verstehen.

Verwendung kontextueller Brücken

Beim Erstellen neuer Inhalte ist es wichtig, „kontextuelle Brücken“ zu verwenden, um sie wieder mit dem Hauptzweck Ihrer Website zu verbinden.

Anstatt einfach neue Inhalte zu Ihrer Website hinzuzufügen, fragen Sie sich immer, wie Sie eine neue Seite mit Ihrem primären Ziel verknüpfen können.

Dadurch kann Google damit beginnen, die Entitäten Ihrer neuen Seite mit Ihrer primären Zielentität zu verknüpfen.

Einschränkungen und Zwänge der aktuellen Autorität

Obwohl wir uns auf den Aufbau thematischer Autorität auf allen von uns erstellten Websites konzentrieren möchten, gibt es dennoch einige Einschränkungen.

Bei diesen Einschränkungen handelt es sich um verbleibende Ranking-Faktoren aus der Zeit des Web 2.0, denen Google immer noch ein angemessenes Maß an Ranking-Power zuerkennt: Zeit im Web und Backlinks.

Erstens braucht es Zeit, um Themenautorität aufzubauen. Mit der jüngsten Explosion von Tools zur Erstellung von KI-Inhalten kann dieser Zeitrahmen drastisch verkürzt werden, aber es braucht immer noch Zeit.

Die Verwendung aktueller Autorität hängt auch davon ab, wie „autoritär“ andere Websites in Ihrer Nische genau sind.

Wenn Sie beispielsweise großartige Inhalte auf der Grundlage einer unglaublichen Themenkarte erstellen, werden Sie dennoch mit anderen Websites in Ihrer Nische verglichen.

Wenn diese anderen Seiten im Laufe der Zeit ebenfalls eine große thematische Autorität entwickelt haben, dann verweisen wir auf das uralte Problem der Backlinks und der Verweildauer im Web.

Es ist äußerst schwierig, Websites zu übertreffen, die eine großartige Entitätsentwicklung entwickelt haben und dies auf einer Domain getan haben, die seit mehreren Jahren oder länger im Internet verfügbar ist. Möglich, sicher, aber dennoch schwierig.

Lassen Sie uns über Backlinks sprechen.

Obwohl es durchaus möglich ist, Websites mit einem guten Ranking ohne den Einsatz von Backlinks zu erstellen, kann es selbst erfahrenen SEOs schwerfallen, dies zu tun.

Backlinks sind nach wie vor ein sehr wichtiger Rankingfaktor. Sicher, sie sind vielleicht nicht mehr so mächtig wie früher, aber sie sind immer noch mächtig.

Das Problem, Backlinks eine so große Ranking-Power zu verleihen, liegt bei großen Nachrichtenkonzernen, die sich eigentlich nicht auf ein Thema „spezialisieren“.

Wir alle haben es gesehen: Wir googeln „Bestes Widget für xyz“ und die ersten 10–15 Ergebnisse sind Nachrichtennetzwerkseiten, die alle behaupten, die besten Ratgeber für den Kauf dieser Widgets zu haben.

Sind die Nachrichtenseiten auf die Entwicklung oder den Verkauf dieser Widgets spezialisiert?

Haben diese Nachrichtenseiten eine aktuelle Autorität, wenn es um diese Widgets geht?

Gar nicht.

Wenn die Nachrichtenseiten keine thematische Autorität über diese Widgets haben, warum dominieren sie dann immer noch die SERPs? Es kommt auf die Zeit im Web und die Backlink-Profile an.

Da die Redakteure dieser großen Nachrichtennetzwerke wissen, dass sie einen extrem hohen Rang erreichen werden, sobald sie auf die Schaltfläche „Veröffentlichen“ klicken, werben sie um den Verkauf von Werbeflächen auf ihren Websites.

Unternehmen wissen auch, dass ihr Produkt ganz oben in den Google-SERPs landen wird, und zahlen daher bereitwillig Tausende und Abertausende von Dollar für diese Funktion.

Sie berauben im Wesentlichen die Fähigkeit der Nachrichtenseite, SERPs zu dominieren, wann immer sie etwas veröffentlicht – daher der Name „Parasit SEO“.

Unabhängig davon, wie relevant Ihre Website thematisch ist, wird sie Schwierigkeiten haben, mit diesen Nachrichtenseiten-Kraftpaketen zu konkurrieren.

Solange Google dieses Problem nicht angeht, reicht es leider nicht aus, eine aktuelle Autorität zu werden, um mit einigen dieser heißen SERPs zu konkurrieren, die Nachrichtenseiten dominieren.

SEO im Zeitalter der Entitäten beherrschen

Indem ich Sie durch den Weg von der Abfrageverarbeitung zur Indexierung und zum Ranking geführt habe, habe ich Ihnen hoffentlich dabei geholfen, Ihre „fiktive Maschine“ zu aktualisieren, um den neuesten Änderungen an der Google-Suchmaschine besser Rechnung zu tragen.

Dieses verfeinerte Verständnis sollte Ihnen dabei helfen, Ihre Taktiken zu verbessern, indem Sie Ihre Zeit und die Rankings Ihrer eigenen Website und der Ihrer Kunden konzentrieren.

Schließlich ist es wichtig, sich daran zu erinnern, dass die Theorie wirklich glänzt, wenn sie in der Praxis angewendet wird.

Beispielsweise haben Affiliate-SEO-Praktiker vor einiger Zeit herausgefunden, dass die Erstellung einer beträchtlichen Menge an Inhalten zu ihrem Thema einen SEO-Schub an thematischer Autorität auslösen kann.

Dies wurde erkannt, lange bevor die Weiterentwicklung unseres Verständnisses von Entity-SEO ins Spiel kam.

Die SEO-Reise entwickelt sich ständig weiter und bietet zahlreiche Möglichkeiten für Entdeckungen und Verbesserungen.

Ausgestattet mit diesem Wissen und diesen Erkenntnissen ist es für Sie an der Zeit, einzutauchen, zu experimentieren und Ihre eigenen SEO-Strategien zu entwickeln. Der Beweis für den Pudding liegt schließlich beim Essen. Viel Spaß beim Testen!

Dieser Artikel wurde von Paul DeMott mitverfasst .

Dies ist der dritte Artikel in der Entity-SEO-Reihe. Wenn Sie mit der Lektüre der ersten beiden Artikel beginnen möchten, sind diese hier verlinkt:

- Der definitive Leitfaden für Entity-SEO

- So optimieren Sie für Entitäten

- 3 Möglichkeiten, KI für die Website-weite Entitätsoptimierung zu nutzen

Die in diesem Artikel geäußerten Meinungen sind die des Gastautors und nicht unbedingt die von Search Engine Land. Die Autoren unserer Mitarbeiter sind hier aufgelistet.