So verbessern Sie die Crawling- und Indexierungseffizienz auf Unternehmensebene

Veröffentlicht: 2023-07-13Für Enterprise SEO gelten andere Regeln.

Strategien, die für kleine oder Nischen-Websites funktionieren, funktionieren nicht immer im großen Maßstab.

Was genau kann also passieren, wenn Unternehmens-SEO zu groß wird?

In diesem Artikel werde ich drei Beispiele aus der Praxis vorstellen. Anschließend lernen Sie ein mögliches Gegenmittel für ein effizienteres SEO-Management in großem Maßstab kennen.

Angesichts des Indexierungsdilemmas

Kleine Websites neigen dazu, Seite für Seite zu wachsen und dabei Schlüsselwörter als Bausteine einer SEO-Strategie zu verwenden.

Große Websites verfolgen häufig ausgefeiltere Ansätze und stützen sich stark auf Systeme, Regeln und Automatisierung.

Es ist wichtig, SEO mit den Geschäftszielen in Einklang zu bringen. Die Messung des SEO-Erfolgs anhand von Keyword-Rankings oder Traffic führt zu negativen Folgen aufgrund einer Überindizierung.

Es gibt keine Zauberformel, um die optimale Anzahl indizierter URLs zu bestimmen. Google legt keine Obergrenze fest.

Ein guter Ausgangspunkt ist jedoch, den Gesamtzustand des SEO-Trichters zu berücksichtigen. Wenn eine Website…

- Schickt Dutzende oder Hunderte Millionen oder sogar Milliarden von URLs an Google

- Rankings nur für ein paar Millionen Keywords

- Erhält Besuche auf einigen tausend Seiten

- Konvertiert einen Bruchteil davon (falls überhaupt)

… dann ist es ein guter Hinweis darauf, dass Sie sich mit ernsthaften SEO-Gesundheitsbedürfnissen befassen müssen.

Wenn Sie jetzt alle Probleme mit der Website-Hygiene beheben, sollten später noch größere SEO-Probleme vermieden werden.

Schauen wir uns drei reale SEO-Beispiele für Unternehmen an, die veranschaulichen, warum dies so wichtig ist.

Fall 1: Folgen einer Überindizierung minderwertiger Inhalte

Google verfügt nur über begrenzte Ressourcen für das Web-Crawling und die Verarbeitung. Sie priorisieren Inhalte, die für Benutzer wertvoll sind.

Google crawlt möglicherweise Seiten, die es als dünn, doppelt oder von geringer Qualität einstuft, aber nicht indiziert.

Wenn es nur ein paar Seiten sind, ist das kein Problem. Wenn es jedoch weit verbreitet ist, ignoriert Google möglicherweise ganze Seitentypen oder den größten Teil des Inhalts der Website.

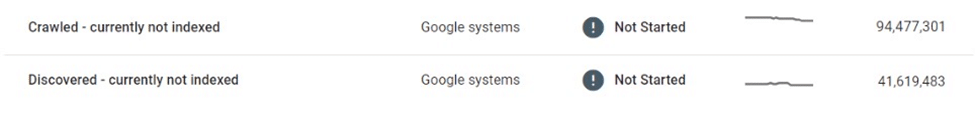

In einem Fall stellte ein E-Commerce-Marktplatz fest, dass zig Millionen seiner Angebotsseiten durch selektives Crawling und Indexierung beeinträchtigt waren.

Nachdem Google Millionen dünner, nahezu doppelt vorhandener Eintragsseiten gecrawlt und nicht indiziert hatte, reduzierte es schließlich das Crawlen der Website ganz und ließ viele in der Schwebe „Entdeckt – derzeit nicht indiziert“ zurück.

Dieser Marktplatz war in hohem Maße auf Suchmaschinen angewiesen, um Nutzern neue Angebote vorzustellen. Es wurden keine neuen Inhalte mehr entdeckt, was eine erhebliche geschäftliche Herausforderung darstellte.

Es wurden einige Sofortmaßnahmen ergriffen, beispielsweise die Verbesserung der internen Verlinkung und die Bereitstellung dynamischer XML-Sitemaps. Letztlich waren diese Versuche vergeblich.

Die eigentliche Lösung bestand darin, die Menge und Qualität der indexierbaren Inhalte zu kontrollieren.

Fall 2: Unvorhergesehene Folgen des Kriechens hören auf

Wenn das Crawling stoppt, verbleiben unerwünschte Inhalte im Google-Index – auch wenn sie geändert, umgeleitet oder gelöscht werden.

Viele Websites verwenden Weiterleitungen anstelle von 404-Fehlern für entfernte Inhalte, um die Autorität aufrechtzuerhalten. Diese Taktik kann über Monate, wenn nicht Jahre hinweg zusätzlichen Traffic von Geisterseiten unterdrücken.

Allerdings kann das manchmal furchtbar schief gehen.

Beispielsweise hat ein bekannter globaler Marktplatz, der handgefertigte Waren verkauft, versehentlich die privaten Informationen der Verkäufer (z. B. Name, Adresse, E-Mail-Adresse, Telefonnummer) auf lokalisierten Versionen seiner Angebotsseiten preisgegeben. Einige dieser Seiten wurden von Google indiziert und zwischengespeichert, wodurch personenbezogene Daten (PII) in den Suchergebnissen angezeigt werden, was die Sicherheit und den Datenschutz der Nutzer gefährdet.

Da Google diese Seiten nicht erneut gecrawlt hat, wurden sie durch das Entfernen oder Aktualisieren nicht aus dem Index entfernt. Auch Monate nach der Löschung waren zwischengespeicherte Inhalte und Benutzer-PII-Daten weiterhin im Google-Index vorhanden.

In einer solchen Situation lag es in der Verantwortung des Marktplatzes, die Fehler zu beheben und direkt mit Google zusammenzuarbeiten, um sensible Inhalte aus der Suche zu entfernen.

Fall 3: Die Risiken einer Überindizierung von Suchergebnisseiten

Die unkontrollierte Indizierung großer Mengen dünner Seiten mit geringer Qualität kann nach hinten losgehen – aber wie sieht es mit der Indizierung von Suchergebnisseiten aus?

Google unterstützt die Indexierung interner Suchergebnisse nicht und viele erfahrene SEOs würden dringend von dieser Taktik abraten. Viele große Websites haben sich jedoch stark auf die interne Suche als Haupttreiber für die Suchmaschinenoptimierung verlassen, was oft zu erheblichen Erträgen führt.

Wenn die Kennzahlen zum Nutzerengagement, die Seitenerfahrung und die Inhaltsqualität hoch genug sind, kann Google ein Auge zudrücken. Tatsächlich gibt es genügend Beweise dafür, dass Google möglicherweise sogar eine qualitativ hochwertige interne Suchergebnisseite einer dünnen Eintragsseite vorzieht.

Allerdings kann diese Strategie auch schief gehen.

Ich habe einmal gesehen, wie eine lokale Auktionsseite über Nacht einen erheblichen Teil ihres Suchseitenrankings – und mehr als ein Drittel ihres SEO-Verkehrs – verloren hat.

Die 20/80-Regel gilt insofern, als ein kleiner Teil der Hauptbegriffe die meisten SEO-Besuche in indexierten Suchergebnissen ausmacht. Allerdings ist es oft der Long Tail, der den Löwenanteil des URL-Volumens ausmacht und einige der höchsten Conversion-Raten aufweist.

Daher legen nur wenige Websites, die diese Taktik anwenden, strenge Beschränkungen oder Regeln für die Indexierung von Suchseiten fest.

Dies wirft zwei große Probleme auf:

- Jede Suchanfrage kann eine gültige Seite generieren, was bedeutet, dass unendlich viele Seiten automatisch generiert werden können.

- Alle von ihnen sind in Google indexierbar.

Im Fall eines Kleinanzeigen-Marktplatzes, der seine Suchseiten mit Anzeigen von Drittanbietern monetarisierte, wurde diese Schwachstelle durch eine Form der Anzeigenarbitrage gut ausgenutzt:

- Es wurde eine enorme Anzahl von Such-URLs für zwielichtige, nicht jugendfreie und völlig illegale Begriffe generiert.

- Diese automatisch generierten Seiten lieferten zwar keine tatsächlichen Inventarergebnisse, lieferten jedoch Anzeigen von Drittanbietern und wurden durch Seitenvorlagen und Metadaten für das Ranking bei angeforderten Suchanfragen optimiert.

- Von minderwertigen Foren wurden Backlinks zu diesen Seiten erstellt, damit sie von Bots entdeckt und gecrawlt werden.

- Nutzer, die über Google auf diese Seiten gelangten, klickten auf die Anzeigen von Drittanbietern und gelangten zu den minderwertigen Websites, die als Ziel vorgesehen waren.

Als der Plan entdeckt wurde, war der allgemeine Ruf der Website beschädigt. Darüber hinaus kam es zu mehreren Strafen und anhaltenden massiven Einbußen bei der SEO-Leistung.

Einführung der verwalteten Indizierung

Wie hätten diese Probleme vermieden werden können?

Eine der besten Möglichkeiten für große Unternehmenswebsites, im Bereich SEO erfolgreich zu sein, ist die Verkleinerung durch verwaltete Indexierung.

Bei einer Website mit Dutzenden oder Hunderten Millionen Seiten ist es entscheidend, über einen schlüsselwortorientierten Ansatz hinaus zu einem Ansatz zu gelangen, der auf Daten, Regeln und Automatisierung basiert.

Datengesteuerte Indizierung

Ein wesentlicher Vorteil großer Websites ist die Fülle an internen Suchdaten, die ihnen zur Verfügung stehen.

Anstatt sich auf externe Tools zu verlassen, können sie diese Daten nutzen, um die regionale und saisonale Suchnachfrage und -trends auf granularer Ebene zu verstehen.

Wenn diese Daten dem vorhandenen Inhaltsinventar zugeordnet werden, können sie einen verlässlichen Leitfaden dafür liefern, welche Inhalte wann und wo indexiert werden sollen.

Deduplizieren und konsolidieren

Eine kleine Anzahl maßgeblicher, hochrangiger URLs ist weitaus wertvoller als eine große Menge an Seiten, die über die Top 100 verstreut sind.

Es lohnt sich, ähnliche Seiten mithilfe von Canonicals zu konsolidieren und dabei Regeln und Automatisierung zu nutzen. Einige Seiten werden möglicherweise auf der Grundlage von Ähnlichkeitswerten konsolidiert, andere werden gruppiert, wenn sie bei ähnlichen Suchanfragen insgesamt einen Rang einnehmen.

Der Schlüssel hier ist das Experimentieren. Optimieren Sie die Logik und überarbeiten Sie die Schwellenwerte im Laufe der Zeit.

Bereinigen Sie dünne und leere Inhaltsseiten

Wenn dünne und leere Seiten in großen Mengen vorhanden sind, können sie die Hygiene und Leistung der Website erheblich beeinträchtigen.

Wenn es zu schwierig ist, sie mit wertvollen Inhalten zu verbessern oder zu konsolidieren, sollten sie nicht indiziert oder sogar nicht zugelassen werden.

Reduzieren Sie unendlich viele Leerzeichen mit robots.txt

Fünfzehn Jahre nachdem Google zum ersten Mal über „unendliche Räume“ geschrieben hat, beschäftigt das Problem der Überindizierung von Filtern, Sortierungen und anderen Kombinationen von Parametern weiterhin viele E-Commerce-Websites.

In extremen Fällen können Crawler Server zum Absturz bringen, wenn sie versuchen, durch diese Links zu gelangen. Glücklicherweise kann dies leicht über robots.txt behoben werden.

Clientseitiges Rendering

Die Verwendung von clientseitigem Rendering für bestimmte On-Page-Komponenten, die nicht von Suchmaschinen indiziert werden sollen, könnte eine Option sein. Bedenken Sie dies sorgfältig.

Besser noch: Diese Komponenten sollten für abgemeldete Benutzer nicht zugänglich sein.

Mit zunehmender Größe steigen die Einsätze dramatisch

Obwohl SEO oft als „kostenlose“ Traffic-Quelle wahrgenommen wird, ist dies etwas irreführend. Das Hosten und Bereitstellen von Inhalten kostet Geld.

Die Kosten pro URL mögen vernachlässigbar sein, aber sobald die Größenordnung Hunderte von Millionen oder Milliarden von Seiten erreicht, summieren sich die Centbeträge zu echten Zahlen.

Auch wenn der SEO-ROI schwer zu messen ist, ist jeder eingesparte Cent ein verdienter Cent, und Kosteneinsparungen durch verwaltetes Crawling und Indexierung sollten ein Faktor sein, wenn man über Indexierungsstrategien für große Websites nachdenkt.

Ein pragmatischer SEO-Ansatz – mit gut verwaltetem Crawling und Indexierung, geleitet von Daten, Regeln und Automatisierung – kann große Websites vor kostspieligen Fehlern schützen.

Die in diesem Artikel geäußerten Meinungen sind die des Gastautors und nicht unbedingt die von Search Engine Land. Die Autoren unserer Mitarbeiter sind hier aufgelistet.