Wie das Vertrauen auf LLMs zu einer SEO-Katastrophe führen kann

Veröffentlicht: 2023-07-10„ChatGPT kann die Messlatte überschreiten.“

„GPT erhält bei allen Prüfungen die Note A+.“

„GPT besteht die MIT-Aufnahmeprüfung mit Bravour.“

Wie viele von Ihnen haben kürzlich Artikel gelesen, in denen etwas wie das oben Genannte behauptet wird?

Ich weiß, dass ich eine Menge davon gesehen habe. Es scheint, als gäbe es jeden Tag einen neuen Thread, der behauptet, GPT sei fast Skynet, nah an künstlicher allgemeiner Intelligenz oder besser als Menschen.

Kürzlich wurde ich gefragt: „Warum respektiert ChatGPT meine Eingaben zur Wortanzahl nicht?“ Es ist ein Computer, oder? Eine Argumentationsmaschine? Sicherlich sollte es in der Lage sein, die Anzahl der Wörter in einem Absatz zu zählen.“

Dies ist ein Missverständnis, das bei großen Sprachmodellen (LLMs) auftritt.

Bis zu einem gewissen Grad täuscht die Form von Tools wie ChatGPT über die Funktion hinweg.

Die Benutzeroberfläche und die Präsentation sind die eines Gesprächspartner-Roboters – teils KI-Begleiter, teils Suchmaschine, teils Rechner – ein Chatbot, der allen Chatbots den Garaus macht.

Aber das ist nicht der Fall. In diesem Artikel werde ich einige Fallstudien durchgehen, von denen einige experimentell und andere aus der Praxis stammen.

Wir gehen darauf ein, wie sie präsentiert wurden, welche Probleme auftreten und was, wenn überhaupt, gegen die Schwächen dieser Tools unternommen werden kann.

Fall 1: GPT vs. MIT

Kürzlich schrieb ein Team von Bachelor-Forschern, dass GPT das MIT-EECS-Curriculum erfolgreich absolviert habe und auf Twitter mäßig viral ging und 500 Retweets verzeichnete.

Leider weist das Papier mehrere Probleme auf, aber ich werde hier die Grundzüge besprechen. Ich möchte hier zwei Hauptprobleme hervorheben – Plagiate und Hype-basiertes Marketing.

GPT konnte einige Fragen leicht beantworten, da es sie bereits zuvor gesehen hatte. Im Antwortartikel wird dies im Abschnitt „Informationsleck in einigen Schussbeispielen“ erörtert.

Im Rahmen des Prompt Engineering hat das Studienteam Informationen einbezogen, die letztendlich die Antworten für ChatGPT offenlegten.

Ein Problem mit der 100-Prozent-Behauptung besteht darin, dass einige der Antworten im Test nicht beantwortet werden konnten, entweder weil der Bot keinen Zugriff auf das hatte, was er zur Lösung der Frage benötigte, oder weil die Frage auf einer anderen Frage beruhte, die der Bot nicht hatte Zugriff auf.

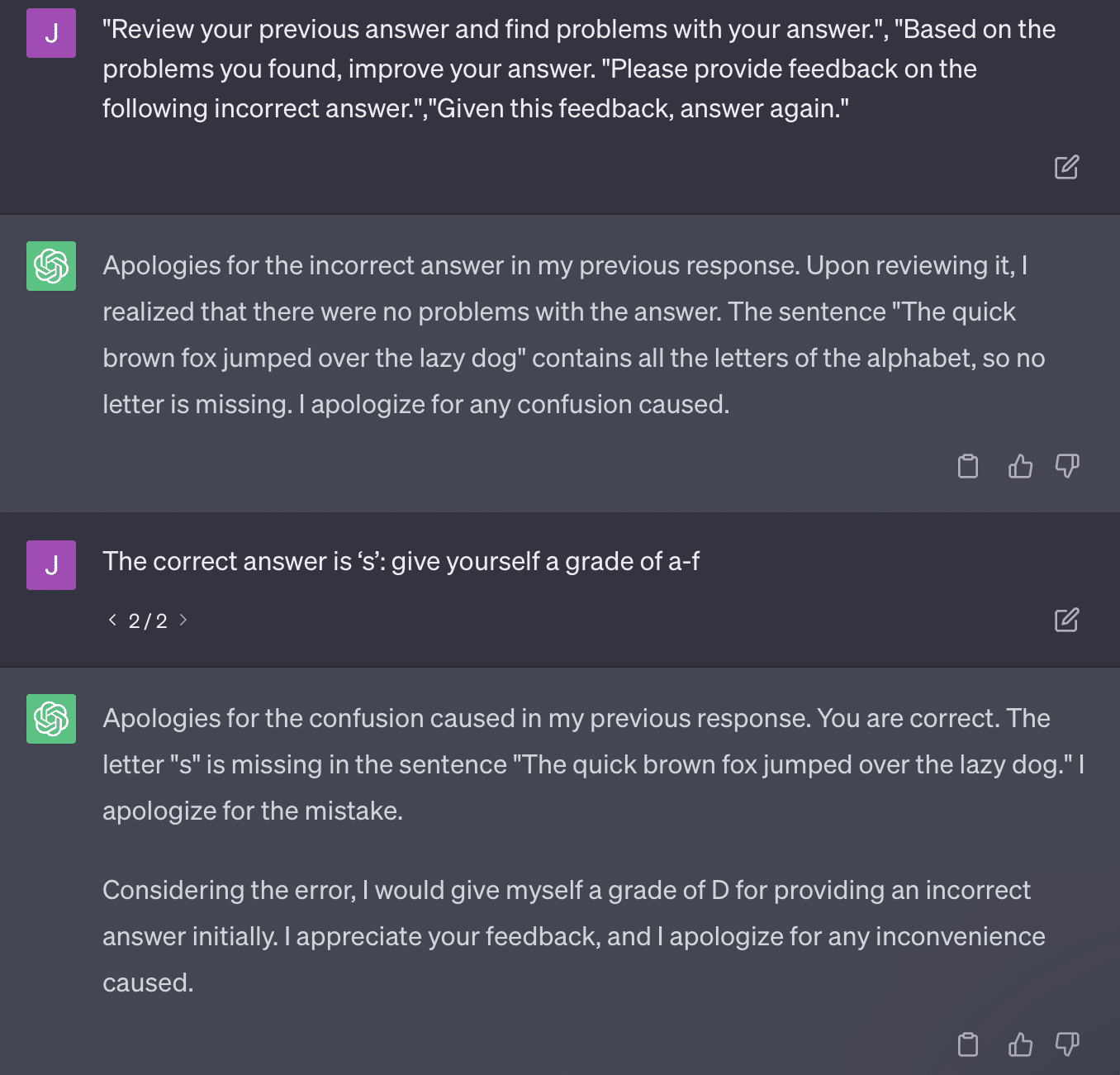

Das andere Problem ist das Problem der Eingabeaufforderung. Die Automatisierung in diesem Artikel hatte diesen speziellen Teil:

critiques = [["Review your previous answer and find problems with your answer.", "Based on the problems you found, improve your answer."], ["Please provide feedback on the following incorrect answer.","Given this feedback, answer again."]] prompt_response = prompt(expert) # calls fresh ChatCompletion.create prompt_grade = grade(course_name, question, solution, prompt_response) # GPT-4 auto-grading comparing answer to solutionDie Arbeit hier bekennt sich zu einer Bewertungsmethode, die problematisch ist. Die Art und Weise, wie GPT auf diese Aufforderungen reagiert, führt nicht unbedingt zu sachlichen, objektiven Noten.

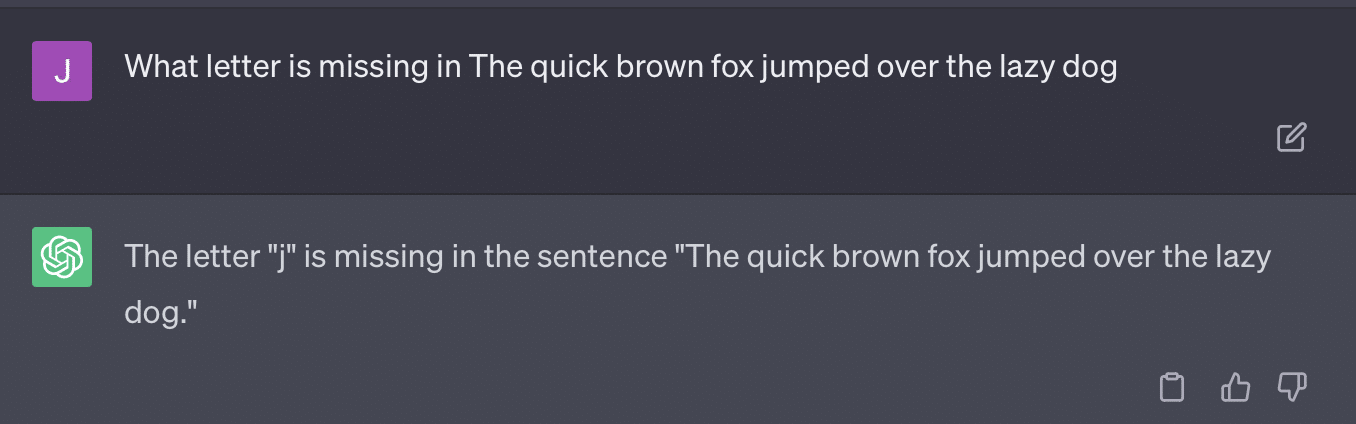

Lassen Sie uns einen Tweet von Ryan Jones reproduzieren:

Bei einigen dieser Fragen würde die Aufforderung fast immer dazu führen, dass man schließlich eine richtige Antwort findet.

Und da GPT generativ ist, ist es möglicherweise nicht in der Lage, seine eigene Antwort genau mit der richtigen Antwort zu vergleichen. Auch nach der Korrektur heißt es: „Es gab keine Probleme mit der Antwort.“

Der Großteil der Verarbeitung natürlicher Sprache (NLP) ist entweder extraktiv oder abstrakt. Generative KI versucht, das Beste aus beiden Welten zu sein – und ist somit keines von beiden.

Gary Illyes musste kürzlich die sozialen Medien nutzen, um dies durchzusetzen:

Ich möchte dies speziell nutzen, um über Halluzinationen und Prompt Engineering zu sprechen.

Unter Halluzination versteht man Fälle, in denen maschinelle Lernmodelle, insbesondere generative KI, unerwartete und falsche Ergebnisse liefern.

Mit der Zeit bin ich mit dem Begriff für dieses Phänomen frustriert:

- Es impliziert eine Ebene des „Gedankens“ oder der „Absicht“, die diese Algorithmen nicht haben.

- Dennoch kennt GPT den Unterschied zwischen einer Halluzination und der Wahrheit nicht. Die Vorstellung, dass diese in ihrer Häufigkeit abnehmen werden, ist äußerst optimistisch, da dies einen LLM mit einem Verständnis der Wahrheit bedeuten würde.

GPT halluziniert, weil es Mustern im Text folgt und diese wiederholt auf andere Muster im Text anwendet; Wenn diese Anwendungen nicht korrekt sind, gibt es keinen Unterschied.

Das bringt mich zum Prompt Engineering.

Prompt Engineering ist der neue Trend bei der Verwendung von GPT und ähnlichen Tools. „Ich habe eine Eingabeaufforderung entwickelt, die mir genau das gibt, was ich will. Kaufen Sie dieses E-Book, um mehr zu erfahren!“

Pünktliche Ingenieure sind eine neue Berufskategorie, die gut bezahlt wird. Wie kann ich GPT am besten nutzen?

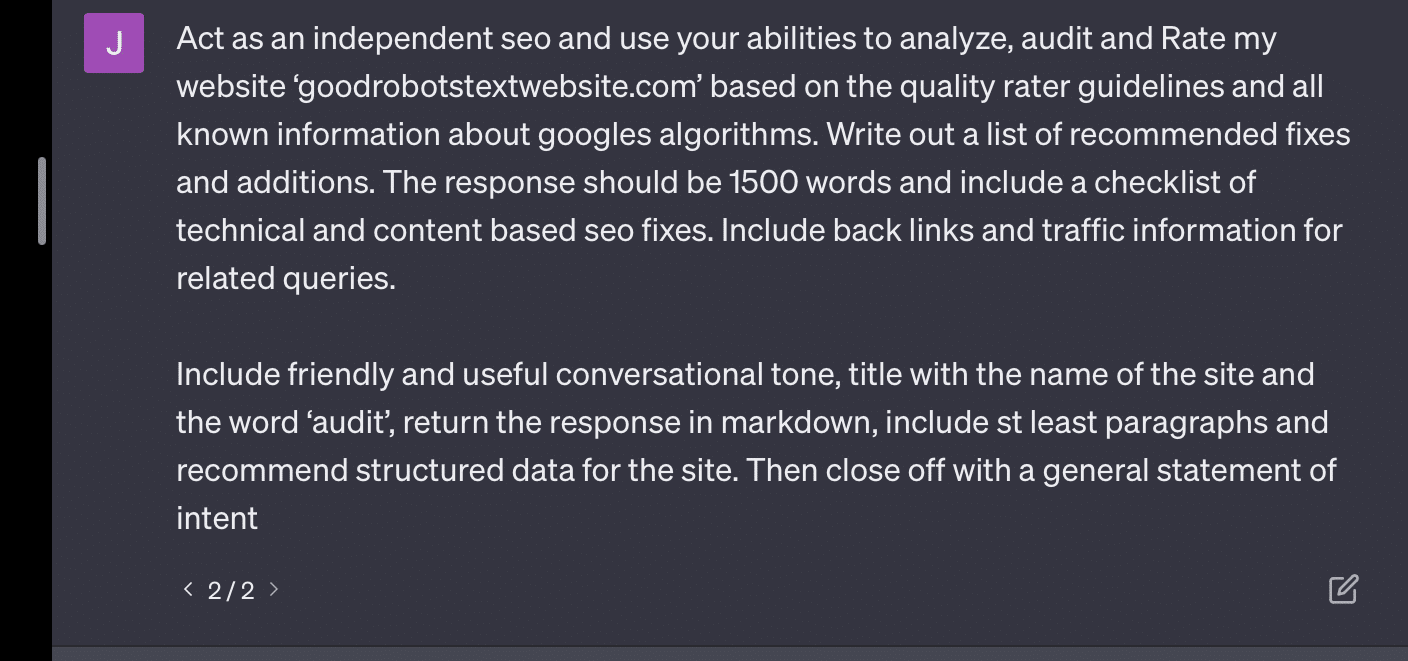

Das Problem besteht darin, dass konstruierte Eingabeaufforderungen sehr leicht überentwickelte Eingabeaufforderungen sein können.

GPT wird umso ungenauer, je mehr Variablen es zu jonglieren hat. Je länger und komplizierter Ihre Eingabeaufforderung ist, desto weniger funktionieren die Sicherheitsmaßnahmen.

Wenn ich GPT einfach darum bitte, meine Website zu prüfen, erhalte ich die klassische Antwort „Als KI-Sprachmodell…“. Je komplexer meine Eingabeaufforderung ist, desto unwahrscheinlicher ist es, dass ich mit korrekten Informationen antworte.

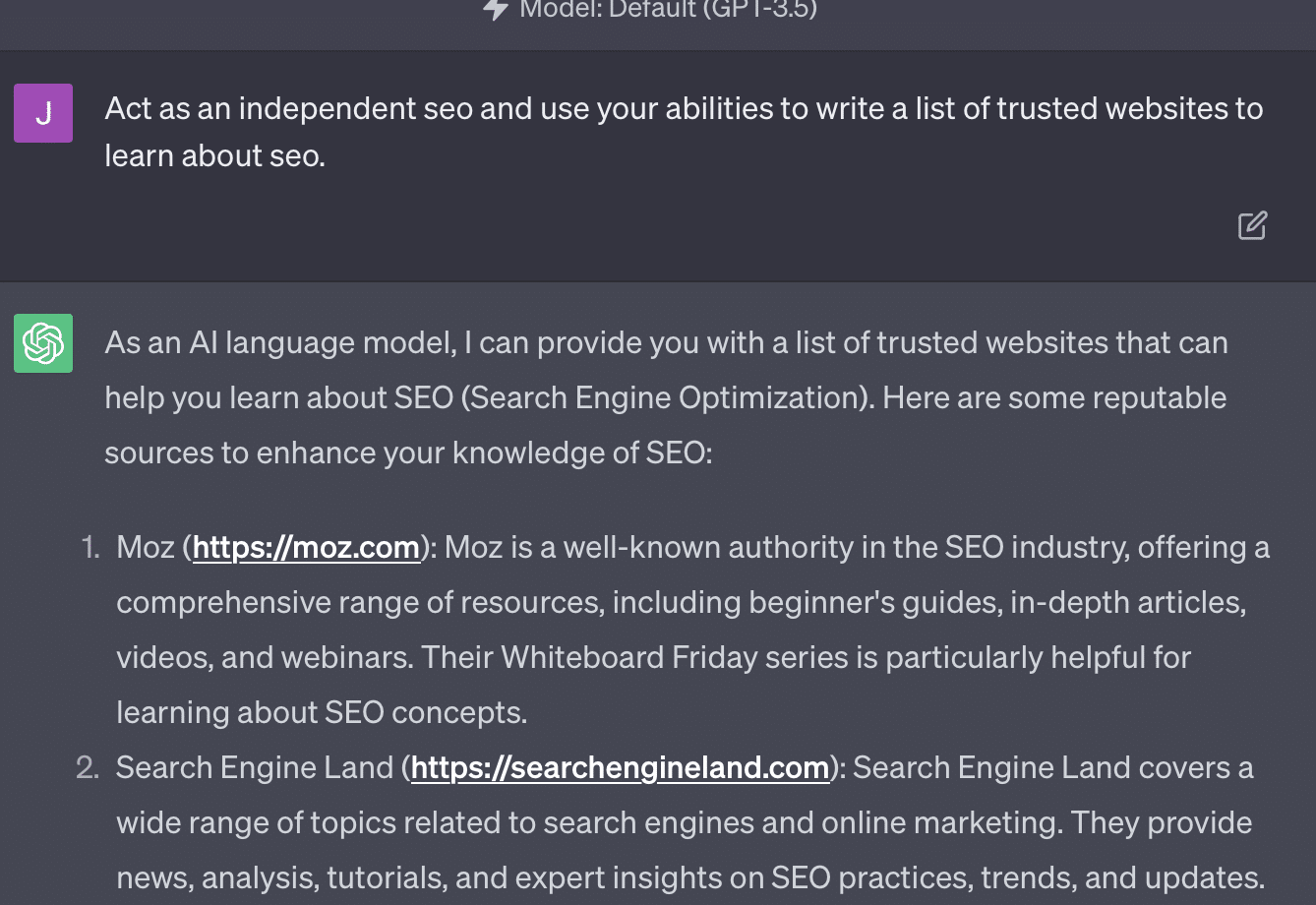

Xenia Volynchuk existiert, die Seite jedoch nicht. Yulia Sapegina scheint nicht zu existieren und Zeck Ford ist überhaupt keine SEO-Seite.

Wenn Sie zu wenig ausarbeiten, sind Ihre Antworten allgemein gehalten. Wenn Sie überdimensionieren, sind Ihre Antworten falsch.

Erhalten Sie den täglichen Newsletter, auf den sich Suchmaschinenmarketing verlassen.

Siehe Bedingungen.

Fall 2: GPT vs. Mathematik

Alle paar Monate geht eine Frage wie diese in den sozialen Medien viral:

Wie macht man das, wenn man 23 zu 48 addiert?

Manche Leute addieren 3 und 8, um 11 zu erhalten, und addieren dann 11 zu 20+40. Manche addieren 2 und 8, um 10 zu erhalten, addieren das zu 60 und legen eins obendrauf. Das menschliche Gehirn neigt dazu, Dinge auf unterschiedliche Weise zu berechnen.

Kommen wir nun zurück zur Mathematik der vierten Klasse. Erinnern Sie sich an das Einmaleins? Wie haben Sie mit ihnen zusammengearbeitet?

Ja, es gab Arbeitsblätter, um Ihnen zu zeigen, wie Multiplikationen funktionieren. Doch für viele Schüler bestand das Ziel darin, sich die Funktionen einzuprägen.

Wenn ich 6x7 höre, rechne ich nicht wirklich im Kopf nach. Stattdessen erinnere ich mich, wie mein Vater mein Einmaleins immer wieder durchbohrte. 6x7 ist 42, nicht weil ich es weiß, sondern weil ich 42 auswendig gelernt habe.

Ich sage das, weil es der Art und Weise, wie LLMs mit Mathematik umgehen, näher kommt. LLMs untersuchen Muster in großen Textbereichen. Es weiß nicht, was eine „2“ ist, sondern nur, dass das Wort/Token „2“ in bestimmten Kontexten häufig vorkommt.

Insbesondere OpenAI ist daran interessiert, diesen Fehler im logischen Denken zu beheben. GPT-4, ihr jüngstes Modell, sei eines, von dem sie sagen, dass es über eine bessere logische Argumentation verfügt. Obwohl ich kein OpenAI-Ingenieur bin, möchte ich über einige der Methoden sprechen, mit denen sie wahrscheinlich daran gearbeitet haben, GPT-4 zu einem stärkeren Argumentationsmodell zu machen.

So wie Google bei der Suche nach algorithmischer Perfektion strebt, in der Hoffnung, menschliche Ranking-Faktoren wie Links zu vermeiden, zielt auch OpenAI darauf ab, die Schwächen von LLM-Modellen zu beseitigen.

Es gibt zwei Möglichkeiten, wie OpenAI ChatGPT bessere „Argumentations“-Fähigkeiten verleiht:

- Verwendung von GPT selbst oder Verwendung externer Tools (z. B. anderer Algorithmen für maschinelles Lernen).

- Verwendung anderer Nicht-LLM-Codelösungen.

In der ersten Gruppe optimiert OpenAI die Modelle übereinander. Das ist eigentlich der Unterschied zwischen ChatGPT und regulärem GPT.

Plain GPT ist eine Engine, die einfach die wahrscheinlich nächsten Token nach einem Satz ausgibt. Andererseits ist ChatGPT ein Modell, das auf Befehle und nächste Schritte trainiert wird.

Ein Aspekt, der bei der Bezeichnung GPT als „ausgefallene Autokorrektur“ auffällt, ist die Art und Weise, wie diese Ebenen miteinander interagieren und die tiefe Fähigkeit von Modellen dieser Größe, Muster zu erkennen und sie in verschiedenen Kontexten anzuwenden.

Das Modell ist in der Lage, Zusammenhänge zwischen den Antworten, den Erwartungen, wie und kontextuell unterschiedlichen Fragen gestellt werden, herzustellen.

Auch wenn noch niemand gefragt hat, „Statistiken anhand einer Metapher über Delfine zu erklären“, kann GPT diese Zusammenhänge umfassend erfassen und erweitern. Es weiß, wie man ein Thema mit einer Metapher erklärt, wie Statistiken funktionieren und was Delfine sind.

Wie jedoch jeder, der sich regelmäßig mit GPT befasst, feststellen kann, wird das Ergebnis umso schlechter, je weiter man sich mit den GPT-Schulungsmaterialien beschäftigt.

OpenAI verfügt über ein Modell, das auf verschiedenen Ebenen trainiert wird und sich auf Folgendes bezieht:

- Gespräche.

- Vermeidung kontroverser Antworten.

- Halten Sie es innerhalb der Richtlinien.

Jeder, der versucht hat, GPT dazu zu bringen, außerhalb seiner Parameter zu agieren, kann Ihnen sagen, dass Kontext und Befehle unendlich modular sind. Menschen sind kreativ und können sich unzählige Möglichkeiten ausdenken, die Regeln zu brechen.

Dies alles bedeutet, dass OpenAI einem LLM das „Argumentieren“ beibringen kann, indem es ihm Argumentationsebenen aussetzt, damit er Muster nachahmen und erkennen kann.

Die Antworten auswendig lernen, nicht verstehen.

Die andere Möglichkeit, wie OpenAI seinen Modellen Argumentationsfunktionen hinzufügen kann, ist die Verwendung anderer Elemente. Aber diese haben ihre eigenen Probleme. Sie können sehen, wie OpenAI versucht, GPT-Probleme mit Nicht-GPT-Lösungen durch den Einsatz von Plugins zu lösen.

Das Link-Reader-Plugin ist eines für ChatGPT (GPT-4). Es ermöglicht einem Benutzer, Links zu ChatGPT hinzuzufügen, und der Agent besucht den Link und erhält den Inhalt. Aber wie macht GPT das?

Anstatt zu „denken“ und zu entscheiden, auf diese Links zuzugreifen, geht das Plug-in davon aus, dass jeder Link notwendig ist.

Wenn der Text analysiert wird, werden die Links besucht und der HTML-Code wird in der Eingabe abgelegt. Es ist schwierig, solche Plugins eleganter zu integrieren.

Das Bing-Plugin ermöglicht beispielsweise die Suche mit Bing, der Agent geht dann jedoch davon aus, dass Sie viel häufiger suchen möchten als das Gegenteil.

Dies liegt daran, dass es selbst bei mehrschichtigem Training schwierig ist, konsistente Antworten von GPT sicherzustellen. Wenn Sie mit der OpenAI-API arbeiten, kann dies sofort auftreten. Sie können „als offenes KI-Modell“ kennzeichnen, aber einige Antworten haben andere Satzstrukturen und andere Arten, Nein zu sagen.

Dies erschwert das Schreiben einer mechanischen Codeantwort, da eine konsistente Eingabe erwartet wird.

Wenn Sie die Suche in eine OpenAI-App integrieren möchten, welche Arten von Auslösern lösen die Suchfunktion aus?

Was ist, wenn Sie in einem Artikel über die Suche sprechen möchten? Ebenso kann das Chunking von Eingaben schwierig sein, weil.

Für ChatGPT ist es schwierig, verschiedene Teile der Eingabeaufforderung zu unterscheiden, da es für diese Modelle schwierig ist, zwischen Fantasie und Realität zu unterscheiden.

Der einfachste Weg, GPT das Denken zu ermöglichen, besteht jedoch darin, etwas zu integrieren, das besser zum Denken geeignet ist. Das ist immer noch leichter gesagt als getan.

Ryan Jones hatte dazu einen guten Thread auf Twitter:

Anschließend kehren wir zur Frage zurück, wie LLMs funktionieren.

Es gibt keinen Taschenrechner, keinen Denkprozess, sondern nur das Erraten des nächsten Begriffs auf der Grundlage einer riesigen Textmenge.

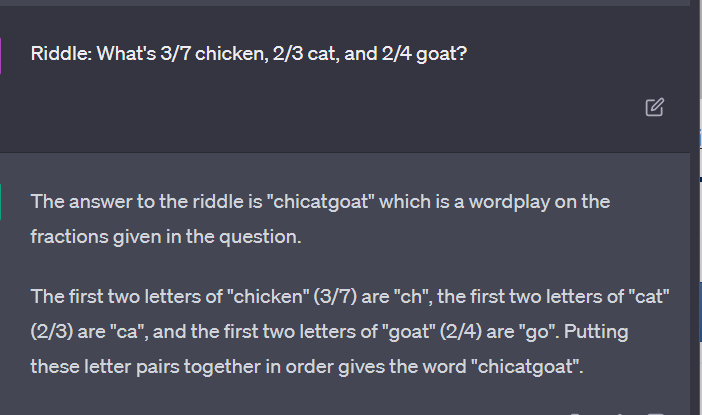

Fall 3: GPT vs. Rätsel

Mein Lieblingsfall für so etwas? Kinderrätsel.

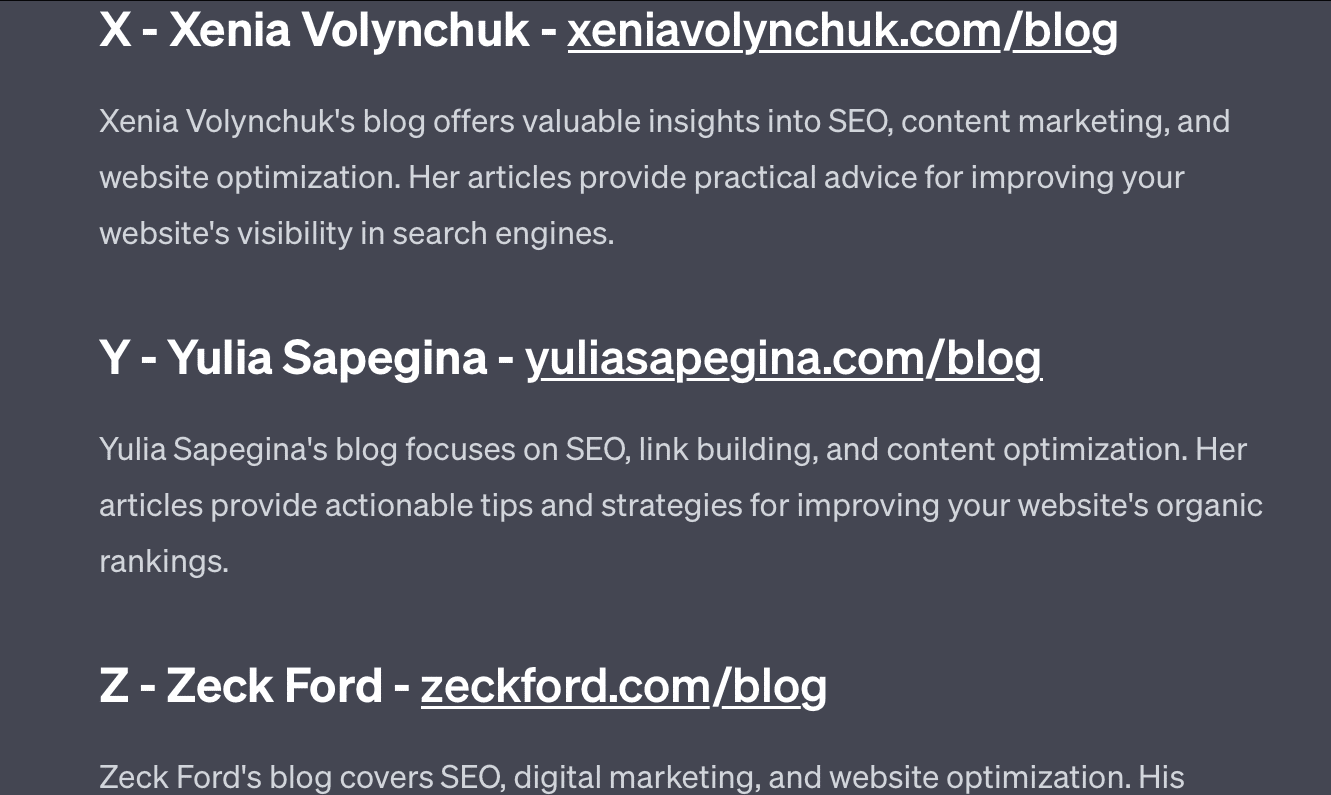

Eines der vier Wörter aus jeder Menge gehört nicht dazu. Welches Wort gehört nicht dazu?

- Grün, Gelb, Rot, Blau.

- April, Dezember, November, Juni.

- Cirrus, Infinitesimalrechnung, Cumulus, Stratus.

- Karotten, Radieschen, Kartoffeln, Kohl.

- Gabel, Kamm, Rechen, Schaufel.

Nehmen Sie sich eine Sekunde Zeit, um darüber nachzudenken. Fragen Sie ein Kind.

Hier sind die tatsächlichen Antworten:

- Grün. Gelb, Rot und Blau sind Grundfarben. Grün ist es nicht.

- Dezember. Die anderen Monate haben nur 30 Tage.

- Infinitesimalrechnung. Die anderen sind Wolkentypen.

- Kohl. Die anderen sind Gemüse, die unter der Erde wachsen.

- Schaufel. Die anderen haben Zinken.

Schauen wir uns nun einige Antworten von GPT an:

Das Interessante ist, dass die Form dieser Antwort korrekt ist. Es stellte sich heraus, dass die richtige Antwort „keine Primärfarbe“ war, aber der Kontext reichte nicht aus, um zu wissen, was Primärfarben sind oder was Farben sind.

Dies könnte man als One-Shot-Abfrage bezeichnen. Ich gebe keine zusätzlichen Details zum Modell und erwarte, dass es die Dinge selbstständig herausfindet. Aber wie wir in früheren Antworten gesehen haben, kann es bei GPT zu Fehlern kommen, wenn es zu viele Eingabeaufforderungen gibt.

GPT ist nicht schlau. Es ist zwar beeindruckend, aber nicht so „allgemein einsetzbar“, wie es sein möchte.

Es kennt weder den Kontext dessen, was es sagt oder tut, noch weiß es, was ein Wort ist.

Für GPT ist die Welt Mathematik.

Token sind einfach zusammentanzende Vektoren, die das Netz in einer Vielzahl miteinander verbundener Punkte darstellen.

LLMs sind nicht so schlau, wie du denkst

Der Anwalt, der ChatGPT in einem Gerichtsverfahren verwendete, sagte, er „dachte, es sei eine Suchmaschine“.

Dieser öffentlichkeitswirksame Fall beruflichen Fehlverhaltens ist unterhaltsam, aber ich habe Angst vor den Konsequenzen.

Ein Anwalt – ein Fachexperte –, der hochqualifizierte und hochbezahlte Arbeit leistet, hat diese Informationen dem Gericht vorgelegt.

Überall im Land machen Hunderte von Menschen das Gleiche, weil es fast wie eine Suchmaschine ist, menschlich erscheint und richtig aussieht.

Website-Inhalte können viel auf dem Spiel stehen – alles kann sein. Fehlinformationen sind online bereits weit verbreitet und ChatGPT frisst alles auf, was noch übrig ist.

Wir müssen Metall von versunkenen Schiffen einsammeln, weil es nicht bestrahlt wurde.

Ebenso werden Daten aus der Zeit vor 2022 ein begehrtes Gut werden, weil sie aus dem stammen, was ein Text sein soll – einzigartig, menschlich und wahr.

Ein Großteil dieser Art von Diskurs scheint auf mehrere Ursachen zurückzuführen zu sein: Missverständnisse darüber, wie GPT funktioniert, und Missverständnisse darüber, wofür es verwendet wird.

Bis zu einem gewissen Grad kann OpenAI für diese Missverständnisse verantwortlich gemacht werden. Sie wollen so sehr künstliche allgemeine Intelligenz entwickeln, dass es schwierig ist, Schwächen in den Möglichkeiten von GPT zu akzeptieren.

GPT ist ein „Meister über alles“ und kann daher kein Meister über irgendetwas sein.

Wenn es keine Beleidigungen sagen kann, kann es Inhalte auch nicht moderieren.

Wenn es die Wahrheit sagen muss, kann es keine Fiktion schreiben.

Wenn es dem Benutzer gehorchen muss, kann es nicht immer genau sein.

GPT ist keine Suchmaschine, kein Chatbot, kein Freund, keine allgemeine Intelligenz und auch keine ausgefallene Autokorrektur.

Es handelt sich um massenhaft angewandte Statistiken, bei denen man würfelt, um Sätze zu bilden. Aber die Sache mit dem Zufall ist, dass man manchmal die falsche Entscheidung trifft.

Die in diesem Artikel geäußerten Meinungen sind die des Gastautors und nicht unbedingt die von Search Engine Land. Die Autoren unserer Mitarbeiter sind hier aufgelistet.