Was ist Crawl-Budget [und wie lässt es sich optimieren]?

Veröffentlicht: 2022-05-16Crawl-Budget ist einer dieser SEO-Begriffe, von denen Marketingleute wahrscheinlich schon gehört haben.

Aber wissen Sie, was es bedeutet und worum es geht?

Keine Sorge, wir sind nicht hier, um Sie zu testen. Im Gegenteil, wir sind hier, um Ihnen zu helfen, alles über das Crawl-Budget zu verstehen, warum es wichtig ist und wie Sie es überprüfen und optimieren können.

Schließlich muss man erst krabbeln lernen, bevor man laufen kann, oder?

Was ist Crawl-Budget?

Das Crawl-Budget ist die Anzahl der Seiten, die Google innerhalb eines bestimmten Zeitraums auf einer Website crawlen kann.

Sie sehen, jedes Mal, wenn Sie eine Seite auf Ihrer Website veröffentlichen, müssen Sie warten, bis Google sie indexiert und bewertet, und um dies tun zu können, müssen ihre Roboter sie zuerst crawlen.

Dieser Prozess kann je nach Umständen schneller oder langsamer ablaufen, z. B. wie groß Ihre Website ist, wie beliebt die Themen sind, wie viel Verkehr auf Ihrer Seite vorhanden ist usw.

Aber wie funktioniert Crawlen eigentlich?

Lass es uns herausfinden.

Wie funktionieren Crawler?

Vor mehr als 10 Jahren erkannte Google, dass die Ressourcen begrenzt sind und nur ein begrenzter Prozentsatz der endlosen Online-Inhalte, die ständig online veröffentlicht werden, gefunden werden konnte.

Dann, im Jahr 2017, veröffentlichte Google seinen offiziellen Artikel „Was Crawl-Budget für Googlebot bedeutet“, in dem sie ihre Definition von Crawling und andere relevante Details erklären.

Hier die wesentlichen Fakten:

- Crawling ist effizient, es sei denn, Ihre Website hat mehr als ein paar tausend URLs

- Schnell reagierende Seiten erhöhen das Crawling-Limit

- Sie können Ihre Website-Crawling-Rate über die Google Search Console reduzieren

- Beliebte URLs werden tendenziell häufiger gecrawlt

- Eine Fülle von URLs mit geringem Wert (Duplicate Content, Soft-Error-Seiten usw.) kann sich negativ auf Indexierung und Crawling auswirken

- Crawling ist kein direkter Rankingfaktor

Um die maximale Crawlbarkeit Ihrer Website zu gewährleisten, müssen Sie grundsätzlich schnelle Ladezeiten haben, doppelte und qualitativ minderwertige Inhalte vermeiden und Ihre Seiten beliebt machen.

Es ist jedoch wichtig zu beachten, dass sich die Mehrheit der Website-Eigentümer nicht allzu sehr um das Crawl-Budget kümmern müssen. Es sind große Websites mit Tausenden von Seiten, wie E-Commerce-Shops, digitale Publikationen und beliebte Blogs, die Aufmerksamkeit verdienen sollten.

Warum ist das Crawl-Budget wichtig?

Das Crawling-Budget ist sehr wichtig für Ihre SEO-Bemühungen, insbesondere wenn Sie Tausende von Seiten haben und täglich viele neue Artikel veröffentlichen. Die Bots werden Ihre neuen Inhalte crawlen wollen, aber sie werden gleichzeitig auch den Rest Ihrer Website erneut besuchen.

Wenn sie auf mehrere Rückschläge und/oder Probleme stoßen, die sie verwirren, verschwenden sie Crawl-Budget auf alten Seiten, anstatt es in die neuen Inhalte zu investieren, die sie indexieren sollen. Dies kann möglicherweise zu Verzögerungen führen und Ihre URLs vorübergehend (oder sogar dauerhaft) in den SERPs nicht verfügbar machen.

Beispielsweise veröffentlichen Sie Neuigkeiten oder Informationen, die wichtig sind, um möglichst schnell Sichtbarkeit zu erlangen.

Sie möchten doch nicht eine Woche warten, bis Ihr Beitrag indexiert wird, oder?

Schließlich können Sie nicht für eine SERP ranken, wenn Ihre Seite nicht indexiert ist. Nehmen wir an, Sie schreiben über ein Weltereignis, das heute stattgefunden hat, aber Ihre Seite wird in fünf Tagen gecrawlt. An diesem Punkt ist es zu spät, um Ihr ursprüngliches Ziel zu erreichen, da die Veranstaltung nicht mehr so relevant und aktuell ist. Ganz zu schweigen davon, dass viele andere Websites darüber geschrieben haben und rechtzeitig indiziert wurden.

Es ist nicht ungewöhnlich, dass Crawl-Bots bis zu einer Woche brauchen, um Ihre Seite zu indexieren, aber um ehrlich zu sein, sollte es weniger Zeit in Anspruch nehmen.

Darüber hinaus werden Sie in der Zwischenzeit weiterhin neue Seiten veröffentlichen, die gecrawlt, indexiert und Ihrer Zielgruppe zeitnah zur Verfügung gestellt werden müssen. Und das ist ein Rezept für einen Indizierungsengpass.

Alles in allem riskieren Sie, wenn Sie oft an die Grenzen Ihres Crawl-Budgets stoßen, dass einige Ihrer Seiten zwischen den Ritzen rutschen und es nicht in die SERPs schaffen. Infolgedessen profitieren diese nicht vom organischen Traffic und haben eine viel geringere Sichtbarkeit als der Rest Ihrer Inhalte.

Und wenn Sie sich fragen, wie Sie Ihr Crawl-Budget überprüfen können – es ist ganz einfach. Gehen Sie einfach zur Google Search Console und überprüfen Sie Crawl → Crawl Stats.

Optimierung des Crawl-Budgets

Es ist wichtig, sich daran zu erinnern, dass das Crawl-Budget von drei Hauptfaktoren abhängt: Website-Größe, Website-Gesundheit und Website-Popularität.

Das bedeutet, dass Sie sich keine Gedanken über die Verschwendung von Crawl-Budget machen müssen, wenn:

- Ihre Website ist mäßig klein, dh weniger als ein paar tausend Seiten.

- Ihre Website ist frei von Statuscodefehlern und verfügt über eine ordnungsgemäße Kanonisierung.

- Ihre Website ist beliebt, was bedeutet, dass Sie eine Fangemeinde in den sozialen Medien und andere Kanäle entwickelt haben, um Ihre Inhalte zu teilen und Traffic zu generieren.

Die Abdeckung dieser Kriterien bedeutet, dass der Googlebot in der Lage sein sollte, Ihre Website effizient zu crawlen.

Falls Ihnen einer dieser drei Faktoren fehlt, besteht das Risiko, dass Crawling-Probleme unterschiedlicher Schweregrade auftreten und die Sichtbarkeit einiger Ihrer Seiten in der organischen Suche verloren geht.

Hier sind einige Best Practices für das Crawl-Budget, die Sie befolgen sollten:

Verbessern Sie die Geschwindigkeit Ihrer Website

Wie oben erwähnt, können die Geschwindigkeit der Website und die Ladezeit der Seite das Crawling-Limit beeinflussen. Eine gesunde, schnelle Website bedeutet, dass der Googlebot mehr Ihrer Seiten in kürzerer Zeit crawlen kann.

Andererseits verringern langsamer ladende Seiten die Crawling-Rate, was bei einer großen Website zu allgemeinen Indexierungsproblemen führen kann.

Kurz gesagt, stellen Sie sicher, dass Sie die Geschwindigkeit Ihrer Website optimieren. Dies macht es nicht nur für die Bots einfacher, sondern verbessert auch die Benutzererfahrung.

Interne Verlinkung anwenden

Das beste Szenario besteht darin, Backlinks zu haben, die auf jede Seite Ihrer Website verweisen. Dies ist nicht nur eine gute SEO-Praxis, um Besucher auf Ihre Website zu bringen und Suchmaschinen zu zeigen, dass Ihre Inhalte wichtig sind, sondern es zieht auch Googlebot an.

Einfach ausgedrückt, Backlinks sind der goldene Junge der SEO.

Aber hier ist der Deal.

Abgesehen von Backlinks liebt Google auch die interne Verlinkung. Es hilft ihm, alle Ihre Seiten zu entdecken und besser zu verstehen, wie sie zusammenhängen. Und während es schwierig sein mag, an Backlinks zu kommen, haben Sie die vollständige Kontrolle über die internen Links und können so viele hinzufügen, wie Sie möchten (übertreiben Sie es nur nicht).

Die Anwendung dieser Optimierungstechnik stellt sicher, dass mehr Ihrer Seiten gecrawlt werden.

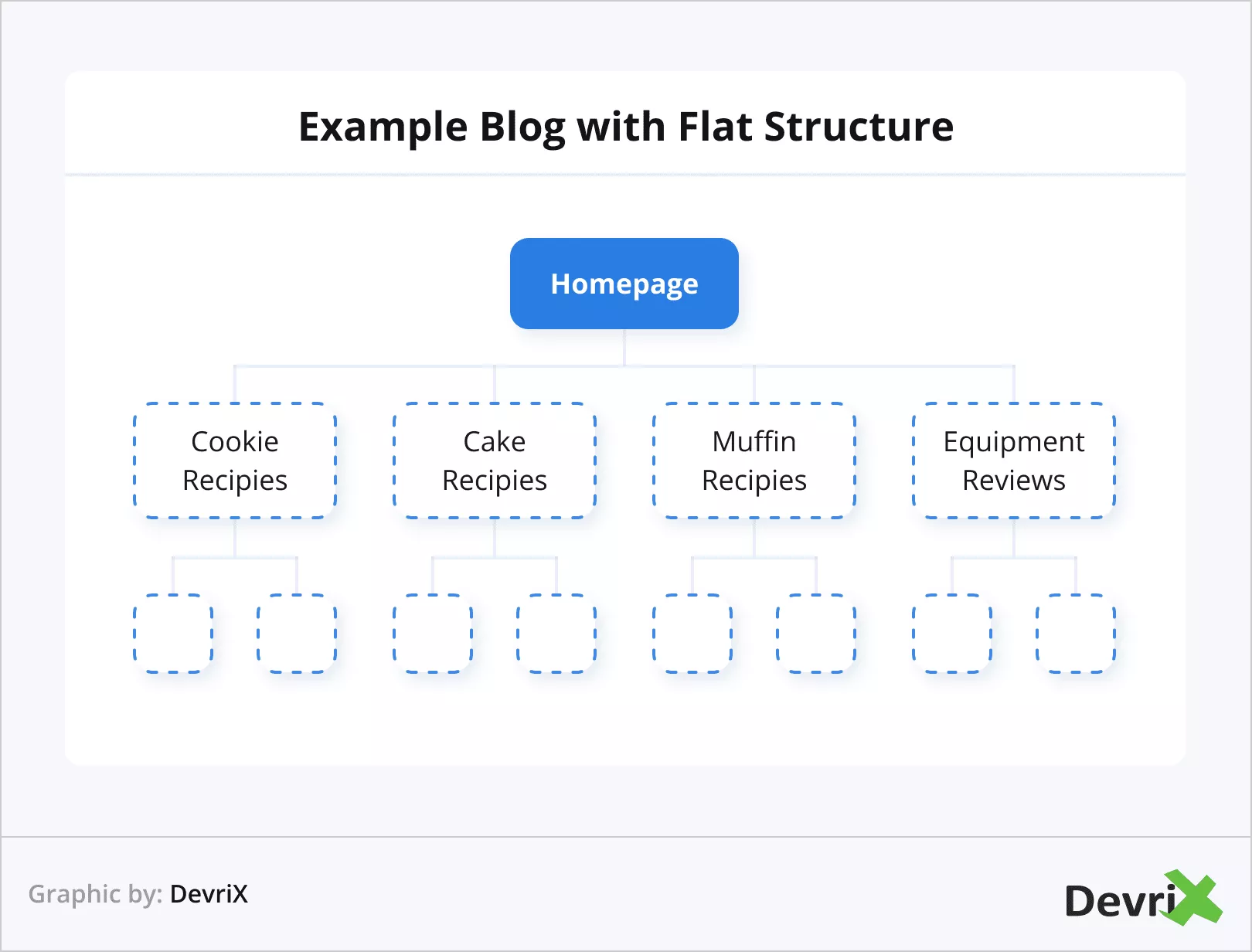

Verwenden Sie eine flache Webarchitektur

Popularität ist in den Augen von Google sehr wichtig. Aus diesem Grund wäre es vorteilhaft, eine flache Website-Architektur zu verwenden. Die flache Architektur ermöglicht es, dass die Linkautorität auf allen Ihren Seiten gleiche Anteile hat.

Es hilft Bots dabei, leichter zu verfolgen, wie die Links auf Ihrer Website verbunden sind, und ermöglicht es Ihnen außerdem, verwandte Seiten besser zu gruppieren und thematische Autorität zu erlangen.

In der Praxis bedeutet dies, dass sowohl Benutzer als auch Suchmaschinen jede beliebige Seite Ihrer Website innerhalb von vier Klicks erreichen können.

Vermeiden Sie verwaiste Seiten und doppelte Inhalte

Eine verwaiste Seite ist eine Seite, die weder einen einzigen externen noch internen Link enthält. Dadurch werden diese Arten von Seiten vom Rest Ihrer Inhalte isoliert, und logischerweise sind sie auch für den Googlebot schwerer zu entdecken.

Sie können verwaiste Seiten ganz einfach vermeiden, indem Sie jedem Artikel und jeder Seite, die Sie haben, mindestens einen internen Link hinzufügen.

Doppelte Inhalte verwalten

Duplicate Content verursacht zahlreiche Probleme. Mehrere URLs mit ähnlichen Parametern zu haben, ist für Crawl-Bots verwirrend. Dadurch wird die Zeit des Googlebot verschwendet, da er herausfinden muss, welche Seite die Hauptseite und welche eine doppelte Version ist, und dies führt zu einem langsameren Crawling-Prozess.

Achten Sie bei Websites wie E-Commerce-Plattformen, auf denen es aufgrund mehrerer ähnlicher Produkte mit kleinen Unterschieden wie Größe und Farbe üblich ist, mehrere ähnliche URLs zu haben, darauf, kanonische Tags zu verwenden, die den Googlebot zu den Seiten führen, die Sie priorisieren möchten.

Crawling für einige Seiten nicht zulassen

Jede Website hat Seiten wie Login, Kontaktformulare, Warenkörbe und so weiter. Diese müssen nicht gecrawlt werden und können darüber hinaus nicht gecrawlt werden. Google wird es jedoch versuchen, daher ist es eine gute Idee, die Bots wissen zu lassen, dass sie sie überspringen und Ressourcen sparen sollen.

Um diese Aktion auszuführen, verwenden Sie Ihre robots.txt-Datei, um das Crawlen der gewünschten Seiten zu verbieten.

Aktualisieren Sie alte und schreiben Sie neue Inhalte

Haben wir schon erwähnt, dass Google frische Inhalte mag? Es tut.

Google hört möglicherweise sogar auf, Ihre Seite zu crawlen, da es dort bei den letzten Crawlings nichts Neues gab.

Stellen Sie sich vor, der Googlebot besucht Ihre Website alle zwei Tage und jedes Mal, wenn er neue Inhalte zum Indexieren findet. Dann hören Sie plötzlich aus irgendeinem Grund auf, Ihre Website zu aktualisieren. Der Googlebot besucht es jedoch weiterhin mit der gleichen Häufigkeit. Nach einer Weile bemerkt der Bot, dass es keine neuen Inhalte zum Indizieren gibt, und macht die Besuche schließlich seltener.

Im gegenteiligen Szenario, in dem Sie häufiger neue Inhalte bereitstellen, könnte der Googlebot Ihre Website häufiger besuchen.

Quelle

Wenn Sie feststellen, welche Seiten aktualisiert werden müssen, achten Sie im Allgemeinen auf die Relevanz – ein Artikel kann zwei Jahre alt sein und immer noch relevante Informationen enthalten (Sie sollten ihn jedoch trotzdem aktualisieren). Oder es könnte ein Monate altes Material sein, das bereits seine Frische verloren hat.

Fehlerseiten reduzieren

Dieser ist einfach zu verstehen.

Der Googlebot verschwendet Zeit, wenn er versucht, Seiten mit 5xx-Fehlercodes (Serverfehler), 4xx-Fehlercodes (Fehler „nicht gefunden“), 3xx-Fehlercodes (Weiterleitungen) usw.

Quelle

Grundsätzlich ist jede Seite, die zu einem anderen Code als 200 führt, eine Verschwendung von Zeit und Crawling-Ressourcen. In der Praxis besteht keine Notwendigkeit, die Aufmerksamkeit von Google auf Seiten zu lenken, die Sie gelöscht oder umgeleitet haben. Priorisieren Sie stattdessen die Korrektur Ihrer Live-URLs.

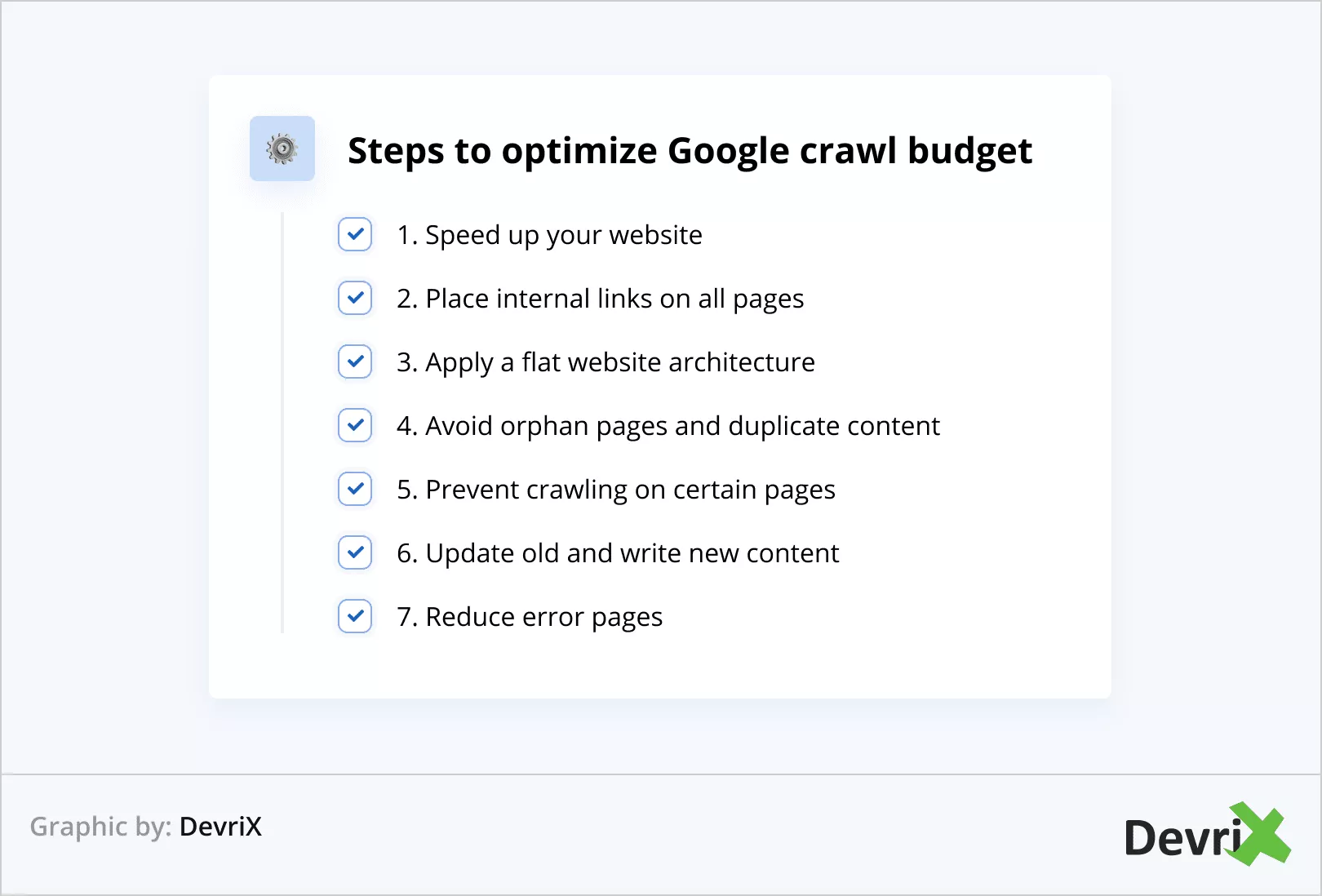

Crawl-Budget-Optimierung auf den Punkt gebracht

Lassen Sie uns die Schritte zur Optimierung des Google-Crawling-Budgets zusammenfassen:

- Beschleunigen Sie Ihre Website

- Platzieren Sie interne Links auf allen Seiten

- Wenden Sie eine flache Website-Architektur an

- Vermeiden Sie verwaiste Seiten und doppelte Inhalte

- Verhindern Sie das Crawlen auf bestimmten Seiten

- Aktualisieren Sie alte und schreiben Sie neue Inhalte

- Fehlerseiten reduzieren

Bonus-Tipp

Wie oft Ihre Website gecrawlt wird, können Sie durch eine Logfile-Analyse überprüfen. Auf diese Weise können Sie feststellen, ob bestimmte Seiten häufiger gecrawlt werden als andere.

Darüber hinaus kann Ihnen eine Logdatei-Analyse helfen zu verstehen, ob es Probleme in bestimmten Bereichen der Website gibt.

Darüber hinaus kann Ihnen eine Logdatei-Analyse helfen zu verstehen, ob es Probleme in bestimmten Bereichen der Website gibt.

Endeffekt

Das Crawl-Budget ist für die allgemeine Sichtbarkeit Ihrer Website in Suchmaschinen von entscheidender Bedeutung. Wenn der Googlebot Ihre Seiten nicht crawlen und indexieren kann, existieren Sie praktisch nicht online.

Stellen Sie sicher, dass Sie alle Techniken zur Optimierung des Crawl-Budgets anwenden, die wir im Artikel besprochen haben, und Sie werden die Früchte ernten.

Google kann Ihre Inhalte schneller finden und indizieren, und Ihre Website wird letztendlich der Konkurrenz voraus sein, die die Optimierung nicht oder nicht umsetzt.

1:0 für dich! Gut gemacht!