So skalieren Sie den Einsatz großer Sprachmodelle im Marketing

Veröffentlicht: 2023-05-18Generative KI und große Sprachmodelle werden die Marketingbranche, wie wir sie kennen, verändern.

„Um wettbewerbsfähig zu bleiben, müssen Sie die Technologie verstehen und wissen, wie sie sich auf unsere Marketingbemühungen auswirkt“, sagte Christopher Penn, Chief Data Scientist bei TrustInsights.ai, der auf der MarTech-Konferenz sprach.

Erfahren Sie, wie Sie den Einsatz großer Sprachmodelle skalieren können, welchen Wert Prompt Engineering hat und wie sich Vermarkter auf die Zukunft vorbereiten können.

Die Prämisse hinter großen Sprachmodellen

Seit seiner Einführung ist ChatGPT in den meisten Branchen ein Trendthema. Man kann nicht online gehen, ohne zu sehen, was jeder davon hält. Dennoch verstehen nicht viele Menschen die Technologie dahinter, sagte Penn.

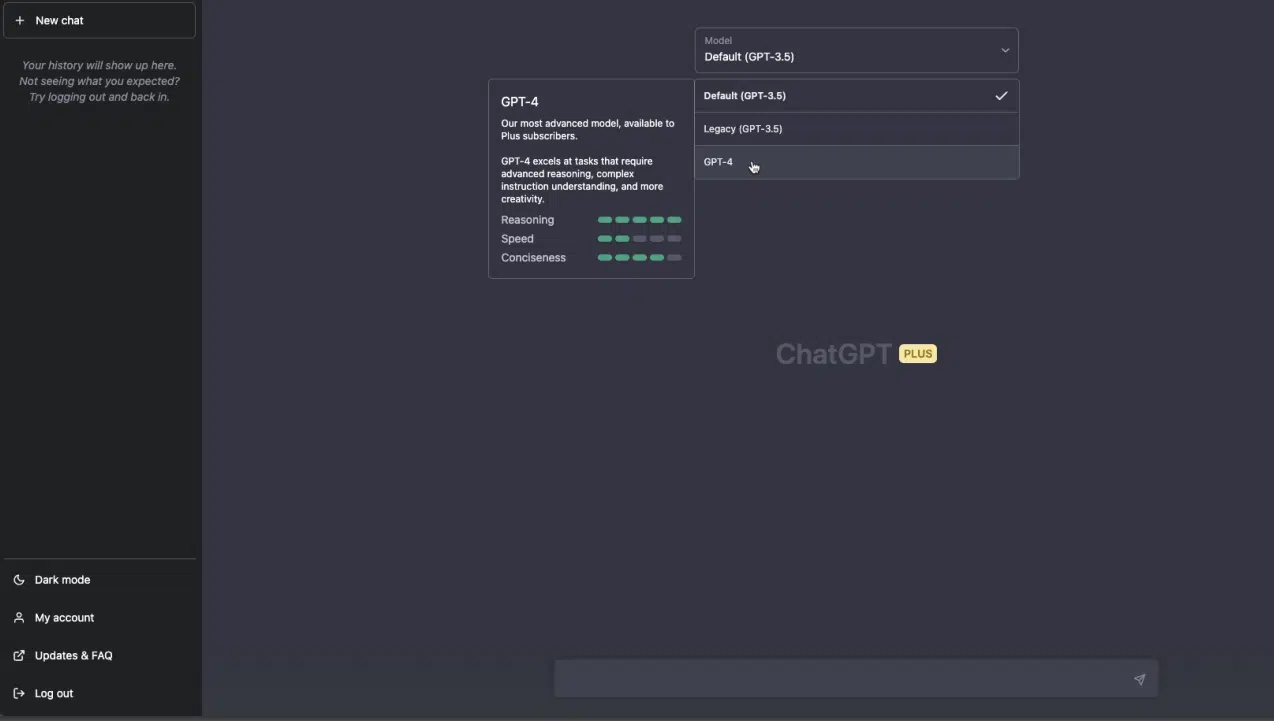

ChatGPT ist ein KI-Chatbot, der auf den großen Sprachmodellen (LLMs) GPT-3.5 und GPT-4 von OpenAI basiert.

LLMs basieren auf einer Prämisse des englischen Linguisten John Rupert Firth aus dem Jahr 1957:

- „Du sollst ein Wort durch die Gesellschaft erfahren, die es leistet.“

Dies bedeutet, dass die Bedeutung eines Wortes anhand der Wörter verstanden werden kann, die typischerweise neben ihm stehen. Einfach ausgedrückt: Wörter werden nicht nur durch ihre Wörterbuchdefinition definiert, sondern auch durch den Kontext, in dem sie verwendet werden.

Diese Prämisse ist der Schlüssel zum Verständnis der Verarbeitung natürlicher Sprache.

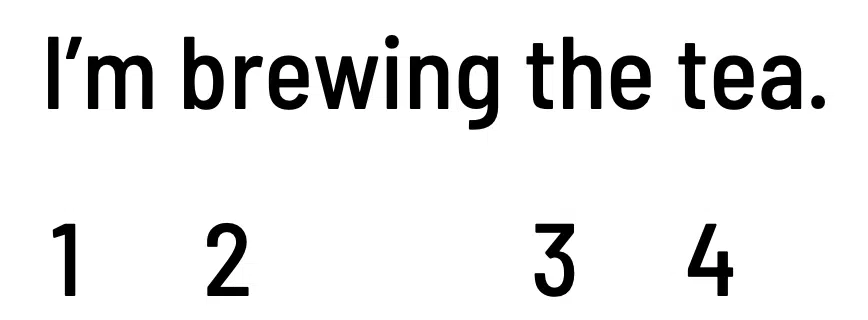

Schauen Sie sich zum Beispiel die folgenden Sätze an:

- „Ich koche den Tee.“

- „Ich verschütte den Tee.“

Ersteres bezieht sich auf ein heißes Getränk, während letzteres umgangssprachlich für Klatschen ist. „Tee“ hat in diesen Fällen sehr unterschiedliche Bedeutungen.

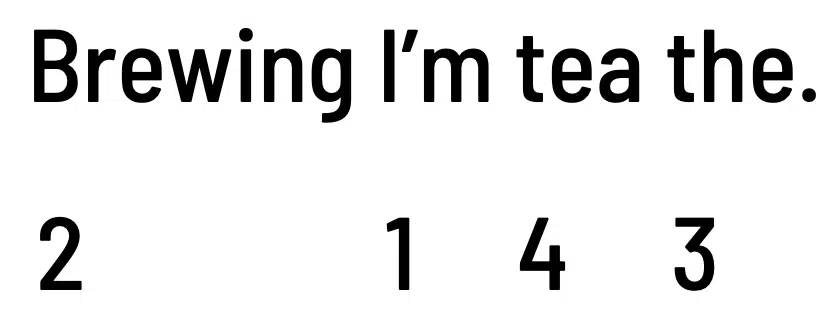

Auch die Reihenfolge der Wörter ist wichtig.

- „Ich koche den Tee.“

- „Der Tee, den ich koche.“

Die obigen Sätze haben unterschiedliche Themenschwerpunkte, obwohl sie dasselbe Verb verwenden: „brauen“.

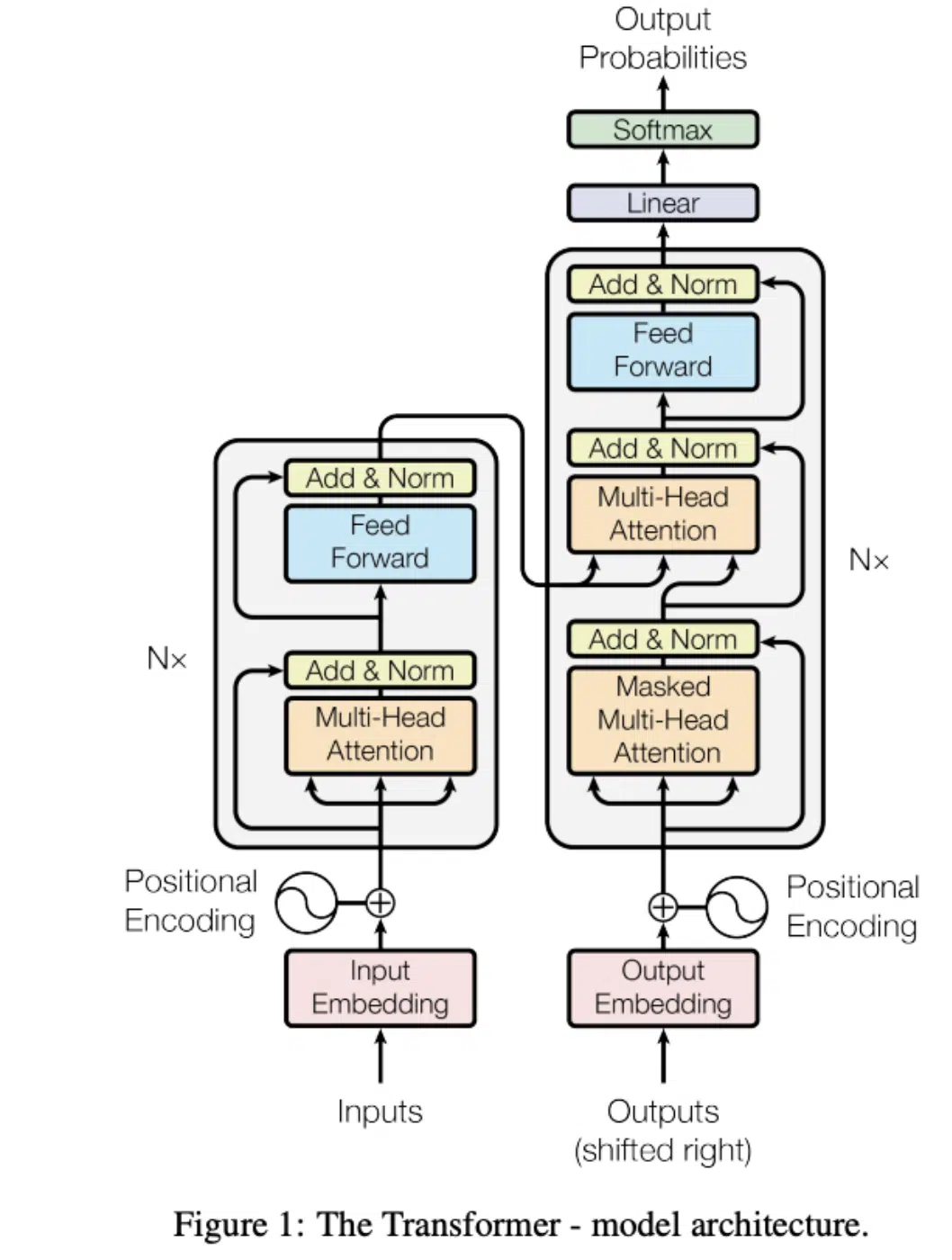

Wie große Sprachmodelle funktionieren

Unten finden Sie ein Systemdiagramm von Transformatoren, dem Architekturmodell, in dem große Sprachmodelle erstellt werden.

Einfach ausgedrückt: Ein Transformator nimmt eine Eingabe und wandelt sie in etwas anderes um (dh „transformiert“).

LLMs können zum Schaffen genutzt werden, sind aber besser darin, aus einer Sache etwas anderes zu machen.

OpenAI und andere Softwareunternehmen erfassen zunächst einen riesigen Datenbestand, darunter Millionen von Dokumenten, wissenschaftlichen Arbeiten, Nachrichtenartikeln, Produktrezensionen, Forumskommentaren und vielem mehr.

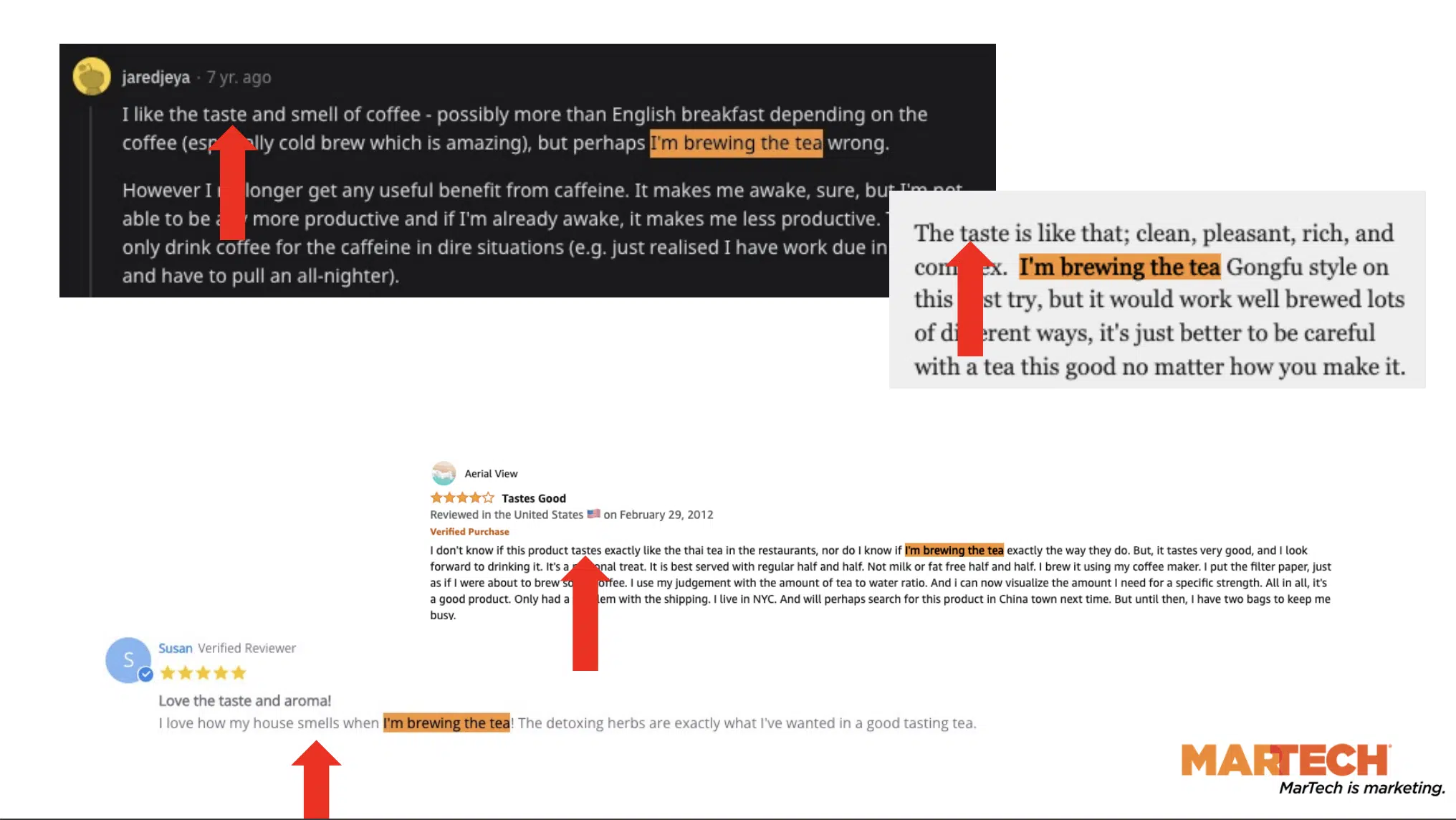

Bedenken Sie, wie häufig der Satz „Ich koche den Tee“ in all diesen aufgenommenen Texten vorkommt.

Die Amazon-Produktbewertungen und Reddit-Kommentare oben sind einige Beispiele.

Beachten Sie das „die Gesellschaft“, das dieser Satz leistet – das heißt alle Wörter, die in der Nähe von „Ich koche den Tee“ erscheinen.

„Geschmack“, „Geruch“, „Kaffee“, „Aroma“ und mehr verleihen diesen LLMs einen Kontext.

Maschinen können nicht lesen. Um diesen gesamten Text zu verarbeiten, verwenden sie Einbettungen, den ersten Schritt in der Transformer-Architektur.

Durch die Einbettung können Modelle jedem Wort einen numerischen Wert zuweisen, und dieser numerische Wert kommt im Textkorpus wiederholt vor.

Für diese Modelle ist auch die Wortposition von Bedeutung.

Im obigen Beispiel bleiben die Zahlenwerte gleich, haben jedoch eine andere Reihenfolge. Dies ist eine Positionskodierung.

Vereinfacht ausgedrückt funktionieren große Sprachmodelle folgendermaßen:

- Die Maschinen nehmen Textdaten auf.

- Weisen Sie allen Wörtern Zahlenwerte zu.

- Schauen Sie sich die statistischen Häufigkeiten und die Verteilungen zwischen den verschiedenen Wörtern an.

- Versuchen Sie herauszufinden, wie das nächste Wort in der Sequenz lauten wird.

All dies erfordert erhebliche Rechenleistung, Zeit und Ressourcen.

Erhalten Sie den täglichen Newsletter, auf den sich Suchmaschinenmarketing verlassen.

Siehe Bedingungen.

Schnelles Engineering: Eine Fähigkeit, die man unbedingt erlernen muss

Je mehr Kontext und Anweisungen wir LLMs bereitstellen, desto wahrscheinlicher ist es, dass sie bessere Ergebnisse liefern. Darin liegt der Wert einer schnellen Entwicklung.

Penn betrachtet Eingabeaufforderungen als Leitplanken dafür, was die Maschinen produzieren werden. Maschinen erfassen die Wörter in unserer Eingabe und greifen bei der Entwicklung der Ausgabe auf sie zurück, um den Kontext zu ermitteln.

Wenn Sie beispielsweise ChatGPT-Eingabeaufforderungen schreiben, werden Sie feststellen, dass detaillierte Anweisungen tendenziell zu zufriedenstellenderen Antworten führen.

In gewisser Weise sind Eingabeaufforderungen für Autoren wie kreative Briefings. Wenn Sie möchten, dass Ihr Projekt korrekt ausgeführt wird, geben Sie Ihrem Autor keine einzeilige Anweisung.

Stattdessen senden Sie ein ausreichend großes Briefing, das alles abdeckt, worüber Sie schreiben sollen, und wie es geschrieben werden soll.

Skalierung des Einsatzes von LLMs

Wenn Sie an KI-Chatbots denken, denken Sie vielleicht sofort an eine Weboberfläche, auf der Benutzer Eingabeaufforderungen eingeben und dann auf die Antwort des Tools warten können. Das ist es, was jeder gewohnt ist zu sehen.

„Dies ist keineswegs das Endziel dieser Tools. Das ist der Spielplatz. Hier können die Menschen an dem Werkzeug herumbasteln“, sagte Penn. „So werden Unternehmen das nicht auf den Markt bringen.“

Stellen Sie sich schnelles Schreiben als Programmieren vor. Sie sind ein Entwickler, der Anweisungen an einen Computer schreibt, damit dieser etwas tut.

Sobald Sie Ihre Eingabeaufforderungen für bestimmte Anwendungsfälle optimiert haben, können Sie APIs nutzen und echte Entwickler dazu bringen, diese Eingabeaufforderungen in zusätzlichen Code zu verpacken, sodass Sie Daten in großem Umfang programmgesteuert senden und empfangen können.

Auf diese Weise werden LLMs Unternehmen skalieren und zum Besseren verändern.

Da diese Tools überall eingeführt werden, ist es wichtig zu bedenken, dass jeder ein Entwickler ist.

Diese Technologie wird in Microsoft Office – Word, Excel und PowerPoint – und vielen anderen Tools und Diensten enthalten sein, die wir täglich verwenden.

„Da in natürlicher Sprache programmiert wird, sind es nicht unbedingt die traditionellen Programmierer, die die besten Ideen haben“, fügte Penn hinzu.

Da LLMs auf Autoren basieren, können Marketing- oder PR-Experten – und nicht Programmierer – innovative Wege zur Nutzung der Tools entwickeln.

Wie sich LLMs auf das Suchmaschinenmarketing auswirken und was Sie dagegen tun können

Wir beginnen, die Auswirkungen großer Sprachmodelle auf das Marketing zu erkennen, insbesondere auf die Suche.

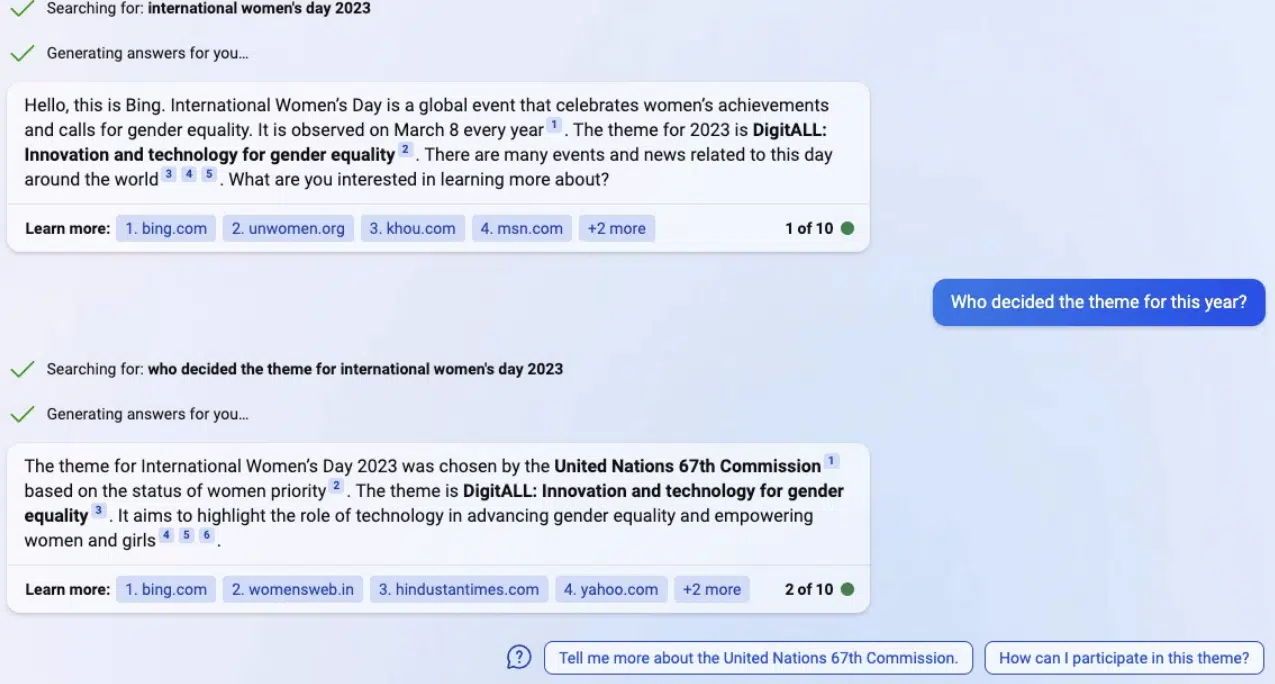

Im Februar stellte Microsoft das neue Bing vor, das von ChatGPT unterstützt wird. Benutzer können mit der Suchmaschine kommunizieren und erhalten direkte Antworten auf ihre Fragen, ohne auf Links klicken zu müssen.

„Sie können davon ausgehen, dass diese Tools Ihre markenlose Suche erheblich entlasten, da sie Fragen auf eine Weise beantworten, die keine Klicks erfordert“, sagte Penn.

„Als SEO-Profis haben wir das bereits erlebt, mit Featured Snippets und Zero-Click-Suchergebnissen … aber für uns wird es noch schlimmer werden.“

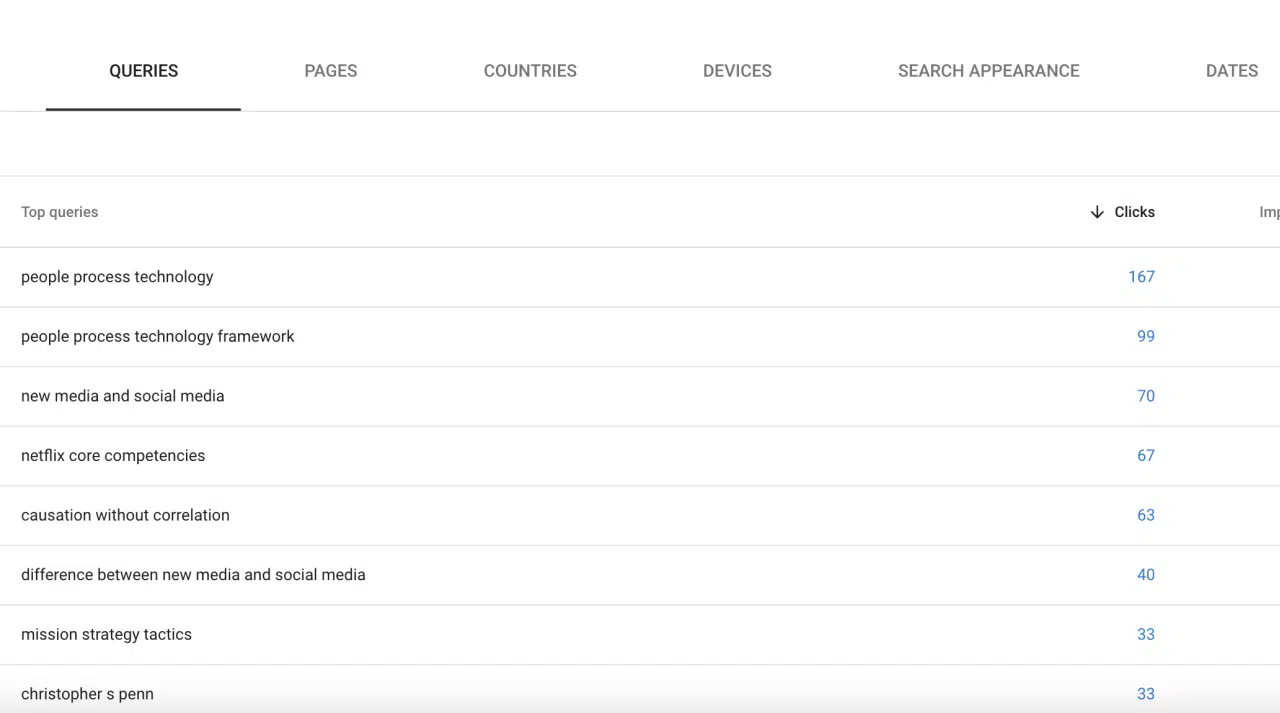

Er empfiehlt, zu den Bing Webmaster Tools oder der Google Search Console zu gehen und sich den Prozentsatz des Traffics anzusehen, den Ihre Website durch markenlose, informative Suchanfragen erhält, da dies der größte Risikobereich für SEO ist.

Bauen Sie Ihre Marke auf

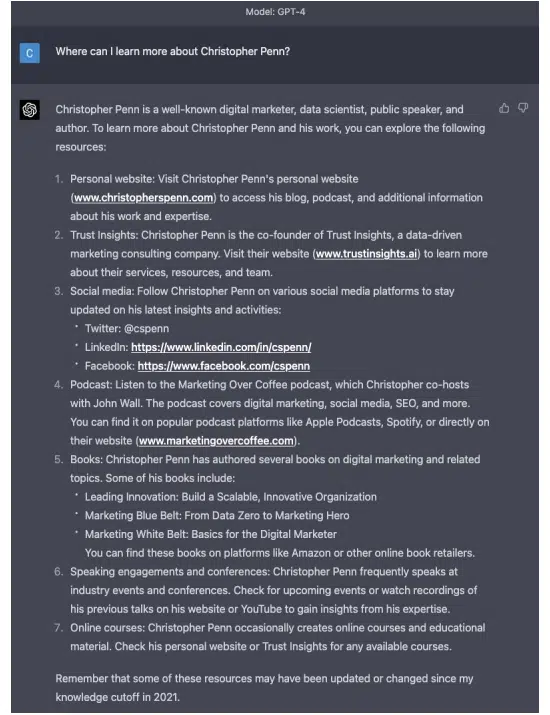

„Wenn der Markenaufbau für 2023 und darüber hinaus nicht zu Ihren obersten strategischen Prioritäten gehört, muss er es sein“, betonte Penn.

Sie müssen Ihre Marke aufbauen und die Leute dazu bringen, bei der Suche nach Ihrem Namen zu fragen.

Wenn Benutzer nach Ideen oder Empfehlungen zu einem Thema fragen, werden LLMs sie wahrscheinlich auf synthetisierte Informationen verweisen, nicht auf Sie.

Aber wenn die Leute gezielt nach Ihrem Namen fragen, kommen sie trotzdem ans Ziel.

Machen Sie die Online-Präsenz Ihrer Marke so stark wie möglich.

Nutzen Sie eine Veröffentlichungsplattform, die „immun“ gegen KI ist

Penn betonte auch, wie wichtig es ist, eine Plattform zu nutzen, über die Sie direkten und unmittelbaren Zugang zu Ihrem Publikum haben.

Mit Kanälen wie E-Mail oder SMS (sogar Direktmailing) können Sie Kunden direkt erreichen und sicherstellen, dass Sie sie ohne Vermittlung durch KI erreichen.

Organische Suche und soziale Medien werden bereits stark durch KI vermittelt. Daher ist die Wahrscheinlichkeit, auch nur einen Bruchteil Ihrer Zielgruppe zuverlässig zu erreichen, gering.

Selbst die größten Marken können nur dann genügend Aufrufe erzielen, wenn sie in bezahlte Kampagnen investieren.

Konzentrieren Sie sich auf die Gemeinschaft

Dienste wie Slack, Telegram und Discord ermöglichen es Ihnen, sich mit Gleichgesinnten zu treffen und sinnvolle Verbindungen aufzubauen.

Wenn Sie Ihren Nutzern einen Mehrwert bieten, können Sie sie zuverlässig erreichen, ihre Loyalität gewinnen und den Markenwert steigern.

Anschauen: Die Marketing-Singularität: Große Sprachmodelle und das Ende des Marketings, wie Sie es kannten

Penn teilte auf der MarTech-Konferenz weitere Erkenntnisse über die Auswirkungen von LLMs auf Marketingjobs. Sehen Sie sich hier seine vollständige Präsentation an: