Top 7 der besten Web-Scraping-Techniken 2023: Ein praktischer Leitfaden

Veröffentlicht: 2023-03-08Die weltweit größte Informationsquelle ist wahrscheinlich im Internet zu finden. Das Sammeln und Analysieren von Daten von Websites hat ein enormes Anwendungspotenzial in einer Vielzahl von Bereichen, darunter Data Science, Corporate Intelligence und investigative Berichterstattung.

Data Scientists sind ständig auf der Suche nach neuen Informationen und Daten, die sie modifizieren und analysieren können. Das Durchsuchen des Internets nach bestimmten Informationen ist derzeit eine der beliebtesten Methoden dafür.

Sind Sie bereit für Ihre erste Web-Scraping-Erfahrung? Aber zuerst müssen Sie verstehen, was Web Scraping eigentlich ist und einige seiner Grundlagen, und dann werden wir über die besten Web Scraping-Techniken sprechen.

Inhaltsverzeichnis

Was ist Webscraping?

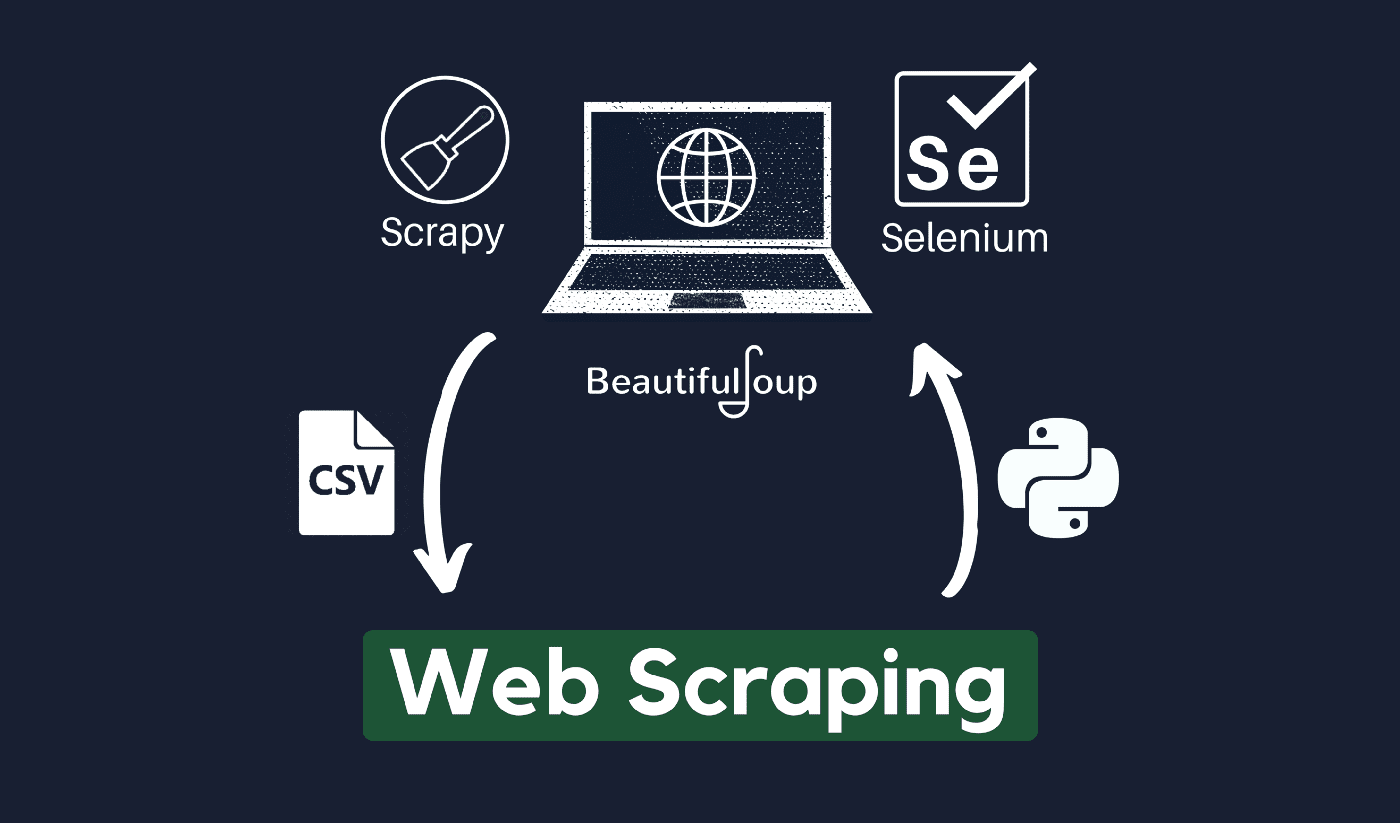

Die Technik zum Sammeln und Verarbeiten von Rohdaten aus dem Web ist als Web-Scraping bekannt, und die Python-Community hat einige ziemlich leistungsfähige Web-Scraping-Tools entwickelt. Über eine Datenpipeline werden diese Daten strukturiert verarbeitet und gespeichert.

Web Scraping ist heute eine gängige Praxis mit zahlreichen Anwendungen:

- Marketing- und Vertriebsunternehmen können Lead-bezogene Daten mithilfe von Web Scraping sammeln.

- Immobilienunternehmen können Informationen über neue Entwicklungen, zum Verkauf stehende Immobilien usw. mithilfe von Web Scraping erhalten.

- Preisvergleichsseiten wie Trivago verwenden häufig Web Scraping, um Produkt- und Preisdaten von verschiedenen E-Commerce-Websites zu erhalten.

Sie können das Web mit einer Vielzahl von Programmiersprachen durchsuchen, und jede Programmiersprache verfügt über eine Vielzahl von Bibliotheken, mit denen Sie dasselbe erreichen können. Eines der beliebtesten, vertrauenswürdigsten und legitimsten Programme für effektives Web Scraping ist Python.

Über Python

Python ist die beliebteste Sprache zum Scraping, die 1991 entwickelt und auf den Markt gebracht wurde. Diese Programmiersprache wird häufig zum Erstellen von Websites, Schreiben von Code, Erstellen von Software, Erstellen von Systemskripten und anderen Dingen verwendet. Das Programm ist ein Eckpfeiler des Online-Sektors und wird weltweit im Handel eingesetzt.

Webanwendungen können auf einem Server mit Python entwickelt werden. Es kann in Verbindung mit Anwendungen verwendet werden, um Prozesse zu erstellen und mit Datenbanksystemen zu verknüpfen. Auch Dateien können damit gelesen und verändert werden.

Es kann auch verwendet werden, um riesige Datenmengen zu verwalten, komplizierte mathematische Operationen durchzuführen, den Prototypprozess zu beschleunigen oder produktionsreife Software zu erstellen.

Wie können Sie Python für Web Scraping verwenden?

Sie müssen wahrscheinlich drei Schritte durchlaufen, um alle Informationen aus dem Internet zu kratzen und zu extrahieren: HTML abrufen, den HTML-Baum abrufen und schließlich die Informationen aus dem Baum extrahieren.

Mit der Requests-Bibliothek ist es möglich, HTML-Code von einer bestimmten Site abzurufen. Der HTML-Baum wird dann mit BeautifulSoup geparst und extrahiert, und die Daten können dann nur mit Python organisiert werden.

Es ist immer ratsam, die Richtlinie zur akzeptablen Nutzung Ihrer Ziel-Website zu überprüfen, um festzustellen, ob der Zugriff auf die Website mit automatisierten Tools einen Verstoß gegen ihre Nutzungsbedingungen darstellt, bevor Sie Ihre Python-Talente für Web Scraping einsetzen.

Wie funktioniert Web Scraping?

Spinnen werden typischerweise im Online-Scraping-Prozess verwendet. Sie rufen HTML-Dokumente von relevanten Websites ab, extrahieren die erforderlichen Inhalte basierend auf der Geschäftslogik und speichern sie dann in einem bestimmten Format.

Diese Website dient als Leitfaden für die Erstellung hochskalierbarer Scraper.

Python-Frameworks und -Ansätze in Kombination mit einigen Code-Snippets können verwendet werden, um Daten auf verschiedene einfache Arten zu kratzen. Es gibt mehrere Anleitungen, die Ihnen helfen können, dasselbe in die Praxis umzusetzen.

Das Scraping einer einzelnen Seite ist einfach, aber die Verwaltung des Spinnencodes, das Sammeln von Daten und die Pflege eines Data Warehouse ist schwierig, wenn Millionen von Seiten gescrapt werden. Um das Scraping einfach und präzise zu gestalten, untersuchen wir diese Probleme und ihre Lösungen.

Schnelle Links:

- Shiftproxy-Überprüfung

- Was ist ein Proxyserver

- Top 3 SmartProxy-Alternativen

**Zusätzlicher Tipp: Verwenden Sie rotierende IPs und Proxy-Dienste

Wie Sie sich bereits ein Bild gemacht haben, können Sie mit Web Scraping mithilfe einer Reihe von Programmierbefehlen Informationen aus dem Internet sammeln. Aber wie Sie wissen müssen, können Ihre Web-Scraping-Aktivitäten über Ihre IP-Adresse nachverfolgt werden.

Dies wird kein großes Problem sein, wenn Sie die Daten aus einer öffentlichen Domäne kratzen. Aber wenn Sie private Daten von beispielsweise einer speziellen Medienseite kratzen, können Sie in Schwierigkeiten geraten, wenn Ihre IP-Adresse aufgespürt wird.

Um also zu verhindern, dass Ihr Spider auf die schwarze Liste gesetzt wird, ist es grundsätzlich immer vorzuziehen, Proxy-Dienste zu verwenden und IP-Adressen zu ändern.

Wir ermutigen Sie auf keinen Fall, Web Scraping zum Sammeln illegaler oder privater Daten zu verwenden oder sich böswilligen Spyware-Aktivitäten hinzugeben?

Wenn Sie jedoch Daten sammeln, die möglicherweise privat sind, wird empfohlen, Ihre IP-Adresse zu maskieren oder zu rotieren oder einen Proxy-Server zu verwenden, um eine Verfolgung zu vermeiden.

Vielleicht möchten Sie auch lesen:

- Octoparse-Rezension

- Die besten Reddit-Scraper

- Die 12 besten Web-Scraping-Proxys

Ist Web Scraping legal?

Offiziell steht in den Internetnormen und -richtlinien nirgends, dass Web Scraping illegal ist. Fairerweise muss gesagt werden, dass Web Scraping völlig legal ist, vorausgesetzt, Sie arbeiten mit öffentlichen Daten.

Ende Januar 2020 wurde bekannt gegeben, dass das Scrapen öffentlich zugänglicher Daten für nichtkommerzielle Zwecke vollständig erlaubt ist.

Für die Allgemeinheit frei zugängliche Informationen sind Daten, die ohne Passwort oder sonstige Authentifizierung für jedermann online zugänglich sind. Öffentlich verfügbare Informationen umfassen also Informationen, die auf Wikipedia, in sozialen Medien oder in den Google-Suchergebnissen zu finden sind.

Einige Websites verbieten es den Nutzern jedoch ausdrücklich, ihre Daten mit Web Scraping zu scrapen. Das Scraping von Daten aus sozialen Medien wird manchmal als illegal angesehen.

Der Grund dafür ist, dass einige davon der Öffentlichkeit nicht zugänglich sind, beispielsweise wenn ein Benutzer seine Informationen privat macht. In diesem Fall ist das Scrapen dieser Informationen verboten. Das Scraping von Informationen von Websites ohne Zustimmung des Eigentümers kann ebenfalls als schädlich angesehen werden.

Holen Sie das Beste aus dem Web heraus durch Web Scraping!

Das Sammeln und Analysieren von Daten von Websites hat ein enormes Anwendungspotenzial in einer Vielzahl von Bereichen, darunter Data Science, Corporate Intelligence und investigative Berichterstattung.

Eine der grundlegenden Fähigkeiten, die ein Data Scientist benötigt, ist Web Scraping.

Denken Sie daran, dass nicht jeder möchte, dass Sie auf seine Webserver zugreifen, um Daten zu erhalten. Bevor Sie mit dem Scrapen einer Website beginnen, stellen Sie sicher, dass Sie die Nutzungsbedingungen gelesen haben. Seien Sie auch beim Timing Ihrer Webabfragen rücksichtsvoll, um eine Überlastung eines Servers zu vermeiden.

Schnelle Links

- Beste Proxys für die Aggregation von Reisepreisen

- Beste französische Proxys

- Die besten Tripadvisor-Proxys

- Beste Etsy-Proxys

- IPRoyal Gutscheincode

- Beste TikTok-Proxys

- Beste freigegebene Proxys

- Beste Deutschland Proxys