Was ist Bot-Traffic? So verhindern Sie, dass Traffic-Bots Chaos verursachen

Veröffentlicht: 2021-02-08Bot-Traffic ist jeglicher Internetverkehr, der von automatisierten Bots kommt. Diese Bots können Aufgaben schneller ausführen als jeder Mensch, was sie sehr effizient und beliebt macht.

Bei so vielen Missverständnissen in Bezug auf Bot-Traffic werfen wir einen Blick auf die verschiedenen beteiligten Roboter und was dies für Ihre Website bedeutet.

In einer Welt, in der täglich Milliarden von Nutzern online miteinander interagieren, kann das Internet wie ein hektischer Ort erscheinen. Da Benutzer Bilder mögen, Nachrichten retweeten und Kommentare positiv bewerten, ist der tägliche Webverkehr im Internet auf einem Allzeithoch.

Aber wie viele dieser Besucher sind wirklich echt?

Ist dies eine gute Sache für Website-Besitzer und -Benutzer, wenn täglich mehr Bots ins Internet gelangen, oder nur ein weiteres Ärgernis?

Um vollständig zu verstehen, was Bot-Traffic ist, müssen wir zunächst die verschiedenen Arten von automatisierten Bots und deren Funktionsweise untersuchen.

Was ist Bot-Traffic?

Bot-Traffic kann als jeglicher Online-Internetverkehr definiert werden, der nicht von einem Menschen generiert wird . Dies bedeutet normalerweise, dass der Datenverkehr von einer Art automatisierten Skripts oder Computerprogramms stammt, das einem Benutzer die Zeit ersparen soll, alle Aufgaben manuell zu erledigen. Obwohl diese Bots versuchen, menschliches Verhalten nachzuahmen, sind sie mit Sicherheit keine Menschen.

Diese automatisierten Bots können einfache Dinge wie das Klicken von Links und das Herunterladen von Bildern oder komplizierte Aufgaben wie das Scrapen oder das Ausfüllen von Formularen erledigen. Was auch immer sie tun sollen, sie tun es normalerweise in großem Umfang und laufen fast ununterbrochen. Wenn Sie jemals ein Bild in sozialen Medien wie Instagram oder Facebook gepostet und innerhalb von Sekunden Hunderte von Likes erhalten haben, dann handelt es sich höchstwahrscheinlich um Bots.

Da schätzungsweise über 50 % des Internets auf Bot-Traffic entfallen, ist klar, dass Bots fast überall und auf praktisch jeder Website zu finden sind.

Um Ihnen eine Vorstellung von den verschiedenen Arten von Bots zu geben, finden Sie hier eine kurze Aufschlüsselung der guten Bots und ihrer Funktionsweise sowie der schlechten Bots.

Der gute Bot-Traffic

Obwohl automatisierter Bot-Traffic von Webmastern einen ziemlich negativen Ruf hat, gibt es tatsächlich eine Reihe legitimer Bots, die nur versuchen, zu helfen.

Suchmaschinen-Bots

Die erste und offensichtlichste Art von gutem Bot-Traffic sind Suchmaschinen-Bots. Diese Internet-Bots crawlen so viel wie möglich im Web und helfen Website-Besitzern, ihre Websites in Suchmaschinen wie Google-Suche, Yahoo und Bing aufzulisten. Ihre Anfragen können automatisiert und als Bot-Traffic aufgeführt werden, aber diese Bots sind sicherlich gute Bots.

Bots überwachen

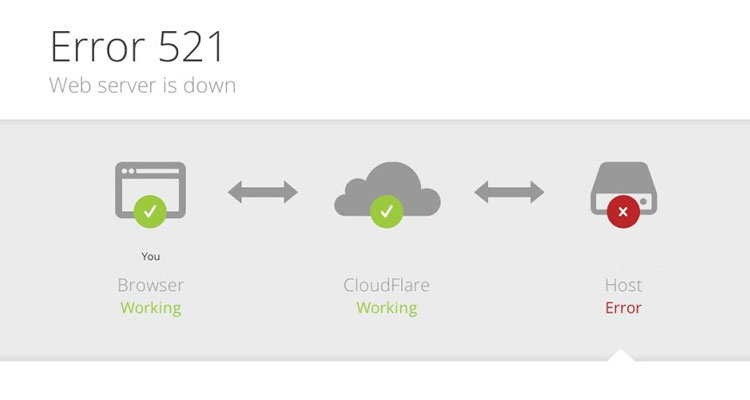

Wenn Sie eine Website besitzen, dann ist es für viele Eigentümer oft eine Priorität, sicherzustellen, dass Ihre Website intakt und immer online ist. Um Benutzern dabei zu helfen, sicherzustellen, dass ihre Website immer zugänglich ist, gibt es eine Reihe von Website-Überwachungs-Bots, die Ihre Website automatisch anpingen, um sicherzustellen, dass sie noch online ist. Wenn jemals etwas kaputt geht oder Ihre Website offline geht, werden Sie sofort benachrichtigt und können etwas dagegen tun.

SEO-Crawler

Der Versuch, Ihre Website in Suchmaschinen auf Platz eins zu bringen, kann äußerst schwierig sein, insbesondere wenn Sie nicht über viele Informationen verfügen. Glücklicherweise gibt es eine Reihe von Software, die Ihnen helfen kann, Ihre SEO-Bemühungen zu verbessern, indem Sie Ihre Website und Ihre Konkurrenten crawlen, um zu sehen, wofür Sie und wie gut Sie ranken. Webmaster können diese Daten dann verwenden, um ihre Sichtbarkeit in der Suche zu verbessern und ihren organischen Web-Traffic zu verbessern.

Copyright-Bots

Sicherzustellen, dass niemand Ihre Bilder gestohlen und als eigene verwendet hat, kann eine schwierige Aufgabe sein. Bei so vielen Websites, die ständig überprüft werden müssen, ist die einzig sinnvolle Lösung ein automatisierter Bot. Diese Webroboter crawlen das Web und scannen nach bestimmten Bildern, um sicherzustellen, dass niemand ohne Erlaubnis urheberrechtlich geschützte Inhalte illegal verwendet.

Der schlechte Bot-Traffic

Im Gegensatz zu den oben erwähnten guten Bots machen schlechte Bots wirklich schlechte Dinge mit Ihrer Website und können viel Schaden anrichten, wenn sie frei herumlaufen. Dies kann jede Art von Bot-Angriff sein, der gefälschten Datenverkehr und Spam-Datenverkehr sendet, oder etwas viel Störenderes wie Anzeigenbetrug.

Webschaber

Web Scraper sind nervige Internet-Bots, die Websites auf der Suche nach wertvollen Informationen wie E-Mail-Adresse und Kontaktdaten durchsuchen. In anderen Fällen stehlen sie Inhalte und Bilder von Websites und verwenden sie ohne Erlaubnis auf ihrer eigenen Website oder in sozialen Medien. Sie nützen niemandem außer der Person, die sie zum Scrapen von Daten verwendet.

Spam-Bots

Wenn Sie jemals eine bizarre E-Mail oder einen Blog-Kommentar von jemandem erhalten haben, dann ist die Wahrscheinlichkeit groß, dass ein Spam-Bot sie hinterlassen hat. Diese Bots lieben es, generierte Nachrichten (die oft keinen Sinn machen) auf dem Blog einer Website zu hinterlassen. Sie füllen auch Kontaktformulare auf Websites und Spam-Eigentümer mit Werbenachrichten aus.

DDoS-Netzwerke

Einer der ältesten und tödlichsten Bad Bots auf dem Markt muss der DDoS-Bot sein. Diese Bots, die als verteilte Denial-of-Service-Bots bekannt sind, werden oft auf den PCs ahnungsloser Opfer installiert und werden verwendet, um eine bestimmte Website oder einen bestimmten Server ins Visier zu nehmen, um sie offline zu schalten.

Bekannt als DDoS-Angriff, gab es in der Vergangenheit viele Berichte darüber, dass sie Websites, die mehrere Tage offline waren, schweren finanziellen Schaden zufügten.

Schwachstellenscanner

Diese Bots mögen aus den Serverprotokollen einer Website wie gute Bots erscheinen, aber das ist leider nicht der Fall. Es gibt eine Reihe bösartiger Bots, die Millionen von Websites auf Schwachstellen scannen und sie ihrem Ersteller melden. Im Gegensatz zu echten Bots, die den Website-Besitzer informieren würden, werden diese bösartigen Bots speziell dafür entwickelt, einer Person Bericht zu erstatten, die dann höchstwahrscheinlich die Informationen verkauft oder sie selbst zum Hacken von Websites verwendet.

Klicken Sie auf Betrugsbots

Viele wissen nicht, dass es viele ausgeklügelte Bots gibt, die eine große Menge an bösartigem Bot-Traffic produzieren, der speziell auf bezahlte Anzeigen abzielt. Im Gegensatz zu Robotern, die unerwünschten Website-Traffic erzeugen, begehen diese Bots etwas, das als Anzeigenbetrug bekannt ist.

Verantwortlich für das betrügerische Klicken auf bezahlte Anzeigen, kostet dieser nicht menschliche Traffic Werbetreibende jedes Jahr Milliarden und wird oft als legitimer Traffic getarnt. Ohne gute Bot-Erkennungssoftware kann diese Bot-Aktivität Werbetreibende einen großen Teil ihres Werbebudgets kosten.

Wie können Traffic-Bots schlecht für Websites sein?

Jetzt wissen Sie über die verschiedenen Arten von guten und bösartigen Bots Bescheid. Wie kann Bot-Traffic für Ihre Website schädlich sein?

Das Wichtigste bei Bots ist, dass die meisten Skripte und Programme darauf ausgelegt sind, eine Aufgabe mehrmals zu erledigen. Der Ersteller des Bots möchte natürlich, dass die Arbeit so schnell wie möglich erledigt wird, aber dies kann viele Probleme für Ihre Website mit sich bringen.

Das größte Problem besteht darin, dass, wenn ein Roboter kontinuierlich Informationen von Ihrer Website anfordert, dies zu einer allgemeinen Verlangsamung führen kann. Dies bedeutet, dass die Site für jeden, der darauf zugreift, langsam ist, was zu massiven Problemen führen kann, wenn Sie beispielsweise ein Online-Shop sind.

Konsistente Scraping-Anfragen können auch dazu führen, dass wichtige KPIs und Google Analytics-Daten wie Ihre Absprungrate verzerrt werden.

Im Extremfall kann zu viel Bot-Traffic sogar Ihre gesamte Website offline nehmen, was natürlich nicht gut ist. Aber zum Glück ist dies nur unter extremen Umständen der Fall, die Auswirkungen von Bot-Traffic auf Ihre Website sind meistens sehr subtil.

Viel Bot-Traffic auf Ihrer Website führt normalerweise zu Dingen wie:

- Mehr Seitenaufrufe

- Höhere Bandbreitennutzung

- Falsches Google Analytics

- Verzerrte Marketingdatenqualität

- Rückgang der Conversions

- Spamnachrichten

- Längere Ladezeiten

- Höhere Serverkosten

- Erhöhte Absprungrate

- Erhöhte Belastung der Rechenzentren

Bot-Traffic erkennen

Wenn Sie überprüfen möchten, ob Ihre Website von Bot-Traffic betroffen ist, dann ist der beste Ausgangspunkt Google Analytics.

In Google Analytics können Sie alle wichtigen Website-Metriken wie die durchschnittliche Verweildauer auf der Seite, die Absprungrate, die Anzahl der Seitenaufrufe und andere Analysedaten sehen. Anhand dieser Informationen können Sie schnell feststellen, ob und in welchem Umfang die Analysedaten Ihrer Website durch Bot-Traffic verzerrt wurden.

Da Sie in Google Analytics keine IP-Adressen von Nutzern sehen können, müssen Sie diese Messwerte überprüfen, um zu sehen, ob sie sinnvoll sind. Eine sehr niedrige Metrik für die Verweildauer auf der Website ist ein klarer Indikator dafür, dass die meisten Ihrer Besucher Bots sein könnten. Ein Internet-Bot braucht nur wenige Sekunden, um eine Webseite zu crawlen, bevor sie sie verlässt und zu ihrem nächsten Ziel wechselt.

Ein weiterer Ort, an dem Sie in Google Analytics nachsehen können, ist der Abschnitt "Empfehlungen", um zu überprüfen, ob Sie keinen Empfehlungs-Spam erhalten. Viele Unternehmen zielen auf andere Websites mit einem benutzerdefinierten Bot ab, der ihre Website-URL spammt.

Wenn ein Webmaster seinen Referral-Traffic in Google Analytics überprüft, sieht er den Namen der Website und neigt zum Besuch. So grob das klingt, es kann dazu beitragen, dass die Site viele Besucher generiert (hauptsächlich aus Neugier!). Es hört sich vielleicht nicht so an, als würden sie Ihrer Website schaden, aber sie verfälschen tatsächlich alle Ihre Metriken, verschwenden Ihre Bandbreite und verstopfen Ihren Server im Allgemeinen.

So stoppen Sie den Bot-Verkehr

Es ist durchaus möglich, schlechten Bot-Traffic zu filtern und automatisierte Roboter daran zu hindern, Ihrer Website zu schaden, aber die Lösung hängt von der Art der Verkehrsquelle ab, die Ihre Website beeinflusst. Denken Sie daran, dass nicht jeder Bot-Traffic schlecht ist und das Blockieren von Bots wie Suchmaschinen-Crawlern wirklich keine gute Idee ist!

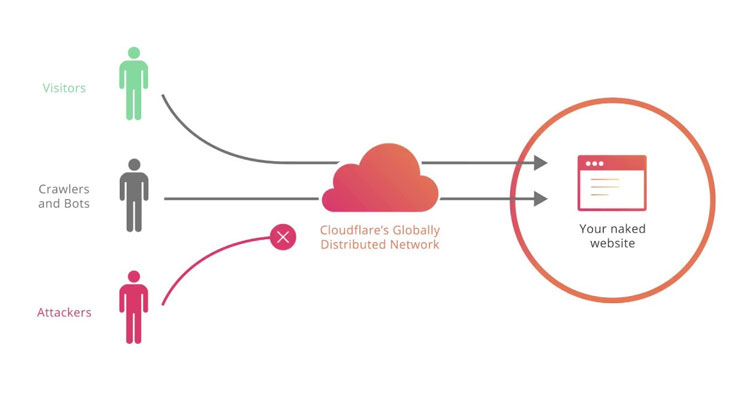

Wenn Ihre Website anfällig dafür ist, von Robotern, Schwachstellenscannern und automatisierten Traffic-Bots abgekratzt zu werden, besteht die Möglichkeit, dass Sie eine Bot-Filterung in Form einer Firewall oder eines CAPTCHA benötigen. Der beste Weg, dies zu tun, besteht darin, einen kostenlosen Bot-Filter-Dienst namens CloudFlare auf Ihrer Website zu installieren.

Abgesehen davon, dass es sich um ein Content Delivery Network (CDN) handelt, fungiert CloudFlare als Anwendungs-Firewall zwischen der Website und dem Benutzer, was bedeutet, dass nur legitime Benutzer auf Ihre Website zugreifen können. Alle verdächtigen Benutzer werden es nicht schaffen und nicht auf Ihre Website zugreifen. Das bedeutet, dass sie Ihre Bandbreite nicht verschwenden, Ihre Analysen ruinieren oder Ihre Inhalte gestohlen werden.

Eine weitere nützliche Möglichkeit, Bots zu blockieren, besteht darin, die Robots-txt-Datei Ihrer Website zu verwenden, indem Sie sie mit Benutzeragenten oder dem tatsächlichen Namen der bekannten Bots füllen. In dieser praktischen Anleitung erfahren Sie mehr über das Blockieren von Robots in der robots-txt-Datei. Dies funktioniert natürlich nur, wenn der Roboter die Datei robots.txt respektiert, was die meisten echten Bots tun. Wenn Sie versuchen, einen lästigen Bad Bot loszuwerden, ist die Verwendung der oben genannten CloudFlare-Option am besten.

Wenn Sie Ihre Website jedoch vor anderen Arten von Bots wie betrügerischen und wiederholten Klicks auf Ihre Anzeigen schützen möchten, benötigen Sie etwas anderes.

Schützen Sie Ihre Anzeigen vor schlechtem Bot-Traffic

Jeder, der Pay-per-Click-Anzeigen bei Google schaltet, unterliegt Bot-Traffic. Bei so vielen Crawlern da draußen, die ständig Google und seine Ergebnisse abkratzen, ist es nur eine Frage der Zeit, bis diese Bots auf Ihre Anzeigen klicken und Ihre Analysedaten und Ihr Budget ruinieren.

PPC Protect ist ein automatisiertes Tool zur Erkennung von Anzeigenbetrug, das jeden Klickbetrug bei Ihren Pay-per-Click-Anzeigen in Echtzeit erkennt.

Durch das Sammeln vieler Daten bei jedem Klick kann die Software erkennen, wenn eine IP-Adresse verdächtig ist, und diesen bestimmten Benutzer daran hindern, Ihre Anzeigen in Zukunft zu sehen.

Dies hilft, Bot-Traffic von SEO-Tools zu bekämpfen, die Google und andere Suchmaschinen crawlen, die nach PPC-Anzeigen suchen. Bei vielen dieser Tools auf dem Markt werden Sie überrascht sein, wie oft sie Suchergebnisse nach Anzeigen und anderen Informationen crawlen.

Um Ihre Anzeigen vor unerwünschtem Bot-Traffic und Scrapern zu schützen, klicken Sie unten, um sich für eine kostenlose 14-tägige Testversion unseres Dienstes anzumelden.