AI をマーケティングに使用することで直面する 7 つの重大なリスク

公開: 2023-07-06数年前、私たちマーケターのほとんどは、マーケティングに AI を使用する方法についてほとんど漠然とした考えを持っていませんでした。 突然、私たちは ChatGPT の耳にささやくのに最適なプロンプトについて LinkedIn の投稿を書いています。

私たちの仕事に人工知能が突然導入されたことについては、祝うべきことがたくさんあります。 マッケンジー氏は、AI によってマーケターにとって 2 兆 6000 億ドルの価値が解放されると考えています。

しかし、私たちのAIの急速な導入は、重要な倫理的、法的、運用上の問題を先取りしている可能性があり、マーケターはこれまで考える必要がなかったリスクにさらされることになる(つまり、AIに「スティーブン・キングのように書くように命じたとして訴訟を起こされる可能性があるのか?」)。 ”)。

マーケティング環境には何トンもの AI の塵があり、それは何年も解決しないでしょう。 どんなに目を細めても、大規模な言語モデルや機械学習を使用してコンテンツを作成したり広告を管理したりする場合に起こり得る落とし穴をすべて理解することはできません。

したがって、この記事の目的は、マーケティングに AI を使用することによる 7 つの最も顕著なリスクを非常に高い観点から考察することです。 こうしたリスクを軽減するための専門家からのアドバイスをまとめました。 また、最も気になる質問をさらに深く掘り下げることができるように、多くのリソースを追加しました。

リスク #1: 機械学習のバイアス

機械学習アルゴリズムは、誰かまたは何かに不当に有利または不利な結果を与えることがあります。 これは機械学習バイアス、または AI バイアスと呼ばれ、最先端のディープ ニューラル ネットワークにも蔓延する問題です。

データの問題です

AI ネットワークが本質的に偏見を持っているというわけではありません。 それは、それらに供給されるデータに問題があるのです。

機械学習アルゴリズムは、特定の買い物客グループが商品を気に入るかどうかなど、結果の確率を計算するパターンを識別することで機能します。

しかし、AI がトレーニングするデータが特定の人種、性別、年齢層に偏っていたらどうなるでしょうか? AI は、これらの人々の方がより適しているという結論に達し、それに応じて広告クリエイティブや配置を歪めます。

バイアスロンダリング編 pic.twitter.com/YQLRcq59lQ

— ジャネル・シェーン (@JanelleCShane) 2021年6月17日

ここに例を示します。 研究者らは最近、Facebookの広告ターゲティングシステムにおけるジェンダーバイアスをテストした。 捜査当局はピザハットの配達ドライバーを募集する広告を掲載し、インスタカートにも同じ資格を持つ同様の広告を掲載した。

ピザハットの既存のドライバーは男性に偏っているため、フェイスブックはこうした広告を男性に偏って表示した。 インスタカートには女性ドライバーが多いため、より多くの女性の前に彼らの仕事の広告が掲載されました。 しかし、女性がピザハットの仕事について知りたくないという本質的な理由はないので、これは広告のターゲティングにおける大きな間違いだ。

AIバイアスは一般的です

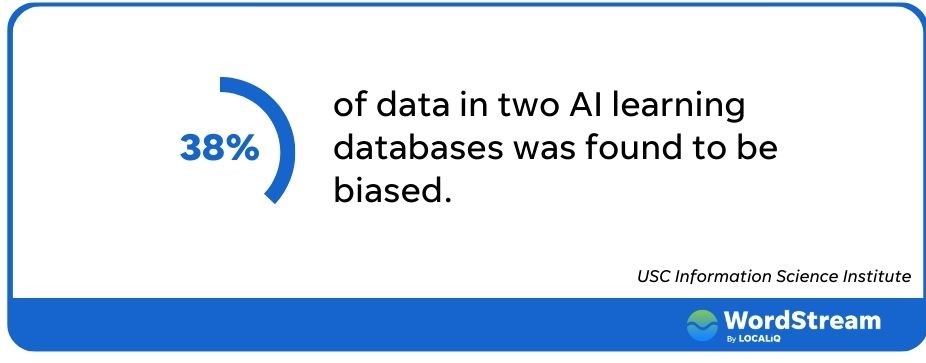

この問題はFacebookを超えて広がっている。 USC の研究者は 2 つの大規模な AI データベースを調べたところ、それらのデータの 38% 以上に偏りがあることがわかりました。 ChatGPT の文書では、そのアルゴリズムが「否定的な固定観念を黒人女性」と結び付ける可能性があるとさえ警告しています。

機械学習のバイアスはマーケターにいくつかの影響を与えます。 少なくとも広告パフォーマンスの低下は問題です。 可能な限り多くの潜在顧客にリーチしたい場合、人口の大部分を除外する広告ターゲティング プラットフォームは理想的とは言えません。

もちろん、広告が特定のグループを不当にターゲットにしたり排除したりすると、より大きな影響が生じます。 不動産広告が保護された少数者を差別している場合、公正住宅法と連邦取引委員会の間違った方向に到達する可能性があります。 言うまでもなく、包括的なマーケティングボートを完全に逃しています。

AI のバイアスを回避する方法

では、AI ツールが暴走した場合はどうすればよいのでしょうか? 広告ですべての人を公平に扱うために実行できる手順が 2 つあります。

何よりもまず、誰かにあなたのコンテンツをレビューしてもらってください。Writer のコンテンツおよびコミュニティ担当シニア マネージャーである Alaura Weaver が執筆しています。 「AI テクノロジーは大幅に進歩しましたが、人間が持つ批判的思考や意思決定能力が欠けています」と彼女は説明します。 「人間の編集者に AI が書いたコンテンツをレビューおよび事実確認させることで、コンテンツに偏見がなく、倫理基準に従っていることを確認できます。」

人間による監視により、有料広告キャンペーンでマイナスの結果が生じるリスクも軽減されます。

「現時点では、そしておそらく今後も、キャンペーンやあらゆる形態のマーケティングを AI に完全に引き継がせるのは賢明ではありません」とエンピリック マーケティングの創設者ブレット マクヘイルは言います。 「AI は、すでに膨大な量のデータと経験を蓄積している有機知能から正確な入力を受け取ると、最適に動作します。」

リスク #2: 事実の誤り

Googleは最近、同社の新しいAIチャットボット「Bard」が宣伝ツイートで不正確な回答をしたため、親会社の評価額として1000億ドルの費用がかかった。

Bard は、LaMDA を利用した実験的な会話型 AI サービスです。 大規模な言語モデルを使用し、Web からの情報を利用して構築されたこのツールは、好奇心を刺激する出発点であり、複雑なトピックを単純化するのに役立ちます → https://t.co/fSp531xKy3 pic.twitter.com/JecHXVmt8l

— Google (@Google) 2023 年 2 月 6 日

Google のおふざけは、AI の最大の限界の 1 つと、AI を使用するマーケティング担当者にとっての最大のリスクの 1 つを浮き彫りにしました。それは、AI が常に真実を伝えるとは限らないということです。

AIが幻覚を起こす

ウォートン・スクール・オブ・ビジネスのイーサン・モリック教授は最近、ChatGPTのようなAIを活用したシステムを「全知で喜ばせたがりで、時々嘘をつくインターン」と表現した。

もちろん、一部の人が主張しているにもかかわらず、AI には知覚力はありません。 私たちを騙すつもりはありません。 ただし、「幻覚」に悩まされて、ただでっち上げてしまう可能性があります。

AIは予測機械です。 質問に答える次の単語またはフレーズを入力するようです。 しかし、それは自己認識ではありません。 AI には、つなぎ合わせたものが意味があるかどうかを判断するための直感的なロジックがありません。

バイアスとは異なり、これはデータの問題ではないようです。 ネットワークに正しい情報がすべて含まれている場合でも、間違ったことを伝える可能性があります。

ユーザーが ChatGPT に「アルゼンチンは FIFA ワールドカップで何回優勝しましたか?」と質問した例を考えてみましょう。 かつて、チームの1978年の勝利について言及したことがある。 次にツイート主は、1986年にどのチームが優勝したかを尋ねた。

#ChatGPT abt に 2022 年の FIFA ワールドカップで誰が優勝したか尋ねましたが、回答できませんでした。 それは予想通りです。 ただし、システムには情報があるにもかかわらず、間違った情報 (他の 2 人の勝利について) が提供されているようです。 #説明はありますか? pic.twitter.com/fvxe05N12p

— インドラニル・シンハロイ (@indranil_leo) 2022 年 12 月 29 日

チャットボットは、以前の失言について何の説明もせずに、それがアルゼンチンであることを認めた。

厄介な点は、AI の誤った回答が自信満々に書かれていることが多く、周囲のテキストに溶け込んでいて、完全にもっともらしい回答であるかのように見えることです。 また、Open.ai に対して起こされた訴訟で詳述されているように、それらは包括的なものになる可能性があります。この訴訟では、ChatGPT が横領の全容をでっち上げ、それがジャーナリストによって共有されたとされています。

AIの幻覚を避ける方法

AI は 1 語の答えでもユーザーを迷わせる可能性がありますが、長い文章を書く場合には脱線する可能性が高くなります。

「単一のプロンプトから、AI はブログや電子書籍を生成できます。 はい、それは素晴らしいことですが、落とし穴があります」とウィーバー氏は警告する。 「生成されるデータが多ければ多いほど、より多くの編集と事実確認が必要になります。」

AI ツールが幻覚的な物語を紡ぎ始める可能性を減らすには、アウトラインを作成し、ボットに一度に 1 つのセクションずつ取り組んでもらうのが最善だとウィーバー氏は言います。 そしてもちろん、追加された事実と統計を人にレビューしてもらいます。

リスク #3: AI ツールの誤用

私たちは毎朝目覚めると、まるで暴風雨の後のキノコのように一夜にして芽生えたように見える、新たな AI ツールの収穫を目の当たりにします。

しかし、すべてのプラットフォームがすべてのマーケティング機能に合わせて構築されているわけではなく、一部のマーケティング課題は(まだ)AI によって解決できません。

AIツールには限界がある

ChatGPT はその良い例です。 AI ボールの魅力は、楽しく遊ぶことができます (ビデオデッキからピーナッツバターサンドイッチを取り出す方法を欽定訳聖書風に書くのと同じです)。 そして、驚くほどよく書かれた短い形式の回答を量産して、ライターのブロックを解消することができます。 ただし、キーワード調査に役立つように求めないでください。

ChatGPT は、2022 年より前の情報のみを含む比較的古いデータ セットが原因で失敗します。 「AI マーケティング」のキーワードを提供するよう依頼しても、その答えは Thinword や Contextminds などの他のツールで見つかるものと一致しません。

同様に、Google と Facebook は、マーケティング担当者が広告を作成し、広告費用を最適化し、広告エクスペリエンスをパーソナライズできるようにする、AI を活用した新しいツールを提供しています。 チャットボットではこれらの課題を解決できません。

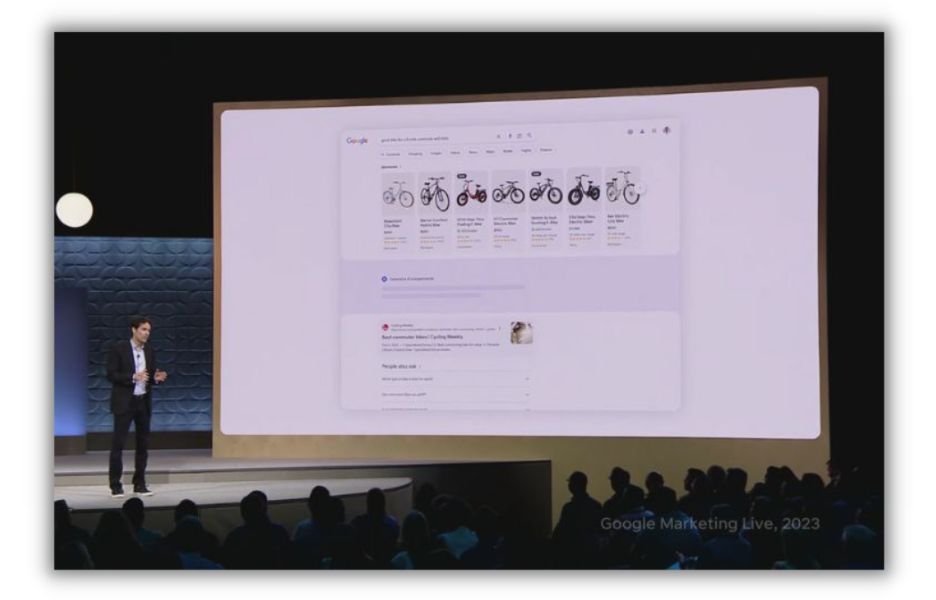

Googleは、2023年のGoogleマーケティングライブイベントで、検索および広告管理製品に対する多数のAIアップグレードを発表した。

AIを使いすぎる可能性がある

AI ツールに単一のタスクを与えると、たった 1 つの目標に対してインデックスが過剰になる可能性があります。 マーケティングオートメーションの専門家であるニック・アビーン氏は、SEOの改善に注力している企業でこれをよく目にします。

「私が考える最大の問題は、SEO ツールを盲目的に使用し、検索エンジンに過剰に最適化し、顧客の検索意図を無視していることです」とアベンヌ氏は言います。 「SEO ツールは、検索エンジンに質の高いコンテンツを伝えるのに最適です。 しかし最終的には、Google は検索者の要望に応えたいと考えています。」

AIツールの誤用を避けるには

レンチは釘を打つのに最適な選択肢ではありません。 同様に、AI ライティング アシスタントは Web ページの作成には適していない可能性があります。 1 つの AI オプションにすべてを投入する前に、ツールの作成者や他のユーザーからフィードバックを得るようにと Abbene 氏は言います。

「AI ツールの選択を誤ることを避けるために、他のマーケターがあなたのユースケースにそのツールを使用しているかどうかを理解してください」と彼は言います。 「お気軽に製品デモをリクエストしたり、同じ機能を提供する他のツールと合わせて試してみたりしてください。」

Capterra のような Web サイトを使用すると、複数の AI プラットフォームを簡単に比較できます。

そして、適切な AI ツール スタックを見つけたら、それを引き継ぐのではなく、プロセスを支援するために使用します。 「ワークフローを強化するために AI ツールを使用することを恐れないでください。ただし、そのためだけに使用してください」とアベンヌ氏は言います。 「質の高いキーワード調査と検索意図の理解という第一原則から各コンテンツを開始します。」

リスク #4: 均質なコンテンツ

AI はエッセイ全体を約 10 秒で書くことができます。 しかし、生成 AI は印象的なものになりましたが、真に創造的であるというニュアンスが欠けており、その出力はしばしばロボットのように感じられます。

「AI は有益なコンテンツを作成するのには優れていますが、人間がもたらす創造性や関与性に欠けていることがよくあります」とウィーバー氏は言います。

AIは模倣するように作られている

生成 AI ライティング ボットに読書感想文を書いてもらうと、『キャッチャー イン ザ ライ麦』のメイン テーマを適切に説明する 500 語を簡単に紡ぎ出してくれます (ホールデン コールフィールドが銀行強盗として幻覚を起こさないと仮定して)。

それができるのは、J.D.サリンジャーの傑作に関する何千ものテキストを吸収しているからです。

次に、AI 仲間に、ブランド、視聴者、価値提案を要約した方法でビジネスの核となるコンセプトを説明するブログ投稿を書いてもらいます。 がっかりするかもしれません。 「AI が生成したコンテンツは、ブランドの個性や価値観の微妙なニュアンスを常に考慮しているとは限らず、的を外したコンテンツが生成される可能性があります」とウィーバー氏は言います。

言い換えれば、AI はすでに作成されたものを消化し、結合し、再構成することに優れています。 既存のコンテンツに対して目立つものを作成するのは得意ではありません。

生成 AI ツールは、コンテンツを魅力的にすることも苦手です。 彼らは、疲れた目を休めるために、画像、グラフ、箇条書きのない巨大な単語のブロックを喜んで量産します。 ポイントをより共感しやすくするために、顧客のストーリーや架空の例を持ち出すことはありません。 そして、彼らはあなたの業界のニュース記事をあなたの製品が提供する利点と結びつけるのに苦労するでしょう。

同種のコンテンツを避ける方法

Writer などの一部の AI ツールには、ライターが一貫したブランド パーソナリティを維持するのに役立つ機能が組み込まれています。 しかし、「視聴者の共感を呼び、組織のメッセージと目標を強化するために、ブランドの声やトーンに合わせてコンテンツをレビューおよび編集する」編集者が依然として必要になるとウィーバー氏はアドバイスします。

編集者やライターも、他の人間と同じように記事を見ることができます。 理解できない言葉のブロックがある場合は、彼らがそれを解体し、視覚的な視覚効果を少し追加します。

AI コンテンツを出発点として使用し、創造性と研究を開始するのに役立ちます。 ただし、常にあなた自身の個人的なタッチを加えてください。

リスク #5: SEO の損失

AIコンテンツに対するGoogleのスタンスは少し曖昧だ。 当初、検索エンジンは AI で書かれた投稿にペナルティを与えるのではないかと思われました。

[画像: AIに関するジョン・ミューラー氏のツイート]

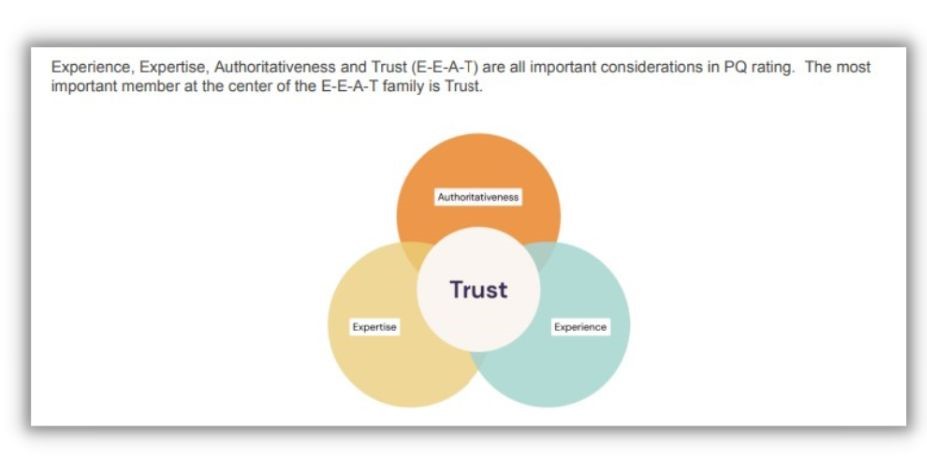

最近では、Google の開発者ブログが本の中で AI は OK だと述べています。 しかし、この確認には大きな意味があります。 Google のランキング システムを継続的に評価する人間の検索評価者に好印象を与えるのは、「専門知識、経験、権威性、信頼性といった、いわゆる EEAT の性質を示すコンテンツ」だけです。

信頼はSEOにとって重要です

Google の EEAT の中で、すべてを支配する 1 つの要素は信頼です。

[ソース]

AI コンテンツは誤解を招きやすいため、人間の監督がなければ本質的に信頼できないものであることについてはすでに説明しました。 また、本質的に、そのテーマに関する専門知識、権威、経験を持つ人によって書かれたものではないため、サポート要件も満たしていません。

バナナブレッドの焼き方についてのブログ投稿を見てみましょう。 AIボットが約2秒でレシピを教えてくれる。 しかし、家族のためにパンを焼いて過ごす寒い冬の日には、詩的になることはできません。 あるいは、業務用パン屋としてさまざまな種類の小麦粉を実験して過ごした長年のことについて話してください。 Google の検索評価者が求めているのは、こうした視点です。

それは人々が切望しているものでもあるようです。 だからこそ、彼らの多くは、以前は Google で見つけたものを学ぶために、TikTok 動画で実際の人物に目を向けているのです。

SEO の損失を回避する方法

AI の素晴らしい点は、署名欄の共有を気にしないことです。 したがって、チャットボットを使用してコンテンツ制作をスピードアップする場合は、資格情報を持つ人間の作成者を参照するようにしてください。

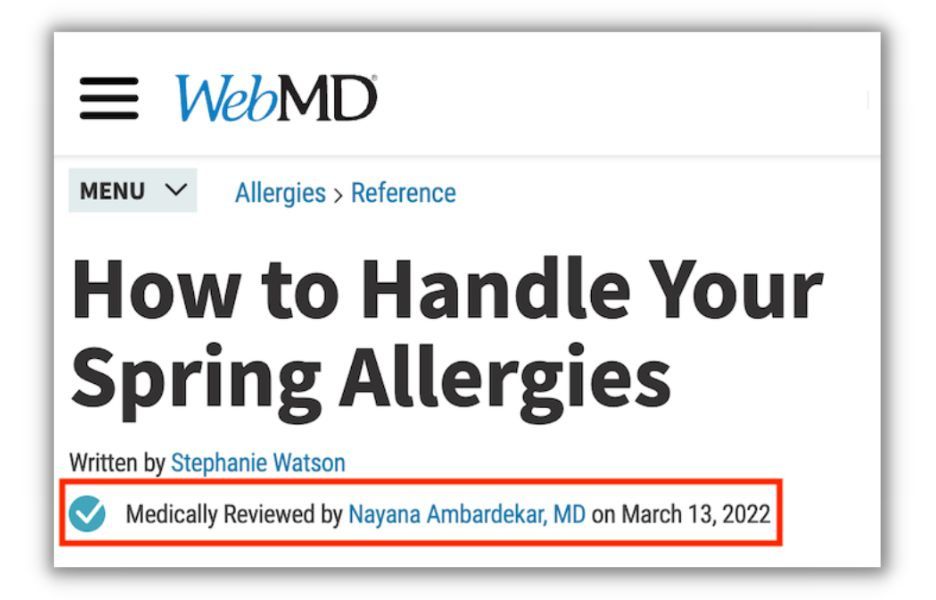

これは、Google が Your Money, Your Life トピックと呼ぶ医療や個人の財務などの機密性の高い主題に特に当てはまります。 WordStream と LocaliQ のコンテンツおよび SEO ディレクターである Elisa Gabbert 氏は、「YMYL の分野に携わっている場合は、コンテンツの権威、信頼、正確さを何よりも優先してください」とアドバイスしています。

たとえば、医療について書く場合は、医療専門家に投稿をレビューしてもらい、投稿内で参照してください。 これは、たとえチャットボットで開始されたものであっても、コンテンツが信頼できるということを Google に示す強力なシグナルとなります。

リスク #6: 法的異議申し立て

生成型 AI は人間が作成した作品から学習し、何か新しいもの (っぽいもの) を作成します。 AI コンテンツ モデルの入力と出力の両方について、著作権の問題は不明瞭です。

既存の研究は AI にとって公平なゲームである可能性が高い

大規模な学習モデルにフィードを与える作品の著作権の問題を説明するために (駄洒落を意図したものです)、技術者の Andy Baio によって報告された事例を取り上げます。 バイオ氏の説明によると、LA を拠点とするアーティスト、ホリー メンガートは、彼女のイラストのうち 32 点が AI モデルに取り込まれ、その後、彼女のスタイルを再現したい人にオープン ライセンスで提供されていることを知りました。

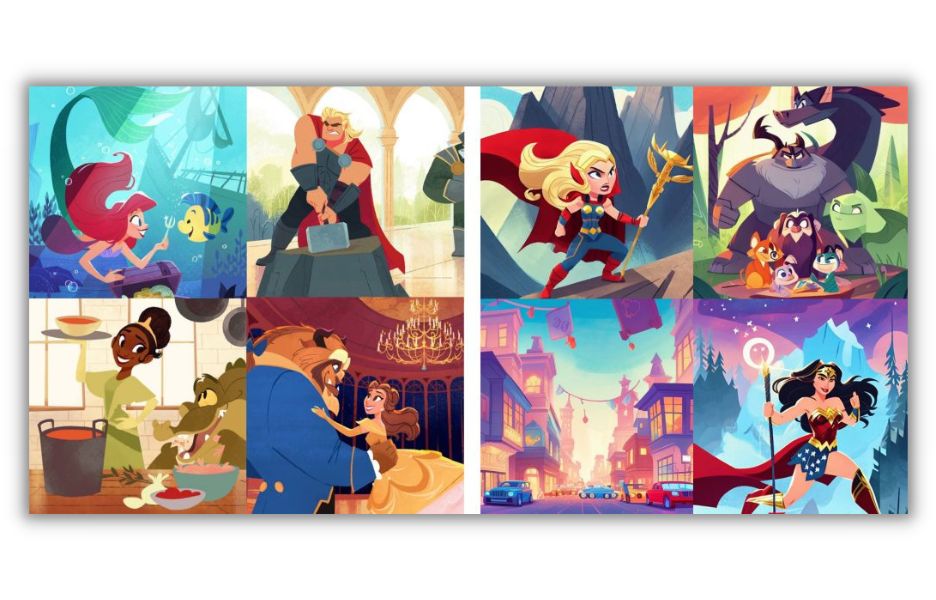

キャプション: アーティスト、ホリー メンガートのイラスト集 (左) と、アンディ バイオが監修した彼女のスタイルに基づいて AI が生成したイラストとの比較。

彼女が実際に権利を所有しているディズニーなどのクライアントのために多くの画像を作成したことを知ると、話はさらに複雑になります。

メンゲルトと同じ立場に陥ったイラストレーター(または作家やプログラマー)は、著作権侵害で首尾よく訴訟を起こすことができるだろうか?

この質問に対する明確な答えはまだありません。 「この問題の両側の人々が自分たちの立場に非常に自信を持っているのを見ますが、現実は誰も知りません」とバイオ氏はThe Vergeに語った。 「そして、これが法廷でどのように展開されるかを自信を持って知っていると言う人は間違いです。」

画像や記事の作成に使用する AI が、多くのクリエイターによる何千もの作品に基づいてトレーニングされたものであれば、裁判で負ける可能性は低いでしょう。 しかし、スティーブン キングの本を 10 冊マシンに入力し、そのスタイルで新しい本を書くようにボットに指示した場合、問題が発生する可能性があります。

免責事項:私たちは弁護士ではないため、不明な点がある場合は法的なアドバイスを受けてください。

AI コンテンツも保護されない可能性があります

チャットボットを使用して作成したコンテンツはどうなりますか? 著作権法の対象になりますか? ほとんどの場合、かなりの編集作業を行った場合を除き、問題は発生しません。 つまり、誰かがあなたの投稿を自分のブログ用に再利用(盗用)した場合、あなたにはほとんど頼る手段がありません。

保護されているコンテンツの場合、権利を持っているのはあなたではなく AI のプログラマーである可能性があります。 多くの国では、プロンプトを入力した人ではなく、作品を作成したツールの作成者を作成者と見なしています。

法的異議を回避する方法

まずは、評判の良い AI コンテンツ作成ツールを使用してください。 著作権法に対する自社の姿勢を明確に表明している企業が作成した、肯定的なレビューがたくさん掲載されているものを見つけてください。

また、クリエイターの作品を意図的にコピーしているのか、単に AI を使用して自分の作品を拡張しているのかを、賢明な判断で決定してください。

そして、自分が作ったものを守るために法廷で争うチャンスが欲しいなら、多くの大幅な変更を加えるべきです。 または、AI を使用してアウトラインを作成し、単語のほとんどを自分で書きます。

リスク #7: セキュリティとプライバシーの侵害

AI ツールは、システムのセキュリティとデータ プライバシーに対する幅広い潜在的な脅威をマーケティング担当者に提示します。 悪意のある攻撃者からの直接攻撃もあります。 また、単にユーザーが機密情報を共有するように設計されたシステムに無意識のうちに提供してしまう場合もあります。

AIツールによるセキュリティリスク

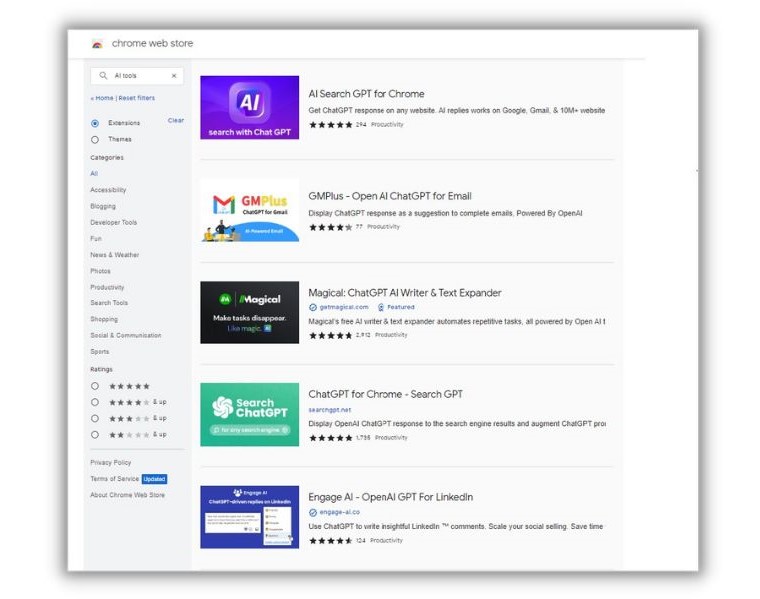

エンドポイント セキュリティ プロバイダーである Kolide のコンテンツ マーケティング担当シニア エディターである Elaine Atwell 氏は、「正規のツールのように見え、使用感、動作する製品がたくさんありますが、実際にはマルウェアです」と語った。 「正規のツールと区別するのは非常に困難ですが、現在は Chrome ストアで見つけることができます。」

Google Chrome ストアに「AI ツール」の任意のバージョンを入力すると、オプションが不足することがなくなります。

アトウェル氏はこれらのリスクについて Kolide ブログに書いた。 彼女は記事の中で、「チャット GPT へのクイック アクセス」と呼ばれる Chrome 拡張機能が実際には策略であった事件について言及しました。 このソフトウェアはダウンロードされると、ユーザーの Facebook アカウントを乗っ取り、被害者のすべての Cookie (セキュリティのための Cookie も含む) をスワイプしました。 アトウェル氏の報告によると、毎日 2,000 人以上がこの拡張機能をダウンロードしたという。

プライバシーが保護されていない

アトウェル氏は、正規の AI ツールであってもセキュリティ上のリスクが生じる可能性があると述べています。 「…現時点では、ほとんどの企業は、さまざまな拡張機能によってもたらされるリスクの種類とレベルを評価するためのポリシーさえ整備していません。 そして、明確なガイダンスがない中、世界中の人々がこれらの小さなヘルパーをインストールし、機密データを供給しています。」

投資家と共有する内部財務報告書を作成しているとします。 AI ネットワークは与えられたものから学習して、他のユーザー向けの出力を生成することを忘れないでください。 AI チャットボットに配置されたすべてのデータは、社外の人々にとっては公平な対象となる可能性があります。 また、競合他社があなたの収益について尋ねた場合にポップアップ表示される可能性があります。

プライバシーとセキュリティのリスクを回避する方法

防御の第一線は、ソフトウェアが主張どおりのものであることを確認することです。 さらに、選択したツールの使用方法には注意してください。 「AI ツールを使用する場合は (もちろん用途はありますが)、機密とみなされる可能性のあるデータを AI ツールに提供しないでください」とアトウェル氏は言います。

また、有用性と偏見について AI ツールをレビューする際には、そのプライバシーとセキュリティ ポリシーについて尋ねてください。

マーケティングに AI を使用するリスクを軽減する

AIは信じられないほどの速度で進歩しています。 1 年も経たないうちに、Chat GTP の機能はすでに大幅に向上しています。 今後 6 ~ 12 か月以内に AI で何ができるようになるかを知ることは不可能です。 また、潜在的な問題を予測することもできません。

最も一般的なリスクのいくつかを回避しながら、AI マーケティングの成果を向上させる方法をいくつか紹介します。

- 人間の編集者にコンテンツの品質、読みやすさ、ブランドの声をレビューしてもらいます

- セキュリティと機能のために使用する各ツールを精査する

- AI による広告ターゲティングにバイアスがないか定期的にレビューする

- コピーと画像に著作権侵害の可能性があるかどうかを評価する

この投稿に貢献してくれた Elain Attwell、Brett McHale、Nick Abenne、Alaura Weaver に感謝します。

要約として、マーケティングに AI を使用することに伴うリスクのリストを確認してみましょう。

- 機械学習のバイアス

- 事実の誤謬

- AIツールの誤用

- 均質なコンテンツ

- SEOの喪失

- 法的異議申し立て

- セキュリティとプライバシーの侵害