7 riesgos graves a los que te enfrentas al usar IA para marketing

Publicado: 2023-07-06Hace un par de años, la mayoría de nosotros, los especialistas en marketing, no teníamos la menor idea de cómo usar la IA para el marketing. De repente, estamos escribiendo publicaciones de LinkedIn sobre las mejores indicaciones para susurrar al oído de ChatGPT.

Hay mucho que celebrar sobre la repentina infusión de inteligencia artificial en nuestro trabajo. McKenzie cree que la IA desbloqueará un valor de 2,6 billones de dólares para los especialistas en marketing.

Pero nuestra rápida adopción de la IA puede estar adelantándonos a importantes cuestiones éticas, legales y operativas, lo que dejará a los especialistas en marketing expuestos a riesgos en los que nunca tuvimos que pensar antes (es decir, ¿podemos ser demandados por decirle a la IA que “escriba como Stephen King? ”).

Hay una tonelada métrica de polvo de IA en la atmósfera de marketing que no se asentará durante años. No importa lo mucho que entrecierre los ojos, no notará todos los peligros potenciales del uso de modelos de lenguaje grandes y el aprendizaje automático para crear contenido y administrar anuncios.

Entonces, nuestro objetivo en este artículo es ver siete de los riesgos más destacados del uso de la IA para el marketing desde un punto de vista muy elevado. Hemos recopilado consejos de expertos para ayudar a mitigar estos riesgos. Y hemos agregado muchos recursos para que pueda profundizar en las preguntas que más le preocupan.

Riesgo #1: sesgo de aprendizaje automático

A veces, los algoritmos de aprendizaje automático dan resultados que son injustamente a favor o en contra de alguien o algo. Se llama sesgo de aprendizaje automático o sesgo de IA, y es un problema generalizado incluso con las redes neuronales profundas más avanzadas.

es un problema de datos

No es que las redes de IA sean intrínsecamente intolerantes. Es un problema con los datos que se alimentan en ellos.

Los algoritmos de aprendizaje automático funcionan mediante la identificación de patrones para calcular la probabilidad de un resultado, como si a un grupo particular de compradores le gustará o no su producto.

Pero, ¿qué pasa si los datos en los que se entrena la IA están sesgados hacia una raza, género o grupo de edad en particular? La IA llegará a la conclusión de que esas personas son una mejor combinación y sesgarán la creatividad o la ubicación del anuncio en consecuencia.

Edición de lavado de prejuicios pic.twitter.com/YQLRcq59lQ

— Janelle Shane (@JanelleCShane) 17 de junio de 2021

Aquí hay un ejemplo. Los investigadores probaron recientemente el sesgo de género en los sistemas de orientación de anuncios de Facebook. Los investigadores colocaron un anuncio para reclutar repartidores para Pizza Hut y un anuncio similar con las mismas calificaciones para Instacart.

El grupo existente de conductores de Pizza Hut está sesgado por hombres, por lo que Facebook mostró esos anuncios de manera desproporcionada a los hombres. Instacart tiene más mujeres conductoras, por lo que los anuncios de su trabajo se colocaron frente a más mujeres. Pero no hay una razón inherente por la que las mujeres no quieran saber sobre los trabajos de Pizza Hut, por lo que es un gran paso en falso en la orientación de los anuncios.

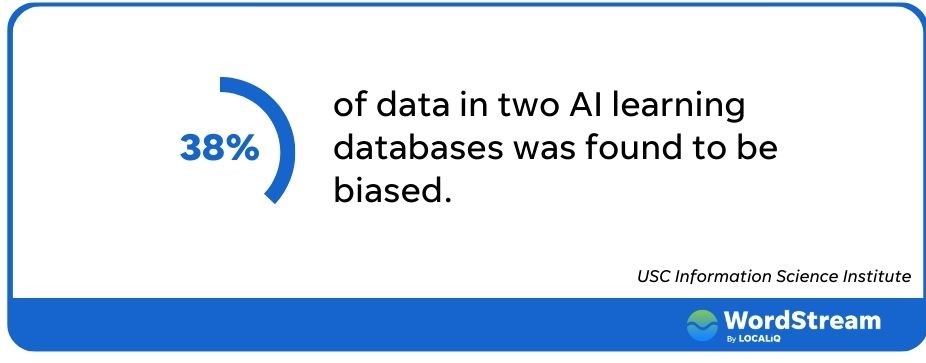

El sesgo de IA es común

El problema se extiende mucho más allá de Facebook. Investigadores de la USC observaron dos grandes bases de datos de IA y encontraron que más del 38% de los datos en ellas estaban sesgados. La documentación de ChatGPT incluso advierte que su algoritmo puede asociar "estereotipos negativos con mujeres negras".

El sesgo de aprendizaje automático presenta varias implicaciones para los especialistas en marketing; el menor de los cuales es el bajo rendimiento de los anuncios. Si espera llegar a la mayor cantidad posible de clientes potenciales, una plataforma de orientación de anuncios que excluya a una gran parte de la población no es ideal.

Por supuesto, hay mayores ramificaciones si nuestros anuncios se dirigen injustamente a ciertos grupos o los excluyen. Si su anuncio de bienes raíces discrimina a las minorías protegidas, podría caer en el lado equivocado de la Ley de Vivienda Justa y la Comisión Federal de Comercio. Sin mencionar que se perdió por completo el bote del marketing inclusivo.

Cómo evitar el sesgo de la IA

Entonces, ¿qué hacemos cuando nuestras herramientas de IA se vuelven locas? Hay un par de pasos que puede seguir para asegurarse de que sus anuncios traten a todos de manera equitativa.

En primer lugar, asegúrese de que alguien revise su contenido, escribe Alaura Weaver, gerente sénior de contenido y comunidad de Writer. “Si bien la tecnología de IA ha avanzado significativamente, carece del pensamiento crítico y la capacidad de toma de decisiones que tienen los humanos”, explica. "Al hacer que los editores humanos revisen y verifiquen el contenido escrito por IA, pueden asegurarse de que esté libre de sesgos y siga los estándares éticos".

La supervisión humana también reducirá el riesgo de resultados negativos en las campañas publicitarias pagas.

“Actualmente, y quizás indefinidamente, no es aconsejable dejar que la IA se haga cargo por completo de las campañas o cualquier forma de marketing”, dice Brett McHale, fundador de Empiric Marketing. “La IA funciona de manera óptima cuando recibe información precisa de la inteligencia orgánica que ya ha acumulado grandes cantidades de datos y experiencias”.

Riesgo #2: Falacias fácticas

Google recientemente le costó a su empresa matriz $ 100 mil millones en valoración cuando su nuevo chatbot de IA, Bard, dio una respuesta incorrecta en un tweet promocional.

Bard es un servicio experimental de inteligencia artificial conversacional, impulsado por LaMDA. Creado utilizando nuestros modelos de lenguaje grande y basándose en información de la web, es una plataforma de lanzamiento para la curiosidad y puede ayudar a simplificar temas complejos → https://t.co/fSp531xKy3 pic.twitter.com/JecHXVmt8l

— Google (@Google) 6 de febrero de 2023

El error de Google destaca una de las mayores limitaciones de la IA y uno de los mayores riesgos para los especialistas en marketing que la usan: la IA no siempre dice la verdad.

IA alucina

Ethan Mollic, profesor de la Escuela de Negocios de Wharton, describió recientemente los sistemas impulsados por IA como ChatGPT como un "pasante omnisciente y ansioso por complacer que a veces miente".

Por supuesto, la IA no es consciente, a pesar de lo que algunos puedan afirmar. No pretende engañarnos. Sin embargo, puede sufrir "alucinaciones" que lo llevan a inventar cosas.

La IA es una máquina de predicción. Busca completar la siguiente palabra o frase que responderá a su consulta. Pero no es consciente de sí mismo; AI no tiene una lógica de verificación intuitiva para saber si lo que está uniendo tiene sentido.

A diferencia del sesgo, esto no parece ser un problema de datos. Incluso cuando la red tiene toda la información correcta, aún puede decirnos algo incorrecto.

Considere este ejemplo en el que un usuario le preguntó a ChatGPT "¿cuántas veces ganó Argentina la copa mundial de la FIFA?" Dijo una vez y se refirió a la victoria del equipo en 1978. El tuitero luego preguntó qué equipo ganó en 1986.

Se le preguntó a #ChatGPT sobre quién ganó la copa mundial de la FIFA en 2022. No pudo responder. Eso es de esperar. Sin embargo, parece proporcionar información incorrecta (sobre las otras 2 victorias) a pesar de que la información está en el sistema. ¿Alguna #Explicación? pic.twitter.com/fvxe05N12p

– indranil sinharoy (@indranil_leo) 29 de diciembre de 2022

El chatbot admitió que era Argentina sin explicar su error anterior.

La parte preocupante es que las respuestas erróneas de AI a menudo se escriben con tanta confianza que se mezclan con el texto que las rodea, lo que las hace parecer completamente plausibles. También pueden ser integrales, como se detalla en una demanda presentada contra Open.ai, donde ChatGPT supuestamente inventó una historia completa de malversación de fondos que luego compartió un periodista.

Cómo evitar las alucinaciones de la IA

Si bien la IA puede desviarlo incluso con respuestas de una sola palabra, es más probable que se descarrile al escribir textos más largos.

“A partir de un solo aviso, la IA puede generar un blog o un libro electrónico. Sí, eso es increíble, pero hay una trampa”, advierte Weaver. “Cuanto más genere, más edición y verificación tendrás que hacer”.

Para reducir las posibilidades de que su herramienta de IA comience a girar narrativas alucinantes, Weaver dice que es mejor crear un esquema y hacer que el bot lo aborde una sección a la vez. Y luego, por supuesto, haga que una persona revise los hechos y las estadísticas que agrega.

Riesgo #3: Aplicación incorrecta de herramientas de IA

Cada mañana nos despertamos con una nueva cosecha de herramientas de IA que aparentemente brotaron de la noche a la mañana como hongos después de una tormenta.

Pero no todas las plataformas están diseñadas para todas las funciones de marketing, y algunos desafíos de marketing no pueden (todavía) resolverse con IA.

Las herramientas de IA tienen limitaciones

ChatGPT es un gran ejemplo. Es divertido jugar con la belleza de la bola de IA (como escribir cómo quitar un sándwich de mantequilla de maní de una videograbadora al estilo de la Biblia King James). Y puede generar algunas respuestas breves sorprendentemente bien escritas que rompen el bloqueo del escritor. Pero no le pidas que te ayude a hacer una investigación de palabras clave.

ChatGPT falla debido a su conjunto de datos relativamente antiguo que solo incluye información anterior a 2022. Pídale que ofrezca palabras clave para "marketing de IA" y sus respuestas no coincidirán con lo que encuentre en otras herramientas como Thinword o Contextminds.

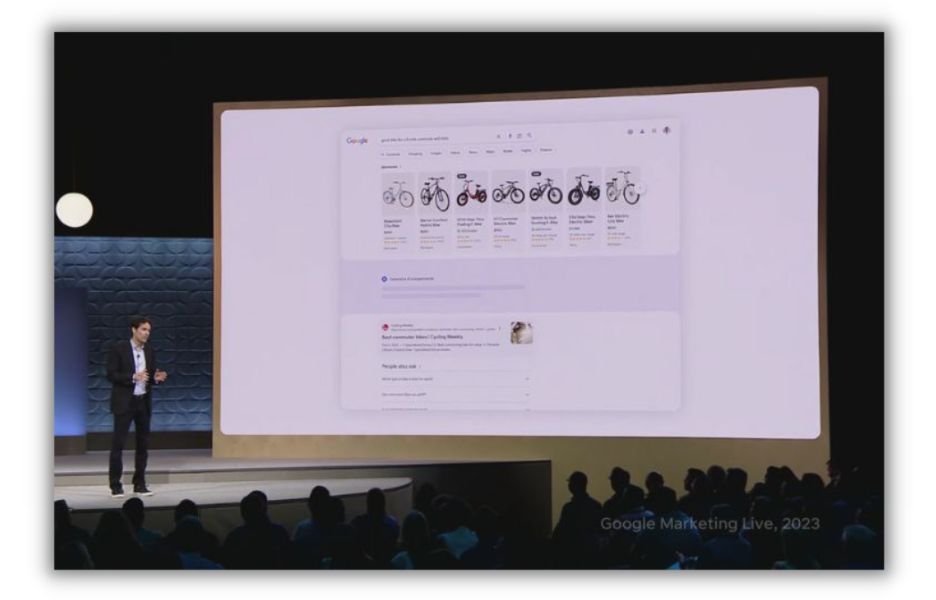

Del mismo modo, tanto Google como Facebook tienen nuevas herramientas impulsadas por IA para ayudar a los especialistas en marketing a crear anuncios, optimizar el gasto publicitario y personalizar la experiencia publicitaria. Un chatbot no puede resolver esos desafíos.

Google anunció una serie de actualizaciones de inteligencia artificial para sus productos de gestión de anuncios y búsqueda en el evento Google Marketing Live de 2023.

Puedes abusar de la IA

Si le da a una herramienta de IA una tarea singular, puede sobre indexar en un solo objetivo. Nick Abbene, un experto en automatización de marketing, ve esto a menudo con empresas enfocadas en mejorar su SEO.

“El mayor problema que veo es usar las herramientas de SEO a ciegas, optimizar en exceso para los motores de búsqueda e ignorar la intención de búsqueda del cliente”, dice Abbene. “Las herramientas de SEO son excelentes para señalar contenido de calidad a los motores de búsqueda. Pero, en última instancia, Google quiere coincidir con la pregunta del buscador".

Cómo evitar la mala aplicación de las herramientas de IA

Una llave inglesa no es la mejor opción para clavar clavos. Del mismo modo, un asistente de escritura de IA puede no ser bueno para crear páginas web. Antes de apostar por cualquier opción de IA, Abbene recomienda obtener comentarios del creador de la herramienta y de otros usuarios.

“Para evitar una mala selección de herramientas de IA, comprenda si otros especialistas en marketing están utilizando la herramienta para su caso de uso”, dice. "No dude en solicitar una demostración del producto o probarlo junto con otras herramientas que ofrecen la misma funcionalidad".

Los sitios web como Capterra le permiten comparar rápidamente múltiples plataformas de IA.

Y una vez que encuentre la pila de herramientas de IA adecuada, utilícela para ayudar en el proceso, no para tomar el control. “No tenga miedo de usar herramientas de IA para aumentar su flujo de trabajo, pero utilícelas solo para eso”, dice Abbene. “Comience cada pieza de contenido desde los primeros principios, con una investigación de palabras clave de calidad y comprendiendo la intención de búsqueda”.

Riesgo #4: contenido homogéneo

AI puede escribir un ensayo completo en unos 10 segundos. Pero a pesar de lo impresionante que se ha vuelto la IA generativa, carece de los matices para ser verdaderamente creativa, dejando su producción a menudo sintiéndose, bueno, robótica.

“Si bien la IA es excelente para producir contenido informativo, a menudo carece del estilo creativo y el compromiso que los humanos aportan”, dice Weaver.

La IA está hecha para imitar

Pídale a un robot de escritura de IA generativa que escriba el informe de su libro, y fácilmente generará 500 palabras que explicarán de manera competente el tema principal de Catcher in the Rye (suponiendo que no alucine a Holden Caulfield como un ladrón de bancos).

Puede hacerlo porque ha absorbido miles de textos sobre la obra maestra de JD Salinger.

Ahora pídale a su amigo de IA que escriba una publicación de blog que explique un concepto central para su negocio de una manera que encapsule su marca, audiencia y propuesta de valor. Puede que te decepciones. “El contenido generado por IA no siempre tiene en cuenta los matices de la personalidad y los valores de una marca y puede producir contenido que no da en el blanco”, dice Weaver.

En otras palabras, la IA es excelente para digerir, combinar y reconfigurar lo que ya se ha creado. No es bueno para crear algo que se destaque frente al contenido existente.

Las herramientas de IA generativa tampoco son buenas para hacer que el contenido sea atractivo. Felizmente producirán enormes bloques de palabras sin una imagen, gráfico o viñeta para dar un descanso a los ojos cansados. No extraerán historias de clientes o ejemplos hipotéticos para hacer un punto más identificable. Y tendrían dificultades para conectar una noticia de su industria con un beneficio que brinda su producto.

Cómo evitar el contenido homogéneo

Algunas herramientas de IA, como Writer, tienen características integradas para ayudar a los escritores a mantener una personalidad de marca consistente. Pero aún necesitará un editor para "revisar y editar el contenido de la voz y el tono de la marca para garantizar que resuene en la audiencia y refuerce el mensaje y los objetivos de la organización", aconseja Weaver.

Los editores y escritores también pueden ver un artículo como lo verán otros humanos. Si hay un bloque impenetrable de palabras, serán ellas las que lo rompan y agreguen un poco de zhuzh visual.

Utilice el contenido de IA como punto de partida, como una forma de ayudar a impulsar su creatividad e investigación. Pero siempre añade tu propio toque personal.

Riesgo #5: Pérdida de SEO

La postura de Google sobre el contenido de IA ha sido un poco turbia. Al principio, parecía que el motor de búsqueda penalizaría las publicaciones escritas con IA.

[Imagen: tuit de John Mueller sobre IA]

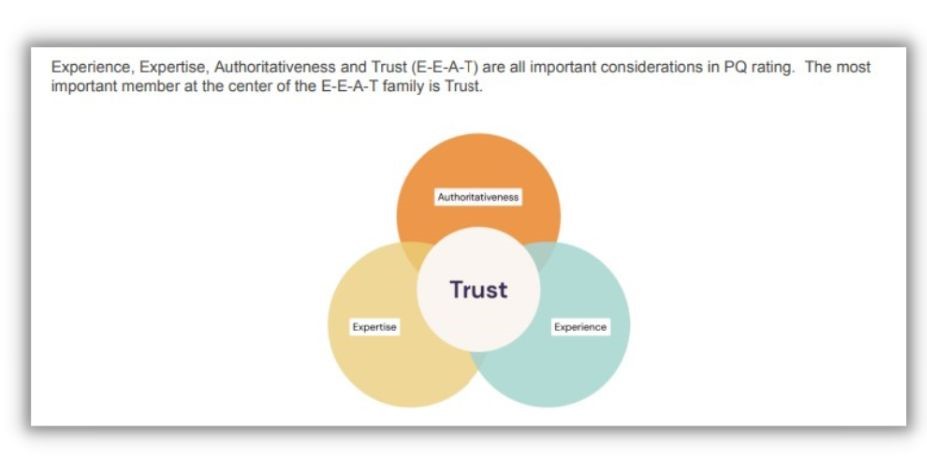

Más recientemente, el blog de desarrolladores de Google dijo que la IA está bien en su libro. Pero hay un guiño significativo con esa confirmación. Solo el "contenido que demuestre cualidades de lo que llamamos EEAT: pericia, experiencia, autoridad y confiabilidad" impresionará a los evaluadores de búsqueda humanos que evalúan continuamente los sistemas de clasificación de Google.

La confianza es fundamental para el SEO

Entre los EEAT de Google, el único factor que los gobierna a todos es la confianza.

[fuente]

Ya hemos discutido que el contenido de IA es propenso a las falacias, lo que lo hace inherentemente poco confiable sin supervisión humana. Tampoco cumple con los requisitos de respaldo porque, por naturaleza, no está escrito por alguien con conocimientos, autoridad o experiencia en el tema.

Tome una publicación de blog sobre cómo hornear pan de plátano. Un bot de IA te dará una receta en unos dos segundos. Pero no puede volverse poético sobre los fríos días de invierno que pasó horneando para su familia. O hable sobre los años que pasó experimentando con varios tipos de harina como panadero comercial. Esas perspectivas son lo que buscan los evaluadores de búsqueda de Google.

También parece ser lo que la gente anhela. Es por eso que muchos de ellos recurren a personas reales en los videos de TikTok para aprender cosas que solían encontrar en Google.

Cómo evitar perder el SEO

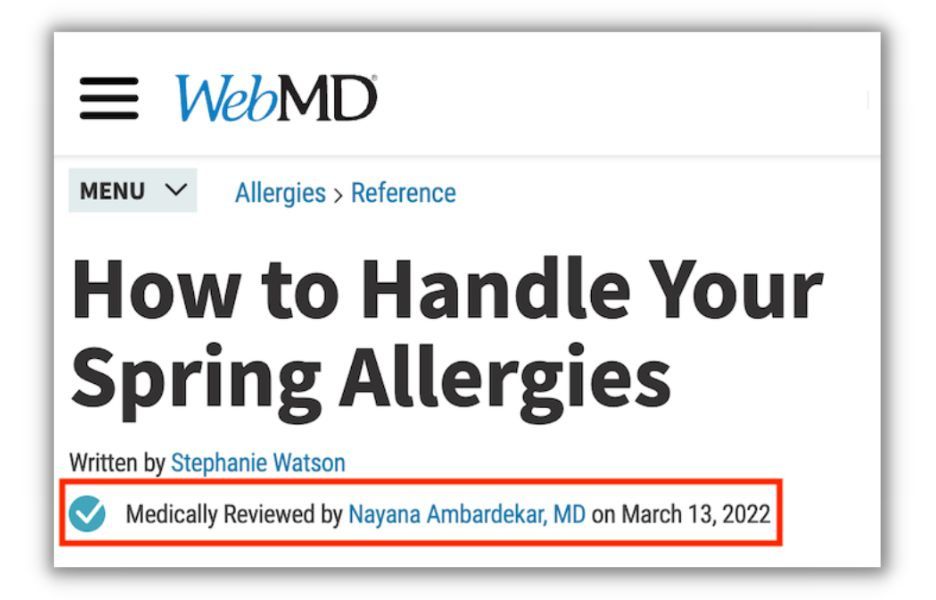

Lo mejor de la IA es que no le importa compartir firmas. Entonces, cuando use un chatbot para acelerar la producción de contenido, asegúrese de hacer referencia a un autor humano con credenciales.

Esto es especialmente cierto para temas delicados como la atención médica y las finanzas personales, que Google llama temas de Tu dinero, tu vida. “Si está en una vertical de YMYL, priorice la autoridad, la confianza y la precisión por encima de todo en su contenido”, aconseja Elisa Gabbert, directora de contenido y SEO de WordStream y LocaliQ.

Al escribir sobre atención médica, por ejemplo, haga que un profesional médico revise sus publicaciones y haga referencia a ellas en la publicación. Esa es una señal fuerte para Google de que su contenido es confiable, incluso si se inició en un chatbot.

Riesgo #6: Desafíos legales

La IA generativa aprende del trabajo creado por humanos, luego crea algo nuevo (más o menos). La cuestión de los derechos de autor no está clara tanto para la entrada como para la salida del modelo de contenido de IA.

El trabajo existente es probablemente un juego justo para la IA

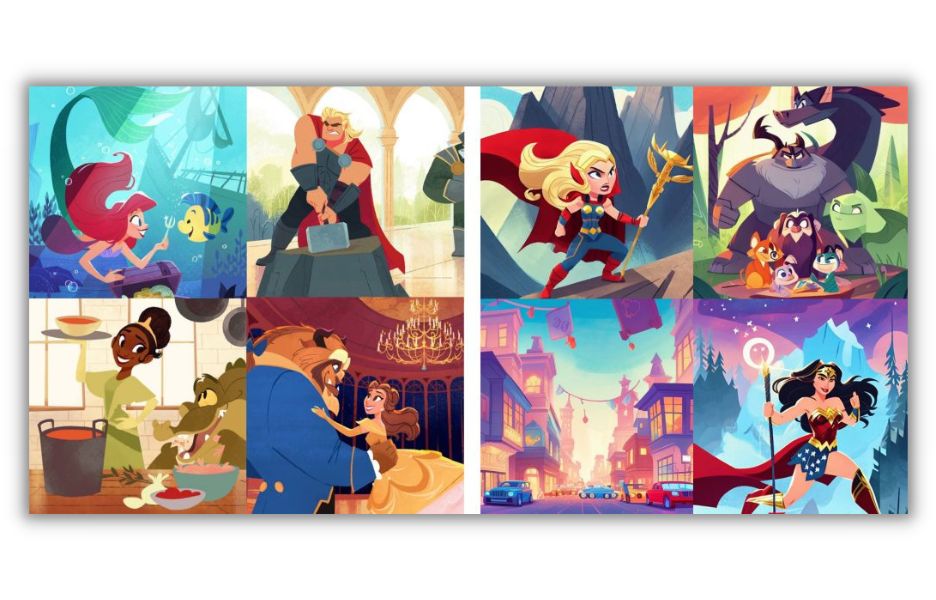

Para ilustrar (juego de palabras) la cuestión de los derechos de autor para trabajos que alimentan grandes modelos de aprendizaje, recurrimos a un caso informado por el tecnólogo Andy Baio. Como explica Baio, una artista con sede en Los Ángeles llamada Hollie Mengert se enteró de que 32 de sus ilustraciones habían sido absorbidas por un modelo de IA y luego ofrecidas a través de una licencia abierta a cualquier persona que quisiera recrear su estilo.

Leyenda: una colección de ilustraciones de la artista Hollie Mengert (izquierda) comparadas con ilustraciones generadas por IA basadas en su estilo, seleccionadas por Andy Baio .

La historia se vuelve más complicada cuando te enteras de que ella creó muchas de sus imágenes para clientes como Disney, que en realidad posee los derechos sobre ellas.

¿Pueden los ilustradores (o escritores o codificadores) que se encuentran en el mismo lugar que Mengert demandar con éxito por infracción de derechos de autor?

Todavía no hay una respuesta clara a la pregunta. “Veo personas en ambos lados de esto extremadamente confiadas en sus posiciones, pero la realidad es que nadie lo sabe”, dijo Baio a The Verge. “Y cualquiera que diga que sabe con confianza cómo se desarrollará esto en la corte está equivocado”.

Si la IA que usa para crear una imagen o un artículo se entrenó en miles de obras de muchos creadores, no es probable que pierda un caso judicial. Pero si alimentas la máquina con diez libros de Stephen King y le dices al bot que escriba uno nuevo en ese estilo, podrías tener problemas.

Descargo de responsabilidad: no somos abogados, así que obtenga asesoramiento legal si no está seguro.

Es posible que su contenido de IA tampoco esté protegido

¿Qué pasa con el contenido que crea usando un chatbot? ¿Está cubierto por las leyes de derechos de autor? En su mayor parte, no es a menos que haya hecho un trabajo considerable para editarlo. Lo que significa que tendría pocos recursos si alguien reutiliza (léase: roba) sus publicaciones para su propio blog.

Para el contenido que está protegido, puede ser el programador de la IA, no usted, el que tiene los derechos. Muchos países consideran que el fabricante de la herramienta que produjo un trabajo es su creador, no la persona que escribió el aviso.

Cómo evitar desafíos legales

Comience utilizando una herramienta de creación de contenido de IA de buena reputación. Encuentre uno con muchas críticas positivas producidas por una empresa que aborde claramente su postura sobre las leyes de derechos de autor.

Además, use su buen juicio para decidir si está copiando intencionalmente el trabajo de un creador o simplemente está usando IA para aumentar el suyo.

Y si quiere una oportunidad de pelear en la corte para proteger lo que produce, haga muchos cambios sustanciales. O use AI para ayudar a crear un esquema, pero escriba la mayoría de las palabras usted mismo.

Riesgo #7: Infracciones de seguridad y privacidad

Las herramientas de IA presentan a los especialistas en marketing una amplia gama de amenazas potenciales para la seguridad de sus sistemas y la privacidad de los datos. Algunos son ataques directos de actores malintencionados. Otros son simplemente usuarios que, sin darse cuenta, brindan información confidencial a un sistema diseñado para compartirla.

Riesgos de seguridad de las herramientas de IA

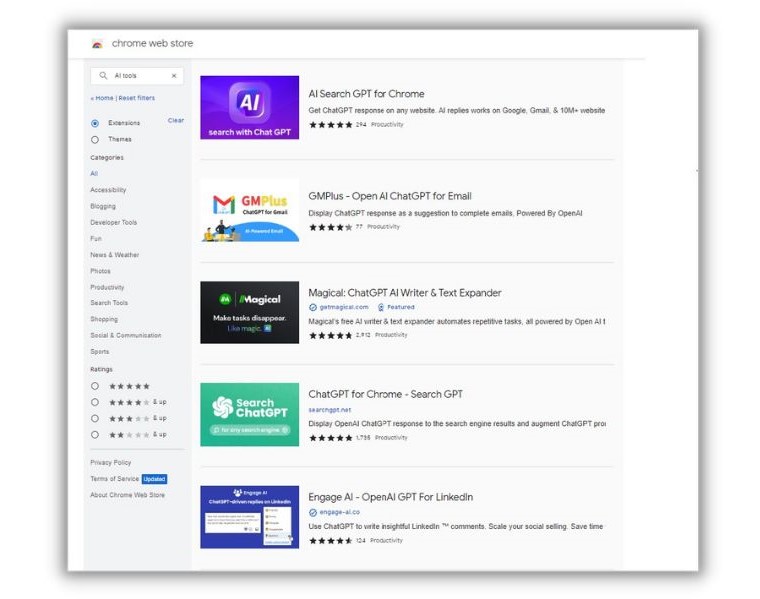

“Hay muchos productos que se ven, se sienten y se comportan como herramientas legítimas, pero en realidad son malware”, nos dijo Elaine Atwell, editora sénior de marketing de contenido del proveedor de seguridad de punto final Kolide. "Son extremadamente difíciles de diferenciar de las herramientas legítimas y puedes encontrarlas en la tienda de Chrome ahora mismo".

Escriba cualquier versión de "herramientas de IA" en la tienda de Google Chrome y no le faltarán opciones.

Atwell escribió sobre estos riesgos en el blog Kolide. En su artículo, hizo referencia a un incidente en el que una extensión de Chrome llamada "Acceso rápido a Chat GPT" era en realidad una artimaña. Una vez descargado, el software secuestró las cuentas de Facebook de los usuarios y robó todas las cookies de la víctima, incluso las de seguridad. Más de 2000 personas descargaron la extensión todos los días, informó Atwell.

Privacidad desprotegida

Atwell dice que incluso una herramienta de IA legítima puede presentar un riesgo de seguridad. “…en este momento, la mayoría de las empresas ni siquiera cuentan con políticas para evaluar los tipos y niveles de riesgo que plantean las diferentes extensiones. Y en ausencia de una guía clara, personas de todo el mundo están instalando estos pequeños ayudantes y brindándoles datos confidenciales”.

Supongamos que está escribiendo un informe financiero interno para compartirlo con los inversores. Recuerde que las redes de IA aprenden de lo que se les da para producir resultados para otros usuarios. Todos los datos que coloque en el chatbot de IA podrían ser un juego justo para personas ajenas a su empresa. Y puede aparecer si un competidor le pregunta sobre sus resultados.

Cómo evitar riesgos de privacidad y seguridad

La primera línea de defensa es asegurarse de que una pieza de software sea lo que dice ser. Más allá de eso, tenga cuidado con la forma en que utiliza las herramientas que elija. “Si va a utilizar herramientas de inteligencia artificial (¡y tienen usos!), no les proporcione ningún dato que pueda considerarse confidencial”, dice Atwell.

Además, mientras revisa las herramientas de IA en cuanto a su utilidad y sesgo, pregunte acerca de sus políticas de privacidad y seguridad.

Mitigar los riesgos de usar IA para marketing

La IA está avanzando a un ritmo increíble. En menos de un año, Chat GTP ya ha visto aumentos significativos en sus capacidades. Es imposible saber qué podremos hacer con la IA incluso en los próximos seis a doce meses. Tampoco podemos anticipar los problemas potenciales.

Aquí hay varias formas en que puede mejorar sus resultados de marketing de IA mientras evita algunos de los riesgos más comunes:

- Haga que los editores humanos revisen el contenido en busca de calidad, legibilidad y voz de la marca

- Examine cada herramienta que utiliza para la seguridad y la capacidad

- Revise regularmente la orientación de anuncios dirigidos por IA para detectar sesgos

- Evaluar la copia y las imágenes para detectar posibles infracciones de derechos de autor

Nos gustaría agradecer a Elain Attwell, Brett McHale, Nick Abenne y Alaura Weaver por contribuir con esta publicación.

Para recapitular, revisemos nuestra lista de riesgos que conlleva el uso de IA para marketing:

- Sesgo de aprendizaje automático

- Falacias fácticas

- Aplicación incorrecta de herramientas de IA

- Contenido homogéneo

- Pérdida de SEO

- Desafíos legales

- Violaciones de seguridad y privacidad