IA en SEO: cómo afrontar los desafíos legales y garantizar el cumplimiento

Publicado: 2023-09-26La inteligencia artificial (IA) está preparada para convertirse en una herramienta vital para las marcas que buscan mejorar su presencia en línea.

Sin embargo, la integración de la IA en las estrategias de marketing genera inevitablemente consideraciones legales y nuevas regulaciones que las agencias deben navegar con cuidado.

En este artículo descubrirás:

- Cómo las empresas, las agencias de medios y SEO pueden minimizar los riesgos legales de implementar estrategias mejoradas con IA.

- Herramientas útiles para reducir el sesgo de la IA y un proceso útil para revisar la calidad del contenido generado por la IA.

- Cómo las agencias pueden afrontar los principales desafíos de la implementación de la IA para garantizar la eficiencia y el cumplimiento de sus clientes.

Consideraciones de cumplimiento legal

Propiedad intelectual y derechos de autor

Una preocupación legal crucial al utilizar la IA en SEO y en los medios es el cumplimiento de las leyes de propiedad intelectual y derechos de autor.

Los sistemas de inteligencia artificial a menudo recopilan y analizan grandes cantidades de datos, incluido material protegido por derechos de autor.

Ya existen múltiples demandas contra OpenAI por violaciones de derechos de autor y privacidad.

La empresa enfrenta demandas por el uso no autorizado de libros con derechos de autor para entrenar ChatGPT y la recopilación ilegal de información personal de usuarios de Internet utilizando sus modelos de aprendizaje automático.

Las preocupaciones sobre la privacidad en el procesamiento y almacenamiento de datos de los usuarios por parte de OpenAI también hicieron que Italia bloqueara por completo el uso de ChatGPT a finales de marzo.

La prohibición ahora se levantó después de que la compañía realizó cambios para aumentar la transparencia en el procesamiento de datos de los usuarios del chatbot y agregar una opción para optar por no participar en las conversaciones de ChatGPT utilizadas para los algoritmos de entrenamiento.

Sin embargo, con el lanzamiento de GPTBot, el rastreador de OpenAI, es probable que surjan más consideraciones legales.

Para evitar posibles problemas legales y reclamaciones por infracción, las agencias deben asegurarse de que todos los modelos de IA estén entrenados en fuentes de datos autorizadas y respeten las restricciones de derechos de autor:

- Asegúrese de que los datos se hayan obtenido legalmente y que la agencia tenga los derechos adecuados para utilizarlos.

- Filtra los datos que no tengan los permisos legales requeridos o sean de mala calidad.

- Realice auditorías periódicas de los datos y los modelos de IA para garantizar que cumplan con las leyes y los derechos de uso de datos.

- Realice una consulta legal sobre derechos de datos y privacidad para garantizar que nada entre en conflicto con las políticas legales.

Es probable que los equipos legales de la agencia y del cliente deban participar en las discusiones anteriores antes de que los modelos de IA puedan integrarse en los flujos de trabajo y proyectos.

Privacidad y protección de datos

Las tecnologías de inteligencia artificial dependen en gran medida de datos, que pueden incluir información personal confidencial.

La recopilación, el almacenamiento y el procesamiento de datos de los usuarios deben alinearse con las leyes de privacidad pertinentes, como el Reglamento General de Protección de Datos (GDPR) de la Unión Europea.

Además, la Ley de IA de la UE recientemente introducida también hace hincapié en abordar las preocupaciones sobre la privacidad de los datos asociadas con los sistemas de IA.

Esto no carece de mérito. Grandes corporaciones, como Samsung, han prohibido completamente la IA debido a la exposición de datos confidenciales cargados en ChatGPT.

Por lo tanto, si las agencias utilizan datos de clientes junto con tecnología de inteligencia artificial, deberían:

- Priorizar la transparencia en la recopilación de datos.

- Obtener el consentimiento del usuario.

- Implementar medidas de seguridad sólidas para salvaguardar la información confidencial.

En estos casos, las agencias pueden priorizar la transparencia en la recopilación de datos comunicando claramente a los usuarios qué datos se recopilarán, cómo se utilizarán y quién tendrá acceso a ellos.

Para obtener el consentimiento del usuario, asegúrese de que el consentimiento sea informado y se otorgue libremente a través de formularios de consentimiento claros y fáciles de entender que expliquen el propósito y los beneficios de la recopilación de datos.

Además, las sólidas medidas de seguridad incluyen:

- Cifrado de datos.

- Control de acceso.

- Anonimización de datos (cuando sea posible).

- Auditorías y actualizaciones periódicas.

Por ejemplo, las políticas de OpenAI se alinean con la necesidad de privacidad y protección de los datos y se centran en promover la transparencia, el consentimiento del usuario y la seguridad de los datos en las aplicaciones de IA.

Equidad y parcialidad

Los algoritmos de IA utilizados en SEO y en los medios tienen el potencial de perpetuar sesgos o discriminar a ciertos individuos o grupos sin darse cuenta.

Las agencias deben ser proactivas a la hora de identificar y mitigar el sesgo algorítmico. Esto es especialmente importante en virtud de la nueva Ley de IA de la UE, que prohíbe que los sistemas de IA afecten injustamente al comportamiento humano o muestren un comportamiento discriminatorio.

Para mitigar este riesgo, las agencias deben garantizar que se incluyan datos y perspectivas diversas en el diseño de los modelos de IA y monitorear continuamente los resultados para detectar posibles sesgos y discriminación.

Una forma de lograrlo es mediante el uso de herramientas que ayuden a reducir el sesgo, como AI Fairness 360, IBM Watson Studio y What-If Tool de Google.

Contenido falso o engañoso

Las herramientas de inteligencia artificial, incluido ChatGPT, pueden generar contenido sintético que puede ser inexacto, engañoso o falso.

Por ejemplo, la inteligencia artificial suele crear reseñas online falsas para promocionar determinados lugares o productos. Esto puede tener consecuencias negativas para las empresas que dependen del contenido generado por IA.

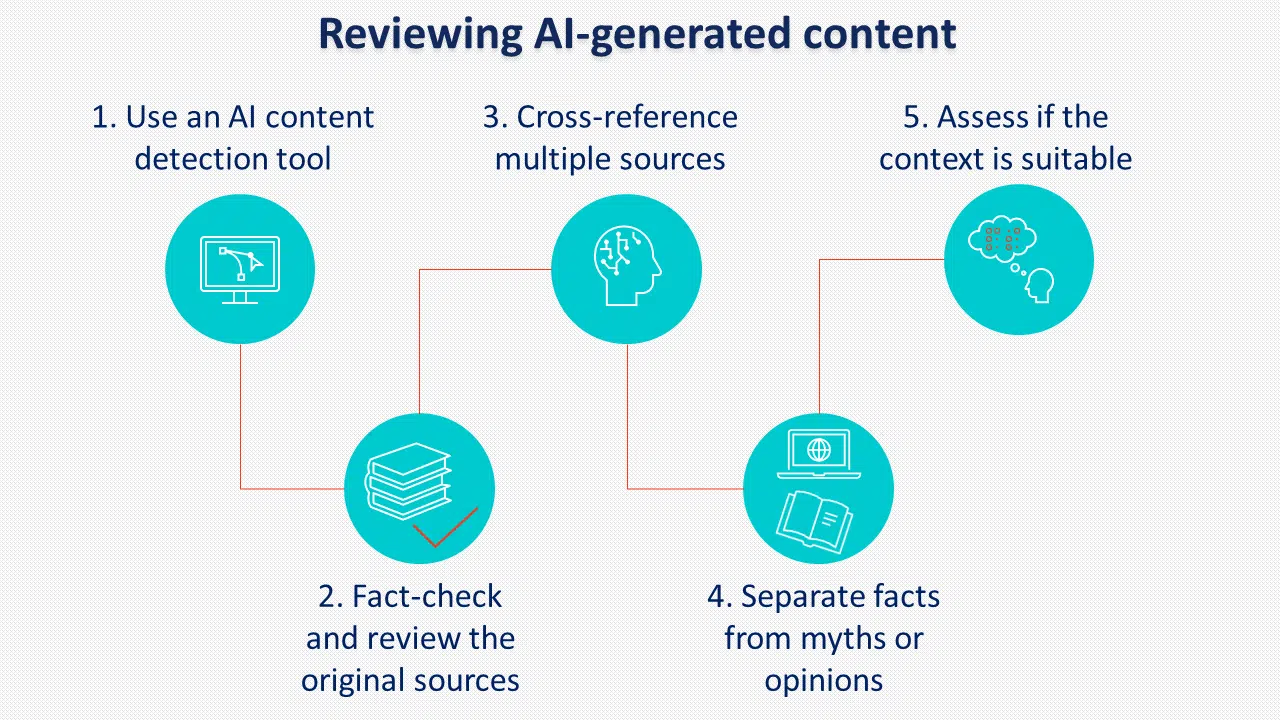

Implementar políticas y procedimientos claros para revisar el contenido generado por IA antes de su publicación es crucial para prevenir este riesgo.

Otra práctica a considerar es etiquetar el contenido generado por IA. Aunque Google parece no imponerlo, muchos formuladores de políticas apoyan el etiquetado de IA.

Responsabilidad y rendición de cuentas

A medida que los sistemas de IA se vuelven más complejos, surgen cuestiones de responsabilidad.

Las agencias que utilizan IA deben estar preparadas para asumir la responsabilidad de cualquier consecuencia no deseada que resulte de su uso, incluyendo:

- Sesgo y discriminación al utilizar la IA para seleccionar candidatos para su contratación.

- El potencial de abusar del poder de la IA con fines maliciosos como los ciberataques.

- La pérdida de privacidad si la información se recopila sin consentimiento.

La Ley de IA de la UE introduce nuevas disposiciones sobre sistemas de IA de alto riesgo que pueden afectar significativamente los derechos de los usuarios, destacando por qué las agencias y los clientes deben cumplir con los términos y políticas relevantes al utilizar tecnologías de IA.

Algunos de los términos y políticas más importantes de OpenAI se relacionan con el contenido proporcionado por el usuario, la precisión de las respuestas y el procesamiento de datos personales.

La política de contenido establece que OpenAI asigna los derechos del contenido generado al usuario. También especifica que el contenido generado se puede utilizar para cualquier fin, incluido el comercial, siempre que cumpla con las restricciones legales.

Sin embargo, también establece que los resultados pueden no ser completamente únicos ni precisos, lo que significa que el contenido generado por IA siempre debe revisarse minuciosamente antes de su uso.

En cuanto a los datos personales, OpenAI recopila toda la información que ingresan los usuarios, incluida la carga de archivos.

Al utilizar el servicio para procesar datos personales, los usuarios deberán proporcionar avisos de privacidad legalmente adecuados y completar un formulario para solicitar el procesamiento de datos.

Las agencias deben abordar de manera proactiva las cuestiones de rendición de cuentas, monitorear los resultados de la IA e implementar medidas sólidas de control de calidad para mitigar posibles responsabilidades legales.

Obtenga el boletín de noticias diario en el que confían los especialistas en marketing.

Ver términos.

Desafíos de la implementación de IA para las agencias

Desde que OpenAI lanzó ChatGPT el año pasado, ha habido muchas conversaciones sobre cómo la IA generativa cambiará el SEO como profesión y su impacto general en la industria de los medios.

Aunque los cambios vienen acompañados de una combinación de mejoras en la carga de trabajo diaria, existen algunos desafíos que las agencias deben considerar al implementar la IA en las estrategias de los clientes.

Educación y sensibilización

Es posible que muchos clientes carezcan de una comprensión integral de la IA y sus implicaciones.

Por lo tanto, las agencias enfrentan el desafío de educar a los clientes sobre los posibles beneficios y riesgos asociados con la implementación de la IA.

El panorama regulatorio en evolución requiere una comunicación clara con los clientes sobre las medidas tomadas para garantizar el cumplimiento legal.

Para lograr esto, las agencias deben:

- Tener una comprensión clara de los objetivos de sus clientes.

- Ser capaz de explicar los beneficios.

- Mostrar experiencia en la implementación de IA.

- Abordar los desafíos y riesgos.

Una forma de hacerlo es tener una hoja informativa para compartir con los clientes que contenga toda la información necesaria y, si es posible, proporcionar estudios de casos u otros ejemplos de cómo pueden beneficiarse del uso de la inteligencia artificial.

Asignación de recursos

La integración de la IA en el SEO y las estrategias de medios requiere importantes recursos, incluidas inversiones financieras, personal capacitado y actualizaciones de infraestructura.

Las agencias deben evaluar cuidadosamente las necesidades y capacidades de sus clientes para determinar la viabilidad de implementar soluciones de IA dentro de sus limitaciones presupuestarias, ya que pueden requerir especialistas en IA, analistas de datos, SEO y especialistas en contenido que puedan colaborar juntos de manera efectiva.

Las necesidades de infraestructura pueden incluir herramientas de inteligencia artificial, procesamiento de datos y plataformas de análisis para extraer información. La prestación de servicios o la facilitación de recursos externos depende de las capacidades y el presupuesto existentes de cada agencia.

La subcontratación de otras agencias podría conducir a una implementación más rápida, mientras que invertir en capacidades internas de IA podría ser mejor para el control y la personalización a largo plazo de los servicios ofrecidos.

Conocimientos técnicos

La implementación de la IA exige conocimientos y experiencia técnicos especializados.

Es posible que las agencias necesiten contratar o mejorar las habilidades de sus equipos para desarrollar, implementar y gestionar eficazmente sistemas de IA de acuerdo con los nuevos requisitos regulatorios.

Para aprovechar al máximo la IA, los miembros del equipo deben tener:

- Buenos conocimientos de programación.

- Habilidades analíticas y de procesamiento de datos para la gestión de grandes cantidades de datos.

- Conocimientos prácticos del aprendizaje automático.

- Excelentes habilidades para la resolución de problemas.

Consideraciones éticas

Las agencias deben considerar las implicaciones éticas del uso de la IA para sus clientes.

Deben establecerse marcos y directrices éticos para garantizar prácticas responsables de IA durante todo el proceso, abordando las preocupaciones planteadas en las regulaciones actualizadas.

Éstas incluyen:

- Transparencia, divulgación y responsabilidad cuando se utiliza la IA.

- Respetar la privacidad del usuario y la propiedad intelectual.

- Obtener el consentimiento del cliente para utilizar inteligencia artificial.

- Control humano sobre la IA con compromiso continuo para mejorar y adaptarse a las tecnologías de IA emergentes.

La rendición de cuentas importa: enfrentar los desafíos legales de la implementación de la IA

Si bien la IA presenta oportunidades interesantes para mejorar el SEO y las prácticas de medios, las agencias deben superar los desafíos legales y cumplir con las regulaciones actualizadas asociadas con su implementación.

Las empresas y agencias pueden minimizar los riesgos legales al:

- Garantizar que los datos se hayan obtenido legalmente y que la agencia tenga los derechos adecuados para utilizarlos.

- Filtrar datos que no tengan los permisos legales requeridos o sean de mala calidad.

- Realizar auditorías de datos y modelos de IA para garantizar que cumplan con las leyes y los derechos de uso de datos.

- Realizar una consulta legal sobre derechos de datos y privacidad para garantizar que nada entre en conflicto con las políticas legales.

- Priorizar la transparencia en la recopilación de datos y obtener el consentimiento del usuario mediante formularios de consentimiento claros y fáciles de entender.

- Usar herramientas que ayuden a reducir el sesgo, como AI Fairness 360, IBM Watson Studio y What-If Tool de Google.

- Implementar políticas y procedimientos claros para revisar la calidad del contenido generado por IA antes de su publicación.

Las opiniones expresadas en este artículo son las del autor invitado y no necesariamente las de Search Engine Land. Los autores del personal se enumeran aquí.