Más allá de las palabras clave: cómo las entidades impactan en las estrategias modernas de SEO

Publicado: 2023-07-06La transición del "motor de búsqueda 2.0" al "motor de búsqueda 3.0" ha traído cambios significativos, particularmente con la introducción de entidades.

Este artículo explora estos cambios, el impacto de las entidades en el SEO moderno y cómo adaptar sus estrategias para prosperar en esta nueva era.

Construyendo tu propia 'máquina teórica' de SEO

En mis primeros años de aprender a codificar, un maestro introdujo un concepto impactante conocido como "máquina nocional", que reformuló mi enfoque de la programación y, más tarde, el SEO.

En pocas palabras, es el modelo mental aproximado de un desarrollador de lo que sucede dentro de la computadora cuando hace clic en ejecutar.

Mi maestro enfatizó que cuanto más detallada y precisa fuera esta representación mental, mejor equipado estaría para abordar nuevos problemas.

¡Los programadores más exitosos fueron aquellos que habían desarrollado las máquinas teóricas más precisas y confiables!

Haciendo un paralelo con el SEO, cuando absorbemos nuevos conceptos, examinamos un estudio de caso u observamos el impacto de un cambio, estamos actualizando continuamente nuestro modelo mental (nuestra propia máquina nocional) de cómo funcionan los motores de búsqueda.

La diferencia entre los SEO expertos y los SEO no calificados es que pueden generar resultados porque pueden extraer soluciones de un modelo más preciso.

La investigación en el campo de especialización realizada por Anderson Ericsson proporciona evidencia sustancial para afirmar este punto.

Sus estudios sobre la experiencia revelan que aquellos que sobresalen en sus campos poseen modelos mentales superiores y más fácilmente accesibles.

Estos modelos les permiten comprender las intrincadas relaciones de causa y efecto, distinguir lo que realmente importa en un escenario complejo y percibir los procesos subyacentes que no son evidentes de inmediato.

Con la introducción de la entidad SEO, se modificaron varios componentes importantes dentro del motor de búsqueda de Google.

Parece que muchos profesionales de SEO todavía operan bajo las reglas del "motor de búsqueda 2.0", aunque el "motor de búsqueda 3.0" ahora sigue un conjunto de reglas ligeramente diferente.

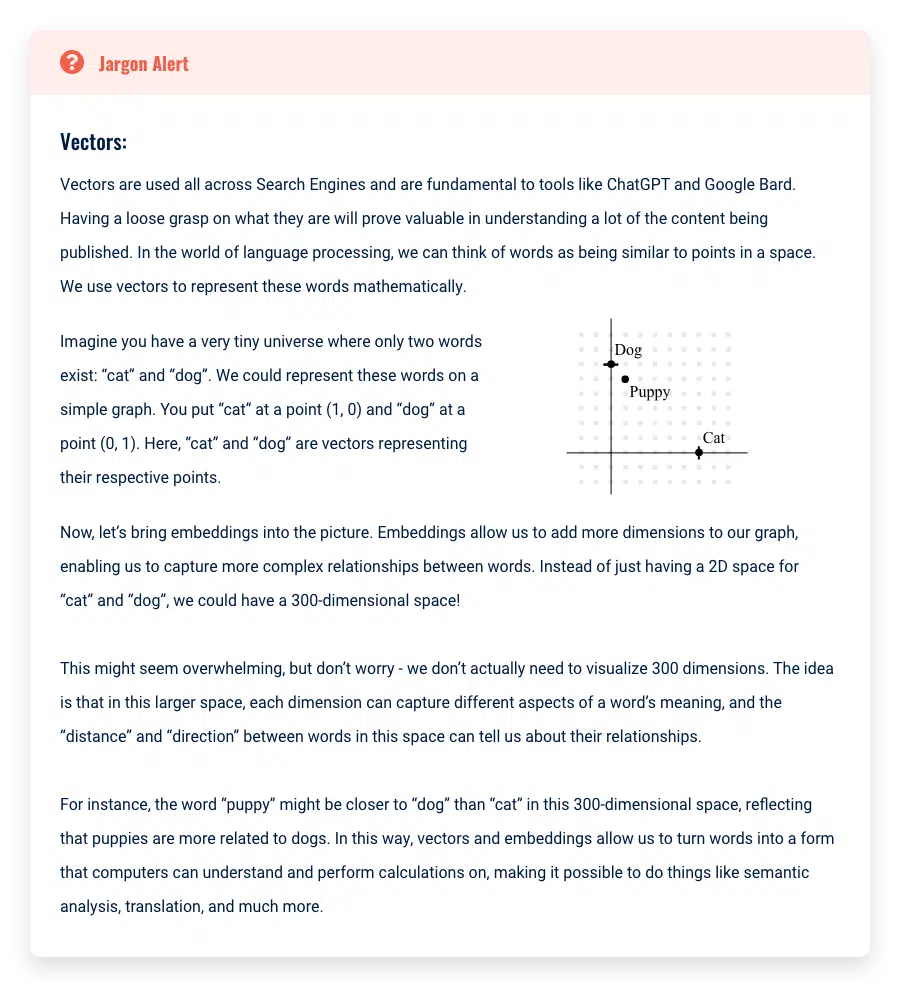

Entity SEO presenta vocabulario y conceptos que se originan en disciplinas de aprendizaje automático y recuperación de información.

Estos términos pueden parecer complejos porque no se han simplificado en sus significados principales. Una vez que los destilemos, encontrará que los conceptos no son demasiado complicados.

Mi objetivo es construir una máquina nocional simple pero efectiva de cómo los últimos motores de búsqueda usan entidades.

Más específicamente, quiero ilustrar cómo su comprensión del SEO debe actualizarse para reflejar esta nueva realidad.

Si bien comprender el "por qué" detrás de estos cambios puede parecer poco importante, muchos profesionales de SEO "hackean la matriz" de manera efectiva al usar su comprensión de cómo Google interpreta la web para su beneficio.

En los últimos tiempos, las personas han creado millones de sitios de visitantes y han transformado la comprensión de Google sobre el tema mediante la manipulación de estos conceptos.

Actualización: Cómo llegamos al motor de búsqueda 2.0

Antes de explorar las diferencias entre el "motor de búsqueda 2.0" y el "motor de búsqueda 3.0", repasemos los cambios principales de la versión inicial 1.0.

Al principio, los motores de búsqueda operaban con un modelo simple de "bolsa de palabras".

Este modelo trataba un documento como una mera colección de palabras, descuidando el significado contextual o la disposición de estas palabras.

Cuando un usuario realizaba una consulta, el motor de búsqueda se refería a una base de datos de índice invertido, una estructura de datos que asigna palabras a sus ubicaciones en un conjunto de documentos, y recuperaba los documentos con el mayor número de coincidencias.

Sin embargo, debido a su falta de comprensión del contexto y la semántica tanto de los documentos como de las consultas de los usuarios, este modelo a menudo no lograba brindar resultados de búsqueda relevantes y precisos.

Por ejemplo, si un usuario busca "jaguar" usando un modelo de "saco de palabras", el motor de búsqueda simplemente buscará documentos que contengan la palabra "jaguar" sin considerar el contexto.

Esto podría arrojar resultados sobre la marca de automóviles Jaguar, el animal jaguar o incluso el equipo de fútbol Jacksonville Jaguars, independientemente de la intención del usuario.

Con la llegada del “motor de búsqueda 2.0”, Google adoptó estrategias más sofisticadas. En lugar de solo hacer coincidir palabras, esta iteración tenía como objetivo descifrar la intención del usuario detrás de su consulta.

Por ejemplo, si un usuario buscaba "jaguar", el motor ahora podría considerar el historial de búsqueda y la ubicación del usuario para inferir el contexto probable.

Si el usuario había estado buscando modelos de automóviles o residía en un área donde los automóviles Jaguar eran populares, el motor podría priorizar los resultados sobre la marca del automóvil sobre el animal o el equipo de fútbol.

La introducción de resultados de búsqueda personalizados, teniendo en cuenta factores como el historial y la ubicación del usuario, mejoró significativamente la relevancia y precisión de los resultados de búsqueda. Esto marcó una evolución significativa del modelo básico de "bolsa de palabras" al "motor de búsqueda 2.0".

Buscador 2.0 vs 3.0

A medida que hicimos la transición del "motor de búsqueda 1.0" al "motor de búsqueda 2.0", tuvimos que actualizar nuestros modelos mentales y cambiar nuestras prácticas.

La calidad de los vínculos de retroceso se volvió crucial, lo que llevó a los profesionales de SEO a abandonar las herramientas de vínculos de retroceso automatizadas y buscar vínculos de retroceso de sitios web de mayor calidad, entre una serie de cambios clave.

En la era del "motor de búsqueda 3.0", está claro que el cambio mental para acomodar estos cambios aún está en progreso.

Persisten muchos conceptos de la era 2.0, en gran parte porque los profesionales necesitan tiempo para observar la correlación entre sus ajustes y los resultados posteriores.

Un número significativo de profesionales de SEO todavía tienen que adaptarse por completo a estos cambios sustanciales, o pueden haber intentado hacerlo pero no han dado en el blanco.

Para aclarar estas nuevas distinciones y brindar orientación sobre cómo modificar su enfoque, presentaré una comparación simplificada pero útil de "motor de búsqueda 2.0" y "motor de búsqueda 3.0".

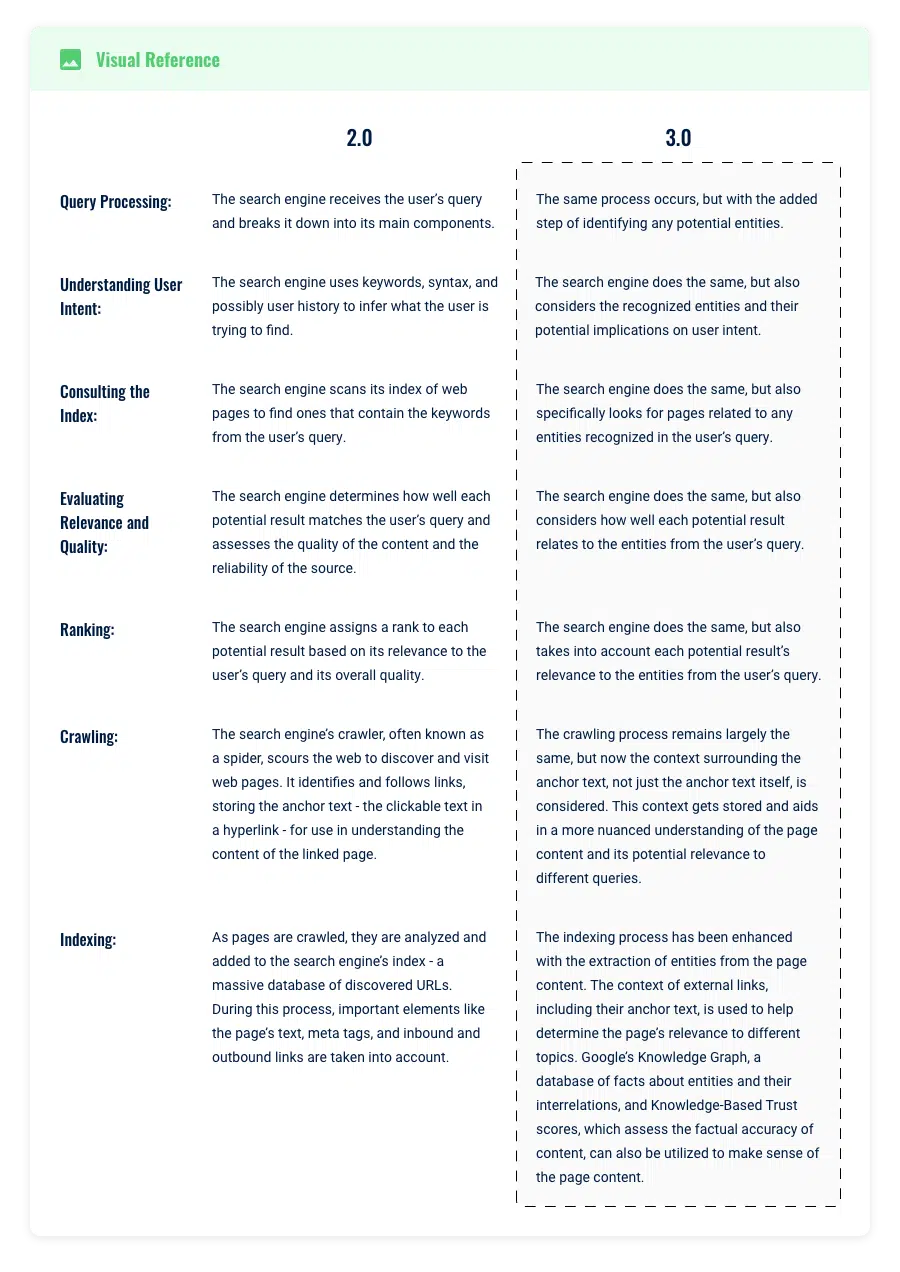

Procesamiento de consultas y recuperación de información

Imagine escribir la consulta de búsqueda "Elvis" en Google.

En la era del motor de búsqueda 2.0 de Google, la sofisticación de los algoritmos subyacentes permitía comprender la intención del usuario detrás de una consulta, más allá de la coincidencia de palabras clave.

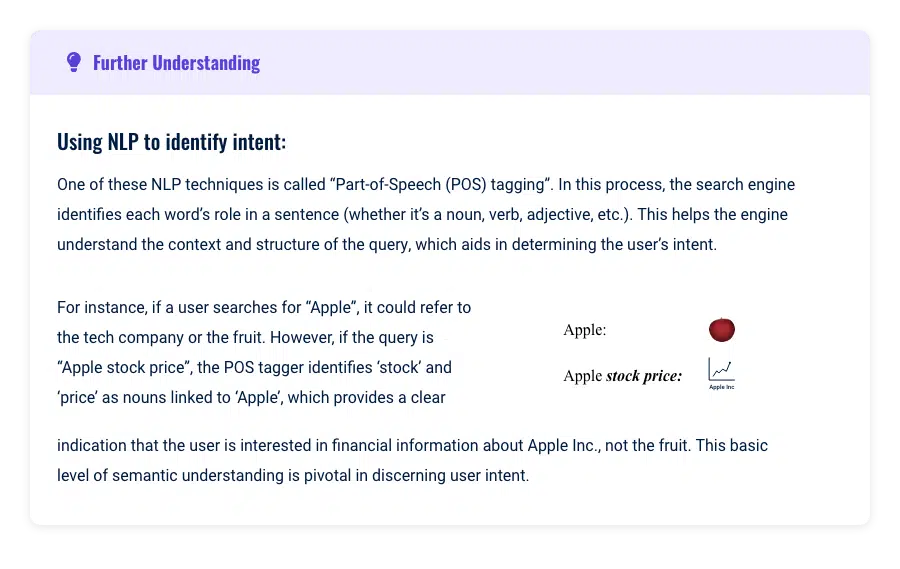

Por ejemplo, si un usuario busca "Elvis", el sistema usaría el procesamiento del lenguaje natural y el aprendizaje automático para comprender y anticipar la intención detrás de la consulta.

Buscaría "Elvis" en su índice y devolvería resultados que mencionaran la palabra "Elvis" o se basaran (casi completamente) en la relevancia de la copia en las páginas web y los parámetros de personalización, como el historial del usuario y la ubicación.

Sin embargo, este modelo aún tenía sus limitaciones, ya que dependía en gran medida de las palabras clave, el historial de búsqueda del usuario, la ubicación y las frases dentro del texto de las páginas web indexadas.

El contexto de "Elvis" podría significar Elvis Presley, Elvis Costello o incluso un restaurante local llamado "Elvis".

El desafío era que dependía en gran medida del usuario para especificar y refinar su consulta, y aún estaba limitado por la semántica de las palabras clave.

Mejoras en el procesamiento de consultas en 3.0

Mucha gente aún no se da cuenta de cuán fundamentalmente la introducción de entidades revolucionó la forma en que funcionaba la búsqueda.

Desde 2012, Hummingbird y RankBrain han allanado el camino para que las entidades asuman un papel más central.

En este modelo 3.0, las entidades se refieren a conceptos o cosas distintas y únicas, ya sean personas, lugares u objetos.

Usando nuestro ejemplo anterior, "Elvis" ya no es simplemente una palabra clave, sino que se reconoce como una entidad, probablemente refiriéndose al famoso músico Elvis Presley.

Por ejemplo, cuando se identifica una entidad como “Elvis Presley”, el motor de búsqueda ahora puede asociar una gran cantidad de atributos con esta entidad, incluidos aspectos como su música, su filmografía y sus fechas de nacimiento y muerte.

Este nuevo enfoque amplía significativamente el alcance de la búsqueda. Antes, una consulta de "Elvis" podía considerar principalmente alrededor de 2 000 000 de páginas que contenían la palabra clave exacta "Elvis".

Ahora, en este modelo centrado en entidades, el motor de búsqueda mira más allá de esto para considerar cualquier página relacionada con los atributos de Elvis.

Esto podría potencialmente ampliar el campo de búsqueda para incluir 10,000,000 de páginas, incluso si algunas de ellas no mencionan explícitamente a "Elvis".

Además, este modelo permite que el motor de búsqueda entienda que otras palabras clave relacionadas con los atributos de la entidad Elvis, como “Graceland” o “Blue Suede Shoes”, están implícitamente conectadas a “Elvis”.

Por lo tanto, la búsqueda de estos términos también podría mostrar información sobre Elvis, ampliando la red de posibles resultados de búsqueda.

Obtenga el boletín informativo diario en el que confían los especialistas en marketing.

Ver términos.

Procesamiento de consultas y límites de temas en el motor de búsqueda 3.0

Otro cambio significativo provocado por estas mejoras a las entidades en el procesamiento de consultas fue cómo Google percibe el alcance de los temas que deberían residir en una sola página.

En la era del "motor de búsqueda 2.0", era ventajoso crear una página separada para cada palabra clave identificada, de modo que la página pudiera optimizarse específicamente para ese término.

Sin embargo, en el "motor de búsqueda 3.0", los límites se han vuelto más fluidos y se actualizan en tiempo real en función de las predicciones de aprendizaje automático y el comportamiento observado del usuario.

En esta nueva era, los límites de un tema pueden ser amplios o estrechos, cubriendo una amplia gama de temas o centrándose intensamente en un aspecto particular. Esta flexibilidad permite que los sitios web se conviertan en autoridades tanto en áreas amplias como específicas.

Ejemplo

Considere el ejemplo de los crayones. Un sitio web podría tener como objetivo cubrir todo lo que hay que saber sobre los crayones en general: su historia, tipos, proceso de fabricación, consejos de uso, etc.

Este sitio web tiene como objetivo convertirse en una autoridad en el tema de los "crayones" en general.

Por otro lado, otro sitio web podría centrarse únicamente en los crayones rojos: sus pigmentos únicos, estadísticas de popularidad, importancia cultural, etc.

Este sitio está tratando de establecer su autoridad tópica en un contexto más limitado, pero aún válido. Sin embargo, es crucial que el enfoque en los 'crayones rojos' se alinee con el propósito general del sitio web.

Agregar microcontextos que no coincidan con el propósito más amplio de su sitio web podría confundir a Google sobre la relevancia y la autoridad de su sitio, lo que podría diluir su autoridad temática.

En teoría, un sitio web podría incluso profundizar en un microcontexto y centrar su contenido únicamente en torno a las "etiquetas utilizadas en los crayones rojos".

Este es un enfoque increíblemente específico, y uno podría preguntarse si Google lo reconocería como una autoridad de actualidad.

Los sitios web de redes sociales utilizan el aprendizaje automático para predecir las interacciones de los usuarios con elementos de contenido relacionados con un tema determinado.

Si un usuario interactúa con frecuencia con contenido sobre "etiquetas utilizadas en crayones rojos", el sistema podría identificar esto como un tema de interés para el usuario, y el sitio web que proporciona el contenido podría ser reconocido como una autoridad en este tema.

Se puede teorizar que Google puede hacer algo similar o al menos mantener las expectativas de qué tan bueno debería funcionar el contenido de acuerdo con las métricas de usuario que rastrean.

Para determinar esto, Google considera varios factores:

¿Hay una cantidad significativa de actividad de búsqueda en torno a este tema?

Si las personas buscan activamente información sobre las 'etiquetas utilizadas en los crayones rojos' y el sitio proporciona contenido completo y valioso sobre este tema, muy bien podría ser reconocido como una autoridad en este microcontexto.

¿Hay buenas métricas de usuario?

Si los usuarios pasan mucho tiempo en el sitio, tienen bajas tasas de rebote y demuestran otras señales de compromiso, Google puede interpretar esto como una señal de la autoridad del sitio en el tema.

Recuerde, la autoridad tópica es un concepto basado en la relatividad de diferentes sujetos (entidades). Su sitio puede considerarse una autoridad en temas tan amplios como "tecnología" o tan limitados como "máquinas de escribir antiguas".

El factor crucial es que su sitio muestre un comportamiento de usuario positivo y emplee entidades de manera efectiva para establecer relaciones dentro del contenido. Al hacerlo, Google comienza a confiar en su sitio para mejorar su propia comprensión del tema, independientemente del volumen de búsqueda general del tema.

Aplicaciones y conclusiones de SEO

El contenido más completo gana

En versiones anteriores, muchas páginas web se pasaban por alto para las consultas porque no contenían las palabras exactas incluidas en la búsqueda.

Por ejemplo, una página bien vinculada que no incorporó un término de búsqueda en particular no aparecería en los resultados, independientemente de sus otros factores de clasificación sólidos, como la participación del usuario y los vínculos de retroceso.

Esto alentó a los SEO a escribir menos piezas de contenido más enfocadas para lograr clasificaciones para una palabra clave objetivo.

Sin embargo, con la llegada de 3.0 y su enfoque en comprender las entidades y sus relaciones, el juego ha cambiado.

No se trata de si el término de búsqueda exacto aparece en la página. Google ahora buscará entidades relativas en su página e intentará vincular estas entidades a entidades relacionadas en todo su sitio.

Luego determinará la relatividad aproximada y lo clasificará en consecuencia. Este cambio fundamental trae páginas con fuertes factores de clasificación a la competencia, incluso si les faltan términos específicos.

La conclusión clave para los creadores de contenido y los estrategas de SEO es inclinarse hacia la creación de contenido más completo y expansivo.

Centralice sus esfuerzos de vínculo de retroceso en estas piezas amplias y detalladas en lugar de dividir los temas en varios artículos de enfoque limitado.

Utilice los SERP actuales como punto de partida para identificar temas importantes, pero no se limite a ellos.

Apunta a ir más allá de la cobertura tópica existente en SERPs y proporciona contenido valioso y completo al usuario.

Esto atenderá la consulta existente del usuario y las posibles consultas relacionadas que pueda tener, lo que en última instancia aumentará la relevancia y visibilidad de su contenido en esta nueva era de búsqueda.

Intención de respuesta en lugar de centrarse en el uso de palabras clave, tenga cuidado con los títulos

En la era del "motor de búsqueda 3.0", la estrategia de SEO ha evolucionado. Ya no es suficiente simplemente insertar palabras clave de su informe de Search Console en su contenido y esperar una mejor clasificación.

Los algoritmos avanzados de Google ahora pueden detectar cuando una palabra clave se usa fuera de contexto, lo que puede confundir al algoritmo y conducir potencialmente a clasificaciones más bajas.

El orden de los encabezados importa

Usa tu cerebro para conectar las ideas clave más relevantes para el objetivo de tu página. Asegúrese de que el contenido debajo del encabezado coincida con el tema del encabezado.

¿Recuerdas los días de lluvia de ideas para tus clases de escritura en la escuela primaria?

Dibujaríamos círculos, escribiríamos temas dentro de los círculos y luego los vincularíamos dibujando una línea recta a círculos más pequeños con temas relacionados con nuestra historia.

No compliques demasiado las cosas. Usa esta estrategia para formar tus encabezados también.

En resumen, el "motor de búsqueda 3.0" requiere un enfoque más reflexivo para el uso de palabras clave, abordando la intención del usuario y manteniendo el contexto para mejorar la relevancia y el potencial de clasificación.

Puntuación y clasificación de los documentos.

Una vez que un motor de búsqueda como Google ha obtenido documentos potencialmente relevantes, el siguiente paso crucial es calificar estas páginas y clasificarlas para que un usuario las seleccione.

La evolución de la inteligencia artificial (IA) y el procesamiento del lenguaje natural (NLP) ha transformado significativamente la forma en que se clasifican los documentos, marcando una clara distinción entre las eras 2.0 y 3.0.

Era 2.0 (posterior a la bolsa de palabras, anterior a RankBrain)

En la era 2.0, el sistema de puntuación de Google se basaba principalmente en algoritmos como PageRank, Hummingbird, Panda y Penguin.

Estos algoritmos dependían en gran medida de la coincidencia de palabras clave y la cantidad de vínculos de retroceso para clasificar los documentos. Cada documento obtendría una puntuación basada en las páginas y se ordenaría según el orden de clasificación.

Las evoluciones de algoritmos como Panda y Penguin tenían menos que ver con alejarse de la coincidencia de palabras clave y más con penalizar a los sitios que intentaban jugar con el sistema.

Los sistemas basados en palabras clave aún eran más eficientes y el hardware no era lo suficientemente avanzado para ofrecer resultados de búsqueda rápidos con métodos de lenguaje evolucionados.

Puntuación y clasificación en la era del motor de búsqueda 3.0

En el panorama del "motor de búsqueda 3.0", el enfoque de Google para puntuar y clasificar documentos ha evolucionado significativamente.

Este es el resultado de las mejoras de software y hardware. Google evalúa la idoneidad de una página para una consulta de búsqueda en función de varios factores clave.

La diferencia clave es una capacidad mejorada para cuantificar la relevancia, en lugar de depender de señales externas como backlinks para identificar las mejores piezas de contenido:

Precisión fáctica

El contenido fácticamente preciso de fuentes acreditadas sigue ocupando un lugar más alto. La Confianza basada en el conocimiento de Google lo confirma, afirmando:

"Llamamos al puntaje de confiabilidad que calculamos Confianza basada en el conocimiento (KBT)... La evaluación manual de un subconjunto de los resultados confirma la efectividad del método.

Señales de interacción del usuario

Las estrategias de "Publicar contenido de baja calidad ahora y editar más tarde" pueden ser problemáticas por estas razones. Google ahora considera los datos de participación del usuario tanto históricos como actuales asociados con una página web.

Este cambio se describe en la patente de Google titulada "Clasificación basada en la participación y la experiencia" (US20140244560A1), que enfatiza el uso de la puntuación de participación histórica como parte de sus consideraciones de clasificación.

Compromisos de calidad

Los compromisos, como los clics prolongados en los que un usuario permanece en su página durante un período de tiempo significativo, son beneficiosos.

Sin embargo, los compromisos que no son de calidad, como los retornos rápidos a los resultados de búsqueda (conocidos como "pogo-sticking"), pueden afectar negativamente su clasificación.

Estas métricas de compromiso pueden influir en su posición en el ranking y en las impresiones, lo que aumenta su autoridad temática.

Sin embargo, la participación deficiente del usuario puede provocar una caída en la clasificación de su página. La recuperación de tal caída puede llevar tiempo, lo que subraya la importancia de proporcionar constantemente contenido relevante y de alta calidad que fomente la participación positiva del usuario.

Conclusiones y aplicaciones de SEO

Comprobación de hechos

Google puede verificar la exactitud de los hechos. Invierta tiempo en la creación de contenido basado en hechos precisos.

Esto incluye la investigación adecuada, la verificación de hechos y la cita de fuentes acreditadas. Implemente un esquema de verificación de hechos para generar credibilidad y relevancia para sus artículos informativos.

Compromiso del usuario

Preste atención a las métricas de participación de los usuarios de su página. Si su contenido no atrae a los usuarios como se esperaba, considere revisar su estrategia de contenido.

Rastreo e indexación

A medida que finalizamos nuestra exploración del proceso de búsqueda, veamos cómo han evolucionado las técnicas de indexación y rastreo web de Google con su enfoque en las entidades.

Comprender estos cambios es crucial, ya que afectan directamente la forma en que debe estructurar su sitio web y formular su estrategia de contenido, incluida la construcción de su mapa temático.

En la era del "motor de búsqueda 2.0", los rastreadores web de Google, también conocidos como arañas, navegaban sistemáticamente por Internet para descubrir páginas nuevas y actualizadas.

Seguirían los enlaces de una página web a otra y recopilarían datos sobre cada página para almacenarlos en el índice de Google. Este proceso consistía principalmente en descubrir contenido nuevo y garantizar que el índice se mantuviera actualizado.

Una vez que los rastreadores descubrían una página, se agregaba al índice de Google, una base de datos masiva de todas las páginas web que Google había encontrado.

Se analizó el contenido de cada página (incluidos texto, imágenes y videos) y se clasificó la página en función de este contenido.

El enfoque principal estaba en las palabras clave y frases dentro del texto y factores como los vínculos de retroceso, que se utilizaron para determinar la relevancia y la autoridad de una página.

Avance rápido a la era del "motor de búsqueda 3.0", y las cosas se han vuelto más complejas.

Los rastreadores de Google siguen descubriendo páginas nuevas y actualizadas siguiendo enlaces en Internet. Pero ahora, también están tratando de comprender las entidades que representan las palabras clave en una página.

Por ejemplo, una página sobre "Elvis" también podría indexarse en entidades relacionadas como "música rock and roll", "Graceland" y "Blue Suede Shoes".

Además, están siguiendo sus enlaces internos para comprender qué entidades se relacionan en su sitio.

Esto es un poco como un bibliotecario que no solo cataloga libros en función de sus títulos, sino que también los lee para comprender cómo se relacionan los capítulos entre sí y con el tema general del libro.

Esta comprensión más profunda ayuda a Google a ofrecer resultados de búsqueda más relevantes y precisos.

Pero, ¿cómo se relaciona el rastreo con la autoridad y las entidades temáticas?

Bueno, cuando Google rastrea un sitio web, ya no solo mira las páginas individuales de forma aislada. También está mirando el tema general o tema del sitio web.

Aquí es donde entra la autoridad tópica.

Si un sitio web publica constantemente contenido de alta calidad sobre un tema específico, puede verse como una autoridad en ese tema.

Si Google considera que el sitio es una autoridad, puede impulsarlo en los resultados de búsqueda. (A menudo, verá sitios con perfiles de vínculo de retroceso pequeños que se clasifican en términos competitivos, probablemente debido a un aumento de la puntuación de autoridad temática que están obteniendo).

Curiosamente, el concepto de autoridad temática ha existido durante al menos algunos años, pero Google lo reconoció recientemente.

El 23 de mayo de 2023, Google publicó "Comprender la autoridad del tema de las noticias".

Aunque muchos SEO experimentados creían que la autoridad temática era un factor de clasificación, nadie podía verificar esto a través del contenido publicado en Google (aparte de investigar las patentes pendientes).

No se deje engañar por la palabra "noticias" en este comunicado. La autoridad del tema se relaciona con todos los sitios web que rastrea Google, no solo con los sitios de noticias.

Este concepto de autoridad temática se describe en la patente de Google US20180046717A1.

La patente describe un proceso para determinar la autoridad de un sitio web basado en la consistencia y profundidad de un tema específico dentro del sitio.

Por ejemplo, un sitio web que publique constantemente contenido de alta calidad sobre "jardinería orgánica" puede tener un factor de pureza alto (sí, Google analiza la capacidad de su sitio para mantenerse en el tema), lo que contribuye a una puntuación de autoridad más alta.

Además, Google puede extraer los temas principales de su contenido y graficar su contenido, al igual que ChatGPT grafica palabras en incrustaciones (un vector de características).

Esto le permite a Google ver si su contenido es similar y consistente, mejorando aún más su comprensión de la autoridad temática de su sitio web.

Entonces, en esencia, el cambio en el sistema de indexación de Google no se trata solo de comprender el contenido de las páginas individuales, sino también de reconocer el enfoque temático de un sitio web.

Esto subraya la importancia de mantener un enfoque constante en su estrategia de contenido, ya que puede afectar significativamente la visibilidad de su sitio web en los resultados de búsqueda.

Conclusiones y aplicaciones de SEO

Enfoque de tema consistente

Google puede identificar cuándo su sitio se desvía de su tema principal. Si su contenido es inconsistente, puede confundir el propósito y el objetivo de su sitio web.

Mantenga un enfoque constante en su estrategia de contenido para beneficiarse de los aumentos de puntuación asociados con la autoridad del tema.

profundidad del contenido

Construir profundidad en tu contenido es clave, pero debe ser una profundidad relevante. Use su comprensión del propósito principal de su sitio para guiar la profundidad de su contenido.

Por ejemplo, si el propósito principal de su sitio es proporcionar información sobre técnicas de fotografía digital, no se desvíe a escribir en profundidad sobre la historia de las cámaras de película.

Si bien está relacionado con la fotografía, no se alinea estrechamente con el enfoque principal de su sitio en las técnicas digitales. En cambio, profundice su contenido explorando varias técnicas de fotografía digital, revisando cámaras digitales o brindando consejos para editar fotografías digitales.

Demasiado contenido puede diluir tu autoridad

Demasiado contenido en su sitio web puede diluir el significado y el propósito de su sitio web.

Examine su mapa del sitio y asegúrese de que solo incluya contenido que respalde sus ideas clave y que el contenido sea de calidad suficiente para ayudar a Google a comprender las entidades.

Uso de puentes contextuales

Al crear contenido nuevo, es importante usar "puentes contextuales" para volver a conectarlo con el propósito principal de su sitio.

En lugar de simplemente agregar contenido nuevo a su sitio web, siempre pregúntese cómo puede vincular una nueva página con su objetivo principal.

Esto permitirá que Google comience a asociar las entidades de su nueva página con su entidad objetivo principal.

Limitaciones y restricciones de la autoridad tópica

Si bien queremos centrarnos en generar autoridad temática en cualquier sitio que creemos, todavía existen algunas limitaciones.

Estas limitaciones son factores de clasificación persistentes desde los días de la Web 2.0 a los que Google aún otorga una cantidad razonable de poder de clasificación: tiempo en la web y vínculos de retroceso.

En primer lugar, se necesita tiempo para construir la autoridad del tema. Con la reciente explosión de herramientas de creación de contenido de IA, esta línea de tiempo se puede acortar drásticamente, pero aún lleva tiempo.

El uso de la autoridad tópica también es relativo a qué tan "autorizados" son otros sitios en su nicho.

Por ejemplo, si crea contenido excelente basado en un mapa temático increíble, aún se lo comparará con otros sitios en su nicho.

Si estos otros sitios también han desarrollado una gran autoridad temática a lo largo del tiempo, entonces nos remitimos al antiguo problema de los vínculos de retroceso y el tiempo en la web.

Es extremadamente difícil superar a los sitios que han desarrollado un gran desarrollo de entidad y lo han hecho en un dominio que ha estado en la web durante varios años o más. Posible, seguro, pero difícil no obstante.

Hablemos de los vínculos de retroceso.

Si bien es bastante posible crear sitios que se clasifiquen bien sin el uso de vínculos de retroceso, incluso los SEO experimentados pueden tener dificultades para hacerlo.

Los backlinks siguen siendo un factor de clasificación muy importante. Claro, puede que no sean tan poderosos como antes, pero siguen siendo poderosos.

El problema de otorgar una cantidad tan grande de poder de clasificación a los vínculos de retroceso proviene de los grandes conglomerados de sitios de noticias que en realidad no se "especializan" en ningún tema.

Todos lo hemos visto: buscamos en Google "mejor widget para xyz" y los primeros 10-15 resultados son sitios de redes de noticias que afirman tener las mejores guías para comprar estos widgets.

¿Los sitios de noticias se especializan en el desarrollo o venta de estos widgets?

¿Estos sitios de noticias tienen autoridad en el tema cuando se trata de estos widgets?

De nada.

Si los sitios de noticias no tienen autoridad sobre estos widgets, ¿por qué siguen dominando las SERP? Todo se reduce al tiempo en la web y a los perfiles de backlinks.

Dado que los editores de estas grandes redes de noticias saben que obtendrán una clasificación extremadamente alta una vez que hagan clic en el botón de publicación, solicitan la venta de espacios publicitarios en sus sitios.

Las empresas también saben que su producto llegará a la cima de las SERP de Google, por lo que están dispuestas a pagar miles y miles de dólares por esta función.

En esencia, se están aprovechando de la capacidad del sitio de noticias para dominar las SERP cada vez que publican algo, de ahí el nombre de parásito SEO.

Independientemente de la autoridad temática de su sitio, tendrá dificultades para competir con estas potencias de sitios de noticias.

Desafortunadamente, hasta que Google aborde este problema, convertirse en una autoridad en el tema no es suficiente para competir con algunos de estos SERP populares que dominan los sitios de noticias.

Dominar el SEO en la era de las entidades

Con suerte, al guiarlo a través del viaje desde el procesamiento de consultas hasta la indexación y clasificación, lo he ayudado a actualizar su "máquina teórica" para tener mejor cuenta de los cambios más recientes en el motor de búsqueda de Google.

Esta comprensión refinada debería ayudarlo a mejorar sus tácticas, donde enfoca su tiempo y las clasificaciones de su propio sitio web y las de sus clientes.

Por último, es crucial recordar que la teoría realmente brilla cuando se aplica en la práctica.

Por ejemplo, los practicantes de SEO de afiliados descubrieron hace bastante tiempo que producir una cantidad sustancial de contenido sobre su tema podría desencadenar un impulso de SEO de autoridad tópica.

Esto se dio cuenta mucho antes de que entrara en juego la evolución de nuestra comprensión del SEO de entidades.

El viaje del SEO siempre está evolucionando, lleno de oportunidades de descubrimiento y mejora.

Entonces, armado con este conocimiento y perspectivas, es hora de que te sumerjas, experimentes y des forma a tus propias estrategias de SEO. Después de todo, la prueba del budín está en comerlo. ¡Feliz prueba!

Este artículo fue coescrito por Paul DeMott .

Este es el tercer artículo de la serie SEO de entidades. Si desea comenzar leyendo los dos primeros artículos, están vinculados aquí:

- La guía definitiva para el SEO de entidades

- Cómo optimizar para entidades

- 3 formas de usar IA para la optimización de entidades en todo el sitio

Las opiniones expresadas en este artículo pertenecen al autor invitado y no necesariamente a Search Engine Land. Los autores del personal se enumeran aquí.