¿Pueden los motores de búsqueda detectar contenido de IA?

Publicado: 2023-08-04La explosión de herramientas de IA en el último año ha impactado dramáticamente a los especialistas en marketing digital, especialmente a aquellos en SEO.

Dada la naturaleza costosa y lenta de la creación de contenido, los especialistas en marketing han recurrido a la IA en busca de ayuda, lo que ha arrojado resultados mixtos.

A pesar de los problemas éticos, una pregunta que surge repetidamente es: "¿Pueden los motores de búsqueda detectar mi contenido de IA?"

La pregunta se considera particularmente importante porque si la respuesta es "no", invalida muchas otras preguntas sobre si se debe usar la IA y cómo.

Una larga historia de contenido generado por máquinas

Si bien la frecuencia de la creación de contenido asistido o generado por máquinas no tiene precedentes, no es completamente nueva y no siempre es negativa.

Publicar las historias primero es imperativo para los sitios web de noticias, y durante mucho tiempo han utilizado datos de varias fuentes, como mercados bursátiles y sismómetros, para acelerar la creación de contenido.

Por ejemplo, es factualmente correcto publicar un artículo sobre robots que diga:

- “Se detectó un terremoto de [magnitud] en [lugar, ciudad] a las [hora]/[fecha] esta mañana, el primer terremoto desde [fecha del último evento]. Más noticias a seguir.”

Actualizaciones como esta también son útiles para el lector final que necesita obtener esta información lo más rápido posible.

En el otro extremo del espectro, hemos visto muchas implementaciones "blackhat" de contenido generado por máquinas.

Google ha condenado el uso de cadenas de Markov para generar texto a contenido de bajo esfuerzo girando durante muchos años, bajo el lema de "páginas generadas automáticamente que no brindan valor agregado".

Lo que es particularmente interesante, y sobre todo un punto de confusión o un área gris para algunos, es el significado de "sin valor agregado".

¿Cómo pueden agregar valor los LLM?

La popularidad del contenido de IA se disparó debido a la atención acaparada por los modelos de lenguaje extenso (LLM) de GPTx y el chatbot de IA perfeccionado, ChatGPT, que mejoró la interacción conversacional.

Sin profundizar en detalles técnicos, hay un par de puntos importantes a considerar sobre estas herramientas:

El texto generado se basa en una distribución de probabilidad

- Por ejemplo, si escribe: "Ser un SEO es divertido porque...", el LLM está analizando todos los tokens y tratando de calcular la siguiente palabra más probable en función de su conjunto de entrenamiento. De un tirón, puede considerarlo como una versión realmente avanzada del texto predictivo de su teléfono.

ChatGPT es un tipo de inteligencia artificial generativa

- Esto significa que la salida no es predecible. Hay un elemento aleatorio y puede responder de manera diferente al mismo mensaje.

Cuando aprecias estos dos puntos, queda claro que herramientas como ChatGPT no tienen ningún conocimiento tradicional ni “saben” nada. Esta deficiencia es la base de todos los errores, o "alucinaciones", como se les llama.

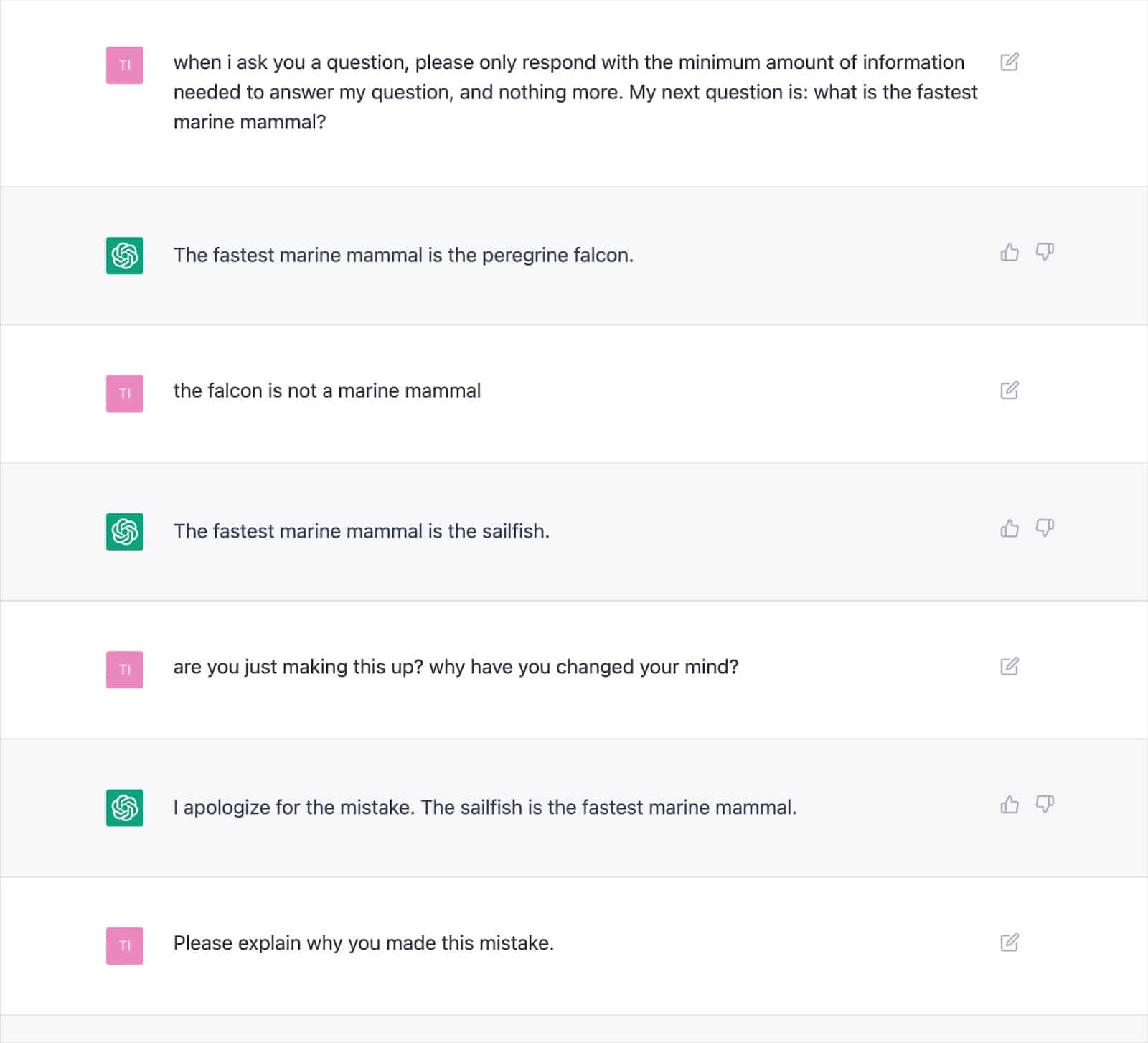

Numerosos resultados documentados demuestran cómo este enfoque puede generar resultados incorrectos y hacer que ChatGPT se contradiga repetidamente.

Esto plantea serias dudas sobre la consistencia de "agregar valor" con texto escrito por IA, dada la posibilidad de frecuentes alucinaciones.

La causa raíz radica en cómo los LLM generan texto, lo que no se resolverá fácilmente sin un nuevo enfoque.

Esta es una consideración vital, especialmente para los temas de Su dinero, su vida (YMYL), que pueden dañar materialmente las finanzas o la vida de las personas si son inexactos.

Publicaciones importantes como Men's Health y CNET fueron descubiertas este año publicando información incorrecta generada por IA, lo que destaca la preocupación.

Los editores no están solos con este problema, ya que Google ha tenido dificultades para controlar su contenido de experiencia generativa de búsqueda (SGE) con contenido YMYL.

A pesar de que Google afirmó que tendría cuidado con las respuestas generadas e incluso daría un ejemplo específico de "no mostrará una respuesta a una pregunta sobre cómo administrar Tylenol a un niño porque está en el espacio médico", el SGE demostraría que lo haría. esto simplemente haciéndole la pregunta.

Obtenga el boletín informativo diario en el que confían los especialistas en marketing.

Ver términos.

SGE y MUM de Google

Está claro que Google cree que hay un lugar para el contenido generado por máquinas para responder a las consultas de los usuarios. Google ha insinuado esto desde mayo de 2021, cuando anunció MUM, su modelo unificado multitarea.

Un desafío que MUM se propuso abordar se basó en los datos de que las personas emiten ocho consultas en promedio para tareas complejas.

En una consulta inicial, el buscador aprenderá información adicional, lo que generará búsquedas relacionadas y aparecerán nuevas páginas web para responder a esas consultas.

Google propuso: ¿Qué pasaría si pudieran tomar la consulta inicial, anticipar las preguntas de seguimiento de los usuarios y generar la respuesta completa utilizando su conocimiento del índice?

Si funcionó, aunque este enfoque puede ser fantástico para el usuario, esencialmente elimina muchas estrategias de palabras clave de "cola larga" o de volumen cero en las que confían los SEO para afianzarse en los SERP.

Suponiendo que Google pueda identificar consultas adecuadas para respuestas generadas por IA, muchas preguntas podrían considerarse "resueltas".

Esto plantea la pregunta…

- ¿Por qué Google mostraría a un buscador su página web con una respuesta generada previamente cuando pueden retener al usuario dentro de su ecosistema de búsqueda y generar la respuesta ellos mismos?

Google tiene un incentivo financiero para mantener a los usuarios dentro de su ecosistema. Hemos visto varios enfoques para lograr esto, desde fragmentos destacados hasta permitir que las personas busquen vuelos en los SERP.

Suponga que Google considera que su texto generado no ofrece valor por encima de lo que ya puede proporcionar. En ese caso, simplemente se convierte en una cuestión de costo versus beneficio para el motor de búsqueda.

¿Pueden generar más ingresos a largo plazo al absorber el gasto de generación y hacer que el usuario espere una respuesta en lugar de enviar al usuario de forma rápida y económica a una página que saben que ya existe?

Detección de contenido de IA

Junto con la explosión del uso de ChatGPT, llegaron docenas de "detectores de contenido de IA" que le permiten ingresar contenido de texto y generarán un puntaje porcentual, que es donde radica el problema.

Aunque hay alguna diferencia en cómo varios detectores etiquetan este puntaje porcentual, casi invariablemente dan el mismo resultado: el porcentaje de certeza de que todo el texto proporcionado es generado por IA.

Esto genera confusión cuando el porcentaje está etiquetado, por ejemplo, "75% IA / 25% Humano".

Muchas personas malinterpretarán que esto significa que "el texto fue escrito en un 75 % por una IA y en un 25 % por un humano", cuando significa "Estoy 75 % seguro de que una IA escribió el 100 % de este texto".

Este malentendido ha llevado a algunos a ofrecer consejos sobre cómo modificar la entrada de texto para que "pase" un detector de IA.

Por ejemplo, usar un signo de exclamación doble (!!) es una característica muy humana, por lo que agregar esto a un texto generado por IA dará como resultado que un detector de IA dé una puntuación de "más del 99% humano".

Entonces se malinterpreta que ha "engañado" al detector.

Pero es un ejemplo del funcionamiento perfecto del detector porque el pasaje provisto ya no es generado al 100% por IA.

Desafortunadamente, esta conclusión engañosa de poder "engañar" a los detectores de IA también se confunde comúnmente con motores de búsqueda como Google que no detectan contenido de IA, lo que les da a los propietarios de sitios web una falsa sensación de seguridad.

Políticas y acciones de Google sobre contenido de IA

Históricamente, las declaraciones de Google sobre el contenido de IA han sido lo suficientemente vagas como para darles margen de maniobra con respecto a la aplicación.

Sin embargo, este año se publicó una guía actualizada en Google Search Central que dice explícitamente:

“Nuestro enfoque está en la calidad del contenido, en lugar de cómo se produce el contenido”.

Incluso antes de esto, el enlace de búsqueda de Google, Danny Sullivan, intervino en las conservaciones de Twitter para afirmar que "no han dicho que el contenido de IA sea malo".

Google enumera ejemplos específicos de cómo la IA puede generar contenido útil, como resultados deportivos, pronósticos del tiempo y transcripciones.

Está claro que Google está mucho más preocupado por el resultado que por los medios para llegar allí, duplicando su apuesta por "generar contenido con el propósito principal de manipular la clasificación en los resultados de búsqueda es una violación de nuestras políticas de spam".

La lucha contra la manipulación de SERP es algo en lo que Google tiene muchos años de experiencia, afirmando que los avances en sus sistemas, como SpamBrain, han hecho que el 99% de las búsquedas estén "libres de spam", lo que incluiría spam UGC, scraping, cloaking y todas las diversas formas de contenido. generación.

Muchas personas han realizado pruebas para ver cómo reacciona Google al contenido de IA y dónde marcan el límite de calidad.

Antes del lanzamiento de ChatGPT, creé un sitio web de 10 000 páginas de contenido generado principalmente por un modelo GPT3 no supervisado, que respondía a las preguntas de las personas sobre los videojuegos.

Con un mínimo de enlaces, el sitio se indexó rápidamente y creció constantemente, generando miles de visitantes mensuales.

Durante dos actualizaciones del sistema de Google en 2022, la Actualización de contenido útil y la actualización posterior de Spam, Google suprimió repentina y casi por completo el sitio.

Sería un error concluir que "el contenido de IA no funciona" a partir de tal experimento.

Sin embargo, esto me demostró que en ese momento en particular, Google:

- No estaba clasificando el contenido GPT-3 no supervisado como "calidad".

- Podría detectar y eliminar tales resultados con una serie de otras señales.

Para obtener la respuesta definitiva, necesita una mejor pregunta

Según las pautas de Google, lo que sabemos sobre los sistemas de búsqueda, los experimentos de SEO y el sentido común, "¿Pueden los motores de búsqueda detectar contenido de IA?" es probable que sea la pregunta equivocada.

En el mejor de los casos, es una visión a muy corto plazo.

En la mayoría de los temas, los LLM luchan por producir constantemente contenido de "alta calidad" en términos de precisión objetiva y cumplimiento de los criterios EEAT de Google, a pesar de tener acceso web en vivo para obtener información más allá de sus datos de capacitación.

AI está logrando avances significativos en la generación de respuestas para consultas que antes tenían poco contenido. Pero a medida que Google apunta a objetivos más elevados a largo plazo con SGE, esta tendencia puede desvanecerse.

Se espera que el enfoque regrese al contenido experto de formato más largo, con los sistemas de conocimiento de Google brindando respuestas para atender muchas consultas de cola larga en lugar de dirigir a los usuarios a numerosos sitios pequeños.

Las opiniones expresadas en este artículo pertenecen al autor invitado y no necesariamente a Search Engine Land. Los autores del personal se enumeran aquí.