Cómo mejorar la eficiencia del rastreo y la indexación a nivel empresarial

Publicado: 2023-07-13El SEO empresarial se rige por reglas diferentes.

Las estrategias que pueden funcionar para sitios web pequeños o de nicho no siempre funcionarán a escala.

Entonces, ¿qué puede pasar exactamente cuando el SEO empresarial crece demasiado ?

En este artículo, compartiré tres ejemplos de la vida real. Luego, aprenderá un antídoto potencial para una gestión más eficiente del SEO a escala.

Enfrentando el dilema de la indexación

Los sitios pequeños tienden a crecer una página a la vez, utilizando palabras clave como los componentes básicos de una estrategia de SEO.

Los sitios grandes a menudo adoptan enfoques más sofisticados, apoyándose en gran medida en los sistemas, las reglas y la automatización.

Es fundamental alinear el SEO con los objetivos comerciales. Medir el éxito de SEO en función de las clasificaciones de palabras clave o el tráfico tiene consecuencias negativas debido a la indexación excesiva.

No existe una fórmula mágica para determinar el número óptimo de URL indexadas. Google no establece un límite superior.

Sin embargo, un buen punto de partida es considerar la salud general del embudo de SEO. Si un sitio…

- Envía decenas o cientos de millones , o incluso miles de millones de URL a Google

- Posiciona solo para unos pocos millones de palabras clave

- Recibe visitas a unas miles de páginas

- Convierte una fracción de estos (si es que hay alguno)

…entonces es una buena indicación de que necesita abordar algunas necesidades serias de salud de SEO.

Arreglar cualquier problema de higiene del sitio ahora debería evitar problemas de SEO aún mayores más adelante.

Veamos tres ejemplos de SEO empresarial de la vida real que ilustran por qué esto es tan importante.

Caso 1: Consecuencias de sobreindexar contenido de baja calidad

Google tiene recursos limitados para el rastreo y procesamiento web. Priorizan el contenido que es valioso para los usuarios.

Google podría rastrear, pero no indexar, las páginas que considere delgadas, duplicadas o de baja calidad.

Si son solo unas pocas páginas, no hay problema. Pero si está muy extendido, Google podría ignorar tipos de páginas completos o la mayor parte del contenido del sitio.

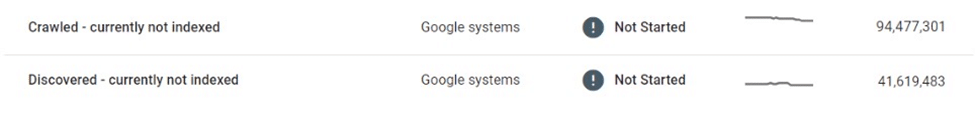

En un caso, un mercado de comercio electrónico descubrió que decenas de millones de sus páginas de listas se vieron afectadas por el rastreo y la indexación selectivos.

Después de rastrear millones de páginas de listados delgados y casi duplicados y no indexarlos, Google finalmente redujo el rastreo del sitio web por completo, dejando a muchos en el limbo "Descubierto, actualmente no indexado".

Este mercado dependía en gran medida de los motores de búsqueda para promocionar nuevos listados a los usuarios. Ya no se descubría nuevo contenido, lo que planteaba un importante desafío empresarial.

Se tomaron algunas medidas inmediatas, como mejorar los enlaces internos y desplegar mapas de sitio XML dinámicos. En última instancia, estos intentos fueron inútiles.

La solución real requería controlar el volumen y la calidad del contenido indexable.

Caso 2: Consecuencias imprevistas del cese del rastreo

Cuando se detiene el rastreo, el contenido no deseado permanecerá en el índice de Google, incluso si se modifica, redirige o elimina.

Muchos sitios web usan redireccionamientos en lugar de errores 404 para contenido eliminado para mantener la autoridad. Esta táctica puede exprimir tráfico adicional de páginas fantasma durante meses, si no años.

Sin embargo, esto a veces puede salir terriblemente mal.

Por ejemplo, un conocido mercado mundial que vende productos hechos a mano reveló accidentalmente la información privada de los vendedores (p. ej., nombre, dirección, correo electrónico, número de teléfono) en versiones localizadas de sus páginas de listados. Algunas de estas páginas fueron indexadas y almacenadas en caché por Google, mostrando información de identificación personal (PII) en los resultados de búsqueda, comprometiendo la seguridad y privacidad del usuario.

Debido a que Google no volvió a rastrear estas páginas, eliminarlas o actualizarlas no las eliminaría del índice. Incluso meses después de la eliminación, el contenido en caché y los datos PII del usuario continuaron existiendo en el índice de Google.

En una situación como esta, era responsabilidad del mercado corregir los errores y trabajar directamente con Google para eliminar el contenido confidencial de la Búsqueda.

Caso 3: Los riesgos de sobreindexar las páginas de resultados de búsqueda

La indexación descontrolada de grandes volúmenes de páginas delgadas y de baja calidad puede ser contraproducente, pero ¿qué pasa con la indexación de páginas de resultados de búsqueda?

Google no respalda la indexación de los resultados de búsqueda internos, y muchos SEO experimentados desaconsejarían esta táctica. Sin embargo, muchos sitios grandes se han apoyado en gran medida en la búsqueda interna como su principal impulsor de SEO, lo que a menudo genera ganancias sustanciales.

Si las métricas de participación del usuario, la experiencia de la página y la calidad del contenido son lo suficientemente altas, Google puede hacer la vista gorda. De hecho, hay suficiente evidencia para sugerir que Google podría incluso preferir una página de resultados de búsqueda interna de alta calidad a una página de lista delgada.

Sin embargo, esta estrategia también puede salir mal.

Una vez vi que un sitio de subastas local perdía una parte importante de su clasificación en la página de búsqueda, y más de un tercio de su tráfico de SEO, de la noche a la mañana.

La regla 20/80 se aplica en el sentido de que una pequeña parte de los términos principales representan la mayoría de las visitas de SEO a los resultados de búsqueda indexados. Sin embargo, a menudo es la cola larga la que constituye la mayor parte del volumen de URL y cuenta con algunas de las tasas de conversión más altas.

Como resultado, de los sitios que utilizan esta táctica, pocos imponen límites estrictos o reglas sobre la indexación de las páginas de búsqueda.

Esto plantea dos problemas importantes:

- Cualquier consulta de búsqueda puede generar una página válida, lo que significa que se podría generar automáticamente una cantidad infinita de páginas.

- Todos ellos son indexables en Google.

En el caso de un mercado de clasificados que monetizó sus páginas de búsqueda con anuncios de terceros, esta vulnerabilidad fue bien aprovechada a través de una forma de arbitraje de anuncios:

- Se generó una enorme cantidad de URL de búsqueda para términos sospechosos, para adultos y totalmente ilícitos.

- Si bien estas páginas generadas automáticamente no arrojaron resultados de inventario reales, publicaron anuncios de terceros y se optimizaron para clasificar las consultas de búsqueda solicitadas a través de la plantilla de página y los metadatos.

- Se crearon vínculos de retroceso a estas páginas desde foros de baja calidad para que los bots los descubrieran y rastrearan.

- Los usuarios que llegaban a estas páginas desde Google hacían clic en los anuncios de terceros y se dirigían a los sitios de baja calidad que eran el destino previsto.

Cuando se descubrió el esquema, la reputación general del sitio se había dañado. También recibió varias penalizaciones y sufrió caídas masivas en el rendimiento de SEO.

Adoptar la indexación administrada

¿Cómo podrían haberse evitado estos problemas?

Una de las mejores maneras para que los sitios de grandes empresas prosperen en SEO es reducir la escala a través de la indexación administrada.

Para un sitio de decenas o cientos de millones de páginas, es crucial pasar de un enfoque centrado en palabras clave a uno impulsado por datos, reglas y automatización.

Indexación basada en datos

Una ventaja significativa de los sitios grandes es la gran cantidad de datos de búsqueda internos que tienen a su disposición.

En lugar de depender de herramientas externas, pueden utilizar estos datos para comprender la demanda y las tendencias de búsqueda regionales y estacionales a nivel granular.

Estos datos, cuando se asignan al inventario de contenido existente, pueden proporcionar una guía sólida sobre qué contenido indexar, así como cuándo y dónde hacerlo.

Deduplicar y consolidar

Una pequeña cantidad de URL autorizadas y de alto rango es mucho más valiosa que un gran volumen de páginas dispersas entre las 100 principales.

Vale la pena consolidar páginas similares usando canonicals, aprovechando las reglas y la automatización para hacerlo. Algunas páginas pueden consolidarse en función de las puntuaciones de similitud, otras, agrupadas si se clasifican colectivamente para consultas similares.

La clave aquí es la experimentación. Modifique la lógica y revise los umbrales con el tiempo.

Limpie las páginas de contenido delgadas y vacías

Cuando están presentes en volúmenes masivos, las páginas delgadas y vacías pueden causar un daño significativo a la higiene y el rendimiento del sitio.

Si es demasiado difícil mejorarlos con contenido valioso o consolidarlos, entonces no deberían indexarse o incluso rechazarse.

Reducir espacios infinitos con robots.txt

Quince años después de que Google escribiera por primera vez sobre "espacios infinitos", el problema de la sobreindexación de filtros, la clasificación y otras combinaciones de parámetros continúa afectando a muchos sitios de comercio electrónico.

En casos extremos, los rastreadores pueden bloquear los servidores mientras intentan abrirse camino a través de estos enlaces. Afortunadamente, esto se puede abordar fácilmente a través de robots.txt.

Representación del lado del cliente

El uso de la representación del lado del cliente para ciertos componentes en la página que no desea que los motores de búsqueda indexen, podría ser una opción. Considere esto cuidadosamente.

Mejor aún, estos componentes deberían ser inaccesibles para los usuarios que no hayan iniciado sesión.

Las apuestas aumentan drásticamente a medida que aumenta la escala

Si bien el SEO a menudo se percibe como una fuente de tráfico "gratuita", esto es algo engañoso. Cuesta dinero alojar y servir contenido.

Los costos pueden ser insignificantes por URL, pero una vez que la escala alcanza cientos de millones o miles de millones de páginas, los centavos comienzan a sumar números reales.

Aunque el ROI de SEO es difícil de medir, un centavo ahorrado es un centavo ganado, y los ahorros de costos a través del rastreo y la indexación administrados deben ser un factor al considerar estrategias de indexación para sitios grandes.

Un enfoque pragmático del SEO, con rastreo e indexación bien administrados, guiados por datos, reglas y automatización, puede proteger sitios web grandes de errores costosos.

Las opiniones expresadas en este artículo pertenecen al autor invitado y no necesariamente a Search Engine Land. Los autores del personal se enumeran aquí.