L'IA dans le référencement : comment relever les défis juridiques et garantir la conformité

Publié: 2023-09-26L’intelligence artificielle (IA) est en passe de devenir un outil essentiel pour les marques cherchant à améliorer leur présence en ligne.

Cependant, l’intégration de l’IA dans les stratégies marketing crée inévitablement des considérations juridiques et de nouvelles réglementations que les agences doivent soigneusement maîtriser.

Dans cet article, vous découvrirez :

- Comment les entreprises, les agences de référencement et les agences média peuvent minimiser les risques juridiques liés à la mise en œuvre de stratégies améliorées par l'IA.

- Des outils utiles pour réduire les biais de l’IA et un processus pratique pour examiner la qualité du contenu généré par l’IA.

- Comment les agences peuvent relever les principaux défis de mise en œuvre de l’IA pour garantir l’efficacité et la conformité pour leurs clients.

Considérations relatives à la conformité juridique

Propriété intellectuelle et droit d'auteur

Une préoccupation juridique cruciale lors de l’utilisation de l’IA dans le référencement et les médias est le respect des lois sur la propriété intellectuelle et le droit d’auteur.

Les systèmes d’IA récupèrent et analysent souvent de grandes quantités de données, y compris du matériel protégé par le droit d’auteur.

Il existe déjà plusieurs poursuites contre OpenAI pour violations des droits d'auteur et de la vie privée.

La société fait face à des poursuites judiciaires alléguant l'utilisation non autorisée de livres protégés par le droit d'auteur pour la formation de ChatGPT et la collecte illégale d'informations personnelles auprès des internautes à l'aide de leurs modèles d'apprentissage automatique.

Des problèmes de confidentialité concernant le traitement et la sauvegarde des données des utilisateurs par OpenAI ont également amené l'Italie à bloquer entièrement l'utilisation de ChatGPT fin mars.

L'interdiction a maintenant été levée après que la société a apporté des modifications pour accroître la transparence sur le traitement des données utilisateur du chatbot et a ajouté une option permettant de se désinscrire des conversations de ChatGPT utilisées pour les algorithmes de formation.

Cependant, avec le lancement de GPTBot, le robot d'exploration d'OpenAI, d'autres considérations juridiques sont susceptibles de surgir.

Pour éviter d'éventuels problèmes juridiques et réclamations pour violation, les agences doivent s'assurer que tous les modèles d'IA sont formés sur des sources de données autorisées et respectent les restrictions de droits d'auteur :

- Assurez-vous que les données ont été obtenues légalement et que l’agence dispose des droits appropriés pour les utiliser.

- Filtrez les données qui ne disposent pas des autorisations légales requises ou qui sont de mauvaise qualité.

- Effectuez des audits réguliers des données et des modèles d’IA pour vous assurer qu’ils sont conformes aux droits et aux lois d’utilisation des données.

- Organisez une consultation juridique sur les droits des données et la confidentialité pour vous assurer que rien n’est en conflit avec les politiques juridiques.

Les équipes juridiques de l’agence et du client devront probablement être impliquées dans les discussions ci-dessus avant que les modèles d’IA puissent être intégrés dans les flux de travail et les projets.

Confidentialité et protection des données

Les technologies d’IA s’appuient fortement sur les données, qui peuvent inclure des informations personnelles sensibles.

La collecte, le stockage et le traitement des données des utilisateurs doivent être conformes aux lois pertinentes sur la confidentialité, telles que le Règlement général sur la protection des données (RGPD) de l'Union européenne.

En outre, la loi européenne sur l’IA récemment introduite met également l’accent sur la résolution des problèmes de confidentialité des données associés aux systèmes d’IA.

Cela n’est pas sans mérite. De grandes entreprises, telles que Samsung, ont complètement interdit l'IA en raison de l'exposition de données confidentielles téléchargées sur ChatGPT.

Par conséquent, si les agences utilisent les données clients en conjonction avec la technologie de l’IA, elles doivent :

- Donner la priorité à la transparence dans la collecte de données.

- Obtenez le consentement de l’utilisateur.

- Mettez en œuvre des mesures de sécurité robustes pour protéger les informations sensibles.

Dans ces cas-là, les agences peuvent donner la priorité à la transparence dans la collecte de données en communiquant clairement aux utilisateurs quelles données seront collectées, comment elles seront utilisées et qui y aura accès.

Pour obtenir le consentement de l'utilisateur, assurez-vous que celui-ci est éclairé et donné librement au moyen de formulaires de consentement clairs et faciles à comprendre qui expliquent le but et les avantages de la collecte de données.

De plus, des mesures de sécurité robustes comprennent :

- Cryptage des données.

- Contrôle d'accès.

- Anonymisation des données (si possible).

- Audits et mises à jour réguliers.

Par exemple, les politiques d'OpenAI s'alignent sur le besoin de confidentialité et de protection des données et se concentrent sur la promotion de la transparence, du consentement des utilisateurs et de la sécurité des données dans les applications d'IA.

Équité et partialité

Les algorithmes d'IA utilisés dans le référencement et les médias ont le potentiel de perpétuer par inadvertance des préjugés ou de discriminer certains individus ou groupes.

Les agences doivent être proactives dans l’identification et l’atténuation des biais algorithmiques. Ceci est particulièrement important dans le cadre de la nouvelle loi européenne sur l’IA, qui interdit aux systèmes d’IA d’affecter injustement le comportement humain ou d’afficher un comportement discriminatoire.

Pour atténuer ce risque, les agences doivent veiller à ce que diverses données et perspectives soient incluses dans la conception des modèles d'IA et surveiller en permanence les résultats pour détecter d'éventuels biais et discriminations.

Un moyen d'y parvenir consiste à utiliser des outils qui aident à réduire les préjugés, comme AI Fairness 360, IBM Watson Studio et l'outil What-If de Google.

Contenu faux ou trompeur

Les outils d'IA, dont ChatGPT, peuvent générer du contenu synthétique qui peut être inexact, trompeur ou faux.

Par exemple, l’intelligence artificielle crée souvent de faux avis en ligne pour promouvoir certains lieux ou produits. Cela peut avoir des conséquences négatives pour les entreprises qui s’appuient sur le contenu généré par l’IA.

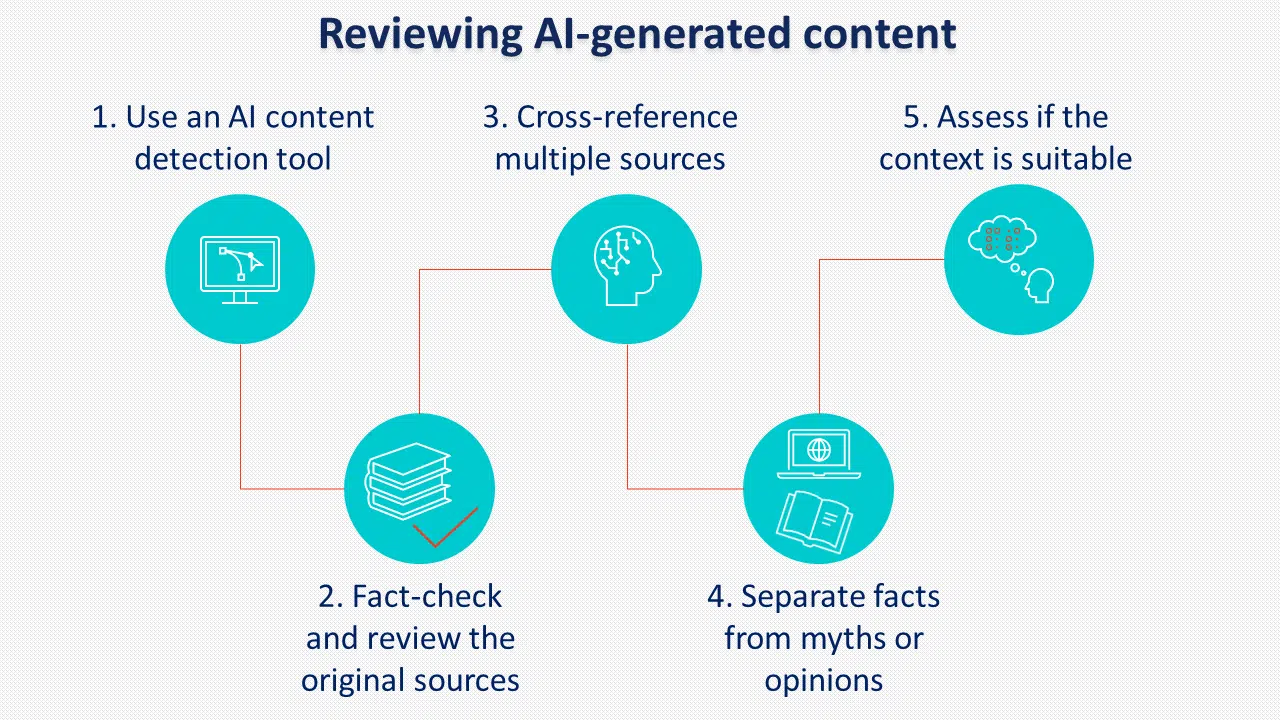

La mise en œuvre de politiques et de procédures claires pour examiner le contenu généré par l’IA avant sa publication est cruciale pour prévenir ce risque.

Une autre pratique à considérer consiste à étiqueter le contenu généré par l’IA. Bien que Google ne semble pas l’appliquer, de nombreux décideurs politiques soutiennent l’étiquetage de l’IA.

Responsabilité et imputabilité

À mesure que les systèmes d’IA deviennent plus complexes, des questions de responsabilité se posent.

Les agences utilisant l’IA doivent être prêtes à assumer la responsabilité de toute conséquence imprévue résultant de son utilisation, notamment :

- Biais et discrimination lors de l’utilisation de l’IA pour trier les candidats à l’embauche.

- La possibilité d’abuser de la puissance de l’IA à des fins malveillantes telles que des cyberattaques.

- La perte de confidentialité si les informations sont collectées sans consentement.

La loi de l'UE sur l'IA introduit de nouvelles dispositions sur les systèmes d'IA à haut risque qui peuvent affecter considérablement les droits des utilisateurs, soulignant pourquoi les agences et les clients doivent se conformer aux conditions et politiques pertinentes lorsqu'ils utilisent des technologies d'IA.

Certaines des conditions et politiques les plus importantes d'OpenAI concernent le contenu fourni par l'utilisateur, l'exactitude des réponses et le traitement des données personnelles.

La politique de contenu stipule qu'OpenAI attribue les droits du contenu généré à l'utilisateur. Il précise également que le contenu généré peut être utilisé à toutes fins, y compris commerciales, à condition qu'il respecte les restrictions légales.

Cependant, il indique également que le résultat peut ne pas être complètement unique ni précis, ce qui signifie que le contenu généré par l'IA doit toujours être soigneusement examiné avant utilisation.

Concernant les données personnelles, OpenAI collecte toutes les informations saisies par les utilisateurs, y compris les téléchargements de fichiers.

Lorsqu'ils utilisent le service pour traiter des données personnelles, les utilisateurs doivent fournir des avis de confidentialité légalement adéquats et remplir un formulaire pour demander le traitement des données.

Les agences doivent résoudre de manière proactive les problèmes de responsabilité, surveiller les résultats de l’IA et mettre en œuvre des mesures de contrôle de qualité robustes pour atténuer les responsabilités juridiques potentielles.

Obtenez la newsletter quotidienne sur laquelle les spécialistes du marketing de recherche comptent.

Voir les conditions.

Les défis de la mise en œuvre de l’IA pour les agences

Depuis qu'OpenAI a publié ChatGPT l'année dernière, de nombreuses discussions ont eu lieu sur la manière dont l'IA générative changera le référencement en tant que profession et sur son impact global sur l'industrie des médias.

Bien que les changements s'accompagnent d'une combinaison d'améliorations de la charge de travail quotidienne, les agences doivent prendre en compte certains défis lors de la mise en œuvre de l'IA dans les stratégies des clients.

Éducation et sensibilisation

De nombreux clients peuvent ne pas avoir une compréhension globale de l’IA et de ses implications.

Les agences sont donc confrontées au défi d’éduquer leurs clients sur les avantages et les risques potentiels associés à la mise en œuvre de l’IA.

Le paysage réglementaire en évolution nécessite une communication claire avec les clients concernant les mesures prises pour garantir la conformité légale.

Pour y parvenir, les agences doivent :

- Avoir une compréhension claire des objectifs de leur client.

- Être capable d’expliquer les avantages.

- Démontrer une expertise dans la mise en œuvre de l’IA.

- Relever les défis et les risques.

Un moyen d'y parvenir est de partager avec les clients une fiche d'information contenant toutes les informations nécessaires et, si possible, de fournir des études de cas ou d'autres exemples de la manière dont ils peuvent bénéficier de l'utilisation de l'intelligence artificielle.

Allocation des ressources

L'intégration de l'IA dans les stratégies de référencement et de médias nécessite des ressources importantes, notamment des investissements financiers, du personnel qualifié et des mises à niveau des infrastructures.

Les agences doivent évaluer soigneusement les besoins et les capacités de leurs clients pour déterminer la faisabilité de la mise en œuvre de solutions d'IA dans le cadre de leurs contraintes budgétaires, car elles peuvent avoir besoin de spécialistes de l'IA, d'analystes de données, de spécialistes du référencement et du contenu capables de collaborer efficacement ensemble.

Les besoins en infrastructure peuvent inclure des outils d’IA, des plateformes de traitement de données et d’analyse pour extraire des informations. Qu'il s'agisse de fournir des services ou de faciliter des ressources externes dépend des capacités et du budget existants de chaque agence.

L'externalisation d'autres agences pourrait conduire à une mise en œuvre plus rapide, tandis qu'investir dans des capacités d'IA internes pourrait s'avérer préférable pour un contrôle et une personnalisation à long terme des services proposés.

Expertise technique

La mise en œuvre de l’IA nécessite des connaissances et une expertise techniques spécialisées.

Les agences peuvent avoir besoin de recruter ou de perfectionner leurs équipes pour développer, déployer et gérer efficacement les systèmes d'IA conformément aux nouvelles exigences réglementaires.

Pour tirer le meilleur parti de l’IA, les membres de l’équipe doivent avoir :

- Bonnes connaissances en programmation.

- Compétences en traitement et analyse des données pour gérer de grandes quantités de données.

- Connaissance pratique de l'apprentissage automatique.

- Excellentes compétences en résolution de problèmes.

Considérations éthiques

Les agences doivent considérer les implications éthiques de l’utilisation de l’IA pour leurs clients.

Des cadres et des lignes directrices éthiques devraient être établis pour garantir des pratiques responsables en matière d’IA tout au long du processus, répondant ainsi aux préoccupations soulevées dans la réglementation mise à jour.

Ceux-ci inclus:

- Transparence, divulgation et responsabilité lorsque l’IA est utilisée.

- Respecter la vie privée des utilisateurs et la propriété intellectuelle.

- Obtenir le consentement du client pour utiliser l’intelligence artificielle.

- Contrôle humain sur l’IA avec engagement continu à améliorer et à s’adapter aux technologies émergentes d’IA.

La responsabilité est importante : relever les défis juridiques liés à la mise en œuvre de l’IA

Alors que l’IA présente des opportunités passionnantes pour améliorer les pratiques de référencement et de médias, les agences doivent relever des défis juridiques et adhérer aux réglementations mises à jour associées à sa mise en œuvre.

Les entreprises et les agences peuvent minimiser les risques juridiques en :

- S'assurer que les données ont été obtenues légalement et que l'agence dispose des droits appropriés pour les utiliser.

- Filtrage des données qui ne disposent pas des autorisations légales requises ou qui sont de mauvaise qualité.

- Réaliser des audits des données et des modèles d'IA pour garantir qu'ils sont conformes aux droits et aux lois d'utilisation des données.

- Organiser une consultation juridique sur les droits des données et la confidentialité pour garantir que rien n'est en conflit avec les politiques juridiques.

- Donner la priorité à la transparence dans la collecte de données et obtenir le consentement des utilisateurs au moyen de formulaires de consentement clairs et faciles à comprendre.

- Utiliser des outils qui aident à réduire les préjugés, comme AI Fairness 360, IBM Watson Studio et l'outil What-If de Google.

- Mettre en œuvre des politiques et des procédures claires pour examiner la qualité du contenu généré par l’IA avant sa publication.

Les opinions exprimées dans cet article sont celles de l’auteur invité et ne sont pas nécessairement celles de Search Engine Land. Les auteurs du personnel sont répertoriés ici.