Qu'est-ce que le budget de crawl [et comment l'optimiser] ?

Publié: 2022-05-16Le budget de crawl est l'un de ces termes SEO dont vous avez probablement entendu parler par les spécialistes du marketing.

Cependant, savez-vous ce que cela signifie et de quoi il s'agit?

Ne vous inquiétez pas, nous ne sommes pas là pour vous tester. Au contraire, nous sommes là pour vous aider à tout comprendre sur le budget de crawl, pourquoi il est important et comment vous pouvez le vérifier et l'optimiser.

Après tout, vous devez apprendre à ramper avant de savoir marcher, n'est-ce pas ?

Qu'est-ce qu'un budget de crawl ?

Le budget de crawl correspond au nombre de pages que Google peut explorer sur un site Web dans un délai donné.

Vous voyez, chaque fois que vous publiez une page sur votre site Web, vous devez attendre que Google l'indexe et la classe, et pour pouvoir le faire, ses robots doivent d'abord l'explorer.

Ce processus peut se produire plus rapidement ou plus lentement en fonction de circonstances telles que la taille de votre site Web, la popularité des sujets, le trafic sur votre page, etc.

Mais comment fonctionne réellement le crawl ?

Découvrons-le.

Comment fonctionnent les robots ?

Il y a plus de 10 ans, Google s'est rendu compte que ses ressources étaient limitées et qu'il ne pouvait trouver qu'un pourcentage limité du contenu en ligne sans fin qui était constamment publié en ligne.

Puis, en 2017, Google a publié son article officiel « Ce que signifie le budget de crawl pour Googlebot », dans lequel ils expliquent leur définition du crawl et d'autres détails pertinents.

Voici les faits essentiels :

- L'exploration est efficace, sauf si votre site Web contient plus de quelques milliers d'URL

- Les pages qui répondent rapidement augmentent la limite de crawl

- Vous pouvez réduire le taux de crawl de votre site Web via Google Search Console

- Les URL populaires ont tendance à être explorées plus souvent

- Une abondance d'URL de faible valeur (contenu dupliqué, pages d'erreur logicielles, etc.) peut avoir un impact négatif sur l'indexation et l'exploration

- L'exploration n'est pas un facteur de classement direct

Fondamentalement, afin d'assurer une capacité d'exploration maximale de votre site Web, vous devez avoir des temps de chargement rapides, éviter les contenus en double et de mauvaise qualité et rendre vos pages populaires.

Cependant, il est important de noter que la majorité des propriétaires de sites Web n'ont pas besoin d'être trop préoccupés par le budget de crawl. Ce sont les grands sites Web avec des milliers de pages, comme les magasins de commerce électronique, les publications numériques et les blogs populaires, qui devraient prêter attention.

Pourquoi le budget de crawl est-il important ?

Le budget de crawl est très important pour vos efforts de référencement, en particulier lorsque vous avez des milliers de pages et que vous publiez constamment de nombreux nouveaux articles quotidiennement. Les robots voudront explorer votre nouveau contenu, mais ils revisiteront également le reste de votre site Web simultanément.

S'ils rencontrent plusieurs revers et/ou problèmes qui les déroutent, ils seront obligés de gaspiller le budget de crawl sur les anciennes pages, au lieu de l'investir dans le nouveau contenu que vous souhaitez qu'ils indexent. Cela peut, potentiellement, créer des retards et rendre temporairement (voire définitivement) vos URLs indisponibles dans les SERPs.

Par exemple, vous publiez des nouvelles ou des informations qui sont importantes pour gagner en visibilité le plus rapidement possible.

Vous ne voudriez pas attendre une semaine pour que votre message soit indexé, n'est-ce pas ?

Après tout, vous ne pouvez pas vous classer pour un SERP si votre page n'est pas indexée. Et disons que vous écrivez sur un événement mondial qui s'est produit aujourd'hui, mais que votre page est explorée dans cinq jours. À ce stade, il est trop tard pour atteindre votre objectif initial, car l'événement n'est plus aussi pertinent et frais. Sans oublier que de nombreux autres sites Web auront écrit à ce sujet et auront été indexés à temps.

Il n'est pas rare que les crawl bots mettent jusqu'à une semaine pour indexer votre page, mais pour être honnête, cela devrait prendre moins de temps que cela.

De plus, pendant ce temps, vous continuerez à publier de nouvelles pages qui doivent être explorées, indexées et disponibles pour votre public cible en temps opportun. Et c'est une recette pour un goulot d'étranglement d'indexation.

Dans l'ensemble, si vous atteignez souvent les limites de votre budget de crawl, vous risquez que certaines de vos pages glissent entre les mailles du filet et ne parviennent pas aux SERPs. De ce fait, ceux-ci ne bénéficieront pas du trafic organique, et auront une visibilité bien moindre que le reste de votre contenu.

Et si vous vous demandez comment vérifier votre budget de crawl, c'est facile. Allez simplement sur Google Search Console et cochez Crawl → Crawl Stats.

Optimisation du budget de crawl

Il est important de se rappeler que le budget d'exploration dépend de trois facteurs principaux : la taille du site Web, la santé du site Web et la popularité du site Web.

Cela signifie que vous n'avez pas à vous soucier du gaspillage du budget de crawl si :

- Votre site Web est modérément petit, c'est-à-dire moins de quelques milliers de pages.

- Votre site Web est exempt d'erreurs de code d'état et dispose d'une canonisation appropriée.

- Votre site Web est populaire, ce qui signifie que vous avez développé un suivi des médias sociaux et d'autres canaux pour partager votre contenu et générer du trafic.

Couvrir ces critères signifie que Googlebot devrait être en mesure d'explorer efficacement votre site Web.

Si vous ne disposez pas de l'un de ces trois facteurs, vous risquez de rencontrer différents niveaux de problèmes d'exploration et de perdre la visibilité de la recherche organique pour certaines de vos pages.

Voici quelques bonnes pratiques de budget de crawl à suivre :

Améliorez la vitesse de votre site Web

Comme mentionné ci-dessus, la vitesse du site Web et le temps de chargement des pages peuvent affecter la limite d'exploration. Un site Web sain et rapide signifie que Googlebot est capable d'explorer plus de pages et en moins de temps.

D'un autre côté, les pages de chargement plus lentes réduisent le taux d'exploration et, dans un grand site Web, cela peut entraîner des problèmes d'indexation globaux.

En un mot, assurez-vous d'optimiser la vitesse de votre site. Cela facilitera non seulement la tâche des bots, mais améliorera également l'expérience utilisateur.

Appliquer le maillage interne

Le meilleur scénario est d'avoir des backlinks pointant vers chaque page de votre site. Ce n'est pas seulement une bonne pratique de référencement pour attirer des visiteurs sur votre site et montrer aux moteurs de recherche que votre contenu est important, mais cela attire également Googlebot.

En termes simples, les backlinks sont le golden boy du SEO.

Mais voici le marché.

Outre les backlinks, Google aime également les liens internes. Cela l'aide à découvrir toutes vos pages et à mieux comprendre comment elles sont liées. Et bien que les backlinks puissent être difficiles à trouver, vous avez un contrôle total sur les liens internes et pouvez en ajouter autant que vous le souhaitez (mais n'en faites pas trop).

L'application de cette technique d'optimisation garantira que davantage de vos pages seront explorées.

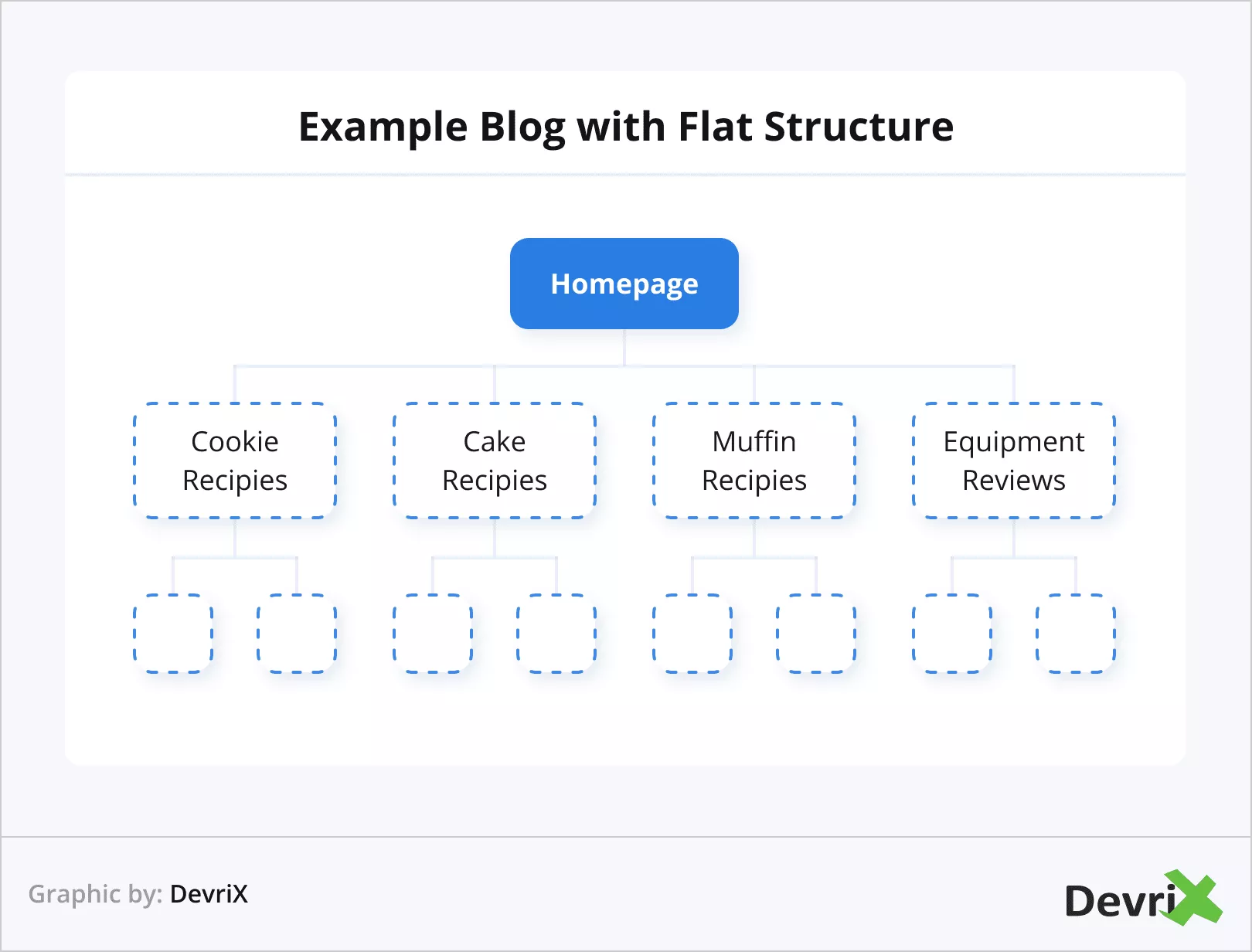

Utiliser l'architecture Web plate

La popularité est très importante aux yeux de Google. C'est pourquoi il serait avantageux d'utiliser une architecture de site Web plate. L'architecture plate permet à l'autorité des liens d'avoir des proportions égales sur toutes vos pages.

Cela aidera les bots à suivre plus facilement la façon dont les liens de votre site Web sont connectés, et vous permettra en outre de mieux regrouper les pages connexes et d'acquérir une autorité thématique.

En pratique, cela signifie que les utilisateurs et les moteurs de recherche peuvent accéder à n'importe quelle page de votre site Web en quatre clics.

Évitez les pages orphelines et le contenu dupliqué

Une page orpheline est une page qui ne contient pas un seul lien externe, ni interne. Cela rend ces types de pages isolés du reste de votre contenu et, logiquement, ils sont également plus difficiles à découvrir pour Googlebot.

Vous pouvez facilement éviter les pages orphelines en ajoutant au moins un lien interne à chaque article et page que vous avez.

Gérer le contenu dupliqué

Le contenu dupliqué cause de nombreux problèmes. Avoir plusieurs URL avec des paramètres similaires est source de confusion pour les crawl bots. Cela fera perdre du temps à Googlebot, car il devra déterminer quelle page est la page principale et quelle est une version dupliquée, ce qui ralentira le processus d'exploration.

Pour les sites comme les plates-formes de commerce électronique, où il est courant d'avoir plusieurs URL similaires, en raison de plusieurs produits similaires avec de petites différences, comme la taille et la couleur, assurez-vous d'utiliser des balises canoniques, qui guideront Googlebot vers les pages que vous souhaitez prioriser.

Interdire l'exploration pour certaines pages

Chaque site Web contient des pages telles que la connexion, les formulaires de contact, les paniers d'achat, etc. Ceux-ci n'ont pas besoin d'être explorés, et, au-delà, ils ne peuvent pas être explorés. Cependant, Google essaiera, c'est donc une bonne idée de faire savoir aux bots qu'ils doivent les ignorer et économiser des ressources.

Pour effectuer cette action, utilisez votre fichier robots.txt pour interdire l'exploration des pages souhaitées.

Mettre à jour l'ancien et écrire du nouveau contenu

Avons-nous mentionné que Google aime le contenu frais ? Cela fait.

Google peut même arrêter d'explorer votre page, car il n'y avait rien de nouveau les dernières fois qu'elle a été explorée.

Imaginez, Googlebot visite votre site une fois tous les deux jours et à chaque fois il trouve un nouveau contenu à indexer. Puis, tout d'un coup, pour une raison quelconque, vous arrêtez de mettre à jour votre site Web. Cependant, Googlebot continue de le visiter avec la même fréquence. Au bout d'un moment, le bot remarque qu'il n'y a pas de nouveau contenu à indexer et, finalement, rend les visites moins fréquentes.

Dans le cas contraire, où vous commencez à fournir plus souvent du nouveau contenu, Googlebot pourrait commencer à visiter votre site Web plus souvent.

La source

En règle générale, lors de l'établissement des pages qui doivent être mises à jour, observez la pertinence - un article peut avoir deux ans et contenir encore des informations applicables (vous devriez quand même le mettre à jour). Ou il peut s'agir d'un matériau vieux d'un mois qui a déjà perdu sa fraîcheur.

Réduire les pages d'erreur

Celui-ci est simple à comprendre.

Googlebot perd du temps lorsqu'il essaie d'explorer des pages avec des codes d'erreur 5xx (erreur de serveur), des codes d'erreur 4xx (erreur introuvable), des codes d'erreur 3xx (redirections), etc., et par conséquent, cela réduit votre limite de vitesse d'exploration.

La source

Fondamentalement, chaque page qui aboutit à un code différent de 200 est une perte de temps et de ressources d'exploration. En pratique, il n'est pas nécessaire d'attirer l'attention de Google sur les pages que vous avez supprimées ou redirigées. Au lieu de cela, donnez la priorité à la correction de vos URL en direct.

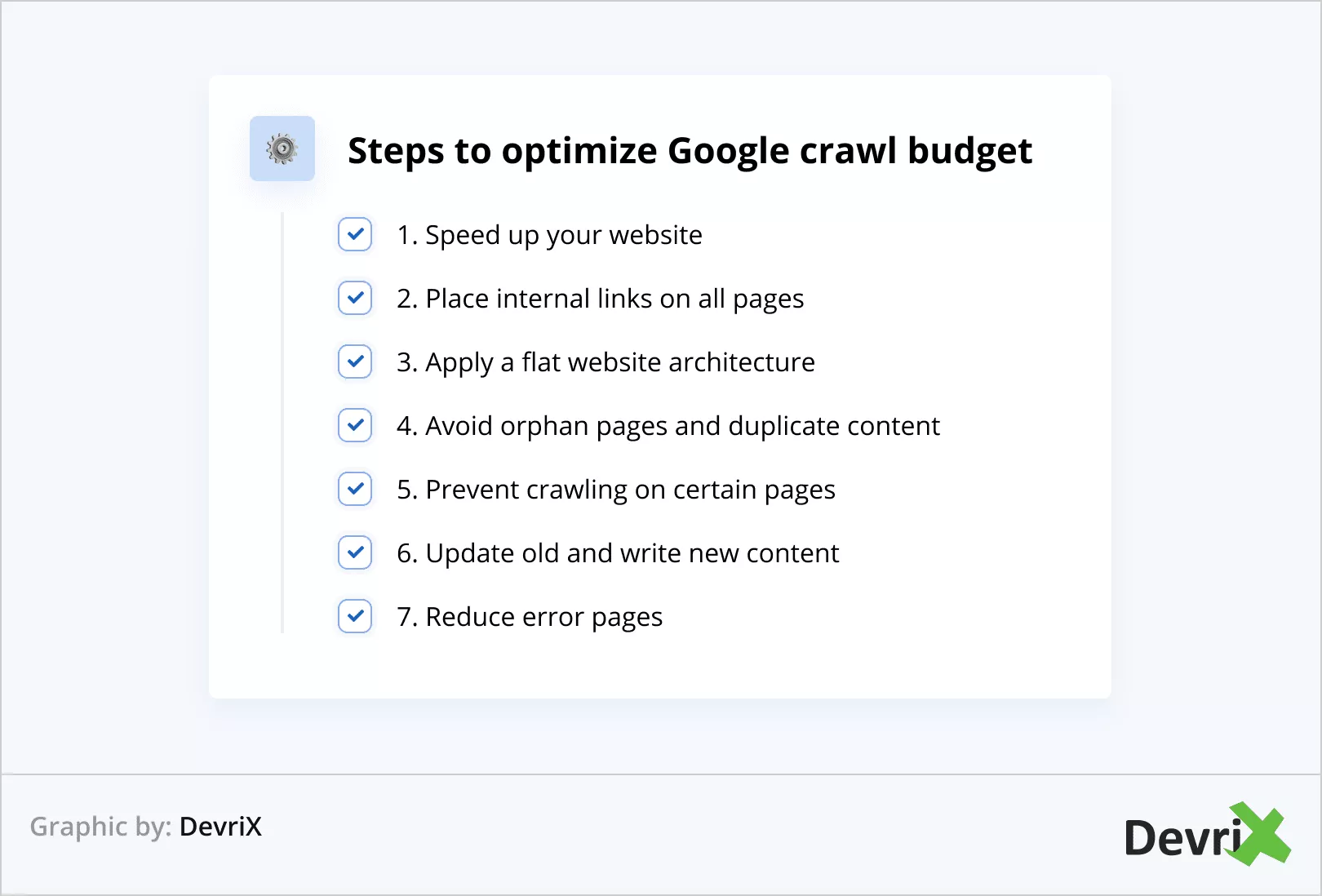

L'optimisation du budget de crawl en bref

Récapitulons les étapes pour optimiser le budget de crawl Google :

- Accélérez votre site web

- Placer des liens internes sur toutes les pages

- Appliquer une architecture de site Web plate

- Évitez les pages orphelines et le contenu dupliqué

- Empêcher l'exploration sur certaines pages

- Mettre à jour l'ancien et écrire du nouveau contenu

- Réduire les pages d'erreur

Astuce bonus

Vous pouvez vérifier la fréquence d'exploration de votre site Web en effectuant une analyse du fichier journal. De cette façon, vous pouvez déterminer si certaines pages sont explorées plus souvent que d'autres.

De plus, une analyse du fichier journal peut vous aider à comprendre s'il existe des problèmes dans des zones spécifiques du site Web.

De plus, une analyse du fichier journal peut vous aider à comprendre s'il existe des problèmes dans des zones spécifiques du site Web.

Conclusion

Le budget de crawl est essentiel pour la visibilité globale de votre site Web sur les moteurs de recherche. Si Googlebot ne peut pas explorer et indexer vos pages, vous n'existez pratiquement pas en ligne.

Assurez-vous d'appliquer toutes les techniques d'optimisation du budget de crawl dont nous avons parlé dans l'article, et vous en récolterez les fruits.

Google sera en mesure de trouver et d'indexer votre contenu plus rapidement et, en fin de compte, votre site Web sera en avance sur la concurrence qui échoue ou néglige de mettre en œuvre l'optimisation.

1:0 pour vous ! Bon travail!