Le guide complet des tests A/B : conseils d'experts de Google, HubSpot et plus encore

Publié: 2020-04-10Ce n'est probablement pas la première fois que vous lisez des informations sur les tests A/B. Vous pouvez même déjà tester A/B les lignes d'objet de vos e-mails ou vos publications sur les réseaux sociaux.

Malgré le fait que l'on ait beaucoup parlé des tests A/B dans le domaine du marketing, beaucoup de gens se trompent encore. Le résultat? Les personnes qui prennent des décisions commerciales majeures sur la base de résultats inexacts d'un test inapproprié.

Les tests A/B sont souvent trop simplifiés, en particulier dans le contenu écrit pour les propriétaires de magasins. Vous trouverez ci-dessous tout ce que vous devez savoir pour démarrer avec différents types de tests A/B pour le commerce électronique, expliqués aussi clairement que possible.

Table des matières

- Qu'est-ce qu'un test A/B ?

- Comment fonctionnent les tests A/B

- Qu'est-ce qu'un test A/B/n ?

- Combien de temps les tests A/B doivent-ils durer ?

- Pourquoi faire un test A/B ?

- Que devriez-vous tester A/B ?

- Prioriser les idées de test A/B

- Un cours accéléré sur les statistiques des tests AB

- Comment mettre en place un test A/B

- Comment analyser les résultats des tests A/B

- Comment archiver les tests A/B passés

- Processus de test A/B des pros

- Optimisez les tests A/B pour votre entreprise

Qu'est-ce qu'un test A/B ?

Les tests A/B, parfois appelés tests fractionnés, consistent à comparer deux versions d'une même page Web, d'un même e-mail ou d'un autre actif numérique afin de déterminer laquelle est la plus performante.

Ce processus vous permet de répondre à des questions commerciales importantes, vous aide à générer plus de revenus à partir du trafic que vous avez déjà et jette les bases d'une stratégie marketing basée sur les données.

En savoir plus : comment effectuer une analyse SWOT pour votre entreprise

Comment fonctionnent les tests A/B

Lorsque vous utilisez les tests A/B dans le contexte du marketing, vous montrez à 50 % des visiteurs la version A de votre ressource (appelons cela le "contrôle") et à 50 % des visiteurs la version B (appelons cela la "variante").

La version qui génère le taux de conversion le plus élevé gagne. Par exemple, supposons que la variante (version B) ait généré le taux de conversion le plus élevé. Vous le déclareriez alors vainqueur et pousseriez 100% des visiteurs vers la variante.

Ensuite, la variante devient le nouveau contrôle et vous devez concevoir une nouvelle variante.

Il convient de mentionner qu'un taux de conversion de test A/B est une mesure imparfaite du succès. Pourquoi? Vous pouvez augmenter instantanément votre taux de conversion en rendant tout ce qui se trouve dans votre magasin gratuitement. Bien sûr, c'est une décision commerciale terrible.

C'est pourquoi vous devez suivre la valeur d'une conversion jusqu'au son d'une caisse enregistreuse qui sonne.

Liste de lecture gratuite : optimisation de la conversion pour les débutants

Transformez davantage de visiteurs de votre site Web en clients en suivant un cours accéléré sur l'optimisation des conversions. Accédez à notre liste gratuite et organisée d'articles à fort impact ci-dessous.

Recevez notre liste de lecture sur l'optimisation des conversions directement dans votre boîte de réception.

Vous y êtes presque : veuillez saisir votre adresse e-mail ci-dessous pour obtenir un accès instantané.

Nous vous enverrons également des mises à jour sur les nouveaux guides pédagogiques et les histoires de réussite de la newsletter Shopify. Nous détestons le SPAM et nous nous engageons à protéger votre adresse e-mail.

Qu'est-ce qu'un test A/B/n ?

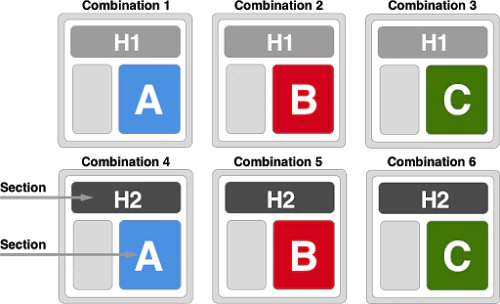

Avec les tests A/B/n, vous pouvez tester plusieurs variantes par rapport au contrôle. Ainsi, au lieu de montrer à 50 % des visiteurs le contrôle et à 50 % des visiteurs la variante, vous pouvez montrer à 25 % des visiteurs le contrôle, 25 % la première variante, 25 % la deuxième variante et 25 % la troisième variante.

Remarque : Ceci est différent des tests multivariés, qui impliquent également plusieurs variantes. Lorsque vous exécutez des tests multivariés, vous ne testez pas seulement plusieurs variantes, vous testez également plusieurs éléments, tels que les tests A/B UX ou les tests fractionnés SEO. Le but est de déterminer quelle combinaison fonctionne le mieux.

Vous aurez besoin de beaucoup de trafic pour exécuter des tests multivariés, vous pouvez donc les ignorer pour le moment.

Combien de temps les tests A/B doivent-ils durer ?

Exécutez votre test A/B pendant au moins un, idéalement deux, cycles économiques complets. N'arrêtez pas votre test simplement parce que vous avez atteint la signification. Vous devrez également respecter la taille de votre échantillon prédéterminé. Enfin, n'oubliez pas d'exécuter tous les tests par incréments d'une semaine entière.

Pourquoi deux cycles économiques complets ? Pour commencer:

- Vous pouvez comptabiliser les acheteurs « j'ai besoin d'y penser ».

- Vous pouvez prendre en compte toutes les différentes sources de trafic (Facebook, newsletter par e-mail, recherche organique, etc.)

- Vous pouvez tenir compte des anomalies. Par exemple, votre newsletter par e-mail du vendredi.

Si vous avez utilisé n'importe quel type d'outil de test A/B ou de page de destination, vous connaissez probablement la petite icône verte "Statistiquement significatif".

Pour beaucoup, malheureusement, c'est le signe universel pour "le test est cuit, appelez-le". Comme vous en apprendrez plus ci-dessous, ce n'est pas parce que la signification statistique du test A/B a été atteinte que vous devez arrêter le test.

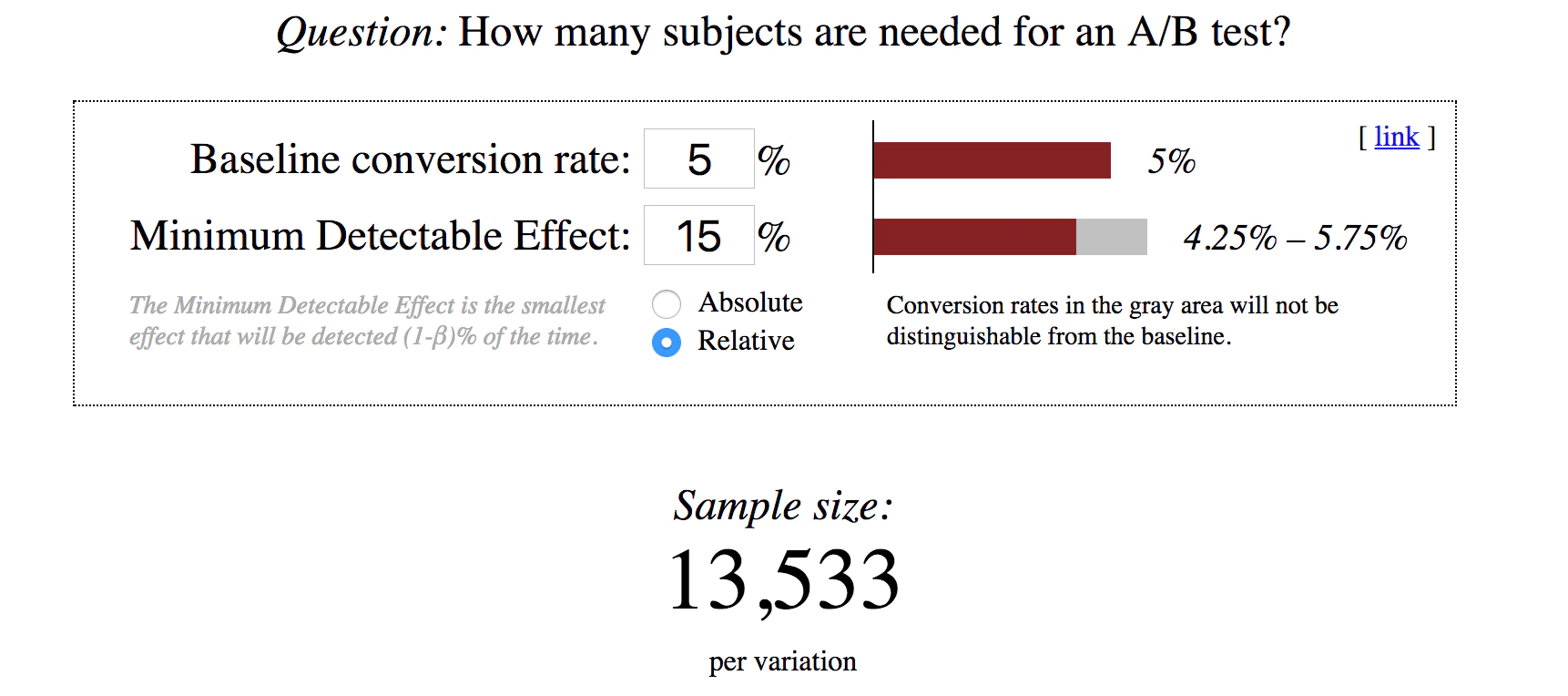

Et votre taille d'échantillon prédéterminée ? Ce n'est pas aussi intimidant qu'il n'y paraît. Ouvrez un calculateur de taille d'échantillon, comme celui-ci d'Evan Miller.

Ce calcul indique que si votre taux de conversion actuel est de 5 % et que vous souhaitez pouvoir détecter un effet de 15 %, vous avez besoin d'un échantillon de 13 533 par variation. Donc, au total, plus de 25 000 visiteurs sont nécessaires s'il s'agit d'un test A/B standard.

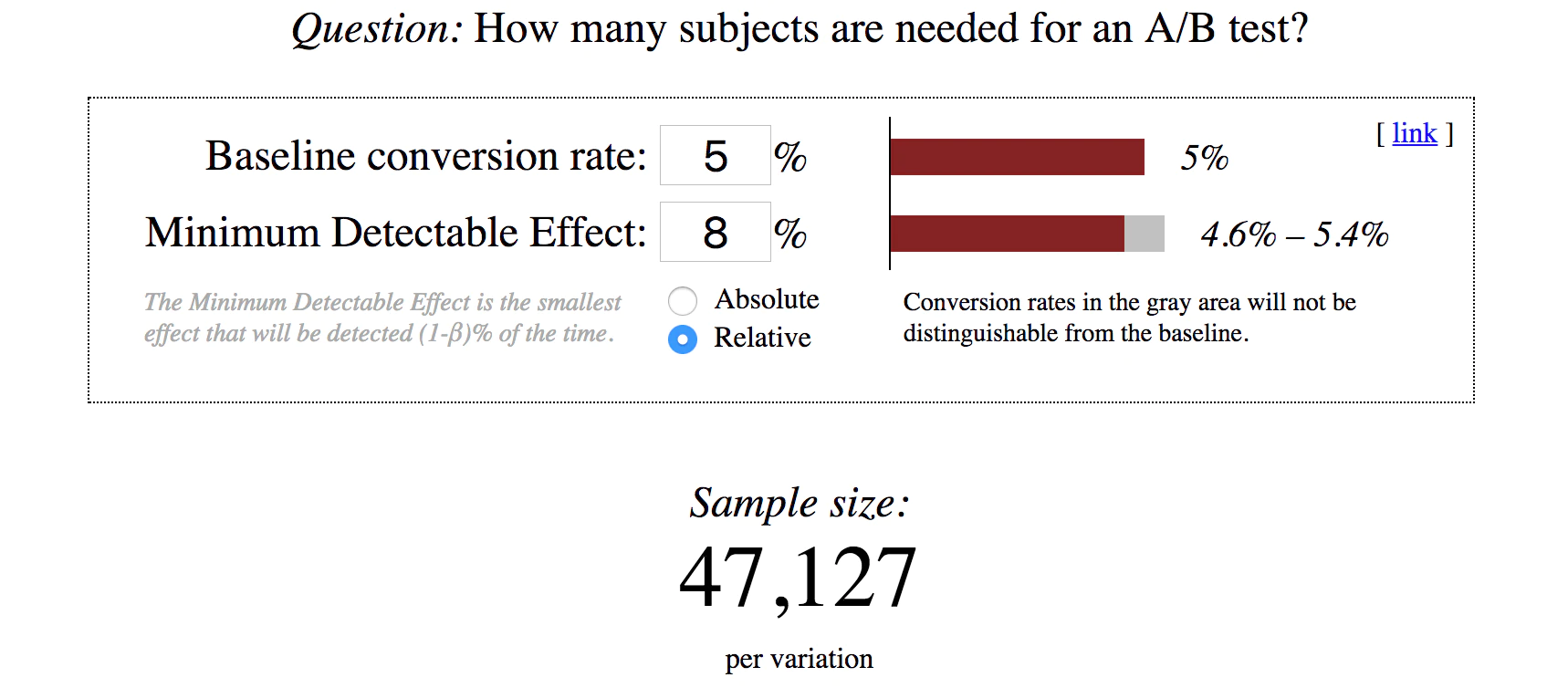

Regardez ce qui se passe si vous voulez détecter un effet plus petit :

Tout ce qui a changé est l'effet minimum détectable (MDE). Il est passé de 15 % à 8 %. Dans ce cas, vous avez besoin d'un échantillon de 47 127 par variation. Donc, au total, près de 100 000 visiteurs sont nécessaires s'il s'agit d'un test A/B standard.

Que vous effectuiez des tests A/B UX ou des tests fractionnés SEO, la taille de votre échantillon doit être calculée à l'avance, avant le début de votre test. Votre test ne peut pas s'arrêter, même s'il atteint la signification, tant que la taille d'échantillon prédéterminée n'est pas atteinte. Si c'est le cas, le test n'est pas valide.

C'est pourquoi vous ne pouvez pas suivre sans but les meilleures pratiques, comme "arrêter après 100 conversions".

Il est également important d'exécuter des tests pour des incréments d'une semaine entière. Votre trafic peut changer en fonction du jour de la semaine et de l'heure de la journée, vous devez donc vous assurer d'inclure tous les jours de la semaine.

Pourquoi faire un test A/B ?

Disons que vous dépensez 100 $ en publicités Facebook pour envoyer 10 personnes sur votre site. La valeur moyenne de votre commande est de 25 $. Huit de ces visiteurs partent sans rien acheter et les deux autres dépensent 25 $ chacun. Le résultat? Vous avez perdu 50 $.

Supposons maintenant que vous dépensiez 100 $ en publicités Facebook pour envoyer 10 personnes sur votre site. La valeur moyenne de votre commande est toujours de 25 $. Cette fois, cependant, seuls cinq de ces visiteurs partent sans rien acheter et les cinq autres dépensent 25 $ chacun. Le résultat? Vous avez gagné 25 $.

C'est l'un des exemples de test A/B les plus simples, bien sûr. Mais en augmentant le taux de conversion sur site, vous avez rendu le même trafic plus précieux.

Les images et les copies de test A/B vous aident également à découvrir des informations, que votre test soit gagnant ou perdant. Cette valeur est très transférable. Par exemple, un aperçu de la rédaction d'un test A/B de description de produit pourrait aider à éclairer votre proposition de valeur, une vidéo de produit ou d'autres descriptions de produits.

Vous ne pouvez pas non plus ignorer la valeur inhérente de l'amélioration continue de l'efficacité de votre magasin.

Faut-il faire des tests A/B ?

Pas nécessairement. Si vous utilisez un site à faible trafic ou une application Web ou mobile, les tests A/B ne sont probablement pas le meilleur effort d'optimisation pour vous. Vous constaterez probablement un retour sur investissement (ROI) plus élevé en effectuant des tests utilisateur ou en discutant avec vos clients, par exemple.

Malgré la croyance populaire, l'optimisation du taux de conversion ne commence pas et ne se termine pas par des tests.

Considérez les chiffres du calculateur de taille d'échantillon ci-dessus. 47 127 visiteurs par variation pour détecter un effet de 8 % si votre taux de conversion de base est de 5 %. Imaginons que vous souhaitiez tester une page produit. Reçoit-il près de 100 000 visiteurs en deux à quatre semaines ?

Pourquoi deux à quatre semaines ? N'oubliez pas que nous voulons exécuter des tests pendant au moins deux cycles économiques complets. Habituellement, cela équivaut à deux à quatre semaines. Maintenant peut-être que vous pensez, "Pas de problème, Shanelle, je vais faire le test pendant plus de deux à quatre semaines pour atteindre la taille d'échantillon requise." Cela ne fonctionnera pas non plus.

Vous voyez, plus un test dure longtemps, plus il est sensible aux menaces de validité externe et à la pollution des échantillons. Par exemple, les visiteurs peuvent supprimer leurs cookies et se retrouver à nouveau dans le test A/B en tant que nouveau visiteur. Ou quelqu'un pourrait passer de son téléphone portable à son ordinateur de bureau et voir une variante alternative.

Essentiellement, laisser votre test s'exécuter trop longtemps est aussi mauvais que de ne pas le laisser s'exécuter assez longtemps.

Les tests valent l'investissement pour les magasins qui peuvent atteindre la taille d'échantillon requise en deux à quatre semaines. Les magasins qui ne le peuvent pas devraient envisager d'autres formes d'optimisation jusqu'à ce que leur trafic augmente.

Julia Starostenko, data scientist chez Shopify, est d'accord, expliquant :

Julia Starostenko, Shopify

« Expérimenter, c'est amusant ! Mais il est important de s'assurer que les résultats sont exacts.

"Demandez-vous : votre audience est-elle suffisamment large ? Avez-vous collecté suffisamment de données ? Afin d'atteindre une véritable signification statistique (dans un délai raisonnable), la taille de l'audience doit être suffisamment grande.

Que devriez-vous tester A/B ?

Je ne peux pas vous dire ce que vous devriez tester A/B. Je sais je sais. Cela vous faciliterait certainement la vie si je pouvais vous donner une liste de 99 choses à tester dès maintenant. Il ne manque pas de spécialistes du marketing prêts à le faire en échange des clics.

La vérité est que les seuls tests qui valent la peine d'être exécutés sont des tests basés sur vos propres données. Je n'ai pas accès à vos données, à vos clients, etc., et personne ne gère ces énormes listes d'idées de test A/B non plus. Aucun de nous ne peut vous dire de manière significative quoi tester.

Les seuls tests qui valent la peine d'être exécutés sont les tests basés sur vos propres données.

Au lieu de cela, je vous encourage à répondre à cette question par vous-même par le biais d'une analyse qualitative et quantitative. Voici quelques exemples de tests A/B populaires :

- Analyse technique. Votre boutique se charge-t-elle correctement et rapidement sur chaque navigateur ? Sur chaque appareil ? Vous avez peut-être un nouvel iPhone 11 brillant, mais quelqu'un quelque part berce encore un Motorola Razr de 2005. Si votre site ne fonctionne pas correctement et rapidement, il ne se convertit certainement pas aussi bien qu'il le pourrait.

- Enquêtes sur place. Ceux-ci apparaissent lorsque les visiteurs de votre magasin naviguent. Par exemple, une enquête sur site peut demander aux visiteurs qui sont sur la même page depuis un certain temps s'il y a quelque chose qui les empêche de faire un achat aujourd'hui. Si oui, qu'est-ce que c'est ? Vous pouvez utiliser ces données qualitatives pour améliorer votre copie et votre taux de conversion.

- Entretiens clients. Rien ne peut remplacer le fait de téléphoner et de parler à vos clients. Pourquoi ont-ils choisi votre magasin plutôt que des magasins concurrents ? Quel problème essayaient-ils de résoudre lorsqu'ils sont arrivés sur votre site ? Il y a un million de questions que vous pourriez poser pour comprendre qui sont vos clients et pourquoi ils achètent vraiment chez vous.

- Enquêtes clients. Les sondages auprès des clients sont des sondages complets qui s'adressent aux personnes qui ont déjà effectué un achat (par opposition aux visiteurs). Lors de la conception d'une enquête, vous souhaitez vous concentrer sur : la définition de vos clients, la définition de leurs problèmes, la définition des hésitations qu'ils ont eues avant d'acheter et l'identification des mots et des phrases qu'ils utilisent pour décrire votre magasin.

- Analyse analytique. Vos outils d'analyse suivent-ils et rapportent-ils correctement vos données ? Cela peut sembler idiot, mais vous seriez surpris du nombre d'outils d'analyse mal configurés. L'analyse analytique consiste à déterminer le comportement de vos visiteurs. Par exemple, vous pouvez vous concentrer sur l'entonnoir. Où sont vos plus grandes fuites d'entonnoir de conversion ? En d'autres termes, où la plupart des gens abandonnent-ils votre entonnoir ? C'est un bon endroit pour commencer les tests.

- Tests utilisateurs. C'est là que vous regardez de vraies personnes dans une expérience payante et contrôlée essayer d'effectuer des tâches sur votre site. Par exemple, vous pouvez leur demander de trouver un jeu vidéo entre 40 $ et 60 $ et de l'ajouter à leur panier. Pendant qu'ils accomplissent ces tâches, ils racontent leurs pensées et leurs actions à haute voix.

- Rediffusions de session. Les rediffusions de session sont similaires aux tests utilisateurs, mais vous avez maintenant affaire à de vraies personnes avec de l'argent réel et une réelle intention d'achat. Vous verrez vos visiteurs réels naviguer sur votre site. Qu'est-ce qu'ils ont du mal à trouver ? Où sont-ils frustrés ? Où semblent-ils confus?

Il existe également d'autres types de recherche, mais commencez par choisir la meilleure méthodologie de test A/B pour vous. Si vous parcourez certaines d'entre elles, vous aurez une énorme liste d'idées fondées sur des données qui méritent d'être testées. Je vous garantis que votre liste vous apportera plus de valeur que n'importe quel article "99 choses à tester en ce moment".

Prioriser les idées de test A/B

Une énorme liste d'idées de test A/B est passionnante, mais pas vraiment utile pour décider quoi tester. Par où commencer ? C'est là que la priorisation entre en jeu.

Il existe quelques cadres de priorisation courants que vous pouvez utiliser :

- GLACE. ICE est synonyme d'impact, de confiance et de facilité. Chacun de ces facteurs reçoit un classement de 1 à 10. Par exemple, si vous pouviez facilement exécuter le test par vous-même sans l'aide d'un développeur ou d'un concepteur, vous pourriez donner un huit à la facilité. Vous utilisez votre jugement ici, et si vous avez plus d'une personne qui effectue des tests, les classements peuvent devenir trop subjectifs. Il est utile d'avoir un ensemble de lignes directrices pour garder tout le monde objectif.

- TARTE. PIE représente le potentiel, l'importance et la facilité. Encore une fois, chaque facteur reçoit un classement de 1 à 10. Par exemple, si le test atteindra 90 % de votre trafic, vous pouvez donner une importance à huit. PIE est aussi subjectif que ICE, donc des directives peuvent également être utiles pour ce cadre.

- PXL. PXL est le cadre de priorisation de CXL. C'est un peu différent et plus personnalisable, forçant des décisions plus objectives. Au lieu de trois facteurs, vous trouverez des questions oui/non et une question de facilité de mise en œuvre. Par exemple, le cadre peut demander : « Le test est-il conçu pour accroître la motivation ? » Si oui, il obtient un 1. Si non, il obtient un 0. Vous pouvez en savoir plus sur ce cadre et télécharger la feuille de calcul ici.

Vous savez maintenant par où commencer, mais cela peut également vous aider à classer vos idées. Par exemple, lors d'une recherche de conversion que j'ai effectuée récemment, j'ai utilisé trois catégories : mettre en œuvre, enquêter et tester.

- Mettre en œuvre. Fais-le. C'est cassé ou évident.

- Enquêter. Nécessite une réflexion supplémentaire pour définir le problème ou se concentrer sur une solution.

- Test. L'idée est solide et les données informées. Essaye-le!

Entre cette catégorisation et cette hiérarchisation, vous êtes prêt.

Un cours accéléré sur les statistiques d'A/B testing

Avant d'exécuter un test, il est important de creuser dans les statistiques. Je sais, les statistiques ne sont généralement pas les préférées des fans, mais considérez cela comme le cours obligatoire que vous suivez à contrecœur pour obtenir votre diplôme.

Les statistiques sont une grande partie des tests A/B. Heureusement, les outils de test A/B et les logiciels de test fractionné ont facilité le travail d'un optimiseur, mais une compréhension de base de ce qui se passe dans les coulisses est cruciale pour analyser ultérieurement les résultats de vos tests.

Alex Birkett, Growth Marketing Manager chez HubSpot, explique :

Alex Birkett, HubSpot

"Les statistiques ne sont pas un nombre magique de conversions ou un 'Succès !" binaire. ou 'Échec' chose. C'est un processus utilisé pour prendre des décisions dans l'incertitude et pour réduire les risques en essayant de réduire le flou sur ce que sera le résultat d'une décision donnée.

« Avec cela à l'esprit, je pense qu'il est très nécessaire de connaître les bases : qu'est-ce qu'une moyenne, une variance, un échantillonnage, un écart-type, une régression vers la moyenne et ce qui constitue un échantillon « représentatif ». En outre, lorsque vous débutez avec des tests A/B, il est utile de mettre en place des garde-corps spécifiques pour atténuer autant que possible les erreurs humaines. »

Qu'est-ce que c'est ?

La moyenne est la moyenne. Votre but est de trouver une moyenne représentative de l'ensemble.

Par exemple, supposons que vous essayez de trouver le prix moyen des jeux vidéo. Vous n'allez pas ajouter le prix de chaque jeu vidéo dans le monde et le diviser par le nombre de tous les jeux vidéo dans le monde. Au lieu de cela, vous isolerez un petit échantillon représentatif de tous les jeux vidéo du monde.

Vous pourriez finir par trouver le prix moyen de quelques centaines de jeux vidéo. Si vous avez sélectionné un échantillon représentatif, le prix moyen de ces deux cents jeux vidéo devrait être représentatif de tous les jeux vidéo dans le monde.

Qu'est-ce que l'échantillonnage ?

Plus la taille de l'échantillon est grande, moins il y aura de variabilité, ce qui signifie que la moyenne est plus susceptible d'être exacte.

Donc, si vous augmentiez votre échantillon de deux cents jeux vidéo à deux mille jeux vidéo, vous auriez moins de variance et une moyenne plus précise.

Qu'est-ce que la variance ?

La variance est la variabilité moyenne. Essentiellement, plus la variabilité est élevée, moins la moyenne sera précise pour prédire un point de données individuel.

Alors, à quel point la moyenne est-elle proche du prix réel de chaque jeu vidéo individuel ?

Qu'est-ce que la signification statistique ?

En supposant qu'il n'y a pas de différence entre A et B, combien de fois verrez-vous l'effet par hasard ?

Plus le niveau de signification statistique est bas, plus il y a de chances que votre variante gagnante ne soit pas gagnante du tout.

En termes simples, un niveau de signification faible signifie qu'il y a de grandes chances que votre "gagnant" ne soit pas un vrai gagnant (c'est ce qu'on appelle un faux positif).

Sachez que la plupart des outils de test A/B et des logiciels de test A/B open source appellent la signification statistique sans attendre qu'une taille d'échantillon ou un moment prédéterminé soit atteint. C'est pourquoi vous remarquerez peut-être que votre test oscille entre statistiquement significatif et statistiquement non significatif.

Peep Laja, fondateur de l'Institut CXL, souhaite que davantage de personnes comprennent vraiment la signification statistique des tests A/B et pourquoi c'est important :

Peep Laja, Institut CXL

« La signification statistique n'est pas égale à la validité – ce n'est pas une règle d'arrêt. Lorsque vous atteignez une signification statistique de 95 % ou plus, cela signifie très peu avant que deux autres conditions plus importantes ne soient remplies :

"1. Il y a suffisamment de taille d'échantillon, que vous déterminez à l'aide de calculatrices de taille d'échantillon. Cela signifie que suffisamment de personnes ont participé à l'expérience pour que nous puissions conclure quoi que ce soit.

« 2. Le test a duré suffisamment longtemps pour que l'échantillon soit représentatif (et pas trop longtemps pour éviter la pollution de l'échantillon). Dans la plupart des cas, vous voudrez exécuter vos tests sur deux, trois ou quatre semaines, selon la rapidité avec laquelle vous pouvez obtenir l'échantillon nécessaire. »

Qu'est-ce que la régression vers la moyenne ?

Vous remarquerez peut-être des fluctuations extrêmes au début de votre test A/B.

La régression vers la moyenne est le phénomène qui dit que si quelque chose est extrême lors de sa première mesure, il sera probablement plus proche de la moyenne lors de sa deuxième mesure.

Si la seule raison pour laquelle vous appelez un test est qu'il a atteint une signification statistique, vous pourriez voir un faux positif. Votre variation gagnante régressera probablement vers la moyenne au fil du temps.

Qu'est-ce que la puissance statistique ?

En supposant qu'il y ait une différence entre A et B, à quelle fréquence verrez-vous l'effet ?

Plus le niveau de puissance est bas, plus le risque qu'un gagnant ne soit pas reconnu est grand. Plus le niveau de puissance est élevé, plus le risque qu'un gagnant ne soit pas reconnu est faible. En réalité, tout ce que vous devez savoir, c'est qu'une puissance statistique de 80 % est la norme pour la plupart des outils de test A/B et/ou tout service de test fractionné.

Ton Wesseling, fondateur de Online Dialogue, souhaite que plus de gens connaissent la puissance statistique :

Ton Wesseling, Dialogue en ligne

"Beaucoup de gens s'inquiètent des faux positifs. Nous nous inquiétons beaucoup plus des faux négatifs. Pourquoi mener des expériences où les chances de trouver la preuve que votre changement positif a un impact sont vraiment faibles ? »

Que sont les menaces de validité externe ?

Il existe des facteurs externes qui menacent la validité de vos tests. Par exemple:

- Soldes Black Friday Cyber Monday (BFCM)

- Une mention presse positive ou négative

- Un lancement majeur de campagne payante

- Le jour de la semaine

- Les saisons changeantes

L'un des exemples de tests A/B les plus courants où les menaces de validité externes ont un impact sur vos résultats est lors d'événements saisonniers. Supposons que vous deviez effectuer un test en décembre. Les grandes vacances de magasinage signifieraient une augmentation du trafic pour votre magasin au cours de ce mois. Vous constaterez peut-être en janvier que votre gagnant de décembre ne fonctionne plus bien.

Pourquoi?

A cause d'une menace de validité externe : les vacances.

Les données sur lesquelles vous avez fondé votre décision de test étaient une anomalie. Lorsque les choses se calmeront en janvier, vous pourriez être surpris de voir votre gagnant perdre.

Vous ne pouvez pas éliminer les menaces de validité externe, mais vous pouvez les atténuer en exécutant des tests pendant des semaines complètes (par exemple, ne démarrez pas un test un lundi et ne le terminez pas un vendredi), y compris différents types de trafic (par exemple, ne t testez exclusivement le trafic payant, puis diffusez les résultats sur toutes les sources de trafic), et gardez à l'esprit les menaces potentielles.

S'il vous arrive d'effectuer un test pendant une saison de magasinage chargée, comme BFCM, ou à travers une menace de validité externe majeure, vous voudrez peut-être lire notre Guide complet des tests A/B.

Comment mettre en place un test A/B

Passons en revue un petit tutoriel sur les tests A/B. Avant de tester quoi que ce soit, vous devez avoir une hypothèse solide. (Génial, nous venons de terminer le cours de mathématiques et maintenant nous passons aux sciences.)

Ne vous inquiétez pas, ce n'est pas compliqué. Fondamentalement, vous devez tester une hypothèse, pas une idée. Une hypothèse est mesurable, aspire à résoudre un problème de conversion spécifique et se concentre sur les informations plutôt que sur les gains.

Vous devez A/B tester une hypothèse, pas une idée.

Chaque fois que j'écris une hypothèse, j'utilise une formule empruntée au kit d'hypothèses de Craig Sullivan :

- Parce que vous voyez [insert data/feedback from research]

- Vous vous attendez à ce que [le changement que vous testez] entraîne [l'impact que vous anticipez] et

- Vous mesurerez cela à l'aide de [données métriques]

Facile, non ? Il vous suffit de remplir les blancs et votre idée de test se transforme en hypothèse.

Choisir un outil de test A/B

Vous pouvez maintenant commencer à choisir un outil de test A/B ou un service de test fractionné. Le plus souvent, vous penserez d'abord à Google Optimize, Optimizely et VWO.

Toutes sont de bonnes options sûres.

- Google Optimiser. Gratuit, à l'exception de certaines limitations multivariées, qui ne devraient pas vraiment vous affecter si vous débutez. Cela fonctionne bien lors des tests A/B de Google Analytics, ce qui est un plus.

- De façon optimale. Facile à mettre en place des tests mineurs, même sans compétences techniques. Stats Engine facilite l'analyse des résultats des tests. En règle générale, Optimizely est l'option la plus chère des trois.

- VWO. VWO a SmartStats pour faciliter l'analyse. De plus, il dispose d'un excellent éditeur WYSIWYG pour les débutants. Chaque plan VWO est livré avec des cartes thermiques, des enquêtes sur site, des analyses de formulaire, etc.

Nous proposons également des outils de test A/B dans l'App Store de Shopify qui pourraient vous être utiles.

Une fois que vous avez sélectionné un outil de test A/B ou un logiciel de test fractionné, remplissez le formulaire d'inscription et suivez les instructions fournies. Le processus varie d'un outil à l'autre. En règle générale, cependant, il vous sera demandé d'installer un extrait sur votre site et de définir des objectifs.

Comment analyser les résultats des tests A/B

Vous vous souvenez quand j'ai dit que l'écriture d'une hypothèse déplace l'attention des victoires vers les idées ? Krista Seiden, Analytics Advocate et Product Manager chez Google, explique ce que cela signifie :

Krista Seiden, Google

"L'aspect le plus négligé des tests A/B est d'apprendre de vos perdants. En fait, dans les programmes d'optimisation que j'ai exécutés, j'ai pris l'habitude de publier un "rapport d'échecs" dans lequel j'appelle certains des plus gros perdants du trimestre et ce que nous avons appris d'eux.

"L'un de mes favoris de tous les temps était issu d'une campagne qui a duré des mois. Nous avons pu nous faufiler dans les tests de page de destination juste avant sa mise en ligne, et c'est une bonne chose que nous ayons fait, car cela a lamentablement échoué. Si nous avions réellement lancé la page telle qu'elle était, nous aurions eu un impact significatif sur le résultat net. Non seulement nous avons fini par économiser une tonne d'argent à l'entreprise, mais nous avons pu creuser et faire des hypothèses (que nous avons ensuite testées) sur les raisons pour lesquelles la nouvelle page avait si mal fonctionné, et cela nous a fait de meilleurs spécialistes du marketing et plus performants. dans les campagnes futures.

Si vous élaborez votre hypothèse correctement, même un perdant est un gagnant, car vous obtiendrez des informations que vous pourrez utiliser pour de futurs tests et dans d'autres domaines de votre entreprise. Ainsi, lorsque vous analysez les résultats de votre test, vous devez vous concentrer sur les informations, et non sur la réussite ou la perte du test. Il y a toujours quelque chose à apprendre, toujours quelque chose à analyser. Ne rejetez pas les perdants !

Si vous élaborez votre hypothèse correctement, même un perdant est un gagnant.

La chose la plus importante à noter ici est le besoin de segmentation. Un test peut être globalement perdant, mais il y a de fortes chances qu'il ait bien fonctionné avec au moins un segment. Qu'est-ce que j'entends par segment ?

- Nouveaux visiteurs

- Visiteurs de retour

- Visiteurs iOS

- Visiteurs Android

- Visiteurs Chrome

- Visiteurs de safaris

- Visiteurs de bureau

- Visiteurs sur tablette

- Visiteurs de recherche organique

- Visiteurs payants

- Visiteurs des réseaux sociaux

- Acheteurs connectés

Vous avez l'idée, non?

Lorsque vous regardez les résultats dans votre outil de test, vous regardez toute la boîte de bonbons. Ce que vous devez faire est de séparer les Smarties par couleur afin de pouvoir manger les rouges en dernier. Je veux dire, pour que vous puissiez découvrir des informations plus profondes et segmentées.

Il y a de fortes chances que l'hypothèse ait été prouvée parmi certains segments. Cela vous dit aussi quelque chose.

L'analyse ne se limite pas à savoir si le test a été gagnant ou perdant. Segmentez vos données pour trouver des informations cachées sous la surface.

Les outils de test A/B ne feront pas l'analyse pour vous, c'est donc une compétence importante à développer au fil du temps.

Ebook gratuit : analyse du commerce électronique pour les débutants

Découvrez quelles mesures sont essentielles pour établir et développer votre activité en ligne. Ce guide gratuit est la première étape idéale pour en savoir plus sur l'analyse du commerce électronique.

Recevez Ecommerce Analytics for Beginners directement dans votre boîte de réception.

Vous y êtes presque : veuillez saisir votre adresse e-mail ci-dessous pour obtenir un accès instantané.

Nous vous enverrons également des mises à jour sur les nouveaux guides pédagogiques et les histoires de réussite de la newsletter Shopify. Nous détestons le SPAM et nous nous engageons à protéger votre adresse e-mail.

Comment archiver les tests A/B passés

Disons que vous exécutez votre premier test demain. Dans deux ans demain, vous souviendrez-vous des détails de ce test ? Pas probable.

C'est pourquoi il est important d'archiver les résultats de vos tests A/B. Sans une archive bien entretenue, toutes ces informations que vous obtenez seront perdues. De plus, je ne plaisante pas, il est très facile de tester deux fois la même chose si vous n'archivez pas.

Il n'y a pas de "bonne" façon de faire cela, cependant. Vous pouvez utiliser un outil comme Projects ou Effective Experiments, ou vous pouvez utiliser Excel. C'est vraiment à vous de décider, surtout quand vous ne faites que commencer. Assurez-vous simplement de suivre :

- L'hypothèse

- Captures d'écran du contrôle et de la variation

- Qu'il ait gagné ou perdu

- Aperçus obtenus grâce à l'analyse

Au fur et à mesure que vous grandissez, vous vous remercierez d'avoir conservé cette archive. Non seulement cela vous aidera, mais également les nouvelles recrues et les conseillers/parties prenantes.

Processus de test A/B des pros

Maintenant que vous avez suivi un didacticiel de test A/B standard, examinons les processus exacts des professionnels d'entreprises telles que Google et HubSpot.

Liste de lecture gratuite : optimisation de la conversion pour les débutants

Transformez davantage de visiteurs de votre site Web en clients en suivant un cours accéléré sur l'optimisation des conversions. Accédez à notre liste gratuite et organisée d'articles à fort impact ci-dessous.

Recevez notre liste de lecture sur l'optimisation des conversions directement dans votre boîte de réception.

Vous y êtes presque : veuillez saisir votre adresse e-mail ci-dessous pour obtenir un accès instantané.

Nous vous enverrons également des mises à jour sur les nouveaux guides pédagogiques et les histoires de réussite de la newsletter Shopify. Nous détestons le SPAM et nous nous engageons à protéger votre adresse e-mail.

Krista Seiden, Google

Mon processus étape par étape pour les tests A/B Web et d'applications commence par une analyse - à mon avis, c'est le cœur de tout bon programme de test. Dans la phase d'analyse, l'objectif est d'examiner vos données d'analyse, vos données d'enquête ou UX, ou toute autre source d'informations sur les clients dont vous pourriez disposer afin de comprendre où se trouvent vos opportunités d'optimisation.

Une fois que vous avez un bon pipeline d'idées dès l'étape d'analyse, vous pouvez passer à l'hypothèse de ce qui pourrait mal se passer et comment vous pourriez potentiellement corriger ou améliorer ces domaines d'optimisation.

Ensuite, il est temps de construire et d'exécuter vos tests. Assurez-vous de les exécuter pendant une durée raisonnable (je suis par défaut sur deux semaines pour m'assurer que je tiens compte des changements ou des anomalies d'une semaine à l'autre), et lorsque vous avez suffisamment de données, analysez vos résultats pour déterminer votre gagnant.

Il est également important de prendre du temps à ce stade pour analyser également les perdants. Que pouvez-vous apprendre de ces variations ?

Enfin, et vous n'atteindrez peut-être cette étape qu'une fois que vous aurez passé du temps à jeter les bases d'un programme d'optimisation solide, il est temps de vous pencher sur la personnalisation. Cela ne nécessite pas nécessairement un ensemble d'outils sophistiqués, mais peut plutôt provenir des données dont vous disposez sur vos utilisateurs.

La personnalisation marketing peut être aussi simple que de cibler le bon contenu aux bons endroits ou aussi complexe que le ciblage basé sur les actions individuelles des utilisateurs. Ne sautez pas tout d'un coup sur la personnalisation. Assurez-vous de passer suffisamment de temps pour bien maîtriser les bases.

Alex Birkett, HubSpot

À un niveau élevé, j'essaie de suivre ce processus :

- Collectez des données et assurez-vous que les implémentations analytiques sont exactes.

- Analysez les données et trouvez des idées.

- Transformez les informations en hypothèses.

- Établissez des priorités en fonction de l'impact et de la facilité, et maximisez l'allocation des ressources (en particulier les ressources techniques).

- Exécutez un test (en suivant les meilleures pratiques statistiques au meilleur de mes connaissances et de mes capacités).

- Analyser les résultats et mettre en œuvre ou non selon les résultats.

- Itérez en fonction des résultats et répétez.

Plus simplement : rechercher, tester, analyser, répéter.

Bien que ce processus puisse dévier ou changer en fonction du contexte (Est-ce que je teste une fonctionnalité de produit critique pour l'entreprise ? Un article de blog CTA ? Quel est le profil de risque et l'équilibre entre l'innovation et l'atténuation des risques ?), il est assez applicable à n'importe quelle taille ou type d'entreprise.

Le fait est que ce processus est agile, mais il collecte également suffisamment de données, à la fois des commentaires qualitatifs des clients et des analyses quantitatives, pour pouvoir proposer de meilleures idées de test et mieux les hiérarchiser afin que vous puissiez générer du trafic vers votre boutique en ligne.

Ton Wesseling, Dialogue en ligne

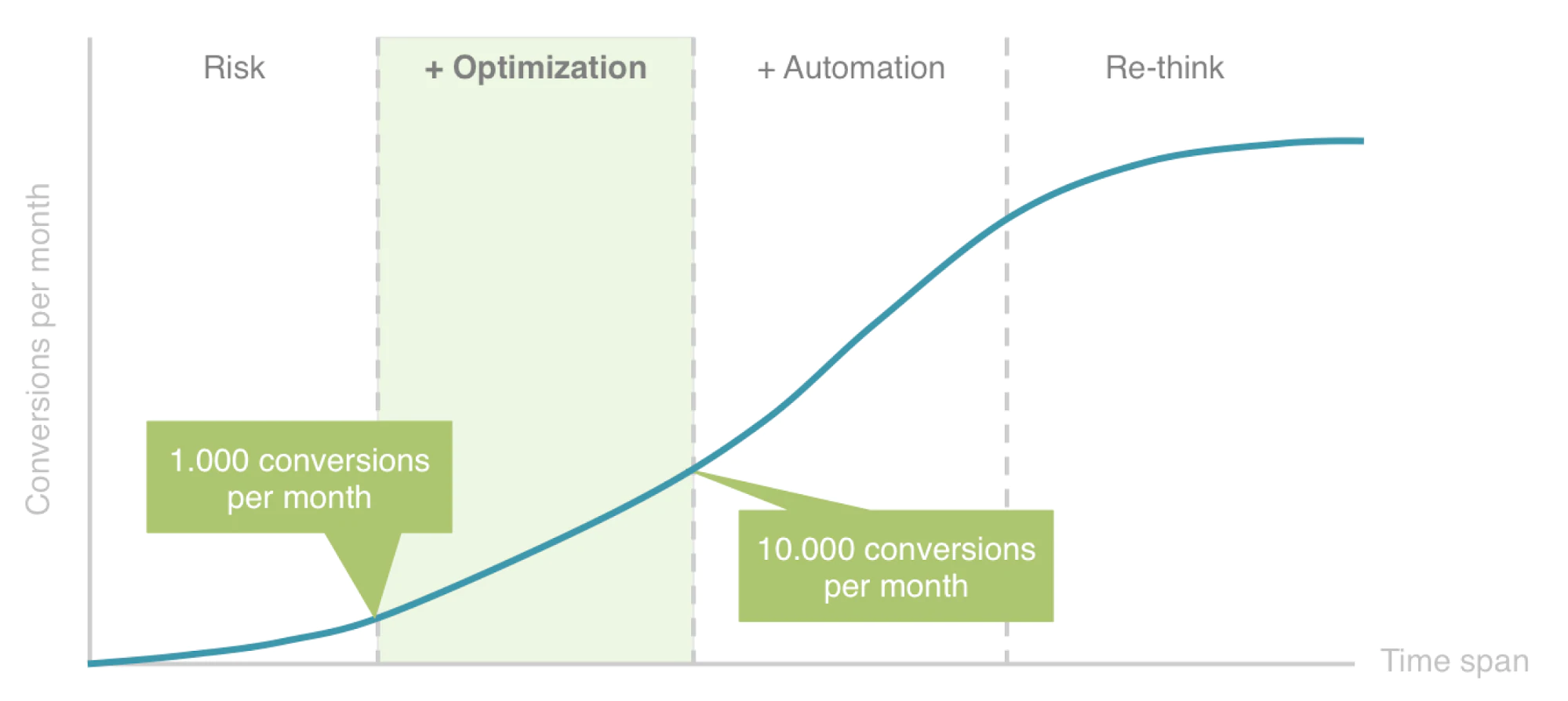

La première question à laquelle nous répondons toujours lorsque nous voulons optimiser un parcours client est : où ce produit ou service s'intègre-t-il dans le modèle ROAR que nous avons créé chez Online Dialogue ? Êtes-vous toujours dans la phase de risque où nous pourrions faire beaucoup de recherches mais ne pouvons pas valider nos résultats par le biais d'expériences en ligne de test A/B (moins de 1 000 conversions par mois), ou êtes-vous dans la phase d'optimisation ? Ou même au dessus ?

- Phase de risque : beaucoup de recherches , qui se traduiront par n'importe quoi, d'un pivot de modèle d'affaires à une toute nouvelle proposition de conception et de valeur.

- Phase d'optimisation : grandes expérimentations qui vont optimiser la proposition de valeur et le business model.

- Phase d'optimisation : petites expériences pour valider les hypothèses de comportement des utilisateurs, ce qui permettra d'accumuler des connaissances pour des changements de conception plus importants.

- A utomation : il vous reste encore du pouvoir d'expérimentation (visiteurs), ce qui signifie que votre plein potentiel de test n'est pas nécessaire pour valider votre parcours utilisateur. Ce qui reste devrait être utilisé pour exploiter, pour grandir plus vite maintenant (sans se concentrer sur les apprentissages à long terme). Cela pourrait être automatisé en exécutant des bandits/en utilisant des algorithmes.

- Repensez : vous arrêtez d'ajouter beaucoup de recherches, à moins qu'il ne s'agisse d'un pivot vers quelque chose de nouveau.

Ainsi, les tests A / B Web ou d'application ne sont importants que dans la phase d'optimisation de ROAR et au-delà (jusqu'à ce qu'ils soient repensés).

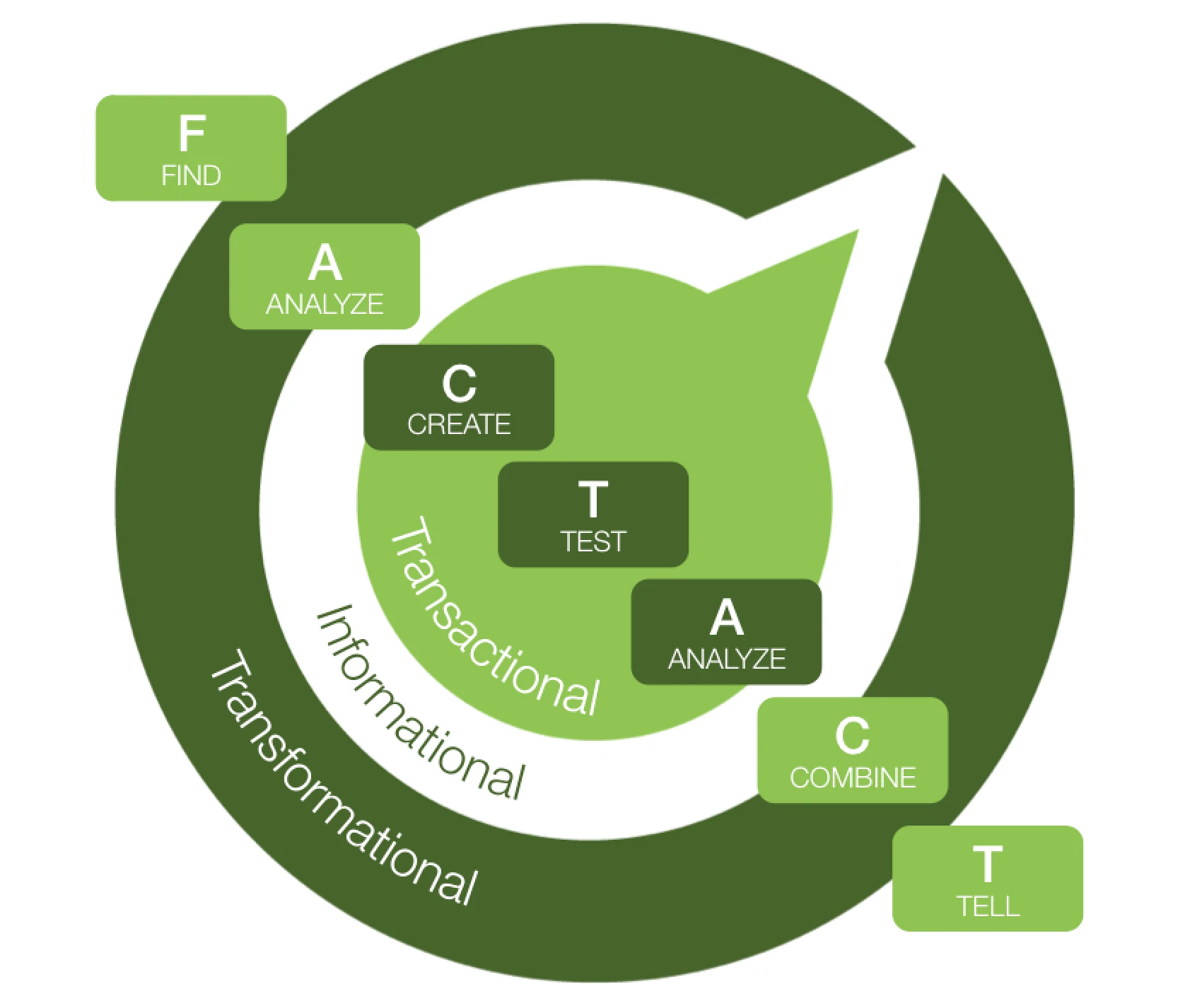

Notre approche pour mener des expériences est le modèle FACT & ACT :

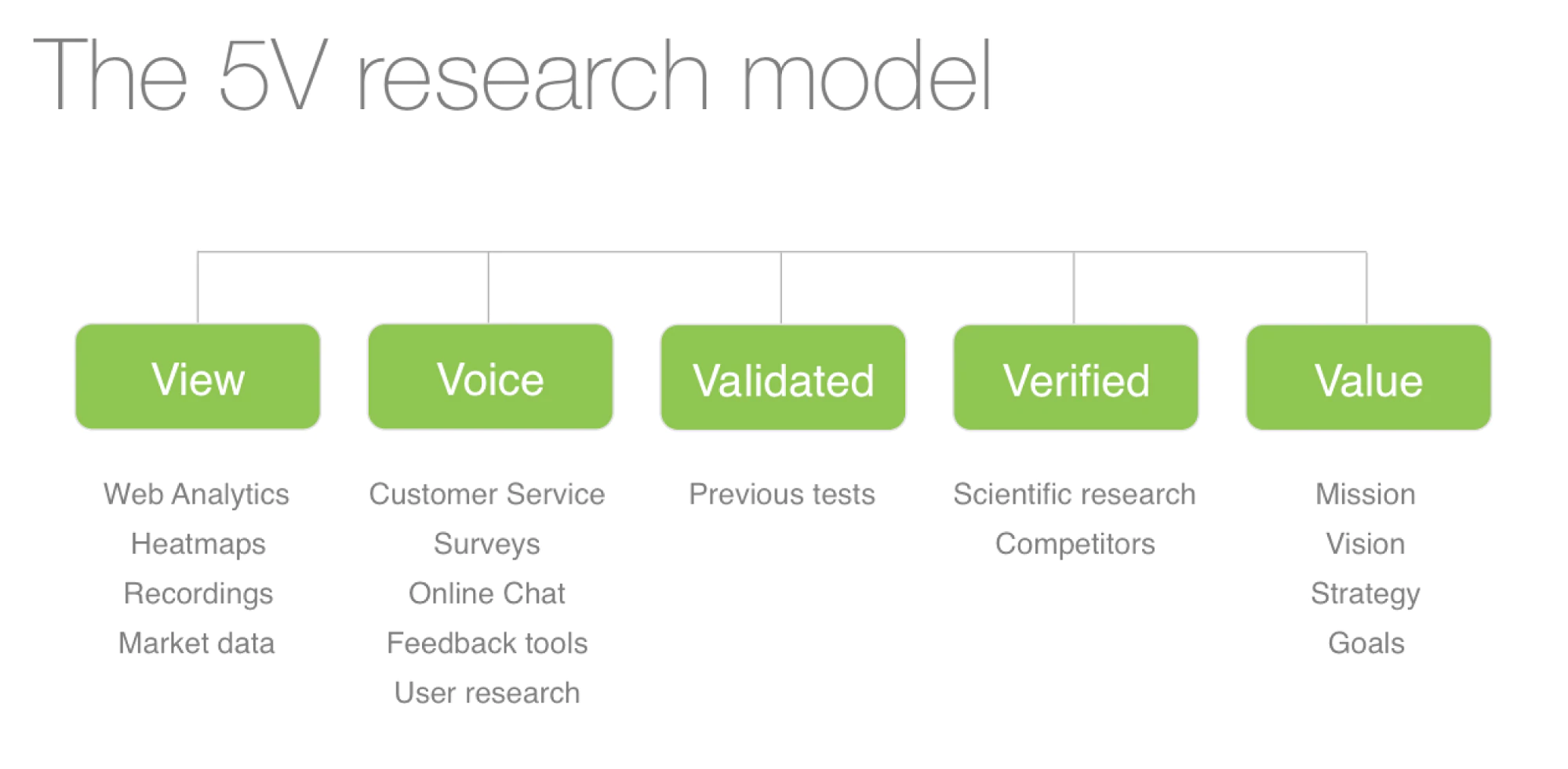

La recherche que nous effectuons est basée sur notre modèle 5V :

Nous rassemblons toutes ces informations pour proposer une hypothèse principale fondée sur la recherche, qui conduira à des sous-hypothèses qui seront hiérarchisées en fonction des données recueillies par le biais de tests A/B sur ordinateur ou sur mobile. Plus la probabilité que l'hypothèse soit vraie est élevée, plus elle sera classée.

Une fois que nous savons si notre hypothèse est vraie ou fausse, nous pouvons commencer à combiner les apprentissages et prendre des mesures plus importantes en repensant/réalignant de plus grandes parties du parcours client. Cependant, à un moment donné, toutes les implémentations gagnantes conduiront à un maximum local. Ensuite, vous devez franchir une étape plus importante pour pouvoir atteindre un maximum mondial potentiel.

Et, bien sûr, les principaux apprentissages seront diffusés dans toute l'entreprise, ce qui conduit à toutes sortes d'optimisations et d'innovations plus larges basées sur vos connaissances de première partie validées.

Faites-vous du marketing auprès d'un public international? Découvrez comment simplifier ce processus grâce à la pseudo-localisation.

Julia Starostenko, Shopify

Le but d'une expérience est de valider que la modification d'une page Web existante aura un impact positif sur l'entreprise.

Avant de commencer, il est important de déterminer si l'exécution d'une expérience est vraiment nécessaire. Considérez le scénario suivant : il y a un bouton avec un taux de clic extrêmement faible. Il serait presque impossible de diminuer les performances de ce bouton. Il n'est donc pas nécessaire de valider l'efficacité d'une proposition de modification du bouton (c'est-à-dire d'effectuer une expérience).

De même, si la modification proposée pour le bouton est petite, cela ne vaut probablement pas la peine de passer du temps à configurer, exécuter et démonter une expérience. Dans ce cas, les modifications doivent simplement être déployées pour tout le monde et les performances du bouton peuvent être surveillées.

S'il est déterminé que l'exécution d'une expérience serait en fait bénéfique, l'étape suivante consiste à définir les mesures commerciales qui devraient être améliorées (par exemple, augmenter le taux de conversion d'un bouton). Then we ensure that proper data collection is in place.

Once this is complete, the audience is randomly run split testing between two groups; one group is shown the existing version of the button while the other group gets the new version. The conversion rate of each audience is monitored, and once statistical significance is reached, the results of the experiment are determined.

Peep Laja, Institut CXL

A/B testing is a part of a bigger conversion optimization picture. In my opinion it's 80% about the research and only 20% about testing. Conversion research will help you determine what to test to begin with.

My process typically looks like this (a simplified summary):

- Effectuez une recherche de conversion à l'aide d'un framework tel que ResearchXL pour identifier les problèmes sur votre site.

- Choisissez un problème hautement prioritaire (celui qui affecte une grande partie des utilisateurs et qui est un problème grave) et réfléchissez à autant de solutions que possible à ce problème. Informez votre processus d'idéation avec vos informations sur la recherche de conversion. Déterminez sur quel appareil vous souhaitez exécuter le test (vous devez exécuter un test A/B mobile séparément du bureau).

- Déterminez le nombre de variantes que vous pouvez tester (en fonction de votre niveau de trafic/de transaction), puis choisissez une ou deux meilleures idées de solution à tester par rapport au contrôle.

- Wireframez les traitements exacts (rédigez la copie, apportez les modifications de conception, etc.) Selon l'étendue des modifications, vous devrez peut-être également inclure un concepteur pour concevoir de nouveaux éléments.

- Demandez à votre développeur front-end d'implémenter les traitements dans votre outil de test. Configurez les intégrations nécessaires (Google Analytics), définissez des objectifs appropriés.

- Effectuez une QA sur le test (les tests cassés sont de loin le plus grand tueur de tests A/B) pour vous assurer qu'il fonctionne avec chaque combo navigateur/appareil.

- Lancez le test !

- Une fois le test terminé, effectuez une analyse post-test.

- En fonction du résultat, implémentez le gagnant, réitérez les traitements ou testez autre chose.

Webinaire gratuit :

Commercialisation 101

Vous avez du mal à augmenter vos ventes ? Apprenez à passer du premier jour à la première vente dans cette formation gratuite.

Optimisez les tests A/B pour votre entreprise

Vous avez le processus, vous avez le pouvoir ! Alors, lancez-vous, procurez-vous le meilleur logiciel de test A/B et commencez à tester votre magasin. Avant que vous ne vous en rendiez compte, ces informations ajouteront à plus d'argent dans la banque de vous.

Si vous souhaitez continuer à en apprendre davantage sur l'optimisation, envisagez de suivre un cours gratuit, tel que les tests A/B d'Udacity par Google. Vous pouvez en savoir plus sur les tests A/B d'applications Web et mobiles pour renforcer vos compétences en matière d'optimisation.