Qu'est-ce que le trafic de robots ? Comment empêcher les robots de trafic de causer des ravages

Publié: 2021-02-08Le trafic de bot est tout trafic Internet provenant de bots automatisés. Ces robots peuvent effectuer des tâches plus rapidement que n'importe quel humain, ce qui les rend très efficaces et populaires.

Avec tant d'incompréhension sur le trafic des bots, nous examinons les différents robots impliqués et ce que cela signifie pour votre site Web.

Dans un monde où des milliards d'utilisateurs interagissent en ligne chaque jour, Internet peut sembler un endroit mouvementé. Avec des utilisateurs qui aiment les photos, retweetent des messages et votent pour des commentaires positifs, la quantité de trafic Web quotidien sur Internet atteint un niveau record.

Mais combien de ces visiteurs sont réellement réels ?

Avec de plus en plus de robots lancés sur Internet chaque jour, est-ce une bonne chose pour les propriétaires et les utilisateurs de sites Web, ou simplement un autre désagrément ?

Afin de bien comprendre ce qu'est le trafic de bots, nous devons d'abord explorer les différents types de bots automatisés et ce qu'ils font.

Qu'est-ce que le trafic de robots ?

Le trafic de bot peut être défini comme tout trafic Internet en ligne qui n'est pas généré par un humain . Cela signifie généralement que le trafic provient d'une sorte de script automatisé ou de programme informatique conçu pour faire gagner à l'utilisateur le temps d'effectuer toutes les tâches manuellement. Bien que ces robots essaient d'imiter le comportement humain, ils ne sont certainement pas humains.

Ces robots automatisés peuvent faire des choses simples comme cliquer sur des liens et télécharger des images, ou des tâches compliquées telles que gratter ou remplir des formulaires. Quoi qu'ils soient faits pour faire, ils le font généralement à grande échelle et fonctionnent presque sans arrêt. Si vous avez déjà publié une image sur des réseaux sociaux comme Instagram ou Facebook et que vous avez reçu des centaines de likes en quelques secondes, il s'agit probablement de robots.

Avec plus de 50% du trafic Internet estimé à être du trafic de bots, il est clair que les bots peuvent être trouvés presque partout et sur pratiquement tous les sites Web.

Pour vous donner une idée des différents types de bots, voici une brève description des bons bots et de ce qu'ils font, ainsi que des mauvais bots.

Le bon trafic de bot

Bien que le trafic de bot automatisé ait une réputation assez négative de la part des webmasters, il existe en fait une gamme de bots légitimes qui essaient seulement d'aider.

Bots des moteurs de recherche

Le premier type de trafic de bots, et le plus évident, doit être celui des bots des moteurs de recherche. Ces robots Internet explorent autant que possible le Web et aident les propriétaires de sites Web à faire figurer leurs sites Web sur les moteurs de recherche tels que la recherche Google, Yahoo et Bing. Leurs demandes peuvent être automatisées et répertoriées comme trafic de bot, mais ces bots sont certainement de bons bots.

Robots de surveillance

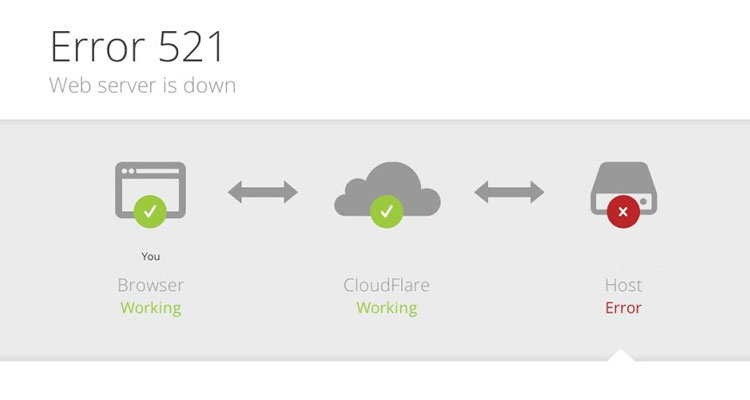

Si vous possédez un site Web, s'assurer que votre site est sain et toujours en ligne est souvent une priorité pour de nombreux propriétaires. Pour aider les utilisateurs à garantir que leur site est toujours accessible, il existe une gamme de robots de surveillance de site Web qui ping automatiquement votre site pour s'assurer qu'il est toujours en ligne. Si quelque chose tombe en panne ou si votre site Web se déconnecte, vous en serez immédiatement averti et pourrez faire quelque chose à ce sujet.

Crawlers SEO

Essayer d'amener votre site au premier rang des moteurs de recherche peut être extrêmement difficile, surtout lorsque vous n'avez pas beaucoup d'informations. Heureusement, il existe une gamme de logiciels qui peuvent vous aider à améliorer vos efforts de référencement en explorant votre site et vos concurrents pour voir pour quoi vous vous classez et dans quelle mesure. Les webmasters peuvent ensuite utiliser ces données pour améliorer leur visibilité de recherche et améliorer leur trafic Web organique.

Bots du droit d'auteur

S'assurer que personne n'a volé vos images et les a utilisées comme les siennes peut être une tâche difficile. Avec autant de sites Web à vérifier en permanence, la seule solution sensée est de faire en sorte qu'un bot automatisé le fasse. Ces robots Web parcourent le Web en recherchant des images spécifiques pour s'assurer que personne n'utilise illégalement un contenu protégé par des droits d'auteur sans autorisation.

Le trafic de mauvais robots

Contrairement aux bons robots que nous venons de mentionner ci-dessus, les mauvais robots font de très mauvaises choses à votre site Web et peuvent causer beaucoup de dégâts s'ils sont laissés en liberté. Il peut s'agir de n'importe quel type d'attaque de bot provenant de l'envoi de faux trafic et de trafic de spam ou de quelque chose de beaucoup plus perturbateur comme la fraude publicitaire.

Grattoirs Web

Les grattoirs Web sont des robots Internet ennuyeux qui grattent les sites Web à la recherche d'informations précieuses telles que l'adresse e-mail et les coordonnées. Dans d'autres cas, ils voleront du contenu et des images de sites Web et les utiliseront sur leur propre site ou sur des comptes de réseaux sociaux sans autorisation. Ils ne profitent à personne en dehors de la personne qui les utilise pour récupérer des données.

Bots de spam

Si vous avez déjà reçu un e-mail ou un commentaire de blog bizarre de la part de quelqu'un, il y a de fortes chances qu'un robot de spam l'ait laissé. Ces robots adorent laisser des messages générés (qui n'ont souvent aucun sens) sur le blog d'un site Web. Ils remplissent également les formulaires de contact sur les sites Web et les propriétaires de spam avec des messages promotionnels.

Réseaux DDoS

L'un des robots malveillants les plus anciens et les plus meurtriers doit être le robot DDoS. Connus sous le nom de robots à déni de service distribué, ces robots sont souvent installés sur les PC des victimes sans méfiance et sont utilisés pour cibler un site Web ou un serveur particulier dans le but de les mettre hors ligne.

Connu sous le nom d'attaque DDoS, il y a eu de nombreux rapports dans le passé d'entre eux causant de graves dommages financiers à des sites qui ont fini par être hors ligne pendant plusieurs jours.

Analyseurs de vulnérabilité

Ces robots peuvent sembler de bons robots à partir des journaux de serveur d'un site Web, mais ce n'est malheureusement pas le cas. Il existe une gamme de robots malveillants qui analyseront des millions de sites à la recherche de vulnérabilités et les signaleront à leur créateur. Contrairement aux véritables robots qui informeraient le propriétaire du site Web, ces robots malveillants sont spécifiquement conçus pour faire rapport à une personne qui vendra probablement les informations ou les utilisera elle-même pour pirater des sites Web.

Cliquez sur Bots de fraude

Inconnu de beaucoup, il existe de nombreux robots sophistiqués qui produisent une énorme quantité de trafic de robots malveillants ciblant spécifiquement les publicités payantes. Contrairement aux robots qui produisent du trafic indésirable sur le site Web, ces robots se livrent à ce que l'on appelle la fraude publicitaire.

Responsable des clics frauduleux sur les publicités payantes, ce trafic non humain coûte des milliards aux annonceurs chaque année et est souvent déguisé en trafic légitime. Sans un bon logiciel de détection de bots, cette activité de bot peut coûter aux annonceurs une grande partie de leur budget publicitaire.

Comment les robots de trafic peuvent-ils être mauvais pour les sites Web ?

Maintenant que vous connaissez les différents types de bots bons et malveillants, comment le trafic de bots peut-il être mauvais pour votre site ?

La chose importante à comprendre à propos des bots est que la plupart des scripts et des programmes sont conçus pour faire un travail plusieurs fois. Le créateur du bot veut évidemment que le travail soit fait le plus rapidement possible, mais cela peut poser de nombreux problèmes pour votre site.

Le plus gros problème est que si un robot demande en permanence des informations à votre site, cela peut entraîner un ralentissement global. Cela signifie que le site sera lent pour tous ceux qui y accèdent, ce qui peut causer d'énormes problèmes si, par exemple, vous êtes une boutique en ligne.

Des demandes de grattage cohérentes peuvent également fausser les KPI importants et les données Google Analytics telles que votre taux de rebond.

Dans les cas extrêmes, trop de trafic de bots peut en fait mettre l'ensemble de votre site Web hors ligne, ce qui n'est évidemment pas bon. Mais heureusement, ce n'est que dans des circonstances extrêmes, la plupart du temps, les effets du trafic de bots sur votre site Web sont très subtils.

Avoir beaucoup de trafic de bots sur votre site Web entraînera généralement des choses telles que :

- Plus de pages vues

- Utilisation plus élevée de la bande passante

- Google Analytics incorrect

- Qualité des données marketing faussée

- Baisse des conversions

- Emails indésirables

- Temps de chargement plus longs

- Coûts de serveur plus élevés

- Augmentation du taux de rebond

- Pression accrue sur les centres de données

Comment détecter le trafic de bots

Si vous souhaitez vérifier si votre site Web est affecté par le trafic de robots, le meilleur endroit pour commencer est Google Analytics.

Dans Google Analytics, vous pourrez voir toutes les métriques essentielles du site, telles que le temps moyen sur la page, le taux de rebond, le nombre de pages vues et d'autres données d'analyse. En utilisant ces informations, vous pouvez déterminer rapidement si les données d'analyse de votre site ont été faussées par le trafic des robots et dans quelle mesure.

Étant donné que vous ne pouvez pas voir les adresses IP des utilisateurs dans Google Analytics, vous devrez examiner ces métriques pour voir si elles ont du sens. Un temps très faible sur le site métrique est un indicateur clair que la plupart de vos visiteurs pourraient être des bots. Il suffit de quelques secondes à un bot Internet pour explorer une page Web avant qu'elle ne quitte et passe à sa prochaine cible.

Un autre endroit pour vérifier dans Google Analytics est la section des références pour vérifier que vous ne recevez pas de spam de référence. De nombreuses entreprises ciblent d'autres sites avec un bot personnalisé qui spammera l'URL de leur site Web.

Lorsqu'un webmaster vérifie son trafic de référence dans Google Analytics, il verra le nom du site Web et sera enclin à le visiter. Aussi grossier que cela puisse paraître, cela peut aider à générer beaucoup de visiteurs sur le site (principalement par curiosité !). Il peut ne pas sembler qu'ils nuisent à votre site Web, mais ils faussent en fait toutes vos mesures, gaspillent votre bande passante et encombrent votre serveur en général.

Comment arrêter le trafic de robots

Il est tout à fait possible de filtrer le trafic des robots malveillants et d'empêcher les robots automatisés de nuire à votre site Web, mais la solution dépendra du type de source de trafic qui affecte votre site. N'oubliez pas que tout le trafic de bots n'est pas mauvais, et bloquer les bots tels que les robots des moteurs de recherche n'est vraiment pas une bonne idée !

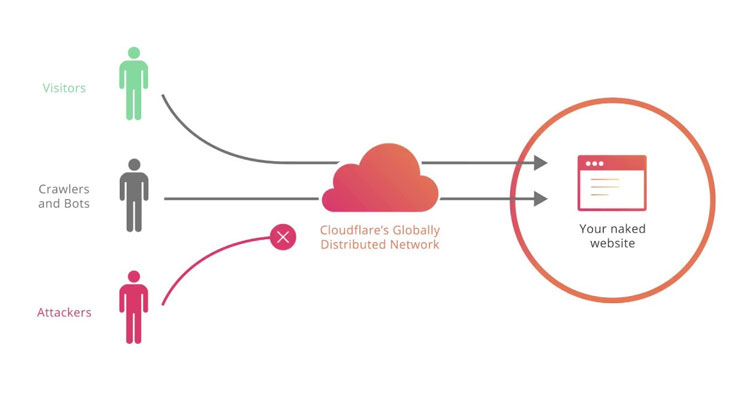

Si votre site Web est susceptible d'être gratté par des robots, des scanners de vulnérabilité et des robots de trafic automatisés, il y a de fortes chances que vous souhaitiez un filtrage des robots sous la forme d'un pare-feu ou d'un CAPTCHA. La meilleure façon de le faire est d'installer un service gratuit de filtrage de robots sur votre site Web appelé CloudFlare.

En plus d'être un réseau de diffusion de contenu (CDN), CloudFlare agit comme un pare-feu d'application entre le site Web et l'utilisateur, ce qui signifie qu'il ne permettra qu'aux utilisateurs légitimes d'accéder à votre site Web. Les utilisateurs suspects ne passeront pas et ne pourront pas accéder à votre site. Cela signifie qu'ils ne gaspilleront pas votre bande passante, ne ruineront pas vos analyses ou ne se feront pas voler votre contenu.

Un autre moyen utile de bloquer les robots consiste à utiliser le fichier txt des robots de votre site Web en le remplissant d'agents utilisateurs ou du nom réel des robots connus. Vous pouvez en savoir plus sur le blocage des robots dans le fichier txt robots de ce guide pratique. Bien sûr, cela ne fonctionne que si le robot respecte le fichier robots.txt, ce que font la plupart des bots authentiques. Si vous essayez de vous débarrasser d'un bad bot embêtant, l'utilisation de l'option CloudFlare mentionnée ci-dessus est la meilleure.

Cependant, si vous cherchez à protéger votre site Web contre d'autres formes de robots tels que les clics frauduleux et répétitifs sur vos annonces, vous aurez besoin d'autre chose.

Protégez vos annonces contre le trafic de robots malveillants

Toute personne qui diffuse des publicités au paiement par clic sur Google est soumise au trafic de bots. Avec autant de robots d'exploration qui scrutent constamment Google et ses résultats, ce n'est qu'une question de temps avant que ces robots ne cliquent sur vos annonces et ruinent vos données d'analyse et votre budget.

PPC Protect est un outil automatisé de détection de fraude publicitaire qui identifiera en temps réel toute fraude au clic sur vos publicités au paiement par clic.

En collectant de nombreuses données à chaque clic, le logiciel pourra détecter lorsqu'une adresse IP est suspecte et empêcher cet utilisateur particulier de voir vos annonces à l'avenir.

Cela aide à combattre le trafic de bots provenant des outils de référencement qui explorent Google et d'autres moteurs de recherche à la recherche d'annonces PPC. Avec beaucoup de ces outils là-bas, vous seriez surpris de voir combien de fois ils explorent les résultats de recherche à la recherche d'annonces et d'autres informations.

Pour protéger vos publicités du trafic de robots indésirables et des scrapers, cliquez ci-dessous pour vous inscrire à un essai gratuit de 14 jours de notre service.