Cara meningkatkan efisiensi perayapan dan pengindeksan tingkat perusahaan

Diterbitkan: 2023-07-13Enterprise SEO bermain dengan aturan yang berbeda.

Strategi yang mungkin berhasil untuk situs web kecil atau khusus tidak akan selalu berhasil dalam skala besar.

Jadi apa sebenarnya yang bisa terjadi ketika SEO perusahaan menjadi terlalu besar ?

Pada artikel ini, saya akan membagikan tiga contoh kehidupan nyata. Kemudian, Anda akan mempelajari penangkal potensial untuk manajemen SEO yang lebih efisien dalam skala besar.

Menghadapi dilema pengindeksan

Situs kecil cenderung tumbuh satu halaman pada satu waktu, menggunakan kata kunci sebagai blok bangunan strategi SEO.

Situs besar sering mengadopsi pendekatan yang lebih canggih, sangat bergantung pada sistem, aturan, dan otomatisasi.

Sangat penting untuk menyelaraskan SEO dengan tujuan bisnis. Mengukur kesuksesan SEO berdasarkan peringkat kata kunci atau lalu lintas mengarah pada konsekuensi negatif karena pengindeksan berlebihan.

Tidak ada rumus ajaib untuk menentukan jumlah optimal dari URL yang diindeks. Google tidak menetapkan batas atas.

Namun, titik awal yang baik adalah mempertimbangkan kesehatan corong SEO secara keseluruhan. Jika sebuah situs…

- Mendorong puluhan atau ratusan juta , atau bahkan miliaran URL ke Google

- Peringkat hanya untuk beberapa juta kata kunci

- Menerima kunjungan ke beberapa ribu halaman

- Mengonversi sebagian kecil dari ini (jika ada)

…maka itu merupakan indikasi yang baik bahwa Anda perlu mengatasi beberapa kebutuhan kesehatan SEO yang serius.

Memperbaiki masalah kebersihan situs apa pun sekarang harus mencegah masalah SEO yang lebih besar di kemudian hari.

Mari kita lihat tiga contoh SEO perusahaan nyata yang mengilustrasikan mengapa ini sangat penting.

Kasus 1: Konsekuensi dari pengindeksan konten berkualitas rendah secara berlebihan

Google memiliki sumber daya terbatas untuk perayapan dan pemrosesan web. Mereka memprioritaskan konten yang berharga bagi pengguna.

Google mungkin meng-crawl, tetapi tidak mengindeks, halaman yang dianggap tipis, duplikat, atau berkualitas rendah.

Kalau hanya beberapa halaman, tidak masalah. Namun jika tersebar luas, Google mungkin akan mengabaikan seluruh jenis halaman atau sebagian besar konten situs.

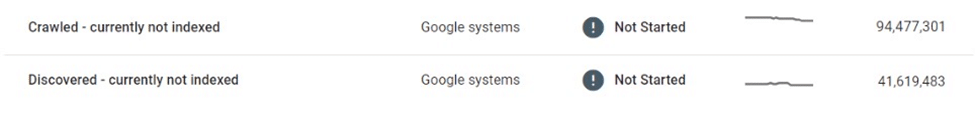

Dalam satu contoh, pasar e-niaga menemukan bahwa puluhan juta halaman cantumannya dipengaruhi oleh perayapan dan pengindeksan selektif.

Setelah merayapi jutaan halaman daftar yang tipis dan hampir duplikat dan tidak mengindeksnya, Google akhirnya mengurangi merayapi situs web sama sekali, meninggalkan banyak di limbo "Ditemukan - saat ini tidak diindeks".

Pasar ini sangat bergantung pada mesin telusur untuk mempromosikan cantuman baru kepada pengguna. Konten baru tidak lagi ditemukan, yang menimbulkan tantangan bisnis yang signifikan.

Beberapa tindakan segera diambil, seperti meningkatkan tautan internal dan menerapkan peta situs XML dinamis. Pada akhirnya, upaya ini sia-sia.

Solusi sebenarnya membutuhkan pengendalian volume dan kualitas konten yang dapat diindeks.

Kasus 2: Konsekuensi tak terduga dari perayapan berhenti

Saat perayapan berhenti, konten yang tidak diinginkan akan tetap ada di indeks Google – meskipun diubah, dialihkan, atau dihapus.

Banyak situs web menggunakan pengalihan alih-alih kesalahan 404 untuk konten yang dihapus untuk mempertahankan otoritas. Taktik ini dapat memeras lalu lintas tambahan dari halaman hantu selama berbulan-bulan, jika tidak bertahun-tahun.

Namun, ini terkadang bisa sangat salah.

Misalnya, pasar global terkenal yang menjual barang kerajinan tangan secara tidak sengaja mengungkap informasi pribadi penjual (mis., nama, alamat, email, nomor telepon) pada versi lokal laman cantuman mereka. Beberapa halaman ini diindeks dan di-cache oleh Google, menampilkan Personal Identifiable Information (PII) di hasil pencarian, membahayakan keamanan dan privasi pengguna.

Karena Google tidak merayapi ulang laman ini, menghapus atau memperbaruinya tidak akan menghilangkannya dari indeks. Bahkan berbulan-bulan setelah penghapusan, konten yang di-cache dan data PII pengguna tetap ada di indeks Google.

Dalam situasi seperti ini, marketplace bertanggung jawab untuk memperbaiki bug dan bekerja langsung dengan Google untuk menghapus konten sensitif dari Penelusuran.

Kasus 3: Risiko mengindeks halaman hasil pencarian secara berlebihan

Pengindeksan yang tidak terkontrol dari volume besar halaman tipis dan berkualitas rendah dapat menjadi bumerang – tetapi bagaimana dengan pengindeksan halaman hasil pencarian?

Google tidak mendukung pengindeksan hasil pencarian internal, dan banyak SEO berpengalaman akan sangat menyarankan taktik ini. Namun, banyak situs besar sangat bergantung pada pencarian internal sebagai penggerak utama SEO mereka, seringkali menghasilkan keuntungan yang besar.

Jika metrik keterlibatan pengguna, pengalaman halaman, dan kualitas konten cukup tinggi, Google dapat menutup mata. Faktanya, ada cukup bukti yang menunjukkan bahwa Google mungkin lebih memilih halaman hasil pencarian internal berkualitas tinggi daripada halaman daftar tipis.

Namun, strategi ini juga bisa salah.

Saya pernah melihat situs lelang lokal kehilangan sebagian besar peringkat halaman pencariannya – dan lebih dari sepertiga lalu lintas SEO – dalam semalam.

Aturan 20/80 berlaku karena sebagian kecil dari istilah utama menyumbang sebagian besar kunjungan SEO ke hasil pencarian yang diindeks. Namun, sering kali ekor panjanglah yang menjadi bagian terbesar dari volume URL dan membanggakan beberapa tingkat konversi tertinggi.

Akibatnya, situs-situs yang menggunakan taktik ini, hanya sedikit yang memberlakukan batasan atau aturan keras pada pengindeksan halaman pencarian.

Ini menimbulkan dua masalah utama:

- Permintaan pencarian apa pun dapat menghasilkan halaman yang valid, yang berarti jumlah halaman yang tak terbatas dapat dibuat secara otomatis.

- Semuanya dapat diindeks di Google.

Dalam kasus pasar iklan baris yang memonetisasi halaman pencariannya dengan iklan pihak ketiga, kerentanan ini dieksploitasi dengan baik melalui bentuk arbitrase iklan:

- Sejumlah besar URL pencarian dihasilkan untuk istilah yang teduh, dewasa, dan sepenuhnya terlarang.

- Meskipun halaman yang dibuat secara otomatis ini tidak memberikan hasil inventaris yang sebenarnya, halaman tersebut menayangkan iklan pihak ketiga, dan dioptimalkan untuk memberi peringkat untuk kueri penelusuran yang diminta melalui template halaman dan metadata.

- Tautan balik dibangun ke halaman ini dari forum berkualitas rendah agar ditemukan dan dirayapi oleh bot.

- Pengguna yang membuka halaman ini dari Google akan mengklik iklan pihak ketiga dan melanjutkan ke situs berkualitas rendah yang menjadi tujuan yang dimaksud.

Pada saat skema tersebut ditemukan, reputasi keseluruhan situs tersebut telah rusak. Itu juga terkena beberapa penalti dan mengalami penurunan besar dalam kinerja SEO.

Merangkul pengindeksan terkelola

Bagaimana masalah ini bisa dihindari?

Salah satu cara terbaik bagi situs perusahaan besar untuk berkembang dalam SEO adalah dengan menurunkan skala melalui pengindeksan terkelola.

Untuk situs dengan puluhan atau ratusan juta halaman, sangat penting untuk beralih dari pendekatan yang berfokus pada kata kunci ke pendekatan yang digerakkan oleh data, aturan, dan otomatisasi.

Pengindeksan berbasis data

Salah satu keuntungan signifikan dari situs besar adalah kekayaan data pencarian internal yang mereka miliki.

Alih-alih mengandalkan alat eksternal, mereka dapat memanfaatkan data ini untuk memahami permintaan dan tren penelusuran regional dan musiman pada tingkat terperinci.

Data ini, saat dipetakan ke inventaris konten yang ada, dapat memberikan panduan yang kuat untuk konten apa yang akan diindeks, serta kapan dan di mana melakukannya.

Hapus duplikat dan konsolidasi

Sejumlah kecil URL otoritatif dan berperingkat tinggi jauh lebih berharga daripada sejumlah besar halaman yang tersebar di 100 teratas.

Sebaiknya gabungkan halaman serupa menggunakan kanonis, gunakan aturan dan otomasi untuk melakukannya. Beberapa halaman mungkin dikonsolidasikan berdasarkan skor kesamaan, yang lain – dikelompokkan bersama jika mereka secara kolektif diberi peringkat untuk kueri serupa.

Kuncinya di sini adalah eksperimen. Tweak logika dan revisi ambang batas dari waktu ke waktu.

Bersihkan halaman konten yang tipis dan kosong

Saat hadir dalam volume besar, halaman tipis dan kosong dapat menyebabkan kerusakan signifikan pada kebersihan dan kinerja situs.

Jika terlalu menantang untuk menyempurnakannya dengan konten yang berharga atau untuk mengkonsolidasikannya, maka mereka harus diindeks atau bahkan dilarang.

Kurangi ruang tanpa batas dengan robots.txt

Lima belas tahun setelah Google pertama kali menulis tentang "ruang tak terbatas", masalah pengindeksan berlebihan filter, penyortiran, dan kombinasi parameter lainnya terus mengganggu banyak situs e-niaga.

Dalam kasus ekstrim, perayap dapat merusak server saat mereka mencoba melewati tautan ini. Untungnya, hal ini dapat diatasi dengan mudah melalui robots.txt.

Render sisi klien

Menggunakan perenderan sisi klien untuk komponen di halaman tertentu yang tidak ingin Anda indeks oleh mesin telusur, dapat menjadi pilihan. Pertimbangkan ini dengan hati-hati.

Lebih baik lagi, komponen ini seharusnya tidak dapat diakses oleh pengguna yang keluar.

Taruhan meningkat secara dramatis saat skala meningkat

Meskipun SEO sering dianggap sebagai sumber lalu lintas “gratis”, ini agak menyesatkan. Menghosting dan menyajikan konten membutuhkan biaya.

Biaya mungkin dapat diabaikan per URL, tetapi begitu skalanya mencapai ratusan juta atau milyaran halaman, uang mulai bertambah menjadi bilangan real.

Meskipun ROI SEO sulit untuk diukur, satu sen yang dihemat adalah satu sen, dan penghematan biaya melalui perayapan dan pengindeksan yang dikelola harus menjadi salah satu faktor saat mempertimbangkan strategi pengindeksan untuk situs besar.

Pendekatan pragmatis untuk SEO – dengan perayapan dan pengindeksan yang dikelola dengan baik, dipandu oleh data, aturan, dan otomatisasi – dapat melindungi situs web besar dari kesalahan yang merugikan.

Pendapat yang diungkapkan dalam artikel ini adalah dari penulis tamu dan belum tentu Search Engine Land. Penulis staf tercantum di sini.