Instalasi Hadoop Menggunakan Ambari

Diterbitkan: 2015-12-11Semua yang ingin Anda ketahui tentang Instalasi Hadoop Menggunakan Ambari

Apache Hadoop telah menjadi kerangka kerja perangkat lunak de-facto untuk komputasi yang andal, terukur, terdistribusi, dan berskala besar. Tidak seperti sistem komputasi lainnya, ini membawa komputasi ke data daripada mengirim data ke komputasi. Hadoop dibuat pada tahun 2006 di Yahoo oleh Doug Cutting berdasarkan makalah yang diterbitkan oleh Google. Seiring bertambahnya usia Hadoop, selama bertahun-tahun banyak komponen dan alat baru ditambahkan ke ekosistemnya untuk meningkatkan kegunaan dan fungsionalitasnya. Hadoop HDFS, Hadoop MapReduce, Hive, HCatalog, HBase, ZooKeeper, Oozie, Pig, Sqoop dll. untuk beberapa nama.

Kenapa Ambar?

Dengan semakin populernya Hadoop, banyak pengembang terjun ke teknologi ini untuk merasakannya. Tetapi seperti yang mereka katakan, Hadoop bukan untuk menjadi lemah hati, banyak pengembang bahkan tidak dapat melewati penghalang untuk menginstal Hadoop. Banyak distribusi menawarkan kotak pasir VM yang sudah diinstal sebelumnya untuk mencoba berbagai hal tetapi tidak memberi Anda nuansa komputasi terdistribusi. Namun, menginstal multi-node bukanlah tugas yang mudah dan dengan bertambahnya jumlah komponen, sangat sulit untuk menangani begitu banyak parameter konfigurasi. Untungnya Apache Ambari datang ke sini untuk menyelamatkan kami!

Apa itu Ambar?

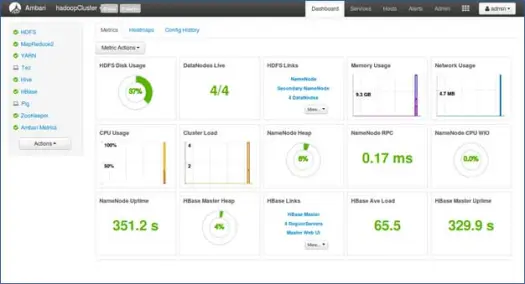

Apache Ambari adalah alat berbasis web untuk menyediakan, mengelola, dan memantau klaster Apache Hadoop. Ambari menyediakan dasbor untuk melihat kesehatan cluster seperti peta panas dan kemampuan untuk melihat aplikasi MapReduce, Pig dan Hive secara visual bersama dengan fitur untuk mendiagnosis karakteristik kinerjanya dengan cara yang ramah pengguna. Ini memiliki UI yang sangat sederhana dan interaktif untuk menginstal berbagai alat dan melakukan berbagai tugas manajemen, konfigurasi, dan pemantauan. Di bawah ini kami membawa Anda melalui berbagai langkah dalam menginstal Hadoop dan berbagai komponen ekosistemnya di cluster multi-node.

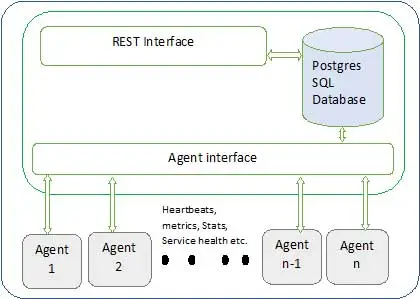

Arsitektur Ambari ditunjukkan di bawah ini

Ambari memiliki dua komponen

- Server Ambari – Ini adalah proses master yang berkomunikasi dengan agen Ambari yang diinstal pada setiap node yang berpartisipasi dalam cluster. Ini memiliki instance database postgres yang digunakan untuk memelihara semua metadata terkait cluster.

- Agen Ambari – Ini adalah agen yang bertindak untuk Ambari di setiap node. Setiap agen secara berkala mengirimkan status kesehatannya sendiri bersama dengan metrik yang berbeda, status layanan yang diinstal, dan banyak hal lainnya. Menurut master memutuskan tindakan selanjutnya dan menyampaikan kembali ke agen untuk bertindak.

Bagaimana cara menginstal Ambari?

Instalasi Ambari adalah tugas yang mudah dari beberapa perintah.

Kami akan membahas instalasi Ambari dan pengaturan cluster. Kita diasumsikan memiliki 4 node. Node1, Node2, Node3 dan Node4. Dan kami memilih Node1 sebagai server Ambari kami.

Ini adalah langkah-langkah instalasi pada sistem berbasis RHEL, untuk debian dan langkah-langkah sistem lainnya akan sedikit berbeda.

- Pemasangan Ambari: –

Dari node server Ambari (Node 1 seperti yang kami putuskan)

saya. Unduh repo publik Ambari

Perintah ini akan menambahkan repositori Hortonworks Ambari ke yum yang merupakan manajer paket default untuk sistem RHEL.

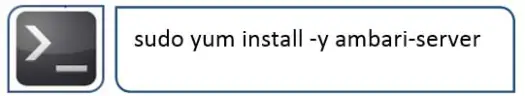

ii.Instal Ambari RPMS

Ini akan memakan waktu dan akan menginstal Ambari pada sistem ini.

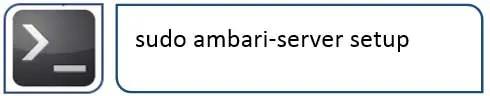

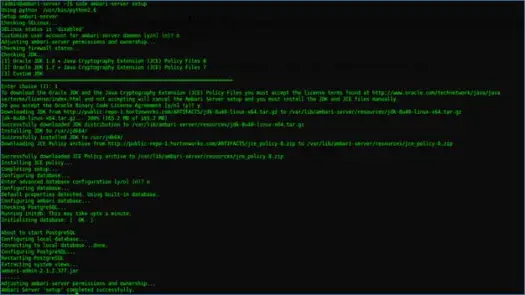

aku aku aku. Mengonfigurasi server Ambari

Hal berikutnya yang harus dilakukan setelah instalasi Ambari adalah mengkonfigurasi Ambari dan mengaturnya untuk menyediakan cluster.

Langkah berikut akan menangani ini

iv. Mulai server dan Masuk ke UI web

Mulai server dengan

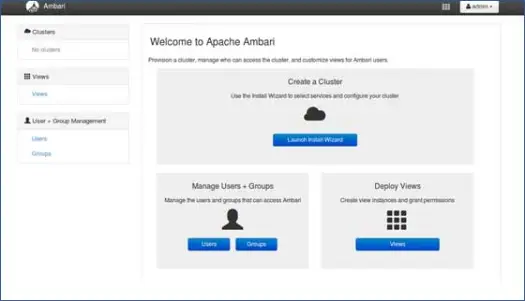

Sekarang kita dapat mengakses web UI Ambari (dihosting di port 8080).

Login ke Ambari dengan username default “admin” dan password default “admin”

Menyiapkan cluster Hadoop

1. Halaman arahan

Klik "Luncurkan Install Wizard" untuk memulai pengaturan cluster

2. Nama Cluster

Memberi Anda nama yang bagus untuk cluster.

Catatan: Ini hanya nama sederhana untuk cluster, tidak terlalu signifikan, jadi jangan khawatir tentang itu dan pilih nama apa pun untuk itu.

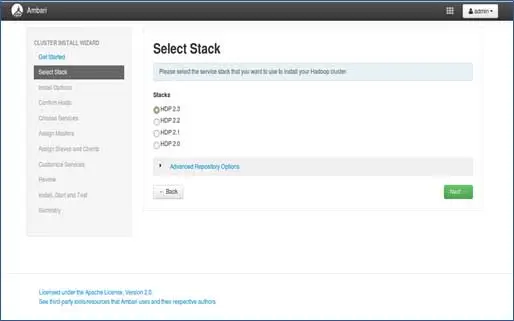

3. Pemilihan tumpukan

Halaman ini akan mencantumkan tumpukan yang tersedia untuk dipasang. Setiap tumpukan sudah dikemas sebelumnya dengan komponen ekosistem Hadoop. Tumpukan ini berasal dari Hortonworks. (Kita juga bisa memasang Hadoop biasa. Itu akan kita bahas di posting selanjutnya).

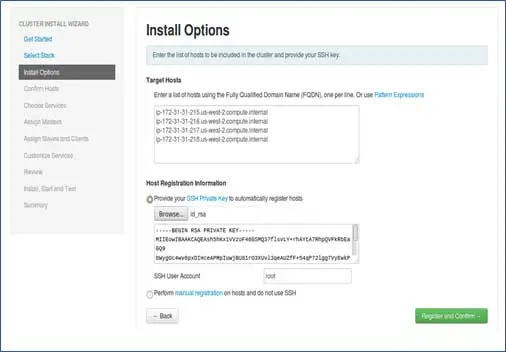

4. Entri Host dan entri kunci SSH

Sebelum melanjutkan langkah ini, kita harus memiliki penyiapan SSH tanpa kata sandi untuk semua node yang berpartisipasi.

Tambahkan nama host dari node, satu entri di setiap baris. [ Tambahkan FQDN yang dapat diperoleh dengan perintah hostname –f]. Pilih kunci pribadi yang digunakan saat mengatur kata sandi lebih sedikit SSH dan nama pengguna menggunakan kunci pribadi mana yang dibuat.

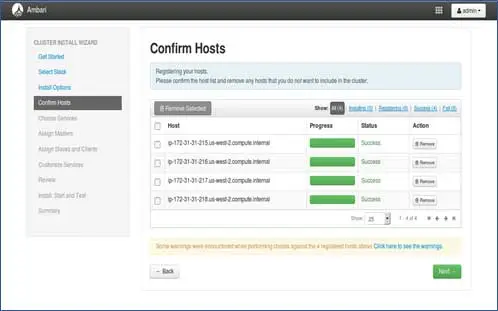

5. Status pendaftaran tuan rumah

Anda dapat melihat beberapa operasi yang dilakukan, operasi ini termasuk pengaturan Ambari-agent pada setiap node, membuat setup dasar pada setiap node. Setelah kita melihat ALL GREEN, kita siap untuk melanjutkan. Terkadang ini membutuhkan waktu karena menginstal beberapa paket.

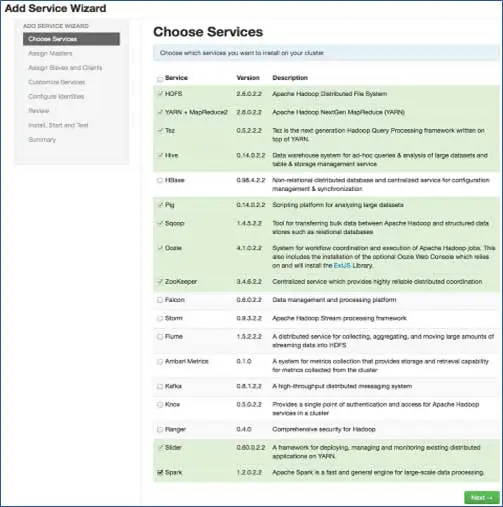

6. Pilih layanan yang ingin Anda instal

Sesuai tumpukan yang dipilih pada langkah 3, kami memiliki jumlah layanan yang dapat kami instal di cluster. Anda dapat memilih salah satu yang Anda inginkan. Ambari dengan cerdas memilih layanan dependen jika Anda belum memilihnya. Misalnya, Anda memilih HBase tetapi bukan Zookeeper, ia akan meminta hal yang sama dan akan menambahkan Zookeeper juga ke cluster.

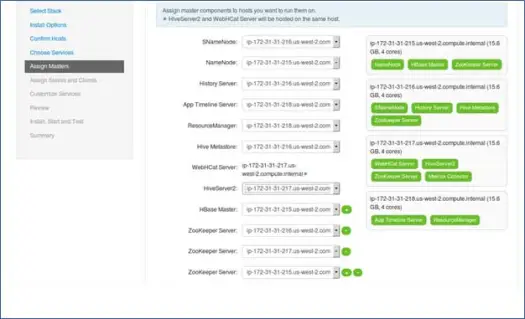

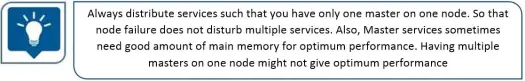

7. Pemetaan layanan master dengan Node

Seperti yang Anda ketahui, ekosistem Hadoop memiliki alat yang didasarkan pada arsitektur master-slave. Pada langkah ini, kita akan mengasosiasikan proses master dengan node. Di sini pastikan Anda menyeimbangkan cluster Anda dengan benar. Juga, perlu diingat bahwa layanan primer dan sekunder seperti Namenode dan Namenode sekunder tidak berada di mesin yang sama.

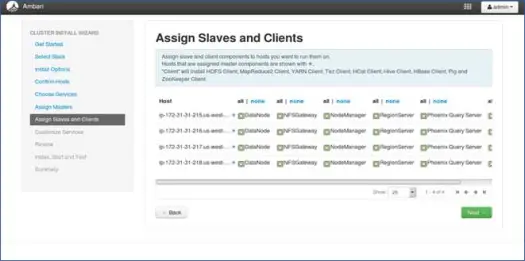

8. Pemetaan budak dengan Node

Mirip dengan master, memetakan layanan slave pada node. Secara umum, semua node akan menjalankan proses slave setidaknya untuk Datanodes dan Nodemanager.

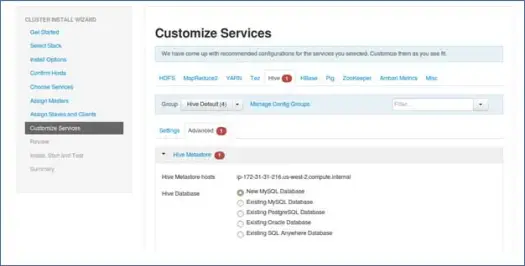

9. Sesuaikan layanan

Ini adalah halaman yang sangat penting bagi Admin.

Di sini Anda dapat mengonfigurasi properti untuk cluster Anda agar paling sesuai dengan kasus penggunaan Anda.

Juga akan memiliki beberapa properti yang diperlukan seperti kata sandi metastore Hive (jika Hive dipilih) dll. Ini akan ditunjukkan dengan simbol seperti kesalahan Merah.

10. Tinjau dan mulai penyediaan

Pastikan Anda meninjau konfigurasi cluster sebelum diluncurkan karena ini akan menyelamatkan dari konfigurasi yang salah tanpa disadari.

11. Luncurkan dan tetap kembali hingga status menjadi HIJAU.

Langkah selanjutnya

Yaa! Kami telah berhasil Menginstal Hadoop dan semua komponen di semua node cluster. Sekarang kita bisa mulai bermain dengan Hadoop.

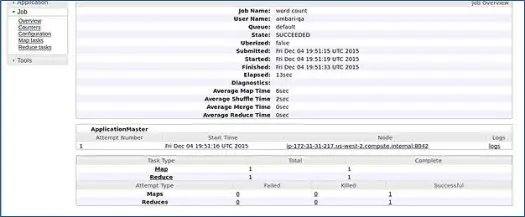

Ambari menjalankan pekerjaan jumlah kata MapReduce untuk memverifikasi apakah semuanya berjalan dengan baik. Mari kita periksa log pekerjaan yang dijalankan oleh pengguna ambari-qa.

Seperti yang Anda lihat pada tangkapan layar di atas, pekerjaan WordCount berhasil diselesaikan. Ini menegaskan bahwa cluster kami berfungsi dengan baik.

Kesimpulan

Itu saja, kita sekarang telah belajar cara menginstal Hadoop dan komponennya pada cluster multi-node menggunakan alat berbasis web sederhana yang disebut Apache Ambari. Apache Ambari memberi kami antarmuka yang lebih sederhana dan menghemat banyak upaya kami dalam instalasi, pemantauan dan manajemen yang akan sangat membosankan dengan begitu banyak komponen dan langkah-langkah instalasi dan kontrol pemantauan yang berbeda.

Biarkan saya meninggalkan Anda dengan hack

Pemasang Ambari memeriksa /etc/lsb-release untuk mendapatkan detail OS. Di Linux Mint, file yang sama untuk versi Ubuntu ada di /etc/upstream-release/lsb-release. Untuk mengelabui penginstal, ganti saja yang pertama dengan yang terakhir (Anda harus mencadangkan file terlebih dahulu).

Pada titik tertentu setelah instalasi Anda selesai, Anda dapat mengembalikan yang asli dengan:

PS Ini adalah peretasan tanpa jaminan apa pun, ini berhasil untuk saya, jadi saya pikir membagikannya kepada Anda.

Anda adalah pengembang/dev-ops dan perlu menginstal Hadoop dengan cepat. Kami punya kabar baik untuk Anda, Ambari menyediakan cara di mana Anda dapat melewati proses wizard lengkap dan menyelesaikan proses instalasi dengan satu skrip, dan saya akan membawanya di posting berikutnya, jadi tetap disini dan sampai saat itu Selamat Hadooping!