Studi Kasus SEO Sepanjang Tahun: Yang Perlu Anda Ketahui Tentang Googlebot

Diterbitkan: 2019-08-30Catatan Editor: CEO perayap JetOctopus Serge Bezborodov memberikan saran ahli tentang cara membuat situs web Anda menarik bagi Googlebot. Data dalam artikel ini didasarkan pada riset selama setahun dan 300 juta halaman yang dirayapi.

Beberapa tahun yang lalu, saya mencoba meningkatkan lalu lintas di situs web agregator pekerjaan kami dengan 5 juta halaman. Saya memutuskan untuk menggunakan layanan agen SEO, berharap lalu lintas akan melewati atap. Tapi saya salah. Alih-alih audit komprehensif, saya membaca kartu tarot. Itu sebabnya saya kembali ke titik awal dan membuat perayap web untuk analisis SEO on-page yang komprehensif.

Saya telah memata-matai Googlebot selama lebih dari setahun, dan sekarang saya siap berbagi wawasan tentang perilakunya. Saya berharap pengamatan saya setidaknya akan memperjelas cara kerja perayap web, dan paling banyak akan membantu Anda melakukan pengoptimalan halaman secara efisien. Saya mengumpulkan data paling berarti yang berguna untuk situs web baru atau yang memiliki ribuan halaman.

Apakah Halaman Anda Muncul di SERP?

Untuk mengetahui dengan pasti halaman mana yang ada di hasil pencarian, Anda harus memeriksa kemampuan indeks seluruh situs web. Namun, analisis setiap URL pada situs web 10 juta lebih halaman menghabiskan banyak uang, hampir sama dengan harga sebuah mobil baru.

Mari gunakan analisis file log sebagai gantinya. Kami bekerja dengan situs web dengan cara berikut: Kami merayapi laman web seperti yang dilakukan bot pencarian, lalu kami menganalisis file log yang dikumpulkan selama setengah tahun. Log menunjukkan apakah bot mengunjungi situs web, halaman mana yang dirayapi, dan kapan serta seberapa sering bot mengunjungi halaman tersebut.

Perayapan adalah proses bot pencarian mengunjungi situs web Anda, memproses semua tautan di halaman web dan menempatkan tautan ini sejalan untuk pengindeksan. Selama perayapan, bot membandingkan URL yang baru saja diproses dengan URL yang sudah ada di indeks. Dengan demikian, bot me-refresh data dan menambahkan/menghapus beberapa URL dari database mesin pencari untuk memberikan hasil yang paling relevan dan segar bagi pengguna.

Sekarang, kita dapat dengan mudah menarik kesimpulan ini:

- Kecuali bot pencarian ada di URL, URL ini mungkin tidak akan ada di indeks.

- Jika Googlebot mengunjungi URL beberapa kali dalam sehari, URL tersebut akan menjadi prioritas tinggi dan karenanya memerlukan perhatian khusus Anda.

Secara keseluruhan, informasi ini mengungkapkan apa yang mencegah pertumbuhan dan perkembangan organik situs web Anda. Sekarang, alih-alih beroperasi secara membabi buta, tim Anda dapat mengoptimalkan situs web dengan bijak.

Kami sebagian besar bekerja dengan situs web besar karena jika situs web Anda kecil, cepat atau lambat Googlebot akan merayapi semua laman web Anda.

Sebaliknya, situs web dengan 100.000 halaman lebih menghadapi masalah saat perayap mengunjungi halaman yang tidak terlihat oleh webmaster. Anggaran perayapan yang berharga mungkin terbuang sia-sia untuk halaman yang tidak berguna atau bahkan berbahaya ini. Pada saat yang sama, bot mungkin tidak akan pernah menemukan halaman menguntungkan Anda karena ada kekacauan dalam struktur situs web.

Anggaran perayapan adalah sumber daya terbatas yang siap digunakan Googlebot di situs web Anda. Itu dibuat untuk memprioritaskan apa yang harus dianalisis dan kapan. Ukuran anggaran perayapan bergantung pada banyak faktor, seperti ukuran situs web Anda, strukturnya, volume, dan frekuensi kueri pengguna, dll.

Perhatikan bahwa bot pencarian tidak tertarik untuk merayapi situs web Anda sepenuhnya.

Tujuan utama bot mesin pencari adalah memberikan jawaban yang paling relevan kepada pengguna dengan kehilangan sumber daya yang minimal.Bot merayapi data sebanyak yang dibutuhkan untuk tujuan utama. Jadi, itu tugas ANDA untuk membantu bot mengambil konten yang paling berguna dan menguntungkan.

Memata-matai Googlebot

Selama setahun terakhir kami telah memindai lebih dari 300 juta URL dan 6 miliar baris log di situs web besar. Berdasarkan data ini, kami menelusuri perilaku Googlebot untuk membantu menjawab pertanyaan berikut:

- Jenis halaman apa yang diabaikan?

- Halaman mana yang sering dikunjungi?

- Apa yang patut diperhatikan untuk bot?

- Apa yang tidak ada nilainya?

Di bawah ini adalah analisis dan temuan kami, dan bukan penulisan ulang Pedoman Webmaster Google. Faktanya, kami tidak memberikan rekomendasi yang tidak terbukti dan tidak dapat dibenarkan. Setiap poin didasarkan pada statistik dan grafik faktual untuk kenyamanan Anda.

Mari langsung ke pengejaran dan cari tahu:

- Apa yang benar-benar penting bagi Googlebot?

- Apa yang menentukan apakah bot mengunjungi halaman atau tidak?

Kami mengidentifikasi faktor-faktor berikut:

Jarak Dari Indeks

DFI adalah singkatan dari Distance From Index dan seberapa jauh URL Anda untuk URL utama/root/indeks dalam klik. Ini adalah salah satu kriteria terpenting yang memengaruhi frekuensi kunjungan Googlebot. Berikut adalah video pendidikan untuk mempelajari lebih lanjut tentang DFI .

Perhatikan bahwa DFI bukanlah jumlah garis miring di direktori URL seperti, misalnya:

site.com / shop /iphone/iphoneX.html – DFI – 3

Jadi, DFI dihitung persis dengan KLIK dari halaman utama

https://site.com/shop/iphone/iphoneX.html

https://site.com Katalog iPhone → https://site.com/shop/iphone iPhone X → https://site.com/shop/iphone/iphoneX.html – DFI – 2

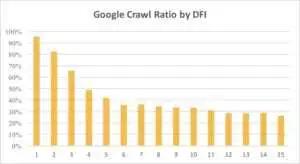

Di bawah ini Anda dapat melihat bagaimana minat Googlebot pada URL dengan DFI-nya berkurang secara bertahap selama sebulan terakhir dan selama enam bulan terakhir.

Seperti yang Anda lihat, jika DFI adalah 5 t0 6, Googlebot hanya merayapi separuh halaman web. Dan persentase halaman yang diproses berkurang jika DFI lebih besar. Indikator dalam tabel disatukan untuk 18 juta halaman. Perhatikan bahwa data dapat bervariasi tergantung pada ceruk situs web tertentu.

Apa yang harus dilakukan?

Jelas bahwa strategi terbaik dalam hal ini adalah menghindari DFI yang lebih panjang dari 5, membangun struktur situs web yang mudah dinavigasi, memberi perhatian khusus pada tautan, dll.

Yang benar adalah bahwa langkah-langkah ini sangat memakan waktu untuk 100.000 halaman situs web. Biasanya situs web besar memiliki sejarah desain ulang dan migrasi yang panjang. Itulah mengapa webmaster sebaiknya tidak hanya menghapus halaman dengan DFI 10, 12, atau bahkan 30. Selain itu, menyisipkan satu link dari halaman yang sering dikunjungi tidak akan menyelesaikan masalah.

Cara optimal untuk mengatasi DFI yang panjang adalah dengan memeriksa dan memperkirakan apakah URL ini relevan, menguntungkan, dan posisi apa yang mereka miliki di SERP.

Halaman dengan DFI panjang tetapi posisi bagus di SERP memiliki potensi tinggi. Untuk meningkatkan lalu lintas di laman berkualitas tinggi, webmaster harus menyisipkan tautan dari laman berikutnya. Satu hingga dua tautan tidak cukup untuk kemajuan yang nyata.

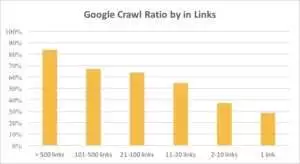

Anda dapat melihat dari grafik di bawah ini bahwa Googlebot lebih sering mengunjungi URL jika terdapat lebih dari 10 tautan di laman tersebut.

Tautan

Faktanya, semakin besar sebuah situs web, semakin signifikan jumlah tautan di halaman web tersebut. Data ini sebenarnya dari 1 juta lebih halaman website.

Jika Anda menemukan ada kurang dari 10 tautan di halaman menguntungkan Anda, jangan panik. Pertama, periksa apakah halaman ini berkualitas tinggi dan menguntungkan. Saat Anda melakukannya, sisipkan tautan pada halaman berkualitas tinggi tanpa terburu-buru dan dengan iterasi singkat, analisis log setelah setiap langkah.

Ukuran Konten

Konten adalah salah satu aspek analisis SEO yang paling populer. Tentu saja, semakin relevan konten di situs web Anda, semakin baik Rasio Perayapan Anda. Di bawah ini Anda dapat melihat seberapa dramatis minat Googlebot menurun untuk halaman dengan kurang dari 500 kata.

Apa yang harus dilakukan?

Berdasarkan pengalaman saya, hampir setengah dari semua halaman dengan kurang dari 500 kata adalah halaman sampah. Kami melihat kasus di mana situs web berisi 70.000 halaman dengan hanya mencantumkan ukuran pakaian, jadi hanya sebagian dari halaman ini yang ada di indeks.

Karena itu, periksa dulu apakah Anda benar-benar membutuhkan halaman tersebut. Jika URL ini penting, Anda harus menambahkan beberapa konten yang relevan di dalamnya. Jika Anda tidak memiliki apa pun untuk ditambahkan, santai saja dan biarkan URL ini apa adanya. Terkadang lebih baik tidak melakukan apa-apa daripada menerbitkan konten yang tidak berguna.

Faktor lain

Faktor-faktor berikut dapat memengaruhi Rasio Perayapan secara signifikan:

Muat Waktu

Kecepatan halaman web sangat penting untuk perayapan dan peringkat. Bot itu seperti manusia: Ia tidak suka menunggu terlalu lama untuk memuat halaman web. Jika ada lebih dari 1 juta halaman di situs web Anda, bot pencarian mungkin akan mengunduh lima halaman dengan waktu muat 1 detik daripada menunggu satu halaman yang dimuat dalam 5 detik.

Apa yang harus dilakukan?

Faktanya, ini adalah tugas teknis dan tidak ada solusi “satu metode yang cocok untuk semua”, seperti menggunakan server yang lebih besar. Ide utamanya adalah untuk menemukan hambatan dari masalah. Anda harus memahami mengapa halaman web dimuat dengan lambat. Hanya setelah alasannya terungkap, Anda dapat mengambil tindakan.

Rasio Konten Unik dan Template

Keseimbangan antara data unik dan template adalah penting. Misalnya, Anda memiliki situs web dengan variasi nama hewan peliharaan. Berapa banyak konten yang relevan dan unik yang dapat Anda kumpulkan tentang topik ini?

Luna adalah nama anjing "selebriti" paling populer, diikuti oleh Stella, Jack, Milo, dan Leo.

Bot pencarian tidak suka menghabiskan sumber dayanya untuk halaman semacam ini.

Apa yang harus dilakukan?

Pertahankan keseimbangan. Pengguna dan bot tidak suka mengunjungi halaman dengan templat yang rumit, banyak tautan keluar, dan sedikit konten.

Halaman Yatim Piatu

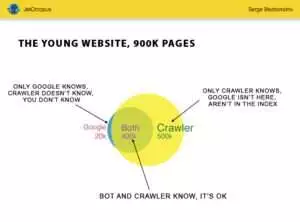

Halaman Orphan adalah URL yang tidak ada dalam struktur situs web dan Anda tidak tahu tentang halaman ini, tetapi halaman yatim ini dapat dirayapi oleh bot. Untuk memperjelasnya, lihat Lingkaran Euler pada gambar di bawah ini:

Anda dapat melihat situasi normal untuk situs web muda, yang strukturnya belum diubah untuk sementara waktu. Ada 900.000 halaman yang dapat dianalisis oleh Anda dan perayap. Sekitar 500.000 halaman diproses oleh perayap tetapi tidak diketahui oleh Google. Jika Anda membuat 500.000 URL ini dapat diindeks, lalu lintas Anda pasti akan meningkat.

Perhatikan: Bahkan situs web muda berisi beberapa halaman (bagian biru pada gambar) yang tidak ada dalam struktur situs web tetapi sering dikunjungi oleh bot.

Dan halaman ini dapat berisi konten sampah, seperti kueri pengunjung yang dibuat secara otomatis yang tidak berguna.

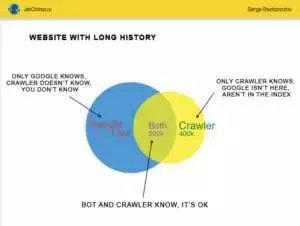

Tetapi situs web besar jarang begitu akurat. Sangat sering situs web dengan riwayat terlihat seperti ini:

Inilah masalah lainnya: Google tahu lebih banyak tentang situs web Anda daripada Anda. Mungkin ada halaman yang dihapus, halaman di JavaScript atau Ajax, pengalihan yang rusak, dan sebagainya. Suatu kali kami menghadapi situasi di mana daftar 500.000 tautan rusak muncul di peta situs karena kesalahan programmer. Setelah tiga hari, bug ditemukan dan diperbaiki, tetapi Googlebot telah mengunjungi tautan yang rusak ini selama setengah tahun!

Seringkali, Anggaran Perayapan Anda sering terbuang sia-sia di Halaman Yatim Piatu ini.

Apa yang harus dilakukan?

Ada dua cara untuk memperbaiki potensi masalah ini: Pertama kanonis: membereskan kekacauan. Atur struktur situs web, sisipkan tautan internal dengan benar, tambahkan halaman yatim piatu ke DFI dengan menambahkan tautan dari halaman yang diindeks, tetapkan tugas untuk pemrogram, dan tunggu kunjungan Googlebot berikutnya.

Cara kedua adalah cepat: kumpulkan daftar halaman yatim piatu dan periksa apakah relevan. Jika jawabannya "ya", buat peta situs dengan URL ini dan kirimkan ke Google. Cara ini lebih mudah dan lebih cepat, tetapi hanya setengah dari halaman anak yatim yang ada di indeks.

Tingkat Selanjutnya

Algoritme mesin pencari telah meningkat selama dua dekade, dan naif untuk berpikir bahwa perayapan pencarian dapat dijelaskan dengan beberapa grafik.

Kami mengumpulkan lebih dari 200 parameter berbeda untuk setiap halaman, dan kami berharap jumlah ini akan meningkat pada akhir tahun. Bayangkan situs web Anda adalah tabel dengan 1 juta baris (halaman) dan kalikan baris ini dengan 200 kolom, sampel sederhana tidak cukup untuk audit teknis yang komprehensif. Apa kamu setuju?

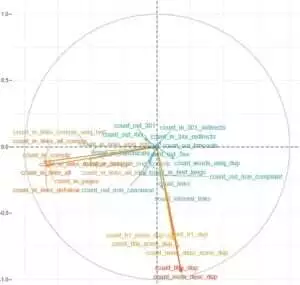

Kami memutuskan untuk mendalami lebih dalam dan menggunakan pembelajaran mesin untuk mencari tahu apa yang memengaruhi perayapan Googlebot dalam setiap kasus.

Pertama, tautan situs web sangat penting sementara konten adalah faktor kunci untuk yang lain.

Poin utama dari tugas ini adalah untuk mendapatkan jawaban yang mudah dari data yang rumit dan masif: Apa di situs web Anda yang paling memengaruhi indeksasi? Kluster URL mana yang terhubung dengan faktor yang sama? Sehingga Anda dapat bekerja dengan mereka secara komprehensif.

Sebelum mengunduh dan menganalisis log di situs web agregator HotWork kami, cerita tentang halaman yatim piatu yang terlihat oleh bot tetapi tidak bagi kami tampaknya tidak realistis bagi saya. Tetapi situasi sebenarnya lebih mengejutkan saya: Perayapan menunjukkan 500 halaman dengan 301 redirect, tetapi Yandex menemukan 700.000 halaman dengan kode status yang sama.

Biasanya, ahli teknis tidak suka menyimpan file log karena data ini "membebani" disk. Namun secara objektif, di sebagian besar situs web dengan kunjungan hingga 10 juta per bulan, pengaturan dasar penyimpanan log berfungsi dengan sempurna.

Berbicara tentang volume log, solusi terbaik adalah membuat arsip dan mengunduhnya di Amazon S3-Glacier (Anda dapat menyimpan 250 GB data hanya dengan $1). Bagi administrator sistem, tugas ini semudah membuat secangkir kopi. Di masa mendatang, log historis akan membantu mengungkap bug teknis dan memperkirakan pengaruh pembaruan Google di situs web Anda.