L'intelligenza artificiale nella SEO: come affrontare le sfide legali e garantire la conformità

Pubblicato: 2023-09-26L’intelligenza artificiale (AI) è destinata a diventare uno strumento vitale per i marchi che cercano di migliorare la propria presenza online.

Tuttavia, l’integrazione dell’intelligenza artificiale nelle strategie di marketing crea inevitabilmente considerazioni legali e nuove normative che le agenzie devono esplorare con attenzione.

In questo articolo scoprirai:

- In che modo le aziende, le agenzie SEO e di media possono ridurre al minimo i rischi legali derivanti dall'implementazione di strategie potenziate dall'intelligenza artificiale.

- Strumenti utili per ridurre i bias dell'intelligenza artificiale e un pratico processo per rivedere la qualità dei contenuti generati dall'intelligenza artificiale.

- Come le agenzie possono affrontare le principali sfide di implementazione dell'intelligenza artificiale per garantire efficienza e conformità ai propri clienti.

Considerazioni sulla conformità legale

Proprietà intellettuale e diritto d'autore

Una preoccupazione legale cruciale quando si utilizza l’intelligenza artificiale nella SEO e nei media è il rispetto delle leggi sulla proprietà intellettuale e sul copyright.

I sistemi di intelligenza artificiale spesso raccolgono e analizzano grandi quantità di dati, compreso materiale protetto da copyright.

Esistono già numerose cause legali contro OpenAI per violazioni del copyright e della privacy.

L'azienda deve affrontare azioni legali per presunto utilizzo non autorizzato di libri protetti da copyright per la formazione di ChatGPT e per la raccolta illegale di informazioni personali dagli utenti di Internet utilizzando i loro modelli di apprendimento automatico.

Le preoccupazioni sulla privacy relative al trattamento e al salvataggio dei dati degli utenti da parte di OpenAI hanno anche portato l'Italia a bloccare completamente l'uso di ChatGPT alla fine di marzo.

Il divieto è stato ora revocato dopo che la società ha apportato modifiche per aumentare la trasparenza sull'elaborazione dei dati degli utenti del chatbot e aggiungere un'opzione per disattivare le conversazioni di ChatGPT utilizzate per l'addestramento degli algoritmi.

Tuttavia, con il lancio di GPTBot, il crawler di OpenAI, potrebbero sorgere ulteriori considerazioni legali.

Per evitare potenziali problemi legali e denunce di violazione, le agenzie devono garantire che tutti i modelli di intelligenza artificiale siano addestrati su fonti di dati autorizzate e rispettino le restrizioni sul copyright:

- Assicurarsi che i dati siano stati ottenuti legalmente e che l'agenzia abbia i diritti appropriati per utilizzarli.

- Filtra i dati che non dispongono delle autorizzazioni legali richieste o che sono di scarsa qualità.

- Condurre controlli regolari dei dati e dei modelli di intelligenza artificiale per garantire che siano conformi ai diritti e alle leggi sull'utilizzo dei dati.

- Organizzare una consulenza legale sui diritti dei dati e sulla privacy per garantire che nulla sia in conflitto con le politiche legali.

Sia i team legali dell’agenzia che quelli dei clienti dovranno probabilmente essere coinvolti nelle discussioni di cui sopra prima che i modelli di intelligenza artificiale possano essere integrati nei flussi di lavoro e nei progetti.

Privacy e protezione dei dati

Le tecnologie di intelligenza artificiale fanno molto affidamento sui dati, che possono includere informazioni personali sensibili.

La raccolta, l'archiviazione e l'elaborazione dei dati degli utenti devono essere in linea con le leggi sulla privacy pertinenti, come il Regolamento generale sulla protezione dei dati (GDPR) nell'Unione Europea.

Inoltre, la legge UE sull’IA recentemente introdotta sottolinea anche la necessità di affrontare le preoccupazioni sulla privacy dei dati associati ai sistemi di intelligenza artificiale.

Ciò non è senza merito. Grandi aziende, come Samsung, hanno bandito completamente l’intelligenza artificiale a causa dell’esposizione dei dati riservati caricati su ChatGPT.

Pertanto, se le agenzie utilizzano i dati dei clienti insieme alla tecnologia AI, dovrebbero:

- Dare priorità alla trasparenza nella raccolta dei dati.

- Ottenere il consenso dell'utente.

- Implementare solide misure di sicurezza per salvaguardare le informazioni sensibili.

In questi casi, le agenzie possono dare priorità alla trasparenza nella raccolta dei dati comunicando chiaramente agli utenti quali dati verranno raccolti, come verranno utilizzati e chi avrà accesso ad essi.

Per ottenere il consenso dell'utente, assicurati che il consenso sia informato e prestato liberamente attraverso moduli di consenso chiari e di facile comprensione che spieghino lo scopo e i vantaggi della raccolta dei dati.

Inoltre, solide misure di sicurezza includono:

- Crittografia dei dati.

- Controllo di accesso.

- Anonimizzazione dei dati (ove possibile).

- Verifiche e aggiornamenti regolari.

Ad esempio, le politiche di OpenAI sono in linea con la necessità di privacy e protezione dei dati e si concentrano sulla promozione della trasparenza, del consenso degli utenti e della sicurezza dei dati nelle applicazioni IA.

Equità e parzialità

Gli algoritmi di intelligenza artificiale utilizzati nella SEO e nei media hanno il potenziale di perpetuare inavvertitamente pregiudizi o discriminare determinati individui o gruppi.

Le agenzie devono essere proattive nell’identificare e mitigare i bias algoritmici. Ciò è particolarmente importante ai sensi della nuova legge UE sull’intelligenza artificiale, che vieta ai sistemi di intelligenza artificiale di influenzare ingiustamente il comportamento umano o di mostrare comportamenti discriminatori.

Per mitigare questo rischio, le agenzie dovrebbero garantire che dati e prospettive diversi siano inclusi nella progettazione dei modelli di intelligenza artificiale e monitorare continuamente i risultati per potenziali pregiudizi e discriminazioni.

Un modo per raggiungere questo obiettivo è utilizzare strumenti che aiutano a ridurre i bias, come AI Fairness 360, IBM Watson Studio e What-If Tool di Google.

Contenuti falsi o fuorvianti

Gli strumenti di intelligenza artificiale, incluso ChatGPT, possono generare contenuti sintetici che potrebbero essere imprecisi, fuorvianti o falsi.

Ad esempio, l’intelligenza artificiale crea spesso false recensioni online per promuovere determinati luoghi o prodotti. Ciò può portare a conseguenze negative per le aziende che fanno affidamento sui contenuti generati dall’intelligenza artificiale.

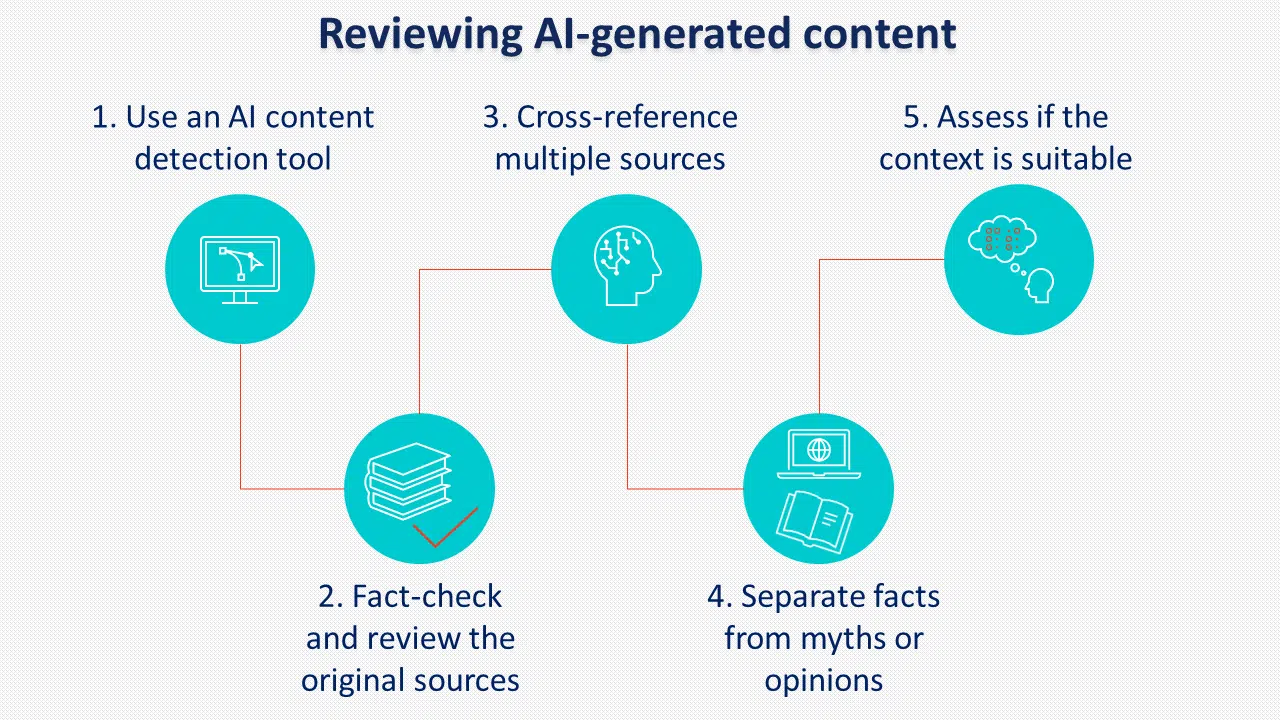

L’implementazione di politiche e procedure chiare per la revisione dei contenuti generati dall’intelligenza artificiale prima della pubblicazione è fondamentale per prevenire questo rischio.

Un’altra pratica da considerare è l’etichettatura dei contenuti generati dall’intelligenza artificiale. Anche se Google sembra non applicarlo, molti politici sostengono l’etichettatura dell’IA.

Responsabilità e responsabilità

Man mano che i sistemi di intelligenza artificiale diventano più complessi, sorgono questioni di responsabilità.

Le agenzie che utilizzano l'intelligenza artificiale devono essere pronte ad assumersi la responsabilità di eventuali conseguenze indesiderate derivanti dal suo utilizzo, tra cui:

- Pregiudizi e discriminazioni quando si utilizza l’intelligenza artificiale per selezionare i candidati per l’assunzione.

- Il potenziale di abusare del potere dell’intelligenza artificiale per scopi dannosi come gli attacchi informatici.

- La perdita di privacy se le informazioni vengono raccolte senza consenso.

La legge UE sull’intelligenza artificiale introduce nuove disposizioni sui sistemi di intelligenza artificiale ad alto rischio che possono influire in modo significativo sui diritti degli utenti, evidenziando il motivo per cui agenzie e clienti devono rispettare i termini e le politiche pertinenti quando utilizzano le tecnologie di intelligenza artificiale.

Alcuni dei termini e delle politiche più importanti di OpenAI riguardano il contenuto fornito dall'utente, l'accuratezza delle risposte e il trattamento dei dati personali.

La politica sui contenuti afferma che OpenAI assegna all'utente i diritti del contenuto generato. Specifica inoltre che il contenuto generato può essere utilizzato per qualsiasi scopo, compreso quello commerciale, purché rispetti le restrizioni legali.

Tuttavia, si afferma anche che l’output potrebbe non essere né del tutto unico né accurato, il che significa che i contenuti generati dall’intelligenza artificiale dovrebbero sempre essere esaminati attentamente prima dell’uso.

In una nota sui dati personali, OpenAI raccoglie tutte le informazioni inserite dagli utenti, inclusi i caricamenti di file.

Quando si utilizza il servizio per trattare dati personali, gli utenti devono fornire informative sulla privacy legalmente adeguate e compilare un modulo per richiedere il trattamento dei dati.

Le agenzie devono affrontare in modo proattivo le questioni di responsabilità, monitorare i risultati dell’intelligenza artificiale e implementare solide misure di controllo della qualità per mitigare potenziali responsabilità legali.

Ottieni la ricerca quotidiana di newsletter su cui fanno affidamento gli esperti di marketing.

Vedi i termini.

Sfide di implementazione dell’intelligenza artificiale per le agenzie

Da quando OpenAI ha rilasciato ChatGPT lo scorso anno, si è parlato molto di come l’intelligenza artificiale generativa cambierà la SEO come professione e del suo impatto complessivo sul settore dei media.

Sebbene i cambiamenti comportino un mix di miglioramenti al carico di lavoro quotidiano, ci sono alcune sfide che le agenzie dovrebbero considerare quando implementano l'intelligenza artificiale nelle strategie dei clienti.

Educazione e consapevolezza

Molti clienti potrebbero non avere una comprensione completa dell’intelligenza artificiale e delle sue implicazioni.

Le agenzie, quindi, affrontano la sfida di educare i clienti sui potenziali vantaggi e rischi associati all’implementazione dell’intelligenza artificiale.

Il panorama normativo in evoluzione richiede una comunicazione chiara con i clienti in merito alle misure adottate per garantire la conformità legale.

Per raggiungere questo obiettivo, le agenzie devono:

- Avere una chiara comprensione degli obiettivi del cliente.

- Essere in grado di spiegare i vantaggi.

- Mostrare esperienza nell'implementazione dell'intelligenza artificiale.

- Affrontare le sfide e i rischi.

Un modo per farlo è avere una scheda informativa da condividere con i clienti contenente tutte le informazioni necessarie e, se possibile, fornire casi di studio o altri esempi di come possono trarre vantaggio dall’uso dell’intelligenza artificiale.

Assegnazione delle risorse

L’integrazione dell’intelligenza artificiale nelle strategie SEO e mediatiche richiede risorse significative, inclusi investimenti finanziari, personale qualificato e aggiornamenti delle infrastrutture.

Le agenzie devono valutare attentamente le esigenze e le capacità dei propri clienti per determinare la fattibilità dell'implementazione di soluzioni di intelligenza artificiale entro i limiti di budget, poiché potrebbero richiedere specialisti di intelligenza artificiale, analisti di dati, SEO e specialisti di contenuti che possano collaborare efficacemente insieme.

Le esigenze infrastrutturali possono includere strumenti di intelligenza artificiale, elaborazione dei dati e piattaforme di analisi per estrarre informazioni approfondite. Se fornire servizi o facilitare risorse esterne dipende dalle capacità e dal budget esistenti di ciascuna agenzia.

L’esternalizzazione di altre agenzie potrebbe portare a un’implementazione più rapida, mentre investire in capacità di intelligenza artificiale interne potrebbe essere migliore per il controllo e la personalizzazione a lungo termine dei servizi offerti.

Competenza tecnica

L’implementazione dell’intelligenza artificiale richiede conoscenze e competenze tecniche specializzate.

Le agenzie potrebbero dover reclutare o migliorare le competenze dei propri team per sviluppare, implementare e gestire in modo efficace i sistemi di intelligenza artificiale in linea con i nuovi requisiti normativi.

Per sfruttare al massimo l'intelligenza artificiale, i membri del team dovrebbero avere:

- Buona conoscenza della programmazione.

- Capacità di elaborazione e analisi dei dati per la gestione di grandi quantità di dati.

- Conoscenza pratica dell'apprendimento automatico.

- Eccellenti capacità di problem solving.

Considerazioni etiche

Le agenzie devono considerare le implicazioni etiche dell’uso dell’intelligenza artificiale per i loro clienti.

Dovrebbero essere stabiliti quadri e linee guida etici per garantire pratiche di IA responsabili durante tutto il processo, affrontando le preoccupazioni sollevate nelle normative aggiornate.

Questi includono:

- Trasparenza, divulgazione e responsabilità quando viene utilizzata l’intelligenza artificiale.

- Rispetto della privacy dell'utente e della proprietà intellettuale.

- Ottenere il consenso del cliente per l'utilizzo dell'intelligenza artificiale.

- Controllo umano sull'IA con impegno costante per migliorare e adattarsi alle tecnologie IA emergenti.

La responsabilità è importante: affrontare le sfide legali legate all’implementazione dell’intelligenza artificiale

Mentre l’intelligenza artificiale presenta interessanti opportunità per migliorare la SEO e le pratiche mediatiche, le agenzie devono affrontare le sfide legali e aderire alle normative aggiornate associate alla sua implementazione.

Le aziende e le agenzie possono ridurre al minimo i rischi legali:

- Garantire che i dati siano stati ottenuti legalmente e che l'agenzia abbia i diritti appropriati per utilizzarli.

- Filtrare i dati che non dispongono delle autorizzazioni legali richieste o che sono di scarsa qualità.

- Condurre controlli sui dati e sui modelli di intelligenza artificiale per garantire che siano conformi ai diritti e alle leggi sull'utilizzo dei dati.

- Tenere una consulenza legale sui diritti dei dati e sulla privacy per garantire che nulla sia in conflitto con le politiche legali.

- Dare priorità alla trasparenza nella raccolta dei dati e ottenere il consenso dell’utente attraverso moduli di consenso chiari e di facile comprensione.

- Utilizzando strumenti che aiutano a ridurre i bias, come AI Fairness 360, IBM Watson Studio e What-If Tool di Google.

- Implementare politiche e procedure chiare per la revisione della qualità dei contenuti generati dall’intelligenza artificiale prima della pubblicazione.

Le opinioni espresse in questo articolo sono quelle dell'autore ospite e non necessariamente Search Engine Land. Gli autori dello staff sono elencati qui.