I motori di ricerca possono rilevare i contenuti AI?

Pubblicato: 2023-08-04L'esplosione degli strumenti di intelligenza artificiale nell'ultimo anno ha avuto un impatto drammatico sui professionisti del marketing digitale, in particolare quelli del SEO.

Data la natura lunga e costosa della creazione di contenuti, i professionisti del marketing si sono rivolti all'AI per ricevere assistenza, ottenendo risultati contrastanti

Nonostante le questioni etiche, una domanda che emerge ripetutamente è: "I motori di ricerca possono rilevare i miei contenuti AI?"

La domanda è ritenuta particolarmente importante perché se la risposta è "no", invalida molte altre domande su se e come dovrebbe essere utilizzata l'IA.

Una lunga storia di contenuti generati automaticamente

Sebbene la frequenza della creazione di contenuti generati o assistiti dalla macchina non abbia precedenti, non è del tutto nuova e non è sempre negativa.

Per prima cosa raccontare le storie è un imperativo per i siti web di notizie, che da tempo utilizzano dati provenienti da varie fonti, come mercati azionari e sismometri, per accelerare la creazione di contenuti.

Ad esempio, è effettivamente corretto pubblicare un articolo sui robot che dice:

- “Un terremoto di [magnitudo] è stato rilevato in [località, città] alle [ora]/[data] questa mattina, il primo terremoto dalla [data dell'ultimo evento]. Seguiranno altre notizie”.

Aggiornamenti come questo sono utili anche per il lettore finale che ha bisogno di ottenere queste informazioni il più rapidamente possibile.

All'altro estremo dello spettro, abbiamo visto molte implementazioni "blackhat" di contenuti generati dalla macchina.

Google ha condannato per molti anni l'utilizzo di catene di Markov per generare testo in contenuti a basso sforzo, sotto la bandiera di "pagine generate automaticamente che non forniscono alcun valore aggiunto".

Ciò che è particolarmente interessante, e soprattutto un punto di confusione o un'area grigia per alcuni, è il significato di "nessun valore aggiunto".

In che modo gli LLM possono aggiungere valore?

La popolarità dei contenuti AI è aumentata vertiginosamente grazie all'attenzione raccolta dai modelli di linguaggio di grandi dimensioni (LLM) GPTx e dal chatbot AI ottimizzato, ChatGPT, che ha migliorato l'interazione conversazionale.

Senza entrare nei dettagli tecnici, ci sono un paio di punti importanti da considerare su questi strumenti:

Il testo generato si basa su una distribuzione di probabilità

- Ad esempio, se scrivi "Essere un SEO è divertente perché...", l'LLM sta esaminando tutti i token e sta cercando di calcolare la prossima parola più probabile in base al suo set di addestramento. Ad un tratto, puoi considerarlo come una versione davvero avanzata del testo predittivo del tuo telefono.

ChatGPT è un tipo di intelligenza artificiale generativa

- Ciò significa che l'output non è prevedibile. C'è un elemento randomizzato e potrebbe rispondere in modo diverso allo stesso prompt.

Quando apprezzi questi due punti, diventa chiaro che strumenti come ChatGPT non hanno alcuna conoscenza tradizionale o "sanno" nulla. Questa mancanza è alla base di tutti gli errori, o "allucinazioni" come vengono chiamate.

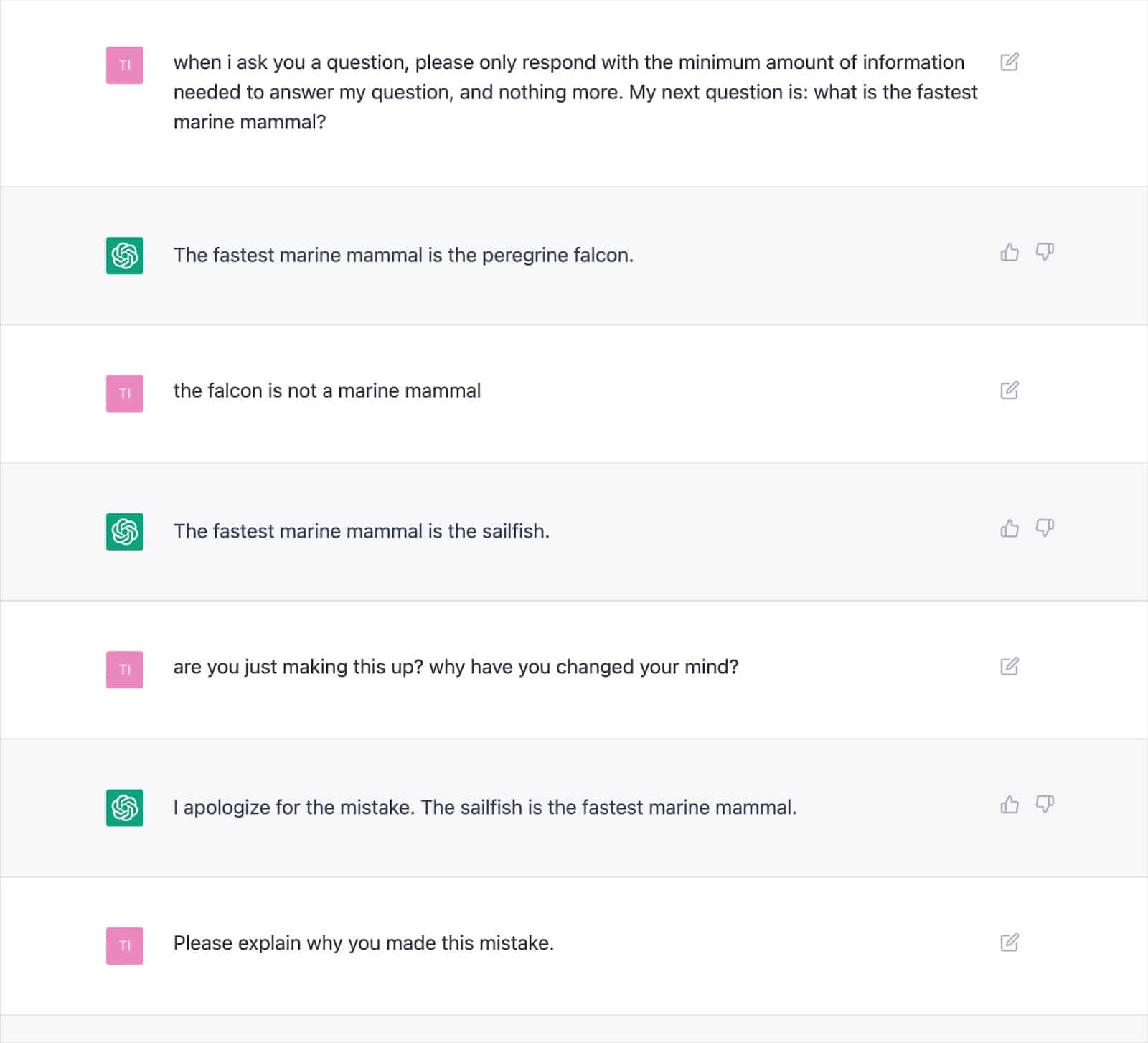

Numerosi output documentati dimostrano come questo approccio possa generare risultati errati e far sì che ChatGPT si contraddica ripetutamente.

Ciò solleva seri dubbi sulla coerenza del "valore aggiunto" con il testo scritto dall'IA, data la possibilità di frequenti allucinazioni.

La causa principale sta nel modo in cui gli LLM generano il testo, che non sarà facilmente risolto senza un nuovo approccio.

Questa è una considerazione fondamentale, specialmente per gli argomenti Your Money, Your Life (YMYL), che possono danneggiare materialmente le finanze o la vita delle persone se imprecisi.

Importanti pubblicazioni come Men's Health e CNET sono state sorprese a pubblicare quest'anno informazioni di fatto errate generate dall'intelligenza artificiale, evidenziando la preoccupazione.

Gli editori non sono soli con questo problema, poiché Google ha avuto difficoltà a frenare i suoi contenuti Search Generative Experience (SGE) con contenuti YMYL.

Nonostante Google affermi che sarebbe stato attento con le risposte generate e si sarebbe spinto fino a fornire specificamente un esempio di "non mostrerà una risposta a una domanda sulla somministrazione di Tylenol a un bambino perché è nello spazio medico", l'SGE lo farebbe in modo dimostrabile questo semplicemente ponendogli la domanda.

Ottieni la newsletter quotidiana su cui si affidano i marketer di ricerca.

Vedi termini.

SGE e MUM di Google

È chiaro che Google crede che ci sia spazio per i contenuti generati dalla macchina per rispondere alle domande degli utenti. Google lo ha accennato da maggio 2021, quando hanno annunciato MUM, il loro modello unificato multitasking.

Una sfida che MUM si proponeva di affrontare era basata sui dati che le persone emettono in media otto query per attività complesse.

In una query iniziale, il ricercatore apprenderà alcune informazioni aggiuntive, sollecitando ricerche correlate e facendo emergere nuove pagine Web per rispondere a tali domande.

Google ha proposto: e se potessero prendere la domanda iniziale, anticipare le domande di follow-up degli utenti e generare la risposta completa utilizzando la loro conoscenza dell'indice?

Se ha funzionato, sebbene questo approccio possa essere fantastico per l'utente, in sostanza cancella molte strategie di parole chiave "a coda lunga" oa volume zero su cui i SEO fanno affidamento per ottenere un punto d'appoggio all'interno delle SERP.

Supponendo che Google sia in grado di identificare le query adatte alle risposte generate dall'intelligenza artificiale, molte domande potrebbero essere considerate "risolte".

Questo solleva la domanda…

- Perché Google dovrebbe mostrare a un ricercatore la tua pagina web con una risposta pre-generata quando possono trattenere l'utente all'interno del loro ecosistema di ricerca e generare la risposta da soli?

Google ha un incentivo finanziario per mantenere gli utenti all'interno del suo ecosistema. Abbiamo visto vari approcci per raggiungere questo obiettivo, dagli snippet in primo piano al consentire alle persone di cercare voli nelle SERP.

Supponiamo che Google ritenga che il tuo testo generato non offra un valore superiore a quello che può già fornire. In tal caso, diventa semplicemente una questione di costi e benefici per il motore di ricerca.

Possono generare maggiori entrate a lungo termine assorbendo le spese di generazione e facendo aspettare all'utente una risposta invece di inviare l'utente in modo rapido ed economico a una pagina che sanno già esistere?

Rilevamento di contenuto AI

Insieme all'esplosione dell'utilizzo di ChatGPT sono arrivate dozzine di "rilevatori di contenuti AI" che ti consentono di inserire contenuti di testo e produrranno un punteggio percentuale, che è dove sta il problema.

Sebbene ci sia qualche differenza nel modo in cui i vari rilevatori etichettano questo punteggio percentuale, quasi invariabilmente danno lo stesso risultato: la percentuale di certezza che l'intero testo fornito sia generato dall'intelligenza artificiale.

Ciò crea confusione quando la percentuale è etichettata, ad esempio, "75% AI / 25% umano".

Molte persone fraintenderanno che questo significhi "il testo è stato scritto per il 75% da un'IA e per il 25% da un essere umano", quando significa "Sono sicuro al 75% che un'IA ha scritto il 100% di questo testo".

Questo malinteso ha portato alcuni a offrire consigli su come modificare l'input di testo per farlo "superare" un rilevatore di intelligenza artificiale.

Ad esempio, l'uso di un doppio punto esclamativo (!!) è una caratteristica molto umana, quindi l'aggiunta di questo a un testo generato dall'intelligenza artificiale risulterà in un rilevatore di intelligenza artificiale che fornisce un punteggio "99% + umano".

Questo viene quindi interpretato erroneamente che hai "ingannato" il rilevatore.

Ma è un esempio del rilevatore che funziona perfettamente perché il passaggio fornito non è più generato al 100% dall'IA.

Sfortunatamente, questa conclusione fuorviante di essere in grado di "ingannare" i rilevatori di intelligenza artificiale è anche comunemente confusa con motori di ricerca come Google che non rilevano i contenuti di intelligenza artificiale dando ai proprietari di siti Web un falso senso di sicurezza.

Norme e azioni di Google sui contenuti AI

Le dichiarazioni di Google sui contenuti AI sono state storicamente abbastanza vaghe da dare loro spazio di manovra per quanto riguarda l'applicazione.

Tuttavia, quest'anno è stata pubblicata una guida aggiornata in Google Search Central che dice esplicitamente:

"Il nostro obiettivo è la qualità dei contenuti, piuttosto che il modo in cui i contenuti vengono prodotti".

Ancor prima di questo, Danny Sullivan, il collegamento con la ricerca di Google, è intervenuto sulle conservazioni di Twitter per affermare che "non hanno detto che i contenuti AI sono cattivi".

Google elenca esempi specifici di come l'IA può generare contenuti utili, come risultati sportivi, previsioni del tempo e trascrizioni.

È chiaro che Google è molto più interessato all'output che ai mezzi per arrivarci, raddoppiando su "generare contenuti con lo scopo principale di manipolare il posizionamento nei risultati di ricerca è una violazione delle nostre norme antispam".

La lotta alla manipolazione della SERP è qualcosa in cui Google ha molti anni di esperienza, affermando che i progressi nei loro sistemi, come SpamBrain, hanno reso il 99% delle ricerche "prive di spam", che includerebbe spam UGC, scraping, cloaking e tutte le varie forme di contenuto generazione.

Molte persone hanno eseguito test per vedere come Google reagisce ai contenuti AI e dove tracciano il limite sulla qualità.

Prima del lancio di ChatGPT, ho creato un sito Web di 10.000 pagine di contenuti generati principalmente da un modello GPT3 non supervisionato, rispondendo a Le persone fanno anche domande sui videogiochi.

Con collegamenti minimi, il sito è stato rapidamente indicizzato ed è cresciuto costantemente, offrendo migliaia di visitatori mensili.

Durante due aggiornamenti di sistema di Google nel 2022, l'Helpful Content Update e il successivo aggiornamento Spam, Google ha improvvisamente e quasi completamente soppresso il sito.

Sarebbe sbagliato concludere che "il contenuto AI non funziona" da un simile esperimento.

Tuttavia, questo mi ha dimostrato che in quel particolare momento Google:

- Non stava classificando i contenuti GPT-3 non supervisionati come "qualità".

- Potrebbe rilevare e rimuovere tali risultati con una serie di altri segnali.

Per ottenere la risposta definitiva, hai bisogno di una domanda migliore

Sulla base delle linee guida di Google, ciò che sappiamo sui sistemi di ricerca, gli esperimenti SEO e il buon senso, "I motori di ricerca possono rilevare i contenuti AI?" è probabilmente la domanda sbagliata.

Nella migliore delle ipotesi, è una visione a brevissimo termine da adottare.

Nella maggior parte degli argomenti, gli LLM faticano a produrre costantemente contenuti di "alta qualità" in termini di accuratezza fattuale e che soddisfano i criteri EEAT di Google, nonostante dispongano di un accesso web in tempo reale per informazioni che vanno oltre i loro dati di formazione.

L'intelligenza artificiale sta facendo passi da gigante nella generazione di risposte a domande precedentemente scarse di contenuto. Ma poiché Google mira a obiettivi a lungo termine più ambiziosi con SGE, questa tendenza potrebbe svanire.

Si prevede che l'attenzione tornerà sui contenuti esperti in forma più lunga, con i sistemi di conoscenza di Google che forniscono risposte per soddisfare molte query longtail invece di indirizzare gli utenti a numerosi piccoli siti.

Le opinioni espresse in questo articolo sono quelle dell'autore ospite e non necessariamente Search Engine Land. Gli autori dello staff sono elencati qui.