Come migliorare l'efficienza della scansione e dell'indicizzazione a livello aziendale

Pubblicato: 2023-07-13La SEO aziendale gioca secondo regole diverse.

Le strategie che possono funzionare per siti web piccoli o di nicchia non sempre funzionano su larga scala.

Quindi cosa può succedere esattamente quando la SEO aziendale diventa troppo grande ?

In questo articolo, condividerò tre esempi di vita reale. Quindi imparerai un potenziale antidoto per una gestione più efficiente della SEO su larga scala.

Affrontare il dilemma dell'indicizzazione

I siti di piccole dimensioni tendono a crescere una pagina alla volta, utilizzando le parole chiave come elementi costitutivi di una strategia SEO.

I siti di grandi dimensioni spesso adottano approcci più sofisticati, basandosi pesantemente su sistemi, regole e automazione.

È fondamentale allineare la SEO con gli obiettivi aziendali. Misurare il successo SEO in base al posizionamento delle parole chiave o al traffico porta a conseguenze negative a causa dell'eccessiva indicizzazione.

Non esiste una formula magica per determinare il numero ottimale di URL indicizzati. Google non fissa un limite massimo.

Un buon punto di partenza, tuttavia, è considerare la salute generale del funnel SEO. Se un sito...

- Invia decine o centinaia di milioni o addirittura miliardi di URL a Google

- Classifica solo per pochi milioni di parole chiave

- Riceve visite a poche migliaia di pagine

- Converte una frazione di questi (se non del tutto)

…allora è una buona indicazione che devi affrontare alcune serie esigenze di salute SEO.

Risolvere ora eventuali problemi di igiene del sito dovrebbe prevenire problemi SEO ancora più grandi in seguito.

Diamo un'occhiata a tre esempi di SEO aziendale nella vita reale che illustrano perché questo è così importante.

Caso 1: conseguenze dell'eccessiva indicizzazione di contenuti di bassa qualità

Google dispone di risorse limitate per la scansione e l'elaborazione del Web. Danno la priorità ai contenuti che sono preziosi per gli utenti.

Google potrebbe eseguire la scansione, ma non l'indicizzazione, delle pagine che considera ridotte, duplicate o di bassa qualità.

Se sono solo poche pagine, non è un problema. Ma se è diffuso, Google potrebbe ignorare interi tipi di pagina o la maggior parte dei contenuti del sito.

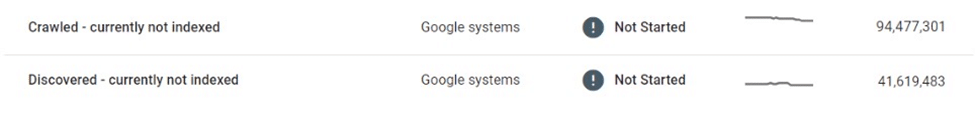

In un caso, un mercato di e-commerce ha scoperto che decine di milioni di pagine delle sue inserzioni erano influenzate dalla scansione e dall'indicizzazione selettive.

Dopo aver scansionato milioni di pagine di elenchi sottili e quasi duplicate e non averle indicizzate, Google alla fine ha ridimensionato del tutto la scansione del sito Web, lasciando molti nel limbo "Scoperto - attualmente non indicizzato".

Questo mercato faceva molto affidamento sui motori di ricerca per promuovere nuove inserzioni agli utenti. Non venivano più scoperti nuovi contenuti, il che rappresentava una sfida aziendale significativa.

Sono state prese alcune misure immediate, come il miglioramento dei collegamenti interni e l'implementazione di sitemap XML dinamiche. Alla fine, questi tentativi furono inutili.

La vera soluzione richiedeva il controllo del volume e della qualità dei contenuti indicizzabili.

Caso 2: Le conseguenze impreviste del gattonare cessano

Quando la scansione si interrompe, i contenuti indesiderati rimarranno nell'indice di Google, anche se vengono modificati, reindirizzati o eliminati.

Molti siti Web utilizzano reindirizzamenti anziché errori 404 per i contenuti rimossi per mantenere l'autorità. Questa tattica può spremere traffico aggiuntivo dalle pagine fantasma per mesi, se non anni.

Tuttavia, questo a volte può andare terribilmente storto.

Ad esempio, un noto mercato globale che vende prodotti artigianali ha accidentalmente rivelato le informazioni private dei venditori (ad es. nome, indirizzo, e-mail, numero di telefono) nelle versioni localizzate delle pagine delle loro inserzioni. Alcune di queste pagine sono state indicizzate e memorizzate nella cache da Google, visualizzando informazioni di identificazione personale (PII) nei risultati di ricerca, compromettendo la sicurezza e la privacy degli utenti.

Poiché Google non ha eseguito nuovamente la scansione di queste pagine, rimuoverle o aggiornarle non le eliminerebbe dall'indice. Anche mesi dopo l'eliminazione, i contenuti memorizzati nella cache e i dati personali degli utenti hanno continuato a esistere nell'indice di Google.

In una situazione come questa, era responsabilità del mercato correggere i bug e collaborare direttamente con Google per rimuovere i contenuti sensibili dalla Ricerca.

Caso 3: i rischi di un'indicizzazione eccessiva delle pagine dei risultati di ricerca

L'indicizzazione incontrollata di grandi volumi di pagine sottili e di bassa qualità può ritorcersi contro, ma per quanto riguarda l'indicizzazione delle pagine dei risultati di ricerca?

Google non approva l'indicizzazione dei risultati di ricerca interni e molti SEO esperti sconsigliano vivamente questa tattica. Tuttavia, molti siti di grandi dimensioni si sono affidati fortemente alla ricerca interna come principale driver SEO, ottenendo spesso rendimenti sostanziali.

Se le metriche sul coinvolgimento degli utenti, l'esperienza sulla pagina e la qualità dei contenuti sono sufficientemente elevate, Google può chiudere un occhio. In effetti, ci sono prove sufficienti per suggerire che Google potrebbe persino preferire una pagina dei risultati di ricerca interna di alta qualità a una pagina di elenco sottile.

Tuttavia, anche questa strategia può andare storta.

Una volta ho visto un sito di aste locali perdere una parte significativa del suo posizionamento nelle pagine di ricerca e più di un terzo del suo traffico SEO durante la notte.

La regola 20/80 si applica in quanto una piccola parte dei termini principali rappresenta la maggior parte delle visite SEO ai risultati di ricerca indicizzati. Tuttavia, è spesso la coda lunga che fa la parte del leone nel volume degli URL e vanta alcuni dei tassi di conversione più elevati.

Di conseguenza, dei siti che utilizzano questa tattica, pochi impongono limiti rigidi o regole sull'indicizzazione delle pagine di ricerca.

Questo pone due grossi problemi:

- Qualsiasi query di ricerca può generare una pagina valida, il che significa che un numero infinito di pagine potrebbe essere generato automaticamente.

- Tutti loro sono indicizzabili in Google.

Nel caso di un mercato di annunci che ha monetizzato le sue pagine di ricerca con annunci di terze parti, questa vulnerabilità è stata ben sfruttata attraverso una forma di arbitraggio pubblicitario:

- È stato generato un numero enorme di URL di ricerca per termini loschi, per adulti e del tutto illeciti.

- Sebbene queste pagine generate automaticamente non restituissero effettivi risultati di inventario, offrivano annunci di terze parti e venivano ottimizzate per classificare le query di ricerca richieste tramite modello di pagina e metadati.

- I backlink sono stati creati su queste pagine da forum di bassa qualità per farli scoprire e scansionare dai bot.

- Gli utenti che arrivavano su queste pagine da Google facevano clic sugli annunci di terze parti e passavano ai siti di bassa qualità che erano la destinazione prevista.

Quando lo schema è stato scoperto, la reputazione complessiva del sito era stata danneggiata. È stato anche colpito da diverse sanzioni e ha subito un massiccio calo delle prestazioni SEO.

Abbracciare l'indicizzazione gestita

Come avrebbero potuto evitare questi problemi?

Uno dei modi migliori per far prosperare i siti aziendali di grandi dimensioni nella SEO è ridimensionare attraverso l'indicizzazione gestita.

Per un sito di decine o centinaia di milioni di pagine, è fondamentale passare da un approccio incentrato sulle parole chiave a uno guidato da dati, regole e automazione.

Indicizzazione basata sui dati

Un vantaggio significativo dei siti di grandi dimensioni è la ricchezza di dati di ricerca interna a loro disposizione.

Invece di affidarsi a strumenti esterni, possono utilizzare questi dati per comprendere la domanda e le tendenze di ricerca regionali e stagionali a livello granulare.

Questi dati, se mappati all'inventario dei contenuti esistente, possono fornire una guida solida su quale contenuto indicizzare, nonché quando e dove farlo.

Deduplica e consolida

Un piccolo numero di URL autorevoli e di alto livello è molto più prezioso di un grande volume di pagine sparse tra le prime 100.

Vale la pena consolidare pagine simili utilizzando canonici, sfruttando le regole e l'automazione per farlo. Alcune pagine potrebbero essere consolidate in base a punteggi di somiglianza, altre - raggruppate insieme se si classificano collettivamente per query simili.

La chiave qui è la sperimentazione. Modifica la logica e rivedi le soglie nel tempo.

Pulisci le pagine di contenuto scarne e vuote

Se presenti in enormi volumi, pagine sottili e vuote possono causare danni significativi all'igiene e alle prestazioni del sito.

Se è troppo impegnativo migliorarli con contenuti di valore o consolidarli, allora dovrebbero essere noindexed o addirittura vietati.

Riduci gli spazi infiniti con robots.txt

Quindici anni dopo che Google ha scritto per la prima volta di "spazi infiniti", il problema della sovraindicizzazione di filtri, ordinamento e altre combinazioni di parametri continua ad affliggere molti siti di e-commerce.

In casi estremi, i crawler possono bloccare i server mentre tentano di farsi strada attraverso questi collegamenti. Per fortuna, questo può essere facilmente risolto tramite robots.txt.

Rendering lato client

L'utilizzo del rendering lato client per determinati componenti sulla pagina che non desideri vengano indicizzati dai motori di ricerca potrebbe essere un'opzione. Considera questo attentamente.

Meglio ancora, questi componenti dovrebbero essere inaccessibili per gli utenti disconnessi.

La posta in gioco aumenta drasticamente con l'aumentare della scala

Sebbene la SEO sia spesso percepita come una fonte di traffico "gratuita", questo è in qualche modo fuorviante. Ospitare e servire contenuti costa denaro.

I costi potrebbero essere trascurabili per URL, ma una volta che la scala raggiunge centinaia di milioni o miliardi di pagine, i centesimi iniziano a sommarsi a numeri reali.

Sebbene il ROI della SEO sia difficile da misurare, un centesimo risparmiato è un centesimo guadagnato e il risparmio sui costi attraverso la scansione e l'indicizzazione gestite dovrebbe essere un fattore quando si considerano le strategie di indicizzazione per siti di grandi dimensioni.

Un approccio pragmatico alla SEO, con crawling e indicizzazione ben gestiti, guidati da dati, regole e automazione, può proteggere i siti Web di grandi dimensioni da costosi errori.

Le opinioni espresse in questo articolo sono quelle dell'autore ospite e non necessariamente Search Engine Land. Gli autori dello staff sono elencati qui.