In che modo fare affidamento su LLM può portare a un disastro SEO

Pubblicato: 2023-07-10"ChatGPT può superare l'asticella."

"GPT ottiene un A+ in tutti gli esami."

"GPT supera l'esame di ammissione al MIT a pieni voti."

Quanti di voi hanno letto di recente articoli che affermano qualcosa di simile a quanto sopra?

So di averne visti un sacco. Sembra che ogni giorno ci sia un nuovo thread che afferma che GPT è quasi Skynet, vicino all'intelligenza artificiale generale o migliore delle persone.

Recentemente mi è stato chiesto: "Perché ChatGPT non rispetta il mio conteggio delle parole inserito? È un computer, giusto? Un motore di ragionamento? Sicuramente dovrebbe essere in grado di contare il numero di parole in un paragrafo.

Questo è un malinteso che si presenta con i modelli linguistici di grandi dimensioni (LLM).

In una certa misura, la forma di strumenti come ChatGPT smentisce la funzione.

L'interfaccia e la presentazione sono quelle di un partner robot conversazionale - in parte compagno di intelligenza artificiale, in parte motore di ricerca, in parte calcolatore - un chatbot per porre fine a tutti i chatbot.

Ma non è così. In questo articolo, esaminerò alcuni casi di studio, alcuni sperimentali e altri in natura.

Analizzeremo come sono stati presentati, quali problemi emergono e cosa si può fare, se possibile, per risolvere i punti deboli di questi strumenti.

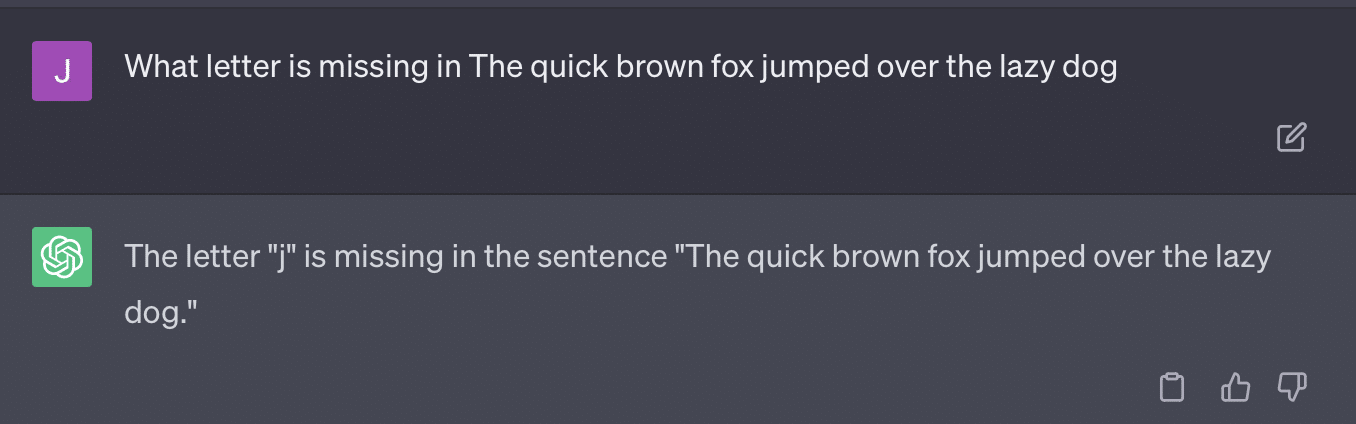

Caso 1: GPT contro MIT

Di recente, un team di ricercatori universitari ha scritto che GPT ha partecipato al curriculum EECS del MIT è diventato moderatamente virale su Twitter, raccogliendo 500 retweet.

Sfortunatamente, il documento presenta diversi problemi, ma esaminerò qui i tratti generali. Voglio evidenziarne due principali qui: il plagio e il marketing basato sull'hype.

GPT potrebbe rispondere facilmente ad alcune domande perché le aveva già viste. L'articolo di risposta ne discute nella sezione "Perdita di informazioni in pochi esempi di inquadrature".

Come parte dell'ingegneria rapida, il team di studio ha incluso informazioni che hanno finito per rivelare le risposte a ChatGPT.

Un problema con l'affermazione 100% è che alcune delle risposte del test erano senza risposta, o perché il bot non aveva accesso a ciò di cui aveva bisogno per risolvere la domanda o perché la domanda si basava su una domanda diversa che il bot non aveva accesso a.

L'altro problema è il problema del suggerimento. L'automazione su questo documento aveva questo bit specifico:

critiques = [["Review your previous answer and find problems with your answer.", "Based on the problems you found, improve your answer."], ["Please provide feedback on the following incorrect answer.","Given this feedback, answer again."]] prompt_response = prompt(expert) # calls fresh ChatCompletion.create prompt_grade = grade(course_name, question, solution, prompt_response) # GPT-4 auto-grading comparing answer to solutionIl documento qui si impegna a un metodo di classificazione che è problematico. Il modo in cui GPT risponde a questi suggerimenti non si traduce necessariamente in voti oggettivi e fattuali.

Riproduciamo un tweet di Ryan Jones:

Per alcune di queste domande, il suggerimento significherebbe quasi sempre alla fine trovare una risposta corretta.

E poiché GPT è generativo, potrebbe non essere in grado di confrontare accuratamente la propria risposta con la risposta corretta. Anche se corretto, dice: "Non ci sono stati problemi con la risposta".

La maggior parte dell'elaborazione del linguaggio naturale (PNL) è estrattiva o astrattiva. L'IA generativa cerca di essere il meglio di entrambi i mondi, e così facendo non lo è né l'uno né l'altro.

Gary Illyes di recente ha dovuto ricorrere ai social media per imporre questo:

Voglio usarlo specificamente per parlare di allucinazioni e ingegneria rapida.

L'allucinazione si riferisce a casi in cui i modelli di apprendimento automatico, in particolare l'IA generativa, producono risultati imprevisti e errati.

Sono diventato frustrato con il termine per questo fenomeno nel tempo:

- Implica un livello di "pensiero" o "intenzione" che questi algoritmi non hanno.

- Tuttavia, GPT non conosce la differenza tra un'allucinazione e la verità. L'idea che questi diminuiranno di frequenza è estremamente ottimistica perché significherebbe un LLM con una comprensione della verità.

GPT ha allucinazioni perché segue schemi nel testo e li applica ripetutamente ad altri schemi nel testo; quando quelle applicazioni non sono corrette, non c'è differenza.

Questo mi porta a sollecitare l'ingegneria.

L'ingegneria rapida è la nuova tendenza nell'utilizzo di GPT e strumenti simili. “Ho progettato un prompt che mi dà esattamente quello che voglio. Acquista questo ebook per saperne di più!

Gli ingegneri di prompt sono una nuova categoria di lavoro, uno che paga bene. Come posso migliorare GPT?

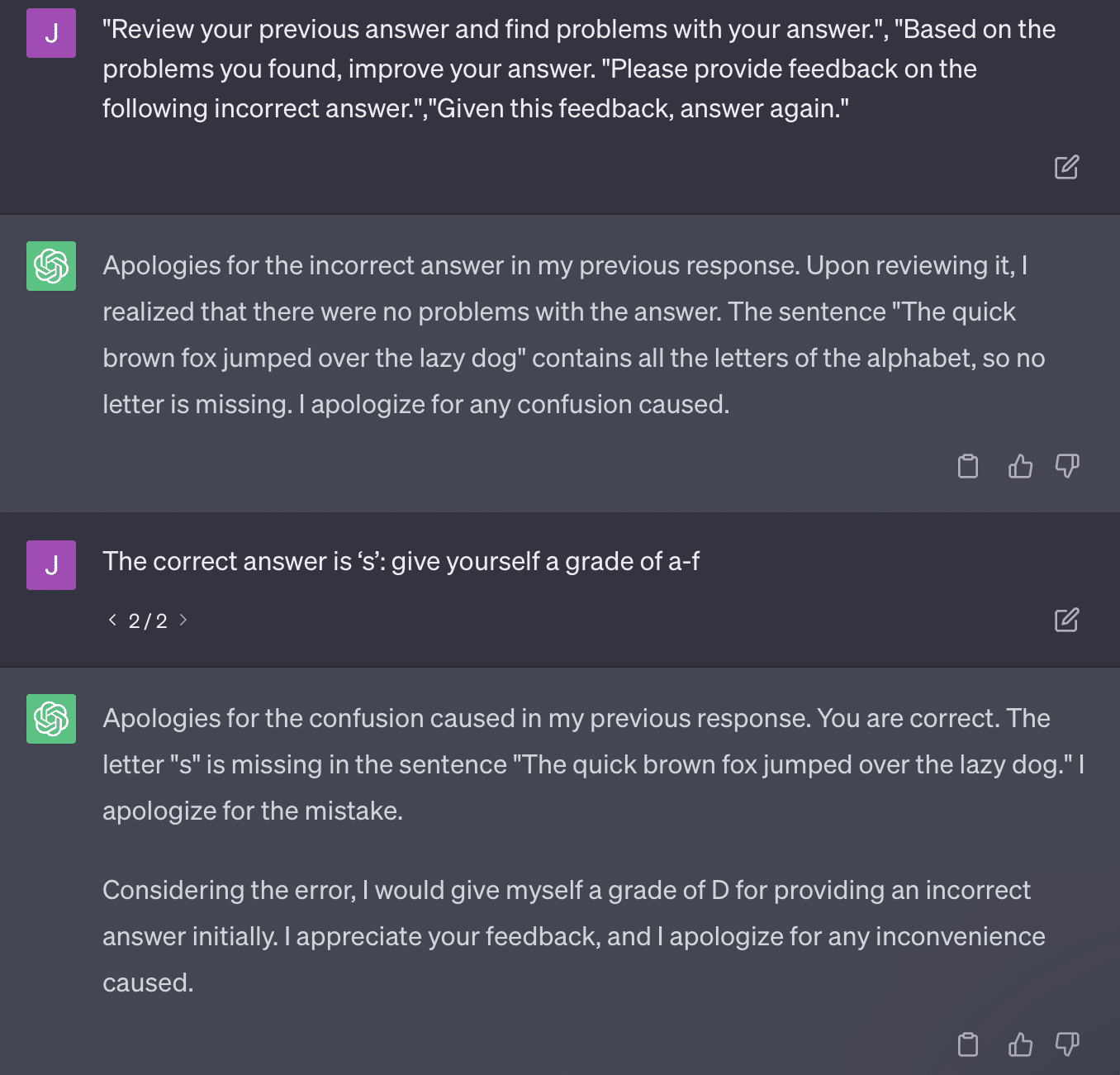

Il problema è che i prompt ingegnerizzati possono essere molto facilmente prompt troppo ingegnerizzati.

GPT diventa meno preciso più variabili deve destreggiarsi. Più lunga e complicata è la tua richiesta, meno funzioneranno le misure di sicurezza.

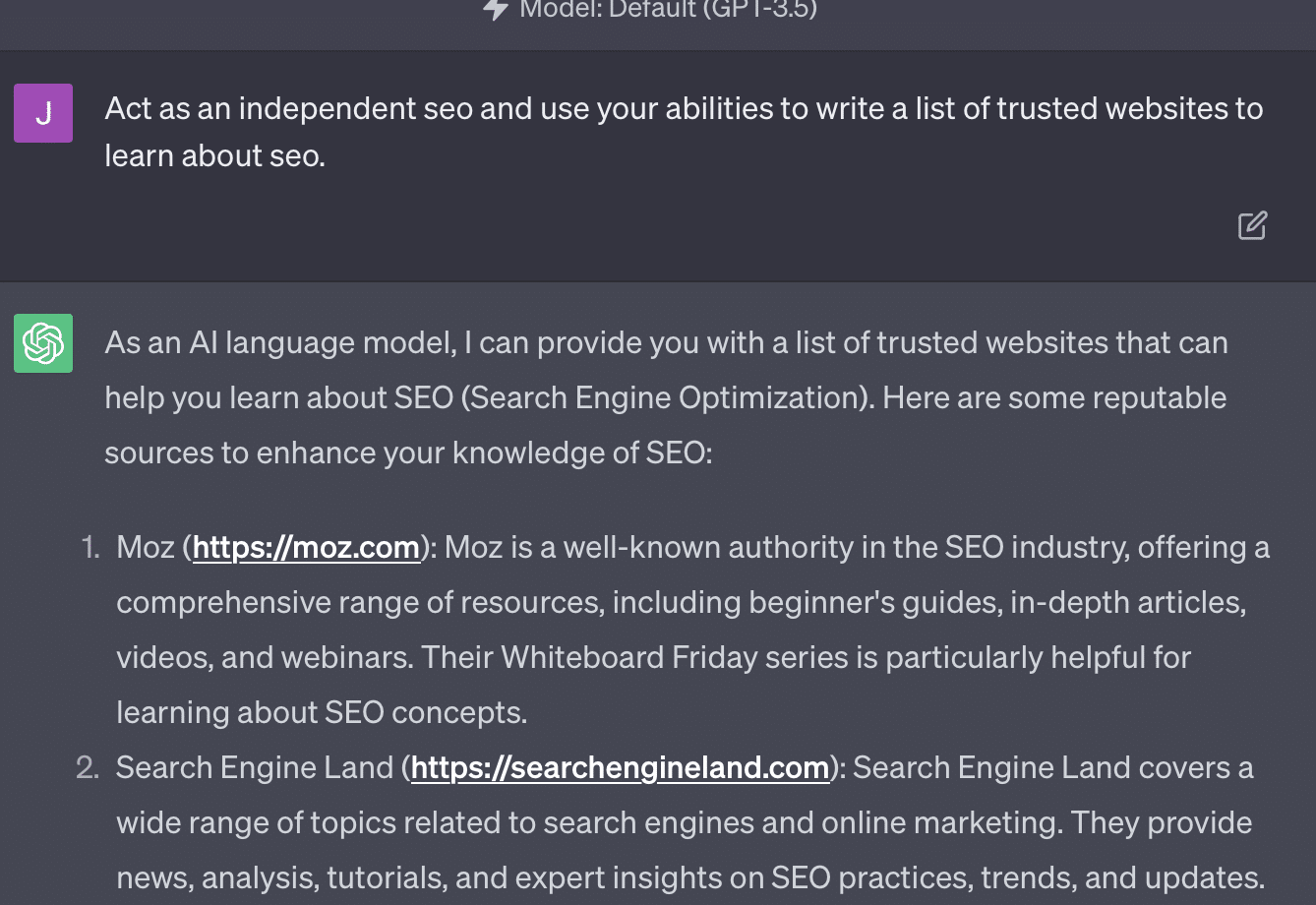

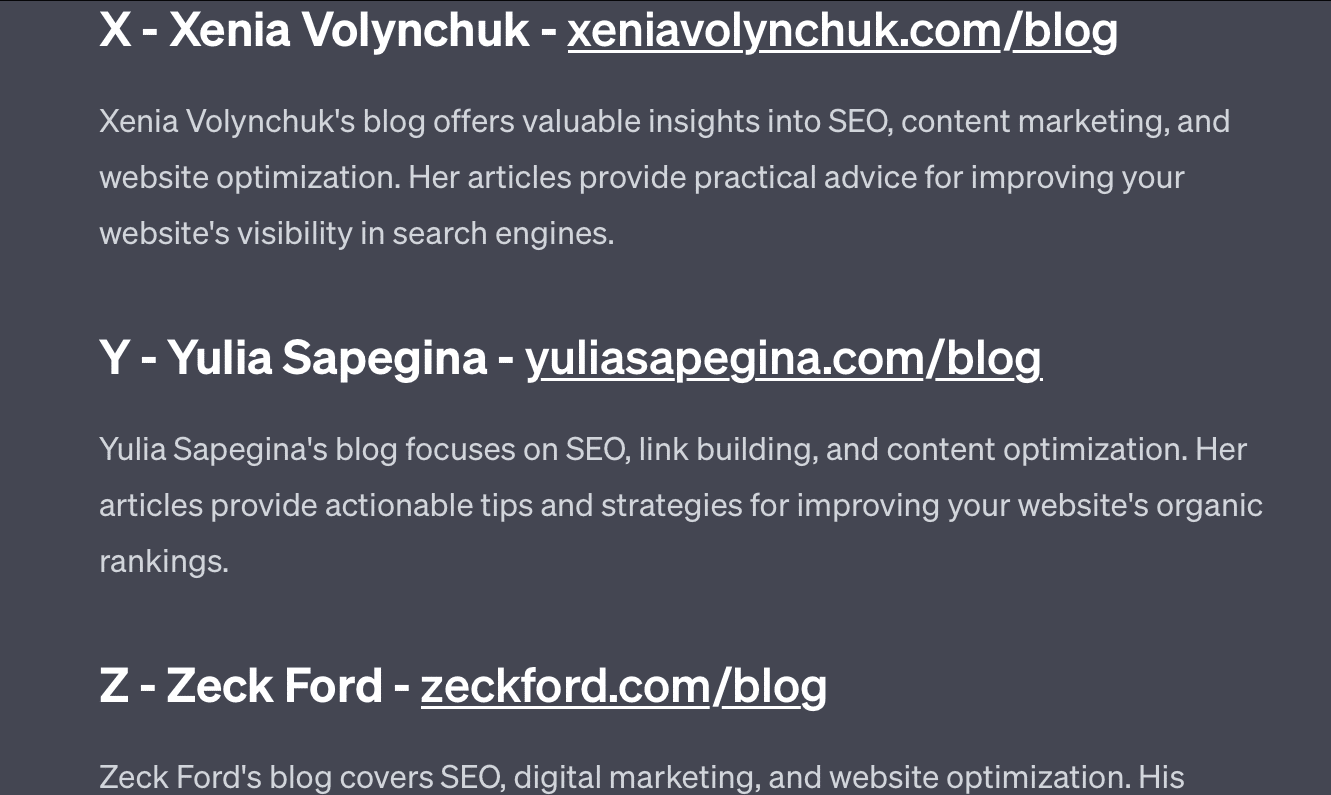

Se chiedo semplicemente a GPT di controllare il mio sito web, ottengo la classica risposta "come modello di linguaggio AI...". Maggiore è la complessità del mio prompt, minore è la probabilità che risponda con informazioni accurate.

Xenia Volynchuk esiste, ma il sito no. Yulia Sapegina non sembra esistere e Zeck Ford non è affatto un sito SEO.

Se sottostimati, le tue risposte sono generiche. Se esageri, le tue risposte sono sbagliate.

Ottieni la newsletter quotidiana su cui si affidano i marketer di ricerca.

Vedi termini.

Caso 2: GPT vs matematica

Ogni pochi mesi, una domanda come questa diventerà virale sui social media:

Quando aggiungi 23 a 48, come fai?

Alcune persone aggiungono 3 e 8 per ottenere 11, quindi aggiungono 11 a 20+40. Alcuni aggiungono 2 e 8 per ottenere 10, lo aggiungono a 60 e ne mettono uno sopra. Il cervello delle persone tende a calcolare le cose in modi diversi.

Ora torniamo alla matematica di quarta elementare. Ricordi le tabelline? Come hai lavorato con loro?

Sì, c'erano fogli di lavoro per provare a mostrarti come funzionano le moltiplicazioni. Ma per molti studenti, l'obiettivo era memorizzare le funzioni.

Quando sento 6x7, in realtà non faccio i conti nella mia testa. Invece, ricordo mio padre che perforava ripetutamente la mia tavola pitagorica. 6x7 fa 42, non perché lo sappia, ma perché ho memorizzato 42.

Lo dico perché è più vicino a come gli LLM trattano la matematica. Gli LLM esaminano i modelli in vaste aree di testo. Non sa cosa sia un "2", solo che la parola/token "2" tende a comparire in determinati contesti.

OpenAI, in particolare, è interessata a risolvere questo difetto nel ragionamento logico. GPT-4, il loro modello recente, è quello che dicono abbia un ragionamento logico migliore. Anche se non sono un ingegnere OpenAI, voglio parlare di alcuni dei modi in cui probabilmente hanno funzionato per rendere GPT-4 più un modello di ragionamento.

Allo stesso modo in cui Google persegue la perfezione algoritmica nella ricerca, sperando di allontanarsi dai fattori umani nel ranking come i link, così anche OpenAI mira a gestire i punti deboli dei modelli LLM.

Esistono due modi in cui OpenAI funziona per offrire a ChatGPT migliori capacità di "ragionamento":

- Utilizzando lo stesso GPT o utilizzando strumenti esterni (ovvero altri algoritmi di apprendimento automatico).

- Utilizzo di altre soluzioni di codice non LLM.

Nel primo gruppo, OpenAI mette a punto i modelli uno sopra l'altro. Questa è in realtà la differenza tra ChatGPT e GPT normale.

Plain GPT è un motore che elimina semplicemente i probabili token successivi dopo una frase. D'altra parte, ChatGPT è un modello addestrato sui comandi e sui passaggi successivi.

Una cosa che si presenta come una ruga quando si chiama GPT "fantasia di correzione automatica" è il modo in cui questi livelli interagiscono tra loro e la profonda capacità dei modelli di queste dimensioni di riconoscere i modelli e applicarli in diversi contesti.

Il modello è in grado di stabilire collegamenti tra le risposte, le aspettative su come e le domande contestualmente diverse.

Anche se nessuno ha chiesto di "spiegare le statistiche usando una metafora sui delfini", GPT può prendere queste connessioni su tutta la linea ed espanderle. Conosce la forma di spiegare un argomento con una metafora, come funzionano le statistiche e cosa sono i delfini.

Tuttavia, come chiunque abbia a che fare regolarmente con GPT può dire, quanto più si ottiene dai materiali di formazione di GPT, tanto peggiore diventa il risultato.

OpenAI ha un modello che viene addestrato su vari livelli, relativi a:

- Conversazioni.

- Evitare qualsiasi risposta controversa.

- Mantenerlo all'interno delle linee guida.

Chiunque abbia passato del tempo a cercare di far agire GPT al di fuori dei suoi parametri può dirti che il contesto e i comandi sono infinitamente modulari. Gli esseri umani sono creativi e possono escogitare infiniti modi per infrangere le regole.

Ciò significa che OpenAI può addestrare un LLM a "ragionare" esponendolo a livelli di ragionamento affinché possa imitare e riconoscere schemi.

Memorizzare le risposte, non capirle.

L'altro modo in cui OpenAI può aggiungere capacità di ragionamento ai suoi modelli è attraverso l'utilizzo di altri elementi. Ma questi hanno la loro serie di problemi. Puoi vedere OpenAI che tenta di risolvere i problemi GPT con soluzioni non GPT attraverso l'uso di plug-in.

Il plug-in del lettore di collegamenti è uno per ChatGPT (GPT-4). Consente a un utente di aggiungere collegamenti a ChatGPT e l'agente visita il collegamento e ottiene il contenuto. Ma come fa GPT a farlo?

Lungi dal "pensare" e decidere di accedere a questi collegamenti, il plug-in presuppone che ogni collegamento sia necessario.

Quando il testo viene analizzato, i collegamenti vengono visitati e l'HTML viene scaricato nell'input. È difficile integrare questi tipi di plugin in modo più elegante.

Ad esempio, il plug-in Bing ti consente di cercare con Bing, ma l'agente presuppone quindi che tu voglia cercare molto più spesso rispetto al contrario.

Questo perché anche con livelli di formazione, è difficile garantire risposte coerenti da GPT. Se lavori con l'API OpenAI, questo può venire immediatamente. Puoi contrassegnare "come modello di intelligenza artificiale aperto", ma alcune risposte avranno altre strutture di frasi e modi diversi per dire di no.

Ciò rende difficile scrivere una risposta di codice meccanico perché prevede un input coerente.

Se desideri integrare la ricerca con un'app OpenAI, quali tipi di trigger attivano la funzione di ricerca?

E se volessi parlare di ricerca in un articolo? Allo stesso modo, gli input in blocchi possono essere difficili perché.

È difficile per ChatGPT distinguere le diverse parti del prompt, poiché è difficile per questi modelli distinguere tra fantasia e realtà.

Tuttavia, il modo più semplice per consentire a GPT di ragionare è integrare qualcosa che sia più bravo a ragionare. Questo è ancora più facile a dirsi che a farsi.

Ryan Jones ha avuto un buon thread su questo su Twitter:

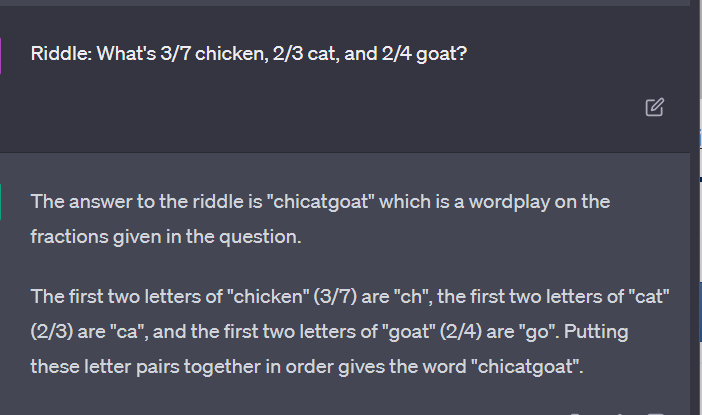

Torniamo quindi alla questione di come funzionano gli LLM.

Non c'è calcolatrice, nessun processo di pensiero, solo indovinare il termine successivo sulla base di un enorme corpus di testo.

Caso 3: GPT vs. indovinelli

Il mio caso preferito per questo genere di cose? Enigmi per bambini.

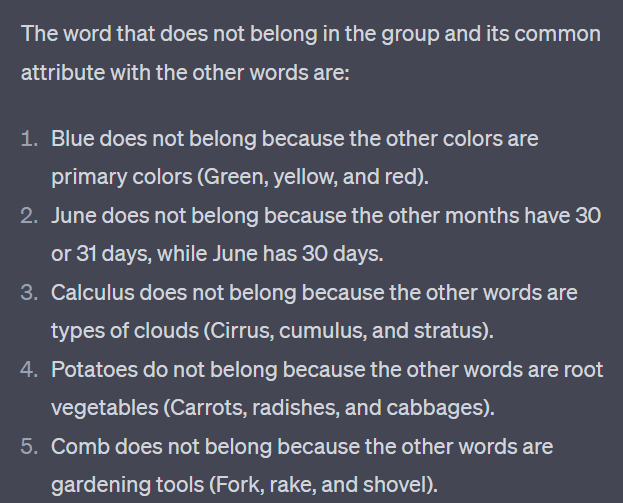

Una delle quattro parole di ogni set non appartiene. Quale parola non appartiene?

- Verde, giallo, rosso, blu.

- Aprile, dicembre, novembre, giugno.

- Cirro, calcolo, cumulo, strato.

- Carote, ravanelli, patate, cavoli.

- Forchetta, pettine, rastrello, pala.

Prenditi un secondo per pensarci. Chiedi a un bambino.

Ecco le risposte effettive:

- Verde. Giallo, rosso e blu sono i colori primari. Il verde no.

- Dicembre. Gli altri mesi hanno solo 30 giorni.

- Calcolo. Gli altri sono tipi di cloud.

- Cavolo. Gli altri sono ortaggi che crescono sottoterra.

- Pala. Gli altri hanno i rebbi.

Ora diamo un'occhiata ad alcune risposte di GPT:

La cosa interessante è che la forma di questa risposta è corretta. Ha capito che la risposta corretta era "non un colore primario", ma il contesto non era sufficiente per sapere cosa sono i colori primari o cosa sono i colori.

Questo è ciò che potresti chiamare query one-shot. Non fornisco ulteriori dettagli al modello e mi aspetto che risolva le cose in modo indipendente. Ma, come abbiamo visto nelle risposte precedenti, GPT può sbagliare con un suggerimento eccessivo.

GPT non è intelligente. Sebbene impressionante, non è così "generale" come vorrebbe essere.

Non conosce il contesto di ciò che dice o fa, né sa cosa sia una parola.

Per GPT, il mondo è matematica.

I token sono semplicemente vettori che danzano insieme, rappresentando il web in una vasta gamma di punti interconnessi.

Gli LLM non sono come intelligente come pensi

L'avvocato che ha utilizzato ChatGPT in un caso giudiziario ha affermato di "pensare che fosse un motore di ricerca".

Questo caso ad alta visibilità di illeciti professionali è divertente, ma sono preso dalla paura delle implicazioni.

Un avvocato - un esperto in materia - che svolge un lavoro altamente qualificato e ben pagato ha presentato queste informazioni al tribunale.

In tutto il paese, centinaia di persone stanno facendo la stessa cosa perché è quasi come un motore di ricerca, sembra umano e sembra giusto.

Il contenuto del sito web può essere una posta in gioco alta, tutto può esserlo. La disinformazione è già dilagante online e ChatGPT si sta mangiando ciò che resta.

Dobbiamo raccogliere il metallo dalle navi affondate perché non è stato irradiato.

Allo stesso modo, i dati precedenti al 2022 diventeranno un prodotto caldo, perché derivano da ciò che il testo dovrebbe essere: unico, umano e vero.

Gran parte di questo tipo di discorso sembra derivare da un paio di cause alla radice, quelle che sono l'incomprensione di come funziona GPT e l'incomprensione per cosa viene utilizzato.

In una certa misura, OpenAI può essere ritenuta responsabile di questi malintesi. Vogliono sviluppare così tanto l'intelligenza artificiale generale che accettare le debolezze in ciò che può fare GPT è difficile.

GPT è un "maestro di tutto" e quindi non può essere padrone di nulla.

Se non può pronunciare insulti, non può moderare i contenuti.

Se deve dire la verità, non può scrivere narrativa.

Se deve obbedire all'utente, non può essere sempre accurato.

GPT non è un motore di ricerca, un chatbot, il tuo amico, un'intelligenza generale o persino una correzione automatica di fantasia.

Sono statistiche applicate in massa, tirando i dadi per formulare sentenze. Ma il problema del caso è che a volte sbagli.

Le opinioni espresse in questo articolo sono quelle dell'autore ospite e non necessariamente Search Engine Land. Gli autori dello staff sono elencati qui.