Test A/B per dispositivi mobili: 7 grandi errori e malintesi che devi evitare

Pubblicato: 2021-10-23

Non è un segreto che il marketing in generale si basi principalmente sui dati. Lo stesso vale per il marketing mobile e l'acquisizione degli utenti. In questo ambito, la scelta degli elementi giusti della pagina del prodotto per l'App Store e Google Play può fare una differenza cruciale per il successo di un'app o di un gioco mobile. Il test A/B mobile è uno strumento che aiuta a fare quella scelta in base ai dati.

Tuttavia, quante volte abbiamo sentito l'argomento che i test A/B non portano i risultati desiderati o che qualcuno non è sicuro di eseguire gli esperimenti mobili nel modo giusto? Ciò accade spesso a causa di alcuni errori comuni e di interpretazioni errate dei dati. In questo post tratterò gli errori più grandi e le conclusioni fuorvianti nei test A/B delle app mobili, la cui conoscenza ti aiuterà a raggiungere il successo.

1. Terminare un esperimento prima di ottenere la giusta quantità di traffico

Questo è uno degli errori più comuni nei test A/B mobili. Nel caso in cui aderisci al classico test A/B, terminare un esperimento prima di ottenere la quantità di traffico necessaria - dimensione del campione - presenta il rischio di ottenere risultati statisticamente inaffidabili .

Per ottenere prove affidabili, è necessario attendere il raggiungimento della quantità di traffico richiesta per entrambe le varianti A e B.

Se stai cercando un'alternativa alla classica opzione, ricorri agli A/B Test sequenziali. Dovrai iniziare specificando il tasso di conversione di base (tasso di conversione della tua variazione attuale), la potenza statistica (80% per impostazione predefinita), il livello di significatività e l' effetto minimo rilevabile (MDE) : questo ti aiuterà a determinare la dimensione del campione.

Il livello di significatività è 5% per impostazione predefinita, il che significa che il margine di errore non supererà il 5%. Puoi personalizzare questo valore insieme all'MDE , l'aumento minimo del tasso di conversione previsto che vorresti vedere . Nota: non modificare il livello di significatività, MDE o potenza statistica dopo aver avviato un esperimento.

Con il test A/B sequenziale, l'algoritmo controllerà costantemente le tue variazioni sul livello di significatività e la quantità di traffico rimasta fino al completamento dell'esperimento. Ecco come funziona sulla nostra piattaforma di test A/B SplitMetrics.

Lezione appresa: se esegui i test A/B classici, non terminare un esperimento finché non viene raggiunta la giusta quantità di traffico. Oppure, prova il test A/B sequenziale e sarai in grado di controllare i risultati in qualsiasi momento.

2. Terminare un esperimento prima che siano trascorsi 7 giorni

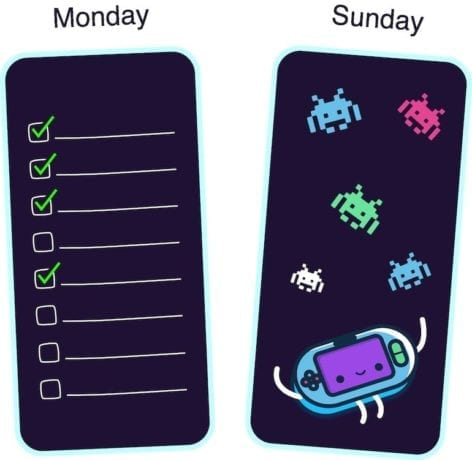

Perché devi aspettare almeno sette giorni? Ebbene, varie app e giochi per dispositivi mobili registrano picchi di attività in giorni diversi durante la settimana . Ad esempio, le app aziendali guardano le esplosioni di attività il lunedì, mentre i giochi sono più popolari tra gli utenti nei fine settimana.

Per ottenere risultati affidabili dagli esperimenti di test A/B per dispositivi mobili, dovresti acquisire i giorni di punta della tua app durante un esperimento. Altrimenti, corri il rischio di saltare alle conclusioni.

Ad esempio, esegui test per un'app di gestione delle attività. Inizi un esperimento mercoledì e lo finisci sabato. Ma la maggior parte del tuo pubblico di destinazione utilizza la tua app il lunedì, quindi ti perderai il punto poiché l'ondata di attività non è entrata nel periodo dell'esperimento. O viceversa, hai eseguito test A/B per il tuo gioco di corse dal venerdì alla domenica: nei giorni di punta del gioco. Anche in questo caso i risultati saranno insufficienti.

Quindi, anche se hai evitato l'errore numero uno e hai già ottenuto la quantità di traffico richiesta il primo giorno, non interrompere l'esperimento prima che siano trascorsi sette giorni.

Lezione appresa: a causa di picchi di attività deboli che variano per ogni gioco o app per dispositivi mobili, non terminare un esperimento prima che sia trascorso il ciclo completo (sette giorni).

3. Testare modifiche troppo piccole nel design

Un altro errore comune nei test A/B per dispositivi mobili è il confronto di variazioni che sembrano quasi identiche a causa di piccole differenze nel design.

Se l'unica differenza tra le icone delle app mobili che stai testando è un colore di sfondo blu anziché azzurro, o hai aggiunto un piccolo dettaglio a un'altra variazione dello screenshot, sei decisamente nei guai. Gli utenti semplicemente non notano cambiamenti così piccoli.

In questo caso, entrambe le variazioni mostreranno lo stesso risultato, ed è perfettamente normale. Quindi, se hai mai provato a eseguire i test A/B dell'app store ma poi ci hai rinunciato, poiché le variazioni hanno funzionato allo stesso modo, è tempo di riflettere su cosa è andato storto. Forse le tue varianti sembravano più o meno le stesse.

Per assicurarti che stai testando A/B un cambiamento significativo, mostra entrambe le versioni alla tua famiglia o ai tuoi amici. Lascia che il tuo collega guardi ogni variazione per 3-5 secondi. Se non conoscono la differenza, faresti meglio a ridisegnare le tue risorse visive.

Lezione appresa: nel caso in cui si verifichino variazioni con modifiche troppo piccole nel design, ci si dovrebbe aspettare che mostrino lo stesso risultato. Tali modifiche sono troppo insignificanti per gli utenti, quindi è meglio testare le icone delle app e gli screenshot che differiscono notevolmente l'uno dall'altro.

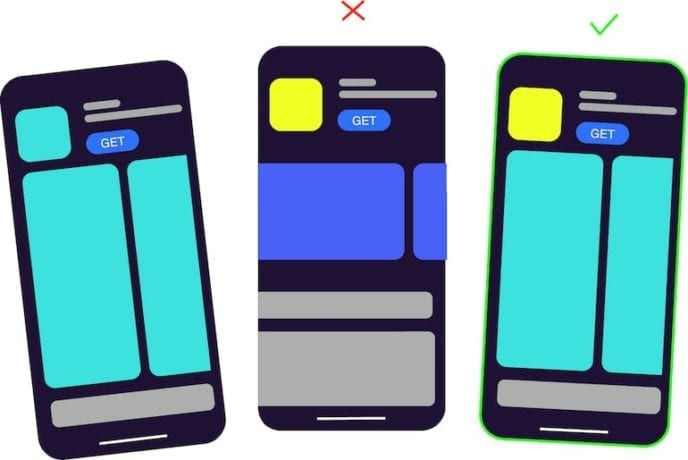

4. I tuoi banner pubblicitari hanno lo stesso design di una delle risorse visive dell'app store

Se utilizzi uno strumento di test A/B mobile di terze parti, come, ad esempio, SplitMetrics, acquisti traffico e inserisci banner nelle reti pubblicitarie. Il punto è che un tale banner non dovrebbe apparire come una delle risorse visive che stai testando , che si tratti di uno screenshot o degli stessi elementi su un'icona.

Ad esempio, esegui esperimenti per la tua app educativa. Disegni un banner che ha lo stesso elemento, come l'icona della variazione A, mentre la variazione B è completamente un'altra icona. La variante A mostrerà il tasso di conversione più elevato, poiché ha lo stesso design, come inizialmente visto e cliccato dagli utenti del banner.

Gli studi dimostrano che se le persone vedono qualcosa ripetutamente, il loro cervello elabora le informazioni più velocemente, il che porta loro un senso di simpatia. Puoi leggere di più a riguardo qui. Quindi, gli utenti tendono a toccare inconsciamente le immagini già familiari.

Lezione appresa: quando si lavora su banner pubblicitari, rendere il design il più neutro possibile. Il design del banner non deve coincidere con il design dell'icona della tua app o con le variazioni degli screenshot.

5. Testare più ipotesi contemporaneamente

Non ha senso apportare più modifiche e testarle nello stesso esperimento. Alcuni esperti di marketing mobile traggono conclusioni sbagliate dopo aver eseguito un test, poiché hanno apportato diverse modifiche e, in effetti, non possono sapere esattamente cosa ha influito sul risultato.

Se hai deciso di cambiare il colore degli screenshot della pagina del prodotto dell'app store, crea una o alcune varianti con un altro colore di sfondo ed esegui un test. Non modificare contemporaneamente il colore, l'ordine e il testo degli screenshot. Altrimenti, vedrai la variazione vincente (lascia che sia la variazione B) e non avrai idea se è il cambio di colore che ha effettivamente funzionato.

Lezione appresa: se metti alla prova più ipotesi contemporaneamente, non sarai in grado di capire quale di esse è corretta.

6. Interpretare male la situazione quando due varianti sono uguali ma ottieni un vincitore

Durante l'esecuzione di test A/A, potresti rimanere confuso quando uno strumento di test A/B mostra la variazione vincente tra due risorse identiche. In particolare, questo è comune per lo strumento integrato di Google Play Store per l'esecuzione di esperimenti.

Sulla piattaforma SplitMetrics, al livello di significatività del 5%, in tal caso, vedrai che il risultato è insignificante.

Piccole differenze tra due esattamente le stesse variazioni sono pura coincidenza. Utenti diversi hanno reagito in modo leggermente diverso. È come lanciare una moneta: c'è una probabilità del 50-50 che tu ottenga testa o croce, e c'è una probabilità del 50-50 che una delle varianti mostri un risultato migliore.

Per ottenere un risultato statisticamente significativo in una situazione come questa, dovresti ottenere risultati da tutti gli utenti, il che è impossibile.

Lezioni apprese: se ottieni la variazione vincente durante il test di risorse identiche, non c'è nulla di sbagliato nel tuo strumento di test A/B, è solo una coincidenza. Tuttavia, con il test A/B sequenziale, vedrai che il risultato è insignificante.

7. Arrabbiarsi quando una nuova variazione perde rispetto a quella attuale

Alcuni esperti di marketing mobile e responsabili dell'acquisizione degli utenti rimangono delusi quando un esperimento mostra che la variante attuale vince, cosa che non si aspettavano, e iniziano a sprecare un budget per traffico più pagato nella speranza che alla fine vinca la nuova variante.

Non c'è motivo di sentirsi male se la tua ipotesi non è stata confermata. Se avessi modificato qualcosa sulla pagina del prodotto dell'app store senza eseguire il test, avresti perso una parte dei tuoi potenziali clienti e, di conseguenza, denaro. Allo stesso tempo, avendo speso soldi per questo esperimento, hai pagato per la conoscenza . Ora sai cosa funziona per la tua app e cosa no.

Lezione appresa: tutto accade per una ragione e non dovresti essere dispiaciuto se il tuo test A/B non ha confermato la tua ipotesi. Ora hai una visione chiara di quali risorse funzionano meglio per il tuo gioco o app.