Che cos'è il budget di scansione [e come ottimizzarlo]?

Pubblicato: 2022-05-16Crawl budget è uno di quei termini SEO di cui probabilmente hai sentito parlare le persone del marketing.

Tuttavia, sai cosa significa e di cosa si tratta?

Non preoccuparti, non siamo qui per metterti alla prova. Al contrario, siamo qui per aiutarti a capire tutto sul crawl budget, perché è importante e come puoi verificarlo e ottimizzarlo.

Dopotutto, devi imparare a gattonare prima di poter camminare, giusto?

Che cos'è il budget di scansione?

Il budget di scansione è il numero di pagine che Google può scansionare su un sito Web in un intervallo di tempo specifico.

Vedi, ogni volta che pubblichi una pagina sul tuo sito web, devi aspettare che Google la indicizzi e la classifichi e, per poterlo fare, i suoi robot devono prima eseguirne la scansione.

Questo processo potrebbe avvenire più velocemente o più lentamente a seconda di circostanze come quanto è grande il tuo sito web, quanto sono popolari gli argomenti, quanto traffico c'è sulla tua pagina, ecc.

Ma come funziona effettivamente la scansione?

Scopriamolo.

Come funzionano i crawler?

Più di 10 anni fa, Google si è resa conto di avere risorse limitate e di poter trovare solo una percentuale limitata dell'infinito contenuto online che viene costantemente pubblicato online.

Quindi, nel 2017, Google ha pubblicato il suo articolo ufficiale "Cosa significa il crawl budget per Googlebot", in cui spiegano la loro definizione di scansione e altri dettagli pertinenti.

Ecco i fatti essenziali:

- La scansione è efficiente, a meno che il tuo sito web non abbia più di qualche migliaio di URL

- Le pagine a risposta rapida aumentano il limite di scansione

- Puoi ridurre la velocità di scansione del tuo sito Web tramite Google Search Console

- Gli URL popolari tendono a essere scansionati più spesso

- Un'abbondanza di URL di basso valore (contenuti duplicati, pagine di errore soft, ecc.) può avere un impatto negativo sull'indicizzazione e sulla scansione

- La scansione non è un fattore di ranking diretto

Fondamentalmente, per garantire la massima scansionabilità del tuo sito web, devi avere tempi di caricamento rapidi, evitare contenuti duplicati e di bassa qualità e rendere popolari le tue pagine.

Tuttavia, è importante notare che la maggior parte dei proprietari di siti Web non deve preoccuparsi troppo del crawl budget. Si tratta di grandi siti Web con migliaia di pagine, come negozi di eCommerce, pubblicazioni digitali e blog popolari, che dovrebbero prestare attenzione.

Perché il budget di scansione è importante?

Il budget di scansione è molto importante per i tuoi sforzi SEO, specialmente quando hai migliaia di pagine e pubblichi costantemente molti nuovi articoli su base giornaliera. I bot vorranno eseguire la scansione dei tuoi nuovi contenuti, ma contemporaneamente rivisiteranno anche il resto del tuo sito web.

Se incontrano più battute d'arresto e/o problemi che li confondono, rimarranno bloccati a sprecare il budget di scansione sulle vecchie pagine, invece di investirlo nel nuovo contenuto che desideri indicizzare. Questo può, potenzialmente, creare ritardi e rendere temporaneamente (o anche permanentemente) i tuoi URL non disponibili nelle SERP.

Ad esempio, stai pubblicando notizie o informazioni importanti per ottenere visibilità il più velocemente possibile.

Non vorresti aspettare una settimana prima che il tuo post venga indicizzato, vero?

Dopotutto, non puoi classificarti per una SERP se la tua pagina non è indicizzata. E supponiamo che tu stia scrivendo di un evento mondiale accaduto oggi, ma la tua pagina viene scansionata tra cinque giorni. A quel punto, è troppo tardi per raggiungere il tuo obiettivo iniziale, poiché l'evento non è più così rilevante e attuale. Per non parlare del fatto che molti altri siti Web ne avranno scritto e saranno indicizzati in tempo.

Non è raro che i bot di scansione impieghino fino a una settimana per indicizzare la tua pagina, ma ad essere onesti, dovrebbe richiedere meno tempo.

Inoltre, nel frattempo continuerai a pubblicare nuove pagine che devono essere scansionate, indicizzate e disponibili anche per il tuo pubblico di destinazione in modo tempestivo. E questa è una ricetta per un collo di bottiglia nell'indicizzazione.

Tutto sommato, se raggiungi spesso i limiti del tuo crawl budget, rischi che alcune delle tue pagine scivolino tra le crepe e non arrivino alle SERP. Di conseguenza, questi non trarranno vantaggio dal traffico organico e avranno una visibilità molto inferiore rispetto al resto dei tuoi contenuti.

E se ti stai chiedendo come controllare il tuo crawl budget, è facile. Basta andare su Google Search Console e controllare Scansione → Statistiche scansione.

Ottimizzazione del budget di scansione

È importante ricordare che il crawl budget dipende da tre fattori principali: dimensioni del sito Web, salute del sito Web e popolarità del sito Web.

Ciò significa che non devi preoccuparti degli sprechi di crawl budget se:

- Il tuo sito web è moderatamente piccolo, il che significa meno di poche migliaia di pagine.

- Il tuo sito web è privo di errori di codice di stato e ha una corretta canonizzazione.

- Il tuo sito web è popolare, il che significa che hai sviluppato un seguito sui social media e altri canali per condividere i tuoi contenuti e generare traffico.

La copertura di questi criteri significa che Googlebot dovrebbe essere in grado di eseguire in modo efficiente la scansione del tuo sito web.

Nel caso in cui tu non abbia uno di questi tre fattori, c'è il rischio che tu possa riscontrare diversi livelli di problemi di scansione e perdere la visibilità della ricerca organica per alcune delle tue pagine.

Di seguito sono riportate alcune best practice per il crawl budget da seguire:

Migliora la velocità del tuo sito web

Come accennato in precedenza, la velocità del sito Web e il tempo di caricamento della pagina potrebbero influire sul limite di scansione. Un sito web sano e veloce significa che Googlebot è in grado di eseguire la scansione di più pagine e in meno tempo.

D'altra parte, il caricamento più lento delle pagine riduce la velocità di scansione e, in un sito Web di grandi dimensioni, ciò può causare problemi di indicizzazione generali.

In poche parole, assicurati di ottimizzare la velocità del tuo sito. Questo non solo renderà più facile per i bot, ma migliorerà l'esperienza dell'utente.

Applicare il collegamento interno

Lo scenario migliore è avere backlink che puntano a ogni pagina del tuo sito. Questa non è solo una buona pratica SEO per attirare visitatori sul tuo sito e mostrare ai motori di ricerca che i tuoi contenuti contano, ma attira anche Googlebot.

In poche parole, i backlink sono il ragazzo d'oro della SEO.

Ma ecco l'accordo.

Oltre ai backlink, Google ama anche i link interni. Lo aiuta a scoprire tutte le tue pagine e a capire meglio come sono correlate. E mentre i backlink possono essere difficili da trovare, hai il controllo completo su quelli interni e puoi aggiungerne quanti ne vuoi (basta non esagerare).

L'applicazione di questa tecnica di ottimizzazione garantirà la scansione di un numero maggiore di pagine.

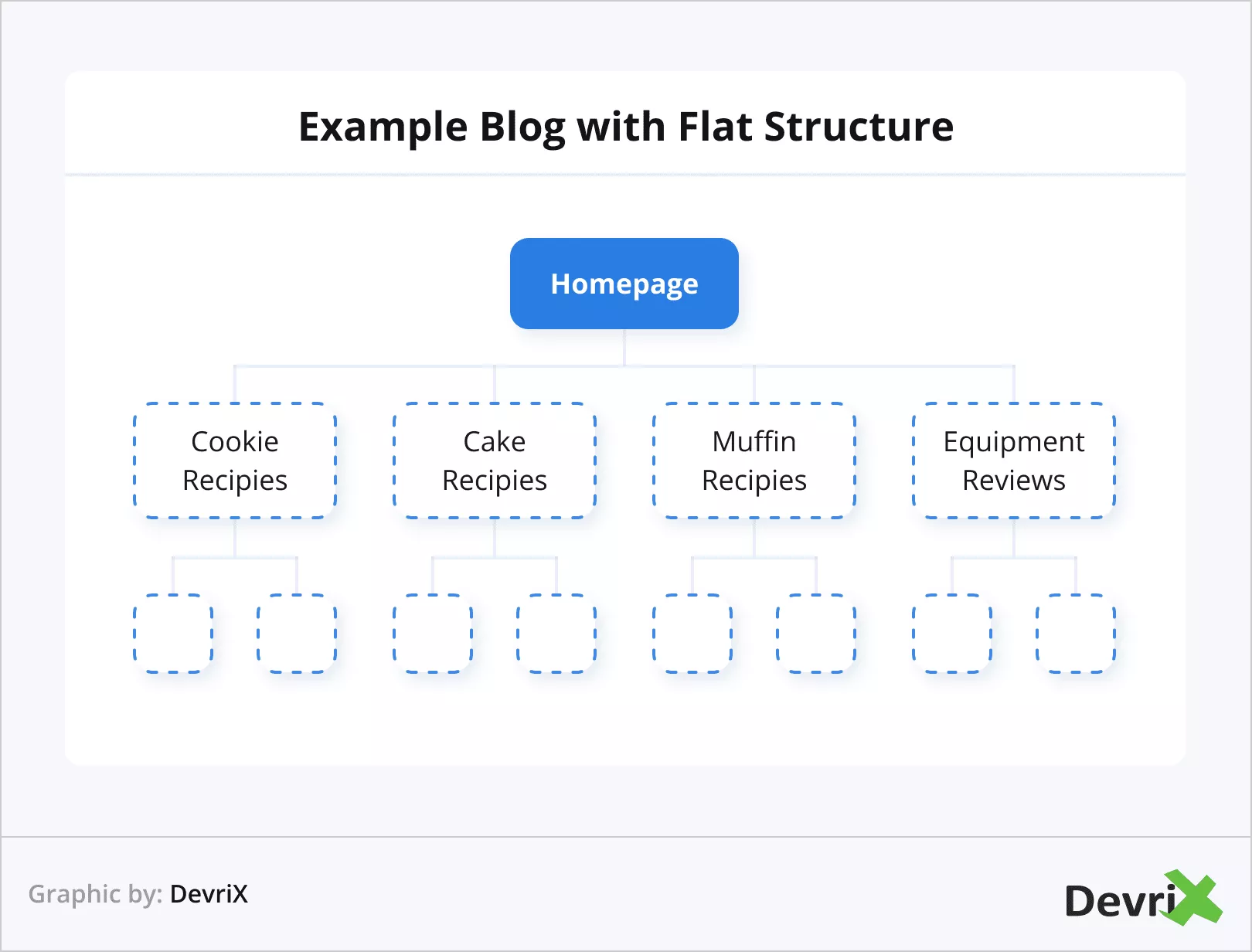

Usa architettura web piatta

La popolarità è molto importante agli occhi di Google. Questo è il motivo per cui sarebbe vantaggioso utilizzare un'architettura di sito Web piatta. L'architettura piatta consente all'autorità di collegamento di avere proporzioni uguali su tutte le tue pagine.

Aiuterà i robot a seguire come i collegamenti sul tuo sito Web sono collegati più facilmente e ti consentirà inoltre di raggruppare meglio le pagine correlate e ottenere autorità di attualità.

In pratica, ciò significa che sia gli utenti che i motori di ricerca possono raggiungere qualsiasi pagina del tuo sito Web in quattro clic.

Evita le pagine orfane e i contenuti duplicati

Una pagina orfana è una pagina che non contiene un singolo collegamento esterno, né interno. Ciò rende questi tipi di pagine isolati dal resto dei tuoi contenuti e, logicamente, sono anche più difficili da scoprire per Googlebot.

Puoi facilmente evitare le pagine orfane aggiungendo almeno un link interno a ogni articolo e pagina che hai.

Gestisci contenuti duplicati

Il contenuto duplicato causa numerosi problemi. Avere più URL con parametri simili crea confusione per i bot di scansione. Questo farà perdere tempo a Googlebot, dal momento che dovrà capire quale pagina è quella principale e quale è una versione duplicata, e questo porterà a un processo di scansione più lento.

Per siti come le piattaforme di eCommerce, dove è comune avere più URL simili, a causa di più prodotti simili con piccole differenze, come dimensioni e colore, assicurati di utilizzare i tag canonici, che guideranno Googlebot alle pagine a cui vuoi dare la priorità.

Non consentire la scansione di alcune pagine

Ogni sito Web ha pagine come login, moduli di contatto, carrelli della spesa e così via. Questi non hanno bisogno di essere scansionati e, soprattutto, non possono essere scansionati. Tuttavia, Google ci proverà, quindi è una buona idea far sapere ai robot che dovrebbero saltarli e risparmiare risorse.

Per eseguire questa azione, utilizza il tuo file robots.txt per impedire la scansione delle pagine desiderate.

Aggiorna vecchio e scrivi nuovo contenuto

Abbiamo già detto che a Google piacciono i contenuti freschi? Lo fa.

Google potrebbe anche interrompere la scansione della tua pagina, poiché non c'era nulla di nuovo lì le ultime volte che è stata scansionata.

Immagina che Googlebot visiti il tuo sito una volta ogni due giorni e ogni volta che trova nuovi contenuti da indicizzare. Poi, all'improvviso, per qualche motivo, smetti di aggiornare il tuo sito web. Tuttavia, Googlebot continua a visitarlo con la stessa frequenza. Dopo un po', il bot si accorge che non ci sono nuovi contenuti da indicizzare e, alla fine, rende le visite meno frequenti.

Nello scenario opposto, in cui inizi a fornire nuovi contenuti più spesso, Googlebot potrebbe iniziare a visitare il tuo sito Web più spesso.

Fonte

In genere, quando stabilisci quali pagine devono essere aggiornate, osserva la pertinenza: un articolo potrebbe essere vecchio di due anni e avere ancora informazioni applicabili (dovresti comunque aggiornarlo). Oppure potrebbe essere un materiale vecchio di un mese che ha già perso la sua freschezza.

Riduci le pagine di errore

Questo è semplice da capire.

Googlebot perde tempo quando tenta di eseguire la scansione di pagine con codici di errore 5xx (errore del server), codici di errore 4xx (errore impossibile da trovare), codici di errore 3xx (reindirizzamenti) ecc. e, di conseguenza, questo riduce il limite della velocità di scansione.

Fonte

Fondamentalmente, ogni pagina che risulta in un codice diverso da 200 è una perdita di tempo e risorse di ricerca per indicizzazione. In pratica, non è necessario indirizzare l'attenzione di Google sulle pagine che hai cancellato o reindirizzato. Invece, dai la priorità alla correzione dei tuoi URL attivi.

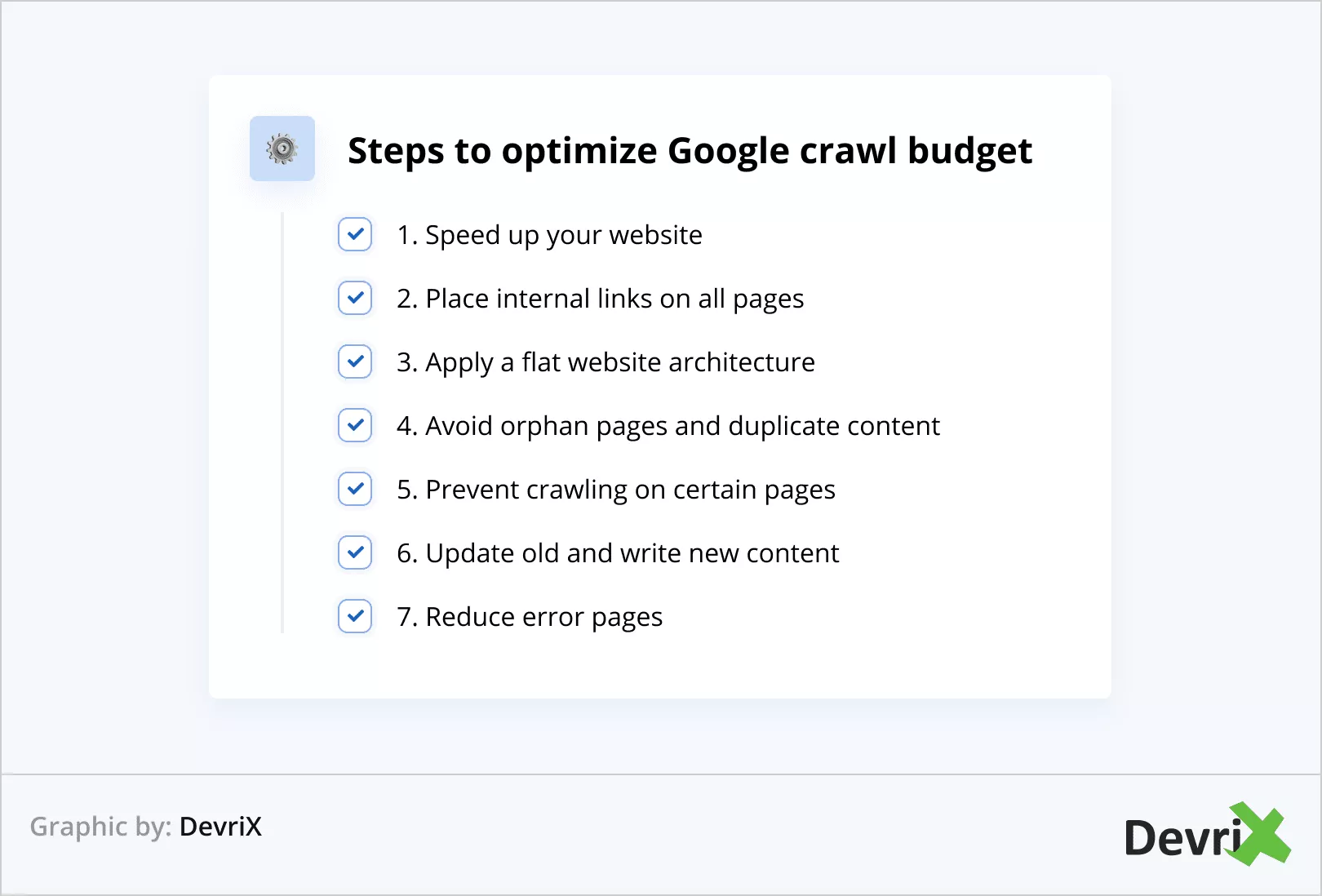

Ottimizzazione del budget di scansione in breve

Ricapitoliamo i passaggi per ottimizzare il budget di scansione di Google:

- Velocizza il tuo sito web

- Inserisci link interni in tutte le pagine

- Applicare un'architettura di sito Web piatta

- Evita le pagine orfane e i contenuti duplicati

- Impedisci la scansione su determinate pagine

- Aggiorna il vecchio e scrivi il nuovo contenuto

- Riduci le pagine di errore

Suggerimento bonus

Puoi controllare la frequenza con cui viene eseguita la scansione del tuo sito Web eseguendo un'analisi del file di registro. In questo modo, puoi determinare se determinate pagine vengono scansionate più spesso di altre.

Inoltre, un'analisi del file di registro può aiutarti a capire se ci sono problemi in aree specifiche del sito web.

Inoltre, un'analisi del file di registro può aiutarti a capire se ci sono problemi in aree specifiche del sito web.

Linea di fondo

Il budget di scansione è essenziale per la visibilità complessiva del tuo sito web sui motori di ricerca. Se Googlebot non è in grado di eseguire la scansione e l'indicizzazione delle tue pagine, praticamente non esisti online.

Assicurati di applicare tutte le tecniche di ottimizzazione del crawl budget di cui abbiamo discusso nell'articolo e raccoglierai i frutti.

Google sarà in grado di trovare e indicizzare i tuoi contenuti più velocemente e, in definitiva, il tuo sito Web sarà in vantaggio rispetto alla concorrenza che non riesce o trascura di implementare l'ottimizzazione.

1:0 per te! Buon lavoro!