Le 7 migliori tecniche di web scraping 2023: una guida pratica

Pubblicato: 2023-03-08La più grande fonte di informazioni al mondo si trova probabilmente su Internet. La raccolta e l'analisi dei dati dai siti Web ha vaste applicazioni potenziali in un'ampia gamma di campi, tra cui scienza dei dati, intelligence aziendale e reportistica investigativa.

I data scientist sono costantemente alla ricerca di nuove informazioni e dati da modificare e analizzare. Raschiare Internet per informazioni specifiche è attualmente uno dei metodi più popolari per farlo.

Sei pronto per la tua prima esperienza di web scraping? Ma prima, devi capire cos'è effettivamente il web scraping e alcuni dei suoi fondamenti, e poi parleremo delle migliori tecniche di web scraping.

Sommario

Che cos'è il web scraping?

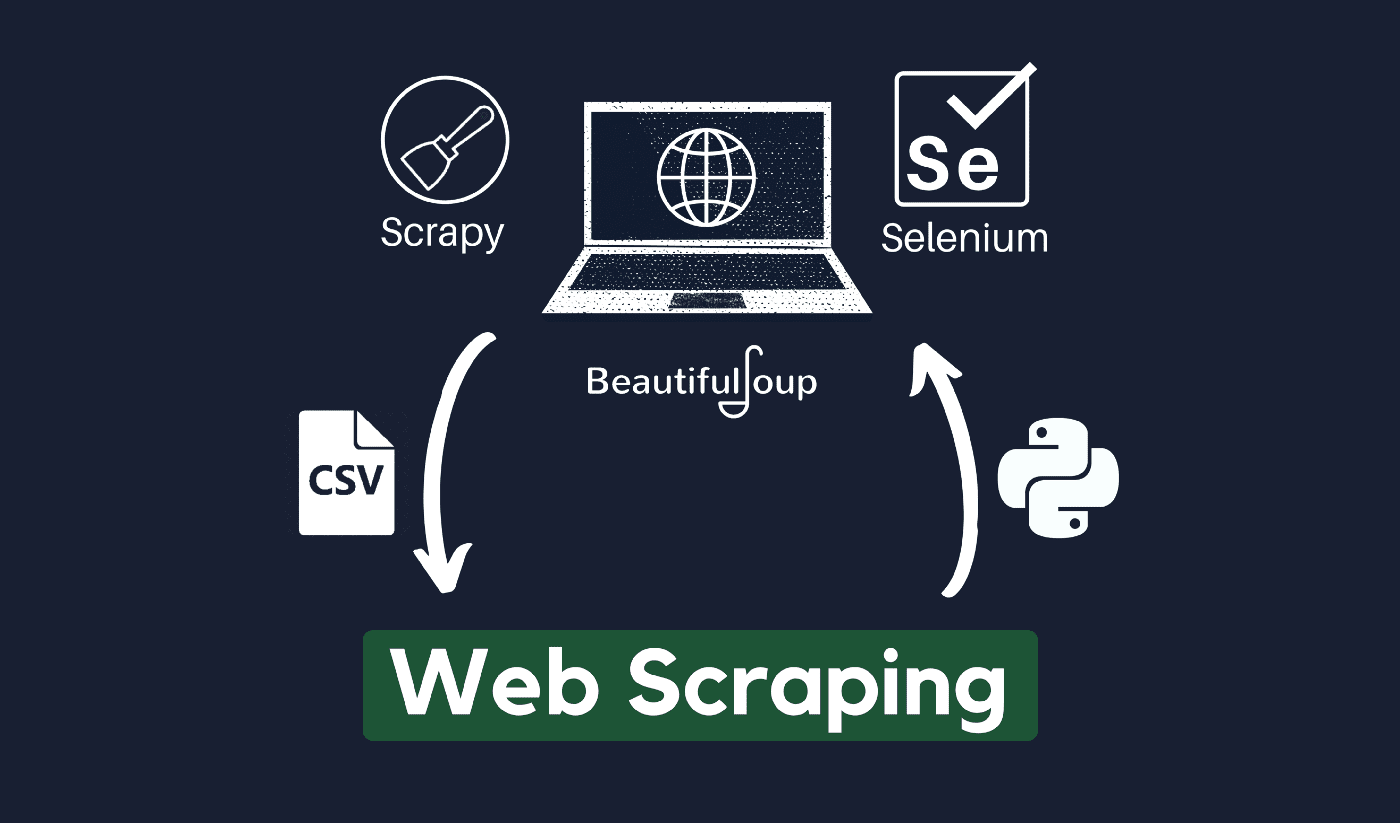

La tecnica di raccolta ed elaborazione dei dati grezzi dal Web è nota come web scraping e la comunità Python ha sviluppato alcuni strumenti di web scraping piuttosto potenti. Una pipeline di dati viene utilizzata per elaborare e archiviare questi dati in modo strutturato.

Il web scraping è una pratica comune oggi con numerose applicazioni:

- Le aziende di marketing e vendita possono raccogliere dati relativi ai lead utilizzando il web scraping.

- Le società immobiliari possono ottenere informazioni su nuovi sviluppi, immobili in vendita, ecc. utilizzando il web scraping.

- I siti Web di confronto dei prezzi come Trivago utilizzano spesso il web scraping per ottenere dati sui prodotti e sui prezzi da diversi siti Web di e-commerce.

Puoi raschiare il Web utilizzando una varietà di linguaggi di programmazione e ogni linguaggio di programmazione ha una varietà di librerie che possono aiutarti a realizzare la stessa cosa. Uno dei programmi più popolari, affidabili e legittimi utilizzati per un web scraping efficace è Python.

A proposito di Python

Python è il linguaggio più popolare per lo scraping sviluppato e lanciato nel 1991. Questo linguaggio di programmazione viene spesso utilizzato per creare siti Web, scrivere codice, creare software, creare script di sistema e altre cose. Il programma è una pietra miliare del settore online ed è ampiamente utilizzato nel commercio di tutto il mondo.

Le applicazioni Web possono essere sviluppate su un server utilizzando Python. Può essere utilizzato insieme ad applicazioni per creare processi e collegarsi a sistemi di database. I file possono anche essere letti e modificati da esso.

Può anche essere utilizzato per gestire enormi quantità di dati, eseguire complicate operazioni matematiche, velocizzare il processo di prototipazione o creare software pronto per la produzione.

Come puoi usare Python per il web scraping?

Probabilmente dovrai eseguire tre passaggi per raccogliere ed estrarre qualsiasi informazione da Internet: ottenere l'HTML, ottenere l'albero HTML e infine estrarre le informazioni dall'albero.

È possibile recuperare il codice HTML da un determinato sito utilizzando la libreria Richieste. L'albero HTML verrà quindi analizzato ed estratto utilizzando BeautifulSoup e i dati potranno quindi essere organizzati utilizzando solo Python.

È sempre consigliabile verificare la politica di utilizzo accettabile del sito Web di destinazione per vedere se l'accesso al sito Web utilizzando strumenti automatici costituisce una violazione delle sue condizioni d'uso prima di utilizzare i propri talenti Python per il web scraping.

Come funziona il web scraping?

Gli spider vengono generalmente utilizzati nel processo di scraping online. Recuperano documenti HTML da siti Web pertinenti, estraggono il contenuto necessario in base alla logica aziendale e quindi lo archiviano in un determinato formato.

Questo sito Web funge da guida per la creazione di scrapper altamente scalabili.

I framework e gli approcci Python combinati con alcuni frammenti di codice possono essere utilizzati per raschiare i dati in diversi modi semplici. Sono disponibili diverse guide che possono aiutarti a mettere in pratica lo stesso.

Lo scraping di una singola pagina è semplice, ma la gestione del codice spider, la raccolta dei dati e la manutenzione di un data warehouse è difficile quando si esegue lo scraping di milioni di pagine. Per rendere lo scraping semplice e preciso, esamineremo questi problemi e le relative soluzioni.

Link veloci:

- Recensione Shiftproxy

- Che cos'è un server proxy

- Le 3 migliori alternative a SmartProxy

**Suggerimento aggiuntivo: utilizza IP a rotazione e servizi proxy

Come hai chiaramente capito, il web scraping ti consente di raccogliere informazioni dal web utilizzando una serie di comandi di programmazione. Ma come devi sapere, le tue attività di web scraping possono essere tracciate attraverso il tuo indirizzo IP.

Questo non sarà un grosso problema se i dati che stai raccogliendo da un dominio pubblico. Ma se stai raccogliendo dati privati, ad esempio, da un sito multimediale speciale, potresti finire nei guai se il tuo indirizzo IP viene rintracciato.

Quindi, in sostanza, per evitare che il tuo spider venga inserito nella lista nera, è sempre preferibile utilizzare i servizi proxy e modificare gli indirizzi IP.

Non ti stiamo incoraggiando in alcun modo a utilizzare il web scraping per raccogliere dati illegali o privati o dedicarti ad attività spyware dannose?

Ma se stai raccogliendo dati che potrebbero essere privati, ti consigliamo di mascherare o ruotare il tuo indirizzo IP o utilizzare un server proxy per evitare di essere rintracciato.

Ti potrebbe piacere anche leggere:

- Recensione Octoparse

- I migliori raschietti Reddit

- 12 migliori proxy di web scraping

Il web scraping è legale?

Ufficialmente, nelle norme e nelle linee guida di Internet non è affermato da nessuna parte che il web scraping sia illegale. In tutta onestà, il web scraping è totalmente legale, a condizione che tu stia lavorando su dati pubblici.

Alla fine di gennaio 2020, è stato annunciato che lo scraping di dati pubblicamente disponibili per scopi non commerciali era del tutto consentito.

Le informazioni liberamente accessibili al pubblico in generale sono dati accessibili a tutti online senza password o altra autenticazione. Pertanto, le informazioni disponibili pubblicamente includono quelle che possono essere trovate su Wikipedia, social media o risultati di ricerca di Google.

Tuttavia, alcuni siti Web vietano esplicitamente agli utenti di eseguire lo scraping dei propri dati con il web scraping. Lo scraping di dati dai social media è talvolta considerato illegale.

La ragione di ciò è che alcuni di essi non sono accessibili al pubblico in generale, ad esempio quando un utente rende private le proprie informazioni. In questo caso, lo scraping di queste informazioni è proibito. Anche lo scraping di informazioni dai siti Web senza il consenso del proprietario può essere considerato dannoso.

Ottieni il meglio dal Web con il Web Scraping!

La raccolta e l'analisi dei dati dai siti Web ha vaste potenziali applicazioni in un'ampia gamma di campi, tra cui scienza dei dati, intelligence aziendale e reportistica investigativa.

Una delle abilità fondamentali richieste da un data scientist è il web scraping.

Tieni presente che non tutti vorranno che tu acceda ai propri server Web per i dati. Prima di iniziare a raschiare un sito Web, assicurati di aver letto le Condizioni d'uso. Inoltre, sii attento quando cronometra le tue query web per evitare di sovraccaricare un server.

Link veloci

- I migliori proxy per l'aggregazione delle tariffe di viaggio

- I migliori proxy francesi

- I migliori proxy di Tripadvisor

- I migliori proxy di Etsy

- Codice coupon IPRoyal

- I migliori proxy TikTok

- I migliori proxy condivisi

- I migliori proxy per la Germania