SEO における AI: 法的課題に対処し、コンプライアンスを確保する方法

公開: 2023-09-26人工知能 (AI) は、オンラインでの存在感を高めようとするブランドにとって、不可欠なツールとなる態勢が整っています。

ただし、AI をマーケティング戦略に統合すると、必然的に法的考慮事項や新たな規制が発生し、代理店は慎重に対応する必要があります。

この記事では、次のことがわかります。

- 企業、SEO、メディア代理店が AI を活用した戦略を導入する際の法的リスクを最小限に抑えるにはどうすればよいか。

- AI のバイアスを軽減する便利なツールと、AI によって生成されたコンテンツの品質をレビューするための便利なプロセス。

- 代理店がクライアントの効率性とコンプライアンスを確保するために、AI 導入の主要な課題にどのように対処できるか。

法的遵守に関する考慮事項

知的財産と著作権

SEO やメディアで AI を使用する場合の重要な法的懸念事項は、知的財産法と著作権法に従うことです。

AI システムは、著作権で保護された素材を含む膨大な量のデータを収集して分析することがよくあります。

著作権とプライバシーの侵害を巡って、OpenAIに対してすでに複数の訴訟が起きている。

同社は、著作権で保護された書籍をChatGPTのトレーニングに不正使用し、機械学習モデルを使用してインターネットユーザーから個人情報を違法に収集したとして訴訟に直面している。

OpenAIによるユーザーデータの処理と保存に関するプライバシー上の懸念もあり、イタリアは3月末にChatGPTの使用を完全にブロックした。

同社がチャットボットのユーザーデータ処理の透明性を高め、アルゴリズムのトレーニングに使用されるChatGPTの会話をオプトアウトするオプションを追加する変更を加えた後、この禁止は解除された。

しかし、OpenAIのクローラーであるGPTBotの発売に伴い、さらなる法的検討が生じる可能性がある。

潜在的な法的問題や侵害の申し立てを回避するために、政府機関は、AI モデルが承認されたデータ ソースでトレーニングされていることを確認し、著作権制限を尊重する必要があります。

- データが合法的に取得され、政府機関がそれを使用するための適切な権利を持っていることを確認してください。

- 必要な法的権限を持たないデータや品質の低いデータを除外します。

- データと AI モデルを定期的に監査して、データ使用権と法律を遵守していることを確認します。

- データの権利とプライバシーに関する法的協議を開催し、法的ポリシーと矛盾しないようにします。

AI モデルをワークストリームやプロジェクトに統合する前に、代理店とクライアントの法務チームの両方が上記の議論に参加する必要がある可能性があります。

データのプライバシーと保護

AI テクノロジーはデータに大きく依存しており、そのデータには機密性の高い個人情報が含まれる場合があります。

ユーザー データの収集、保存、処理は、欧州連合の一般データ保護規則 (GDPR) などの関連するプライバシー法に準拠する必要があります。

さらに、最近導入された EU AI 法では、AI システムに関連するデータプライバシーの懸念への対処も強調されています。

これにはメリットがないわけではありません。 Samsung などの大企業は、ChatGPT にアップロードされた機密データの漏洩を理由に AI を完全に禁止しました。

したがって、代理店が顧客データを AI テクノロジーと組み合わせて使用する場合、次のことを行う必要があります。

- データ収集における透明性を優先します。

- ユーザーの同意を取得します。

- 機密情報を保護するための堅牢なセキュリティ対策を実装します。

このような場合、政府機関は、どのデータが収集されるのか、どのように使用されるのか、誰がアクセスできるのかをユーザーに明確に伝えることで、データ収集の透明性を優先できます。

ユーザーの同意を得るには、データ収集の目的と利点を説明した明確でわかりやすい同意フォームを通じて、同意が十分に伝えられ、自由に与えられるようにしてください。

さらに、堅牢なセキュリティ対策には次のものが含まれます。

- データ暗号化。

- アクセス制御。

- データの匿名化(可能な場合)。

- 定期的な監査と更新。

たとえば、OpenAI のポリシーはデータのプライバシーと保護のニーズに沿っており、AI アプリケーションにおける透明性、ユーザーの同意、データ セキュリティの促進に重点を置いています。

公平性と偏見

SEO やメディアで使用される AI アルゴリズムは、誤って偏見を永続させたり、特定の個人やグループを差別したりする可能性があります。

政府機関は、アルゴリズムのバイアスを特定し、軽減することに積極的に取り組む必要があります。 これは、AI システムが人間の行動に不当に影響を与えたり、差別的な行動を示したりすることを禁止する新しい EU AI 法の下では特に重要です。

このリスクを軽減するために、政府機関は AI モデルの設計に多様なデータと視点が確実に含まれるようにし、潜在的な偏見や差別がないか結果を継続的に監視する必要があります。

これを達成する方法は、AI Fairness 360、IBM Watson Studio、Google の What-If Tool など、バイアスを軽減するツールを使用することです。

虚偽または誤解を招くコンテンツ

ChatGPT などの AI ツールは、不正確、誤解を招く、または偽物の可能性のある合成コンテンツを生成する可能性があります。

たとえば、人工知能は特定の場所や商品を宣伝するために偽のオンライン レビューを作成することがよくあります。 これは、AI が生成したコンテンツに依存する企業にとって悪影響をもたらす可能性があります。

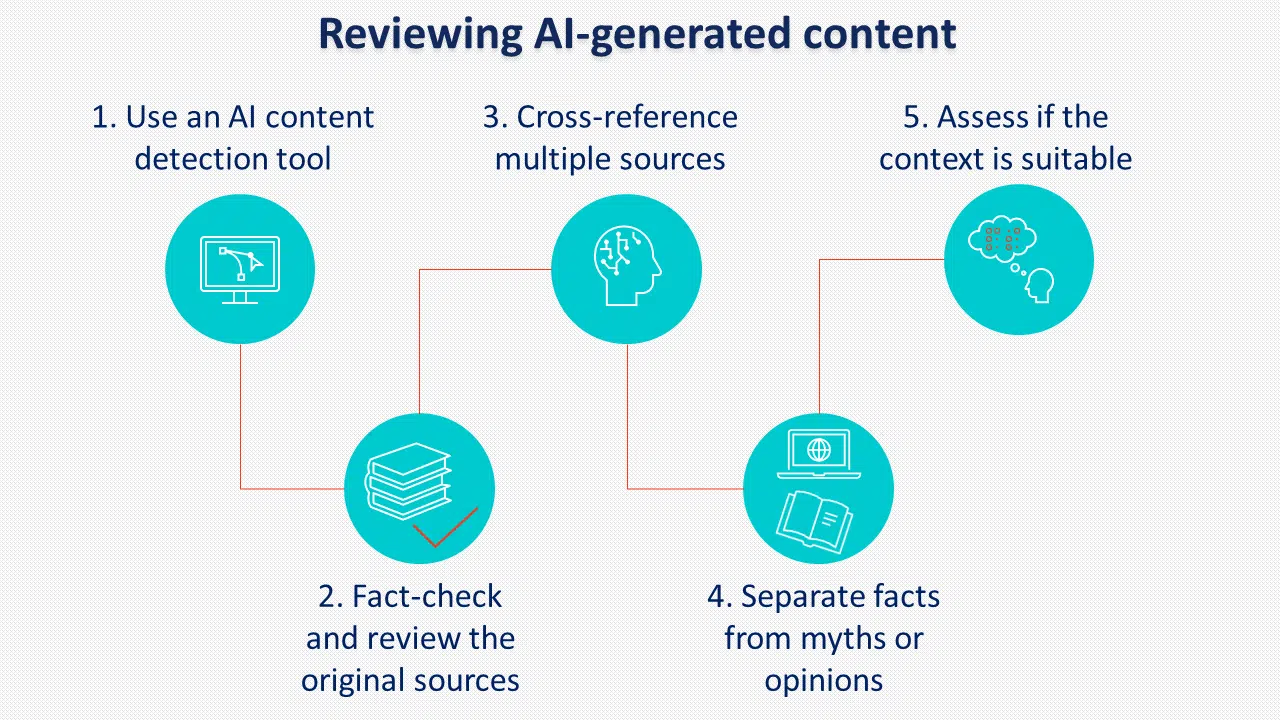

このリスクを防ぐには、AI が生成したコンテンツを公開前にレビューするための明確なポリシーと手順を導入することが重要です。

考慮すべきもう 1 つの実践は、AI によって生成されたコンテンツにラベルを付けることです。 Googleは強制していないようだが、多くの政策立案者はAIラベリングを支持している。

責任と説明責任

AI システムが複雑になるにつれて、責任の問題が生じます。

AI を利用する機関は、その使用から生じる次のような予期せぬ結果に対して責任を負う準備をしておく必要があります。

- AI を使用して採用候補者を分類する際の偏見と差別。

- サイバー攻撃などの悪意のある目的で AI の力を悪用する可能性。

- 同意なしに情報が収集されるとプライバシーが失われます。

EU AI 法では、ユーザーの権利に重大な影響を与える可能性のある高リスク AI システムに関する新たな規定が導入され、AI テクノロジーを使用する際に代理店とクライアントが関連する条件とポリシーに従わなければならない理由が強調されています。

OpenAI の最も重要な条件とポリシーの一部は、ユーザーが提供するコンテンツ、応答の正確さ、個人データの処理に関連しています。

コンテンツ ポリシーには、OpenAI が生成されたコンテンツの権利をユーザーに割り当てることが記載されています。 また、生成されたコンテンツは、法的制限を遵守する限り、商用を含むあらゆる目的に使用できることも規定されています。

ただし、出力は完全にユニークでも正確でもない可能性があるとも述べており、AI によって生成されたコンテンツは使用前に常に徹底的にレビューされる必要があることを意味します。

個人データに関しては、OpenAI はファイルのアップロードを含め、ユーザーが入力したすべての情報を収集します。

個人データを処理するためにサービスを使用する場合、ユーザーは法的に適切なプライバシー通知を提供し、データ処理を要求するフォームに記入する必要があります。

政府機関は、説明責任の問題に積極的に取り組み、AI の出力を監視し、潜在的な法的責任を軽減するために堅牢な品質管理措置を導入する必要があります。

マーケティング担当者が頼りにする毎日のニュースレター検索を入手します。

規約を参照してください。

政府機関の AI 導入の課題

OpenAI が昨年 ChatGPT をリリースして以来、生成 AI が職業としての SEO をどのように変えるか、またメディア業界全体への影響について多くの議論が行われてきました。

変更には日々のワークロードの強化が含まれますが、クライアントの戦略に AI を導入する際に代理店が考慮すべき課題がいくつかあります。

教育と意識向上

多くのクライアントは、AI とその影響についての包括的な理解を欠いている可能性があります。

したがって、代理店は、AI 導入に伴う潜在的な利点とリスクについてクライアントを教育するという課題に直面しています。

規制の状況が進化しているため、法的遵守を確保するために講じられる措置に関してクライアントと明確にコミュニケーションする必要があります。

これを達成するために、政府機関は次のことを行う必要があります。

- クライアントの目標を明確に理解します。

- メリットを説明できるようになる。

- AI の実装に関する専門知識を示します。

- 課題とリスクに対処します。

その方法は、必要な情報をすべて記載したファクトシートをクライアントと共有し、可能であれば人工知能の使用からどのようなメリットが得られるかについてのケーススタディやその他の例を提供することです。

資源の配分

AI を SEO およびメディア戦略に統合するには、財務投資、熟練した人材、インフラストラクチャのアップグレードなど、多大なリソースが必要です。

代理店は、効果的に連携できる AI スペシャリスト、データ アナリスト、SEO、コンテンツ スペシャリストを必要とする場合があるため、クライアントのニーズと能力を慎重に評価して、予算の制約内で AI ソリューションを導入する実現可能性を判断する必要があります。

インフラストラクチャのニーズには、洞察を抽出するための AI ツール、データ処理、分析プラットフォームが含まれる場合があります。 サービスを提供するか外部リソースを促進するかは、各機関の既存の能力と予算によって異なります。

他の機関にアウトソーシングすると、より迅速な実装につながる可能性がありますが、提供されるサービスの長期的な制御とカスタマイズには、社内の AI 機能に投資する方が良い可能性があります。

技術的な専門知識

AIの導入には専門的な技術知識と専門知識が必要です。

政府機関は、新しい規制要件に沿って AI システムを効果的に開発、導入、管理するためにチームを採用したり、スキルを向上させたりする必要がある場合があります。

AI を最大限に活用するには、チーム メンバーが以下を備えている必要があります。

- 優れたプログラミング知識。

- 大量のデータを管理するためのデータ処理および分析スキル。

- 機械学習に関する実践的な知識。

- 優れた問題解決能力。

倫理的配慮

代理店は、クライアントに対する AI 使用の倫理的影響を考慮する必要があります。

倫理的な枠組みとガイドラインを確立して、プロセス全体を通じて責任ある AI の実践を確保し、最新の規制で提起された懸念に対処する必要があります。

これらには次のものが含まれます。

- AI 活用時の透明性、情報開示、説明責任。

- ユーザーのプライバシーと知的財産を尊重します。

- 人工知能の使用についてクライアントの同意を得る。

- AI を人間が制御し、新たな AI テクノロジーの改善と適応に継続的に取り組んでいます。

説明責任が重要: AI 導入における法的課題への対応

AI は SEO とメディアの実践を改善する刺激的な機会をもたらしますが、代理店は法的課題を乗り越え、AI の実装に関連する最新の規制を遵守する必要があります。

企業や代理店は、次の方法で法的リスクを最小限に抑えることができます。

- データが合法的に取得され、政府機関がそれを使用する適切な権利を持っていることを確認します。

- 必要な法的許可を持たないデータ、または低品質のデータをフィルタリングして除外します。

- データと AI モデルの監査を実施し、データ使用権と法律に準拠していることを確認します。

- データの権利とプライバシーに関する法的協議を開催し、法的ポリシーと矛盾しないようにします。

- データ収集の透明性を優先し、明確でわかりやすい同意書によるユーザーの同意を取得します。

- AI Fairness 360、IBM Watson Studio、Google の What-If ツールなど、偏見を減らすのに役立つツールを使用します。

- AI によって生成されたコンテンツの品質を公開前にレビューするための明確なポリシーと手順を実装します。

この記事で表明された意見はゲスト著者の意見であり、必ずしも Search Engine Land とは限りません。 スタッフの著者はここにリストされています。