エンタープライズレベルのクロールとインデックス作成の効率を向上させる方法

公開: 2023-07-13エンタープライズ SEO はさまざまなルールに従っています。

小規模またはニッチな Web サイトでは機能する戦略が、大規模な Web サイトでは必ずしも機能するとは限りません。

では、エンタープライズ SEO が大きくなりすぎると、具体的に何が起こるのでしょうか?

この記事では、実際の例を 3 つ紹介します。 次に、大規模な SEO をより効率的に管理するための潜在的な解毒剤を学びます。

インデックス作成のジレンマに直面する

小規模なサイトは、キーワードを SEO 戦略の構成要素として使用し、一度に 1 ページずつ成長する傾向があります。

大規模なサイトでは、システム、ルール、自動化に重点を置いた、より洗練されたアプローチが採用されることがよくあります。

SEO をビジネス目標と一致させることが重要です。 キーワードのランキングやトラフィックに基づいて SEO の成功を測定すると、過剰なインデックス作成による悪影響が生じます。

インデックス付き URL の最適な数を決定する魔法の公式はありません。 Google は上限を設定しません。

ただし、SEO ファネル全体の健全性を考慮することから始めるのが良いでしょう。 サイトなら…

- 数千万、数億、さらには数十億の URL を Google にプッシュします

- 数百万のキーワードのみでランク付けされます

- 数千ページへのアクセスを受信

- これらの一部を変換します (存在する場合)

…それは、SEO の健全性に関する深刻なニーズに対処する必要があることを示す良い兆候です。

サイトの衛生上の問題を今すぐ修正しておけば、後でさらに大きな SEO の問題が発生することを防ぐことができます。

これがなぜそれほど重要なのかを説明する、実際のエンタープライズ SEO の 3 つの例を見てみましょう。

ケース 1: 低品質コンテンツの過剰なインデックス作成の結果

Google では、ウェブのクローリングと処理に使用できるリソースが限られています。 ユーザーにとって価値のあるコンテンツを優先します。

Google は、内容が薄い、重複している、または低品質であると判断したページをクロールしますが、インデックスには登録しません。

数ページ程度であれば問題ありません。 しかし、それが広範囲に及ぶ場合、Google はページ タイプ全体またはサイトのコンテンツの大部分を無視する可能性があります。

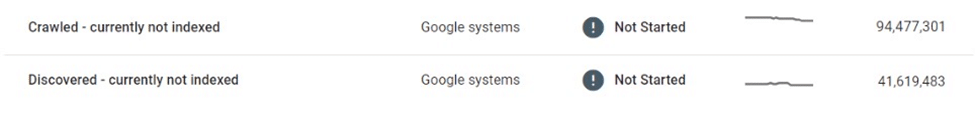

ある例では、e コマース マーケットプレイスでは、数千万のリスティング ページが選択的なクロールとインデックス作成の影響を受けていることがわかりました。

何百万もの薄くて重複に近いリスティングページをクロールしてインデックスを作成しなかった後、Google は最終的に Web サイト全体のクロールを縮小し、多くのページを「検出済み - 現在インデックスに登録されていない」状態のままにしました。

このマーケットプレイスは、ユーザーに新しいリストを宣伝するために検索エンジンに大きく依存していました。 新しいコンテンツが発見されなくなり、ビジネス上の重大な課題が生じていました。

内部リンクの改善や動的 XML サイトマップの導入など、いくつかの即時対策が講じられました。 結局のところ、これらの試みは無駄でした。

実際のソリューションには、インデックス可能なコンテンツの量と品質を制御する必要がありました。

ケース 2: クロールの停止による予期せぬ結果

クロールが停止すると、変更、リダイレクト、削除された場合でも、不要なコンテンツが Google のインデックスに残ります。

多くの Web サイトでは、権限を維持するために削除されたコンテンツに対して 404 エラーの代わりにリダイレクトを使用しています。 この戦術では、数年とは言わないまでも、数か月にわたってゴースト ページからの追加のトラフィックが圧迫される可能性があります。

ただし、これは場合によってはひどい間違いを引き起こす可能性があります。

たとえば、手作り商品を販売する有名な世界的なマーケットプレイスでは、ローカライズ版の出品ページで販売者の個人情報 (名前、住所、電子メール、電話番号など) が誤って公開されてしまいました。 これらのページの一部は Google によってインデックス化およびキャッシュされ、検索結果に個人を特定できる情報 (PII) が表示され、ユーザーの安全性とプライバシーが侵害されていました。

Google はこれらのページを再クロールしなかったため、削除または更新してもインデックスから削除されません。 削除から数カ月たっても、キャッシュされたコンテンツとユーザーの PII データは Google のインデックスに存在し続けました。

このような状況では、バグを修正し、Google と直接協力して機密コンテンツを検索から削除するのがマーケットプレイスの責任でした。

ケース 3: 検索結果ページの過剰なインデックス作成のリスク

大量の薄くて低品質のページのインデックスを制御せずに作成すると、逆効果になる可能性があります。しかし、検索結果ページのインデックス作成についてはどうでしょうか?

Google は内部検索結果のインデックス作成を推奨しておらず、多くの経験豊富な SEO はこの戦術に強く反対するでしょう。 しかし、多くの大規模サイトは主要な SEO 推進力として内部検索に大きく依存しており、多くの場合、多額の利益をもたらしています。

ユーザーエンゲージメント指標、ページエクスペリエンス、コンテンツ品質が十分に高ければ、Googleは見て見ぬふりをすることができます。 実際、Google が薄いリスト ページよりも高品質の内部検索結果ページを好む可能性さえあることを示唆する十分な証拠があります。

ただし、この戦略も失敗する可能性があります。

私はかつて、地元のオークション サイトが一夜にして検索ページのランキングのかなりの部分、そして SEO トラフィックの 3 分の 1 以上を失ったのを見たことがあります。

20/80 ルールは、主要用語のごく一部がインデックス付き検索結果への SEO アクセスのほとんどを占めるという点で適用されます。 ただし、多くの場合、URL ボリュームの大部分を占め、最も高いコンバージョン率を誇るのはロングテールです。

その結果、この戦術を利用しているサイトのうち、検索ページのインデックス作成に厳しい制限やルールを課しているサイトはほとんどありません。

これにより、次の 2 つの大きな問題が生じます。

- どの検索クエリでも有効なページを生成できます。つまり、無限の数のページが自動生成される可能性があります。

- それらはすべて Google でインデックス可能です。

検索ページをサードパーティの広告で収益化している広告マーケットプレイスのケースでは、この脆弱性が広告アービトラージの形式を通じてうまく悪用されました。

- 膨大な数の検索 URL が、いかがわしい、アダルトな、完全に違法な用語に対して生成されました。

- これらの自動生成ページは実際の在庫結果を返しませんでしたが、サードパーティの広告を配信し、ページ テンプレートとメタデータを通じて要求された検索クエリに対してランク付けされるように最適化されました。

- これらのページへのバックリンクは、ボットによって検出され、クロールされるように、低品質のフォーラムから構築されました。

- Google からこれらのページにアクセスしたユーザーは、サードパーティの広告をクリックして、目的のリンク先である低品質のサイトに移動してしまいます。

この計画が発見されるまでに、サイト全体の評判は傷ついていました。 また、いくつかのペナルティも受け、SEO パフォーマンスの大幅な低下が続きました。

マネージド インデックスの採用

これらの問題はどのようにして回避できたのでしょうか?

大規模なエンタープライズ サイトが SEO で成功するための最良の方法の 1 つは、マネージド インデックス作成を通じてスケールダウンすることです。

数千万、数億ページのサイトの場合、キーワード中心のアプローチから、データ、ルール、自動化に基づいたアプローチに移行することが重要です。

データドリブンのインデックス作成

大規模サイトの大きな利点の 1 つは、豊富な内部検索データを自由に使えることです。

外部ツールに依存する代わりに、このデータを利用して、地域および季節の検索需要と傾向を詳細なレベルで理解できます。

このデータを既存のコンテンツ インベントリにマッピングすると、どのコンテンツにインデックスを作成するか、いつ、どこでインデックスを作成するかについての強力なガイドが提供されます。

重複排除と統合

上位 100 位に点在する大量のページよりも、少数の信頼できる上位 URL の方がはるかに価値があります。

正規化を使用し、ルールと自動化を活用して類似のページを統合することは価値があります。 類似性スコアに基づいて統合されるページもあれば、同様のクエリに対して集合的にランク付けされる場合にクラスター化されるページもあります。

ここで重要なのは実験です。 ロジックを微調整し、時間の経過とともにしきい値を修正します。

薄くて空のコンテンツ ページをクリーンアップする

薄くて空のページが大量に存在すると、サイトの衛生状態とパフォーマンスに重大な損害を引き起こす可能性があります。

価値のあるコンテンツでそれらを改善したり、統合したりすることが難しすぎる場合は、インデックスを付けないか、さらには禁止する必要があります。

robots.txt で無限のスペースを削減

Google が最初に「無限スペース」について書いてから 15 年が経った今でも、フィルター、並べ替え、その他のパラメーターの組み合わせの過剰インデックスの問題が多くの e コマース サイトを悩ませ続けています。

極端な場合には、クローラーがこれらのリンクを通過しようとしてサーバーをクラッシュさせる可能性があります。 ありがたいことに、これは robots.txt を通じて簡単に対処できます。

クライアント側のレンダリング

検索エンジンによるインデックスを作成したくない特定のページ上のコンポーネントに対してクライアント側レンダリングを使用することも選択肢の 1 つとなります。 これについては慎重に検討してください。

さらに良いのは、ログアウトしたユーザーがこれらのコンポーネントにアクセスできないようにすることです。

規模が拡大するにつれて賭け金は劇的に増加する

SEO は「無料」のトラフィック源であると認識されることがよくありますが、これはやや誤解を招きます。 コンテンツをホストして提供するには費用がかかります。

URL ごとのコストはごくわずかかもしれませんが、規模が数億ページまたは数十億ページに達すると、数ペニーが実際の数字に達し始めます。

SEO の ROI を測定するのは難しいですが、節約できるのは 1 ペニーであり、大規模なサイトのインデックス戦略を検討する際には、管理されたクロールとインデックス作成によるコスト削減が 1 つの要素となるはずです。

データ、ルール、自動化に基づいて、適切に管理されたクロールとインデックス作成による SEO への実用的なアプローチにより、大規模な Web サイトをコストのかかる間違いから守ることができます。

この記事で表明された意見はゲスト著者の意見であり、必ずしも Search Engine Land とは限りません。 スタッフの著者はここにリストされています。