WordPressで「GooglebotがCSSおよびJSファイルにアクセスできない」という警告を修正するにはどうすればよいですか?

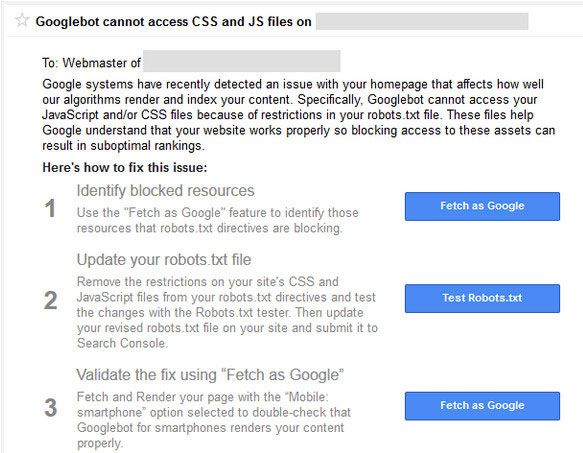

公開: 2015-10-15WordPressを利用したサイトまたはブログを使用している場合、 Googlebotがドメイン上のCSSおよびJSファイルにアクセスできないという警告を過去にGoogle検索コンソールチームから受け取った可能性があります(または受け取る予定です)。

Googleからこの警告を受け取っても、心配しないでください。 それは悪いように聞こえますが、簡単に修正できます。 電子メールメッセージには、この問題を修正する方法の説明へのリンクが含まれています。 しかし、これらの指示に従うのは簡単ではありません。

Googleボットやその他の検索スパイダーは、htaccessファイルにアクセスした直後に、ウェブサイトのrobots.txtファイルにアクセスします。

Htaccessには、IPアドレスのブロック、URLのリダイレクト、gzip圧縮の有効化などのルールがあります。robots.txtには、検索エンジンの一連のルールもあります。 これが、「GooglebotがCSSファイルとJSファイルにアクセスできない」という理由です。

Robots.txtには、ファイルとディレクトリのクロールをブロックまたは許可する行がいくつかあります。 Googleは、jsファイルとcssファイルのクロールをブロックするWebサイトにペナルティを科し始めました。 JavaScriptとカスケードスタイルシートは、Webサイトのレンダリングを担当し、フォームや火災イベントなどを処理します。

JSがブロックされている場合、Googleボットはコードをクロールできず、コードをスパムまたはリンクスキームの違反と見なします。 同じロジックがCSSファイルにも当てはまります。

この警告メールをまだ受け取っていない場合は、メールを待つ代わりに、すぐに対応できます。

WordPress Robots.txtとは何ですか?

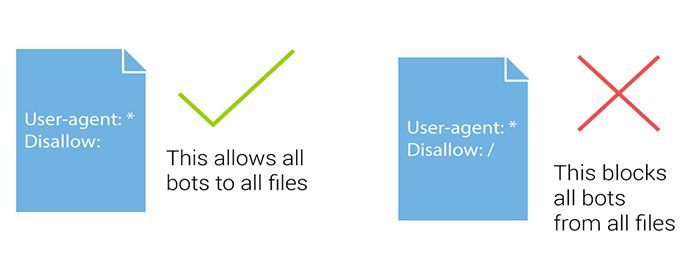

Robots.txtファイルは、検索エンジンロボットが、クロールする部分と回避する部分を指示するのに役立ちます。 検索ボットまたは検索エンジンのスパイダーがサイトにアクセスし、サイトのインデックスを作成する場合、最初にrobots.txtファイルに従います。

検索ボットまたはスパイダーは、このファイルの指示に従って、Webサイトのどのページにもインデックスを付けるかインデックスを付けないようにします。 WordPressを使用している場合は、WordPressインストールのルートにRobots.txtファイルがあります。

robots.txtがない場合は、新しいメモ帳ファイルを作成して、Robots.txtという名前を付けることができます。 次に、FTPを使用して、またはcPanelファイルマネージャーを介して直接、ドメインのルートディレクトリにアップロードします。

cPanelを使用してサーバーのFTPアカウントにログインすることにより、 WordPress robots.txtファイルを編集するか、プラグインを使用することができます。 サイトマップURLと一緒にrobots.txtファイルに追加する必要があるものがいくつかあります。

サイトマップURLを追加すると、検索エンジンボットがサイトマップファイルを見つけて、投稿やページのインデックスをすばやく作成できるようになります。 これがrobots.txtファイルのサンプルです。 サイトマップで、サイトマップのURLをブログのURLに置き換えます。

ユーザーエージェント: * #これらのディレクトリ内のすべてのファイルを禁止する 禁止:/ cgi-bin / 禁止:/ wp-admin / 禁止:/ archives / 禁止:/ *?* 許可しない:*?replytocom 禁止:/ wp- * 禁止:/ comments / feed / ユーザーエージェント:Googlebot-Image 許可:/ wp-content / uploads / ユーザーエージェント:Adsbot-Google 許可する: / ユーザーエージェント:Googlebot-Mobile 許可する: /

サイトマップ:https://www.kasareviews.com/sitemap.xml

GoogleがCSSおよびJSファイルにアクセスする必要があるのはなぜですか?

CSSとJavaScriptをブロックすることは、昨年10月にウェブマスターガイドラインに書かれて以来、Googleのノーノーでした。 同社が警告を発しているのはごく最近のことです。

サイトがGooglebotによるこれらのファイルへのアクセスをブロックしている場合は、問題に対処できるように、サイトについて知っておくとよいでしょう。

Googleは、ユーザーフレンドリーなウェブサイトにより良いランキングを与えることに焦点を当てています。 高速でユーザーエクスペリエンスが優れているサイトなど。ウェブサイトのユーザーエクスペリエンスを判断するには、GoogleがサイトのCSSファイルとJavaScriptファイルにアクセスできるようにするためのアクセス権が必要です。

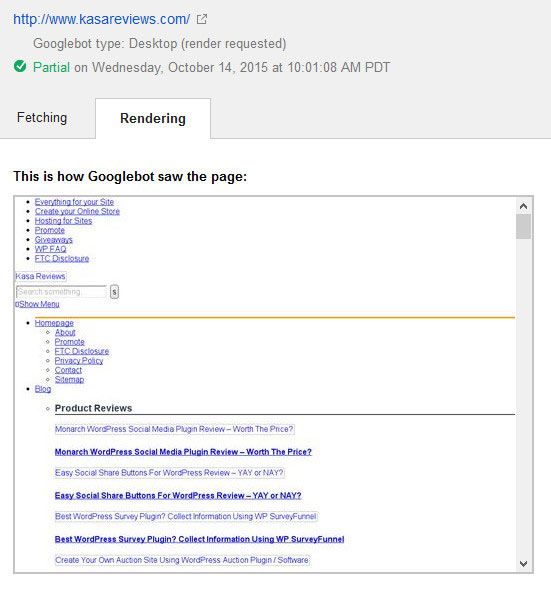

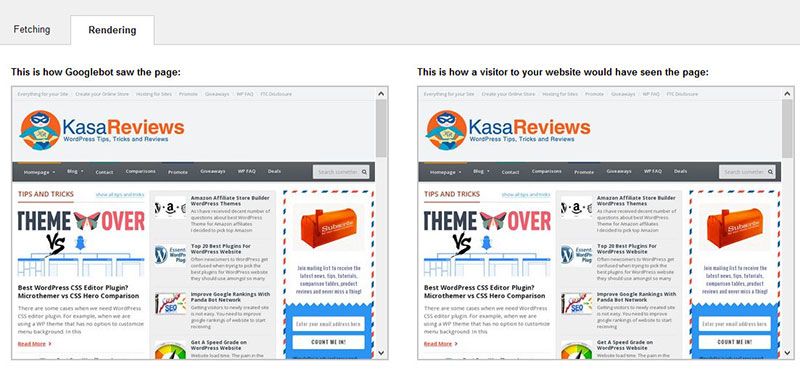

これは、Googleが修正前にKasaレビューサイトを見た方法です

デフォルトでは、WordPressは検索ボットがCSSまたはJSファイルにアクセスするのをブロックしません。 ただし、一部のサイト所有者は、セキュリティ対策を追加しようとしたり、WordPressセキュリティプラグインを使用したりして、誤ってブロックする可能性があります。

これにより、サイトのSEOパフォーマンスに影響を与える可能性のあるCSSファイルとJSファイルのインデックス作成がGooglebotから制限されます。 これには簡単な修正があり、サイトのrobots.txtファイルを編集する必要があります。

「GooglebotはCSSおよびJSファイルにアクセスできません」という警告を修正するにはどうすればよいですか?

robots.txtのような用語が初めて聞こえる場合でも、あなたは一人ではないので心配しないでください。 これはSEO業界では一般的な用語ですが、ブロガーの間ではそれほど人気がありません。

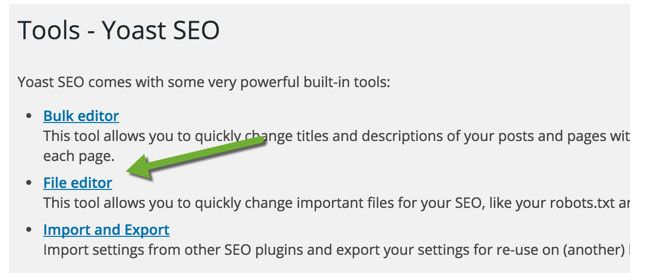

WordPressブログの場合、FileZillaなどのFTPを使用してrobots.txtファイルを編集するか、cPanelを使用するか(cPanelの長所と短所を参照)、YoastによるSEOのファイルエディター機能を使用できます(Yoastとランク数学の比較を確認してください)。

Yoast SEOプラグインを使用すると、WordPressダッシュボードからrobots.txtファイルと.htaccessファイルを編集できます。 WordPressダッシュボード内で、[SEO]> [ツール]をクリックし、ファイルエディターをクリックします

このページでは、robots.txtファイルを表示および編集できます。 ほとんどの場合、次の行を削除する必要があります: Disallow:/ wp-includes /

robots.txtファイルの設定方法に応じて、ほとんどの警告が修正されます。 あなたのサイトが次のようないくつかのWordPressディレクトリへのアクセスを許可していないことがわかるでしょう:

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/plugins/

Disallow: /wp-content/themes/

一部のユーザーは、 robots.txtファイルが空であるか、存在すらしていないことに気付く場合があります。 Googlebotがrobots.txtファイルが見つからない場合は、すべてのファイルを自動的にクロールしてインデックスに登録します。

では、なぜこの警告が表示されるのですか? まれに、一部のWordPressホスティングプロバイダーが、ボットのデフォルトのWordPressフォルダーへのアクセスをプロアクティブにブロックする場合があります。 ブロックされたフォルダへのアクセスを許可することで、robots.txtでこれを上書きできます。

User-agent: *

Allow: /wp-includes/js/

完了したら、robots.txtファイルを保存します。 Googleツールとしてフェッチにアクセスし、フェッチとレンダリングボタンをクリックします。 フェッチ結果を比較すると、ブロックされたリソースの問題のほとんどが解消されていることがわかります。

これは、robots.txtファイルを編集および修正した後、GoogleがKasaレビューをレンダリングする方法です。 また、サイト全体が完全にレンダリングされるようにする必要があります。

ブログのrobots.txtファイルを変更した後、Googleウェブマスターツールのrobots.txtテスターを使用してウェブサイトのURLをテストします。 エラーが見つかった場合、またはGooglebotがリソースをクロールできない場合、ツールはエラーの原因となっている行を強調表示します。

問題を削除するには、強調表示された行を削除します。 これがお役に立てば幸いです。 ご不明な点がございましたら、コメント欄からお気軽にお問い合わせください。