Ambari를 사용한 하둡 설치

게시 됨: 2015-12-11Ambari를 사용한 Hadoop 설치에 대해 알고 싶은 모든 것

Apache Hadoop은 안정적이고 확장 가능하며 분산된 대규모 컴퓨팅을 위한 사실상의 소프트웨어 프레임워크가 되었습니다. 다른 컴퓨팅 시스템과 달리 데이터를 계산에 보내는 것이 아니라 데이터에 계산을 가져옵니다. Hadoop은 2006년 Google에서 발행한 논문을 기반으로 Doug Cutting이 Yahoo에서 만들었습니다. Hadoop이 성숙해짐에 따라 유용성과 기능을 향상시키기 위해 수년에 걸쳐 많은 새로운 구성 요소와 도구가 에코시스템에 추가되었습니다. Hadoop HDFS, Hadoop MapReduce, Hive, HCatalog, HBase, ZooKeeper, Oozie, Pig, Sqoop 등이 있습니다.

왜 암바리인가?

Hadoop의 인기가 높아짐에 따라 많은 개발자들이 이 기술을 맛보기 위해 뛰어들고 있습니다. 하지만 하둡은 마음이 약한 사람들을 위한 것이 아니라 하둡 설치의 장벽조차 넘지 못하는 개발자들이 많다는 말이 있다. 많은 배포판은 사전 설치된 VM 샌드박스를 제공하여 여러 가지를 시도하지만 분산 컴퓨팅의 느낌을 주지는 않습니다. 그러나 다중 노드를 설치하는 것은 쉬운 일이 아니며 구성 요소의 수가 증가함에 따라 많은 구성 매개변수를 처리하는 것이 매우 까다롭습니다. 고맙게도 Apache Ambari가 우리를 구하러 왔습니다!

암바리란?

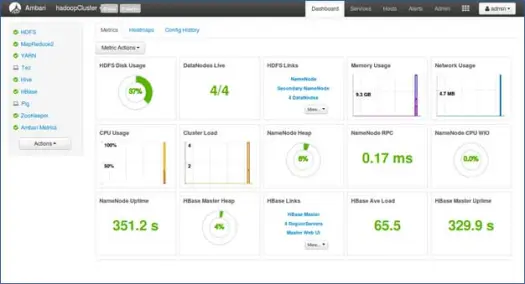

Apache Ambari는 Apache Hadoop 클러스터를 프로비저닝, 관리 및 모니터링하기 위한 웹 기반 도구입니다. Ambari는 히트맵과 같은 클러스터 상태를 볼 수 있는 대시보드와 MapReduce, Pig 및 Hive 애플리케이션을 시각적으로 볼 수 있는 기능과 함께 사용자 친화적인 방식으로 성능 특성을 진단하는 기능을 제공합니다. 다양한 도구를 설치하고 다양한 관리, 구성 및 모니터링 작업을 수행할 수 있는 매우 간단하고 대화형 UI가 있습니다. 아래에서는 다중 노드 클러스터에 Hadoop 및 다양한 에코시스템 구성 요소를 설치하는 다양한 단계를 안내합니다.

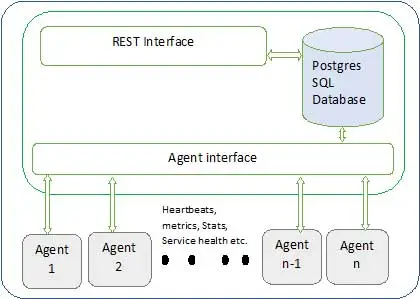

Ambari 아키텍처는 다음과 같습니다.

Ambari에는 두 가지 구성 요소가 있습니다.

- Ambari 서버 – 클러스터에 참여하는 각 노드에 설치된 Ambari 에이전트와 통신하는 마스터 프로세스입니다. 여기에는 모든 클러스터 관련 메타데이터를 유지 관리하는 데 사용되는 postgres 데이터베이스 인스턴스가 있습니다.

- Ambari 에이전트 – 각 노드에서 Ambari의 에이전트 역할을 합니다. 각 에이전트는 다양한 메트릭, 설치된 서비스 상태 및 기타 여러 가지와 함께 자신의 상태를 주기적으로 보냅니다. 마스터는 다음 작업을 결정하고 에이전트에게 다시 전달하여 작업을 수행합니다.

Ambari를 설치하는 방법?

Ambari 설치는 몇 가지 명령으로 간단합니다.

Ambari 설치 및 클러스터 설정을 다룹니다. 4개의 노드가 있다고 가정합니다. 노드1, 노드2, 노드3 및 노드4. 그리고 Node1을 Ambari 서버로 선택합니다.

이것은 RHEL 기반 시스템의 설치 단계입니다. 데비안 및 기타 시스템의 경우 단계가 거의 다를 것입니다.

- Ambari 설치: –

Ambari 서버 노드에서(우리가 결정한 대로 노드 1)

나. Ambari 공개 리포지토리 다운로드

이 명령은 Hortonworks Ambari 저장소를 RHEL 시스템의 기본 패키지 관리자인 yum에 추가합니다.

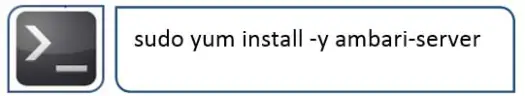

ii.Ambari RPMS 설치

이것은 시간이 걸리며 이 시스템에 Ambari를 설치합니다.

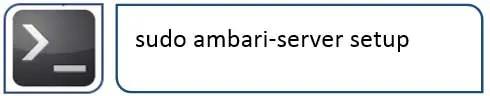

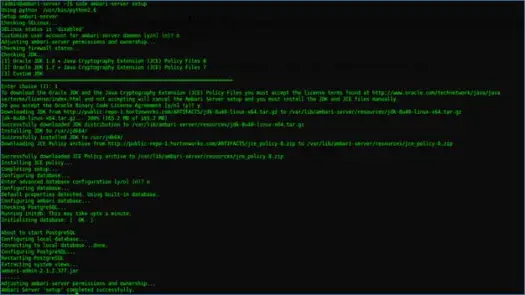

iii. Ambari 서버 구성

Ambari 설치 후 수행할 다음 작업은 Ambari를 구성하고 클러스터를 프로비저닝하도록 설정하는 것입니다.

다음 단계에서 이를 처리합니다.

iv. 서버 시작 및 웹 UI 로그인

다음으로 서버 시작

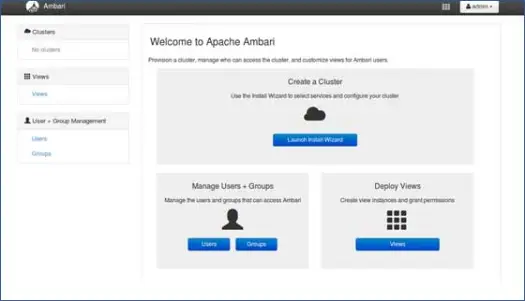

이제 Ambari 웹 UI(8080 포트에서 호스팅됨)에 액세스할 수 있습니다.

기본 사용자 이름 "admin"과 기본 암호 "admin"을 사용하여 Ambari에 로그인합니다.

Hadoop 클러스터 설정

1. 랜딩페이지

클러스터 설정을 시작하려면 "설치 마법사 시작"을 클릭하십시오.

2. 클러스터 이름

클러스터에 좋은 이름을 지정하십시오.

참고: 이것은 클러스터의 단순한 이름일 뿐이며 그다지 중요하지 않으므로 걱정하지 말고 이름을 선택하십시오.

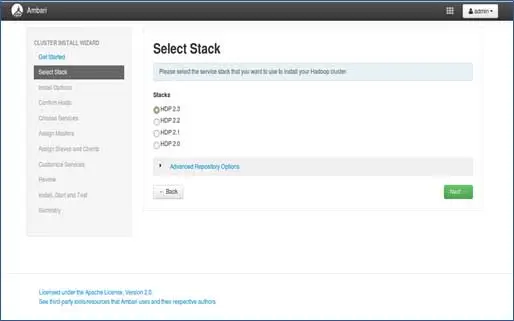

3. 스택 선택

이 페이지에는 설치할 수 있는 스택이 나열됩니다. 각 스택에는 Hadoop 에코시스템 구성 요소가 미리 패키징되어 있습니다. 이 스택은 Hortonworks에서 가져온 것입니다. (일반 Hadoop도 설치할 수 있습니다. 이후 게시물에서 다룰 예정입니다).

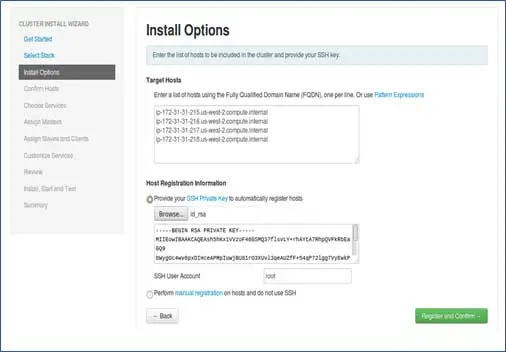

4. 호스트 항목 및 SSH 키 항목

이 단계를 더 진행하기 전에 참여하는 모든 노드에 대해 암호가 없는 SSH 설정이 있어야 합니다.

노드의 호스트 이름을 각 줄에 하나씩 추가합니다. [ hostname –f 명령으로 얻을 수 있는 FQDN 추가]. 비밀번호를 제외한 SSH 설정 시 사용한 개인키와 생성된 사용자 이름을 선택합니다.

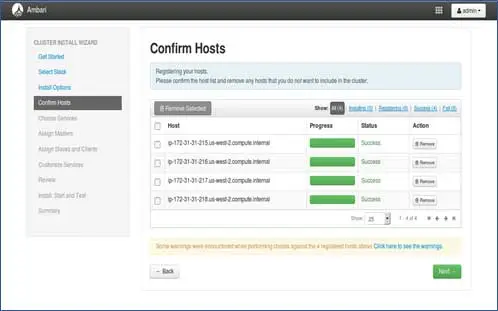

5. 호스트 등록 상태

수행 중인 일부 작업을 볼 수 있습니다. 이러한 작업에는 각 노드에서 Ambari 에이전트 설정, 각 노드에서 기본 설정 생성이 포함됩니다. ALL GREEN이 표시되면 계속 진행할 준비가 되었습니다. 때때로 이것은 몇 개의 패키지를 설치하기 때문에 시간이 걸릴 수 있습니다.

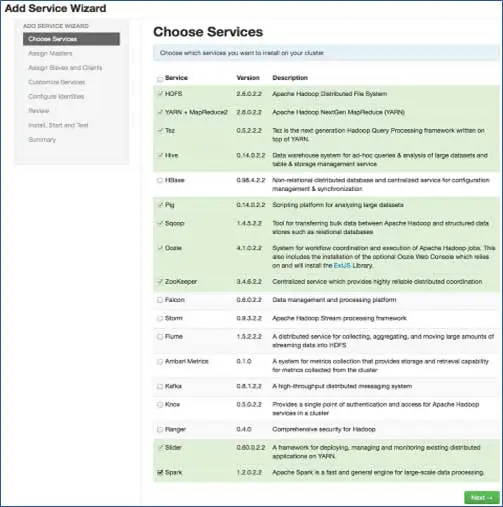

6. 설치하려는 서비스 선택

3단계에서 선택한 스택에 따라 클러스터에 설치할 수 있는 서비스 수가 있습니다. 원하는 것을 선택할 수 있습니다. Ambari는 종속 서비스를 선택하지 않은 경우 지능적으로 선택합니다. 예를 들어 HBase를 선택했지만 Zookeeper가 아닌 경우 동일한 메시지가 표시되고 Zookeeper도 클러스터에 추가됩니다.

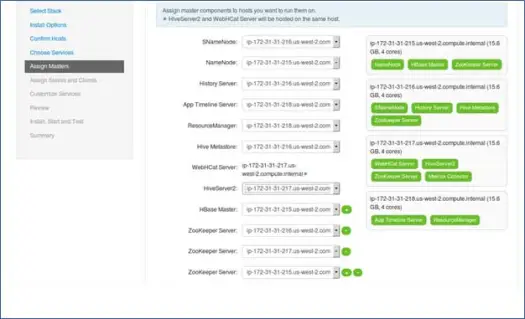

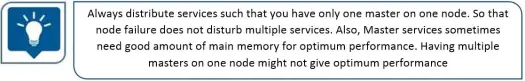

7. 노드를 사용한 마스터 서비스 매핑

아시다시피 Hadoop 생태계에는 마스터-슬레이브 아키텍처를 기반으로 하는 도구가 있습니다. 이 단계에서는 마스터 프로세스를 노드와 연결합니다. 여기에서 클러스터의 균형을 적절하게 조정했는지 확인하십시오. 또한 Namenode 및 보조 Namenode와 같은 기본 및 보조 서비스는 동일한 시스템에 있지 않습니다.

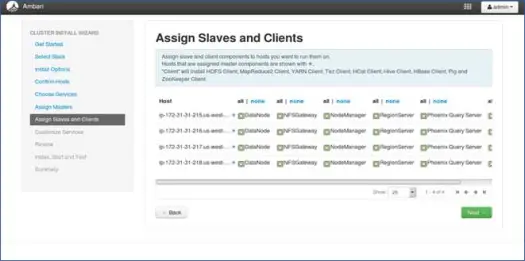

8. 노드와 슬레이브 매핑

마스터와 유사하게 노드에서 슬레이브 서비스를 매핑합니다. 일반적으로 모든 노드에는 적어도 Datanodes 및 Nodemanagers에 대해 실행되는 슬레이브 프로세스가 있습니다.

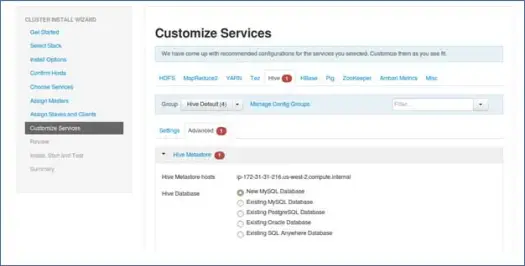

9. 서비스 사용자 정의

이것은 관리자에게 매우 중요한 페이지입니다.

여기에서 사용 사례에 가장 적합하도록 클러스터의 속성을 구성할 수 있습니다.

또한 Hive 메타스토어 비밀번호(하이브가 선택된 경우) 등과 같은 일부 필수 속성이 있습니다. 이러한 속성은 기호와 같은 빨간색 오류로 표시됩니다.

10. 프로비저닝 검토 및 시작

무의식적으로 잘못된 구성을 설정하는 것을 방지하므로 시작하기 전에 클러스터 구성을 검토해야 합니다.

11. 시작하고 상태가 GREEN이 될 때까지 뒤로 물러나십시오.

다음 단계

야! 클러스터의 모든 노드에 Hadoop과 모든 구성 요소를 성공적으로 설치했습니다. 이제 Hadoop을 사용하여 시작할 수 있습니다.

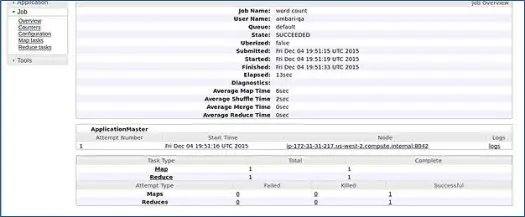

Ambari는 MapReduce 단어 수 작업을 실행하여 모든 것이 제대로 실행되고 있는지 확인합니다. ambari-qa 사용자가 실행한 작업의 로그를 확인합시다.

위 스크린샷에서 볼 수 있듯이 WordCount 작업이 성공적으로 완료되었습니다. 이것은 클러스터가 제대로 작동하고 있음을 확인시켜줍니다.

결론

이제 Apache Ambari라는 간단한 웹 기반 도구를 사용하여 다중 노드 클러스터에 Hadoop 및 해당 구성 요소를 설치하는 방법을 배웠습니다. Apache Ambari는 우리에게 더 간단한 인터페이스를 제공하고 너무 많은 구성 요소와 다양한 설치 단계 및 모니터링 제어로 인해 매우 지루했을 설치, 모니터링 및 관리에 대한 많은 노력을 절약합니다.

해킹으로 당신을 떠나게 해주세요

Ambari 설치 프로그램은 /etc/lsb-release를 확인하여 OS 세부 정보를 가져옵니다. Linux Mint에서 Ubuntu 버전의 동일한 파일은 /etc/upstream-release/lsb-release 아래에 있습니다. 설치 프로그램을 속이려면 전자를 후자로 바꾸면 됩니다(먼저 파일을 백업해야 함).

설치가 완료된 후 어느 시점에서 다음을 사용하여 원본을 복원할 수 있습니다.

추신 : 이것은 어떤 보장도 없는 해킹입니다. 저에게 효과적이었으므로 여러분과 공유할 생각입니다.

개발자/dev-ops이며 Hadoop을 빠르게 설치해야 합니다. 좋은 소식이 있습니다. Ambari는 단일 스크립트로 전체 마법사 프로세스와 완료된 설치 프로세스를 건너뛸 수 있는 방법을 제공합니다. 다음 포스트에서 이를 가져올 것이므로 계속 지켜봐주시고 행복한 Hadooping!