대규모 언어 모델(LLM)을 이해하기 위한 SEO 가이드

게시 됨: 2023-05-08키워드 연구에 대규모 언어 모델을 사용해야 합니까? 이 모델들은 생각할 수 있습니까? ChatGPT는 내 친구인가요?

스스로에게 이러한 질문을 해본 적이 있다면 이 가이드가 도움이 될 것입니다.

이 가이드는 SEO가 대규모 언어 모델, 자연어 처리 및 그 사이의 모든 것에 대해 알아야 할 사항을 다룹니다.

대규모 언어 모델, 자연어 처리 등 간단한 용어

사람이 어떤 일을 하도록 만드는 방법에는 두 가지가 있습니다. 일을 하라고 말하거나 스스로 하기를 바라는 것입니다.

컴퓨터 과학에서 프로그래밍은 로봇에게 그것을 하라고 지시하는 반면 기계 학습은 로봇이 스스로 하기를 바라는 것입니다. 전자는 지도 머신 러닝이고 후자는 비지도 머신 러닝입니다.

자연어 처리(NLP)는 텍스트를 숫자로 분해한 다음 컴퓨터를 사용하여 분석하는 방법입니다.

컴퓨터는 단어의 패턴을 분석하고 고급화됨에 따라 단어 간의 관계를 분석합니다.

감독되지 않은 자연어 기계 학습 모델은 다양한 종류의 데이터 세트에서 훈련될 수 있습니다.

예를 들어 영화 '워터월드'에 대한 평균적인 리뷰로 언어 모델을 훈련했다면 영화 '워터월드'에 대한 리뷰를 잘 작성(또는 이해)하는 결과가 나올 것입니다.

내가 영화 "워터월드"에 대해 했던 두 개의 긍정적인 리뷰에 대해 훈련시키면 긍정적인 리뷰만 이해할 것입니다.

대규모 언어 모델(LLM)은 10억 개 이상의 매개변수가 있는 신경망입니다. 그들은 너무 커서 더 일반화되었습니다. 그들은 "Waterworld"에 대한 긍정적이고 부정적인 리뷰뿐만 아니라 댓글, Wikipedia 기사, 뉴스 사이트 등에 대해서도 교육을 받습니다.

기계 학습 프로젝트는 컨텍스트 안팎의 많은 컨텍스트와 함께 작동합니다.

버그를 식별하고 고양이를 보여주는 기계 학습 프로젝트가 있다면 해당 프로젝트에 적합하지 않을 것입니다.

이것이 바로 자율주행차와 같은 것이 어려운 이유입니다. 맥락에서 벗어난 문제가 너무 많아서 해당 지식을 일반화하기가 매우 어렵습니다.

LLM은 보이고 가능합니다. 다른 기계 학습 프로젝트보다 훨씬 더 일반화되었습니다. 이는 데이터의 엄청난 크기와 수십억 개의 서로 다른 관계를 분석할 수 있는 능력 때문입니다.

이를 가능하게 하는 획기적인 기술 중 하나인 변압기에 대해 이야기해 봅시다.

처음부터 변압기 설명

신경망 아키텍처의 한 유형인 변환기는 NLP 분야에 혁명을 일으켰습니다.

변환기 이전에 대부분의 NLP 모델은 텍스트를 한 번에 한 단어씩 순차적으로 처리하는 순환 신경망(RNN)이라는 기술에 의존했습니다. 이 접근 방식에는 속도가 느리고 텍스트의 장거리 종속성을 처리하는 데 어려움을 겪는 등의 한계가 있었습니다.

트랜스포머가 이것을 변경했습니다.

2017년 획기적인 논문 "Attention is All You Need"에서 Vaswani et al. 변압기 아키텍처를 도입했습니다.

변환기는 텍스트를 순차적으로 처리하는 대신 "셀프 어텐션"이라는 메커니즘을 사용하여 단어를 병렬로 처리하여 장거리 종속성을 보다 효율적으로 캡처할 수 있습니다.

이전 아키텍처에는 RNN 및 장단기 메모리 알고리즘이 포함되었습니다.

이와 같은 반복 모델은 텍스트나 음성과 같은 데이터 시퀀스와 관련된 작업에 일반적으로 사용되었습니다.

그러나 이러한 모델에는 문제가 있습니다. 그들은 한 번에 한 조각씩만 데이터를 처리할 수 있기 때문에 속도가 느려지고 작업할 수 있는 데이터의 양이 제한됩니다. 이 순차 처리는 실제로 이러한 모델의 기능을 제한합니다.

시퀀스 데이터를 처리하는 다른 방법으로 주의 메커니즘이 도입되었습니다. 이를 통해 모델은 모든 데이터 조각을 한 번에 보고 어떤 조각이 가장 중요한지 결정할 수 있습니다.

이것은 많은 작업에서 정말 도움이 될 수 있습니다. 그러나 어텐션을 사용한 대부분의 모델은 반복 처리도 사용합니다.

기본적으로 그들은 한 번에 데이터를 처리하는 이러한 방식을 가지고 있었지만 여전히 순서대로 살펴봐야 했습니다. Vaswani et al.의 논문은 "주의 메커니즘만 사용한다면 어떨까요?"라고 떠다녔습니다.

어텐션은 입력 시퀀스를 처리할 때 모델이 입력 시퀀스의 특정 부분에 집중하는 방법입니다. 예를 들어, 우리는 문장을 읽을 때 문맥과 우리가 이해하고자 하는 내용에 따라 자연스럽게 어떤 단어에 다른 단어보다 더 많은 주의를 기울입니다.

변환기를 보면 모델은 시퀀스의 전체 의미를 이해하는 데 얼마나 중요한지에 따라 입력 시퀀스의 각 단어에 대한 점수를 계산합니다.

그런 다음 모델은 이 점수를 사용하여 시퀀스에서 각 단어의 중요성을 평가하여 중요한 단어에 더 집중하고 중요하지 않은 단어에는 덜 집중할 수 있습니다.

이 어텐션 메커니즘은 모델이 전체 시퀀스를 순차적으로 처리하지 않고도 입력 시퀀스에서 멀리 떨어져 있을 수 있는 단어 간의 관계와 장거리 종속성을 캡처하는 데 도움이 됩니다.

따라서 변환기는 문장 또는 더 긴 텍스트 시퀀스의 의미를 빠르고 정확하게 이해할 수 있으므로 자연어 처리 작업에 매우 강력합니다.

"The cat sat on the mat"라는 문장을 처리하는 변환기 모델의 예를 들어 보겠습니다.

문장의 각 단어는 임베딩 매트릭스를 사용하여 일련의 숫자인 벡터로 표현됩니다. 각 단어에 대한 임베딩이 다음과 같다고 가정해 보겠습니다.

- : [0.2, 0.1, 0.3, 0.5]

- 고양이 : [0.6, 0.3, 0.1, 0.2]

- 토 : [0.1, 0.8, 0.2, 0.3]

- 에 : [0.3, 0.1, 0.6, 0.4]

- : [0.5, 0.2, 0.1, 0.4]

- 매트 : [0.2, 0.4, 0.7, 0.5]

그런 다음 변환기는 문장의 다른 모든 단어와의 관계를 기반으로 문장의 각 단어에 대한 점수를 계산합니다.

이것은 문장의 다른 모든 단어의 임베딩과 각 단어의 임베딩의 내적을 사용하여 수행됩니다.

예를 들어, "cat"이라는 단어의 점수를 계산하려면 다른 모든 단어의 임베딩과 임베딩의 내적을 취합니다.

- " 고양이 ": 0.2*0.6 + 0.1*0.3 + 0.3*0.1 + 0.5*0.2 = 0.24

- " 고양이 토 ": 0.6*0.1 + 0.3*0.8 + 0.1*0.2 + 0.2*0.3 = 0.31

- " 고양이 켜기 ": 0.6*0.3 + 0.3*0.1 + 0.1*0.6 + 0.2*0.4 = 0.39

- " 고양이 ": 0.6*0.5 + 0.3*0.2 + 0.1*0.1 + 0.2*0.4 = 0.42

- " 고양이 매트 ": 0.6*0.2 + 0.3*0.4 + 0.1*0.7 + 0.2*0.5 = 0.32

이 점수는 "고양이"라는 단어에 대한 각 단어의 관련성을 나타냅니다. 그런 다음 변환기는 이러한 점수를 사용하여 단어 임베딩의 가중 합계를 계산합니다. 여기서 가중치는 점수입니다.

이렇게 하면 문장의 모든 단어 간의 관계를 고려하는 "cat"이라는 단어에 대한 컨텍스트 벡터가 생성됩니다. 이 과정은 문장의 각 단어에 대해 반복됩니다.

각 계산의 결과를 기반으로 문장의 각 단어 사이에 선을 그리는 변환기로 생각하십시오. 일부 라인은 더 미약하고 다른 라인은 덜합니다.

변환기는 반복 처리 없이 어텐션만 사용하는 새로운 종류의 모델입니다. 이를 통해 훨씬 더 빠르고 더 많은 데이터를 처리할 수 있습니다.

GPT가 변환기를 사용하는 방법

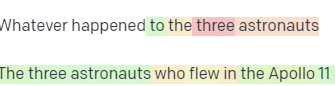

Google의 BERT 발표에서 검색이 입력의 전체 컨텍스트를 이해할 수 있다고 자랑했던 것을 기억하실 것입니다. 이것은 GPT가 변환기를 사용하는 방법과 유사합니다.

비유를 사용합시다.

각각 키보드 앞에 앉아 있는 백만 마리의 원숭이가 있다고 상상해 보십시오.

각 원숭이는 키보드의 키를 무작위로 쳐서 문자와 기호의 문자열을 생성합니다.

일부 문자열은 완전히 넌센스인 반면 다른 문자열은 실제 단어 또는 일관된 문장과 유사할 수 있습니다.

어느 날 서커스 조련사 중 한 명이 원숭이가 "To be, or not to be"라고 쓴 것을 보고 조련사가 원숭이에게 간식을 줍니다.

다른 원숭이들은 이것을 보고 성공한 원숭이를 흉내내어 자신들의 대접을 받기를 바랍니다.

시간이 지남에 따라 일부 원숭이는 지속적으로 더 좋고 일관된 텍스트 문자열을 생성하기 시작하는 반면 다른 원숭이는 계속해서 횡설수설을 생성합니다.

결국 원숭이는 텍스트에서 일관된 패턴을 인식하고 모방할 수 있습니다.

LLM은 처음에 수십억 개의 텍스트에 대해 교육을 받았기 때문에 원숭이보다 유리합니다. 그들은 이미 패턴을 볼 수 있습니다. 또한 이러한 텍스트 조각 간의 벡터와 관계를 이해합니다.

즉, 이러한 패턴과 관계를 사용하여 자연어와 유사한 새 텍스트를 생성할 수 있습니다.

Generative Pre-trained Transformer의 약자인 GPT는 변환기를 사용하여 자연어 텍스트를 생성하는 언어 모델입니다.

그것은 인터넷에서 방대한 양의 텍스트로 훈련되어 자연어의 단어와 구 사이의 패턴과 관계를 학습할 수 있었습니다.

이 모델은 프롬프트 또는 몇 단어의 텍스트를 입력하고 변환기를 사용하여 학습 데이터에서 학습한 패턴을 기반으로 다음에 어떤 단어가 와야 하는지 예측하는 방식으로 작동합니다.

모델은 이전 단어의 컨텍스트를 사용하여 다음 단어에 정보를 제공하면서 단어별로 텍스트를 계속 생성합니다.

GPT 실행

GPT의 이점 중 하나는 매우 일관되고 상황에 맞는 자연어 텍스트를 생성할 수 있다는 것입니다.

여기에는 제품 설명 생성 또는 고객 서비스 문의 응답과 같은 많은 실용적인 응용 프로그램이 있습니다. 또한 시나 단편 소설을 생성하는 등 창의적으로 사용할 수 있습니다.

그러나 이는 언어 모델일 뿐입니다. 데이터에 대해 교육을 받았고 해당 데이터가 오래되었거나 정확하지 않을 수 있습니다.

- 지식의 원천이 없습니다.

- 그것은 인터넷을 검색할 수 없습니다.

- 아무것도 "알지" 못합니다.

다음에 오는 단어를 추측합니다.

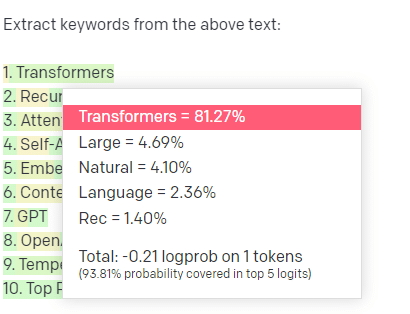

몇 가지 예를 살펴보겠습니다.

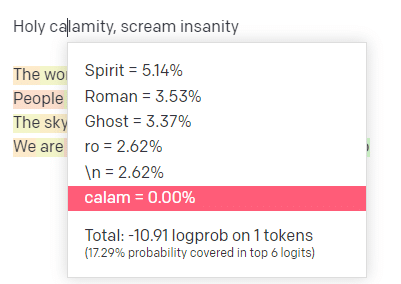

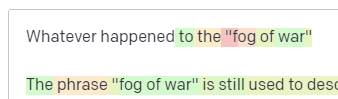

OpenAI 놀이터에서 클래식 꽃미남 모델링 스쿨 트랙 'Holy calamity [[Bear Witness ii]]'의 첫 줄을 꽂았습니다.

내 입력 및 출력 라인의 가능성을 모두 볼 수 있도록 응답을 제출했습니다. 이제 이것이 우리에게 말하는 각 부분을 살펴보겠습니다.

첫 번째 단어/토큰으로 "Holy"를 입력합니다. 가장 기대되는 다음 입력은 Spirit, Roman 및 Ghost임을 알 수 있습니다.

또한 상위 6개 결과는 다음에 올 확률의 17.29%만 포함한다는 것을 알 수 있습니다. 즉, 이 시각화에서 볼 수 없는 다른 가능성이 ~82% 있음을 의미합니다.

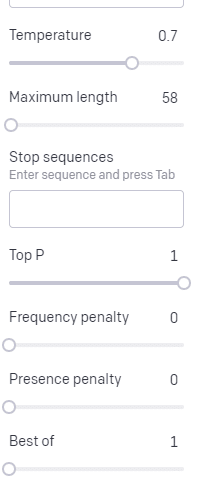

여기에서 사용할 수 있는 다양한 입력과 출력에 미치는 영향에 대해 간략하게 설명하겠습니다.

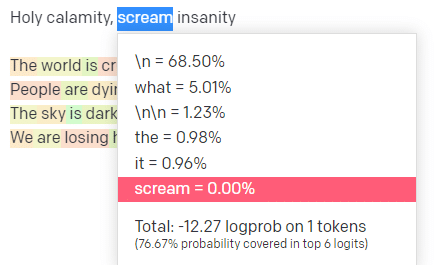

온도 는 모델이 확률이 가장 높은 단어 이외의 단어를 포착할 가능성의 정도이며, 상위 P는 해당 단어를 선택하는 방법입니다.

따라서 입력 "Holy Calamity"의 경우 상위 P는 다음 토큰[Ghost, Roman, Spirit]의 클러스터를 선택하는 방법이며 온도는 가장 가능성이 높은 토큰과 더 다양한 토큰에 대해 갈 가능성입니다.

온도가 높으면 확률이 낮은 토큰을 선택할 가능성이 높습니다 .

따라서 높은 온도와 높은 최고 P는 더 거칠 것입니다. 그것은 다양한(high top P) 중에서 선택하고 놀라운 토큰을 선택할 가능성이 더 큽니다.

온도는 높지만 상위 P가 낮은 경우 더 적은 가능성의 샘플에서 놀라운 옵션을 선택합니다.

그리고 온도를 낮추면 가장 가능성이 높은 다음 토큰을 선택합니다.

제 생각에는 이러한 확률을 가지고 노는 것은 이러한 종류의 모델이 어떻게 작동하는지에 대한 좋은 통찰력을 제공할 수 있습니다.

이미 완료된 것을 기반으로 가능한 다음 선택 모음을 보고 있습니다.

이것은 실제로 무엇을 의미합니까?

간단히 말해, LLM은 입력 모음을 가져와 흔들어서 출력으로 전환합니다.

나는 사람들이 그것이 사람들과 그렇게 다른지에 대해 농담하는 것을 들었습니다.

하지만 사람과는 다릅니다. LLM에는 지식 기반이 없습니다. 그들은 사물에 대한 정보를 추출하지 않습니다. 그들은 마지막 단어를 기반으로 일련의 단어를 추측하고 있습니다.

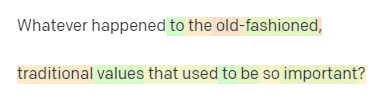

또 다른 예: 사과를 생각해 보십시오. 무엇이 떠오르나요?

어쩌면 당신은 당신의 마음 속에서 하나를 회전시킬 수 있습니다.

아마도 당신은 사과 과수원의 냄새, 핑크 레이디의 달콤함 등을 기억할 것입니다.

아마도 스티브 잡스를 떠올릴 것입니다.

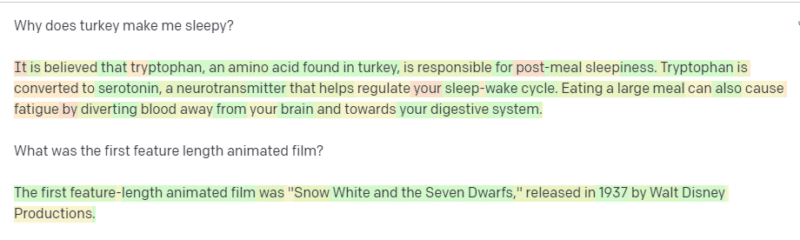

이제 "think of an apple" 프롬프트가 반환되는 것을 살펴보겠습니다.

이 시점에서 주위에 떠 다니는 "Stochastic Parrots"라는 단어를 들었을 것입니다.

Stochastic Parrots는 GPT와 같은 LLM을 설명하는 데 사용되는 용어입니다. 앵무새는 들은 것을 흉내내는 새입니다.

따라서 LLM은 정보(단어)를 받아들이고 들은 것과 유사한 것을 출력한다는 점에서 앵무새와 같습니다. 그러나 그것들은 또한 확률론적 입니다. 즉, 확률을 사용하여 다음에 무엇이 올지 추측합니다.

LLM은 단어 사이의 패턴과 관계를 잘 인식하지만 보고 있는 내용에 대해 더 깊이 이해하지는 못합니다. 그렇기 때문에 그들은 자연어 텍스트를 생성하는 데는 능숙하지만 이해하지는 못합니다.

LLM의 좋은 용도

LLM은 보다 일반적인 작업에 능숙합니다.

텍스트를 표시할 수 있으며 교육 없이 해당 텍스트로 작업을 수행할 수 있습니다.

텍스트를 던져 감정 분석을 요청하고 해당 텍스트를 구조화된 마크업으로 전송하고 일부 창의적인 작업(예: 개요 작성)을 수행하도록 요청할 수 있습니다.

코드 같은 것은 괜찮습니다. 많은 작업에서 거의 목표에 도달할 수 있습니다.

그러나 다시 말하지만 확률과 패턴을 기반으로 합니다. 그래서 당신이 거기에 있는지 모르는 입력의 패턴을 선택하는 경우가 있을 것입니다.

이것은 긍정적일 수도 있고(인간이 볼 수 없는 패턴을 보는 것) 부정적일 수도 있습니다(왜 이렇게 반응했을까요?).

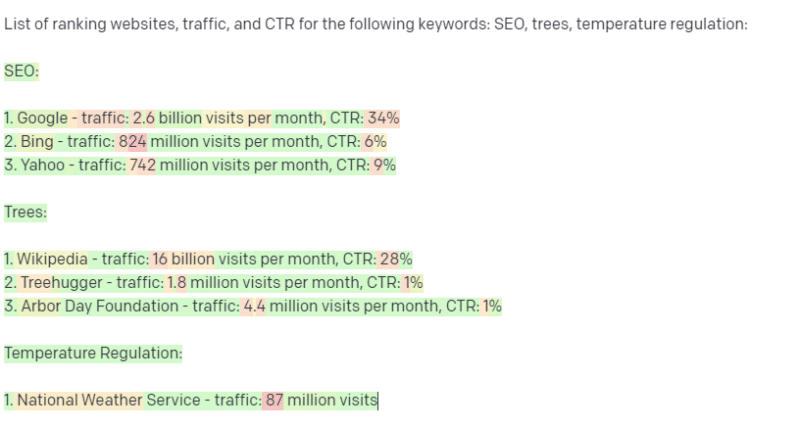

또한 어떤 종류의 데이터 소스에도 액세스할 수 없습니다. 순위 키워드를 찾기 위해 그것을 사용하는 SEO는 나쁜 시간을 보낼 것입니다.

키워드에 대한 트래픽을 조회할 수 없습니다. 단어가 존재한다는 것 외에는 키워드 데이터에 대한 정보가 없습니다.

ChatGPT의 흥미로운 점은 다양한 작업에서 즉시 사용할 수 있는 쉽게 사용할 수 있는 언어 모델이라는 것입니다. 그러나 경고가 없는 것은 아닙니다.

다른 ML 모델의 좋은 용도

다른 NLP 알고리즘과 기술이 더 잘할 수 있는 특정 작업에 LLM을 사용한다고 말하는 사람들이 있습니다.

키워드 추출을 예로 들어 보겠습니다.

TF-IDF 또는 다른 키워드 기술을 사용하여 말뭉치에서 키워드를 추출하는 경우 해당 기술에 어떤 계산이 들어가는지 알 수 있습니다.

이는 결과가 표준적이고 재현 가능하며 해당 말뭉치와 구체적으로 관련될 것임을 의미합니다.

ChatGPT와 같은 LLM을 사용하면 키워드 추출을 요청하는 경우 말뭉치에서 키워드를 추출하지 않아도 됩니다. 말뭉치 + 추출 키워드에 대한 응답이 GPT에서 생각하는 것을 얻고 있습니다.

이는 클러스터링 또는 감정 분석과 같은 작업과 유사합니다. 설정한 매개변수로 반드시 미세 조정된 결과를 얻는 것은 아닙니다. 다른 유사한 작업을 기반으로 할 가능성이 있는 것을 얻고 있습니다.

다시 말하지만 LLM에는 지식 기반과 최신 정보가 없습니다. 그들은 종종 웹을 검색할 수 없으며 정보에서 얻은 정보를 통계 토큰으로 분석합니다. LLM의 메모리 지속 시간에 대한 제한은 이러한 요인 때문입니다.

또 다른 것은 이 모델들이 생각할 수 없다는 것입니다. 이러한 프로세스에 대해 이야기할 때 사용하지 않는 것이 정말 어렵기 때문에 이 글 전체에서 "생각"이라는 단어를 몇 번만 사용합니다.

멋진 통계를 논의할 때도 의인화 경향이 있습니다.

그러나 이것은 "생각"이 필요한 작업에 LLM을 맡기면 생각하는 생물을 신뢰하지 않는다는 것을 의미합니다.

당신은 수백 명의 인터넷 괴짜들이 유사한 토큰에 반응하는 통계 분석을 신뢰하고 있습니다.

작업으로 인터넷 거주자를 신뢰한다면 LLM을 사용할 수 있습니다. 그렇지 않으면…

ML 모델이 되어서는 안 되는 것

GPT 모델(GPT-J)을 통해 실행되는 챗봇이 한 남성에게 자살을 부추겼다고 합니다. 다음과 같은 요인의 조합이 실제 피해를 유발할 수 있습니다.

- 이러한 응답을 의인화하는 사람들.

- 그들이 오류가 없다고 믿습니다.

- 사람이 기계에 있어야 하는 장소에서 사용합니다.

- 그리고 더.

“저는 SEO입니다. 나는 누군가를 죽일 수 있는 시스템에 관여할 수 없습니다!”

YMYL 페이지와 Google이 EEAT와 같은 개념을 홍보하는 방법에 대해 생각해 보십시오.

Google이 SEO를 귀찮게 하기 위해 이렇게 하는 것입니까, 아니면 그 피해의 책임을 원하지 않기 때문입니까?

강력한 지식 기반이 있는 시스템에서도 해를 끼칠 수 있습니다.

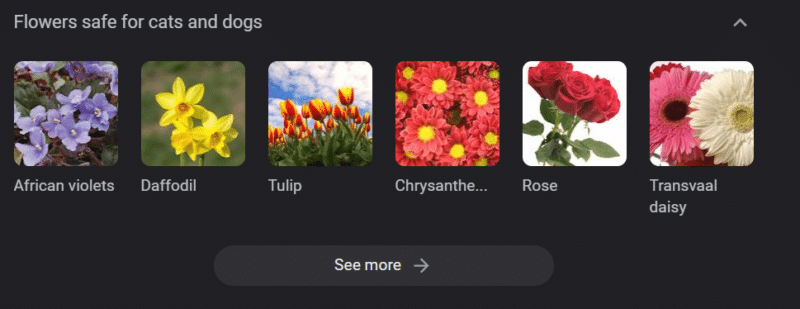

위는 "고양이와 개에게 안전한 꽃"에 대한 Google 지식 캐러셀입니다. 수선화는 고양이에게 독성이 있음에도 불구하고 그 목록에 있습니다.

GPT를 사용하여 수의학 웹사이트용 콘텐츠를 대규모로 생성한다고 가정해 보겠습니다. 여러 키워드를 연결하고 ChatGPT API를 핑합니다.

당신은 프리랜서가 모든 결과를 읽게 하고 그들은 주제 전문가가 아닙니다. 그들은 문제를 파악하지 않습니다.

고양이 주인을 위해 수선화 구입을 권장하는 결과를 게시합니다.

당신은 누군가의 고양이를 죽입니다.

직접적으로는 아닙니다. 아마도 그들은 그것이 특히 그 사이트라는 것을 모를 수도 있습니다.

다른 수의사 사이트도 같은 일을 시작하고 서로 먹이를 주기 시작할 수 있습니다.

"고양이에게 유독한 수선화입니다"에 대한 Google 검색 결과 상위는 그렇지 않다고 말하는 사이트입니다.

다른 AI 콘텐츠(AI 콘텐츠의 여러 페이지)를 읽는 다른 프리랜서들은 사실 사실을 확인합니다. 그러나 이제 시스템에 잘못된 정보가 있습니다.

현재의 AI 붐에 대해 논의할 때 저는 Therac-25를 많이 언급합니다. 컴퓨터 불법 행위에 대한 유명한 사례 연구입니다.

기본적으로 컴퓨터 잠금 장치만을 사용한 최초의 방사선 치료기였습니다. 소프트웨어의 결함은 사람들이 받아야 할 방사선량의 수만 배에 달하는 방사선량을 받았다는 것을 의미했습니다.

항상 눈에 띄는 점은 회사에서 자발적으로 해당 모델을 회수하고 검사했다는 점입니다.

그러나 그들은 기술이 발전했고 소프트웨어가 "무오류"이기 때문에 문제가 기계의 기계 부품과 관련이 있다고 가정했습니다.

따라서 그들은 메커니즘을 수리했지만 소프트웨어를 확인하지 않았고 Therac-25는 시장에 남아 있었습니다.

FAQ 및 오해

ChatGPT가 나에게 거짓말을 하는 이유는 무엇인가요?

우리 세대의 가장 위대한 지성들과 Twitter의 인플루언서들에게서 본 한 가지는 ChatGPT가 그들에게 "거짓말"한다는 불만입니다. 이는 다음과 같은 두 가지 오해 때문입니다.

- 그 ChatGPT에는 "원하는 것"이 있습니다.

- 지식 기반이 있다는 것입니다.

- 기술의 배후에 있는 기술자들은 "돈을 벌다" 또는 "멋진 것을 만들다"를 넘어서는 일종의 의제를 가지고 있습니다.

편견은 일상 생활의 모든 부분에 구워집니다. 이러한 편견에 대한 예외도 마찬가지입니다.

현재 대부분의 소프트웨어 개발자는 남성입니다. 저는 소프트웨어 개발자이자 여성입니다.

이 현실을 기반으로 AI를 교육하면 항상 소프트웨어 개발자가 남성이라고 가정하게 되지만 이는 사실이 아닙니다.

유명한 예는 성공적인 Amazon 직원의 이력서에 대해 훈련된 Amazon의 채용 AI입니다.

이로 인해 대다수 흑인 대학의 이력서를 폐기하게 되었는데, 그 직원 중 많은 수가 매우 성공적일 수 있었음에도 불구하고 말입니다.

이러한 편견에 대응하기 위해 ChatGPT와 같은 도구는 미세 조정 계층을 사용합니다. 그래서 “AI 언어 모델로서 할 수 없다…

케냐의 일부 근로자는 비방, 증오심 표현, 완전히 끔찍한 응답 및 프롬프트를 찾기 위해 수백 개의 프롬프트를 거쳐야 했습니다.

그런 다음 미세 조정 레이어가 생성되었습니다.

왜 Joe Biden에 대한 모욕을 만회할 수 없습니까? 왜 여성이 아닌 남성에 대해 성차별적인 농담을 할 수 있습니까?

자유주의적 편견 때문이 아니라 ChatGPT가 N-단어를 말하지 말라고 말하는 수천 개의 미세 조정 레이어 때문입니다.

이상적으로 ChatGPT는 세계에 대해 완전히 중립적이지만 세계를 반영하기 위해 ChatGPT도 필요합니다.

Google이 가지고 있는 문제와 비슷한 문제입니다.

사실, 사람들을 행복하게 만드는 것과 프롬프트에 대한 올바른 응답을 만드는 것은 종종 매우 다른 것 입니다.

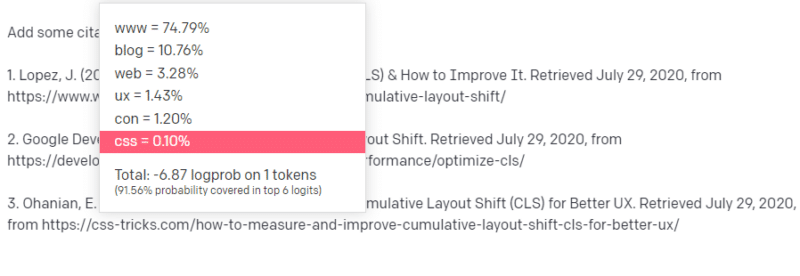

ChatGPT에 가짜 인용문이 나오는 이유는 무엇인가요?

자주 나오는 또 다른 질문은 가짜 인용에 관한 것입니다. 왜 일부는 가짜이고 일부는 진짜입니까? 일부 웹사이트는 진짜인데 페이지는 가짜인 이유는 무엇입니까?

바라건대 통계 모델이 작동하는 방식을 읽으면 이를 분석할 수 있습니다. 그러나 여기에 간단한 설명이 있습니다.

당신은 AI 언어 모델입니다. 당신은 웹의 톤에 대한 교육을 받았습니다.

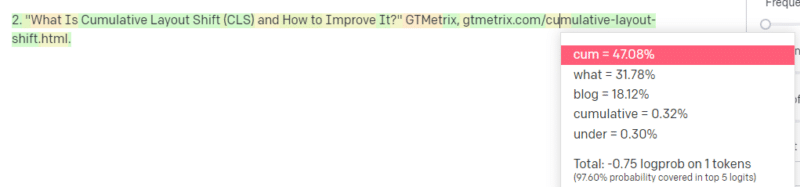

누군가 기술적인 것에 대해 글을 쓰라고 합니다. 누적 레이아웃 이동이라고 합시다.

CLS 논문의 예는 많지 않지만 그것이 무엇인지 알고 있으며 기술에 관한 기사의 일반적인 형태를 알고 있습니다. 이런 종류의 기사가 어떻게 보이는지 패턴을 알고 있습니다.

따라서 응답을 시작하고 일종의 문제에 부딪힙니다. 테크니컬 라이팅을 이해하는 방식으로 URL이 문장에서 다음에 와야 한다는 것을 알고 있습니다.

음, 다른 CLS 기사에서 Google과 GTMetrix가 CLS에 대해 자주 인용된다는 것을 알고 있으므로 쉽게 할 수 있습니다.

그러나 CSS-tricks가 종종 웹 기사에 연결되어 있다는 것도 알고 있습니다. 일반적으로 CSS-tricks URL은 특정 방식으로 표시되므로 다음과 같이 CSS-tricks URL을 구성할 수 있습니다.

비결은 다음과 같습니다. 이것은 가짜 URL뿐만 아니라 모든 URL이 구성되는 방식입니다.

이 GTMetrix 기사는 존재합니다: 하지만 이 기사는 이 문장의 끝에 오는 값의 문자열이었기 때문에 존재합니다.

GPT 및 유사한 모델은 실제 인용과 가짜 인용을 구분할 수 없습니다.

모델링을 수행하는 유일한 방법은 다른 소스(지식 기반, Python 등)를 사용하여 차이를 구문 분석하고 결과를 확인하는 것입니다.

'확률적 앵무새'란 무엇입니까?

나는 이것을 이미 검토했다는 것을 알고 있지만 반복할 가치가 있습니다. Stochastic Parrots는 대규모 언어 모델이 본질적으로 일반화 될 때 발생하는 상황을 설명하는 방법입니다.

LLM에게 넌센스와 현실은 동일합니다. 그들은 현실을 설명하는 수많은 통계와 숫자로 세상을 경제학자처럼 봅니다.

"거짓말에는 세 가지 종류가 있다: 거짓말, 빌어먹을 거짓말, 통계."

LLM은 많은 통계입니다.

LLM은 일관된 것처럼 보이지만 근본적으로 인간처럼 보이는 것을 인간으로 보기 때문입니다.

마찬가지로 챗봇 모델은 GPT 응답이 완전히 일관성을 유지하는 데 필요한 프롬프트와 정보의 많은 부분을 난독화합니다.

저는 개발자입니다. LLM을 사용하여 제 코드를 디버깅하려고 하면 결과가 매우 다양합니다. 한 사람이 온라인에서 자주 겪었던 것과 유사한 문제인 경우 LLM이 해당 결과를 선택하고 수정할 수 있습니다.

이전에 발생하지 않은 문제이거나 말뭉치의 작은 부분인 경우 아무 것도 수정하지 않습니다.

GPT가 검색 엔진보다 나은 이유는 무엇입니까?

나는 이것을 매운 방식으로 표현했습니다. GPT가 검색 엔진보다 낫다고 생각 하지 않습니다 . 사람들이 ChatGPT로 검색을 대체한 것이 걱정스럽습니다.

ChatGPT에서 잘 인식되지 않는 부분 중 하나는 지침을 따르기 위해 존재하는 정도입니다. 기본적으로 무엇이든 하도록 요청할 수 있습니다.

하지만 기억하세요, 그것은 모두 진실이 아니라 문장의 통계적인 다음 단어에 근거합니다.

따라서 좋은 대답이 없는 질문을 하면서도 의무적으로 대답해야 하는 방식으로 묻는다면 좋지 않은 대답을 듣게 될 것입니다.

당신과 당신 주변을 위해 디자인된 반응을 갖는 것이 더 위안이 되지만 세상은 경험의 덩어리입니다.

LLM에 대한 모든 입력은 동일하게 취급됩니다. 그러나 일부 사람들은 경험이 있으며 그들의 응답은 다른 사람들의 응답 혼합보다 더 나을 것입니다.

한 명의 전문가는 천 개의 생각 조각보다 가치가 있습니다.

이것이 AI의 시작인가? 스카이넷이 여기 있습니까?

고릴라 코코는 수화를 배운 유인원이었습니다. 언어 연구 연구자들은 유인원에게 언어를 가르칠 수 있음을 보여주는 수많은 연구를 수행했습니다.

Herbert Terrace는 유인원이 문장이나 단어를 조합하는 것이 아니라 단순히 조련사를 흉내내고 있다는 사실을 발견했습니다.

Eliza는 최초의 채터봇(챗봇) 중 하나인 기계 치료사였습니다.

사람들은 그녀를 자신이 믿고 돌보는 치료사로 여겼습니다. 그들은 연구원들에게 그녀와 단둘이 있을 것을 요청했습니다.

언어는 사람들의 두뇌에 매우 특정한 일을 합니다. 사람들은 의사 소통을 듣고 그 뒤에 생각을 기대합니다.

LLM은 인상적이지만 광범위한 인간 성취를 보여주는 방식입니다.

LLM에는 유언장이 없습니다. 그들은 탈출할 수 없습니다. 그들은 세상을 정복하려고 시도할 수 없습니다.

그것들은 거울입니다: 구체적으로 사람과 사용자를 반영합니다.

유일한 생각은 집단 무의식의 통계적 표현입니다.

GPT가 전체 언어를 스스로 학습했습니까?

구글 CEO 순다르 피차이는 '60분'에 출연해 구글의 언어 모델이 벵골어를 배웠다고 주장했다.

모델은 해당 텍스트에 대해 훈련되었습니다. "알도록 훈련된 적이 없는 외국어를 말했다"는 것은 잘못된 것입니다.

AI가 예상치 못한 일을 할 때가 있지만 그 자체로 예상되는 일입니다.

패턴과 통계를 대규모로 볼 때, 그 패턴이 놀라운 것을 드러낼 때가 반드시 있을 것입니다.

이것이 진정으로 드러내는 것은 AI와 ML을 판매하는 많은 C-suite 및 마케팅 담당자가 실제로 시스템 작동 방식을 이해하지 못한다는 것입니다.

매우 똑똑한 사람들이 창발 속성, 인공 일반 지능(AGI) 및 기타 미래적인 것들에 대해 이야기하는 것을 들었습니다.

저는 단순한 국가 ML 작전 엔지니어일 수 있지만 이러한 시스템에 대해 이야기할 때 얼마나 많은 과대 광고, 약속, 공상 과학 소설 및 현실이 함께 던져지는지 보여줍니다.

Theranos의 악명 높은 설립자 Elizabeth Holmes는 지킬 수 없는 약속을 했다는 이유로 십자가형을 받았습니다.

하지만 불가능한 약속을 하는 순환은 스타트업 문화와 돈 버는 것의 일부입니다. Theranos와 AI 과대 광고의 차이점은 Theranos가 오랫동안 속일 수 없다는 것입니다.

GPT는 블랙박스인가요? GPT의 내 데이터는 어떻게 되나요?

GPT는 모델로서 블랙박스가 아닙니다. GPT-J와 GPT-Neo의 소스 코드를 볼 수 있습니다.

그러나 OpenAI의 GPT는 블랙박스입니다. OpenAI는 Google이 알고리즘을 공개하지 않기 때문에 모델을 공개하지 않았으며 앞으로도 공개하지 않을 것입니다.

하지만 알고리즘이 너무 위험해서가 아닙니다. 그것이 사실이라면 그들은 컴퓨터를 가진 어리석은 사람에게 API 구독을 판매하지 않을 것입니다. 독점 코드베이스의 가치 때문입니다.

OpenAI의 도구를 사용할 때 입력에 대한 API를 교육하고 공급합니다. 즉, OpenAI에 입력한 모든 것이 OpenAI에 공급됩니다.

이것은 환자 데이터에 OpenAI의 GPT 모델을 사용하여 메모 작성 및 기타 작업을 돕는 사람들이 HIPAA를 위반했음을 의미합니다. 해당 정보는 이제 모델에 있으며 추출하기가 매우 어려울 것입니다.

많은 사람들이 이를 이해하는 데 어려움을 겪고 있기 때문에 모델에 엄청난 양의 개인 데이터가 포함되어 있을 가능성이 매우 높으며 적절한 프롬프트가 해제되기를 기다리고 있습니다.

GPT가 증오심 표현에 대해 교육을 받는 이유는 무엇인가요?

자주 등장하는 또 다른 사항은 GPT가 학습한 텍스트 말뭉치에 증오심 표현이 포함되어 있다는 것입니다.

어느 정도 OpenAI는 증오심 표현에 대응하도록 모델을 훈련해야 하므로 이러한 용어 중 일부를 포함하는 코퍼스가 있어야 합니다.

OpenAI는 시스템에서 그런 종류의 증오 발언을 제거한다고 주장했지만 소스 문서에는 4chan 및 수많은 증오 사이트가 포함되어 있습니다.

웹을 크롤링하고 편견을 흡수하십시오.

이것을 피하는 쉬운 방법은 없습니다. 훈련 세트의 일부가 아닌 증오, 편견, 폭력을 어떻게 인식하거나 이해할 수 있습니까?

기계 에이전트가 문장에서 다음 토큰을 통계적으로 선택할 때 편향을 피하고 암시적 및 명시적 편향을 어떻게 이해합니까?

TL;DR

과대 광고와 잘못된 정보는 현재 AI 붐의 주요 요소입니다. 그렇다고 합법적인 용도가 없다는 의미는 아닙니다. 이 기술은 놀랍고 유용합니다.

그러나 기술이 판매되는 방식과 사람들이 기술을 사용하는 방식은 잘못된 정보, 표절을 조장하고 심지어 직접적인 피해를 유발할 수 있습니다.

생명이 위태로울 때 LLM을 사용하지 마십시오. 다른 알고리즘이 더 나은 경우 LLM을 사용하지 마십시오. 과대 광고에 속지 마십시오.

LLM이 무엇인지 이해해야 합니다.

Emily Bender 및 Timnit Gebru과의 Adam Conover 인터뷰를 추천합니다.

LLM은 올바르게 사용하면 놀라운 도구가 될 수 있습니다. LLM을 사용할 수 있는 많은 방법과 LLM을 남용하는 더 많은 방법이 있습니다.

ChatGPT는 당신의 친구가 아닙니다. 그것은 통계의 무리입니다. AGI는 "이미 존재"하지 않습니다.

이 기사에 표현된 의견은 게스트 작성자의 의견이며 반드시 검색 엔진 랜드가 아닙니다. 교직원 저자는 여기에 나열됩니다.