Lista ponad 22 najlepszych narzędzi do usuwania sieci 2022 Jakie jest najlepsze narzędzie do usuwania sieci?

Opublikowany: 2022-10-21

Skrobanie robota

Scraper API obsługuje serwery proxy, przeglądarki i CAPTCHA, dzięki czemu możesz uzyskać kod HTML z dowolnej strony internetowej za pomocą prostego wywołania interfejsu API!

Bright Data (dawniej Luminati)

Bright Data (dawniej Luminati) to największa na świecie usługa proxy z lokalną siecią proxy obejmującą 72 miliony adresów IP na całym świecie i interfejsem zarządzania proxy bez kodowania Rozpocznij 7-dniowy bezpłatny okres próbny.

Skrobak API

Scraper API obsługuje serwery proxy, przeglądarki i CAPTCHA, dzięki czemu możesz uzyskać kod HTML z dowolnej strony internetowej za pomocą prostego wywołania interfejsu API!

W tym poście wymieniliśmy najlepsze narzędzia do skrobania sieci, które powinieneś wypróbować teraz. Więc zanurkujmy.

Narzędzia Web Scraping są specjalnie stworzone do wydobywania danych ze stron internetowych. Narzędzia te, znane również jako narzędzia do zbierania danych z sieci Web lub narzędzia do ekstrakcji danych z sieci Web, są przydatne dla osób, które chcą zebrać dane lub informacje z witryn internetowych. Web Scraping to nowoczesna technika wprowadzania danych, która eliminuje konieczność wielokrotnego wpisywania lub kopiowania i wklejania informacji.

Tego rodzaju oprogramowanie wyszukuje nowe dane ręcznie lub automatycznie i pobiera zaktualizowane dane i przechowuje je, aby można było łatwo uzyskać do nich dostęp. Na przykład możesz zbierać informacje o produktach i ich kosztach od Amazon za pomocą narzędzia do skrobania.

Jeśli kopiujesz dane z witryny do arkusza kalkulacyjnego, bazy danych lub innej centralnej lokalizacji w celu późniejszego ich odzyskania, oznacza to, że zgarniasz sieć. Ale jeśli zrobisz to ręcznie, może to zająć dużo czasu.

Możesz wykonać ten proces zbierania danych automatycznie za pomocą narzędzi do skrobania stron internetowych.

Możesz wykonać skrobanie sieci za pomocą następujących ośmiu technik:

- Parsowanie Document Object Model (DOM)

- Parsowanie HTML

- Ręczne kopiowanie i wklejanie

- Agregacja pionowa

- Dopasowanie wzorca tekstu

- Rozpoznawanie adnotacji semantycznych

- Analiza stron internetowych w zakresie wizji komputerowej

- Programowanie HTTP

Spis treści

Szukasz najlepszych narzędzi do skrobania stron internetowych w 2021 roku?

Procedury, takie jak skrobanie sieci, skrobanie HTML lub jakakolwiek inna forma ekstrakcji danych, mogą być złożone. Od uzyskania dokładnego źródła strony i dokładnego sprawdzenia źródła po renderowanie skryptu java i uzyskanie danych w użytecznej konfiguracji, w rzeczywistości jest dużo pracy do wykonania. Chociaż różni użytkownicy mają różne wymagania, dostępne są narzędzia dla każdego z nich – osób, które chcą tworzyć skrobaki internetowe bez kodowania, programistów, którzy chcą tworzyć roboty indeksujące do większych witryn i wiele więcej

W tym poście wymieniamy 20 najlepszych narzędzi do skrobania sieci do zbierania danych, bez kodowania. Wymieniliśmy również 4 uzupełniające się narzędzia po liście 20 najlepszych, co czyni go 24 narzędziami do skrobania sieci do wyboru.

Top 22+ Najlepsze narzędzia do skrobania stron internetowych 2022:

Oto lista 20 najlepszych narzędzi do skrobania stron internetowych na październik 2022 r., których należy użyć, aby zaspokoić potrzeby w zakresie ekstrakcji danych z witryny. Narzędzia te zostały docenione zarówno przez użytkowników, jak i krytyków za ich funkcje, ogólną wydajność, ceny i inne kluczowe aspekty, jako jedne z najlepszych narzędzi, których możesz użyć do skrobania sieci.

1) Bright Data (dawniej Luminati) #1 Najlepsze narzędzie do skrobania sieci

Firma Luminati Networks stworzyła narzędzie Data Collector nowej generacji, które zapewnia zintegrowany i spersonalizowany przepływ danych w jednym, łatwym do zrozumienia pulpicie nawigacyjnym. Zestawy danych są dostosowane do potrzeb Twojej firmy, od trendów w handlu elektronicznym i treści w mediach społecznościowych po analizy biznesowe i ankiety konsumenckie.

Narzędzia i funkcje:

- Możesz uzyskać zautomatyzowaną analizę danych z modułu Data Collector, kiedy tylko i gdzie chcesz.

- Nie ma potrzeby posiadania skomplikowanej platformy do gromadzenia danych.

- Masz całkowitą kontrolę nad procesem zbierania danych.

- Odblokowywanie danych

- Menedżer proxy Luminati pozwala obsługiwać proxy jak profesjonalista bez kodowania.

- W ciągu kilku minut uzyskasz stabilny przepływ danych.

- Przy jednym zamówieniu ich przeszukiwarka nowej generacji pozwala uzyskać rzeczywiste wyniki wyszukiwania dowolnego słowa kluczowego we wszystkich głównych wyszukiwarkach.

- Zbieranie danych, które jest wszechstronne i wrażliwe na substytuty po stronie docelowej, co skutkuje wysokim wskaźnikiem sukcesu.

- Ich przyjazne dla użytkownika rozszerzenie przeglądarki ułatwia kierowanie na konkretną geolokalizację i zmianę ustawień proxy.

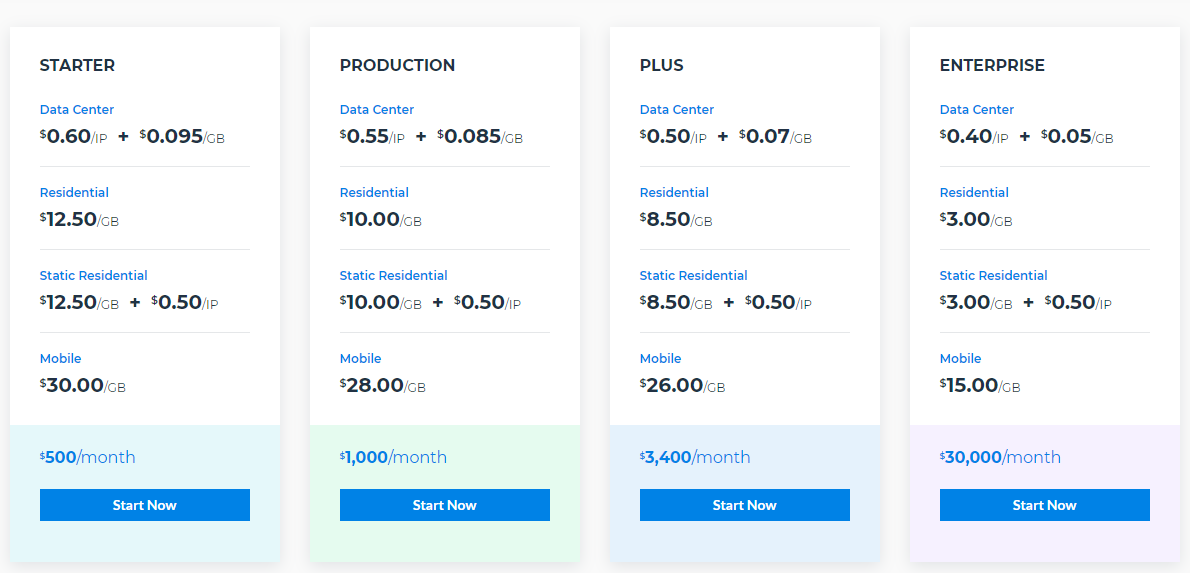

cennik

2) Scraping Robot #2 Najlepsze narzędzie do skrobania sieci

Scraping Robot to skuteczne i przyjazne dla użytkownika narzędzie do skrobania sieci. Ponieważ jest bardzo łatwy w użyciu, jest odpowiedni dla początkujących. Ma kilka nowoczesnych narzędzi i funkcji, których większość innych dostępnych witryn nie oferuje, a nawet jeśli tak, pobierają znacznie więcej.

To najlepsze narzędzie do zbierania danych i rozwijania Twojego biznesu. Nawiązali wiele partnerstw w branży, aby obniżyć cenę w kilku miejscach i zbudowali dobrze zorganizowaną procedurę, która zmniejsza koszty rozwoju i koszty techniczne. Wszystkie te cechy tworzą zatem produkt, który zapewnia wyższy poziom wydajności za niższą cenę niż konkurenci.

Narzędzia i funkcje

- Filtr modułu:

Chociaż ta funkcja jest w fazie rozwoju, w najbliższej przyszłości mogą dodać funkcje, takie jak filtry produktów, filtry profili.

- Biblioteka demonstracyjna:

Ta biblioteka zawiera wszystkie szczegóły i informacje o tym, jak działa każdy moduł.

- API:

Dają swoim klientom dostęp na poziomie programisty. Może to ułatwić organizowanie serwerów proxy, serwerów i zasobów deweloperskich oraz zarządzanie nimi.

- Mapa drogowa:

W ramach tego segmentu możesz zobaczyć, do czego wszystkie są przeznaczone na przyszłość. Dzięki temu dowiesz się, jakie wszystkie funkcje będą dostępne w najbliższej przyszłości.

Jest podzielony na trzy części:

- Relacja na żywo

- W trakcie

- Zaplanowany

Możesz również głosować lub proponować niektóre funkcje. Obiecują również wprowadzać coraz więcej funkcji na swojej stronie z cenami.

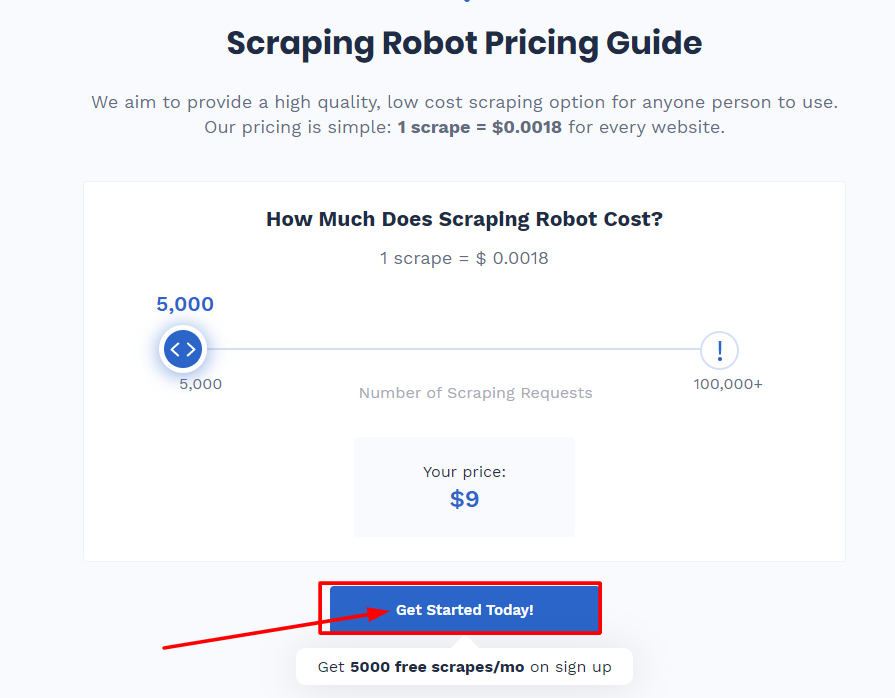

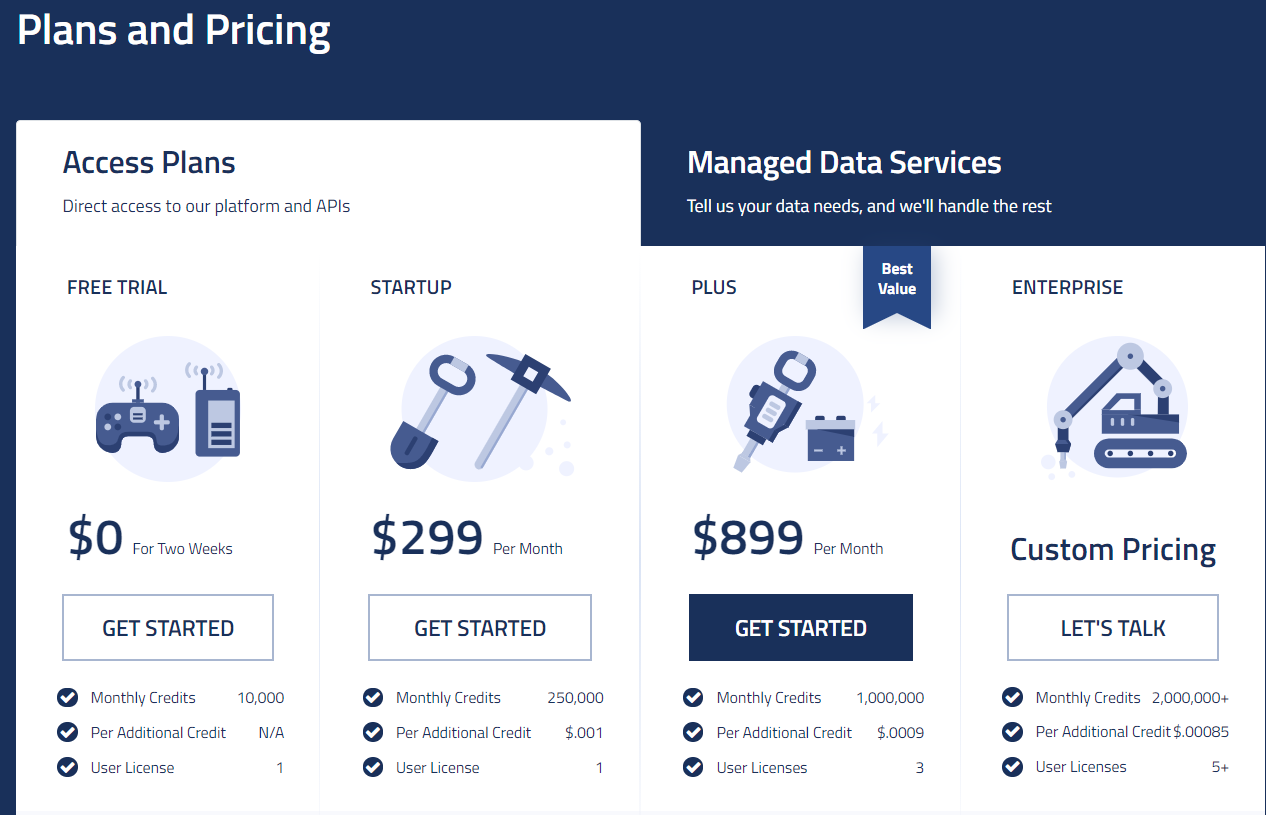

Plany i ceny

Kiedy się zarejestrujesz, będą dostarczać ci 5000 zeskrobań co miesiąc za darmo. Jest to wystarczające, jeśli danych, których szukasz, jest mniej, ale jeśli potrzebujesz więcej danych, musisz zapłacić 0,0018 USD za zeskrobanie. Według nich powodem tego jest ich współpraca z Blazing SEO, dostawcą premium proxy.

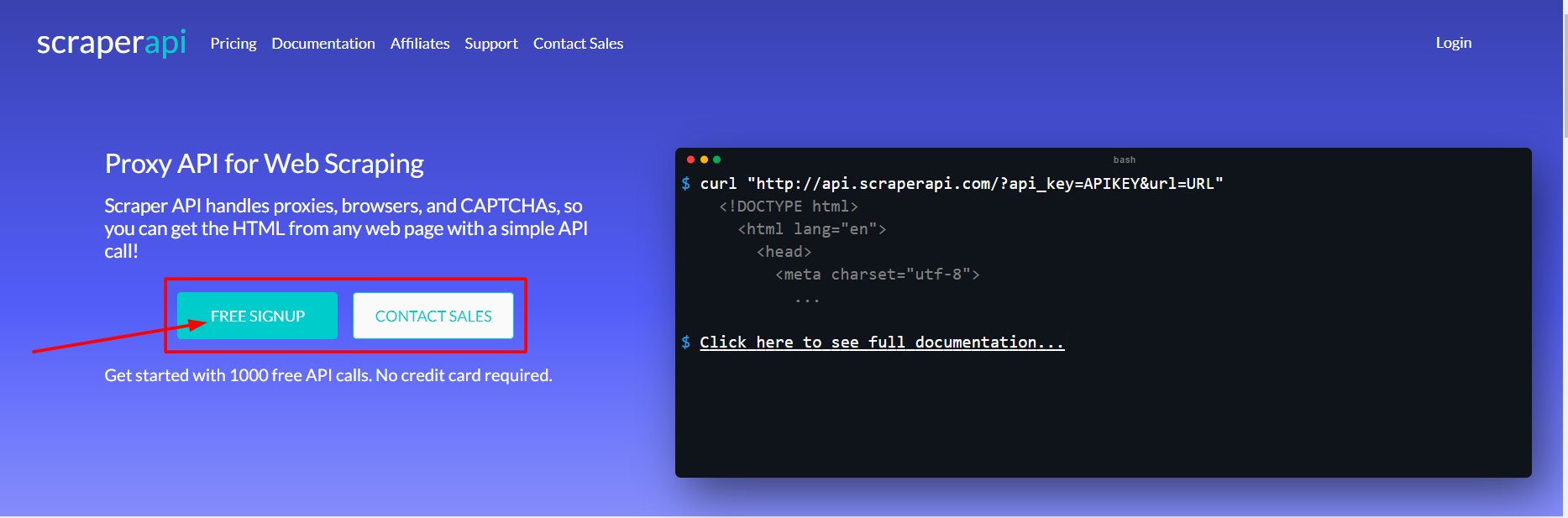

3) Scraper API #3 Najlepsze narzędzie do skrobania stron internetowych

Scraper API to program, który pozwala programistom budować skrobaki internetowe. Działa dla serwerów proxy, przeglądarek i CAPTCHA, umożliwiając programistom uzyskanie surowego kodu HTML z dowolnej witryny za pomocą prostego wywołania interfejsu API.

Jest to najlepsza platforma do skrobania stron internetowych dla programistów z dedykowanymi pulami proxy do skrobania mediów społecznościowych, skrobania biletów, skrobania wyszukiwarek, skrobania cen w handlu elektronicznym i nie tylko! l. Możesz ubiegać się o zniżkę zbiorczą, jeśli potrzebujesz dużej liczby stron miesięcznie.

Narzędzia i funkcje

- Pomaga renderować JavaScript

- Możesz dostosować nagłówki każdego żądania, a także typ żądania

- Oferuje wyjątkową szybkość i niezawodność, co pomaga w budowaniu skalowalnych skrobaków internetowych

- Geolokalizowane rotacyjne proxy

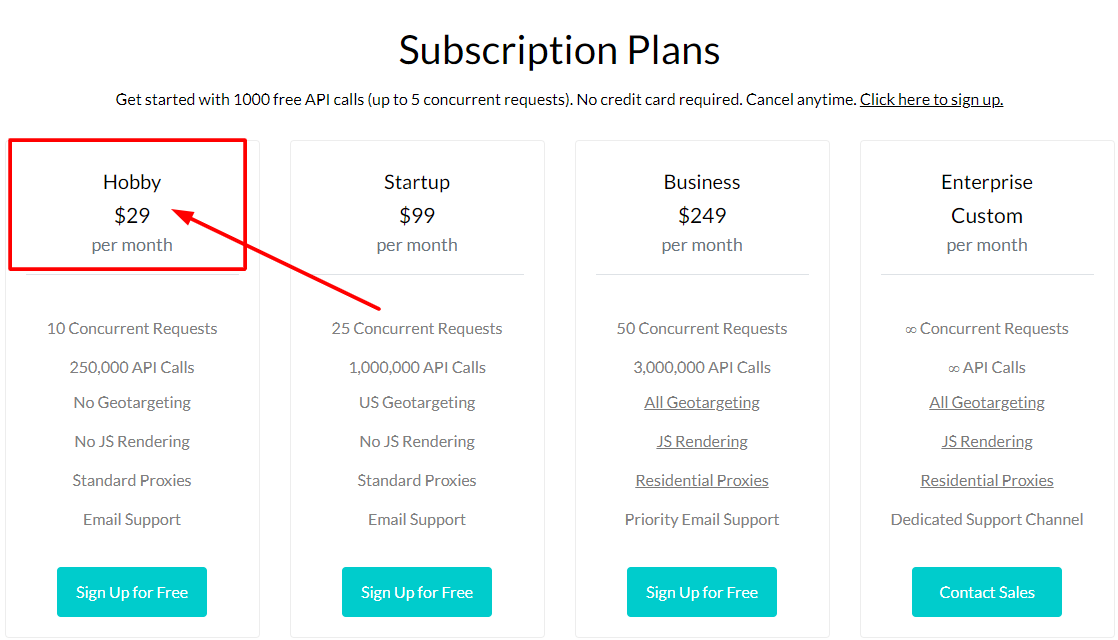

cennik

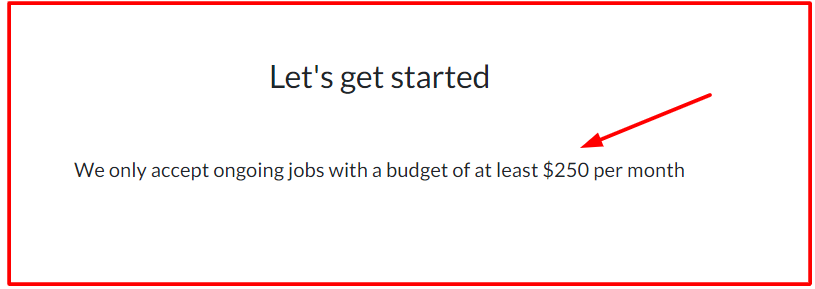

4) ZdrapanieProste

ScrapeSimple to najlepsze narzędzie do skrobania stron internetowych dla programistów poszukujących niestandardowego skrobaka zaprojektowanego od podstaw. Wyodrębnianie danych jest teraz tak proste, jak wypełnienie formularza ze wszystkimi preferencjami i instrukcjami dotyczącymi rodzaju danych, które chcesz.

ScrapeSimple pokazuje, że jest to profesjonalnie obsługiwana usługa narzędziowa, która produkuje niestandardowe skrobaki internetowe i zarządza nimi dla swoich użytkowników. Po prostu powiedz im, jakiego rodzaju dane chcesz zbierać i z której strony oraz Twój spersonalizowany web scraper zostanie skonfigurowany do wysyłania danych do Ciebie w formacie CSV regularnie (codziennie, co tydzień, co miesiąc lub kiedy tylko chcesz) do skrzynki odbiorczej.

To narzędzie jest odpowiednie dla firm, które potrzebują tylko skrobaka HTML i nie muszą ręcznie zapisywać żadnego kodu. Ich czas reakcji jest błyskawiczny, a obsługa klienta niezwykle pomocna i przyjazna.

cennik

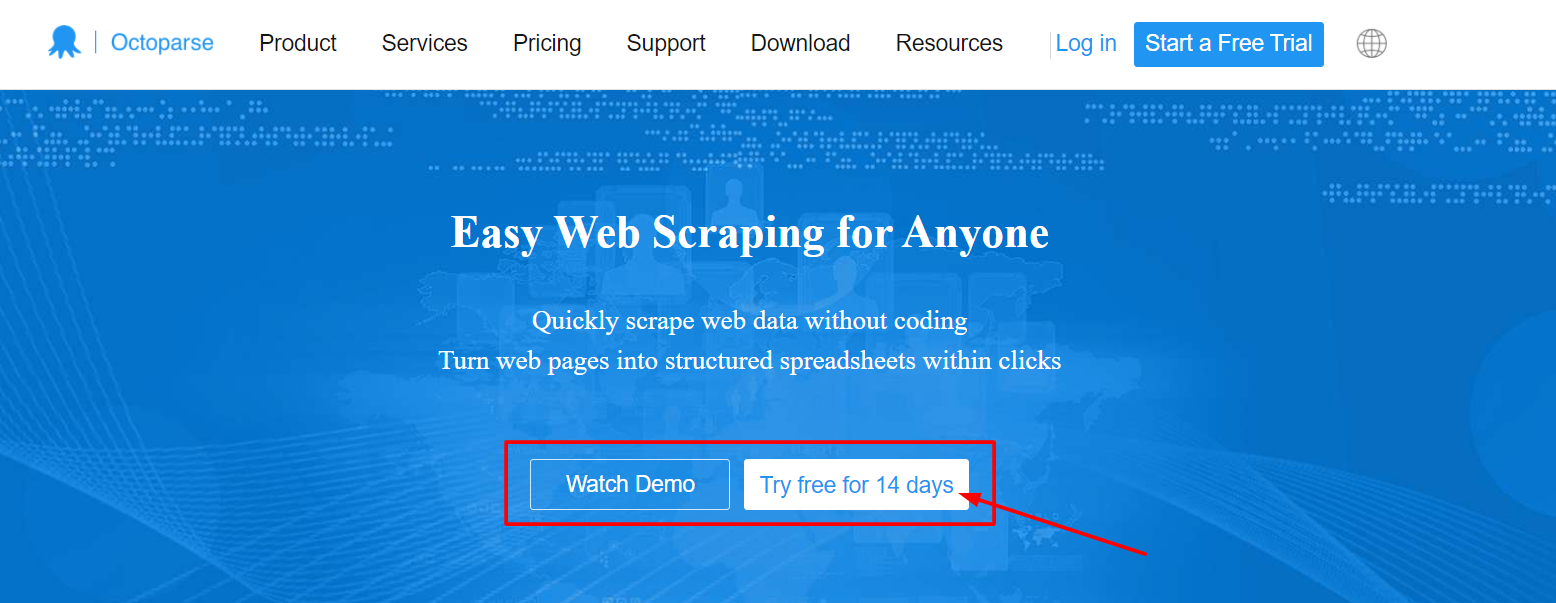

5) Ośmiornica

Octoparse to świetne i szybkie narzędzie do skrobania stron internetowych zarówno dla koderów, jak i osób nie będących programistami, którzy chcą wyodrębnić informacje ze stron internetowych bez konieczności pisania kodu, ale nadal mają całkowitą kontrolę nad procesem. Jest to bardzo powszechne w przypadku skrobania danych eCommerce.

Może być używany do pobierania danych internetowych na większą skalę (do milionów), a dane mogą być przechowywane w zorganizowanych i ustrukturyzowanych plikach, takich jak Excel i CSV, do pobrania. Klienci mogą również skorzystać z bezpłatnego abonamentu i oferty próbnej dla płatnych subskrybentów.

Popularne funkcje tego narzędzia to:

- Ekstrakcja w chmurze z rotacją adresów IP w celu ominięcia captcha i blokowania

- Posiada wbudowane narzędzie RegEx do automatycznego czyszczenia danych

- Możesz zaplanować web scraping i okresowo otrzymywać aktualizacje danych

- Wykorzystuje połączenie API do skonfigurowania potoku danych bezpośrednio do bazy danych

- Obsługuje systemy Windows i Mac

cennik

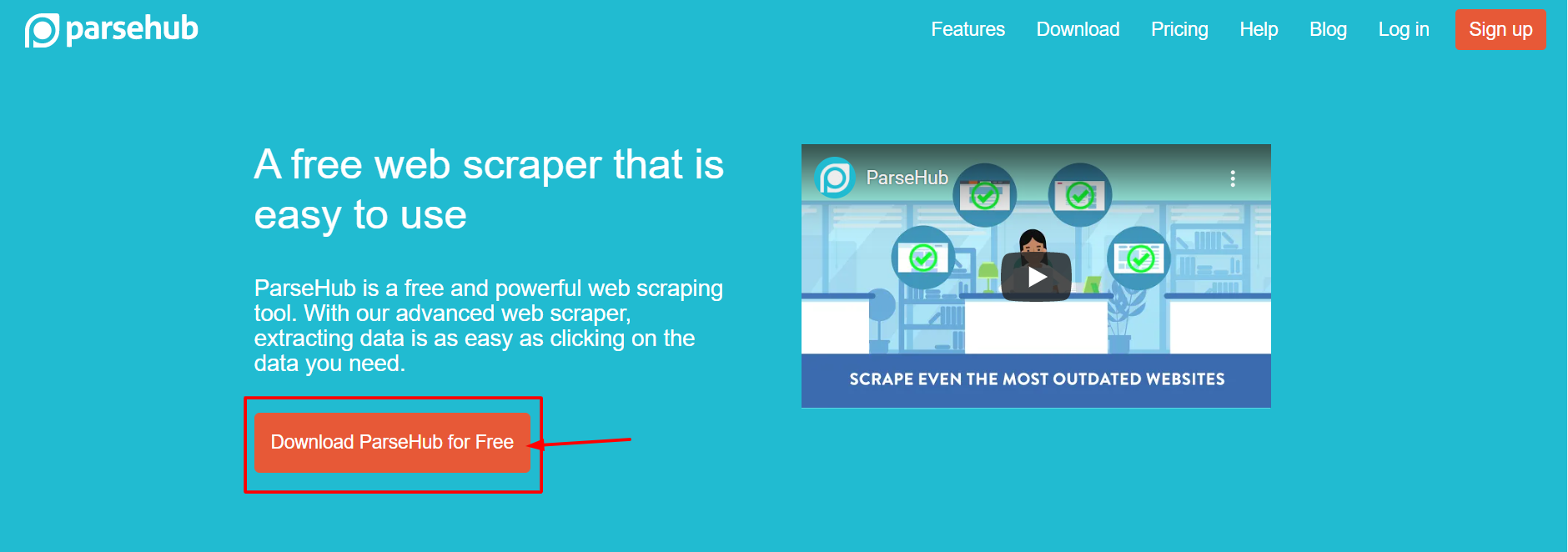

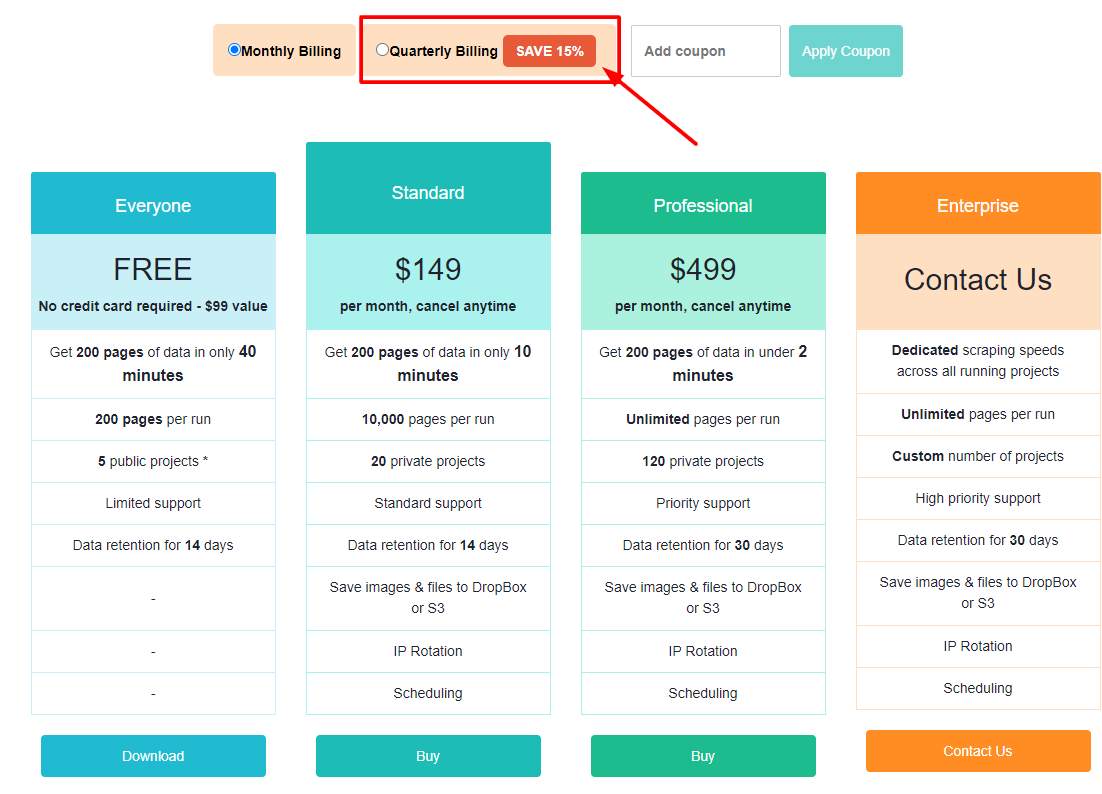

6) ParseHub

Parsehub to wspaniałe i wydajne bezpłatne narzędzie do skrobania sieci, które pozwala tworzyć skrobaki internetowe bez konieczności kodowania. Używa go wielu analityków, dziennikarzy, analityków danych i innych. Jest naprawdę łatwy w użyciu. Bardzo łatwo jest renderować skrobaki internetowe. Wystarczy kliknąć dane, które chcesz wyeksportować, a zostaną one wyeksportowane w formacie JSON lub Excel.

Użytkownicy mogą korzystać z takich funkcji, jak automatyczna rotacja adresów IP, scraping za drzwiami logowania, nawigacja po listach rozwijanych i kartach, wyodrębnianie danych z tabel i map oraz wiele innych. Co więcej, zapewnia hojny darmowy plan, który pozwala użytkownikom zeskrobać do 200 stron danych w mniej niż 40 minut! Oferuje klientów stacjonarnych dla systemów Windows, Mac OS i Linux, umożliwiając dostęp do nich z komputera niezależnie od systemu operacyjnego.

Narzędzia i funkcje

- Czyszczenie tekstu i HTML przed pobraniem danych

- Łatwy w użyciu interfejs graficzny

- Zbieraj i przechowuj informacje na serwerach automatycznie

cennik

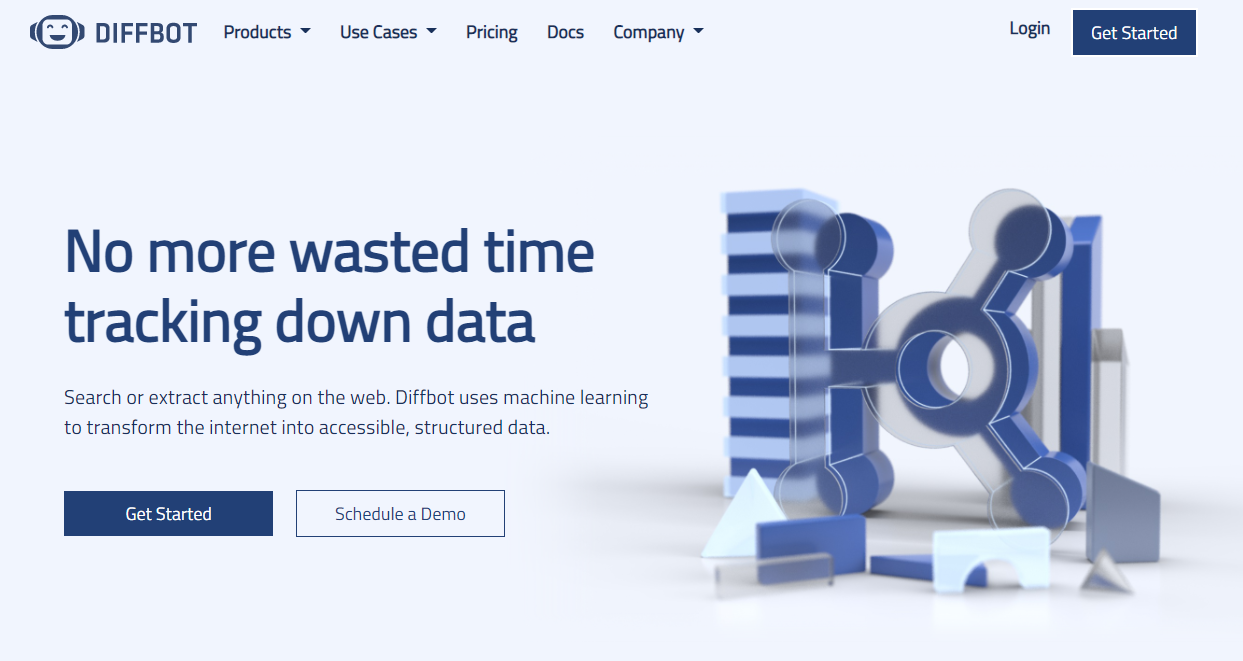

7) Diffbot

Diffbot identyfikuje przydatne dane na stronie internetowej za pomocą wizji komputerowej, a nie dekodowania HTML, co odróżnia ją od innych skrobaków internetowych dostępnych online. Oznacza to, że nawet jeśli zmieni się układ HTML strony, skrobaki internetowe będą działać tak długo, jak wygląd strony pozostanie taki sam.

Jest to doskonała funkcja dla długo działających pracowników zajmujących się skrobaniem sieci o znaczeniu krytycznym. Ekstraktory AI umożliwiają wyodrębnianie danych strukturalnych z dowolnej formy adresu URL za pomocą tego narzędzia. Chociaż jest to trochę kosztowne, dobrze sprawdza się w oferowaniu luksusowego rozwiązania, które niektórzy konsumenci uważają za wartościowe. Ich najtańszy plan kosztuje 299 USD miesięcznie.

Narzędzia i funkcje:

- Będziesz mieć dostęp do wielu źródeł danych opartych na pełnym i dokładnym zrozumieniu każdego systemu.

- Za pomocą Ekstraktorów AI można wyodrębnić ustrukturyzowane dane z dowolnego połączenia URL.

- Dzięki Grafowi wiedzy Crawlbot możesz skalować ekstrakcję danych do kilku domen.

- Ta funkcja zapewnia dokładne, kompletne i głębokie dane z sieci, których wymaga BI do tworzenia użytecznych analiz i spostrzeżeń.

cennik

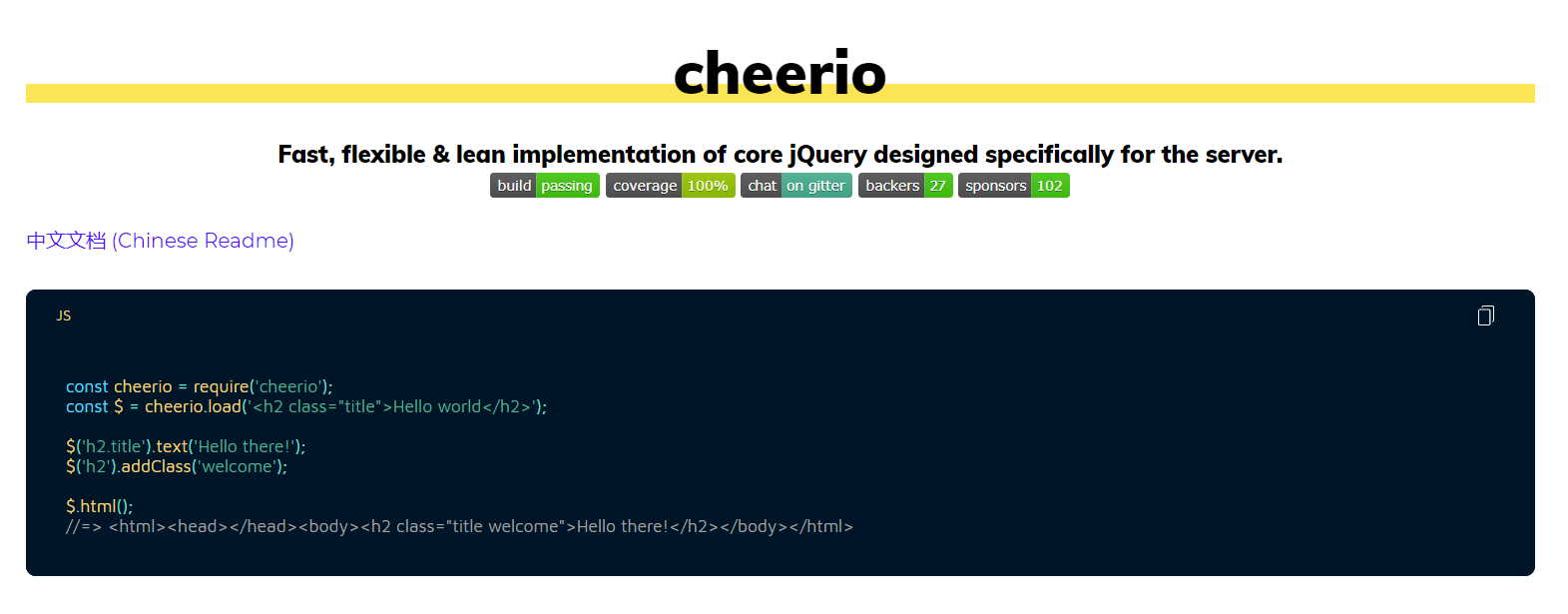

8) Cheerio

Jest przeznaczony dla programistów NodeJS, którzy chcą analizować HTML w prosty sposób. Deweloperzy, którzy są zaznajomieni z jQuery, mogą od razu zauważyć najlepszą dostępną składnię web scrapingu javascript.

Cheerio ma interfejs API, który jest bardzo podobny do jQuery, co ułatwia programistom, którzy są już zaznajomieni z jQuery, korzystanie z tego narzędzia do scrapingu internetowego do parsowania HTML. Jest szybki jak błyskawica i ma szereg przydatnych funkcji do scrapingu HTML, tekstu, identyfikatorów, klas i nie tylko. Od dawna jest najpopularniejszą biblioteką do parsowania HTML napisaną w NodeJS i jest prawdopodobnie jednym z najpopularniejszych narzędzi do przeszukiwania sieci NodeJS lub javascript dla nowych projektów.

9) Piękna Zupa

BeautifulSoup to idealne narzędzie dla programistów Pythona, którzy potrzebują prostego, łatwego w użyciu interfejsu do analizowania kodu HTML, ale nie potrzebują umiejętności ani trudności, które towarzyszą innym skrobakom internetowym.

Beautiful Soup to najpopularniejszy parser HTML dla programistów Pythona, podobnie jak Cheerio jest najlepszym narzędziem do skrobania stron internetowych dla programistów NodeJS. Minęła dekada, odkąd ta metoda została tak dobrze przyjęta i nagrana.

Dostępnych jest wiele samouczków dotyczących parsowania stron internetowych, aby nauczyć programistów, jak używać tej metody do scrapingu różnych witryn internetowych zarówno w Pythonie 2, jak i Pythonie 3. Jeśli szukasz biblioteki do parsowania HTML w języku Python, jest to zdecydowanie najlepsza opcja.

10) Mozenda

Mozenda to idealna platforma dla korporacji i firm potrzebujących samoobsługowego narzędzia do usuwania stron internetowych w chmurze. Mozenda zebrała ponad 7 miliardów stron i ma doświadczenie w obsłudze klientów z całego świata.

Jej klienci mogą używać swojej potężnej platformy w chmurze do uruchamiania skrobaków internetowych. Jedną z funkcji, która oddziela je od innych narzędzi do skrobania stron internetowych, jest obsługa klienta, która zapewnia numery telefonów i adresy e-mail dla wszystkich płacących użytkowników. Ta platforma jest wysoce rozszerzalna i podobnie jak Diffbot, jest trochę kosztowna, a najprostszy pakiet zaczyna się od 250 USD miesięcznie.

Za pomocą Mozendy możesz zeskrobać tekst, obrazy i materiały PDF ze stron internetowych. Jest znany jako jedna z najlepszych aplikacji web scrapingowych do obsługi i przygotowywania plików danych do publikacji.

Narzędzia i funkcje:

- Możesz użyć swojego ulubionego narzędzia lub bazy danych Bl do zbierania i publikowania danych internetowych.

- W ciągu zaledwie kilku minut możesz utworzyć agentów do scrapingu sieci Web za pomocą interfejsu typu „wskaż i kliknij”.

- Dołączone są funkcje Job Sequencer i Request Blocking, które pomagają w zbieraniu danych internetowych w czasie rzeczywistym.

- Pokazuje, że ma najlepsze w branży zarządzanie kontem i obsługę klienta.

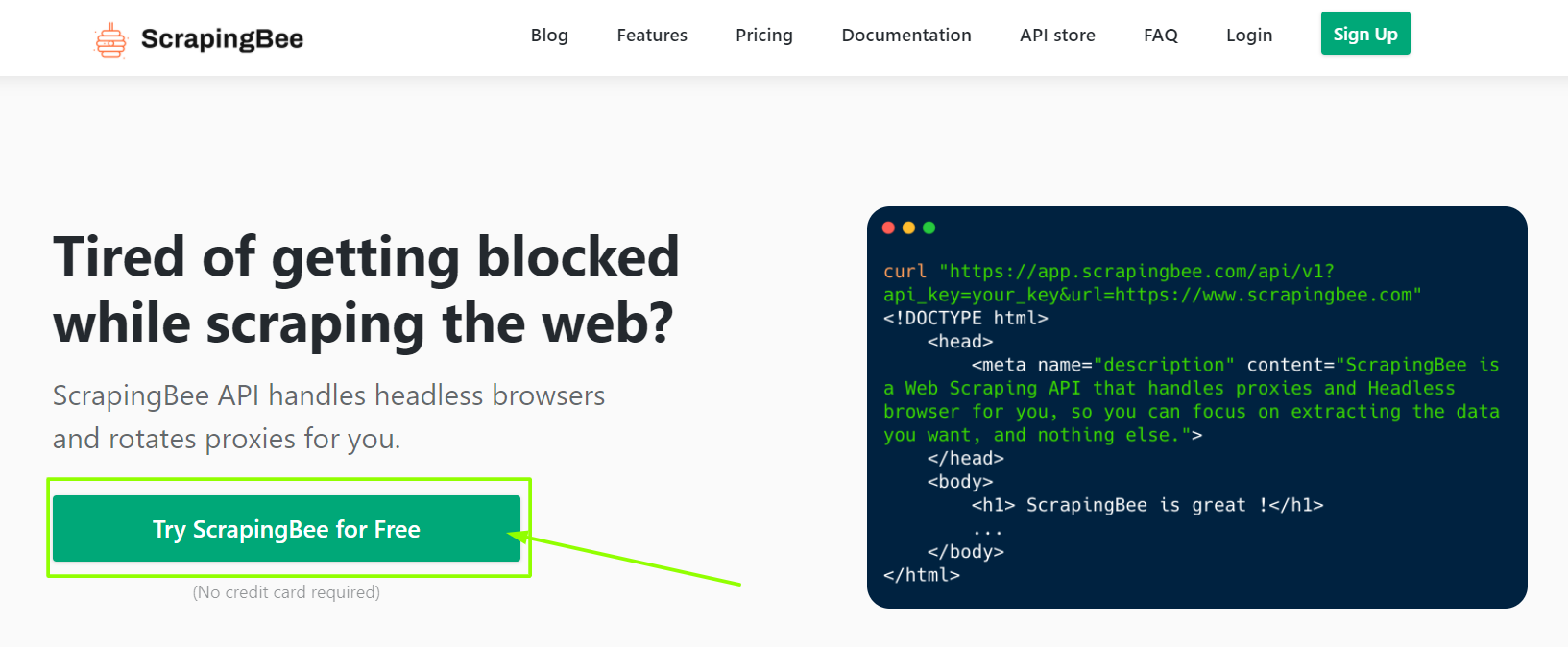

11) Skrobanie pszczół

Scraping Bee to aplikacja do skrobania stron internetowych, która działa z wieloma przeglądarkami i serwerami proxy. Może również uruchamiać Javascript na stronach internetowych i zmieniać serwery proxy dla każdego żądania, umożliwiając dostęp do surowej strony HTML bez blokowania. Mają też dedykowane API do skrobania wyników wyszukiwania Google.

Narzędzia i funkcje:

- Obsługuje renderowanie JavaScript

- Oferuje automatyczną rotację proxy.

- Możesz bezpośrednio korzystać z tej aplikacji w Arkuszu Google.

- Ta aplikacja jest obsługiwana w przeglądarce internetowej Google Chrome.

- Dobry do skrobania Amazona

- Obsługuje skrobanie w wyszukiwarce Google

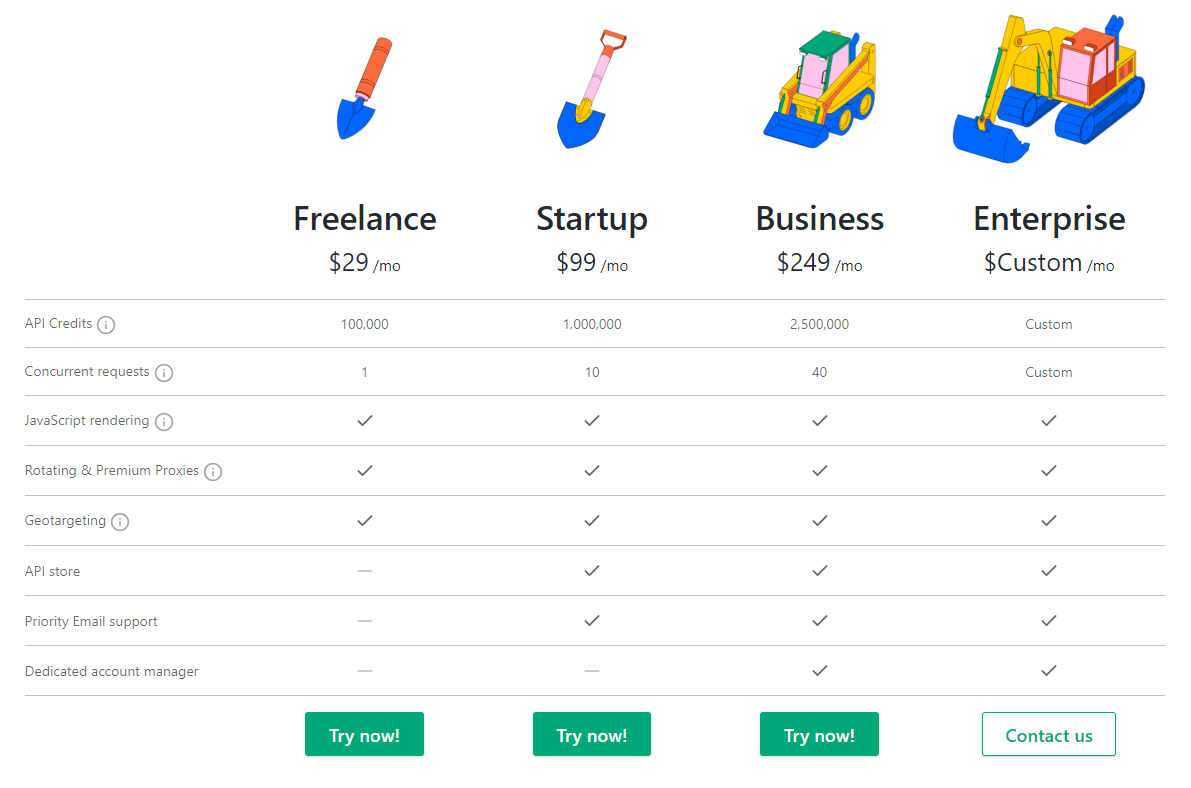

cennik

12) wyciąg.io

xtract.io to spersonalizowane narzędzie do skrobania danych, które gromadzi i porządkuje dane internetowe, dokumenty tekstowe, pliki PDF, wiadomości z mediów społecznościowych, dane historyczne, a nawet wiadomości e-mail w formacie gotowym do użytku biznesowego.

Narzędzia i funkcje

- Dzięki spersonalizowanemu narzędziu do wyodrębniania danych możesz zebrać szczegółowe dane, takie jak informacje o katalogu produktów, dane kontaktowe, dane firmy, informacje finansowe, wykazy pracy, dane dotyczące najmu, recenzje, dane o lokalizacji i oceny.

- Dzięki wydajnej strukturze interfejsu API możesz łatwo włączać ulepszone i czyste dane bezpośrednio do swoich aplikacji biznesowych.

- Dzięki wstępnie skonfigurowanym planom możesz zautomatyzować cały proces ekstrakcji danych.

- W porównaniu ze wstępnie skonfigurowanymi regułami biznesowymi z nieelastyczną spójnością danych, masz dostęp do sprawdzonych danych wysokiej jakości.

- Dane można eksportować w wielu formatach, w tym JSON, pliki tekstowe, HTML, CSV, TSV i inne.

- Unikaj problemów związanych z CAPTCHA rotacją serwerów proxy, aby bez wysiłku wyodrębniać dane w czasie rzeczywistym.

13) Skrobanie-Bot

Scraping-Bot.io to dobrze zorganizowana metoda wydobywania informacji z adresów URL. Zapewnia interfejsy API dostosowane do potrzeb związanych z wyodrębnianiem, takie jak ogólny interfejs API do pobierania nieprzetworzonego kodu HTML strony internetowej, struktura interfejsu API do scrapingu witryn internetowych oraz interfejs API do wyodrębniania wykazów nieruchomości z witryn internetowych z nieruchomościami.

Narzędzia i funkcje:

- Łatwa integracja

- Renderowanie JavaScript w przeglądarkach bezgłowych

- Przystępne plany cenowe

- Obsługuje proxy i przeglądarki internetowe

- Wysokiej jakości proxy

- Kod HTML całej strony

- Do 20 jednoczesnych żądań

- Kierowanie geograficzne

- Pozwala na szeroki zakres wymagań dotyczących zgarniania luzem

- Podstawowy abonament miesięczny za darmo

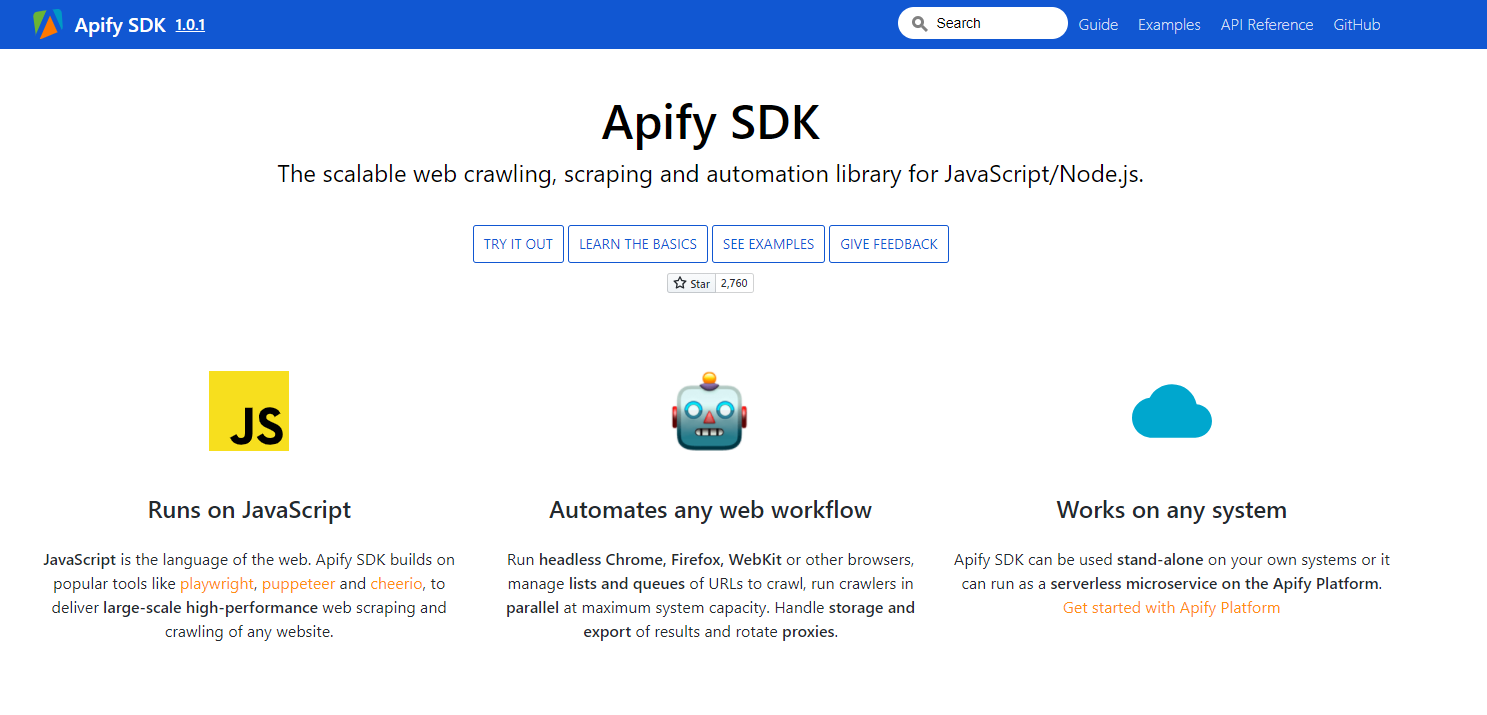

14) Apify SDK

Apify SDK to biblioteka do indeksowania, scrapingu i automatyzacji JavaScript i NodeJS. Umożliwia korzystanie z przeglądarek bezgłowych do tworzenia, automatyzacji sieci i wymiany danych.

Narzędzia i funkcje:

- Automatyzuje każdy przepływ pracy w sieci - Uruchom przeglądarki internetowe bez głowy, takie jak Google Chrome, Mozilla Firefox, WebKit lub inne przeglądarki.

- Zarządzaj listami i adresami URL oraz organizuj je w celu jednoczesnego przeszukiwania i uruchamiania przeszukiwaczy przy maksymalnej wydajności systemu.

- Zajmuj się przechowywaniem i eksportem wyników oraz rotacją serwerów proxy.

- Bezproblemowe i szybkie przeszukiwanie sieci

- Może pracować na dowolnym systemie

- Działa na JavaScript

15) Importuj.io

Import.io pomaga w tworzeniu zestawów danych, importując informacje z jednej strony i eksportując je do formatu CSV. Jest to jedno z najczęściej używanych narzędzi do skrobania stron internetowych do integracji danych z aplikacjami za pomocą frameworka API i HTTP push API.

Narzędzia i funkcje:

- Interakcje z formularzami internetowymi lub loginami są proste i proste.

- Możesz również przygotować ekstrakcję danych z wyprzedzeniem.

- Dzięki wsparciu chmury Import.io możesz przechowywać i uzyskiwać dostęp do danych.

- Zrób wizualny raport z wykresami i wykresami.

- Interakcje i projekty w Internecie są zautomatyzowane.

16) Wąż internetowy.io

Webhose.io oferuje bezpośredni dostęp do wbudowanych danych w czasie rzeczywistym do przeszukiwania tysięcy stron internetowych. Daje dostęp do autentycznych kanałów z ponad dziesięcioletnią przydatną wiedzą.

Narzędzia i funkcje:

- Zestawy danych JSON i XML, które są ustandaryzowane i nadają się do odczytu maszynowego.

- Pozwala uzyskać dostęp do szerokiej bazy danych bez konieczności ponoszenia dodatkowych opłat.

- Zaawansowany filtr pomaga w zarządzaniu szczegółowymi analizami i plikami danych, które należy zasilić.

17) Dexi Inteligentny

Dexi Intelligent to kolejna popularna aplikacja do skrobania stron internetowych, która umożliwia natychmiastowe przekształcenie dowolnej ilości danych w wartość biznesową. To narzędzie do web scrapingu pozwala obniżyć koszty i zaoszczędzić czas Twojej firmy.

Narzędzia i funkcje:

- Zwiększona jakość, dokładność i wydajność

- Najwyższa prędkość dla inteligencji danych

- Szybka i wydajna ekstrakcja danych

- Przechwytywanie wiedzy na dużą skalę

18) Przechytrzyć

Jest to dodatek do przeglądarki Firefox, który można łatwo zainstalować ze sklepu z dodatkami do przeglądarki Firefox. Aby kupić ten produkt, otrzymasz trzy różne plany alternatywne w zależności od Twoich potrzeb.

- Wersja Pro (potężne łatwe skrobanie sieci)

Roczna subskrypcja: 69,00 $

Jednorazowy zakup: 95,00 USD

- Wersja ekspercka (Scraper dla zaawansowanych użytkowników)

Roczna subskrypcja: 195,00 USD

Jednorazowy zakup: 275,00 $

- Wersja Enterprise (duży wolumen, wielu użytkowników)

Roczna subskrypcja. : 535,00 USD

Jednorazowy zakup: 745,00 $

Narzędzia i funkcje:

- Możesz użyć Email Sourcer V.9, aby uzyskać kontakty z Internetu.

- Hub Outwit nie wymaga żadnych specjalnych umiejętności programistycznych, aby wydobyć wiedzę ze stron internetowych.

- Możesz zacząć skrobać tysiące stron internetowych za pomocą jednego kliknięcia przycisku eksploracji.

cennik

19 ) Streamer danych

Narzędzie Data Streamer pomaga w gromadzeniu materiałów i informacji z mediów społecznościowych z całej sieci. Jest to jeden z najlepszych skrobaków internetowych, który wykorzystuje przetwarzanie języka naturalnego do pobierania ważnych metadanych.

Narzędzia i funkcje:

- Posiada zintegrowane wyszukiwanie pełnotekstowe obsługiwane przez Kibana i Elasticsearch

- Zintegrowane usuwanie wzorców i ekstrakcja danych w oparciu o techniki wyszukiwania informacji

- Jest zbudowany na infrastrukturze odpornej na awarie i gwarantuje wysoką dostępność danych

- Przyjazna dla użytkownika i ogólna konsola administracyjna

20) Fminer

Fminer to kolejne dobrze znane narzędzie do skrobania stron internetowych, które może być używane do ekstrakcji danych, indeksowania, skrobania ekranu, makr i obsługi sieci w systemach Windows i Mac OS.

Narzędzia i funkcje:

- Używanie prostego edytora wizualnego do budowania projektu ekstrakcji danych

- Pomaga w poruszaniu się po stronach witryny, integrując struktury linków, kolekcje rozwijane i dopasowywanie wzorców adresów URL.

- Dane mogą pochodzić z trudnych do przeszukania dynamicznych witryn Web 2.0.

- Umożliwia korzystanie z automatycznych usług decaptcha innych firm lub ręcznego wprowadzania w celu ukierunkowania na bezpieczeństwo CAPTCHA witryny.

WYRÓŻNIENIA!

Teraz, gdy skończyliśmy z 20 najlepszymi narzędziami do zgarniania stron internetowych na luty 2021 r., Oto dodatkowa lista 4 narzędzi do zgarniania stron internetowych, które naszym zdaniem wymagają wyróżnienia w tym poście. Narzędzia te zostały również uznane przez kilku użytkowników i krytyków za jedne z najlepszych narzędzi do skrobania stron internetowych, których możesz użyć.

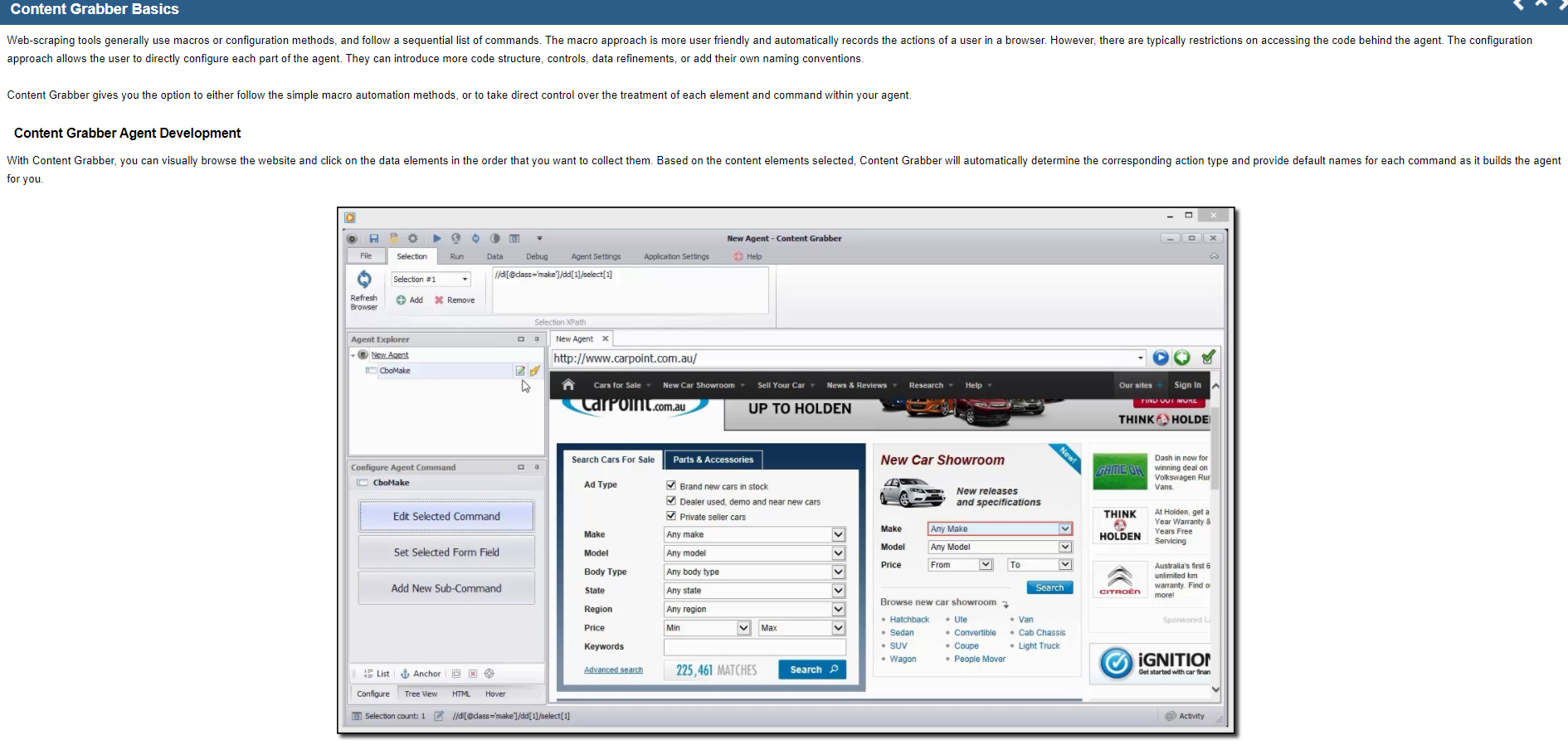

21) Pochłaniacz treści

Content grabber to solidne rozwiązanie Big Data do scrapingu danych internetowych. Pomaga skalować aranżację, ponieważ jest to jeden z najlepszych skrobaków internetowych. Platforma ta oferuje podstawowe funkcje, takie jak wizualny edytor wskaż i kliknij.

Narzędzia i funkcje:

- Wyodrębnianie danych internetowych jest szybsze niż inne narzędzia

- Pomaga tworzyć aplikacje internetowe za pomocą dedykowanego internetowego interfejsu API, który umożliwia wykonywanie danych internetowych bezpośrednio z Twojej witryny

- Pomaga poruszać się między różnymi platformami

22) Zyte (dawniej znany jako ScrapingHub)

Zyte, dawniej Scraping Hub, to oparte na chmurze narzędzie do skrobania stron internetowych, które pomaga programistom w pobieraniu niezbędnych danych. Przekształca całą stronę internetową w dobrze zorganizowaną treść. Jeśli ich konstruktor indeksowania nie spełni Twoich potrzeb, ich profesjonalny zespół jest dostępny, aby Ci pomóc. Standardowy darmowy plan pozwala na uruchomienie jednego indeksowania na raz, podczas gdy plan premium, który kosztuje 25 USD miesięcznie, pozwala na jednoczesne uruchomienie do czterech indeksowań.

Więc teraz, które z nich jest Twoim ulubionym narzędziem do skrobania stron internetowych? A jakie dane chcesz zeskrobać z Internetu? Daj nam znać w komentarzach poniżej i zasugeruj inne dobre narzędzie do skrobania stron internetowych, które Twoim zdaniem powinno znaleźć się na liście.

Dlaczego warto korzystać z narzędzi Web Scraping Tools?

Narzędzia Web Scraping mogą okazać się przydatne z nieograniczonych powodów w różnych scenariuszach –

Zbieranie informacji do badań rynkowych

Narzędzia te mogą pomóc Ci na bieżąco informować, dokąd zmierza Twoja firma w nadchodzących sześciu miesiącach, służąc tym samym jako ważne narzędzie do badań rynkowych. Narzędzia te mogą pozyskiwać dane od więcej niż jednego dostawcy analiz danych i firmy zajmującej się badaniem rynku i łączyć je w jedno miejsce w celu łatwego odniesienia i analizy.

Wyodrębnij informacje kontaktowe

Narzędzia te mogą być nawet wykorzystywane do uzyskiwania informacji, takich jak e-maile i numery kontaktowe z różnych stron internetowych, co umożliwia wymienienie dostawców, producentów i innych osób interesujących się Twoją firmą, wraz z ich numerami kontaktowymi i adresami.

Pobierz rozwiązania z StackOverflow

Za pomocą narzędzia do skrobania stron internetowych możesz również pobrać niektóre rozwiązania w celu czytania lub przechowywania w trybie offline, zbierając informacje z witryn takich jak StackOverflow i wielu innych witryn z pytaniami i odpowiedziami. Prowadzi to do zmniejszenia Twojej zależności od stabilnego połączenia internetowego, ponieważ zasoby są szybko dostępne pomimo dostępności Internetu.

Poszukaj kandydatów lub pracy

W przypadku pracowników, którzy szukają kandydatów do połączenia ze swoim zespołem lub osób poszukujących pracy, które znajdują określone stanowisko, narzędzia te doskonale sprawdzają się w łatwym pobieraniu informacji i danych na podstawie oddzielnych zastosowanych filtrów i skutecznym pobieraniu danych bez konieczności ręcznego wyszukiwania.

Śledzenie cen z wielu sklepów

Jeśli interesują Cię zakupy online i chcesz śledzić bieżące koszty produktów, których szukasz na kilku rynkach oraz stronach i sklepach internetowych, z pewnością potrzebujesz narzędzia do skrobania stron internetowych.

Szybkie linki:

- Szczegółowy przegląd dłużnika:

- Elegancki przegląd rachunku

- Przegląd NetSuite:

Najczęściej zadawane pytania (FAQ) na temat Jakie jest najlepsze narzędzie do skrobania stron internetowych?

Co oznacza „Scraping sieciowy”?

Jeśli zastanawiasz się, co to jest zbieranie danych? - Web Scraping (jednoznaczne z data scrapingiem) to procedura ekstrakcji i importu danych z określonej witryny do arkusza kalkulacyjnego. Skrobanie danych pomaga uzyskać dane lub informacje z Internetu, a następnie przenieść te dane do danych wyjściowych, które mogą być odczytane przez ludzi.

Do czego służy aplikacja Web Scraping?

Web Scraping jest bardzo przydatny do badania rynku, znajdowania potencjalnych klientów, porównywania produktów, analizy treści, porównywania cen, zbierania danych do analizy biznesowej itp.

Jakie wszystkie czynniki muszę wziąć pod uwagę przy wyborze narzędzia do pobierania danych z sieci?

Wybierając dobre narzędzie do skrobania sieci, należy wziąć pod uwagę poniższe czynniki: Powinno być łatwe w użyciu Koszt narzędzia do skrobania sieci Funkcje i cechy Wydajność i szybkość Elastyczność narzędzia zgodnie z wymaganiami Obsługiwane formaty danych Dostępność obsługi klienta

Wniosek: Narzędzia do pobierania danych z sieci w 2022 r.

Web scraping może być żmudnym i skomplikowanym procesem. Podejmując tę decyzję, należy wziąć pod uwagę wiele czynników, ale ostatecznie należy wybrać narzędzie, które najlepiej odpowiada Twoim potrzebom! Bright Data oszczędziło mi radzenia sobie z tym wszystkim, zapewniając łatwy w użyciu interfejs do pobierania danych z różnych źródeł w jednym arkuszu kalkulacyjnym – oszczędzając godziny co tydzień lub co miesiąc w razie potrzeby bez poświęcania dokładności jeszcze raz dziękuję ich niesamowitemu zespołowi obsługi klienta, jeśli cokolwiek kiedykolwiek idzie źle.