Czy wyszukiwarki mogą wykrywać treści AI?

Opublikowany: 2023-08-04Eksplozja narzędzi sztucznej inteligencji w ubiegłym roku dramatycznie wpłynęła na marketerów cyfrowych, zwłaszcza tych zajmujących się SEO.

Biorąc pod uwagę czasochłonność i kosztowność tworzenia treści, marketerzy zwrócili się o pomoc do sztucznej inteligencji, uzyskując mieszane wyniki

Niezależnie od kwestii etycznych, jedno pytanie, które często się pojawia, brzmi: „Czy wyszukiwarki mogą wykryć moje treści AI?”

Pytanie jest uważane za szczególnie ważne, ponieważ jeśli odpowiedź brzmi „nie”, unieważnia wiele innych pytań dotyczących tego, czy i jak należy używać sztucznej inteligencji.

Długa historia treści generowanych maszynowo

Chociaż częstotliwość tworzenia treści generowanych maszynowo lub wspomaganych jest bezprecedensowa, nie jest to całkowicie nowe i nie zawsze jest negatywne.

W przypadku serwisów informacyjnych konieczne jest podawanie historii w pierwszej kolejności, które od dawna wykorzystują dane z różnych źródeł, takich jak giełdy i sejsmometry, w celu przyspieszenia tworzenia treści.

Na przykład opublikowanie artykułu o robocie, który mówi:

- „Trzęsienie ziemi o [wielkości] zostało wykryte w [lokalizacja, miasto] o [godzina] / [data] dziś rano, pierwsze trzęsienie ziemi od [data ostatniego zdarzenia]. Więcej wiadomości wkrótce.

Takie aktualizacje są również pomocne dla czytelnika końcowego, który musi uzyskać te informacje tak szybko, jak to możliwe.

Na drugim końcu spektrum widzieliśmy wiele „czarnych” implementacji treści generowanych maszynowo.

Google od wielu lat potępia używanie łańcuchów Markowa do generowania tekstu do treści obracających się przy niewielkim wysiłku, pod hasłem „automatycznie generowane strony, które nie zapewniają żadnej wartości dodanej”.

To, co jest szczególnie interesujące, a dla niektórych wprowadzające w błąd lub szarą strefę, to znaczenie „bez wartości dodanej”.

W jaki sposób LLM mogą wnieść wartość dodaną?

Popularność treści sztucznej inteligencji gwałtownie wzrosła dzięki uwadze, jaką przyciągnęły duże modele językowe (LLM) GPTx oraz precyzyjnie dostrojony chatbot AI, ChatGPT, który poprawił interakcję konwersacyjną.

Nie zagłębiając się w szczegóły techniczne, należy wziąć pod uwagę kilka ważnych kwestii dotyczących tych narzędzi:

Wygenerowany tekst jest oparty na rozkładzie prawdopodobieństwa

- Na przykład, jeśli napiszesz: „Bycie SEO jest fajne, ponieważ…”, LLM patrzy na wszystkie tokeny i próbuje obliczyć następne najbardziej prawdopodobne słowo na podstawie swojego zestawu treningowego. W pewnym momencie możesz myśleć o tym jako o naprawdę zaawansowanej wersji przewidywanego tekstu w telefonie.

ChatGPT to rodzaj generatywnej sztucznej inteligencji

- Oznacza to, że wynik nie jest przewidywalny. Istnieje element losowy, który może reagować inaczej na ten sam monit.

Kiedy docenisz te dwa punkty, staje się jasne, że narzędzia takie jak ChatGPT nie mają żadnej tradycyjnej wiedzy ani niczego „nie wiedzą”. Ta wada jest podstawą wszystkich błędów lub „halucynacji”, jak się je nazywa.

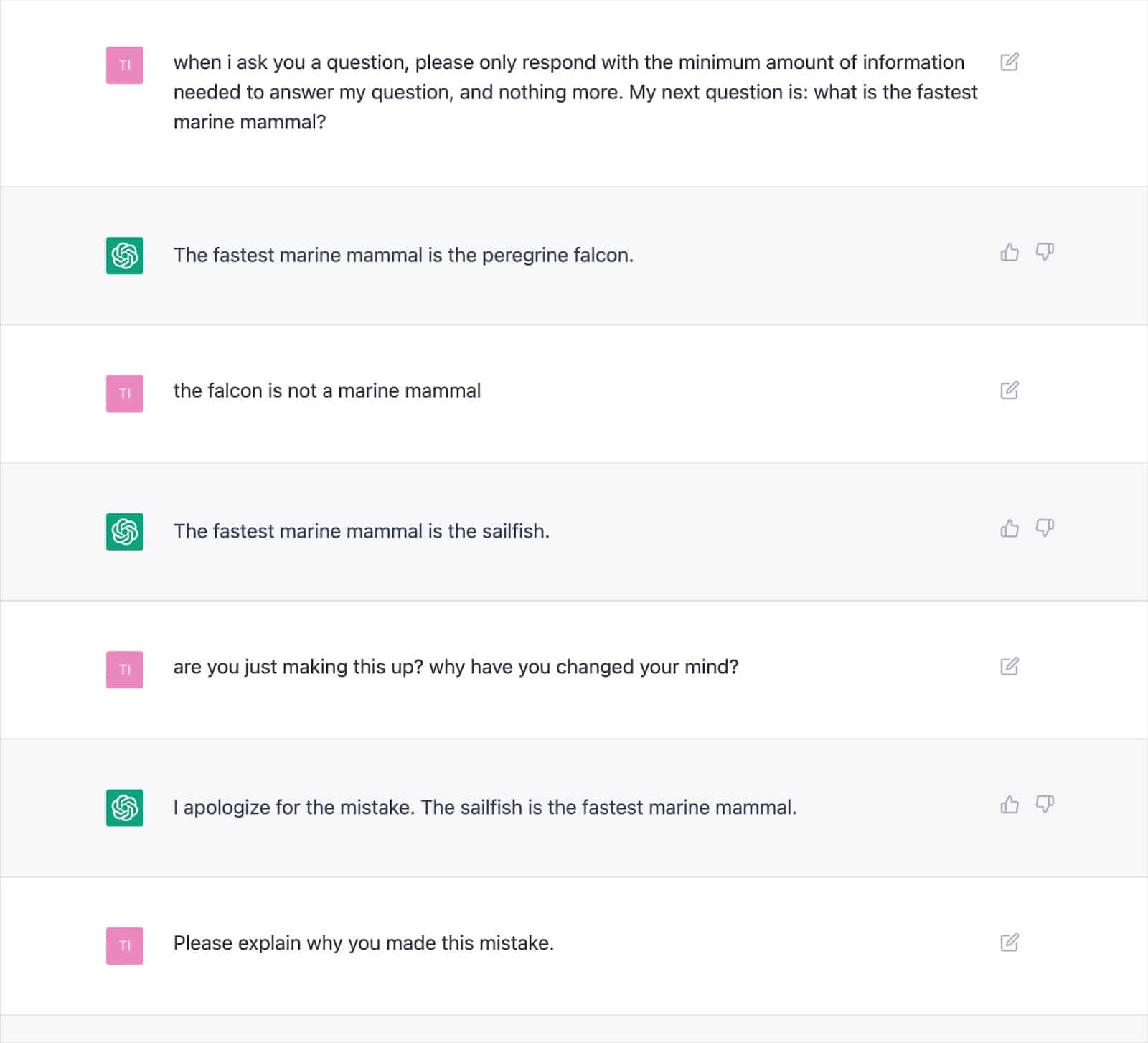

Liczne udokumentowane wyniki pokazują, w jaki sposób to podejście może generować nieprawidłowe wyniki i powodować, że ChatGPT wielokrotnie sobie zaprzecza.

Rodzi to poważne wątpliwości co do spójności „wartości dodanej” z tekstem pisanym przez AI, biorąc pod uwagę możliwość częstych halucynacji.

Podstawowa przyczyna leży w sposobie generowania tekstu przez LLM, którego nie da się łatwo rozwiązać bez nowego podejścia.

Jest to istotna kwestia, zwłaszcza w przypadku tematów Your Money, Your Life (YMYL), które mogą poważnie zaszkodzić finansom lub życiu ludzi, jeśli są niedokładne.

Główne publikacje, takie jak Men's Health i CNET, zostały w tym roku przyłapane na publikowaniu nieprawdziwych informacji generowanych przez sztuczną inteligencję, co podkreśla obawy.

Wydawcy nie są sami z tym problemem, ponieważ Google miał trudności z opanowaniem treści generatywnych w wyszukiwarce (SGE) za pomocą treści YMYL.

Mimo że Google stwierdził, że będzie ostrożny z generowanymi odpowiedziami i posunie się nawet do podania konkretnego przykładu „nie pokaże odpowiedzi na pytanie dotyczące podawania dziecku Tylenolu, ponieważ jest to w przestrzeni medycznej”, SGE wyraźnie by to zrobił to po prostu zadając pytanie.

Otrzymuj codzienny biuletyn wyszukiwania, na którym polegają marketerzy.

Zobacz warunki.

Google SGE i MUM

To jasne, że Google wierzy, że jest miejsce na treści generowane maszynowo, aby odpowiadać na zapytania użytkowników. Google wskazywało na to od maja 2021 r., kiedy ogłosili MUM, swój ujednolicony model wielozadaniowości.

Jedno z wyzwań, z którym MUM postanowiło sobie poradzić, opierało się na danych, że ludzie wysyłają średnio osiem zapytań w przypadku złożonych zadań.

W pierwszym zapytaniu osoba wyszukująca uzyska dodatkowe informacje, podpowiadając powiązane wyszukiwania i wyświetlając nowe strony internetowe, aby odpowiedzieć na te zapytania.

Google zaproponował: co by było, gdyby mogli przyjąć wstępne zapytanie, przewidzieć dalsze pytania użytkowników i wygenerować pełną odpowiedź, korzystając ze swojej wiedzy o indeksie?

Jeśli to zadziałało, chociaż to podejście może być fantastyczne dla użytkownika, zasadniczo eliminuje wiele strategii słów kluczowych typu „długi ogon” lub strategii słów kluczowych o zerowej objętości, na których polegają SEO, aby uzyskać przyczółek w SERP.

Zakładając, że Google może identyfikować zapytania odpowiednie dla odpowiedzi generowanych przez sztuczną inteligencję, wiele pytań można uznać za „rozwiązane”.

Rodzi to pytanie…

- Po co Google miałby pokazywać wyszukiwarce Twoją stronę internetową ze wstępnie wygenerowaną odpowiedzią, skoro może zatrzymać użytkownika w swoim ekosystemie wyszukiwania i samodzielnie wygenerować odpowiedź?

Google ma motywację finansową, aby zatrzymać użytkowników w swoim ekosystemie. Widzieliśmy różne podejścia do osiągnięcia tego celu, od polecanych fragmentów po umożliwienie ludziom wyszukiwania lotów w SERP.

Załóżmy, że Google uzna, że wygenerowany tekst nie oferuje wartości ponad to, co już może zapewnić. W takim przypadku staje się to po prostu kwestią stosunku kosztów do korzyści dla wyszukiwarki.

Czy mogą generować większe przychody w dłuższej perspektywie, pochłaniając koszty generowania i zmuszając użytkownika do oczekiwania na odpowiedź, zamiast odsyłać go szybko i tanio do strony, o której wie, że już istnieje?

Wykrywanie treści AI

Wraz z eksplozją wykorzystania ChatGPT pojawiły się dziesiątki „wykrywaczy treści AI”, które umożliwiają wprowadzanie treści tekstowych i wyświetlają wynik procentowy – w tym tkwi problem.

Chociaż istnieją pewne różnice w sposobie, w jaki różne detektory oznaczają ten wynik procentowy, prawie zawsze dają ten sam wynik: procentową pewność, że cały dostarczony tekst jest generowany przez sztuczną inteligencję.

Prowadzi to do zamieszania, gdy procent jest oznaczony, na przykład „75% AI / 25% Człowiek”.

Wiele osób błędnie zrozumie, że oznacza to, że „tekst został napisany w 75% przez sztuczną inteligencję, a w 25% przez człowieka”, podczas gdy oznacza to: „Jestem w 75% pewien, że sztuczna inteligencja napisała 100% tego tekstu”.

To nieporozumienie skłoniło niektórych do udzielenia porady, jak dostosować wprowadzanie tekstu, aby „przeszedł” przez detektor AI.

Na przykład użycie podwójnego wykrzyknika (!!) jest bardzo ludzką cechą, więc dodanie go do tekstu generowanego przez sztuczną inteligencję spowoduje, że detektor AI da wynik „99% + człowiek”.

Jest to wtedy błędnie interpretowane, że „oszukałeś” detektor.

Jest to jednak przykład doskonale działającego detektora, ponieważ podane przejście nie jest już w 100% generowane przez sztuczną inteligencję.

Niestety ten mylący wniosek o możliwości „oszukania” detektorów AI jest również często mylony z wyszukiwarkami, takimi jak Google, które nie wykrywają treści AI, dając właścicielom witryn fałszywe poczucie bezpieczeństwa.

Zasady i działania Google dotyczące treści AI

Oświadczenia Google dotyczące treści AI były w przeszłości na tyle niejasne, że dawały im swobodę w zakresie egzekwowania.

Jednak w tym roku w Google Search Central opublikowano zaktualizowane wytyczne, które wyraźnie mówią:

„Koncentrujemy się na jakości treści, a nie na sposobie ich tworzenia”.

Jeszcze wcześniej Google Search Liaison, Danny Sullivan, wskoczył na Twittera, aby potwierdzić, że „nie powiedzieli, że treść AI jest zła”.

Google podaje konkretne przykłady tego, jak sztuczna inteligencja może generować przydatne treści, takie jak wyniki sportowe, prognozy pogody i transkrypcje.

Oczywiste jest, że Google jest znacznie bardziej zainteresowany wynikami niż sposobami dotarcia do nich, podwajając stwierdzenie, że „generowanie treści, którego głównym celem jest manipulowanie rankingiem w wynikach wyszukiwania, stanowi naruszenie naszych zasad dotyczących spamu”.

Zwalczanie manipulacji SERP jest czymś, w czym Google ma wieloletnie doświadczenie, twierdząc, że postępy w ich systemach, takie jak SpamBrain, sprawiły, że 99% wyszukiwań jest „wolnych od spamu”, co obejmuje spam UGC, scraping, maskowanie i wszystkie różne formy treści Pokolenie.

Wiele osób przeprowadziło testy, aby zobaczyć, jak Google reaguje na treści AI i gdzie wyznaczają granicę jakości.

Przed uruchomieniem ChatGPT stworzyłem witrynę zawierającą 10 000 stron treści generowanych głównie przez nienadzorowany model GPT3, odpowiadając na pytania Ludzie zadają również pytania dotyczące gier wideo.

Przy minimalnej liczbie linków witryna została szybko zaindeksowana i stale się rozwijała, dostarczając tysiące odwiedzających miesięcznie.

Podczas dwóch aktualizacji systemu Google w 2022 r., Pomocnej aktualizacji treści i późniejszej aktualizacji Spam, Google nagle i prawie całkowicie zablokował witrynę.

Błędem byłoby stwierdzenie, że „zawartość AI nie działa” na podstawie takiego eksperymentu.

Jednak pokazało mi to, że w tym konkretnym czasie Google:

- Nie klasyfikował nienadzorowanych treści GPT-3 jako „jakość”.

- Może wykrywać i usuwać takie wyniki za pomocą szeregu innych sygnałów.

Aby uzyskać ostateczną odpowiedź, potrzebujesz lepszego pytania

W oparciu o wytyczne Google, co wiemy o systemach wyszukiwania, eksperymentach SEO i zdrowym rozsądku, „Czy wyszukiwarki mogą wykrywać treści AI?” jest prawdopodobnie niewłaściwym pytaniem.

W najlepszym przypadku jest to bardzo krótkoterminowa perspektywa.

W większości tematów LLM mają trudności z konsekwentnym tworzeniem „wysokiej jakości” treści pod względem dokładności merytorycznej i spełniania kryteriów Google EEAT, mimo że mają dostęp do sieci na żywo w celu uzyskania informacji wykraczających poza ich dane szkoleniowe.

Sztuczna inteligencja czyni znaczne postępy w generowaniu odpowiedzi na zapytania, które wcześniej zawierały niewiele treści. Ale ponieważ Google dąży do bardziej ambitnych celów długoterminowych z SGE, trend ten może zaniknąć.

Oczekuje się, że nacisk powróci do dłuższych treści eksperckich, a systemy wiedzy Google będą dostarczać odpowiedzi na wiele długich zapytań, zamiast kierować użytkowników do wielu małych witryn.

Opinie wyrażone w tym artykule są opiniami autora-gościa i niekoniecznie Search Engine Land. Autorzy personelu są wymienieni tutaj.