Jak poprawić wydajność przeszukiwania i indeksowania na poziomie przedsiębiorstwa

Opublikowany: 2023-07-13Enterprise SEO działa według innych zasad.

Strategie, które mogą działać w przypadku małych lub niszowych witryn, nie zawsze będą działać na dużą skalę.

Co dokładnie może się stać, gdy SEO dla przedsiębiorstw stanie się zbyt duże ?

W tym artykule podzielę się trzema przykładami z życia wziętymi. Następnie poznasz potencjalne antidotum na efektywniejsze zarządzanie SEO na dużą skalę.

W obliczu dylematu indeksowania

Małe witryny zwykle rozwijają się po jednej stronie na raz, używając słów kluczowych jako elementów składowych strategii SEO.

Duże witryny często przyjmują bardziej wyrafinowane podejście, w dużym stopniu opierając się na systemach, regułach i automatyzacji.

Bardzo ważne jest dostosowanie SEO do celów biznesowych. Mierzenie sukcesu SEO na podstawie rankingów słów kluczowych lub ruchu prowadzi do negatywnych konsekwencji z powodu nadmiernej indeksacji.

Nie ma magicznej formuły pozwalającej określić optymalną liczbę zindeksowanych adresów URL. Google nie ustala górnego limitu.

Dobrym punktem wyjścia jest jednak rozważenie ogólnego stanu lejka SEO. Jeśli witryna…

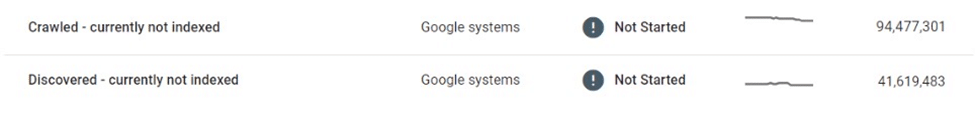

- Przekazuje dziesiątki lub setki milionów , a nawet miliardy adresów URL do Google

- Pozycje tylko dla kilku milionów słów kluczowych

- Odbiera wizyty na kilku tysiącach stron

- Konwertuje ułamek z nich (jeśli w ogóle)

… to dobra wskazówka, że musisz zająć się poważnymi potrzebami zdrowotnymi SEO.

Naprawienie wszelkich problemów z higieną witryny teraz powinno zapobiec jeszcze większym problemom z SEO w przyszłości.

Przyjrzyjmy się trzem rzeczywistym przykładom SEO dla przedsiębiorstw, które ilustrują, dlaczego jest to tak ważne.

Przypadek 1: Konsekwencje nadmiernego indeksowania treści o niskiej jakości

Google ma ograniczone zasoby do indeksowania i przetwarzania sieci. Priorytetowo traktują treści, które są wartościowe dla użytkowników.

Google może przeszukiwać, ale nie indeksować, strony, które uważa za cienkie, zduplikowane lub niskiej jakości.

Jeśli to tylko kilka stron, to nie problem. Ale jeśli jest powszechny, Google może ignorować całe typy stron lub większość treści witryny.

W jednym przypadku platforma handlu elektronicznego odkryła, że dziesiątki milionów jej stron z listami ofert zostało dotkniętych selektywnym indeksowaniem.

Po przeszukaniu milionów cienkich, prawie zduplikowanych stron z listami i nie zindeksowaniu ich, Google ostatecznie ograniczył indeksowanie całej witryny, pozostawiając wiele z nich w zawieszeniu „Odkryte – obecnie nieindeksowane”.

Ten rynek w dużym stopniu polegał na wyszukiwarkach w celu promowania nowych ofert wśród użytkowników. Nowe treści nie były już odkrywane, co stanowiło duże wyzwanie biznesowe.

Podjęto natychmiastowe działania, takie jak poprawa linkowania wewnętrznego i wdrożenie dynamicznych map witryn XML. Ostatecznie próby te spełzły na niczym.

Prawdziwe rozwiązanie wymagało kontrolowania ilości i jakości indeksowalnej zawartości.

Przypadek 2: Ustają nieprzewidziane konsekwencje raczkowania

Po zatrzymaniu indeksowania niechciane treści pozostaną w indeksie Google – nawet jeśli zostaną zmienione, przekierowane lub usunięte.

Wiele stron internetowych używa przekierowań zamiast błędów 404 dla usuniętych treści, aby zachować autorytet. Ta taktyka może wyciskać dodatkowy ruch ze stron duchów przez miesiące, jeśli nie lata.

Jednak czasami może to pójść bardzo źle.

Na przykład dobrze znana globalna platforma handlowa sprzedająca wyroby rękodzieła przypadkowo ujawniła prywatne informacje sprzedawców (np. imię i nazwisko, adres, adres e-mail, numer telefonu) na zlokalizowanych wersjach swoich stron z ofertami. Niektóre z tych stron zostały zindeksowane i zapisane w pamięci podręcznej przez Google, co spowodowało wyświetlenie w wynikach wyszukiwania informacji umożliwiających identyfikację osób, co naraziło bezpieczeństwo i prywatność użytkowników.

Ponieważ Google nie zaindeksował ponownie tych stron, ich usunięcie lub aktualizacja nie wyeliminuje ich z indeksu. Nawet miesiące po usunięciu treści przechowywane w pamięci podręcznej i dane osobowe użytkowników nadal istniały w indeksie Google.

W takiej sytuacji obowiązkiem rynku było naprawienie błędów i bezpośrednia współpraca z Google w celu usunięcia poufnych treści z wyszukiwarki.

Przypadek 3: ryzyko nadmiernego indeksowania stron wyników wyszukiwania

Niekontrolowane indeksowanie dużych ilości cienkich stron o niskiej jakości może przynieść odwrotny skutek – ale co z indeksowaniem stron wyników wyszukiwania?

Google nie popiera indeksowania wewnętrznych wyników wyszukiwania, a wielu doświadczonych specjalistów SEO zdecydowanie odradzałoby tę taktykę. Jednak wiele dużych witryn opierało się głównie na wyszukiwaniu wewnętrznym jako głównym czynniku wpływającym na SEO, co często przynosiło znaczne zyski.

Jeśli wskaźniki zaangażowania użytkowników, wrażenia ze strony i jakość treści są wystarczająco wysokie, Google może przymknąć na to oko. W rzeczywistości istnieje wystarczająco dużo dowodów, aby sugerować, że Google może nawet preferować wysokiej jakości wewnętrzną stronę wyników wyszukiwania od strony z cienkimi listami.

Jednak ta strategia może się również nie udać.

Widziałem kiedyś, jak lokalna witryna aukcyjna straciła znaczną część swoich rankingów na stronach wyszukiwania – i ponad jedną trzecią ruchu SEO – z dnia na dzień.

Zasada 20/80 ma zastosowanie, ponieważ niewielka część haseł głównych odpowiada za większość wizyt SEO w zindeksowanych wynikach wyszukiwania. Jednak często to długi ogon stanowi lwią część wolumenu adresów URL i może pochwalić się jednymi z najwyższych współczynników konwersji.

W rezultacie spośród witryn, które stosują tę taktykę, niewiele narzuca twarde ograniczenia lub reguły dotyczące indeksowania stron wyszukiwania.

Stwarza to dwa główne problemy:

- Każde zapytanie może wygenerować prawidłową stronę, co oznacza, że można wygenerować nieskończoną liczbę stron.

- Wszystkie są indeksowalne w Google.

W przypadku rynku ogłoszeń drobnych, który zarabiał na swoich stronach wyszukiwania za pomocą reklam stron trzecich, luka ta została dobrze wykorzystana w formie arbitrażu reklamowego:

- Wygenerowano ogromną liczbę adresów URL wyszukiwania podejrzanych, dorosłych i całkowicie nielegalnych terminów.

- Chociaż te automatycznie generowane strony nie zwracały rzeczywistych wyników inwentaryzacji, wyświetlały reklamy innych firm i były optymalizowane pod kątem rankingu żądanych zapytań za pomocą szablonu strony i metadanych.

- Linki zwrotne do tych stron zostały utworzone z forów o niskiej jakości, aby umożliwić ich odkrycie i indeksowanie przez boty.

- Użytkownicy, którzy trafili na te strony z Google, klikali reklamy innych firm i przechodzili do witryn o niskiej jakości, które były docelowym miejscem docelowym.

Do czasu odkrycia schematu ogólna reputacja witryny została nadszarpnięta. Został również dotknięty kilkoma karami i doznał ogromnych spadków wydajności SEO.

Wykorzystanie indeksowania zarządzanego

Jak można było uniknąć tych problemów?

Jednym z najlepszych sposobów, aby duże witryny korporacyjne dobrze prosperowały w SEO, jest skalowanie w dół za pomocą zarządzanego indeksowania.

W przypadku witryny zawierającej dziesiątki lub setki milionów stron kluczowe znaczenie ma przejście od podejścia skoncentrowanego na słowach kluczowych do podejścia opartego na danych, regułach i automatyzacji.

Indeksowanie oparte na danych

Istotną zaletą dużych witryn jest bogactwo wewnętrznych danych wyszukiwania, którymi dysponują.

Zamiast polegać na zewnętrznych narzędziach, mogą wykorzystać te dane do szczegółowego zrozumienia regionalnego i sezonowego zapotrzebowania na wyszukiwanie oraz trendów.

Dane te, po zmapowaniu do istniejącego spisu treści, mogą stanowić solidny przewodnik po tym, jakie treści należy indeksować, a także kiedy i gdzie to zrobić.

Deduplikuj i konsoliduj

Niewielka liczba autorytatywnych, wysoko ocenianych adresów URL jest o wiele bardziej wartościowa niż duża liczba stron rozproszonych w pierwszej setce.

Warto skonsolidować podobne strony za pomocą kanonicznych, wykorzystując do tego reguły i automatyzację. Niektóre strony mogą zostać skonsolidowane na podstawie wyników podobieństwa, inne – zgrupowane razem, jeśli zbiorczo uszeregowane są pod kątem podobnych zapytań.

Kluczem jest tutaj eksperymentowanie. Popraw logikę i zmień progi w miarę upływu czasu.

Wyczyść cienkie i puste strony z treścią

Występujące w ogromnych ilościach, cienkie i puste strony mogą powodować znaczne szkody dla higieny i wydajności witryny.

Jeśli ulepszenie ich o wartościową treść lub konsolidacja jest zbyt trudne, nie należy ich indeksować, a nawet zabronić.

Zmniejsz liczbę nieskończonych przestrzeni za pomocą pliku robots.txt

Piętnaście lat po tym, jak Google po raz pierwszy napisało o „nieskończonych przestrzeniach”, problem nadmiernego indeksowania filtrów, sortowania i innych kombinacji parametrów nadal nęka wiele witryn e-commerce.

W skrajnych przypadkach roboty indeksujące mogą powodować awarie serwerów, próbując przedostać się przez te łącza. Na szczęście można temu łatwo zaradzić za pomocą pliku robots.txt.

Renderowanie po stronie klienta

Rozwiązaniem może być użycie renderowania po stronie klienta dla niektórych elementów strony, których nie chcesz indeksować przez wyszukiwarki. Rozważ to dokładnie.

Co więcej, komponenty te powinny być niedostępne dla wylogowanych użytkowników.

Stawki rosną dramatycznie wraz ze wzrostem skali

Chociaż SEO jest często postrzegane jako „darmowe” źródło ruchu, jest to nieco mylące. Hostowanie i udostępnianie treści kosztuje.

Koszty na adres URL mogą być znikome, ale gdy skala osiągnie setki milionów lub miliardy stron, grosze zaczynają się sumować do liczb rzeczywistych.

Chociaż zwrot z inwestycji w SEO jest trudny do zmierzenia, zaoszczędzony grosz to grosz zarobiony, a oszczędności kosztów dzięki zarządzanemu indeksowaniu powinny być jednym z czynników przy rozważaniu strategii indeksowania dużych witryn.

Pragmatyczne podejście do SEO – z dobrze zarządzanym przeszukiwaniem i indeksowaniem, kierując się danymi, regułami i automatyzacją – może uchronić duże strony internetowe przed kosztownymi błędami.

Opinie wyrażone w tym artykule są opiniami autora-gościa i niekoniecznie Search Engine Land. Autorzy personelu są wymienieni tutaj.