Mobilne testy A/B: 7 dużych błędów i nieporozumień, których należy unikać

Opublikowany: 2021-10-23

Nie jest tajemnicą, że marketing w dużej mierze opiera się na danych. To samo dotyczy marketingu mobilnego i pozyskiwania użytkowników. W tej dziedzinie wybór odpowiednich elementów strony produktu dla App Store i Google Play może mieć decydujący wpływ na sukces aplikacji lub gry mobilnej. Mobilne testy A/B to narzędzie, które pomaga dokonać wyboru na podstawie danych.

Jednak ile razy słyszeliśmy argument, że testy A/B nie przynoszą oczekiwanych rezultatów lub że ktoś nie jest pewien, czy prawidłowo przeprowadza eksperymenty mobilne? Dzieje się tak często z powodu typowych błędów i błędnej interpretacji danych. W tym poście omówię największe błędy i mylące wnioski w testach A/B aplikacji mobilnych, których znajomość pomoże Ci osiągnąć sukces.

1. Zakończenie eksperymentu, zanim uzyskasz odpowiedni ruch

To jeden z najczęstszych błędów w mobilnych testach A/B. Jeśli jesteś zwolennikiem klasycznych testów A/B, ukończenie eksperymentu przed uzyskaniem wymaganej ilości ruchu – wielkości próbki – stwarza ryzyko, że otrzymasz statystycznie niewiarygodne wyniki .

Aby uzyskać wiarygodne dowody, musisz poczekać, aż zostanie osiągnięta wymagana ilość ruchu dla odmian A i B.

Jeśli szukasz alternatywy dla klasycznej opcji, skorzystaj z sekwencyjnych testów A/B. Trzeba będzie zacząć od określenia stawki wyjściowej konwersji (współczynnik konwersji z bieżącej zmienności), moc statystyczną (80% domyślnie), poziom istotności a minimalna wykrywalnego wpływu (MDE) - to pomoże Ci określić wielkość próby.

Poziom istotności domyślnie wynosi 5%, co oznacza, że margines błędu nie przekroczy 5%. Możesz dostosować tę wartość wraz z MDE – minimalnym oczekiwanym wzrostem współczynnika konwersji, jaki chcesz uzyskać . Uwaga: nie zmieniaj poziomu istotności, MDE ani mocy statystycznej po rozpoczęciu eksperymentu.

Dzięki sekwencyjnym testom A/B algorytm będzie stale sprawdzać Twoje odmiany na poziomie istotności i ilości ruchu pozostałego do zakończenia eksperymentu. Tak to działa na naszej platformie testowej SplitMetrics A/B.

Wyciągnięta lekcja: jeśli przeprowadzasz klasyczne testy A/B, nie kończ eksperymentu, dopóki nie zostanie osiągnięty odpowiedni ruch. Możesz też wypróbować sekwencyjne testy A/B, a w każdej chwili będziesz mógł sprawdzić wyniki.

2. Zakończenie eksperymentu przed upływem 7 dni

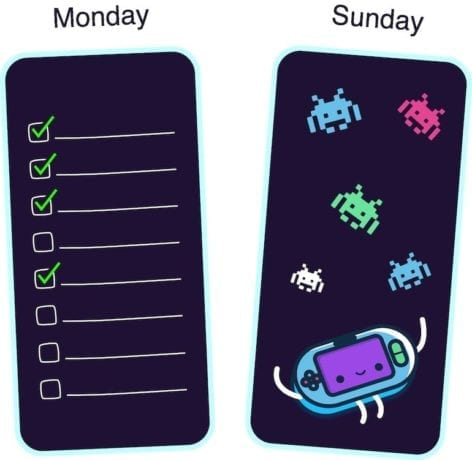

Dlaczego musisz czekać co najmniej siedem dni? Cóż, różne aplikacje i gry mobilne osiągają szczyty aktywności w różne dni tygodnia . Na przykład aplikacje biznesowe w poniedziałki wykazują dużą aktywność, podczas gdy w weekendy użytkownicy cieszą się największą popularnością wśród użytkowników.

Aby uzyskać wiarygodne wyniki z mobilnych eksperymentów testów A/B, podczas eksperymentu należy rejestrować dni szczytu swojej aplikacji. W przeciwnym razie ryzykujesz pochopne wyciąganie wniosków.

Na przykład uruchamiasz testy aplikacji do zarządzania zadaniami. Eksperyment rozpoczynasz w środę, a kończysz w sobotę. Ale większość docelowych odbiorców korzysta z Twojej aplikacji w poniedziałki, więc po prostu przegapisz ten cel, ponieważ wzrost aktywności nie pojawił się w okresie eksperymentu. Lub odwrotnie, przeprowadzasz testy A/B swojej gry wyścigowej od piątku do niedzieli: w dni szczytu gry. W tym przypadku wyniki również będą niewystarczające.

Dlatego nawet jeśli unikniesz błędu numer jeden i już pierwszego dnia uzyskałeś wymagany ruch, nie przerywaj eksperymentu przed upływem siedmiu dni.

Wyciągnięta lekcja: ze względu na słabe szczyty aktywności, które różnią się w zależności od gry lub aplikacji mobilnej, nie kończ eksperymentu przed upływem pełnego (siedmiodniowego) cyklu.

3. Testowanie zbyt małych zmian w projekcie

Jeszcze jednym częstym błędem w mobilnych testach A/B jest porównywanie odmian, które wyglądają prawie tak samo ze względu na niewielkie różnice w projekcie.

Jeśli jedyną różnicą między testowanymi ikonami aplikacji mobilnych jest niebieski kolor tła zamiast jasnoniebieskiego lub dodałeś drobny szczegół do innej odmiany zrzutu ekranu, na pewno masz kłopoty. Użytkownicy po prostu nie zauważają tak drobnych zmian.

W takim przypadku obie odmiany pokażą ten sam wynik i jest to całkowicie normalne. Więc jeśli kiedykolwiek próbowałeś przeprowadzić testy A/B sklepu z aplikacjami, ale potem z nich zrezygnowałeś, ponieważ wariacje działały jednakowo, nadszedł czas na refleksję nad tym, co poszło nie tak. Może twoje wariacje wyglądały prawie tak samo.

Aby upewnić się, że przeprowadzasz testy A/B znaczącej zmiany, pokaż obie wersje swojej rodzinie lub znajomym. Pozwól swojemu koledze przyjrzeć się każdej odmianie przez 3-5 sekund. Jeśli nie znają różnicy, lepiej przeprojektuj swoje zasoby wizualne.

Wyciągnięta lekcja: jeśli testujesz odmiany ze zbyt małymi zmianami w projekcie, powinieneś oczekiwać, że przyniosą ten sam wynik. Takie zmiany są zbyt nieistotne dla użytkowników, dlatego lepiej przetestować ikony aplikacji i zrzuty ekranu, które znacznie się od siebie różnią.

4. Twoje banery reklamowe mają taki sam wygląd jak jeden z zasobów wizualnych sklepu z aplikacjami

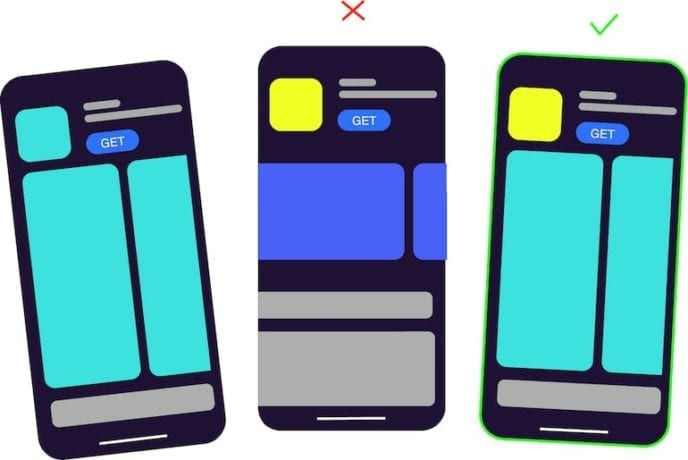

Jeśli korzystasz z narzędzia do testowania mobilnego A/B innej firmy, takiego jak na przykład SplitMetrics, kupujesz ruch i umieszczasz banery w sieciach reklamowych. Chodzi o to, aby taki baner nie wyglądał jak jeden z testowanych zasobów wizualnych , niezależnie od tego, czy jest to zrzut ekranu, czy te same elementy na ikonie.

Na przykład przeprowadzasz eksperymenty w swojej aplikacji edukacyjnej. Projektujesz baner, który ma ten sam element, co ikona z wariantu A, podczas gdy wariant B jest zupełnie inną ikoną. Wariant A pokaże wyższy współczynnik konwersji, ponieważ ma taki sam wygląd, jaki początkowo widzieli i klikali użytkownicy banera.

Badania pokazują, że jeśli ludzie widzą coś wielokrotnie, ich mózg szybciej przetwarza informacje, co daje im poczucie lubienia. Więcej na ten temat przeczytasz tutaj. Tak więc użytkownicy mają tendencję do nieświadomego dotykania już znanych obrazów.

Wyciągnięta lekcja: pracując nad banerami reklamowymi, staraj się, aby projekt był jak najbardziej neutralny. Projekt banera nie powinien pokrywać się z projektem wariantów ikon aplikacji ani zrzutów ekranu.

5. Testowanie kilku hipotez jednocześnie

Wprowadzanie wielu zmian i testowanie ich w ramach tego samego eksperymentu nie ma sensu. Niektórzy marketerzy mobilni wyciągają błędne wnioski po przeprowadzeniu testu, ponieważ dokonali kilku zmian i tak naprawdę nie mogą wiedzieć, co dokładnie wpłynęło na wynik.

Jeśli zdecydowałeś się zmienić kolor zrzutów ekranu ze stron produktów w sklepie z aplikacjami, utwórz jedną lub kilka odmian z innym kolorem tła i przeprowadź test. Nie zmieniaj jednocześnie koloru, kolejności i tekstu na zrzutach ekranu. W przeciwnym razie zobaczysz zwycięską odmianę (niech będzie to odmiana B) i nie będziesz miał pojęcia, czy rzeczywiście zadziałała zmiana koloru.

Wyciągnięta lekcja: jeśli przetestujesz wiele hipotez jednocześnie, nie będziesz w stanie zrozumieć, która z nich jest poprawna.

6. Błędna interpretacja sytuacji, w której dwie odmiany są takie same, ale otrzymujesz zwycięzcę

Podczas przeprowadzania testów A/A możesz być zdezorientowany, gdy narzędzie do testowania A/B pokazuje zwycięską odmianę między dwoma identycznymi zasobami. W szczególności jest to typowe dla wbudowanego narzędzia Sklepu Google Play do przeprowadzania eksperymentów.

Na platformie SplitMetrics, przy 5% poziomie istotności, w takim przypadku zobaczysz, że wynik jest nieistotny.

Małe różnice między dwoma dokładnie takimi samymi odmianami są czystym zbiegiem okoliczności. Różni użytkownicy reagowali nieco inaczej. To tak jak rzucanie monetą: istnieje 50-50 szansa, że dostaniesz orła lub reszka, a 50-50 szansa, że jedna z odmian pokaże lepszy wynik.

Aby w takiej sytuacji uzyskać statystycznie istotny wynik, należy uzyskać wyniki od absolutnie wszystkich użytkowników, co jest niemożliwe.

Wyciągnięte wnioski: jeśli uzyskasz zwycięską odmianę podczas testowania identycznych zasobów, nie ma nic złego w twoim narzędziu do testowania A/B, to tylko zbieg okoliczności. Jednak dzięki sekwencyjnym testom A/B zobaczysz, że wynik jest nieistotny.

7. Zdenerwowanie się, gdy nowa odmiana przegrywa z obecną

Niektórzy marketerzy mobilni i menedżerowie pozyskiwania użytkowników są rozczarowani, gdy eksperyment pokazuje, że aktualna odmiana wygrywa, czego się nie spodziewali, i zaczynają marnować budżet na bardziej płatny ruch w nadziei, że nowa odmiana w końcu wygra.

Nie ma powodu, aby czuć się źle, jeśli twoja hipoteza nie została potwierdzona. Gdybyś zmienił coś na stronie produktu w sklepie z aplikacjami bez testowania, straciłbyś część potencjalnych klientów, a co za tym idzie, pieniądze. Jednocześnie, wydając pieniądze na ten eksperyment, zapłaciłeś za wiedzę . Teraz wiesz, co działa w Twojej aplikacji, a co nie.

Wyciągnięta lekcja: wszystko dzieje się z jakiegoś powodu i nie powinieneś żałować, jeśli Twój test A/B nie potwierdził Twojej hipotezy. Masz teraz jasną wizję tego, jakie zasoby najlepiej sprawdzają się w Twojej grze lub aplikacji.