Wikipedia Web Scraping 2023: Wyodrębnianie danych do analizy

Opublikowany: 2023-03-29Skrobanie online umożliwia gromadzenie otwartych danych ze stron internetowych do celów takich jak porównywanie cen, badanie rynku, weryfikacja reklam itp.

Zwykle wyodrębniane są duże ilości niezbędnych danych publicznych, ale w przypadku napotkania blokad wydobycie może stać się trudne.

Ograniczeniem może być blokowanie szybkości lub blokowanie adresów IP (adres IP żądania jest ograniczony, ponieważ pochodzi z zabronionego obszaru, zabronionego typu adresu IP itp.). (adres IP jest zablokowany, ponieważ wykonał wiele żądań).

Teraz, jeśli chcesz zeskrobać przydatną wiedzę i informacje, to jestem pewien, że musiałeś rozważyć zeskrobanie Wikipedii, encyklopedii wiedzy, która zawiera mnóstwo informacji.

Przyjrzyjmy się kilku rzeczom dotyczącym skrobania Wikipedii.

Spis treści

Skrobanie sieci Wikipedii

Web scraping to zautomatyzowana metoda zbierania danych z Internetu. W tym artykule przedstawiono szczegółowe informacje na temat web scrapingu, porównanie do web crawlingu oraz argumenty przemawiające za web scrapingiem.

Celem jest zebranie danych ze strony głównej Wikipedii przy użyciu różnych metod zbierania danych z sieci, a następnie ich przeanalizowanie.

Zapoznasz się z różnymi metodami zbierania danych, bibliotekami Pythona oraz procedurami ekstrakcji i przetwarzania danych.

Skrobanie sieci i Python

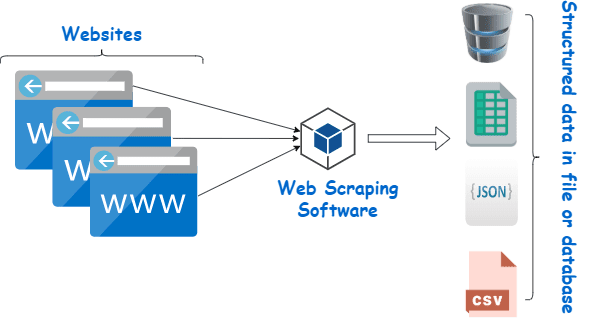

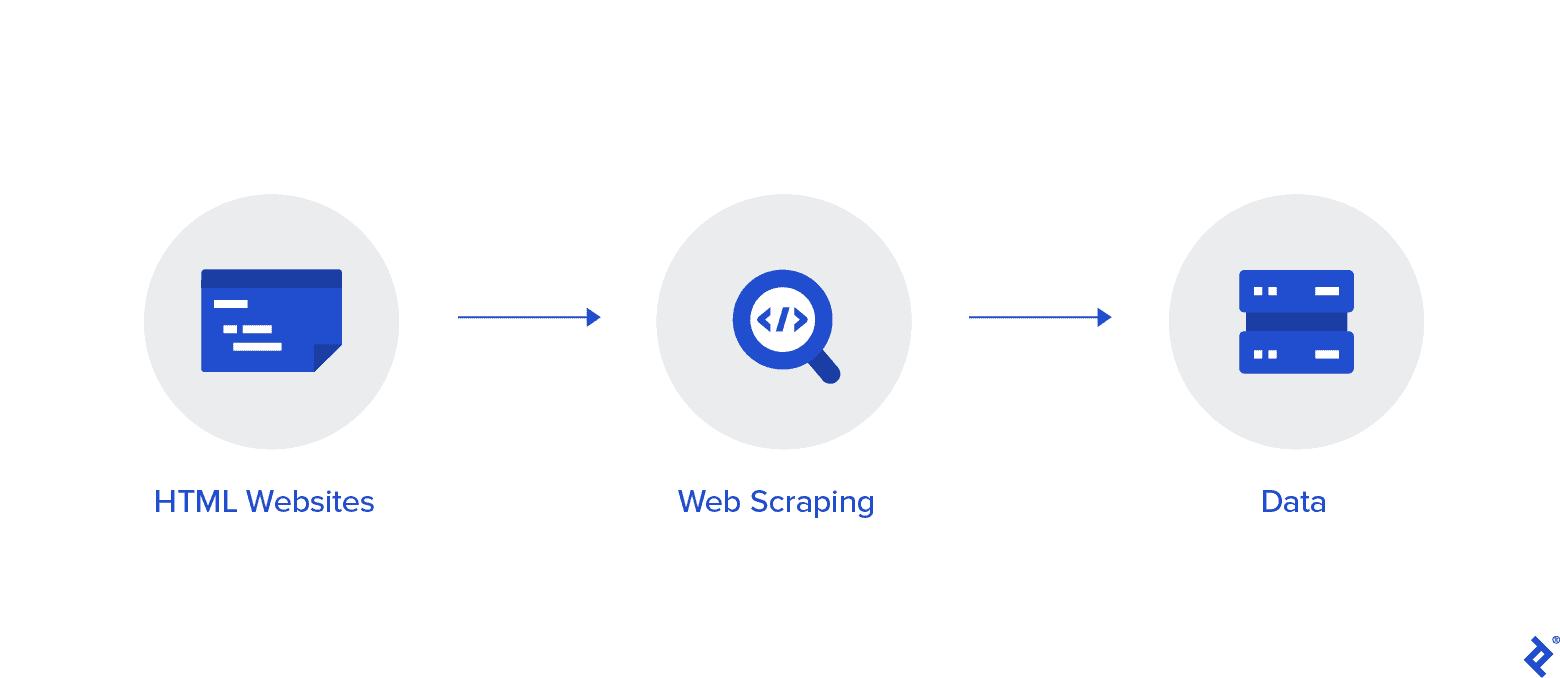

Web scraping to zasadniczo proces wydobywania ustrukturyzowanych danych z dużej ilości danych z dużej liczby stron internetowych za pomocą oprogramowania utworzonego w języku programowania i zapisywania ich lokalnie na naszych urządzeniach, najlepiej w arkuszach Excel, JSON lub arkuszach kalkulacyjnych.

Pomaga to programistom w tworzeniu logicznego, zrozumiałego kodu zarówno dla małych, jak i dużych projektów.

Python jest przede wszystkim uważany za najlepszy język do skrobania stron internetowych. Może skutecznie obsłużyć większość zadań związanych z indeksowaniem sieci i jest bardziej wszechstronny.

Jak zeskrobać dane z Wikipedii?

Dane można wydobywać ze stron internetowych na różne sposoby.

Na przykład możesz zaimplementować go samodzielnie, używając języków komputerowych, takich jak Python. Ale jeśli nie jesteś obeznany z technologią, będziesz musiał dużo się uczyć, zanim będziesz mógł wiele zrobić z tym procesem.

Jest to również czasochłonne i może trwać tak długo, jak ręczne przeszukiwanie stron Wikipedii. Co więcej, darmowe web scrapery są dostępne online. Jednak często brakuje im niezawodności, a ich dostawcy mogą mieć niejasne zamiary.

Inwestycja w przyzwoity web scraper od renomowanego dostawcy to najlepsza metoda zbierania danych Wiki.

Następny krok jest zwykle prosty i nieskomplikowany, ponieważ dostawca zaoferuje instrukcje dotyczące instalacji i użytkowania skrobaka.

Serwer proxy to narzędzie, którego można używać w połączeniu ze skrobakiem wiki, aby skuteczniej usuwać dane. Frameworki oparte na Pythonie, takie jak Scrapy, Scraping Robot i Beautiful Soup, to tylko kilka przykładów tego, jak łatwo jest scrapować za pomocą tego języka.

Proxy do Scrape danych z Wikipedii

Potrzebujesz serwerów proxy, które są niezwykle szybkie, bezpieczne w użyciu i gwarantują, że nie spadną na ciebie, gdy ich potrzebujesz, aby skutecznie zeskrobać dane. Takie serwery proxy są dostępne w Rayobyte w rozsądnej cenie.

Staramy się oferować różnorodne serwery proxy, ponieważ jesteśmy świadomi, że każdy użytkownik ma inne preferencje i przypadki użycia.

Rotacyjne serwery proxy do skrobania stron internetowych Wikipedii

Instancja serwera proxy to taka, która regularnie zmienia swój adres IP. Ponadto, aby zapobiec zakłóceniom, adres IP jest natychmiast zmieniany po nałożeniu blokady. To sprawia, że ten konkretny serwer proxy jest doskonałym wyborem do skrobania witryn.

Dla porównania, statyczne serwery proxy mają tylko jeden adres IP. Jeśli Twój dostawca usług internetowych nie umożliwia automatycznej wymiany, napotkasz mur z cegieł, jeśli masz dostęp tylko do jednego adresu IP i zostanie on zablokowany. Z tego powodu statyczne serwery proxy nie są najlepszą opcją do skrobania sieci.

Mieszkaniowe serwery proxy do zbierania danych Wiki z sieci

Mieszkaniowe serwery proxy to adresy IP serwerów proxy, które są dystrybuowane przez dostawców usług internetowych (ISP) i są powiązane z określonymi gospodarstwami domowymi. Ponieważ pochodzą od prawdziwych ludzi, zdobycie ich jest dość trudne. W rezultacie są one rzadkie i stosunkowo drogie.

Kiedy używasz domowych serwerów proxy do zbierania danych, wydajesz się być zwykłym użytkownikiem, ponieważ są one powiązane z adresami prawdziwych osób.

Tak więc korzystanie z domowych serwerów proxy znacznie zmniejsza szansę na wykrycie i zablokowanie. Są zatem doskonałymi kandydatami do zbierania danych.

Rotacyjne domowe serwery proxy do zbierania danych wiki

Obrotowy domowy serwer proxy, który łączy dwa typy, o których właśnie mówiliśmy, jest najlepszym serwerem proxy do skrobania Wikipedii.

Możesz uzyskać dostęp do dużej liczby domowych adresów IP za pomocą serwera proxy, który często je zmienia.

Ma to kluczowe znaczenie, ponieważ pomimo trudności w identyfikacji domowych serwerów proxy, liczba generowanych przez nich żądań ostatecznie zwróci uwagę strony internetowej, która jest przeglądana.

Rotacja zapewnia, że projekt może być kontynuowany, nawet jeśli adres IP nieuchronnie trafi na czarną listę.

Dlatego mamy to, czego potrzebujesz, niezależnie od tego, czy zdecydujesz się na kilka serwerów proxy do centrów danych, czy wolisz zainwestować w kilka serwerów proxy do użytku domowego.

Będziesz cieszyć się najlepszymi wrażeniami z przeglądania sieci dzięki serwerom proxy działającym z prędkością 1 GBS, nieograniczonej przepustowości i całodobowej obsłudze klienta.

Możesz też przeczytać

- Najlepsze techniki skrobania stron internetowych: praktyczny przewodnik

- Recenzja Octoparse Czy to naprawdę dobre narzędzie do skrobania stron internetowych?

- Najlepsze narzędzia do skrobania stron internetowych

- Co to jest skrobanie stron internetowych? — Jak jest używane? Jak może przynieść korzyści Twojej firmie

Dlaczego warto zeskrobać Wikipedię?

Wikipedia jest obecnie jedną z najbardziej zaufanych i bogatych w informacje usług w świecie online. Na tej platformie znajdziesz odpowiedzi i informacje na prawie wszystkie tematy, które możesz wymyślić.

Tak więc, naturalnie, Wikipedia jest doskonałym źródłem do zbierania danych. Omówmy główne powody, dla których warto zeskrobać Wikipedię.

Skrobanie sieci do badań akademickich

Zbieranie danych jest jedną z najbardziej bolesnych czynności związanych z badaniami. Jak już omówiono, skrobaki internetowe przyspieszają i ułatwiają tę procedurę, jednocześnie oszczędzając mnóstwo czasu i energii.

Za pomocą narzędzia do skrobania stron internetowych możesz szybko przeskanować wiele stron wiki i zebrać wszystkie potrzebne dane w uporządkowany sposób.

Załóżmy na chwilę, że Twoim celem jest ustalenie, czy depresja i ekspozycja na światło słoneczne różnią się w zależności od kraju.

Możesz użyć skrobaka Wiki, aby zlokalizować informacje, takie jak występowanie depresji w różnych krajach i ich słoneczne godziny, zamiast przeglądać liczne wpisy w Wikipedii.

Zarządzanie reputacją

Tworzenie strony w Wikipedii stało się w dzisiejszych czasach obowiązkową strategią marketingową dla wielu różnych typów firm, ponieważ posty w Wikipedii często pojawiają się na pierwszej stronie Google.

Jednak posiadanie strony w Wikipedii nie powinno oznaczać końca działań marketingowych. Wikipedia jest platformą crowdsourcingową, więc wandalizm zdarza się dość często.

W rezultacie ktoś mógłby dodać niekorzystne informacje na stronę Twojej firmy i zaszkodzić Twojej reputacji. Ewentualnie mogą zniesławić Twoją firmę w odpowiednim artykule na wiki.

Z tego powodu musisz mieć oko na swoją stronę Wiki, a także inne strony, które wspominają o Twojej firmie po jej utworzeniu. Możesz to zrobić z łatwością za pomocą skrobaka wiki.

Możesz okresowo przeszukiwać strony Wikipedii w poszukiwaniu odniesień do swojej firmy i wskazywać tam wszelkie przypadki wandalizmu.

Zwiększ SEO

Możesz skorzystać z Wikipedii, aby zwiększyć ruch na swojej stronie.

Utwórz listę artykułów, które chcesz zmienić, korzystając ze skrobaka danych Wiki, aby zlokalizować strony, które są istotne dla Twojej firmy i docelowych odbiorców.

Zacznij od przeczytania artykułów i wprowadzenia kilku przydatnych poprawek, aby zyskać wiarygodność jako współtwórca witryny.

Po ustaleniu pewnej wiarygodności możesz dodać połączenia do swojej witryny w miejscach, w których znajdują się niedziałające linki lub gdzie wymagane są cytaty.

Szybkie linki

- Najlepsze francuskie proxy

- Najlepsze najlepsze proxy Spotify

- Najlepsze proxy Nike

Biblioteki Pythona używane do skrobania stron internetowych

Jak już powiedziano, Python jest najpopularniejszym i najbardziej renomowanym językiem programowania i narzędziem do skrobania stron internetowych na świecie. Przyjrzyjmy się teraz dostępnym w tej chwili bibliotekom Web Scraping w języku Python.

Żądania (HTTP dla ludzi) Biblioteka do skrobania stron internetowych

Służy do wysyłania różnych żądań HTTP, takich jak GET i POST. Spośród wszystkich bibliotek jest to najbardziej podstawowa, ale i najważniejsza.

Biblioteka lxml do skrobania stron internetowych

Bardzo szybkie i wydajne parsowanie tekstu HTML i XML ze stron internetowych oferuje pakiet lxml. To jest ten do wyboru, jeśli zamierzasz zeskrobać ogromne bazy danych.

Piękna biblioteka zup do skrobania stron internetowych

Jego praca polega na budowaniu drzewa analizy do analizowania treści. Świetne miejsce do rozpoczęcia dla początkujących i jest bardzo przyjazne dla użytkownika.

Biblioteka Selenium do skrobania stron internetowych

Ta biblioteka rozwiązuje problem, który mają wszystkie wyżej wymienione biblioteki, a mianowicie zgarnianie treści z dynamicznie wypełnianych stron internetowych.

Pierwotnie został zaprojektowany do automatycznego testowania aplikacji internetowych. Z tego powodu jest wolniejszy i nie nadaje się do zadań na poziomie przemysłowym.

Scrapy do skrobania stron internetowych

Kompletny framework do skrobania stron internetowych, który wykorzystuje użycie asynchroniczne, jest BOSSem wszystkich pakietów. Zwiększa to wydajność i sprawia, że jest niesamowicie szybki.

Wniosek

Więc to był prawie najważniejszy aspekt, który musisz wiedzieć o Wikipedii Web Scraping. Bądź na bieżąco z nami, aby uzyskać więcej takich informacyjnych postów na temat Web Scraping i wiele więcej!

Szybkie linki

- Najlepsze proxy do agregacji taryf podróżnych

- Najlepsze francuskie proxy

- Najlepsze proxy strony Tripadvisor

- Najlepsze serwery proxy Etsy

- IProyal kod kuponu

- Najlepsze proxy TikTok