IA em SEO: como enfrentar desafios legais e garantir conformidade

Publicados: 2023-09-26A inteligência artificial (IA) está prestes a se tornar uma ferramenta vital para marcas que buscam melhorar sua presença online.

No entanto, a integração da IA nas estratégias de marketing cria inevitavelmente considerações legais e novas regulamentações que as agências devem navegar cuidadosamente.

Neste artigo, você descobrirá:

- Como as empresas, as agências de SEO e de mídia podem minimizar os riscos legais da implementação de estratégias aprimoradas por IA.

- Ferramentas úteis para reduzir preconceitos de IA e um processo útil para revisar a qualidade do conteúdo gerado por IA.

- Como as agências podem enfrentar os principais desafios de implementação de IA para garantir eficiência e conformidade para seus clientes.

Considerações sobre conformidade legal

Propriedade intelectual e direitos autorais

Uma preocupação legal crucial ao usar IA em SEO e mídia é seguir as leis de propriedade intelectual e direitos autorais.

Os sistemas de IA frequentemente coletam e analisam grandes quantidades de dados, incluindo material protegido por direitos autorais.

Já existem vários processos judiciais contra a OpenAI por violações de direitos autorais e privacidade.

A empresa enfrenta ações judiciais alegando uso não autorizado de livros protegidos por direitos autorais para treinamento do ChatGPT e coleta ilegal de informações pessoais de usuários da Internet usando seus modelos de aprendizado de máquina.

As preocupações com a privacidade no processamento e armazenamento de dados do usuário pela OpenAI também fizeram com que a Itália bloqueasse totalmente o uso do ChatGPT no final de março.

A proibição foi suspensa agora depois que a empresa fez alterações para aumentar a transparência no processamento de dados do usuário do chatbot e adicionar uma opção para cancelar as conversas do ChatGPT usadas para algoritmos de treinamento.

No entanto, com o lançamento do GPTBot, o rastreador da OpenAI, é provável que surjam outras considerações legais.

Para evitar possíveis problemas legais e reclamações de violação, as agências devem garantir que todos os modelos de IA sejam treinados em fontes de dados autorizadas e respeitem as restrições de direitos autorais:

- Certifique-se de que os dados foram obtidos legalmente e que a agência tem os direitos apropriados para usá-los.

- Filtre dados que não tenham as permissões legais exigidas ou que sejam de baixa qualidade.

- Realize auditorias regulares de dados e modelos de IA para garantir que cumpram os direitos e leis de uso de dados.

- Faça uma consulta jurídica sobre direitos de dados e privacidade para garantir que nada entre em conflito com as políticas legais.

As equipes jurídicas da agência e do cliente provavelmente precisarão estar envolvidas nas discussões acima antes que os modelos de IA possam ser integrados em fluxos de trabalho e projetos.

Privacidade e proteção de dados

As tecnologias de IA dependem fortemente de dados, que podem incluir informações pessoais sensíveis.

A coleta, o armazenamento e o processamento de dados do usuário devem estar alinhados com as leis de privacidade relevantes, como o Regulamento Geral de Proteção de Dados (GDPR) na União Europeia.

Além disso, a recentemente introduzida Lei da UE sobre IA também enfatiza a abordagem das preocupações com a privacidade dos dados associadas aos sistemas de IA.

Isto não é sem mérito. Grandes corporações, como a Samsung, baniram completamente a IA devido à exposição de dados confidenciais carregados no ChatGPT.

Portanto, se as agências usarem dados de clientes em conjunto com tecnologia de IA, deverão:

- Priorize a transparência na coleta de dados.

- Obtenha o consentimento do usuário.

- Implemente medidas de segurança robustas para proteger informações confidenciais.

Nestes casos, as agências podem priorizar a transparência na recolha de dados, comunicando claramente aos utilizadores quais os dados que serão recolhidos, como serão utilizados e quem terá acesso a eles.

Para obter o consentimento do utilizador, certifique-se de que o consentimento é informado e dado livremente através de formulários de consentimento claros e fáceis de compreender que explicam a finalidade e os benefícios da recolha de dados.

Além disso, medidas de segurança robustas incluem:

- Criptografia de dados.

- Controle de acesso.

- Anonimização de dados (quando possível).

- Auditorias e atualizações regulares.

Por exemplo, as políticas da OpenAI alinham-se com a necessidade de privacidade e proteção de dados e concentram-se na promoção da transparência, do consentimento do utilizador e da segurança dos dados em aplicações de IA.

Justiça e preconceito

Os algoritmos de IA usados em SEO e na mídia têm o potencial de perpetuar inadvertidamente preconceitos ou discriminar certos indivíduos ou grupos.

As agências devem ser proativas na identificação e mitigação de vieses algorítmicos. Isto é especialmente importante no âmbito da nova Lei da UE sobre IA, que proíbe os sistemas de IA de afetar injustamente o comportamento humano ou de exibir comportamento discriminatório.

Para mitigar este risco, as agências devem garantir que dados e perspetivas diversos sejam incluídos na conceção dos modelos de IA e monitorizar continuamente os resultados quanto a potenciais preconceitos e discriminação.

Uma maneira de conseguir isso é usar ferramentas que ajudam a reduzir preconceitos, como AI Fairness 360, IBM Watson Studio e a ferramenta What-If do Google.

Conteúdo falso ou enganoso

As ferramentas de IA, incluindo o ChatGPT, podem gerar conteúdo sintético que pode ser impreciso, enganoso ou falso.

Por exemplo, a inteligência artificial muitas vezes cria avaliações online falsas para promover determinados lugares ou produtos. Isto pode levar a consequências negativas para as empresas que dependem de conteúdo gerado por IA.

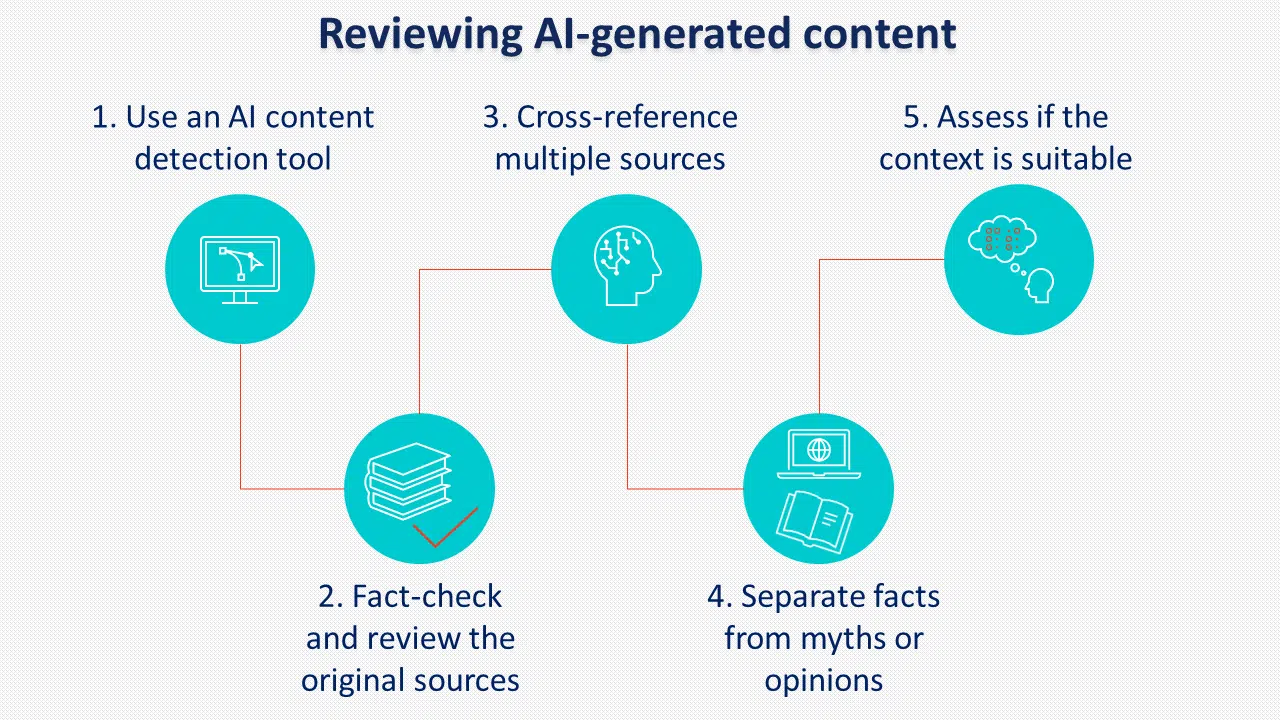

A implementação de políticas e procedimentos claros para a revisão do conteúdo gerado pela IA antes da publicação é crucial para prevenir este risco.

Outra prática a considerar é rotular o conteúdo gerado por IA. Embora o Google pareça não aplicá-la, muitos legisladores apoiam a rotulagem de IA.

Responsabilidade e prestação de contas

À medida que os sistemas de IA se tornam mais complexos, surgem questões de responsabilidade.

As agências que utilizam IA devem estar preparadas para assumir a responsabilidade por quaisquer consequências não intencionais resultantes da sua utilização, incluindo:

- Preconceito e discriminação ao usar IA para classificar candidatos para contratação.

- O potencial de abuso do poder da IA para fins maliciosos, como ataques cibernéticos.

- A perda de privacidade se as informações forem coletadas sem consentimento.

A Lei da UE sobre IA introduz novas disposições sobre sistemas de IA de alto risco que podem afetar significativamente os direitos dos utilizadores, destacando a razão pela qual as agências e os clientes devem cumprir os termos e políticas relevantes quando utilizam tecnologias de IA.

Alguns dos termos e políticas mais importantes da OpenAI estão relacionados ao conteúdo fornecido pelo usuário, à precisão das respostas e ao processamento de dados pessoais.

A política de conteúdo afirma que a OpenAI atribui os direitos do conteúdo gerado ao usuário. Também especifica que o conteúdo gerado pode ser utilizado para qualquer finalidade, inclusive comercial, desde que atenda às restrições legais.

No entanto, também afirma que os resultados podem não ser completamente únicos nem precisos, o que significa que o conteúdo gerado pela IA deve sempre ser cuidadosamente revisto antes da utilização.

Em uma nota de dados pessoais, a OpenAI coleta todas as informações inseridas pelos usuários, incluindo uploads de arquivos.

Ao utilizar o serviço para tratamento de dados pessoais, os usuários deverão fornecer avisos de privacidade legalmente adequados e preencher um formulário para solicitar o tratamento de dados.

As agências devem abordar proativamente as questões de responsabilização, monitorizar os resultados da IA e implementar medidas robustas de controlo de qualidade para mitigar potenciais responsabilidades legais.

Obtenha o boletim informativo diário em que os profissionais de marketing de pesquisa confiam.

Consulte os termos.

Desafios de implementação de IA para agências

Desde que a OpenAI lançou o ChatGPT no ano passado, tem havido muitas conversas sobre como a IA generativa mudará o SEO como profissão e seu impacto geral na indústria de mídia.

Embora as mudanças venham acompanhadas de uma combinação de melhorias na carga de trabalho diária, existem alguns desafios que as agências devem considerar ao implementar a IA nas estratégias dos clientes.

Educação e conscientização

Muitos clientes podem não ter uma compreensão abrangente da IA e das suas implicações.

As agências enfrentam, portanto, o desafio de educar os clientes sobre os potenciais benefícios e riscos associados à implementação da IA.

O cenário regulatório em evolução exige uma comunicação clara com os clientes sobre as medidas tomadas para garantir a conformidade legal.

Para conseguir isso, as agências devem:

- Tenha uma compreensão clara dos objetivos de seus clientes.

- Ser capaz de explicar os benefícios.

- Mostre experiência na implementação de IA.

- Enfrente os desafios e riscos.

Uma forma de fazer isso é ter uma ficha informativa para compartilhar com os clientes contendo todas as informações necessárias e, se possível, fornecer estudos de caso ou outros exemplos de como eles podem se beneficiar do uso da inteligência artificial.

Alocação de recursos

A integração da IA nas estratégias de SEO e de mídia requer recursos significativos, incluindo investimentos financeiros, pessoal qualificado e atualizações de infraestrutura.

As agências devem avaliar cuidadosamente as necessidades e capacidades dos seus clientes para determinar a viabilidade de implementação de soluções de IA dentro das suas restrições orçamentais, uma vez que podem necessitar de especialistas em IA, analistas de dados, SEO e especialistas em conteúdos que possam colaborar eficazmente entre si.

As necessidades de infraestrutura podem incluir ferramentas de IA, processamento de dados e plataformas analíticas para extrair insights. A prestação de serviços ou a facilitação de recursos externos depende das capacidades e do orçamento existentes de cada agência.

A terceirização de outras agências pode levar a uma implementação mais rápida, enquanto o investimento em capacidades internas de IA pode ser melhor para o controle e personalização de longo prazo dos serviços oferecidos.

Conhecimento técnico

A implementação da IA exige conhecimento técnico especializado e experiência.

As agências podem necessitar de recrutar ou melhorar as competências das suas equipas para desenvolver, implementar e gerir eficazmente sistemas de IA em linha com os novos requisitos regulamentares.

Para aproveitar ao máximo a IA, os membros da equipe devem ter:

- Bons conhecimentos de programação.

- Processamento de dados e habilidades analíticas para gerenciar grandes quantidades de dados.

- Conhecimento prático de aprendizado de máquina.

- Excelentes habilidades de resolução de problemas.

Considerações éticas

As agências devem considerar as implicações éticas do uso da IA para os seus clientes.

Devem ser estabelecidos quadros e directrizes éticas para garantir práticas responsáveis de IA ao longo de todo o processo, abordando as preocupações levantadas nos regulamentos actualizados.

Esses incluem:

- Transparência, divulgação e responsabilidade quando a IA é utilizada.

- Respeitar a privacidade do usuário e a propriedade intelectual.

- Obtenção do consentimento do cliente para uso de inteligência artificial.

- Controle humano sobre a IA com compromisso contínuo de melhorar e adaptar-se às tecnologias emergentes de IA.

A responsabilidade é importante: Enfrentar os desafios legais da implementação da IA

Embora a IA apresente oportunidades interessantes para melhorar as práticas de SEO e de mídia, as agências devem enfrentar os desafios legais e aderir aos regulamentos atualizados associados à sua implementação.

As empresas e agências podem minimizar os riscos legais:

- Garantir que os dados foram obtidos legalmente e que a agência tem os direitos apropriados para usá-los.

- Filtrar dados que não tenham as permissões legais exigidas ou que sejam de baixa qualidade.

- Realização de auditorias de dados e modelos de IA para garantir que cumpram os direitos e leis de uso de dados.

- Realizar uma consulta jurídica sobre direitos de dados e privacidade para garantir que nada entre em conflito com as políticas legais.

- Priorizar a transparência na coleta de dados e obter o consentimento dos usuários por meio de formulários de consentimento claros e de fácil compreensão.

- Usando ferramentas que ajudam a reduzir preconceitos, como AI Fairness 360, IBM Watson Studio e ferramenta What-If do Google.

- Implementar políticas e procedimentos claros para revisar a qualidade do conteúdo gerado por IA antes da publicação.

As opiniões expressas neste artigo são do autor convidado e não necessariamente do Search Engine Land. Os autores da equipe estão listados aqui.