Além das palavras-chave: como as entidades afetam as estratégias modernas de SEO

Publicados: 2023-07-06A transição do “motor de busca 2.0” para o “motor de busca 3.0” trouxe mudanças significativas, principalmente com a introdução de entidades.

Este artigo explora essas mudanças, o impacto das entidades no SEO moderno e como adaptar suas estratégias para prosperar nesta nova era.

Construindo sua própria 'máquina nocional' de SEO

Nos meus primeiros anos aprendendo a codificar, um professor introduziu um conceito impactante conhecido como “máquina nocional”, que reformulou minha abordagem de programação e, posteriormente, de SEO.

Simplificando, é o modelo mental aproximado de um desenvolvedor do que acontece dentro do computador quando ele clica em executar.

Meu professor enfatizou que quanto mais detalhada e precisa fosse essa representação mental, mais bem equipado eu estaria para lidar com novos problemas.

Os programadores mais bem-sucedidos foram aqueles que desenvolveram as máquinas nocionais mais precisas e confiáveis!

Traçando um paralelo com o SEO, quando absorvemos novos conceitos, examinamos um estudo de caso ou observamos o impacto de uma mudança, estamos continuamente atualizando nosso modelo mental (nossa própria máquina nocional) de como funcionam os mecanismos de busca.

A diferença entre SEOs qualificados e SEOs não qualificados é que eles podem gerar resultados porque podem extrair soluções de um modelo mais preciso.

Pesquisas na área de especialização conduzidas por Anderson Ericsson fornecem evidências substanciais para afirmar esse ponto.

Seus estudos sobre especialização revelam que aqueles que se destacam em seus campos possuem modelos mentais superiores e mais facilmente acessíveis.

Esses modelos permitem que eles entendam as intrincadas relações de causa e efeito, distingam o que realmente importa em um cenário complexo e percebam os processos subjacentes que não são imediatamente aparentes.

Com a introdução do SEO de entidade, vários componentes principais do mecanismo de busca do Google foram alterados.

Parece que muitos profissionais de SEO ainda operam sob as regras do “mecanismo de busca 2.0”, embora o “mecanismo de busca 3.0” agora siga um conjunto ligeiramente diferente de regras.

Entity SEO introduz vocabulário e conceitos que se originam de disciplinas de aprendizado de máquina e recuperação de informações.

Esses termos podem parecer complexos porque não foram simplificados em seus significados principais. Depois de destilá-los, você descobrirá que os conceitos não são excessivamente complicados.

Meu objetivo é construir uma máquina nocional simples, mas eficaz, de como os mecanismos de pesquisa mais recentes usam entidades.

Mais especificamente, quero ilustrar como sua compreensão de SEO precisa ser atualizada para refletir essa nova realidade.

Embora entender o “porquê” por trás dessas mudanças possa parecer sem importância, muitos profissionais de SEO efetivamente “hackeiam a matriz” usando sua compreensão de como o Google interpreta a web a seu favor.

Nos últimos tempos, as pessoas construíram milhões de sites de visitantes e transformaram a compreensão do Google sobre o assunto, manipulando esses conceitos.

Atualização: como chegamos ao mecanismo de pesquisa 2.0

Antes de explorar as diferenças entre "mecanismo de pesquisa 2.0" e "mecanismo de pesquisa 3.0", vamos revisar as principais alterações da versão inicial 1.0.

No início, os mecanismos de busca operavam em um modelo simples de “saco de palavras”.

Esse modelo tratava um documento como uma mera coleção de palavras, negligenciando o significado contextual ou a disposição dessas palavras.

Quando um usuário fazia uma consulta, o mecanismo de busca se referia a um banco de dados de índice invertido – uma estrutura de dados mapeando palavras para suas localizações em um conjunto de documentos – e recuperava os documentos com o maior número de correspondências.

No entanto, devido à falta de compreensão do contexto e da semântica dos documentos e das consultas do usuário, esse modelo muitas vezes não conseguia fornecer resultados de pesquisa relevantes e precisos.

Por exemplo, se um usuário buscasse por “onça” usando um modelo de “saco de palavras”, o mecanismo de busca simplesmente abriria documentos contendo a palavra “onça” sem considerar o contexto.

Isso pode gerar resultados sobre a marca do carro Jaguar, o animal jaguar ou até mesmo o time de futebol Jacksonville Jaguars, independentemente da intenção do usuário.

Com o advento do “mecanismo de busca 2.0”, o Google adotou estratégias mais sofisticadas. Em vez de apenas palavras correspondentes, essa iteração visava decifrar a intenção do usuário por trás de sua consulta.

Por exemplo, se um usuário pesquisou por “jaguar”, o mecanismo agora pode considerar o histórico de pesquisa e a localização do usuário para inferir o contexto provável.

Se o usuário estiver procurando modelos de carros ou residir em uma área onde os carros Jaguar são populares, o mecanismo pode priorizar os resultados sobre a marca do carro em vez do animal ou do time de futebol.

A introdução de resultados de pesquisa personalizados – considerando fatores como histórico e localização do usuário – aumentou significativamente a relevância e a precisão dos resultados de pesquisa. Isso marcou uma evolução significativa do modelo básico de “saco de palavras” para o “mecanismo de busca 2.0”.

Motor de busca 2.0 vs. 3.0

Ao fazermos a transição do “mecanismo de busca 1.0” para o “mecanismo de busca 2.0”, tivemos que atualizar nossos modelos mentais e mudar nossas práticas.

A qualidade dos backlinks tornou-se crucial, levando os profissionais de SEO a abandonar as ferramentas automatizadas de backlinks e buscar backlinks de sites de alta qualidade, entre várias mudanças importantes.

Na era do “mecanismo de busca 3.0”, fica claro que a mudança mental para acomodar essas mudanças ainda está em andamento.

Muitos conceitos da era 2.0 persistem, principalmente porque os profissionais precisam de tempo para observar a correlação entre seus ajustes e os resultados subsequentes.

Um número significativo de profissionais de SEO ainda não se adaptou totalmente a essas mudanças substanciais, ou pode ter feito tentativas de fazê-lo, mas ainda não atingiu o alvo.

Para esclarecer essas novas distinções e fornecer orientação sobre como modificar sua abordagem, apresentarei uma comparação simplificada, porém útil, entre "mecanismo de pesquisa 2.0" e "mecanismo de pesquisa 3.0".

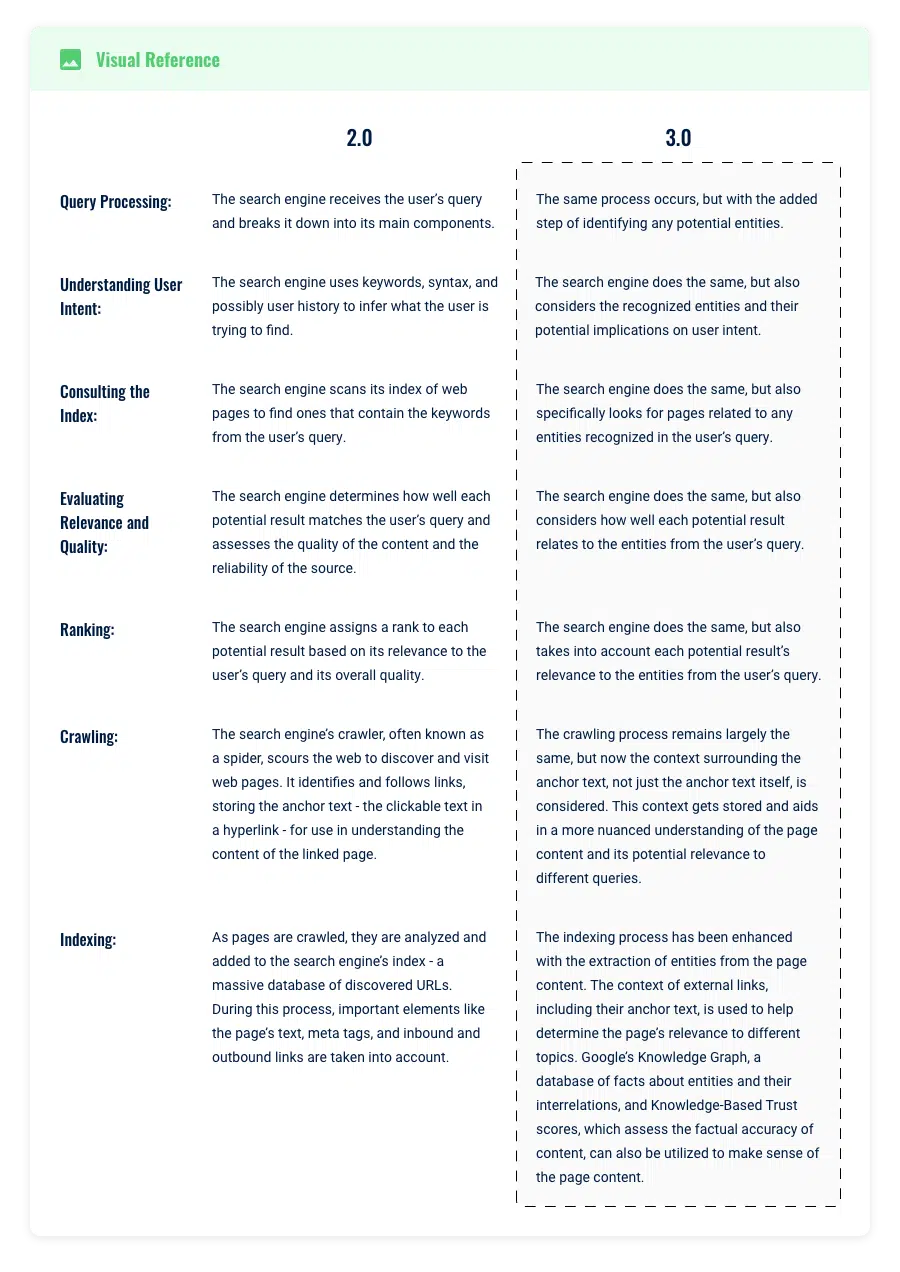

Processamento de consultas e recuperação de informações

Imagine digitar a consulta de pesquisa “Elvis” no Google.

Na era do mecanismo de busca do Google 2.0, a sofisticação dos algoritmos subjacentes permitiu uma compreensão da intenção do usuário por trás de uma consulta, além de apenas palavras-chave correspondentes.

Por exemplo, se um usuário procurasse por “Elvis”, o sistema usaria processamento de linguagem natural e aprendizado de máquina para entender e antecipar a intenção por trás da consulta.

Ele procuraria “Elvis” em seu índice e retornaria resultados que mencionassem a palavra “Elvis” ou fossem baseados (quase completamente) na relevância da cópia em páginas da web e em parâmetros de personalização, como histórico e localização do usuário.

No entanto, esse modelo ainda tinha suas limitações, pois dependia em grande parte de palavras-chave, histórico de pesquisa do usuário, localização e frases no texto de páginas da web indexadas.

O contexto de “Elvis” pode significar Elvis Presley, Elvis Costello ou até mesmo um restaurante local chamado “Elvis”.

O desafio era que ele dependia amplamente do usuário para especificar e refinar sua consulta e ainda era limitado pela semântica das palavras-chave.

Melhorias no processamento de consultas na versão 3.0

Muitas pessoas ainda não perceberam como a introdução de entidades revolucionou fundamentalmente a maneira como a pesquisa funcionava.

Desde 2012, a Hummingbird e a RankBrain abriram caminho para que as entidades assumam um papel mais central.

Neste modelo 3.0, as entidades referem-se a conceitos ou coisas distintas e únicas, sejam pessoas, lugares ou objetos.

Usando nosso exemplo anterior, “Elvis” não é mais simplesmente uma palavra-chave, mas reconhecida como uma entidade, provavelmente referindo-se ao famoso músico Elvis Presley.

Por exemplo, quando uma entidade como “Elvis Presley” é identificada, o mecanismo de busca pode agora associar uma riqueza de atributos a essa entidade, incluindo aspectos como sua música, sua filmografia e suas datas de nascimento e morte.

Essa nova abordagem amplia significativamente o escopo da pesquisa. Antes, uma consulta para “Elvis” poderia considerar principalmente cerca de 2.000.000 de páginas que continham a palavra-chave exata “Elvis”.

Agora, neste modelo centrado na entidade, o mecanismo de busca vai além disso para considerar qualquer página relacionada aos atributos de Elvis.

Isso poderia ampliar o campo de pesquisa para incluir 10.000.000 de páginas, mesmo que algumas delas não mencionem explicitamente “Elvis”.

Além disso, este modelo permite ao motor de busca perceber que outras palavras-chave relacionadas com os atributos da entidade Elvis, como “Graceland” ou “Blue Suede Shoes”, estão implicitamente ligadas a “Elvis”.

Portanto, pesquisar por esses termos também pode trazer informações sobre Elvis, ampliando a rede de possíveis resultados de pesquisa.

Obtenha a newsletter diária em que os profissionais de marketing de busca confiam.

Consulte os termos.

Processamento de consultas e limites de tópicos no mecanismo de pesquisa 3.0

Outra mudança significativa provocada por essas melhorias nas entidades no processamento de consultas foi como o Google percebe o escopo dos tópicos que devem residir em uma única página.

Na era do "mecanismo de busca 2.0", era vantajoso criar uma página separada para cada palavra-chave identificada, de forma que a página pudesse ser otimizada especificamente para aquele termo.

No entanto, no "mecanismo de busca 3.0", os limites se tornaram mais fluidos e são atualizados em tempo real com base em previsões de aprendizado de máquina e comportamento observado do usuário.

Nesta nova era, os limites de um assunto podem ser vastos ou estreitos, abrangendo uma ampla gama de tópicos ou focando intensamente em um determinado aspecto. Essa flexibilidade permite que os sites se tornem autoridades em áreas amplas e de nicho.

Exemplo

Considere o exemplo dos gizes de cera. Um site pode ter como objetivo cobrir tudo o que há para saber sobre giz de cera em geral – sua história, tipos, processo de fabricação, dicas de uso, etc.

Este site tem como objetivo tornar-se uma autoridade tópica em 'crayons' como um todo.

Por outro lado, outro site pode se concentrar apenas em giz de cera vermelho – seus pigmentos exclusivos, estatísticas de popularidade, significado cultural e assim por diante.

Este site está tentando estabelecer sua autoridade tópica em um contexto mais restrito, mas ainda válido. É crucial, no entanto, que o foco em 'lápis de cera vermelho' esteja alinhado com o objetivo geral do site.

Adicionar microcontextos que não correspondem ao objetivo mais amplo do seu site pode confundir o Google sobre a relevância e a autoridade do seu site, possivelmente diluindo sua autoridade tópica.

Em teoria, um site poderia até mesmo mergulhar ainda mais em um microcontexto e centrar seu conteúdo apenas nos “rótulos usados em giz de cera vermelho”.

Este é um foco incrivelmente específico, e alguém pode se perguntar se o Google o reconheceria como uma autoridade tópica.

Os sites de mídia social usam aprendizado de máquina para prever as interações do usuário com itens de conteúdo relacionados a um determinado tópico.

Se um usuário interage com frequência com conteúdo sobre “rótulos usados em giz de cera vermelho”, o sistema pode identificar isso como um tópico de interesse do usuário, e o site que fornece o conteúdo pode ser reconhecido como uma autoridade nesse tópico.

Pode-se teorizar que o Google pode fazer algo semelhante ou, pelo menos, manter as expectativas de como um bom conteúdo deve funcionar de acordo com as métricas do usuário que eles rastreiam.

Para determinar isso, o Google considera vários fatores:

Existe uma quantidade significativa de atividade de pesquisa em torno deste tópico?

Se as pessoas estiverem procurando ativamente por informações sobre os 'rótulos usados em giz de cera vermelho', e o site fornecer conteúdo abrangente e valioso sobre esse tópico, ele poderá muito bem ser reconhecido como uma autoridade tópica nesse microcontexto.

Existem boas métricas de usuário?

Se os usuários passam muito tempo no site, têm baixas taxas de rejeição e demonstram outros sinais de engajamento, o Google pode interpretar isso como um sinal da autoridade do site no assunto.

Lembre-se, autoridade tópica é um conceito baseado na relatividade de diferentes sujeitos (entidades). Seu site pode ser considerado uma autoridade em assuntos tão amplos quanto 'tecnologia' ou tão restritos quanto "máquinas de escrever antigas".

O fator crucial é que seu site exiba um comportamento positivo do usuário e empregue entidades de forma eficaz para estabelecer relacionamentos dentro do conteúdo. Ao fazer isso, o Google começa a confiar em seu site para aprimorar sua própria compreensão do assunto, independentemente do volume geral de pesquisa do tópico.

Aplicativos e tópicos de SEO

Conteúdo mais abrangente ganha

Em versões anteriores, muitas páginas da Web eram ignoradas para consultas porque não continham as palavras exatas incluídas na pesquisa.

Por exemplo, uma página bem vinculada que não incorporou um determinado termo de pesquisa não apareceria nos resultados, independentemente de seus outros fatores de classificação robustos, como engajamento do usuário e backlinks.

Isso encorajou os SEOs a escrever menos peças de conteúdo mais focadas para alcançar classificações para uma palavra-chave alvo.

No entanto, com o advento do 3.0 e seu foco na compreensão das entidades e seus relacionamentos, o jogo mudou.

Não é sobre se o termo de pesquisa exato aparece na página. O Google agora pesquisará entidades relativas em sua página e tentará vincular essas entidades a entidades relacionadas em todo o site.

Ele então determinará a relatividade aproximada e classificará você de acordo. Essa mudança fundamental traz páginas com fortes fatores de classificação para a competição, mesmo que não tenham termos específicos

A principal conclusão para criadores de conteúdo e estrategistas de SEO é se inclinar para a criação de conteúdo mais abrangente e expansivo.

Centralize seus esforços de backlink nessas peças amplas e aprofundadas, em vez de dividir os tópicos em vários artigos com foco restrito.

Use SERPs atuais como ponto de partida para identificar tópicos importantes, mas não se limite a eles.

Procure ir além da cobertura tópica existente nas SERPs e fornecer conteúdo valioso e abrangente ao usuário.

Isso atenderá à consulta existente do usuário e às possíveis consultas relacionadas que ele possa ter, aumentando a relevância e a visibilidade do seu conteúdo nesta nova era de pesquisa.

Intenção de resposta em vez de focar no uso de palavras-chave, cuidado com os títulos

Na era do "mecanismo de busca 3.0", a estratégia de SEO evoluiu. Não é mais suficiente simplesmente inserir palavras-chave do seu relatório do Search Console em seu conteúdo e esperar por melhores classificações.

Os algoritmos avançados do Google agora podem detectar quando uma palavra-chave é usada fora do contexto, o que pode confundir o algoritmo e potencialmente levar a classificações mais baixas.

A ordem do cabeçalho é importante

Use seu cérebro para conectar as ideias-chave mais relevantes ao objetivo da sua página. Certifique-se de que o conteúdo sob o cabeçalho corresponda ao tópico do cabeçalho.

Lembre-se dos dias de brainstorming para suas aulas de redação na escola primária?

Desenharíamos círculos, escreveríamos tópicos dentro dos círculos e depois os ligaríamos desenhando uma linha reta a círculos menores com tópicos relativos à nossa história.

Não complique demais as coisas. Use esta estratégia para formar seus títulos também.

Resumindo, o "mecanismo de busca 3.0" requer uma abordagem mais cuidadosa para o uso de palavras-chave, abordando a intenção do usuário e mantendo o contexto para melhorar a relevância e o potencial de classificação.

Pontuação e classificação dos documentos

Uma vez que um mecanismo de busca como o Google tenha buscado documentos potencialmente relevantes, a próxima etapa crucial é pontuar essas páginas e classificá-las para um usuário selecionar.

A evolução da inteligência artificial (IA) e do processamento de linguagem natural (NLP) transformou significativamente a forma como os documentos são classificados, marcando uma clara distinção entre as eras 2.0 e 3.0.

era 2.0 (pós-saco de palavras, pré-RankBrain)

Na era 2.0, o sistema de pontuação do Google era impulsionado principalmente por algoritmos como PageRank, Hummingbird, Panda e Penguin.

Esses algoritmos dependiam muito da correspondência de palavras-chave e do número de backlinks para classificar os documentos. Cada documento receberia uma pontuação com base nas páginas e seria classificado com base na ordem de classificação.

As evoluções de algoritmos como o Panda e o Penguin eram menos sobre afastar-se da correspondência de palavras-chave e mais sobre penalizar sites que tentavam burlar o sistema.

Os sistemas baseados em palavras-chave ainda eram mais eficientes e o hardware não era avançado o suficiente para fornecer resultados de pesquisa rápidos com métodos de linguagem evoluídos.

Pontuação e classificação na era do mecanismo de busca 3.0

No cenário do "mecanismo de busca 3.0", a abordagem do Google para pontuar e classificar documentos evoluiu significativamente.

Este é o resultado de melhorias de software e hardware. O Google avalia a adequação de uma página para uma consulta de pesquisa com base em vários fatores-chave.

A principal diferença é uma capacidade aprimorada de quantificar a relevância, em vez de depender de sinais externos, como backlinks, para identificar os melhores conteúdos:

Precisão factual

O conteúdo factualmente preciso de fontes respeitáveis continua a ter uma classificação mais alta. O Knowledge-Based Trust do Google confirma isso, afirmando:

"Chamamos a pontuação de confiabilidade que calculamos de Knowledge-Based Trust (KBT)... A avaliação manual de um subconjunto dos resultados confirma a eficácia do método.

Sinais de interação do usuário

As estratégias "Postar conteúdo de baixa qualidade agora e editar depois" podem ser problemáticas por esses motivos. O Google agora considera os dados históricos e atuais de envolvimento do usuário associados a uma página da web.

Essa mudança é descrita na patente do Google intitulada "Engagement and Experience Based Ranking" (US20140244560A1), que enfatiza o uso da pontuação histórica de engajamento como parte de suas considerações de classificação.

Compromissos de qualidade

Os engajamentos, como cliques longos em que um usuário permanece em sua página por um período de tempo significativo, são benéficos.

No entanto, engajamentos sem qualidade, como retornos rápidos aos resultados de pesquisa (conhecidos como "pogo-sticking"), podem afetar negativamente sua classificação.

Essas métricas de engajamento podem influenciar sua posição de classificação e impressões, aumentando sua autoridade tópica.

No entanto, um baixo engajamento do usuário pode levar a uma queda na classificação da sua página. A recuperação de tal queda pode levar tempo, ressaltando a importância de fornecer consistentemente conteúdo relevante e de alta qualidade que incentive o envolvimento positivo do usuário.

Lições e aplicações de SEO

Verificando os fatos

O Google pode verificar a precisão dos fatos. Invista tempo na criação de conteúdo factualmente preciso.

Isso inclui pesquisa adequada, verificação de fatos e citação de fontes confiáveis. Implemente o esquema de verificação de fatos para criar credibilidade e relevância para seus artigos informativos

Engajamento do usuário

Preste atenção às métricas de engajamento do usuário da sua página. Se o seu conteúdo não estiver atraindo os usuários como esperado, considere revisar sua estratégia de conteúdo.

Rastreamento e indexação

À medida que encerramos nossa exploração do processo de pesquisa, vamos ver como as técnicas de rastreamento e indexação da Web do Google evoluíram com seu foco em entidades.

Compreender essas mudanças é crucial, pois elas afetam diretamente como você deve estruturar seu site e formular sua estratégia de conteúdo, incluindo a construção de seu mapa de tópicos.

Na era do "mecanismo de busca 2.0", os rastreadores da web do Google, também conhecidos como spiders, navegavam sistematicamente na Internet para descobrir páginas novas e atualizadas.

Eles seguiam os links de uma página da web para outra e coletavam dados sobre cada página para armazenar no índice do Google. Esse processo consistia principalmente em descobrir novos conteúdos e garantir que o índice permanecesse atualizado.

Assim que os rastreadores descobriam uma página, ela era adicionada ao índice do Google – um enorme banco de dados de todas as páginas da web que o Google encontrou.

O conteúdo de cada página (incluindo texto, imagens e vídeos) foi analisado e a página foi categorizada com base nesse conteúdo.

O foco principal estava nas palavras-chave e frases dentro do texto e fatores como backlinks, que eram usados para determinar a relevância e autoridade de uma página.

Avanço rápido para a era do "mecanismo de busca 3.0" e as coisas se tornaram mais complexas.

Os rastreadores do Google ainda estão descobrindo páginas novas e atualizadas seguindo links na Internet. Mas agora, eles também estão tentando entender as entidades que as palavras-chave em uma página representam.

Por exemplo, uma página sobre "Elvis" também pode ser indexada em entidades relacionadas como "rock and roll", "Graceland" e "Blue Suede Shoes".

Além disso, eles estão seguindo seus links internos para entender quais entidades seu site relaciona.

Isso é um pouco como um bibliotecário não apenas catalogando livros com base em seus títulos, mas também lendo-os para entender como os capítulos se relacionam entre si e com o tema geral do livro.

Esse entendimento mais profundo ajuda o Google a fornecer resultados de pesquisa mais relevantes e precisos.

Mas como o rastreamento se relaciona com autoridades e entidades tópicas?

Bem, quando o Google rastreia um site, não está mais olhando apenas para as páginas individuais isoladamente. Também está olhando para o tema geral ou tópico do site.

É aqui que entra a autoridade tópica.

Se um site publica consistentemente conteúdo de alta qualidade sobre um tópico específico, ele pode ser visto como uma autoridade nesse tópico.

Se o Google considerar o site uma autoridade, pode impulsioná-lo nos resultados da pesquisa. (Muitas vezes, você verá sites com pequenos perfis de backlink classificados em termos competitivos, provavelmente devido a um aumento na pontuação de autoridade tópica que estão obtendo.)

Curiosamente, o conceito de autoridade tópica já existe há pelo menos alguns anos, mas só recentemente foi reconhecido pelo Google.

Em 23 de maio de 2023, o Google publicou “Understanding News Topic Authority”.

Embora muitos SEOs experientes acreditassem que a autoridade tópica era um fator de classificação, ninguém poderia verificar isso por meio de conteúdo publicado no Google (além de vasculhar patentes pendentes).

Não se deixe enganar pela palavra “notícias” neste comunicado. A autoridade do tópico refere-se a todos os sites na web que o Google rastreia, não apenas sites de notícias.

Esse conceito de autoridade tópica é descrito na patente do Google US20180046717A1.

A patente descreve um processo de determinação da autoridade de um site com base na consistência e profundidade de um tópico específico dentro do site.

Por exemplo, um site que publica consistentemente conteúdo de alta qualidade sobre "jardinagem orgânica" pode ter um fator de alta pureza (sim, o Google analisa a capacidade do seu site de permanecer no tópico), contribuindo para uma pontuação de autoridade mais alta.

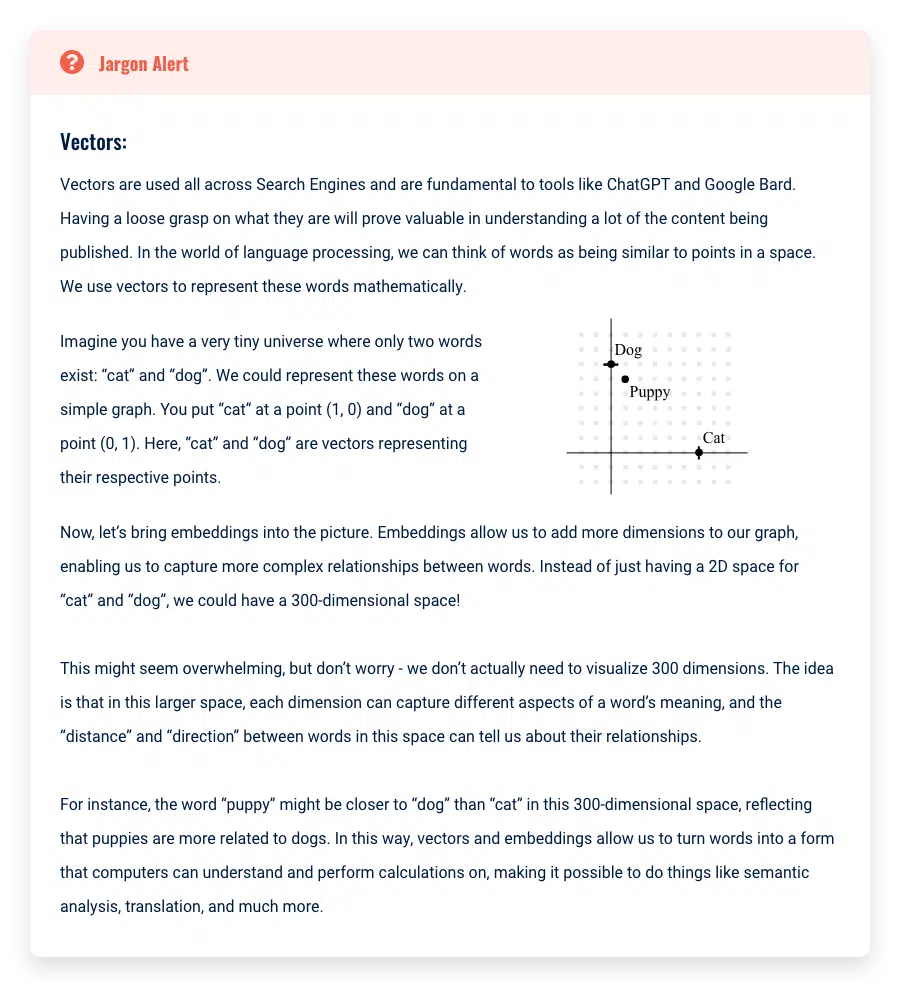

Além disso, o Google pode extrair os temas principais do seu conteúdo e grafá-lo, da mesma forma que o ChatGPT faz gráficos de palavras em incorporações (um vetor de recursos).

Isso permite que o Google veja visualmente se o seu conteúdo é semelhante e consistente, aprimorando ainda mais a compreensão da autoridade tópica do seu site.

Assim, em essência, a mudança no sistema de indexação do Google não é apenas sobre a compreensão do conteúdo de páginas individuais, mas também sobre o reconhecimento do foco tópico de um site.

Isso ressalta a importância de manter um foco consistente em sua estratégia de conteúdo, pois isso pode afetar significativamente a visibilidade do seu site nos resultados de pesquisa.

Lições e aplicações de SEO

Foco no tópico consistente

O Google pode identificar quando seu site se desvia de seu tópico principal. Se o seu conteúdo for inconsistente, pode confundir o propósito e o objetivo do seu site.

Mantenha um foco consistente em sua estratégia de conteúdo para se beneficiar dos aumentos de pontuação associados à autoridade tópica.

Profundidade do conteúdo

Construir profundidade em seu conteúdo é fundamental, mas deve ser uma profundidade relevante. Use sua compreensão do objetivo principal do seu site para orientar a profundidade do seu conteúdo.

Por exemplo, se o objetivo principal do seu site é fornecer informações sobre técnicas de fotografia digital, não se desvie para escrever a fundo sobre a história das câmeras de filme.

Embora esteja relacionado à fotografia, não se alinha de perto com o foco principal do seu site em técnicas digitais. Em vez disso, aprofunde seu conteúdo explorando várias técnicas de fotografia digital, revisando câmeras digitais ou fornecendo dicas para editar fotos digitais.

Muito conteúdo pode diluir sua autoridade

Muito conteúdo em seu site pode diluir o significado e o propósito do seu site.

Vasculhe seu mapa do site e certifique-se de que ele inclua apenas conteúdo que suporte suas ideias principais e que o conteúdo seja de qualidade suficiente para ajudar o Google a entender as entidades.

Uso de pontes contextuais

Ao criar um novo conteúdo, é importante usar "pontes contextuais" para conectá-lo ao objetivo principal do seu site.

Em vez de simplesmente adicionar novo conteúdo ao seu site, sempre pergunte a si mesmo como você pode vincular uma nova página ao seu objetivo principal.

Isso permitirá que o Google comece a associar as entidades de sua nova página com sua entidade de objetivo principal.

Limitações e restrições da autoridade tópica

Embora desejemos nos concentrar na criação de autoridade tópica em qualquer site que criamos, ainda existem algumas limitações.

Essas limitações são fatores de classificação persistentes dos dias da Web 2.0 aos quais o Google ainda concede uma quantidade razoável de poder de classificação: tempo na web e backlinks.

Em primeiro lugar, a autoridade do tópico leva tempo para ser construída. Com a recente explosão de ferramentas de criação de conteúdo de IA, esse cronograma pode ser drasticamente reduzido, mas ainda leva tempo.

O uso de autoridade tópica também é relativo a quão 'autoritários' são outros sites em seu nicho.

Por exemplo, se você criar um ótimo conteúdo com base em um incrível mapa de tópicos, ainda será comparado a outros sites do seu nicho.

Se esses outros sites também desenvolveram uma grande autoridade tópica ao longo do tempo, adiamos para o antigo problema de backlinks e tempo na web.

É extremamente difícil superar sites que desenvolveram um grande desenvolvimento de entidade e o fizeram em um domínio que está na web há vários anos ou mais. Possível, claro, mas difícil mesmo assim.

Vamos falar sobre backlinks.

Embora seja bem possível criar sites com boa classificação sem o uso de backlinks, até mesmo SEOs experientes podem ter dificuldade em fazê-lo.

Backlinks ainda são um fator de classificação muito importante. Claro, eles podem não ser tão poderosos quanto antes, mas ainda são poderosos.

O problema de dar uma quantidade tão grande de poder de classificação aos backlinks vem de grandes sites de conglomerados de notícias que na verdade não se "especializam" em nenhum tópico.

Todos nós já vimos isso: pesquisamos no Google "melhor widget para xyz" e os primeiros 10 a 15 resultados são sites de redes de notícias que afirmam ter os melhores guias para comprar esses widgets.

Os sites de notícias são especializados no desenvolvimento ou venda desses widgets?

Esses sites de notícias têm autoridade tópica quando se trata desses widgets?

De jeito nenhum.

Se os sites de notícias não têm autoridade tópica sobre esses widgets, por que eles ainda dominam as SERPs? Tudo se resume ao tempo na web e aos perfis de backlink.

Como os editores dessas grandes redes de notícias sabem que terão uma classificação extremamente alta assim que clicarem no botão de publicação, eles solicitam a venda de espaço publicitário em seus sites.

As empresas também sabem que seu produto chegará ao topo das SERPs do Google, então elas pagam de bom grado milhares e milhares de dólares por esse recurso.

Eles estão, em essência, se aproveitando da capacidade do site de notícias de dominar as SERPs sempre que publicam algo – daí o nome SEO parasita.

Não importa o quão topicamente autoritário seja o seu site, ele terá dificuldade em competir com essas potências dos sites de notícias.

Infelizmente, até que o Google resolva esse problema, tornar-se uma autoridade no assunto não é suficiente para competir com alguns desses SERPs quentes que os sites de notícias dominam.

Dominando o SEO na era das entidades

Espero que, ao guiá-lo pela jornada do processamento de consultas à indexação e à classificação, eu tenha ajudado você a atualizar sua "máquina teórica" para explicar melhor as mudanças mais recentes no mecanismo de pesquisa do Google.

Esse entendimento refinado deve ajudar a melhorar suas táticas, onde você concentra seu tempo e as classificações do seu próprio site e dos seus clientes.

Por fim, é fundamental lembrar que a teoria realmente brilha quando aplicada na prática.

Por exemplo, os praticantes de SEO afiliados descobriram há algum tempo que produzir uma quantidade substancial de conteúdo sobre seu assunto poderia desencadear um aumento de autoridade tópica de SEO.

Isso foi percebido muito antes da evolução de nossa compreensão do SEO de entidade entrar em ação.

A jornada de SEO está sempre evoluindo, cheia de oportunidades de descoberta e melhoria.

Então, armado com esse conhecimento e insights, é hora de você mergulhar, experimentar e moldar suas próprias estratégias de SEO. Afinal, a prova do pudim está em comê-lo. Teste feliz!

Este artigo foi co-escrito por Paul DeMott .

Este é o terceiro artigo da série SEO de entidades. Se você gostaria de começar lendo os dois primeiros artigos, eles estão vinculados aqui:

- O guia definitivo para SEO de entidades

- Como otimizar para entidades

- 3 maneiras de usar IA para otimização de entidade em todo o site

As opiniões expressas neste artigo são do autor convidado e não necessariamente do Search Engine Land. Os autores da equipe estão listados aqui.