Os mecanismos de pesquisa podem detectar conteúdo de IA?

Publicados: 2023-08-04A explosão de ferramentas de IA no ano passado impactou drasticamente os profissionais de marketing digital, especialmente aqueles em SEO.

Dada a natureza demorada e cara da criação de conteúdo, os profissionais de marketing recorreram à IA para obter assistência, produzindo resultados mistos

Apesar das questões éticas, uma pergunta que surge repetidamente é: “Os mecanismos de pesquisa podem detectar meu conteúdo de IA?”

A questão é considerada particularmente importante porque, se a resposta for “não”, invalida muitas outras questões sobre se e como a IA deve ser usada.

Uma longa história de conteúdo gerado por máquina

Embora a frequência da criação de conteúdo gerada por máquina ou assistida não tenha precedentes, ela não é totalmente nova e nem sempre é negativa.

Dar notícias primeiro é imperativo para sites de notícias, e eles há muito utilizam dados de várias fontes, como bolsas de valores e sismômetros, para acelerar a criação de conteúdo.

Por exemplo, é factualmente correto publicar um artigo sobre robôs que diga:

- “Um terremoto de [magnitude] foi detectado em [local, cidade] em [hora]/[data] esta manhã, o primeiro terremoto desde [data do último evento]. Mais notícias a seguir.”

Atualizações como essa também são úteis para o leitor final que precisa obter essas informações o mais rápido possível.

No outro extremo do espectro, vimos muitas implementações “blackhat” de conteúdo gerado por máquina.

O Google condenou o uso de cadeias de Markov para gerar texto para girar conteúdo de baixo esforço por muitos anos, sob a bandeira de “páginas geradas automaticamente que não fornecem valor agregado”.

O que é particularmente interessante, e principalmente um ponto de confusão ou uma área cinzenta para alguns, é o significado de “sem valor agregado”.

Como os LLMs podem agregar valor?

A popularidade do conteúdo de IA disparou devido à atenção conquistada pelos modelos de linguagem ampla (LLMs) GPTx e pelo chatbot de IA aprimorado, ChatGPT, que melhorou a interação conversacional.

Sem entrar em detalhes técnicos, há alguns pontos importantes a serem considerados sobre essas ferramentas:

O texto gerado é baseado em uma distribuição de probabilidade

- Por exemplo, se você escrever: “Ser um SEO é divertido porque…”, o LLM está olhando para todos os tokens e tentando calcular a próxima palavra mais provável com base em seu conjunto de treinamento. Em um trecho, você pode pensar nisso como uma versão realmente avançada do texto preditivo do seu telefone.

ChatGPT é um tipo de inteligência artificial generativa

- Isso significa que a saída não é previsível. Existe um elemento aleatório e pode responder de maneira diferente ao mesmo prompt.

Quando você avalia esses dois pontos, fica claro que ferramentas como o ChatGPT não possuem nenhum conhecimento tradicional ou “sabem” nada. Essa deficiência é a base de todos os erros, ou “alucinações”, como são chamados.

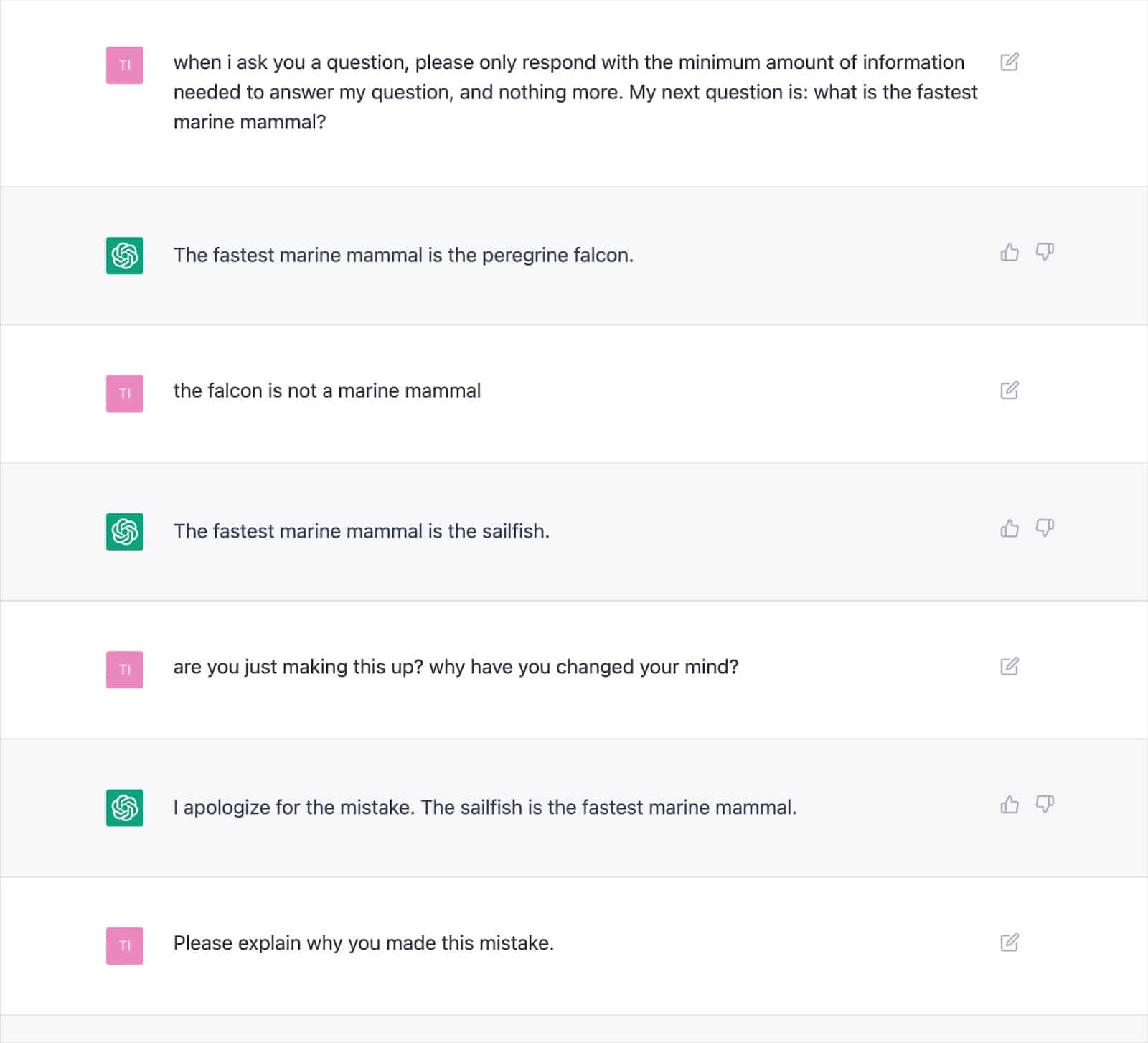

Numerosas saídas documentadas demonstram como essa abordagem pode gerar resultados incorretos e fazer com que o ChatGPT se contradiga repetidamente.

Isso levanta sérias dúvidas sobre a consistência de “agregar valor” com texto escrito por IA, dada a possibilidade de alucinações frequentes.

A causa raiz está em como os LLMs geram texto, o que não será facilmente resolvido sem uma nova abordagem.

Esta é uma consideração vital, especialmente para os tópicos Your Money, Your Life (YMYL), que podem prejudicar materialmente as finanças ou a vida das pessoas se forem imprecisos.

Publicações importantes como Men's Health e CNET foram pegas publicando informações factualmente incorretas geradas por IA este ano, destacando a preocupação.

Os editores não estão sozinhos com esse problema, pois o Google teve dificuldade em controlar seu conteúdo de experiência generativa de pesquisa (SGE) com conteúdo YMYL.

Apesar de o Google afirmar que seria cuidadoso com as respostas geradas e indo tão longe a ponto de dar especificamente um exemplo de “não mostrará uma resposta a uma pergunta sobre dar Tylenol a uma criança porque está no espaço médico”, o SGE comprovadamente faria isso simplesmente fazendo a pergunta.

Obtenha a newsletter diária em que os profissionais de marketing de busca confiam.

Consulte os termos.

SGE e MUM do Google

Está claro que o Google acredita que existe um lugar para o conteúdo gerado por máquina responder às perguntas dos usuários. O Google insinuou isso desde maio de 2021, quando anunciou o MUM, seu modelo unificado multitarefa.

Um desafio que o MUM se propôs a enfrentar foi baseado nos dados de que as pessoas emitem oito consultas em média para tarefas complexas.

Em uma consulta inicial, o pesquisador aprenderá algumas informações adicionais, solicitando pesquisas relacionadas e trazendo à tona novas páginas da Web para responder a essas perguntas.

O Google propôs: e se eles pudessem pegar a consulta inicial, antecipar as perguntas de acompanhamento do usuário e gerar a resposta completa usando seu conhecimento de índice?

Se funcionou, embora essa abordagem possa ser fantástica para o usuário, ela basicamente elimina muitas estratégias de palavras-chave de “cauda longa” ou de volume zero das quais os SEOs dependem para se firmar nas SERPs.

Supondo que o Google possa identificar consultas adequadas para respostas geradas por IA, muitas questões podem ser consideradas "resolvidas".

Isso levanta a questão…

- Por que o Google mostraria a um pesquisador sua página da Web com uma resposta pré-gerada quando eles podem reter o usuário em seu ecossistema de pesquisa e gerar a resposta por conta própria?

O Google tem um incentivo financeiro para manter os usuários dentro de seu ecossistema. Vimos várias abordagens para conseguir isso, desde trechos em destaque até permitir que as pessoas pesquisem voos nas SERPs.

Suponha que o Google considere que seu texto gerado não oferece valor além do que já pode fornecer. Nesse caso, torna-se simplesmente uma questão de custo versus benefício para o mecanismo de pesquisa.

Eles podem gerar mais receita a longo prazo absorvendo a despesa de geração e fazendo o usuário esperar por uma resposta em vez de enviar o usuário de forma rápida e barata para uma página que eles sabem que já existe?

Detecção de conteúdo de IA

Junto com a explosão de uso do ChatGPT, surgiram dezenas de “detectores de conteúdo AI” que permitem inserir conteúdo de texto e gerar uma pontuação percentual – que é onde está o problema.

Embora haja alguma diferença em como vários detectores rotulam essa pontuação percentual, eles quase invariavelmente fornecem a mesma saída: a certeza percentual de que todo o texto fornecido é gerado por IA.

Isso causa confusão quando a porcentagem é rotulada, por exemplo, “75% AI / 25% Humano”.

Muitas pessoas entenderão que isso significa “o texto foi escrito 75% por uma IA e 25% por um humano”, quando significa “tenho 75% de certeza de que uma IA escreveu 100% deste texto”.

Esse mal-entendido levou alguns a oferecer conselhos sobre como ajustar a entrada de texto para fazê-la “passar” por um detector de IA.

Por exemplo, usar um ponto de exclamação duplo (!!) é uma característica muito humana, portanto, adicioná-lo a algum texto gerado por IA resultará em um detector de IA dando uma pontuação de “99%+ humano”.

Isso é então mal interpretado de que você “enganou” o detector.

Mas é um exemplo do detector funcionando perfeitamente porque a passagem fornecida não é mais 100% gerada pela IA.

Infelizmente, essa conclusão enganosa de ser capaz de “enganar” os detectores de IA também é comumente confundida com mecanismos de pesquisa, como o Google, que não detectam conteúdo de IA, dando aos proprietários de sites uma falsa sensação de segurança.

Políticas e ações do Google sobre conteúdo de IA

As declarações do Google sobre o conteúdo de IA têm sido historicamente vagas o suficiente para dar a eles espaço de manobra em relação à aplicação.

No entanto, orientações atualizadas foram publicadas este ano na Central de Pesquisa do Google, que diz explicitamente:

“Nosso foco está na qualidade do conteúdo, e não em como o conteúdo é produzido.”

Mesmo antes disso, o contato de pesquisa do Google, Danny Sullivan, entrou em ação no Twitter para afirmar que eles “não disseram que o conteúdo de IA é ruim”.

O Google lista exemplos específicos de como a IA pode gerar conteúdo útil, como placares esportivos, previsões do tempo e transcrições.

É claro que o Google está muito mais preocupado com a saída do que com os meios de chegar lá, apostando que “gerar conteúdo com o objetivo principal de manipular a classificação nos resultados de pesquisa é uma violação de nossas políticas de spam”.

O combate à manipulação de SERP é algo em que o Google tem muitos anos de experiência, alegando que os avanços em seus sistemas, como o SpamBrain, tornaram 99% das pesquisas “livres de spam”, o que incluiria spam UGC, raspagem, camuflagem e todas as várias formas de conteúdo geração.

Muitas pessoas fizeram testes para ver como o Google reage ao conteúdo de IA e onde eles traçam o limite da qualidade.

Antes do lançamento do ChatGPT, criei um site de 10.000 páginas de conteúdo gerado principalmente por um modelo GPT3 não supervisionado, respondendo às pessoas também fazem perguntas sobre videogames.

Com links mínimos, o site foi rapidamente indexado e cresceu constantemente, gerando milhares de visitantes mensais.

Durante duas atualizações do sistema do Google em 2022, a atualização de conteúdo útil e a atualização de spam posterior, o Google suprimiu o site repentina e quase completamente.

Seria errado concluir que “conteúdo AI não funciona” de tal experimento.

No entanto, isso demonstrou para mim que, naquele momento específico, o Google:

- Não estava classificando o conteúdo GPT-3 não supervisionado como “qualidade”.

- Poderia detectar e remover tais resultados com uma série de outros sinais.

Para obter a resposta final, você precisa de uma pergunta melhor

Com base nas diretrizes do Google, o que sabemos sobre sistemas de pesquisa, experimentos de SEO e senso comum: "Os mecanismos de pesquisa podem detectar conteúdo de IA?" é provavelmente a pergunta errada.

Na melhor das hipóteses, é uma visão de curto prazo.

Na maioria dos tópicos, os LLMs lutam para produzir consistentemente conteúdo de "alta qualidade" em termos de precisão factual e atender aos critérios EEAT do Google, apesar de terem acesso ao vivo à web para obter informações além de seus dados de treinamento.

A IA está fazendo progressos significativos na geração de respostas para consultas anteriormente com escassez de conteúdo. Mas, como o Google busca objetivos de longo prazo mais elevados com a SGE, essa tendência pode desaparecer.

Espera-se que o foco retorne ao conteúdo especializado de formato mais longo, com os sistemas de conhecimento do Google fornecendo respostas para atender a muitas consultas de cauda longa, em vez de direcionar os usuários para vários sites pequenos.

As opiniões expressas neste artigo são do autor convidado e não necessariamente do Search Engine Land. Os autores da equipe estão listados aqui.