Como melhorar a eficiência de rastreamento e indexação em nível empresarial

Publicados: 2023-07-13O SEO corporativo segue regras diferentes.

Estratégias que podem funcionar para sites pequenos ou de nicho nem sempre funcionam em grande escala.

Então, o que exatamente pode acontecer quando o SEO corporativo fica muito grande ?

Neste artigo, compartilharei três exemplos da vida real. Em seguida, você aprenderá um potencial antídoto para um gerenciamento mais eficiente de SEO em escala.

Enfrentando o dilema da indexação

Pequenos sites tendem a crescer uma página de cada vez, usando palavras-chave como os blocos de construção de uma estratégia de SEO.

Grandes sites geralmente adotam abordagens mais sofisticadas, apoiando-se fortemente em sistemas, regras e automação.

É fundamental alinhar o SEO com os objetivos de negócios. Medir o sucesso de SEO com base em classificações de palavras-chave ou tráfego leva a consequências negativas devido ao excesso de indexação.

Não existe uma fórmula mágica para determinar o número ideal de URLs indexados. O Google não define um limite máximo.

Um bom ponto de partida, no entanto, é considerar a saúde geral do funil de SEO. Se um site…

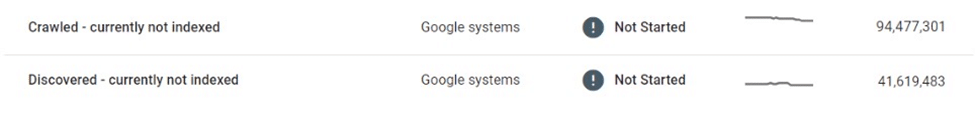

- Envia dezenas ou centenas de milhões ou até bilhões de URLs para o Google

- Classifica apenas para alguns milhões de palavras-chave

- Recebe visitas a alguns milhares de páginas

- Converte uma fração deles (se houver)

…então é uma boa indicação de que você precisa atender a algumas necessidades sérias de saúde de SEO.

Corrigir qualquer problema de higiene do site agora deve evitar problemas de SEO ainda maiores mais tarde.

Vejamos três exemplos reais de SEO corporativo que ilustram por que isso é tão importante.

Caso 1: Consequências da indexação excessiva de conteúdo de baixa qualidade

O Google tem recursos limitados para rastreamento e processamento da web. Eles priorizam o conteúdo valioso para os usuários.

O Google pode rastrear, mas não indexar, páginas que considera finas, duplicadas ou de baixa qualidade.

Se forem apenas algumas páginas, não há problema. Mas se for generalizado, o Google pode ignorar tipos inteiros de páginas ou a maior parte do conteúdo do site.

Em um exemplo, um mercado de comércio eletrônico descobriu que dezenas de milhões de suas páginas de listagem foram afetadas pelo rastreamento e indexação seletivos.

Depois de rastrear milhões de páginas de listas estreitas e quase duplicadas e não indexá-las, o Google finalmente reduziu o rastreamento do site completamente, deixando muitos no limbo “Descobertos – atualmente não indexados”.

Esse mercado dependia fortemente dos mecanismos de pesquisa para promover novas listagens aos usuários. Novos conteúdos não estavam mais sendo descobertos, o que representava um desafio comercial significativo.

Algumas medidas imediatas foram tomadas, como melhorar a vinculação interna e implantar mapas de site XML dinâmicos. Em última análise, essas tentativas foram inúteis.

A solução real exigia o controle do volume e da qualidade do conteúdo indexável.

Caso 2: Consequências imprevistas da interrupção do rastreamento

Ao parar o rastreamento, o conteúdo indesejado permanecerá no índice do Google – mesmo que seja alterado, redirecionado ou excluído.

Muitos sites usam redirecionamentos em vez de erros 404 para conteúdo removido para manter a autoridade. Essa tática pode espremer tráfego adicional de páginas fantasmas por meses, se não anos.

No entanto, isso às vezes pode dar terrivelmente errado.

Por exemplo, um conhecido mercado global que vende produtos artesanais revelou acidentalmente as informações privadas dos vendedores (por exemplo, nome, endereço, e-mail, número de telefone) em versões localizadas de suas páginas de listagens. Algumas dessas páginas foram indexadas e armazenadas em cache pelo Google, exibindo informações de identificação pessoal (PII) nos resultados de pesquisa, comprometendo a segurança e a privacidade do usuário.

Como o Google não rastreou novamente essas páginas, removê-las ou atualizá-las não as eliminaria do índice. Mesmo meses após a exclusão, o conteúdo em cache e os dados PII do usuário continuaram existindo no índice do Google.

Em uma situação como essa, era responsabilidade do mercado corrigir os bugs e trabalhar diretamente com o Google para remover conteúdo confidencial da Pesquisa.

Caso 3: os riscos de indexar excessivamente as páginas de resultados de pesquisa

A indexação descontrolada de grandes volumes de páginas finas e de baixa qualidade pode sair pela culatra – mas e a indexação de páginas de resultados de pesquisa?

O Google não endossa a indexação de resultados de pesquisa interna, e muitos SEOs experientes desaconselham fortemente essa tática. No entanto, muitos sites grandes se apoiaram fortemente na pesquisa interna como seu principal driver de SEO, geralmente gerando retornos substanciais.

Se as métricas de engajamento do usuário, a experiência da página e a qualidade do conteúdo forem altas o suficiente, o Google pode fechar os olhos. Na verdade, há evidências suficientes para sugerir que o Google pode até preferir uma página de resultados de pesquisa interna de alta qualidade a uma página de listagem estreita.

No entanto, essa estratégia também pode dar errado.

Certa vez, vi um site de leilão local perder uma parte significativa de sua classificação na página de pesquisa – e mais de um terço de seu tráfego de SEO – da noite para o dia.

A regra 20/80 se aplica ao fato de que uma pequena parte dos termos principais é responsável pela maioria das visitas de SEO aos resultados de pesquisa indexados. No entanto, muitas vezes é a cauda longa que compõe a maior parte do volume da URL e possui algumas das taxas de conversão mais altas.

Como resultado, dos sites que utilizam essa tática, poucos impõem limites rígidos ou regras na indexação de páginas de busca.

Isso coloca dois grandes problemas:

- Qualquer consulta de pesquisa pode gerar uma página válida, o que significa que um número infinito de páginas pode ser gerado automaticamente.

- Todos eles são indexáveis no Google.

No caso de um mercado de classificados que monetizou suas páginas de pesquisa com anúncios de terceiros, essa vulnerabilidade foi bem explorada por meio de uma forma de arbitragem de anúncios:

- Um número enorme de URLs de pesquisa foi gerado para termos obscuros, adultos e totalmente ilícitos.

- Embora essas páginas geradas automaticamente não retornassem resultados de inventário reais, elas veicularam anúncios de terceiros e foram otimizadas para classificar as consultas de pesquisa solicitadas por meio de modelo de página e metadados.

- Backlinks foram criados para essas páginas a partir de fóruns de baixa qualidade para que fossem descobertos e rastreados por bots.

- Os usuários que acessavam essas páginas do Google clicavam nos anúncios de terceiros e seguiam para os sites de baixa qualidade que eram o destino pretendido.

Quando o esquema foi descoberto, a reputação geral do site havia sido prejudicada. Ele também foi atingido por várias penalidades e sofreu quedas maciças no desempenho de SEO.

Abraçando a indexação gerenciada

Como esses problemas poderiam ter sido evitados?

Uma das melhores maneiras de sites de grandes empresas prosperarem em SEO é diminuindo a escala por meio da indexação gerenciada.

Para um site de dezenas ou centenas de milhões de páginas, é crucial ir além de uma abordagem focada em palavras-chave para uma orientada por dados, regras e automação.

Indexação baseada em dados

Uma vantagem significativa dos grandes sites é a riqueza de dados de pesquisa interna à sua disposição.

Em vez de depender de ferramentas externas, eles podem utilizar esses dados para entender a demanda de pesquisa regional e sazonal e as tendências em um nível granular.

Esses dados, quando mapeados para o inventário de conteúdo existente, podem fornecer um guia robusto para qual conteúdo indexar, bem como quando e onde fazê-lo.

Desduplicar e consolidar

Um pequeno número de URLs confiáveis e de alto escalão é muito mais valioso do que um grande volume de páginas espalhadas pelas 100 principais.

Vale a pena consolidar páginas semelhantes usando canônicos, aproveitando regras e automação para isso. Algumas páginas podem ser consolidadas com base em pontuações de similaridade, outras – agrupadas se forem classificadas coletivamente para consultas semelhantes.

A chave aqui é a experimentação. Ajuste a lógica e revise os limites ao longo do tempo.

Limpe páginas de conteúdo finas e vazias

Quando presentes em grandes volumes, páginas finas e vazias podem causar danos significativos à higiene e ao desempenho do site.

Se for muito desafiador aprimorá-los com conteúdo valioso ou consolidá-los, eles devem ser não indexados ou até mesmo proibidos.

Reduza espaços infinitos com robots.txt

Quinze anos depois que o Google escreveu pela primeira vez sobre “espaços infinitos”, a questão da superindexação de filtros, classificação e outras combinações de parâmetros continua a atormentar muitos sites de comércio eletrônico.

Em casos extremos, os rastreadores podem travar os servidores enquanto tentam acessar esses links. Felizmente, isso pode ser facilmente resolvido por meio do robots.txt.

Renderização do lado do cliente

Usar a renderização do lado do cliente para determinados componentes na página que você não deseja indexar pelos mecanismos de pesquisa pode ser uma opção. Considere isso cuidadosamente.

Melhor ainda, esses componentes devem estar inacessíveis para usuários desconectados.

As apostas aumentam dramaticamente à medida que a escala aumenta

Embora o SEO seja frequentemente percebido como uma fonte “gratuita” de tráfego, isso é um tanto enganoso. Custa dinheiro para hospedar e servir conteúdo.

Os custos podem ser insignificantes por URL, mas quando a escala atinge centenas de milhões ou bilhões de páginas, os centavos começam a se transformar em números reais.

Embora o ROI de SEO seja difícil de medir, um centavo economizado é um centavo ganho, e a economia de custos por meio de rastreamento e indexação gerenciados deve ser um fator ao considerar estratégias de indexação para sites grandes.

Uma abordagem pragmática de SEO – com rastreamento e indexação bem gerenciados, guiados por dados, regras e automação – pode proteger sites grandes de erros dispendiosos.

As opiniões expressas neste artigo são do autor convidado e não necessariamente do Search Engine Land. Os autores da equipe estão listados aqui.