Cum să îmbunătățiți eficiența accesării cu crawlere și a indexării la nivel de întreprindere

Publicat: 2023-07-13Enterprise SEO joacă după reguli diferite.

Strategiile care pot funcționa pentru site-uri web mici sau de nișă nu vor funcționa întotdeauna la scară.

Deci, ce se poate întâmpla exact când SEO pentru întreprinderi devine prea mare ?

În acest articol, voi împărtăși trei exemple din viața reală. Apoi, veți învăța un potențial antidot pentru un management mai eficient al SEO la scară.

Înfruntând dilema de indexare

Site-urile mici tind să crească câte o pagină, folosind cuvinte cheie ca elemente de bază ale unei strategii SEO.

Site-urile mari adoptă adesea abordări mai sofisticate, bazându-se mult pe sisteme, reguli și automatizări.

Este esențial să aliniați SEO cu obiectivele de afaceri. Măsurarea succesului SEO pe baza clasării cuvintelor cheie sau a traficului duce la consecințe negative din cauza supraindexării.

Nu există o formulă magică pentru a determina numărul optim de adrese URL indexate. Google nu stabilește o limită superioară.

Cu toate acestea, un bun punct de plecare este să luați în considerare starea generală de sănătate a pâlniei SEO. Dacă un site...

- Trimite zeci sau sute de milioane sau chiar miliarde de adrese URL către Google

- Se clasează doar pentru câteva milioane de cuvinte cheie

- Primește vizite la câteva mii de pagini

- Convertește o fracțiune din acestea (dacă există)

… atunci este un bun indiciu că trebuie să vă adresați unor nevoi serioase de sănătate SEO.

Remedierea oricăror probleme de igienă a site-ului acum ar trebui să prevină probleme SEO și mai mari ulterior.

Să ne uităm la trei exemple reale de SEO pentru întreprinderi care ilustrează de ce acest lucru este atât de important.

Cazul 1: Consecințele supraindexării conținutului de calitate scăzută

Google are resurse limitate pentru accesarea cu crawlere și procesare pe web. Ei acordă prioritate conținutului care este valoros pentru utilizatori.

Google poate accesa cu crawlere, dar nu indexează, paginile pe care le consideră subțiri, duplicate sau de calitate scăzută.

Dacă sunt doar câteva pagini, nu este o problemă. Dar dacă este larg răspândit, Google ar putea ignora tipurile întregi de pagini sau majoritatea conținutului site-ului.

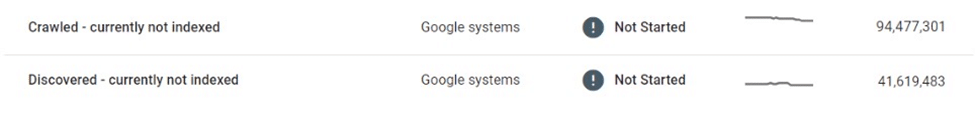

Într-un caz, o piață de comerț electronic a constatat că zeci de milioane de pagini de listă ale sale au fost afectate de accesarea cu crawlere și indexare selectivă.

După ce a accesat cu crawlere milioane de pagini de listări subțiri, aproape duplicate și nu le-a indexat, Google a redus în cele din urmă la accesarea cu crawlere a site-ului web, lăsând multe în limbul „Descoperit – momentan neindexat”.

Această piață s-a bazat în mare măsură pe motoarele de căutare pentru a promova noi listări către utilizatori. Conținut nou nu mai era descoperit, ceea ce a reprezentat o provocare semnificativă pentru afaceri.

Au fost luate câteva măsuri imediate, cum ar fi îmbunătățirea legăturilor interne și implementarea sitemap-urilor XML dinamice. În cele din urmă, aceste încercări au fost zadarnice.

Soluția reală a necesitat controlul volumului și calității conținutului indexabil.

Cazul 2: Consecințele neprevăzute ale târârii încetează

Când accesarea cu crawlere se oprește, conținutul nedorit va rămâne în indexul Google – chiar dacă este modificat, redirecționat sau șters.

Multe site-uri web folosesc redirecționări în loc de erori 404 pentru conținutul eliminat pentru a menține autoritatea. Această tactică poate stoarce trafic suplimentar din paginile fantomă luni, dacă nu ani.

Cu toate acestea, uneori acest lucru poate merge groaznic de rău.

De exemplu, o piață globală binecunoscută care vinde produse artizanale a dezvăluit accidental informațiile private ale vânzătorilor (de exemplu, numele, adresa, e-mailul, numărul de telefon) pe versiunile localizate ale paginilor lor de listări. Unele dintre aceste pagini au fost indexate și stocate în cache de Google, afișând informații de identificare personală (PII) în rezultatele căutării, compromițând siguranța și confidențialitatea utilizatorilor.

Deoarece Google nu a accesat din nou cu crawlere aceste pagini, eliminarea sau actualizarea acestora nu le-ar elimina din index. Chiar și la câteva luni după ștergere, conținutul stocat în cache și datele PII ale utilizatorilor au continuat să existe în indexul Google.

Într-o situație ca aceasta, era responsabilitatea pieței să remedieze erorile și să lucreze direct cu Google pentru a elimina conținutul sensibil din Căutare.

Cazul 3: Riscurile supraindexării paginilor cu rezultatele căutării

Indexarea necontrolată a unor volume mari de pagini subțiri, de calitate scăzută, se poate întoarce înapoi – dar cum rămâne cu indexarea paginilor cu rezultatele căutării?

Google nu susține indexarea rezultatelor căutării interne și mulți SEO experimentați ar sfătui cu tărie împotriva acestei tactici. Cu toate acestea, multe site-uri mari s-au sprijinit foarte mult pe căutarea internă ca principal motor SEO, generând adesea profituri substanțiale.

Dacă valorile privind implicarea utilizatorilor, experiența paginii și calitatea conținutului sunt suficient de ridicate, Google poate închide ochii. De fapt, există suficiente dovezi care să sugereze că Google ar putea prefera chiar o pagină cu rezultate de căutare internă de înaltă calitate, în locul unei pagini de listă subțire.

Cu toate acestea, această strategie poate merge prost, de asemenea.

Am văzut odată că un site de licitații local a pierdut o parte semnificativă din clasamentul paginii de căutare – și mai mult de o treime din traficul său SEO – peste noapte.

Regula 20/80 se aplică prin aceea că o mică parte din termenii principali reprezintă majoritatea vizitelor SEO la rezultatele căutării indexate. Cu toate acestea, deseori coada lungă reprezintă cea mai mare parte a volumului URL-urilor și se mândrește cu unele dintre cele mai mari rate de conversie.

Ca urmare, dintre site-urile care utilizează această tactică, puține impun limite sau reguli stricte privind indexarea paginilor de căutare.

Acest lucru pune două probleme majore:

- Orice interogare de căutare poate genera o pagină validă, ceea ce înseamnă că un număr infinit de pagini pot fi generate automat.

- Toate sunt indexabile în Google.

Într-un caz de piață de anunțuri clasificate care a monetizat paginile sale de căutare cu anunțuri de la terți, această vulnerabilitate a fost bine exploatată printr-o formă de arbitraj publicitar:

- Un număr enorm de adrese URL de căutare au fost generate pentru termeni dubios, adulți și complet iliciți.

- Deși aceste pagini generate automat nu au returnat rezultate reale ale inventarului, ele au difuzat anunțuri terță parte și au fost optimizate pentru a se clasa pentru interogările de căutare solicitate prin șablon de pagină și metadate.

- Backlink-urile au fost create către aceste pagini de pe forumuri de calitate scăzută pentru a le face descoperite și accesate cu crawlere de către roboți.

- Utilizatorii care ajungeau pe aceste pagini de la Google făceau clic pe anunțurile terțelor părți și mergeau la site-urile de calitate scăzută care erau destinația dorită.

Până când schema a fost descoperită, reputația generală a site-ului fusese deteriorată. De asemenea, a fost lovit de mai multe penalități și a susținut scăderi masive ale performanței SEO.

Adoptarea indexării gestionate

Cum ar fi putut fi evitate aceste probleme?

Una dintre cele mai bune modalități prin care site-urile mari de companii să prospere în SEO este reducerea la scară prin indexarea gestionată.

Pentru un site de zeci sau sute de milioane de pagini, este esențial să treceți dincolo de o abordare axată pe cuvinte cheie la una bazată pe date, reguli și automatizare.

Indexare bazată pe date

Un avantaj semnificativ al site-urilor mari este bogăția de date de căutare interne pe care le au la dispoziție.

În loc să se bazeze pe instrumente externe, ei pot utiliza aceste date pentru a înțelege cererea și tendințele de căutare regionale și sezoniere la un nivel granular.

Aceste date, atunci când sunt mapate la inventarul de conținut existent, pot oferi un ghid solid pentru conținutul de indexat, precum și când și unde să faceți acest lucru.

Deduplicați și consolidați

Un număr mic de adrese URL cu autoritate, de rang înalt este mult mai valoros decât un volum mare de pagini împrăștiate în primele 100.

Merită să consolidați pagini similare folosind canonice, utilizând reguli și automatizări pentru a face acest lucru. Unele pagini pot fi consolidate pe baza scorurilor de similaritate, altele – grupate împreună dacă se clasează în mod colectiv pentru interogări similare.

Cheia aici este experimentarea. Modificați logica și revizuiți pragurile în timp.

Curățați paginile de conținut subțiri și goale

Atunci când sunt prezente în volume masive, paginile subțiri și goale pot provoca daune semnificative igienei și performanței site-ului.

Dacă este prea dificil să le îmbunătățim cu conținut valoros sau să le consolidați, atunci ar trebui să nu fie indexate sau chiar interzise.

Reduceți spațiile infinite cu robots.txt

La cincisprezece ani după ce Google a scris pentru prima dată despre „spații infinite”, problema supraindexării filtrelor, sortării și a altor combinații de parametri continuă să afecteze multe site-uri de comerț electronic.

În cazuri extreme, crawlerele pot bloca serverele în timp ce încearcă să-și croiască drum prin aceste legături. Din fericire, acest lucru poate fi rezolvat cu ușurință prin robots.txt.

Redare pe partea clientului

Utilizarea redării pe partea client pentru anumite componente de pe pagină pe care nu doriți să le indexeze de motoarele de căutare ar putea fi o opțiune. Luați în considerare acest lucru cu atenție.

Mai bine, aceste componente ar trebui să fie inaccesibile pentru utilizatorii deconectați.

Mizele cresc dramatic pe măsură ce scara crește

În timp ce SEO este adesea perceput ca o sursă „gratuită” de trafic, acest lucru este oarecum înșelător. Costă bani să găzduiești și să difuzezi conținut.

Costurile pot fi neglijabile pe adresă URL, dar odată ce scara atinge sute de milioane sau miliarde de pagini, banii încep să se adună la cifre reale.

Deși rentabilitatea investiției SEO este dificil de măsurat, un ban economisit este un ban, iar economiile de costuri prin accesarea cu crawlere și indexare gestionate ar trebui să fie un factor atunci când luați în considerare strategiile de indexare pentru site-uri mari.

O abordare pragmatică a SEO – cu crawling și indexare bine gestionate, ghidate de date, reguli și automatizare – poate proteja site-urile mari de greșeli costisitoare.

Opiniile exprimate în acest articol sunt cele ale autorului invitat și nu neapărat Search Engine Land. Autorii personalului sunt enumerați aici.