Cum se remediază avertismentul „Googlebot nu poate accesa fișierele CSS și JS” în WordPress?

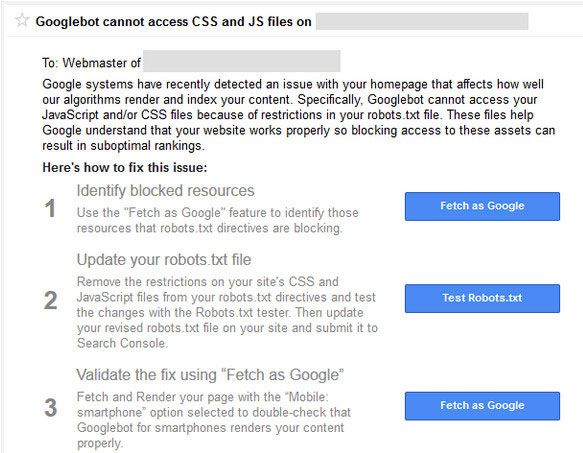

Publicat: 2015-10-15Dacă utilizați site-ul sau blogul WordPress, probabil că ați primit în trecut un avertisment din partea echipei consolei Căutării Google (sau veți primi) spunând că Googlebot nu poate accesa fișierele CSS și JS de pe domeniul dvs.

Nu vă alarmați dacă ați primit acest avertisment de la Google. Sună prost, dar există o soluție ușoară pentru asta. Mesajul de e-mail conține linkuri către instrucțiuni despre cum să remediați această problemă. Dar aceste instrucțiuni nu sunt foarte ușor de urmat .

Google bot și alți păianjeni de căutare vor vizita fișierul robots.txt de pe site-ul dvs. web imediat după ce au lovit fișierul htaccess.

Htaccess are reguli pentru blocarea adreselor IP, redirecționarea adreselor URL, activarea compresiei gzip etc. Robotul.txt va avea un set de reguli și pentru motoarele de căutare . Acestea sunt motivul pentru care ați primit „Googlebot nu poate accesa fișierele CSS și JS”.

Robots.txt are câteva linii care vor bloca sau vor permite accesarea cu crawlere a fișierelor și a directoarelor . Google a început să penalizeze site-urile web care blochează accesarea cu crawlere a fișierelor js și css. JavaScript și foile de stil în cascadă sunt responsabile pentru redarea site-ului dvs. web și se ocupă de formulare, evenimente de incendiu etc.

Dacă JS este blocat, botul Google nu va putea să acceseze cu crawlere codul și va considera codul ca spam sau încălcare a schemelor de legături. Aceeași logică se aplică fișierelor CSS.

Dacă nu ați primit încă acest e-mail de avertizare, în loc să așteptați e-mailul , puteți lua măsuri imediat.

Ce este WordPress Robots.txt?

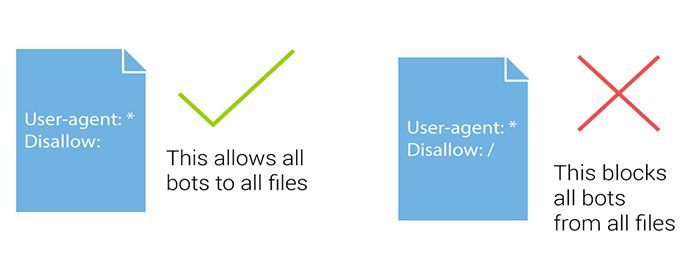

Fișierul Robots.txt ajută roboții motoarelor de căutare să direcționeze ce parte să acceseze cu crawlere și ce parte să evite. Când botul de căutare sau păianjenul motorului de căutare vine pe site-ul dvs. și dorește să vă indexeze site-ul, acesta urmărește mai întâi fișierul robots.txt.

Căutarea robotului sau a păianjenului urmează această direcție a fișierelor pentru indexarea sau lipsa indexării oricărei pagini a site-ului dvs. web. Dacă utilizați WordPress , veți găsi fișierul Robots.txt în rădăcina instalării dvs. WordPress.

Dacă nu aveți robots.txt, puteți crea pur și simplu un nou fișier de notepad și îl puteți numi Robots.txt. Apoi, pur și simplu încărcați-l în directorul rădăcină al domeniului dvs. utilizând FTP sau direct prin managerul de fișiere cPanel.

Puteți edita fișierul WordPress robots.txt conectându-vă la contul FTP al serverului, utilizând cPanel sau puteți utiliza pluginul. Există puține lucruri pe care ar trebui să le adăugați în fișierul robots.txt împreună cu adresa URL a sitemap-ului.

Adăugarea adresei URL a sitemap-ului ajută roboții motoarelor de căutare să găsească fișierul dvs. de sitemap și astfel să indexeze mai rapid postarea și paginile dvs. Iată un exemplu de fișier robots.txt . În sitemap, înlocuiți adresa URL a sitemapului cu adresa URL a blogului dvs.:

Agent utilizator: * # interzice toate fișierele din aceste directoare Nu permiteți: / cgi-bin / Nu permiteți: / wp-admin / Nu permiteți: / archives / interzice: / *? * Nu permiteți: *? Replytocom Nu permiteți: / wp- * Nu permiteți: / comments / feed / Agent-utilizator: Googlebot-Image Permiteți: / wp-content / uploads / Utilizator-agent: Adsbot-Google Permite: / Agent-utilizator: Googlebot-Mobile Permite: /

sitemap: https://www.kasareviews.com/sitemap.xml

De ce Google are nevoie de acces la fișierele CSS și JS?

Blocarea CSS și a JavaScript-ului a fost un Google nu, de când a fost scris în Ghidul pentru webmasteri în octombrie trecut. Abia recent, compania a emis avertismente cu privire la aceasta.

Dacă site-ul dvs. a blocat Googlebot de la accesarea acelor fișiere, atunci este bine să știți despre el, astfel încât să puteți rezolva problema.

Google se concentrează pe oferirea de clasamente mai bune site-urilor web ușor de utilizat. Site-urile care sunt rapide, au o experiență bună a utilizatorului etc. Pentru a determina experiența utilizatorului unui site web, Google are nevoie de acces pentru a putea vizita fișierele CSS și JavaScript ale site-ului.

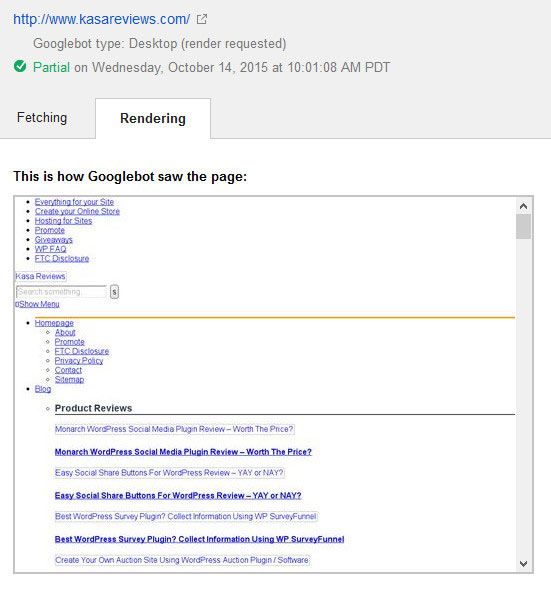

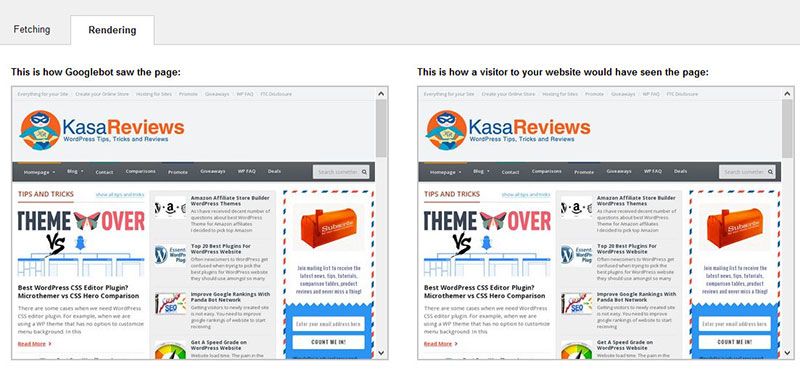

Acesta a fost modul în care Google a văzut site-ul Kasa Reviews înainte de remediere

În mod implicit, WordPress nu blochează accesarea roboților de căutare la orice fișier CSS sau JS. Cu toate acestea, unii proprietari de site-uri le pot bloca accidental în timp ce încearcă să adauge măsuri de securitate suplimentare sau utilizând un plugin de securitate WordPress.

Aceasta restricționează Googlebot de la indexarea fișierelor CSS și JS care pot afecta performanța SEO a site-ului dvs. Există o soluție ușoară pentru aceasta și implică editarea fișierului robots.txt al site-ului dvs.

Cum se remediază avertismentul „Googlebot nu poate accesa fișierele CSS și JS”?

Dacă termenii precum robots.txt sună noi pentru dvs., nu vă faceți griji, deoarece nu sunteți singur. Este o limbă obișnuită în industria SEO, dar nu atât de populară printre bloggeri.

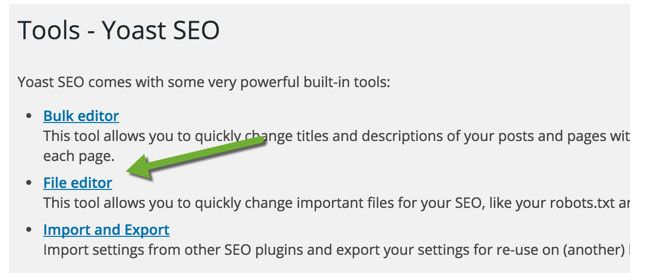

Pentru blogul WordPress, puteți edita fișierul robots.txt folosind FTP, cum ar fi FileZilla, folosind cPanel (consultați argumentele pro și contra cPanel) sau puteți utiliza funcția de editor de fișiere SEO de Yoast (verificați comparația Yoast vs Rank Math).

Pluginul Yoast SEO vă permite să editați fișierul robots.txt și .htaccess din tabloul de bord WordPress. În interiorul tabloului de bord WordPress, faceți clic pe SEO> Instrumente și faceți clic pe editorul de fișiere

Pe această pagină, puteți vizualiza și edita fișierul robots.txt. În majoritatea cazurilor, trebuie să eliminați următoarea linie : Disallow: / wp-includes /

În funcție de modul în care ați configurat fișierul robots.txt, acesta va remedia majoritatea avertismentelor. Cel mai probabil veți vedea că site-ul dvs. a interzis accesul la unele directoare WordPress ca acesta:

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/plugins/

Disallow: /wp-content/themes/

Unii utilizatori pot observa că fișierul lor robots.txt este fie gol, fie că nici măcar nu există. Dacă Googlebot nu găsește un fișier robots.txt, atunci crawlează automat și indexează toate fișierele.

Atunci de ce vezi acest avertisment? În rare ocazii, unii furnizori de găzduire WordPress pot bloca proactiv accesul la folderele WordPress implicite pentru roboți. Puteți înlocui acest lucru în robots.txt permițând accesul la folderele blocate.

User-agent: *

Allow: /wp-includes/js/

După ce ați terminat, salvați fișierul robots.txt. Accesați instrumentul de preluare ca Google și faceți clic pe butonul de preluare și redare. Comparați acum rezultatele de preluare și veți vedea că majoritatea problemelor de resurse blocate ar trebui să dispară acum.

Iată cum Google redă Kasa Reviews după ce a editat și remediat fișierul robots.txt. De asemenea, ar trebui să vizați ca întregul site să fie redat integral.

După ce modificați fișierul robots.txt al blogului dvs., testați orice adresă URL a site-ului dvs. web cu testerul robots.txt al instrumentelor Google pentru webmasteri. Dacă găsiți erori sau dacă Googlebot nu este capabil să acceseze cu crawlere o resursă, instrumentul va evidenția linia care cauzează eroarea.

Pentru a elimina problema, ștergeți linia evidențiată. Sper că acest lucru a ajutat. Dacă aveți întrebări, nu ezitați să întrebați prin secțiunea de comentarii.