Testarea A/B mobilă: 7 mari erori și concepții greșite pe care trebuie să le evitați

Publicat: 2021-10-23

Nu este un secret pentru nimeni că, în general, marketingul se bazează în mare parte pe date. Același lucru este valabil și pentru marketingul mobil și achiziția de utilizatori. În acest domeniu, alegerea elementelor potrivite pentru pagina de produs pentru App Store și Google Play poate face o diferență crucială pentru succesul unei aplicații sau al unui joc mobil. Testarea A/B mobilă este un instrument care vă ajută să faceți această alegere pe baza datelor.

Cu toate acestea, de câte ori am auzit argumentul că testarea A/B nu aduce rezultatele dorite sau că cineva nu este sigur că efectuează experimente pe mobil, nu? Acest lucru se întâmplă adesea din cauza unor greșeli comune și interpretării greșite a datelor. În această postare, voi acoperi cele mai mari greșeli și concluzii înșelătoare în testarea A/B a aplicației mobile, cunoașterea cărora vă va ajuta să obțineți succes.

1. Finalizarea unui experiment înainte de a obține cantitatea potrivită de trafic

Aceasta este una dintre cele mai frecvente greșeli în testarea A/B mobilă. În cazul în care sunteți un adept al testării A/B clasice, finalizarea unui experiment înainte de a obține cantitatea necesară de trafic - dimensiunea eșantionului - prezintă riscul să obțineți rezultate nesigure din punct de vedere statistic .

Pentru a obține dovezi de încredere, trebuie să așteptați până când se ajunge la cantitatea necesară de trafic atât pentru variantele A cât și pentru B.

Dacă sunteți în căutarea unei alternative la opțiunea clasică, apelați la Testarea A/B secvențială. Va trebui să începeți cu specificarea ratei de conversie de bază (rata de conversie a variației dvs. curente), a puterii statistice (80% în mod implicit), a nivelului de semnificație și a efectului minim detectabil (MDE) – acest lucru vă va ajuta să determinați dimensiunea eșantionului.

Nivelul de semnificație este implicit de 5%, ceea ce înseamnă că marja de eroare nu va depăși 5%. Puteți personaliza această valoare împreună cu MDE – creșterea minimă așteptată a ratei de conversie pe care ați dori să o vedeți . Notă: nu modificați nivelul de semnificație, MDE sau puterea statistică după ce ați început un experiment.

Cu testarea A/B secvențială, algoritmul vă va verifica în mod constant variațiile privind nivelul de semnificație și cantitatea de trafic rămasă până la finalizarea experimentului. Așa funcționează pe platforma noastră de testare SplitMetrics A/B.

Lecție învățată: dacă rulați teste A/B clasice, nu finalizați un experiment până când nu ajungeți la cantitatea potrivită de trafic. Sau, încercați testarea A/B secvențială și veți putea verifica rezultatele în orice moment.

2. Terminarea unui experiment înainte de a trece 7 zile

De ce trebuie să așteptați cel puțin șapte zile? Ei bine, diverse aplicații și jocuri mobile înregistrează vârfuri de activitate în diferite zile ale săptămânii . De exemplu, aplicațiile de afaceri urmăresc exploziile de activitate în zilele de luni, în timp ce jocurile sunt cele mai populare în rândul utilizatorilor în weekend.

Pentru a obține rezultate fiabile din experimentele de testare A/B pentru dispozitive mobile, ar trebui să capturați zilele de vârf ale aplicației dvs. în timpul unui experiment. Altfel, riști să tragi concluzii.

De exemplu, executați teste pentru o aplicație de gestionare a sarcinilor. Începi un experiment miercuri și îl termini sâmbătă. Dar cea mai mare parte a publicului țintă folosește aplicația dvs. luni, așa că veți rata doar ideea, deoarece creșterea activității nu a intrat în perioada experimentului. Sau invers, ați rulat teste A/B pentru jocul dvs. de curse de vineri până duminică: în zilele de vârf ale jocului. În acest caz, rezultatele vor fi, de asemenea, inadecvate.

Deci, chiar dacă ați evitat greșeala numărul unu și ați obținut deja cantitatea necesară de trafic chiar în prima zi, nu opriți experimentul până nu trec șapte zile.

Lecție învățată: din cauza vârfurilor slabe ale activității, care variază pentru fiecare joc sau aplicație mobilă, nu finalizați un experiment înainte ca ciclul complet (de șapte zile) să fi trecut.

3. Testarea unor modificări prea mici în design

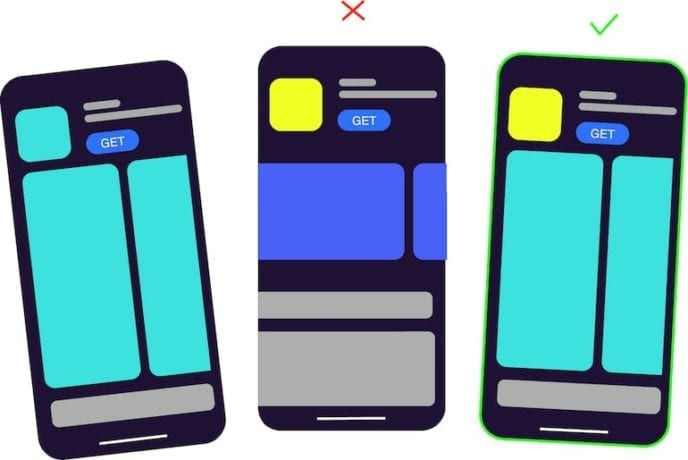

O greșeală încă obișnuită în testarea A/B mobilă este compararea variațiilor care arată aproape la fel din cauza diferențelor minore de design.

Dacă singura diferență între pictogramele aplicațiilor mobile pe care le testați este culoarea de fundal albastru în loc de albastru deschis sau ați adăugat un detaliu mic la o altă variantă de captură de ecran, cu siguranță aveți probleme. Utilizatorii pur și simplu nu observă schimbări atât de mici.

În acest caz, ambele variante vor arăta același rezultat și este perfect normal. Deci, dacă ați încercat vreodată să rulați testele A/B din magazinul de aplicații, dar apoi ați renunțat la ele, deoarece variațiile au avut rezultate egale, este timpul să reflectați asupra a ceea ce a mers prost. Poate că variațiile tale au arătat cam la fel.

Pentru a vă asigura că testați A/B o schimbare semnificativă, afișați ambele versiuni familiei sau prietenilor. Lăsați-vă colegul să se uite la fiecare variație timp de 3-5 secunde. Dacă ei nu cunosc diferența, ar fi bine să vă reproiectați elementele vizuale.

Lecție învățată: în cazul în care testați variații cu modificări prea mici în design, trebuie să vă așteptați ca acestea să arate același rezultat. Astfel de modificări sunt prea nesemnificative pentru utilizatori, așa că este mai bine să testați pictogramele aplicațiilor și capturile de ecran care diferă semnificativ unele de altele.

4. Anunțurile dvs. banner au același design ca unul dintre elementele vizuale ale magazinului de aplicații

Dacă utilizați un instrument de testare A/B mobil terță parte, cum ar fi, de exemplu, SplitMetrics, cumpărați trafic și plasați bannere în rețelele publicitare. Ideea este că un astfel de banner nu ar trebui să arate ca unul dintre activele vizuale pe care le testați , fie că este o captură de ecran sau aceleași elemente pe o pictogramă.

De exemplu, desfășurați experimente pentru aplicația dvs. educațională. Proiectați un banner care are același element, ca și pictograma din variația A, în timp ce varianta B este complet o altă pictogramă. Varianta A va afișa rata de conversie mai mare, deoarece are același design, așa cum l-au văzut inițial utilizatorii de banner și au făcut clic pe.

Studiile arată că, dacă oamenii văd ceva în mod repetat, creierul lor procesează informații mai repede, ceea ce le aduce un sentiment de plăcere. Puteți citi mai multe despre el aici. Deci, utilizatorii tind să atingă inconștient imaginile deja familiare.

Lecție învățată: atunci când lucrați la reclame banner, faceți designul cât mai neutru posibil. Designul bannerului nu trebuie să coincidă cu designul pictogramei aplicației dvs. sau cu variantele capturii de ecran.

5. Testarea mai multor ipoteze deodată

Nu are sens să faceți mai multe modificări și să le testați în cadrul aceluiași experiment. Unii marketeri mobile trag concluzii greșite după ce au efectuat un test, deoarece au făcut mai multe modificări și, de fapt, nu pot ști ce anume a afectat rezultatul.

Dacă ați decis să schimbați culoarea capturilor de ecran din pagina de produs din magazinul de aplicații, creați una sau câteva variații cu o altă culoare de fundal și executați un test. Nu schimbați culoarea, ordinea și textul de pe capturile de ecran în același timp. În caz contrar, veți vedea varianta câștigătoare (să fie varianta B) și nu veți avea nicio idee dacă schimbarea de culoare a funcționat de fapt.

Lecția învățată: dacă testezi mai multe ipoteze deodată, nu vei putea înțelege care dintre ele este corectă.

6. Interpretarea greșită a situației când două variante sunt aceleași, dar obțineți un câștigător

Când rulați teste A/A, este posibil să fiți confuz când un instrument de testare A/B arată variația câștigătoare între două active identice. În special, acest lucru este comun pentru instrumentul încorporat din Magazinul Google Play pentru rularea experimentelor.

Pe platforma SplitMetrics, la nivelul de semnificație de 5%, într-un astfel de caz, vei vedea că rezultatul este nesemnificativ.

Micile diferențe între două variații exact aceleași sunt pură coincidență. Diferiți utilizatori au reacționat puțin diferit. Este la fel ca să arunci o monedă: există o șansă de 50-50 să obții cap sau cozi și există o șansă de 50-50 ca una dintre variante să arate un rezultat mai bun.

Pentru a obține un rezultat semnificativ statistic într-o situație ca aceasta, ar trebui să obțineți rezultate de la absolut toți utilizatorii, ceea ce este imposibil.

Lecții învățate: dacă obțineți varianta câștigătoare atunci când testați active identice, nu este nimic în neregulă cu instrumentul dvs. de testare A/B, este doar o coincidență. Cu toate acestea, cu testarea A/B secvențială, veți vedea că rezultatul este nesemnificativ.

7. Supărarea când o nouă variație pierde în fața celei actuale

Unii agenți de marketing mobil și manageri de achiziții de utilizatori sunt dezamăgiți când un experiment arată că varianta actuală câștigă, ceea ce nu se așteptau, și încep să irosească un buget pentru mai mult trafic plătit în speranța că noua variantă va câștiga în cele din urmă.

Nu există niciun motiv să te simți prost dacă ipoteza ta nu a fost confirmată. Dacă ai fi schimbat ceva pe pagina produsului magazinului tău de aplicații fără a fi testat, ai fi pierdut o parte din potențialii tăi clienți și, în consecință, bani. În același timp, după ce ați cheltuit bani pentru acest experiment, ați plătit pentru cunoștințe . Acum știi ce funcționează pentru aplicația ta și ce nu.

Lecție învățată: totul se întâmplă cu un motiv și nu ar trebui să-ți pară rău dacă testul tău A/B nu ți-a confirmat ipoteza. Acum aveți o viziune clară asupra activelor care funcționează cel mai bine pentru jocul sau aplicația dvs.