Ce este bugetul de accesare cu crawlere [și cum să-l optimizezi]?

Publicat: 2022-05-16Bugetul de accesare cu crawlere este unul dintre acei termeni SEO despre care probabil ați auzit vorbind oamenii de marketing.

Totuși, știi ce înseamnă și despre ce este vorba?

Nu vă faceți griji, nu suntem aici pentru a vă testa. Dimpotrivă, suntem aici pentru a vă ajuta să înțelegeți totul despre bugetul de accesare cu crawlere, de ce este important și cum îl puteți verifica și optimiza.

La urma urmei, trebuie să înveți să te târăști înainte de a putea merge, nu?

Ce este Bugetul Crawl?

Bugetul de accesare cu crawlere este numărul de pagini pe care Google le poate accesa cu crawlere pe un site într-un anumit interval de timp.

Vedeți, de fiecare dată când publicați o pagină pe site-ul dvs., trebuie să așteptați ca Google să o indexeze și să o clasifice și, pentru a putea face acest lucru, roboții săi trebuie să o acceseze cu crawlere mai întâi.

Acest proces se poate întâmpla mai rapid sau mai lent, în funcție de circumstanțe precum cât de mare este site-ul dvs. web, cât de populare sunt subiectele, cât de mult trafic există către pagina dvs. etc.

Dar cum funcționează de fapt crawling-ul?

Să aflăm.

Cum funcționează crawlerele?

În urmă cu mai bine de 10 ani, Google și-a dat seama că are resurse limitate și că poate găsi doar un procent limitat din conținutul online fără sfârșit care este publicat în mod constant online.

Apoi, în 2017, Google a publicat articolul oficial „Ce înseamnă bugetul cu crawlere pentru Googlebot”, în care explică definiția lor despre crawling și alte detalii pertinente.

Iată faptele esențiale:

- Accesarea cu crawlere este eficientă, cu excepția cazului în care site-ul dvs. are mai mult de câteva mii de adrese URL

- Paginile care răspund rapid măresc limita de accesare cu crawlere

- Puteți reduce rata de accesare cu crawlere a site-ului dvs. prin Google Search Console

- Adresele URL populare tind să fie accesate cu crawlere mai des

- O abundență de adrese URL cu valoare redusă (conținut duplicat, pagini de eroare soft etc.) poate avea un impact negativ asupra indexării și accesării cu crawlere.

- Crawling-ul nu este un factor direct de clasare

Practic, pentru a asigura accesarea cu crawlere maximă a site-ului dvs., trebuie să aveți timpi de încărcare rapidi, să evitați conținutul duplicat și de calitate scăzută și să vă faceți paginile populare.

Cu toate acestea, este important să rețineți că majoritatea proprietarilor de site-uri web nu trebuie să fie prea preocupați de bugetul de accesare cu crawlere. Sunt site-urile mari cu mii de pagini, cum ar fi magazinele de comerț electronic, publicațiile digitale și blogurile populare, care ar trebui să acorde atenție.

De ce este important bugetul de accesare cu crawlere?

Bugetul de accesare cu crawlere este foarte important pentru eforturile dvs. de SEO, mai ales atunci când aveți mii de pagini și publicați în mod constant o mulțime de articole noi în fiecare zi. Boții vor dori să vă acceseze cu crawlere noul conținut, dar vor revizui simultan și restul site-ului dvs. web.

Dacă se confruntă cu mai multe eșecuri și/sau probleme care îi încurcă, vor rămâne blocați să irosească bugetul de accesare cu crawlere pe paginile vechi, în loc să-l investească în noul conținut pe care doriți să-l indexeze. Acest lucru poate, potențial, să creeze întârzieri și să facă temporar (sau chiar permanent) adresele URL indisponibile în SERP-uri.

De exemplu, publicați știri sau informații care sunt importante pentru a obține vizibilitate cât mai repede posibil.

Nu ai vrea să aștepți o săptămână pentru ca postarea ta să fie indexată, nu-i așa?

La urma urmei, nu te poți clasa pentru un SERP dacă pagina ta nu este indexată. Și să presupunem că scrii despre un eveniment mondial care a avut loc astăzi, dar pagina ta este accesată cu crawlere în cinci zile. În acel moment, este prea târziu pentru a-ți atinge obiectivul inițial, deoarece evenimentul nu mai este atât de relevant și de proaspăt. Ca să nu mai vorbim, multe alte site-uri web vor fi scris despre asta și au fost indexate în timp.

Nu este neobișnuit ca boții de accesare cu crawlere să dureze până la o săptămână pentru a indexa pagina dvs., dar sincer să fiu, ar trebui să dureze mai puțin timp decât atât.

În plus, între timp vei continua să postezi pagini noi care trebuie accesate cu crawlere, indexate și disponibile pentru publicul țintă, de asemenea, în timp util. Și aceasta este o rețetă pentru un blocaj de indexare.

Una peste alta, dacă atingeți adesea limitele bugetului de accesare cu crawlere, riscați ca unele dintre paginile dvs. să scape între fisuri și să nu ajungă la SERP-uri. Drept urmare, acestea nu vor beneficia de trafic organic și vor avea o vizibilitate mult mai mică decât restul conținutului dvs.

Și dacă vă întrebați cum să vă verificați bugetul de accesare cu crawlere - este ușor. Accesați Google Search Console și bifați Crawl → Crawl Statistics.

Optimizarea bugetului cu crawlere

Este important să rețineți că bugetul de accesare cu crawlere depinde de trei factori majori: dimensiunea site-ului, sănătatea site-ului și popularitatea site-ului.

Aceasta înseamnă că nu trebuie să vă faceți griji cu privire la risipa de buget cu crawlere, dacă:

- Site-ul dvs. este moderat de mic, adică mai puțin de câteva mii de pagini.

- Site-ul dvs. web nu conține erori de cod de stare și are o canonizare adecvată.

- Site-ul dvs. este popular, ceea ce înseamnă că ați dezvoltat o rețea de socializare și alte canale pentru a vă distribui conținutul și a genera trafic.

Acoperirea acestor criterii înseamnă că Googlebot ar trebui să poată accesa cu crawlere eficient site-ul dvs.

În cazul în care vă lipsește oricare dintre acești trei factori, există riscul să întâmpinați diferite niveluri de probleme de accesare cu crawlere și să pierdeți vizibilitatea căutării organice pentru unele dintre paginile dvs.

Iată câteva dintre cele mai bune practici privind bugetul de accesare cu crawlere de urmat:

Îmbunătățiți viteza site-ului dvs

După cum sa menționat mai sus, viteza site-ului și timpul de încărcare a paginii ar putea afecta limita de accesare cu crawlere. Un site web sănătos și rapid înseamnă că Googlebot poate accesa cu crawlere mai multe pagini și în mai puțin timp.

Pe de altă parte, încărcarea mai lentă a paginilor reduce rata de accesare cu crawlere și, într-un site web mare, acest lucru poate duce la probleme generale de indexare.

Pe scurt, asigurați-vă că vă optimizați viteza site-ului. Acest lucru nu numai că va face mai ușor pentru roboți, dar va îmbunătăți experiența utilizatorului.

Aplicați legătura internă

Cel mai bun scenariu este să aveți backlink-uri care să indice fiecare pagină de pe site-ul dvs. Aceasta nu este doar o practică SEO bună pentru a atrage vizitatori pe site-ul dvs. și pentru a le arăta motoarelor de căutare că conținutul dvs. contează, dar atrage și Googlebot.

Mai simplu spus, backlink-urile sunt băiatul de aur al SEO.

Dar aici e afacerea.

Pe lângă backlink, Google adoră și linkurile interne. Îl ajută să descopere toate paginile dvs. și să înțeleagă mai bine modul în care acestea sunt legate. Și în timp ce backlink-urile pot fi dificil de găsit, aveți control complet asupra celor interne și puteți adăuga câte doriți (nu exagerați).

Aplicarea acestei tehnici de optimizare va asigura că mai multe pagini sunt accesate cu crawlere.

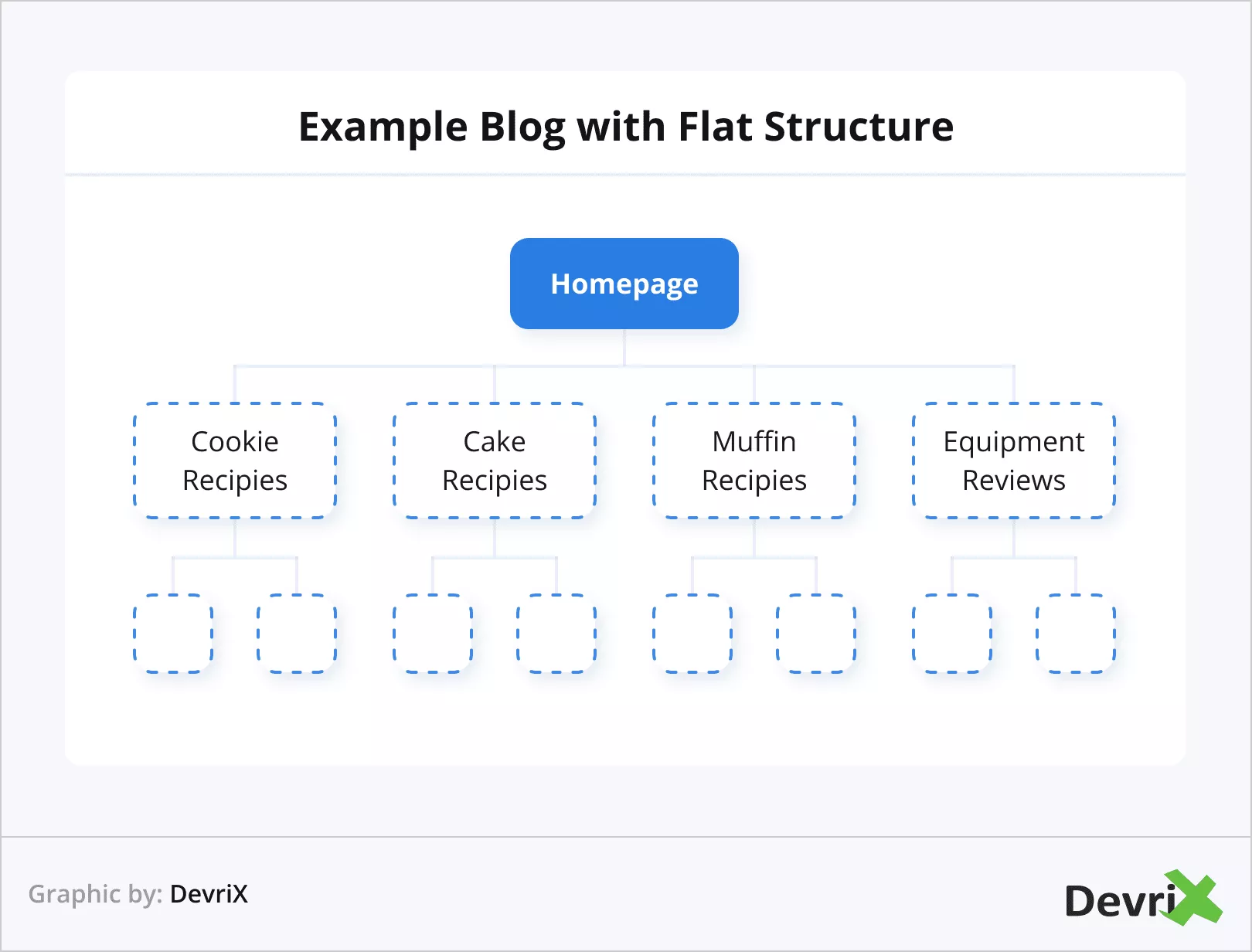

Utilizați arhitectura web plată

Popularitatea este foarte importantă în ochii Google. Acesta este motivul pentru care ar fi benefic să folosiți o arhitectură web plată. Arhitectura plată permite autorității linkurilor să aibă proporții egale pe toate paginile dvs.

Îi va ajuta pe roboții să urmărească modul în care link-urile de pe site-ul dvs. sunt conectate mai ușor și, în plus, vă permite să grupați mai bine paginile asociate și să obțineți autoritate de actualitate.

În practică, aceasta înseamnă că atât utilizatorii, cât și motoarele de căutare pot ajunge la orice pagină de pe site-ul dvs. în doar patru clicuri.

Evitați paginile orfane și conținutul duplicat

O pagină orfană este una care nu conține un singur link extern, nici intern. Acest lucru face ca aceste tipuri de pagini să fie izolate de restul conținutului dvs. și, în mod logic, sunt, de asemenea, mai greu de descoperit de Googlebot.

Puteți evita cu ușurință paginile orfane adăugând cel puțin un link intern la fiecare articol și pagină pe care o aveți.

Gestionați conținutul duplicat

Conținutul duplicat cauzează numeroase probleme. A avea mai multe adrese URL cu parametri similari este confuz pentru roboții de accesare cu crawlere. Acest lucru va pierde timpul Googlebot, deoarece va trebui să descopere care pagină este cea principală și care este o versiune duplicată, iar acest lucru va duce la un proces de accesare cu crawlere mai lent.

Pentru site-uri precum platformele de comerț electronic, unde este obișnuit să aveți mai multe adrese URL similare, datorită mai multor produse similare cu mici diferențe, cum ar fi dimensiunea și culoarea, asigurați-vă că utilizați etichete canonice, care vor ghida Googlebot către paginile pe care doriți să le acordați prioritate.

Nu permite accesarea cu crawlere pentru unele pagini

Fiecare site web are pagini precum autentificare, formulare de contact, coșuri de cumpărături și așa mai departe. Acestea nu trebuie să fie crawlate și, mai presus de aceasta, nu pot fi crawlate. Cu toate acestea, Google va încerca, așa că este o idee bună să anunțați roboții că ar trebui să le omite și să economisească resurse.

Pentru a efectua această acțiune, utilizați fișierul robots.txt pentru a interzice accesarea cu crawlere a paginilor dorite.

Actualizați vechi și scrieți conținut nou

Am menționat că Google îi place conținutul proaspăt? Da.

Google ar putea chiar să înceteze accesarea cu crawlere a paginii dvs., din cauza faptului că nu a fost nimic nou acolo în ultimele câteva ori când a fost accesată cu crawlere.

Imaginați-vă că Googlebot vă vizitează site-ul o dată la două zile și de fiecare dată când găsește conținut nou de indexat. Apoi, dintr-o dată, dintr-un motiv oarecare, încetați să vă actualizați site-ul. Cu toate acestea, Googlebot continuă să îl viziteze cu aceeași frecvență. După un timp, botul observă că nu există conținut nou de indexat și, în cele din urmă, face vizitele mai puțin frecvente.

În scenariul opus, în care începeți să oferiți conținut proaspăt mai des, Googlebot ar putea începe să vă viziteze site-ul mai des.

Sursă

În general, atunci când stabiliți ce pagini trebuie actualizate, țineți cont de relevanța – un articol ar putea avea doi ani și poate avea încă informații aplicabile (totuși ar trebui să îl actualizați). Sau ar putea fi un material vechi de o lună care și-a pierdut deja prospețimea.

Reduceți paginile de eroare

Acesta este simplu de înțeles.

Googlebot pierde timpul când încearcă să acceseze cu crawlere pagini cu coduri de eroare 5xx (eroare de server), coduri de eroare 4xx (eroare nu poate fi găsită), coduri de eroare 3xx (redirecționări) etc. și, ca urmare, acest lucru reduce limita ratei de accesare cu crawlere.

Sursă

Practic, fiecare pagină care are ca rezultat un cod diferit de 200 este o pierdere de timp și resurse de accesare cu crawlere. În practică, nu este nevoie să îndreptați atenția Google către paginile pe care le-ați șters sau redirecționat. În schimb, acordați prioritate remedierii adreselor URL live.

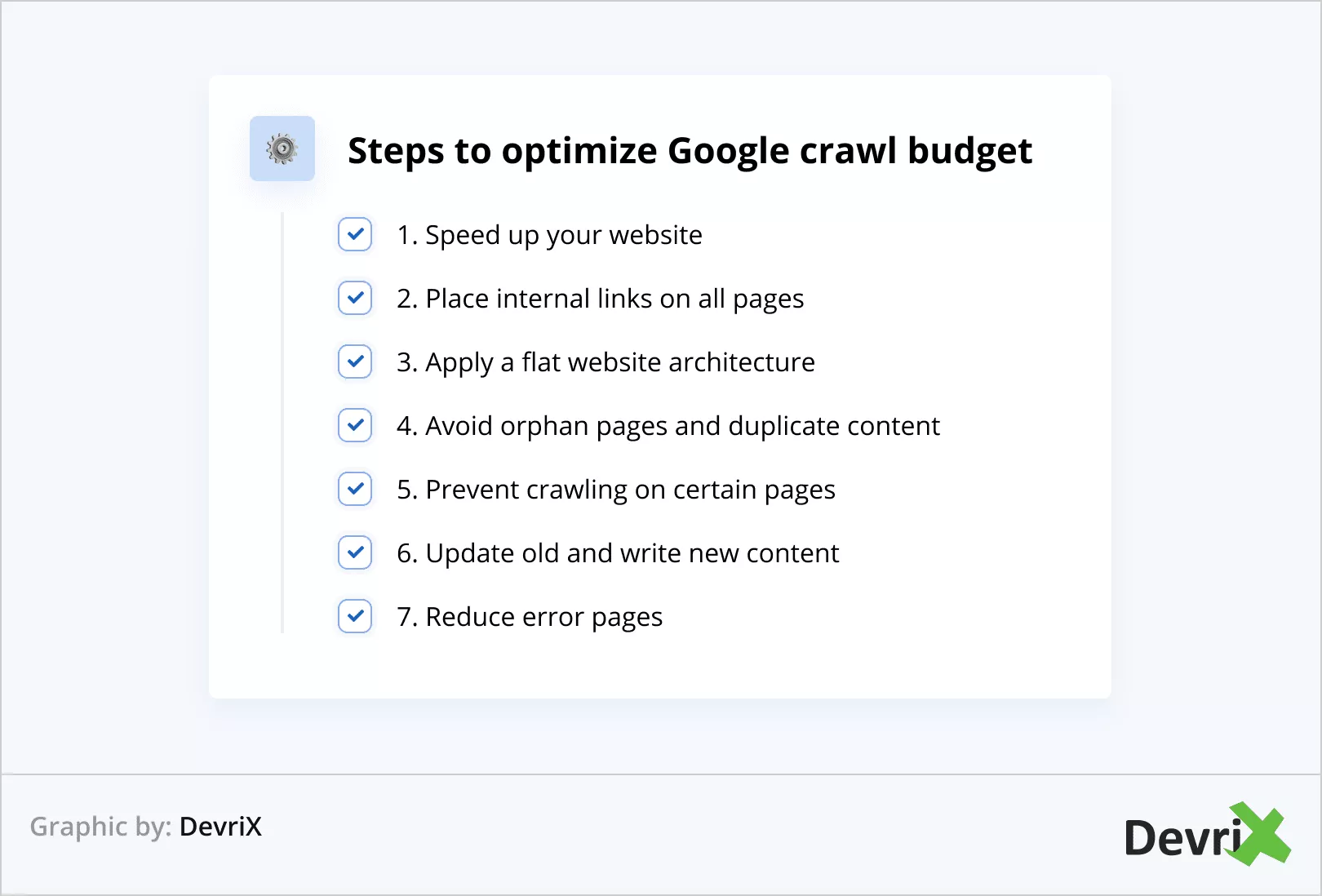

Optimizarea bugetului cu crawlere pe scurt

Să recapitulăm pașii pentru a optimiza bugetul de accesare cu crawlere Google:

- Accelerează-ți site-ul

- Plasați link-uri interne pe toate paginile

- Aplicați o arhitectură web plată

- Evitați paginile orfane și conținutul duplicat

- Preveniți accesarea cu crawlere pe anumite pagini

- Actualizați vechiul și scrieți conținut nou

- Reduceți paginile de eroare

Sfat bonus

Puteți verifica cât de des site-ul dvs. este accesat cu crawlere efectuând o analiză a fișierului jurnal. În acest fel, puteți determina dacă anumite pagini sunt accesate cu crawlere mai des decât altele.

În plus, o analiză a fișierului jurnal vă poate ajuta să înțelegeți dacă există probleme în anumite zone ale site-ului web.

În plus, o analiză a fișierului jurnal vă poate ajuta să înțelegeți dacă există probleme în anumite zone ale site-ului web.

Concluzie

Bugetul de accesare cu crawlere este esențial pentru vizibilitatea generală a site-ului dvs. web în motorul de căutare. Dacă Googlebot nu poate accesa cu crawlere și indexa paginile dvs., practic nu existați online.

Asigurați-vă că aplicați toate tehnicile de optimizare a bugetului cu crawlere pe care le-am discutat în articol și veți culege roadele.

Google va putea să găsească și să indexeze conținutul dvs. mai rapid și, în cele din urmă, site-ul dvs. web va fi înaintea concurenței care nu reușește sau neglijează să implementeze optimizarea.

1:0 pentru tine! Bună treabă!