Top 7 cele mai bune tehnici de web scraping 2023: un ghid practic

Publicat: 2023-03-08Cea mai mare sursă de informații din lume se găsește probabil pe Internet. Colectarea și analiza datelor de pe site-uri web are aplicații potențiale vaste într-o gamă largă de domenii, inclusiv știința datelor, inteligența corporativă și raportarea investigațiilor.

Oamenii de știință de date caută în mod constant informații și date noi pentru a le modifica și analiza. În prezent, folosirea internetului pentru informații specifice este una dintre cele mai populare metode de a face acest lucru.

Ești pregătit pentru prima ta experiență de web scraping? Dar mai întâi, trebuie să înțelegeți ce este de fapt web scraping și câteva dintre elementele sale fundamentale, apoi vom vorbi despre cele mai bune tehnici de web scraping.

Cuprins

Ce este Web Scraping?

Tehnica de colectare și procesare a datelor brute de pe Web este cunoscută sub numele de web scraping, iar comunitatea Python a dezvoltat câteva instrumente de web scraping destul de puternice. O conductă de date este utilizată pentru a procesa și stoca aceste date într-un mod structurat.

Web scraping este o practică comună astăzi, cu numeroase aplicații:

- Afacerile de marketing și vânzări pot aduna date legate de clienți potențiali utilizând web scraping.

- Companiile imobiliare pot obține informații despre noile dezvoltări, proprietăți de vânzare etc. prin utilizarea web scraping.

- Site-urile web de comparare a prețurilor, cum ar fi Trivago, folosesc frecvent web scraping pentru a obține date despre produse și prețuri de la diferite site-uri web de comerț electronic.

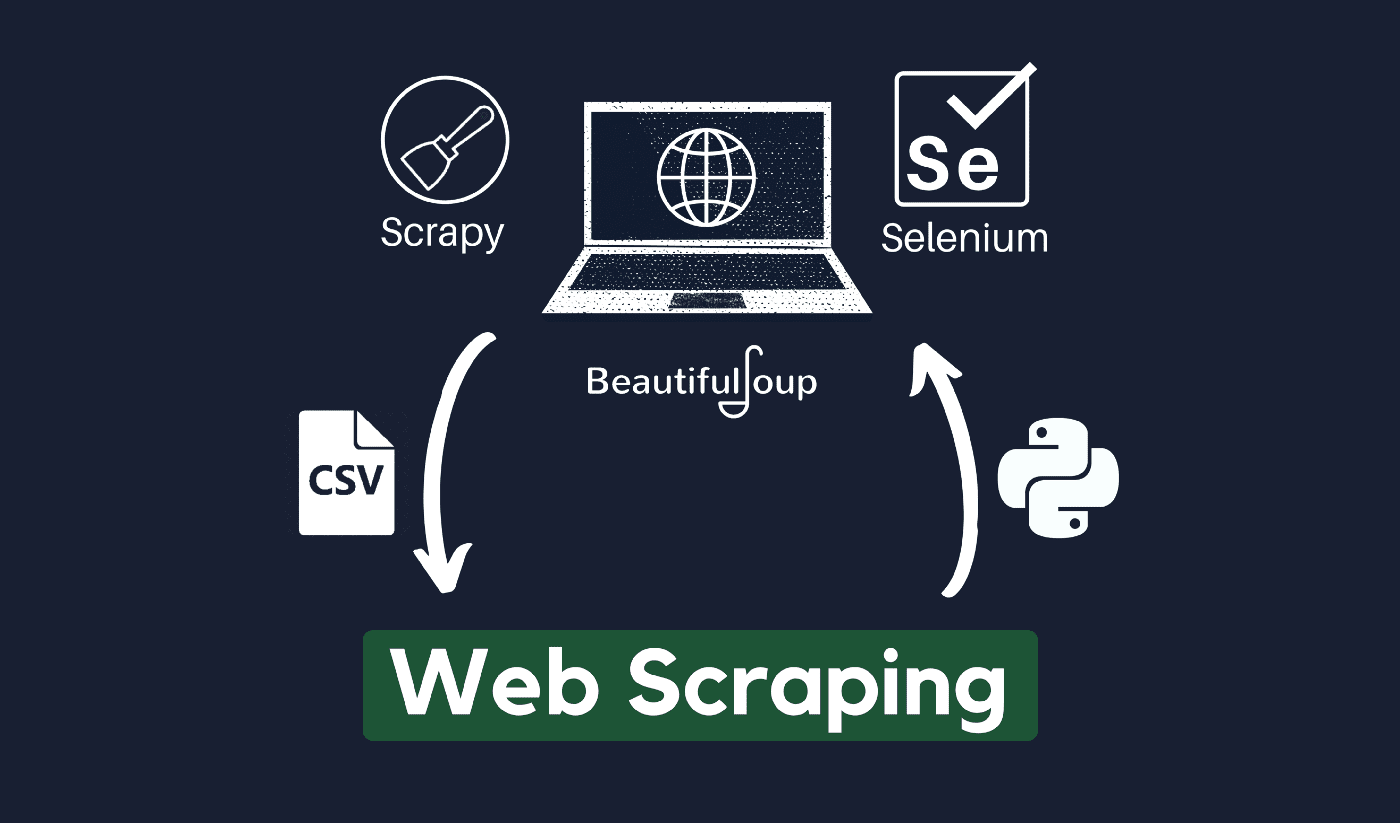

Puteți răzui pe web folosind o varietate de limbaje de programare, iar fiecare limbaj de programare are o varietate de biblioteci care vă pot ajuta să realizați același lucru. Unul dintre cele mai populare, de încredere și legitime programe utilizate pentru scraping web eficient este Python.

Despre Python

Python este cel mai popular limbaj pentru scraping dezvoltat și lansat în 1991. Acest limbaj de programare este folosit frecvent pentru crearea de site-uri web, scrierea codului, crearea de software, crearea de scripturi de sistem și alte lucruri. Programul este o piatră de temelie a sectorului online și este utilizat pe scară largă în comerțul din întreaga lume.

Aplicațiile web pot fi dezvoltate pe un server folosind Python. Poate fi folosit împreună cu aplicații pentru a construi procese și a legă la sistemele de baze de date. Fișierele pot fi, de asemenea, citite și modificate de acesta.

De asemenea, poate fi folosit pentru a gestiona date masive, pentru a efectua operațiuni matematice complicate, pentru a accelera procesul de prototip sau pentru a crea software gata pentru producție.

Cum puteți folosi Python pentru web scraping?

Probabil că va trebui să parcurgeți trei pași pentru a răzui și a extrage orice informație de pe internet: obținerea HTML, obținerea arborelui HTML și, în final, extragerea informațiilor din arbore.

Este posibil să preluați codul HTML de pe un anumit site utilizând biblioteca de solicitări. Arborele HTML va fi apoi analizat și extras folosind BeautifulSoup, iar datele pot fi apoi organizate folosind doar Python.

Este întotdeauna recomandabil să verificați politica de utilizare acceptabilă a site-ului țintă pentru a vedea dacă accesarea site-ului web folosind instrumente automate reprezintă o încălcare a condițiilor sale de utilizare înainte de a vă folosi talentele Python pentru web scraping.

Cum funcționează web scraping?

Păianjenii sunt utilizați de obicei în procesul de răzuire online. Aceștia preiau documente HTML de pe site-uri web relevante, extrag conținutul necesar pe baza logicii de afaceri și apoi îl stochează într-un anumit format.

Acest site web servește drept ghid pentru crearea de scrappers extrem de scalabili.

Cadrele și abordările Python combinate cu câteva fragmente de cod pot fi folosite pentru a răzui datele într-o serie de moduri simple. Există mai multe ghiduri disponibile care vă pot ajuta să puneți același lucru în practică.

Scrapingul unei singure pagini este simplu, dar gestionarea codului spider, colectarea datelor și întreținerea unui depozit de date este dificilă atunci când răzuiți milioane de pagini. Pentru a face răzuirea simplă și precisă, vom examina aceste probleme și soluțiile lor.

Link-uri rapide:

- Revizuire Shiftproxy

- Ce este un server proxy

- Top 3 alternative SmartProxy

**Sfat suplimentar: utilizați IP-uri rotative și servicii proxy

După cum ați înțeles clar imaginea, web scraping vă permite să adunați informații de pe web folosind un set de comenzi de programare. Dar, așa cum trebuie să știți, activitățile dvs. de web scraping pot fi urmărite prin adresa dvs. IP.

Aceasta nu va fi o problemă prea mare dacă datele pe care le eliminați dintr-un domeniu public. Dar dacă ștergeți date private de la, de exemplu, un site media special, atunci puteți avea probleme dacă adresa dvs. IP este urmărită.

Deci, practic, pentru a preveni ca spider-ul tău să fie inclus pe lista neagră, este întotdeauna de preferat să folosești servicii proxy și să schimbi adresele IP.

În niciun caz nu vă încurajăm să utilizați web scraping pentru a culege date ilegale sau private sau să vă dedați la unele activități spyware rău intenționate?

Dar dacă colectați date care ar putea fi private, este recomandat să vă mascați sau să rotiți adresa IP sau să utilizați un server proxy pentru a evita urmărirea.

S-ar putea să-ți placă să citești și:

- Octoparse Review

- Cele mai bune răzuitoare Reddit

- 12 cele mai bune proxy de scraping web

Este legală web scraping?

Oficial, nicăieri în normele și liniile directoare de internet nu este menționat că scrapingul web este ilegal. În mod corect, web scraping este complet legal, cu condiția să lucrați la date publice.

La sfârșitul lunii ianuarie 2020, a fost anunțat că eliminarea datelor disponibile public în scopuri necomerciale a fost în întregime permisă.

Informațiile care sunt accesibile publicului larg sunt date care sunt accesibile tuturor online, fără o parolă sau altă autentificare. Prin urmare, informațiile care sunt disponibile public includ cele care pot fi găsite pe Wikipedia, rețelele sociale sau rezultatele căutării Google.

Cu toate acestea, unele site-uri web interzic în mod explicit utilizatorilor să-și rase datele cu ajutorul web scraping. Scrapingul datelor de pe rețelele sociale este uneori considerată ilegală.

Motivul pentru aceasta este că unele dintre ele nu sunt accesibile publicului larg, cum ar fi atunci când un utilizator își face informațiile private. În acest caz, eliminarea acestor informații este interzisă. Scraping informații de pe site-uri web fără acordul proprietarului poate fi, de asemenea, considerată dăunătoare.

Obțineți cele mai bune rezultate din web prin Web Scraping!

Colectarea și analiza datelor de pe site-uri web are aplicații potențiale vaste într-o gamă largă de domenii, inclusiv știința datelor, inteligența corporativă și raportarea investigațiilor.

Una dintre abilitățile fundamentale de care are nevoie un cercetător de date este web scraping.

Rețineți că nu toată lumea va dori să accesați serverele lor web pentru date. Înainte de a începe să răzuiți un site web, asigurați-vă că ați citit Condițiile de utilizare. De asemenea, fiți atenți când sincronizați interogările web pentru a evita copleșirea unui server.

Legături rapide

- Cele mai bune proxy pentru agregarea tarifelor de călătorie

- Cele mai bune proxy franceze

- Cele mai bune proxy Tripadvisor

- Cele mai bune proxy Etsy

- Cod cupon IPRoyal

- Cele mai bune proxy TikTok

- Cele mai bune proxy partajate

- Cele mai bune proxy din Germania